Périphériques technologiques

Périphériques technologiques

IA

IA

Implémentez une formation Edge avec moins de 256 Ko de mémoire et le coût est inférieur à un millième de celui de PyTorch

Implémentez une formation Edge avec moins de 256 Ko de mémoire et le coût est inférieur à un millième de celui de PyTorch

Implémentez une formation Edge avec moins de 256 Ko de mémoire et le coût est inférieur à un millième de celui de PyTorch

En matière de formation aux réseaux neuronaux, la première impression de chacun est GPU + serveur + plateforme cloud. En raison de son énorme surcharge de mémoire, la formation traditionnelle est souvent effectuée dans le cloud et la plate-forme périphérique est uniquement responsable de l'inférence. Cependant, une telle conception rend difficile l'adaptation du modèle d'IA aux nouvelles données : après tout, le monde réel est un scénario dynamique, changeant et évolutif. Comment une formation peut-elle couvrir tous les scénarios ?

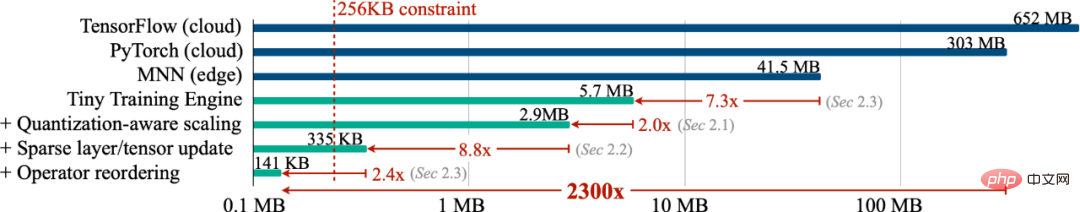

Afin de permettre au modèle de s'adapter en permanence aux nouvelles données, pouvons-nous effectuer une formation en périphérie (formation sur l'appareil) afin que l'appareil puisse continuellement apprendre par lui-même ? Dans ce travail, nous avons implémenté une formation sur l'appareil en utilisant moins de 256 Ko de mémoire, et la surcharge était inférieure à 1/1000 de PyTorch. Dans le même temps, nous avons réalisé une formation cloud sur la tâche de mot de réveil visuel (VWW. ). Précision. Cette technologie permet aux modèles de s’adapter aux nouvelles données des capteurs. Les utilisateurs peuvent profiter de services personnalisés sans télécharger de données sur le cloud, protégeant ainsi leur confidentialité.

- Site Web : https://tinytraining.mit.edu/

- Papier : https://arxiv.org/abs/2206.15472

- De mo: https : //www.bilibili.com/video/BV1qv4y1d7MV

- Code : https://github.com/mit-han-lab/tiny-training

Contexte

Formation sur l'appareil (On-device Training) permet aux modèles pré-entraînés de s'adapter aux nouveaux environnements après le déploiement. En s'entraînant et en s'adaptant localement sur mobile, le modèle peut améliorer continuellement ses résultats et personnaliser le modèle pour l'utilisateur. Par exemple, l’ajustement des modèles de langage leur permet d’apprendre de l’historique des entrées ; l’ajustement des modèles de vision permet aux caméras intelligentes de reconnaître en permanence de nouveaux objets. En rapprochant la formation du terminal plutôt que du cloud, nous pouvons améliorer efficacement la qualité des modèles tout en protégeant la confidentialité des utilisateurs, en particulier lors du traitement d'informations privées telles que les données médicales et l'historique des saisies.

Cependant, la formation sur les petits appareils IoT est fondamentalement différente de la formation sur le cloud et est très difficile. Premièrement, la taille SRAM des appareils AIoT (MCU) est généralement limitée (256 Ko). Ce niveau de mémoire est très difficile à déduire, sans parler de l'entraînement. De plus, les algorithmes d'apprentissage par transfert existants, peu coûteux et efficaces, tels que la formation uniquement du classificateur de dernière couche (dernier FC) et l'apprentissage uniquement du terme de biais, ont souvent une précision insatisfaisante et ne peuvent pas être utilisés dans la pratique, encore moins dans les applications modernes. les cadres d’apprentissage profond sont incapables de traduire les chiffres théoriques de ces algorithmes en économies mesurées. Enfin, les frameworks de formation approfondie modernes (PyTorch, TensorFlow) sont généralement conçus pour les serveurs cloud, et la formation de petits modèles (MobileNetV2-w0.35) nécessite une grande quantité de mémoire même si la taille du lot est définie sur 1. Par conséquent, nous devons co-concevoir des algorithmes et des systèmes pour réaliser la formation sur les terminaux intelligents.

Méthodes et résultats

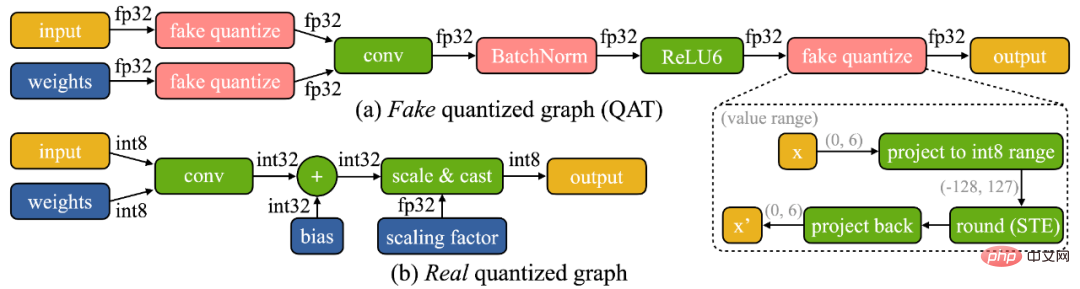

Nous avons constaté que la formation sur appareil présente deux défis uniques : (1) Le modèle est quantifié sur l'appareil de pointe. Un graphique véritablement quantifié (illustré ci-dessous) est difficile à optimiser en raison de tenseurs de faible précision et du manque de couches de normalisation par lots ; (2) les ressources matérielles limitées (mémoire et calcul) du petit matériel ne permettent pas une rétropropagation complète, ce qui entraîne l'utilisation de la mémoire. peut facilement dépasser la limite de la SRAM du microcontrôleur (de plus d'un ordre de grandeur), mais si seule la dernière couche est mise à jour, la précision finale sera inévitablement insatisfaisante.

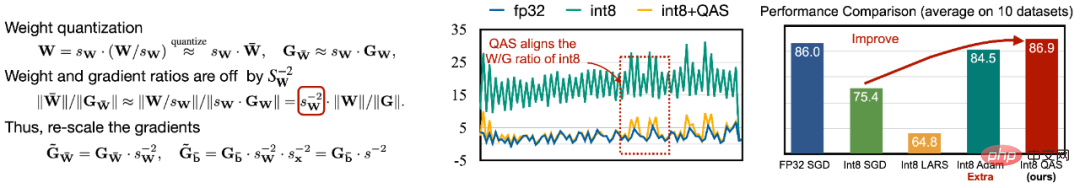

Pour faire face à la difficulté de l'optimisation, nous proposons une mise à l'échelle sensible à la quantification (QAS) pour mettre automatiquement à l'échelle le gradient des tenseurs avec différentes précisions en bits (comme le montre la figure de gauche ci-dessous). QAS peut automatiquement faire correspondre les gradients et les échelles de paramètres et stabiliser l'entraînement sans nécessiter d'hyperparamètres supplémentaires. Sur 8 ensembles de données, QAS peut atteindre des performances cohérentes avec un entraînement en virgule flottante (image de droite ci-dessous).

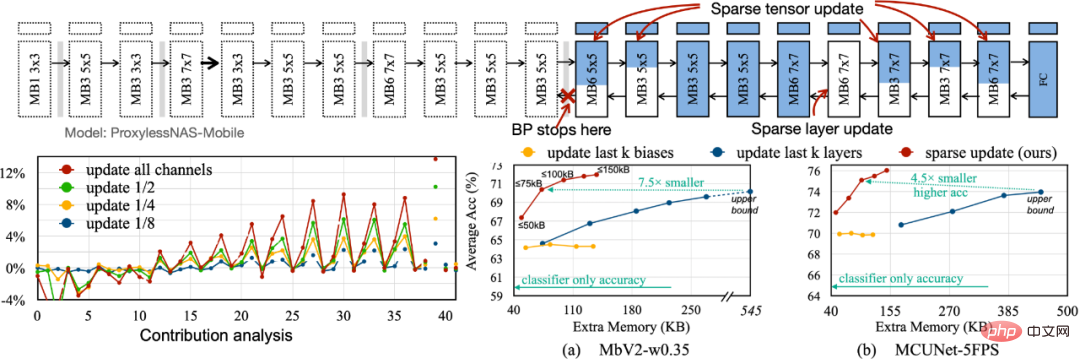

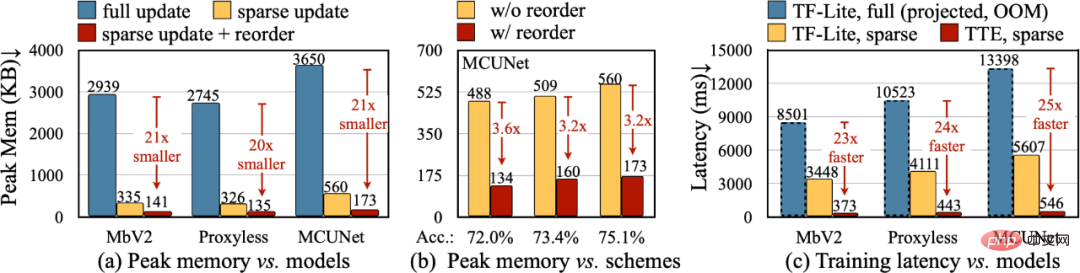

Afin de réduire l'empreinte mémoire requise pour la rétropropagation, nous proposons Sparse Update pour ignorer le calcul du dégradé des couches et sous-feuilles moins importantes. Nous développons une méthode automatique basée sur l'analyse des contributions pour trouver le schéma de mise à jour optimal. Par rapport à la précédente mise à jour des k dernières couches, uniquement biaisée, le schéma de mise à jour clairsemé que nous avons recherché permet d'économiser 4,5 à 7,5 fois la mémoire, et la précision moyenne sur 8 ensembles de données en aval est encore plus élevée.

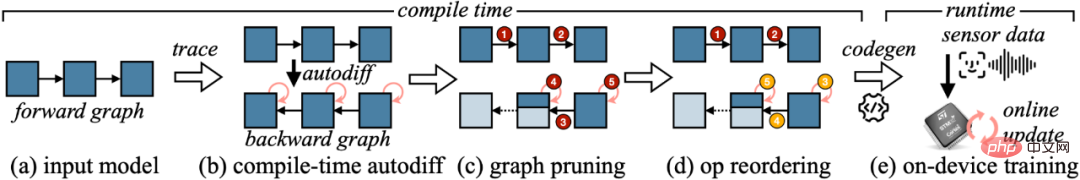

Pour convertir la réduction théorique de l'algorithme en valeurs numériques réelles, nous avons conçu le Tiny Training Engine (TTE) : il déplace le travail de différenciation automatique vers le temps de compilation et utilise codegen pour réduire la surcharge d'exécution. Il prend également en charge l'élagage et la réorganisation des graphiques pour de réelles économies et accélérations. Sparse Update réduit efficacement la mémoire maximale de 7 à 9 fois par rapport à la mise à jour complète et peut être encore améliorée jusqu'à 20 à 21 fois les économies de mémoire totales avec une réorganisation. Par rapport à TF-Lite, le noyau optimisé et la mise à jour clairsemée dans TTE augmentent la vitesse globale d'entraînement de 23 à 25 fois.

Conclusion

Dans cet article, nous avons présenté la première solution pour mettre en œuvre une formation sur un microcontrôleur (avec seulement 256 Ko de mémoire et 1 Mo de mémoire flash). Notre co-conception de système d'algorithme (System-Algorithm Co-design) réduit considérablement la mémoire requise pour la formation (1 000 fois par rapport à PyTorch) et le temps de formation (20 fois par rapport à TF-Lite), et atteint une plus grande précision sur le taux des tâches en aval. Tiny Training peut permettre de nombreuses applications intéressantes. Par exemple, les téléphones mobiles peuvent personnaliser les modèles de langage en fonction des e-mails/de l'historique des entrées des utilisateurs, les caméras intelligentes peuvent reconnaître en permanence de nouveaux visages/objets, et certains scénarios d'IA qui ne peuvent pas être connectés à Internet peuvent également continuer. à apprendre (comme l'agriculture, la marine, les chaînes de montage industrielles). Grâce à notre travail, les petits appareils peuvent effectuer non seulement des inférences, mais également des formations. Dans ce processus, les données personnelles ne seront jamais téléchargées sur le cloud, il n'y a donc aucun risque pour la vie privée. Dans le même temps, le modèle d'IA peut continuellement apprendre par lui-même pour s'adapter à un monde en évolution dynamique !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Optimisation importante de la mémoire, que dois-je faire si l'ordinateur passe à une vitesse de mémoire de 16 Go/32 Go et qu'il n'y a aucun changement ?

Jun 18, 2024 pm 06:51 PM

Optimisation importante de la mémoire, que dois-je faire si l'ordinateur passe à une vitesse de mémoire de 16 Go/32 Go et qu'il n'y a aucun changement ?

Jun 18, 2024 pm 06:51 PM

Pour les disques durs mécaniques ou les disques SSD SATA, vous ressentirez l'augmentation de la vitesse d'exécution du logiciel. S'il s'agit d'un disque dur NVME, vous ne la ressentirez peut-être pas. 1. Importez le registre sur le bureau et créez un nouveau document texte, copiez et collez le contenu suivant, enregistrez-le sous 1.reg, puis cliquez avec le bouton droit pour fusionner et redémarrer l'ordinateur. WindowsRegistryEditorVersion5.00[HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\SessionManager\MemoryManagement]"DisablePagingExecutive"=d

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

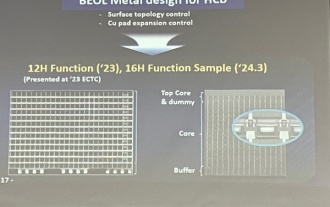

Samsung a annoncé l'achèvement de la vérification de la technologie du processus d'empilement de liaisons hybrides à 16 couches, qui devrait être largement utilisée dans la mémoire HBM4.

Apr 07, 2024 pm 09:19 PM

Samsung a annoncé l'achèvement de la vérification de la technologie du processus d'empilement de liaisons hybrides à 16 couches, qui devrait être largement utilisée dans la mémoire HBM4.

Apr 07, 2024 pm 09:19 PM

Selon le rapport, Dae Woo Kim, directeur de Samsung Electronics, a déclaré que lors de la réunion annuelle 2024 de la Korean Microelectronics and Packaging Society, Samsung Electronics terminerait la vérification de la technologie de mémoire HBM à liaison hybride à 16 couches. Il est rapporté que cette technologie a passé avec succès la vérification technique. Le rapport indique également que cette vérification technique jettera les bases du développement du marché de la mémoire dans les prochaines années. DaeWooKim a déclaré que Samsung Electronics avait réussi à fabriquer une mémoire HBM3 empilée à 16 couches basée sur la technologie de liaison hybride. À l'avenir, la technologie de liaison hybride empilée à 16 couches sera utilisée pour la production en série de mémoire HBM4. ▲ Source de l'image TheElec, comme ci-dessous. Par rapport au processus de liaison existant, la liaison hybride n'a pas besoin d'ajouter de bosses entre les couches de mémoire DRAM, mais connecte directement les couches supérieure et inférieure de cuivre au cuivre.

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,

Lexar lance le kit de mémoire Ares Wings of War DDR5 7600 16 Go x2 : particules Hynix A-die, 1 299 yuans

May 07, 2024 am 08:13 AM

Lexar lance le kit de mémoire Ares Wings of War DDR5 7600 16 Go x2 : particules Hynix A-die, 1 299 yuans

May 07, 2024 am 08:13 AM

Selon les informations de ce site Web le 6 mai, Lexar a lancé la mémoire d'overclocking DDR57600CL36 de la série Ares Wings of War. L'ensemble de 16 Go x 2 sera disponible en prévente à 00h00 le 7 mai avec un dépôt de 50 yuans, et le prix est de 50 yuans. 1 299 yuans. La mémoire Lexar Wings of War utilise des puces mémoire Hynix A-die, prend en charge Intel XMP3.0 et fournit les deux préréglages d'overclocking suivants : 7600MT/s : CL36-46-46-961.4V8000MT/s : CL38-48-49 -1001.45V En termes de dissipation thermique, cet ensemble de mémoire est équipé d'un gilet de dissipation thermique tout en aluminium de 1,8 mm d'épaisseur et est équipé du tampon de graisse en silicone thermoconducteur exclusif de PMIC. La mémoire utilise 8 perles LED haute luminosité et prend en charge 13 modes d'éclairage RVB.