Périphériques technologiques

Périphériques technologiques

IA

IA

De grandes choses se produisent dans le domaine de l'intelligence artificielle, et LeCun a également transformé

De grandes choses se produisent dans le domaine de l'intelligence artificielle, et LeCun a également transformé

De grandes choses se produisent dans le domaine de l'intelligence artificielle, et LeCun a également transformé

Le traitement des symboles est un processus courant en logique, en mathématiques et en informatique qui traite la pensée comme des opérations algébriques. Depuis près de 70 ans, le débat le plus fondamental dans le domaine de l’intelligence artificielle porte sur la question de savoir si les systèmes d’intelligence artificielle doivent être basés sur un traitement symbolique ou sur des systèmes neuronaux similaires au cerveau humain.

Il existe en fait une troisième possibilité comme compromis : un modèle hybride. Les modèles hybrides tentent de tirer le meilleur parti des deux mondes en combinant l’apprentissage des réseaux de neurones basé sur les données avec les puissantes capacités d’abstraction du traitement symbolique. C'est également là que j'ai travaillé pendant la majeure partie de ma carrière.

Dans un article récent publié dans le magazine NOEMA, Yann LeCun, lauréat du prix Turing et scientifique en chef en intelligence artificielle chez Meta, et Jacob Browning, le « philosophe résident » du LeCun Lab, se sont également impliqués dans cette controverse. L’article semble proposer une nouvelle alternative, mais un examen plus approfondi révèle que ses idées ne sont ni nouvelles ni convaincantes.

Yann LeCun et Jacob Browning ont formellement répondu pour la première fois à l'idée selon laquelle "l'apprentissage profond a heurté un mur" dans un article publié dans le magazine NOEMA, déclarant que "dès le début, les critiques ont cru prématurément que les réseaux de neurones avaient "

Au début de l'article, ils semblaient s'opposer aux modèles hybrides, qui sont généralement définis comme des systèmes combinant apprentissage profond et neuronal. réseaux et traitement symbolique. Mais à la fin, LeCun reconnaissait, de manière inhabituelle, en plusieurs termes, que les systèmes hybrides existent – qu’ils sont importants, qu’ils constituent une voie possible vers l’avenir et que nous l’avons toujours su. L'article lui-même est contradictoire.

Quant à la raison pour laquelle cette contradiction surgit, la seule raison à laquelle je peux penser est que LeCun et Browning croient d'une manière ou d'une autre que les modèles qui apprennent le traitement symbolique ne sont pas des modèles hybrides. Mais l’apprentissage est un problème en développement (comment les systèmes naissent-ils ?), et le fonctionnement des systèmes développés (avec un ou deux mécanismes) est un problème informatique : selon toute mesure raisonnable, un système qui utilise à la fois des mécanismes de réseau symboliques et neuronaux est un système hybride. . (Peut-être que ce qu'ils veulent vraiment dire, c'est que l'IA ressemble plus à un hybride appris qu'à un hybride inné. Mais un hybride appris reste un hybride.)

Vers 2010, le traitement symbolique était considéré comme un gros mot par les partisans de l'apprentissage profond ; comprendre les origines du traitement symbolique est devenu une priorité absolue.

Je pense que le traitement des symboles est soit inné, soit que quelque chose d'autre contribue indirectement à l'acquisition du traitement des symboles. Plus tôt nous déterminerons les fondements permettant aux systèmes d’apprendre des abstractions symboliques, plus tôt nous pourrons construire des systèmes qui exploitent correctement toutes les connaissances du monde, et plus tôt les systèmes seront plus sûrs, plus fiables et explicables.

Cependant, nous devons d’abord comprendre les tenants et les aboutissants de ce débat important dans l’histoire du développement de l’intelligence artificielle.

Les premiers pionniers de l'IA, Marvin Minsky et John McCarthy, pensaient que le traitement symbolique était la seule voie raisonnable à suivre, tandis que le pionnier des réseaux neuronaux, Frank Rosenblatt, pensait que l'IA serait mieux construite sur des collections de « nœuds » de type neurone capables de traiter structurellement les données. faire le gros du travail en matière de statistiques.

Ces deux possibilités ne s’excluent pas mutuellement. Le « réseau neuronal » utilisé en intelligence artificielle n’est pas un véritable réseau de neurones biologiques. Il s’agit plutôt d’un modèle numérique simplifié qui ressemble dans une certaine mesure à un véritable cerveau biologique, mais avec une complexité minimale. En principe, ces neurones abstraits pourraient être connectés de différentes manières, dont certaines pourraient directement permettre un traitement logique et symbolique. Cette possibilité a été explicitement reconnue dès 1943 dans l'un des premiers articles dans le domaine, A Logical Calculus of the Ideas Inmanent in Nervous Activity.

Frank Rosenblatt dans les années 1950, et David Rumelhart et Jay McClelland dans les années 1980, ont proposé les réseaux de neurones comme alternative au traitement des symboles, une position généralement soutenue par Geoffrey Hinton ;

L'histoire peu connue ici est qu'au début des années 2010, LeCun, Hinton et Yoshua Bengio étaient si enthousiasmés par ces réseaux de neurones multicouches qui devenaient enfin pratiques qu'ils voulaient supprimer complètement le traitement des symboles. En 2015, l’apprentissage profond en était encore à son époque d’insouciance et d’enthousiasme, et LeCun, Bengio et Hinton ont écrit un manifeste sur l’apprentissage profond dans la nature. L'article se termine par une attaque contre les symboles, affirmant que « de nouveaux paradigmes sont nécessaires pour remplacer les opérations basées sur des règles sur les expressions symboliques par des opérations sur les grands vecteurs ».

En fait, Hinton était tellement convaincu que le traitement des symboles était une impasse que la même année, il a donné une conférence intitulée « Symboles éthérés » à l'Université de Stanford, comparant les symboles à l'une des plus grandes erreurs de l'histoire de la science.

De même, dans les années 1980, les collaborateurs de Hinton, Rumelhart et McClelland, ont fait valoir un point similaire, affirmant dans un livre de 1986 que les symboles ne sont pas « l'essence du calcul humain ».

Lorsque j'ai écrit un article défendant le traitement des symboles en 2018, LeCun a qualifié ma vision des systèmes hybrides de « pour la plupart fausse » sur Twitter. À cette époque, Hinton comparait également mon travail à une perte de temps sur un « moteur à essence » et qu'un « moteur électrique » était la meilleure voie à suivre. Même en novembre 2020, Hinton affirmait que « l’apprentissage profond sera capable de tout faire ».

Ainsi, lorsque LeCun et Browning écrivent maintenant, sans ironie, que « tous ceux qui travaillent dans le domaine de l’apprentissage profond conviennent que le traitement symbolique est une fonctionnalité nécessaire pour créer une IA de type humain », ils bouleversent des décennies de débat. Comme l'a déclaré Christopher Manning, professeur d'intelligence artificielle à l'Université de Stanford : "La position de LeCun a quelque peu changé

De toute évidence, l'approche d'il y a dix ans n'est plus applicable."

Dans les années 2010, de nombreux membres de la communauté de l’apprentissage automatique affirmaient (sans preuves réelles) que « les symboles sont biologiquement invraisemblables ». Dix ans plus tard, LeCun envisageait une nouvelle approche qui impliquerait un traitement symbolique, qu'il soit inné ou appris. La nouvelle vision de LeCun et Browning selon laquelle le traitement symbolique est crucial représente une énorme concession pour le domaine de l'apprentissage profond.

Les historiens de l'intelligence artificielle devraient considérer l'article du magazine NOEMA comme un tournant majeur, dans lequel LeCun, l'un des trios de l'apprentissage profond, a été le premier à reconnaître directement le caractère inévitable de l'IA hybride.

Il convient de noter que plus tôt cette année, deux autres membres des Big Three du deep learning ont également exprimé leur soutien aux systèmes d'IA hybrides. L'informaticien Andrew Ng et le co-créateur du LSTM Sepp Hochreiter ont également exprimé leur soutien à de tels systèmes. La société d’IA NNAISANCE de Jürgen Schmidhuber mène actuellement des recherches autour de la combinaison du traitement symbolique et du deep learning.

Le reste de l'article de LeCun et Browning peut être grossièrement divisé en trois parties :

- Une mauvaise caractérisation de ma position

- Un effort pour restreindre la portée du modèle hybride

- Une discussion sur la raison pour laquelle le traitement symbolique est plutôt appris ; que Pas inné.

Par exemple, LeCun et Browning disent : "Marcus croit que si vous n'avez pas de manipulation symbolique au début, vous ne l'aurez jamais)." En fait, je l'ai dit clairement dans mon livre de 2001 ". L'esprit algébrique » : Nous ne savons pas si le traitement symbolique est inné.

Ils ont également dit que je ne m'attendais à "aucun progrès supplémentaire" dans l'apprentissage profond, et ce que je voulais réellement dire n'était pas qu'il n'y aurait plus de progrès sur aucun problème, mais que l'apprentissage profond est très utile pour certaines tâches (telles que les problèmes combinatoires, problèmes causals) est en soi un mauvais outil pour les problèmes de raisonnement).

Ils ont également dit que je pense que "le raisonnement symbolique est tout ou rien pour un modèle, car DALL-E n'utilise pas de symboles ni de règles logiques comme base de son traitement, il ne raisonne pas réellement avec des symboles", et je je n'ai rien dit de tel. DALL·E ne raisonne pas à l'aide de symboles, mais cela ne signifie pas que tout système incluant un raisonnement symbolique doit être tout ou rien. Au moins dès les années 1970, dans le système expert MYCIN, il existait des systèmes purement symboliques capables d'effectuer toutes sortes de raisonnements quantitatifs.

En plus de supposer qu'« un modèle contenant des symboles appris n'est pas un modèle hybride », ils tentent également d'assimiler un modèle hybride à « un modèle contenant un processeur de symboles non différentiable ». Ils pensent que j'assimile les modèles hybrides à « une simple combinaison de deux choses : l'insertion d'un module de traitement symbolique codé en dur au-dessus d'un module d'apprentissage profond à complétion de modèles. En fait, tous ceux qui travaillent réellement sur la symbolique neuronale s'en rendent compte. » que le travail n'est pas si simple.

Au lieu de cela, comme nous le savons tous, le nœud du problème est la bonne façon de construire des systèmes hybrides. De nombreuses méthodes différentes ont été envisagées pour combiner les réseaux symboliques et neuronaux, en se concentrant sur des techniques telles que l'extraction de règles symboliques à partir de réseaux neuronaux, la conversion de règles symboliques directement en réseaux neuronaux et la construction de systèmes intermédiaires permettant la transmission d'informations entre les réseaux neuronaux et les systèmes symboliques. et reconstruire le réseau neuronal lui-même. De nombreuses pistes sont explorées.

Enfin, examinons la question la plus critique : le traitement des symboles peut-il être appris sans avoir à l'intégrer dès le début ?

Ma réponse est simple : bien sûr. Autant que je sache, personne ne nie que le traitement symbolique puisse s’apprendre. J'ai répondu à cette question en 2001 dans la section 6.1 de la pensée algébrique, et même si je pensais que c'était peu probable, je n'ai pas dit que c'était absolument impossible. Au contraire, ma conclusion est : « Ces expériences et théories ne garantissent certainement pas que la capacité à traiter les symboles est innée, mais elles sont conformes à ce point de vue

En résumé, mon point de vue comprend les deux parties suivantes :

La première est la perspective de « capacité d'apprentissage » : tout au long de la pensée algébrique, je montre que certains types de systèmes (essentiellement les précurseurs des systèmes plus profonds d'aujourd'hui) n'ont pas réussi à apprendre des aspects du traitement des symboles. Il n'y a donc aucune garantie qu'un système soit capable pour apprendre le traitement symbolique. Comme le disent les mots originaux de mon livre :

Certaines choses doivent être innées. Mais il n’y a pas de véritable conflit entre « nature » et « culture ». La nature fournit un ensemble de mécanismes qui nous permettent d'interagir avec notre environnement, un ensemble d'outils pour extraire des connaissances du monde et un ensemble d'outils pour exploiter ces connaissances. Sans certains outils d’apprentissage innés, nous n’apprendrions pas du tout.

La psychologue du développement Elizabeth Spelke a dit un jour : « Je pense qu'un système avec un point de départ intégré (tel que des objets, des ensembles, des dispositifs de traitement symbolique, etc.) sera plus efficace pour comprendre le monde qu'un système pur. table vierge. » En fait, le travail le plus célèbre de LeCun sur les réseaux neuronaux convolutifs illustre ce point.

Le deuxième point est que les nourrissons humains montrent des preuves de capacités de traitement symbolique. Dans une série d’expériences d’apprentissage de règles souvent citées dans mon laboratoire, les nourrissons ont généralisé une gamme de modèles abstraits au-delà des exemples spécifiques dans lesquels ils ont été formés. Des travaux de suivi sur les capacités de raisonnement logique implicite des nourrissons humains le confirmeront davantage.

Malheureusement, LeCun et Browning évitent complètement mes deux points. Bizarrement, ils assimilent plutôt les symboles d’apprentissage à des acquisitions ultérieures telles que « des cartes, des représentations picturales, des rituels et même des rôles sociaux », ignorant apparemment que moi-même et plusieurs autres scientifiques cognitifs avons appris de la vaste littérature en sciences cognitives. Les pensées sur les bébés, les jeunes enfants, et les animaux non humains. Si un agneau peut descendre une colline peu après sa naissance, pourquoi un réseau neuronal nouveau-né ne peut-il pas intégrer un peu de traitement symbolique ? Enfin, le fait est de savoir pourquoi LeCun et Browning y vont ? autant de longueur pour argumenter contre le caractère inné du traitement des symboles ? Ils ne donnent pas d'argument de principe solide contre le caractère inné, et ne donnent aucune raison de principe pour prouver que le traitement des symboles est acquis

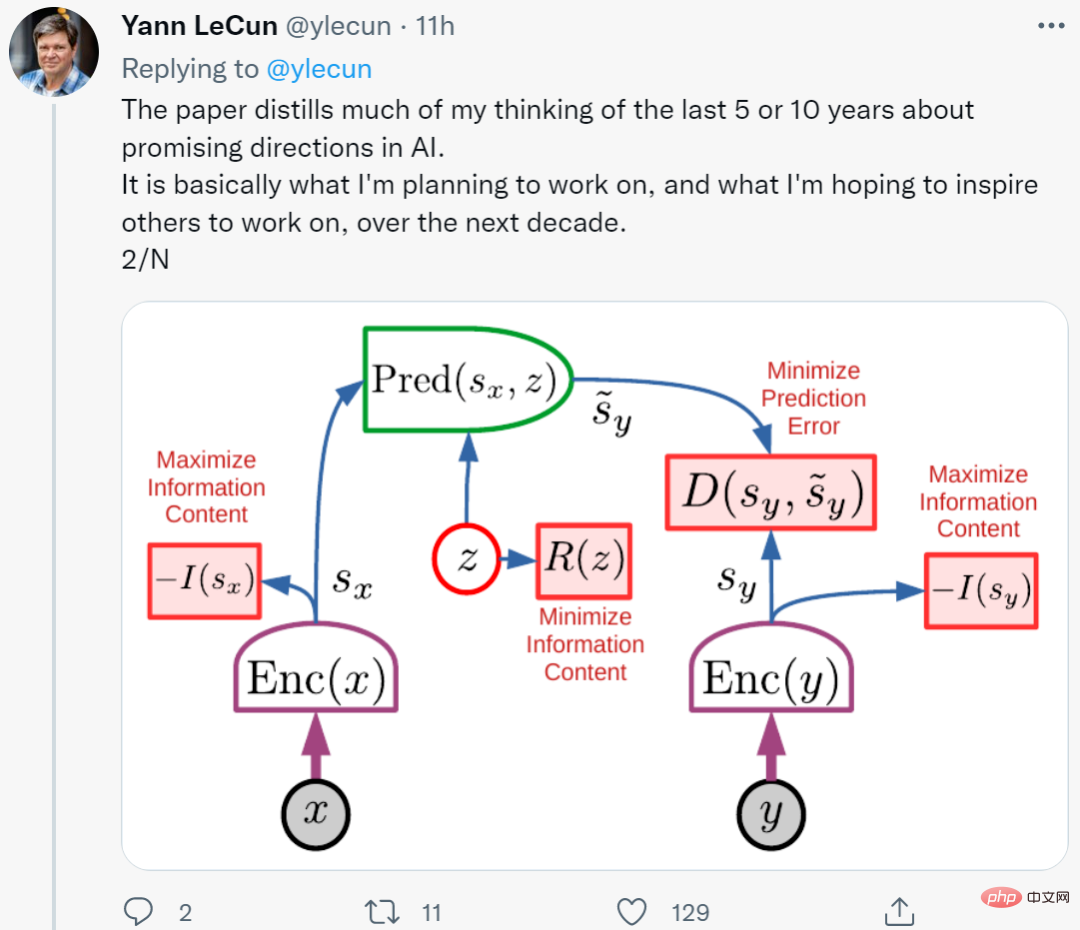

Il convient de noter que les dernières recherches de LeCun en intègrent. traitement des symboles « innés ». Sa nouvelle architecture récemment dévoilée se compose de six modules au total, dont la plupart sont réglables mais tous intégrés.

De plus, LeCun et Browning ne précisent pas comment résoudre les problèmes spécifiques bien connus de compréhension et de raisonnement du langage, car les modèles de langage n'ont pas de mécanismes innés de traitement des symboles.

De plus, LeCun et Browning ne précisent pas comment résoudre les problèmes spécifiques bien connus de compréhension et de raisonnement du langage, car les modèles de langage n'ont pas de mécanismes innés de traitement des symboles.

Au contraire, ils utilisent simplement le principe d'induction pour expliquer le rôle du deep learning : "Puisque le deep learning a surmonté les problèmes de 1 à N, il faut croire qu'il peut surmonter le problème de N+1."

Ce point de vue est très faible. Ce à quoi les gens devraient vraiment réfléchir et se remettre en question, c'est la limite de l'apprentissage profond.

Deuxièmement, il existe de solides raisons concrètes pour lesquelles l'apprentissage profond est déjà confronté à des défis de principe, à savoir des problèmes de combinatoire, de systématisation et de compréhension du langage. Ces problèmes reposent sur la « généralisation » et le « changement de distribution ». Tout le monde dans le domaine reconnaît désormais que le changement de distribution est le talon d'Achille des réseaux de neurones actuels. C'est également la vision pionnière des systèmes d'apprentissage profond actuels en matière de pensée algébrique.

En fait, l’apprentissage profond n’est qu’une partie de la construction de machines intelligentes. De telles techniques manquent de méthodes pour caractériser les relations causales (telles que la relation entre une maladie et ses symptômes) et peuvent présenter des difficultés pour saisir des concepts abstraits. L’apprentissage profond n’a pas de méthode de raisonnement logique évidente et est encore loin d’intégrer des connaissances abstraites.

Bien sûr, l'apprentissage profond a fait beaucoup de progrès, et il est bon en reconnaissance de formes, mais il n'a pas fait suffisamment de progrès sur certains problèmes fondamentaux comme le raisonnement, et le système est encore très peu fiable.

Prenons comme exemple le nouveau modèle Minerva développé par Google. Il contient des milliards de jetons lors de la formation, mais il est encore difficile de résoudre le problème de la multiplication de nombres à 4 chiffres. Il a atteint une précision de 50 % aux examens de mathématiques du secondaire, mais a été présenté comme une « amélioration majeure ». Il est donc encore difficile de construire un système maîtrisant le raisonnement et l’abstraction dans le domaine du deep learning. La conclusion actuelle est la suivante : non seulement il y a un problème avec l’apprentissage profond, mais l’apprentissage profond « a toujours eu des problèmes ».

Il me semble que la situation avec la gestion des symboles est probablement la même que jamais :

Sous l'influence de 20 ans de « pensée algébrique », les systèmes actuels ne peuvent toujours pas extraire de manière fiable le traitement symbolique (comme la multiplication), même face à d'énormes ensembles de données et à une formation. L’exemple des nourrissons et des jeunes enfants montre qu’avant l’éducation formelle, les humains sont capables de généraliser des concepts complexes de langage naturel et de raisonnement (vraisemblablement de nature symbolique).

Un peu de symbolisme intégré peut grandement améliorer l'efficacité de l'apprentissage. Le propre succès de LeCun avec les convolutions (contraintes intégrées sur la manière dont les réseaux neuronaux sont connectés) illustre bien cette situation. Une partie du succès d'AlphaFold 2 provient de représentations innées soigneusement construites de la biologie moléculaire, et une autre partie vient du rôle des modèles. Un nouvel article de DeepMind indique qu'ils ont fait des progrès dans la construction d'un raisonnement systématique sur la connaissance innée des cibles.

Et rien de ce que LeCun et Browning ont dit ne change cela.

En prenant du recul, le monde peut être grossièrement divisé en trois parties :

- Les systèmes avec un équipement de traitement de symboles entièrement installé en usine (comme presque tous les langages de programmation connus).

- Les systèmes dotés de dispositifs d'apprentissage innés manquent de traitement symbolique, mais avec des données et un environnement de formation appropriés, ils sont suffisants pour obtenir un traitement symbolique.

- Même avec une formation suffisante, il est impossible d'obtenir un système doté de mécanismes complets de traitement des symboles.

Les systèmes d'apprentissage profond actuels entrent dans la troisième catégorie : aucun mécanisme de traitement de symboles au début, et aucun mécanisme de traitement de symboles fiable dans le processus.

LeCun et Browning semblent être d'accord avec mon récent argument contre la mise à l'échelle lorsqu'ils se rendent compte que la mise à l'échelle fait du bon travail en ajoutant plus de couches, plus de données, mais ce n'est pas suffisant. Nous avons tous les trois reconnu la nécessité de nouvelles idées.

De plus, au niveau macro, les affirmations récentes de LeCun sont à bien des égards très proches de mes affirmations de 2020 selon lesquelles nous soulignons tous les deux l’importance de percevoir, de raisonner et d’avoir des modèles du monde plus riches. Nous sommes tous d’accord sur le fait que le traitement des symboles joue un rôle important (même s’il peut être différent). Nous sommes tous d’accord sur le fait que les techniques d’apprentissage par renforcement actuellement populaires ne peuvent pas répondre à tous les besoins, pas plus que la mise à l’échelle pure.

La plus grande différence dans le traitement des symboles réside dans la quantité de structure inhérente requise et dans la capacité d'exploiter les connaissances existantes. Le traitement symbolique souhaite exploiter autant de connaissances existantes que possible, tandis que l'apprentissage profond souhaite que le système reparte autant que possible de zéro.

Dans les années 2010, le traitement symbolique était un mot impopulaire parmi les partisans de l'apprentissage profond. Dans les années 2020, nous devrions faire de la compréhension des origines de cette méthode une priorité. Même les partisans les plus ardents des réseaux de neurones ont déjà reconnu l'importance de. traitement symbolique pour réaliser l’IA. Une question de longue date dans la communauté neurosymbolique est la suivante : comment l’apprentissage basé sur les données et la représentation symbolique peuvent-ils fonctionner en harmonie au sein d’une intelligence unique et plus puissante ? Fait intéressant, LeCun s’est finalement engagé à travailler pour atteindre cet objectif.

Lien original : https://www.noemamag.com/deep-learning-alone-isnt-getting-us-to-human-like-ai/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Pour en savoir plus sur l'AIGC, veuillez visiter : 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou est différent de la banque de questions traditionnelle que l'on peut voir partout sur Internet. nécessite de sortir des sentiers battus. Les grands modèles linguistiques (LLM) sont de plus en plus importants dans les domaines de la science des données, de l'intelligence artificielle générative (GenAI) et de l'intelligence artificielle. Ces algorithmes complexes améliorent les compétences humaines et stimulent l’efficacité et l’innovation dans de nombreux secteurs, devenant ainsi la clé permettant aux entreprises de rester compétitives. LLM a un large éventail d'applications. Il peut être utilisé dans des domaines tels que le traitement du langage naturel, la génération de texte, la reconnaissance vocale et les systèmes de recommandation. En apprenant de grandes quantités de données, LLM est capable de générer du texte

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

AlphaFold 3 est lancé, prédisant de manière exhaustive les interactions et les structures des protéines et de toutes les molécules de la vie, avec une précision bien plus grande que jamais

Jul 16, 2024 am 12:08 AM

AlphaFold 3 est lancé, prédisant de manière exhaustive les interactions et les structures des protéines et de toutes les molécules de la vie, avec une précision bien plus grande que jamais

Jul 16, 2024 am 12:08 AM

Editeur | Radis Skin Depuis la sortie du puissant AlphaFold2 en 2021, les scientifiques utilisent des modèles de prédiction de la structure des protéines pour cartographier diverses structures protéiques dans les cellules, découvrir des médicaments et dresser une « carte cosmique » de chaque interaction protéique connue. Tout à l'heure, Google DeepMind a publié le modèle AlphaFold3, capable d'effectuer des prédictions de structure conjointe pour des complexes comprenant des protéines, des acides nucléiques, de petites molécules, des ions et des résidus modifiés. La précision d’AlphaFold3 a été considérablement améliorée par rapport à de nombreux outils dédiés dans le passé (interaction protéine-ligand, interaction protéine-acide nucléique, prédiction anticorps-antigène). Cela montre qu’au sein d’un cadre unique et unifié d’apprentissage profond, il est possible de réaliser