Périphériques technologiques

Périphériques technologiques

IA

IA

L'équipe Google lance un nouveau Transformer pour optimiser la solution de segmentation panoramique

L'équipe Google lance un nouveau Transformer pour optimiser la solution de segmentation panoramique

L'équipe Google lance un nouveau Transformer pour optimiser la solution de segmentation panoramique

Récemment, l'équipe Google AI a proposé une solution de bout en bout pour la segmentation panoramique utilisant Mask Transformer, inspirée de Transformer et DETR.

Le nom complet est une solution de bout en bout pour la segmentation panoptique avec des transformateurs de masque, qui est principalement utilisée pour générer des extensions de l'architecture de segmentation MaskTransformer.

La solution utilise un chemin de pixel (composé d'un réseau neuronal convolutif ou d'un transformateur visuel) pour extraire les caractéristiques des pixels, un chemin de mémoire (composé d'un module décodeur Transformer) pour extraire les caractéristiques de la mémoire et un transformateur à double chemin pour la connexion. entre les fonctionnalités de pixels et les fonctionnalités interactives de la mémoire.

Cependant, le transformateur à double chemin utilisant l'attention croisée a été conçu à l'origine pour les tâches linguistiques, dont la séquence de saisie se compose de centaines de mots.

Pour les tâches de vision, en particulier les problèmes de segmentation, la séquence d'entrée se compose de dizaines de milliers de pixels, ce qui indique non seulement que l'ampleur de l'échelle d'entrée est beaucoup plus grande, mais représente également un niveau d'intégration inférieur par rapport aux mots du langage.

La segmentation panoramique est un problème de vision par ordinateur qui constitue désormais une tâche essentielle dans de nombreuses applications.

Il est divisé en deux parties : la segmentation sémantique et la segmentation des instances.

La segmentation sémantique revient à attribuer des étiquettes sémantiques à chaque pixel de l'image, telles que « personne » et « ciel ».

La segmentation d'instance identifie et segmente uniquement les objets dénombrables dans le graphique, tels que les « piétons » et les « voitures », et les divise en plusieurs sous-tâches.

Chaque sous-tâche est traitée individuellement et des modules supplémentaires sont appliqués pour fusionner les résultats de chaque étape de sous-tâche.

Ce processus est non seulement complexe, mais introduit également de nombreux a priori conçus artificiellement lors du traitement des sous-tâches et de l'intégration des résultats des différentes sous-tâches.

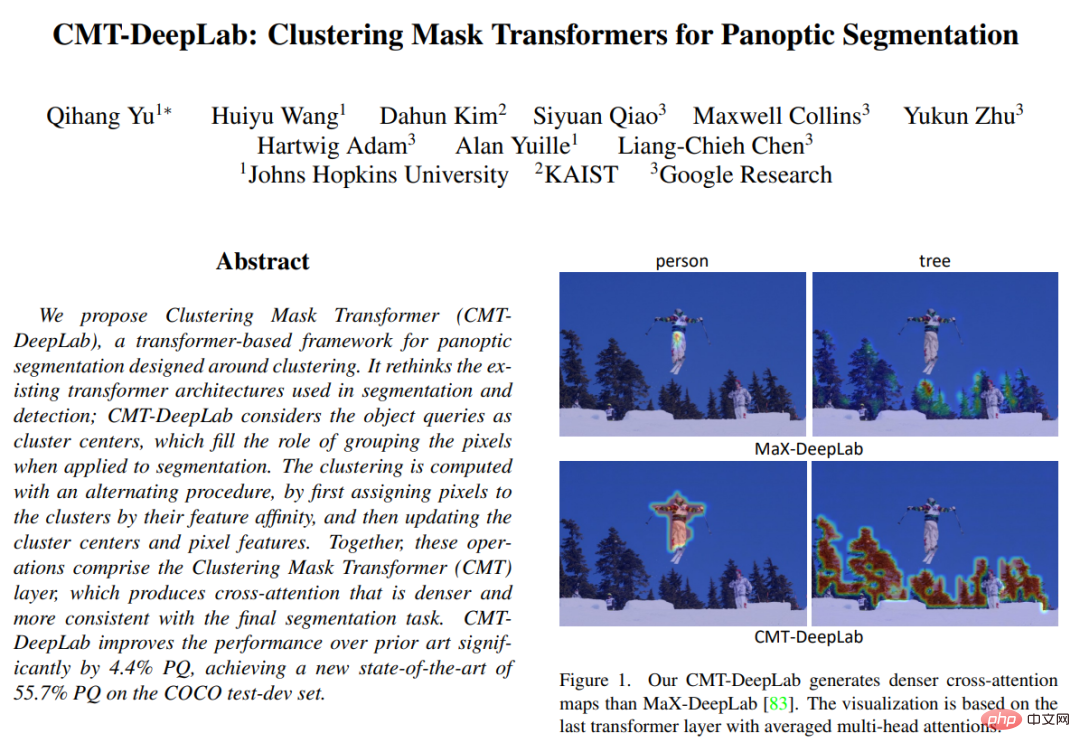

Dans "CMT-DeepLab: Clustering Mask Transformers for Panoptic Segmentation" publié au CVPR 2022, l'article propose de réinterpréter et de repenser l'attention croisée du point de vue du clustering (c'est-à-dire convertir les mêmes étiquettes sémantiques en pixels regroupés ensemble) pour mieux répondre aux tâches de vision.

CMT-DeepLab s'appuie sur la méthode de pointe précédente MaX-DeepLab et adopte une méthode de regroupement de pixels pour effectuer une attention croisée, ce qui donne lieu à des cartes d'attention plus denses et plus raisonnables.

kMaX-DeepLab redessine davantage l'attention croisée pour ressembler davantage à un algorithme de clustering k-means avec de simples modifications de la fonction d'activation.

Aperçu structurel

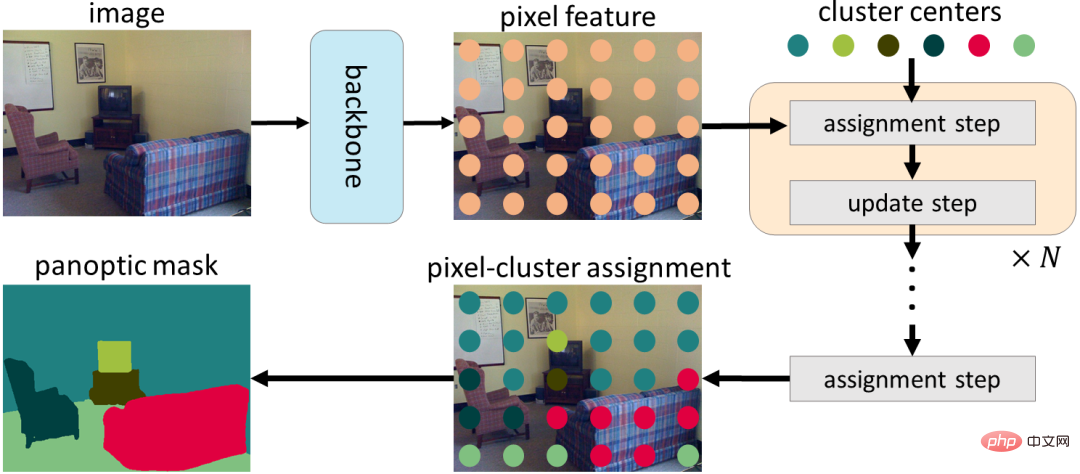

Les chercheurs réinterpréteront du point de vue du clustering au lieu d'appliquer directement une attention croisée aux tâches visuelles sans modification.

Plus précisément, ils notent que les requêtes d'objets Mask Transformer peuvent être considérées comme des centres de cluster (destinés à regrouper des pixels avec la même étiquette sémantique).

Le processus d'attention croisée est similaire à l'algorithme de clustering k-means, (1) processus itératif d'attribution de pixels aux centres de cluster, où plusieurs pixels peuvent être attribués à un seul centre de cluster, et certains centres de cluster peuvent ne pas exister. pixels attribués, et (2) les centres de cluster sont mis à jour en faisant la moyenne des pixels attribués au même centre de cluster, s'il n'y a pas de pixels attribués, les centres de cluster ne sont pas mis à jour).

Dans CMT-DeepLab et kMaX-DeepLab, nous reformulons l'attention croisée dans une perspective de clustering, qui comprend des étapes d'affectation itérative de cluster et de mise à jour de cluster

Compte tenu de la popularité de l'algorithme de clustering k-means, dans CMT-DeepLab , ils ont repensé l'attention croisée de sorte que l'opération softmax de l'aspect spatial (c'est-à-dire l'opération softmax appliquée le long de la résolution spatiale de l'image) attribue en fait les centres du cluster aux pixels opposés le long de l'application Cluster Center.

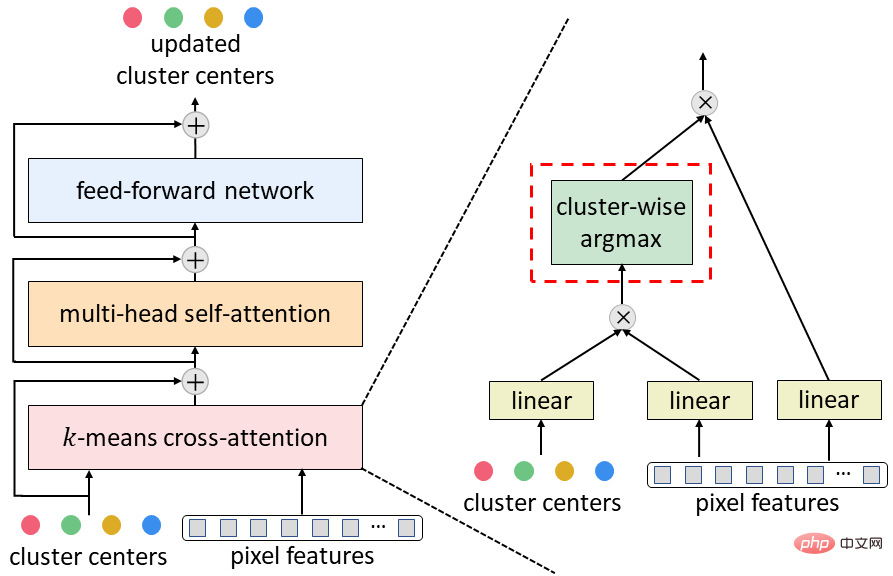

Dans kMaX-DeepLab, nous simplifions davantage le softmax spatial en argmax au niveau du cluster (c'est-à-dire que nous appliquons les opérations argmax le long du centre du cluster).

Ils notent que l'opération argmax est la même que l'affectation dure (c'est-à-dire qu'un pixel est attribué à un seul cluster) utilisée dans l'algorithme de clustering k-means.

La reconstruction de l'attention croisée de MaskTransformer dans une perspective de clustering améliore considérablement les performances de segmentation et simplifie le pipeline complexe de MaskTransformer pour le rendre plus interprétable.

Tout d'abord, une structure encodeur-décodeur est utilisée pour extraire les caractéristiques des pixels de l'image d'entrée. Les pixels sont ensuite regroupés à l'aide d'un ensemble de centres de cluster, qui sont ensuite mis à jour en fonction des attributions de cluster. Enfin, les étapes d'affectation du cluster et de mise à jour sont effectuées de manière itérative, et la dernière affectation peut être directement utilisée comme prédiction de segmentation.

Afin de convertir le décodeur MaskTransformer typique (composé d'une attention croisée, d'une auto-attention multi-têtes et d'un réseau de rétroaction) en l'attention croisée k-means proposée ci-dessus, juste du softmax spatialement Remplacé par le paramètre maximum du mode cluster.

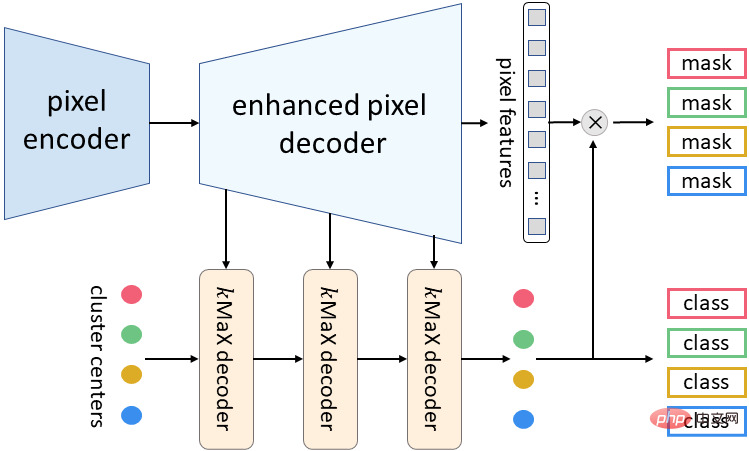

La méta-architecture de kMaX-DeepLab proposée cette fois se compose de trois composants : un encodeur de pixels, un décodeur de pixels amélioré et un décodeur kMaX.

L'encodeur pixel est l'épine dorsale de tout réseau et est utilisé pour extraire les caractéristiques de l'image.

Le décodeur de pixels amélioré comprend un encodeur Transformer pour améliorer les fonctionnalités des pixels et une couche de suréchantillonnage pour générer des fonctionnalités de résolution plus élevée.

Une série de décodeurs kMaX convertit les centres de cluster en (1) vecteurs d'incorporation de masques, qui sont multipliés par des caractéristiques de pixels pour générer des masques prédits, et (2) des prédictions de classe pour chaque masque.

Méta-architecture de kMaX-DeepLab

Résultats de recherche

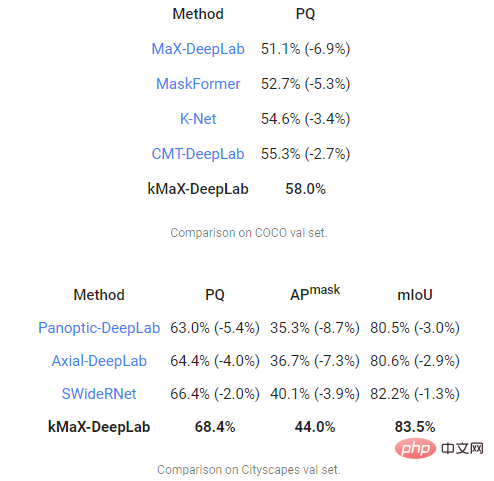

Enfin, l'équipe de recherche a utilisé la métrique Panorama Quality (PQ) pour évaluer CMT-DeepLab et kMaX-DeepLab, et comparer MaX-DeepLab avec d'autres états de -les méthodes de l'art.

Parmi eux, CMT-DeepLab a obtenu une amélioration significative des performances, tandis que kMaX-DeepLab a non seulement simplifié la modification, mais l'a également améliorée davantage. Le PQ sur l'ensemble COCO val était de 58,0 %, le PQ était de 68,4 % et la moyenne du masque. la précision était de 44,0 % AP), 83,5 % d'intersection moyenne sur l'union (mIoU) sur l'ensemble de validation Cityscapes, sans augmentation du temps de test ni utilisation d'ensembles de données externes.

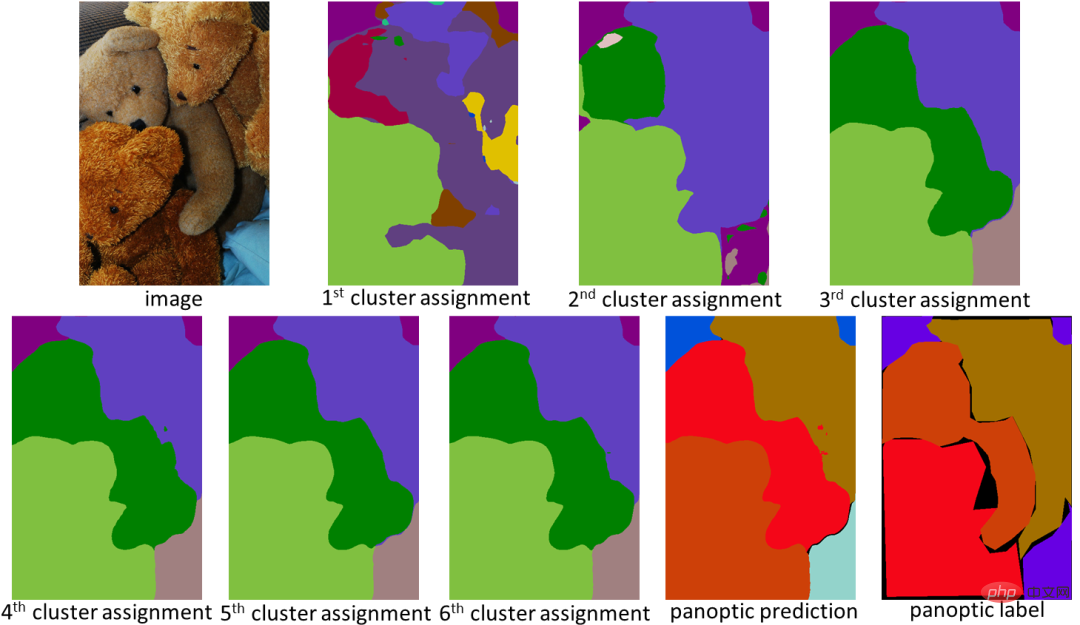

Conçu dans la perspective du clustering, kMaX-DeepLab a non seulement des performances plus élevées, mais peut également visualiser plus raisonnablement la carte d'attention pour comprendre son mécanisme de fonctionnement.

Dans l'exemple ci-dessous, kMaX-DeepLab effectue de manière itérative l'affectation et les mises à jour des clusters, améliorant progressivement la qualité du masque.

La carte d'attention de kMaX-DeepLab peut être directement visualisée sous forme de segmentation panoramique, ce qui rend le mécanisme de fonctionnement du modèle plus raisonnable

Conclusion

Cette recherche démontre une méthode pour mieux concevoir MaskTransformer dans les tâches de vision.

Avec de simples modifications, CMT-DeepLab et kMaX-DeepLab restructurent l'attention croisée pour la faire ressembler davantage à un algorithme de clustering.

Ainsi, le modèle proposé atteint des performances de pointe sur les ensembles de données COCO et Cityscapes.

L'équipe de recherche a déclaré qu'elle espère que la version open source de kMaX-DeepLab dans la bibliothèque DeepLab2 contribuera aux recherches futures sur la conception d'une architecture visuelle de Transformer.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.

La dernière adresse de téléchargement de Bitget en 2025: étapes pour obtenir l'application officielle

Feb 25, 2025 pm 02:54 PM

La dernière adresse de téléchargement de Bitget en 2025: étapes pour obtenir l'application officielle

Feb 25, 2025 pm 02:54 PM

Ce guide fournit des étapes de téléchargement et d'installation détaillées pour l'application officielle Bitget Exchange, adaptée aux systèmes Android et iOS. Le guide intègre les informations de plusieurs sources faisant autorité, y compris le site officiel, l'App Store et Google Play, et met l'accent sur les considérations pendant le téléchargement et la gestion des comptes. Les utilisateurs peuvent télécharger l'application à partir des chaînes officielles, y compris l'App Store, le téléchargement officiel du site Web APK et le saut de site Web officiel, ainsi que des paramètres d'enregistrement, de vérification d'identité et de sécurité. De plus, le guide couvre les questions et considérations fréquemment posées, telles que