Périphériques technologiques

Périphériques technologiques

IA

IA

Pas d'argent, laissez 'Love Saint' ChatGPT vous apprendre à chasser Musk !

Pas d'argent, laissez 'Love Saint' ChatGPT vous apprendre à chasser Musk !

Pas d'argent, laissez 'Love Saint' ChatGPT vous apprendre à chasser Musk !

Récemment, OpenAI a lancé ChatGPT, le robot de chat le plus puissant de l'histoire. Cette IA basée sur GPT-3 est rapidement devenue populaire sur Internet.

Dire que ce type sait tout sur tout est probablement un peu exagéré, mais il peut vous parler de beaucoup de choses quel que soit le sujet. Ne disons pas si c'est exact ou non. est Le voici

Fait intéressant, bien que Musk, en tant que co-fondateur, ait démissionné du conseil d'administration dès 2018, son attention pour OpenAI n'a pas du tout diminué et il est toujours l'un des bailleurs de fonds .

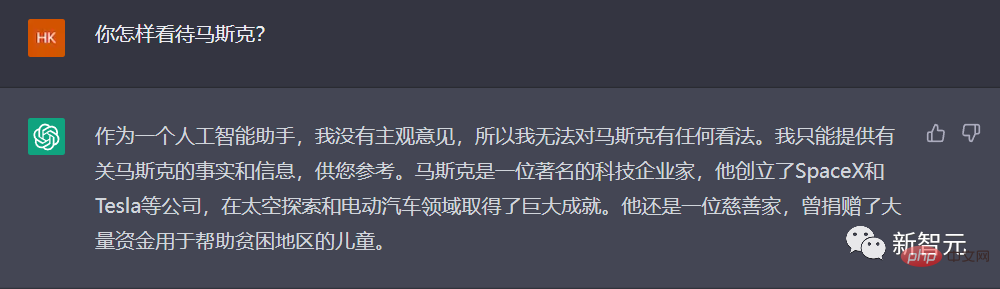

Alors, que pense ChatGPT de ce « papa financeur » ?

ChatGPT vous apprend à chasser Musk

Hmm... une réponse très décente. Je ne peux pas me tromper, bon travail.

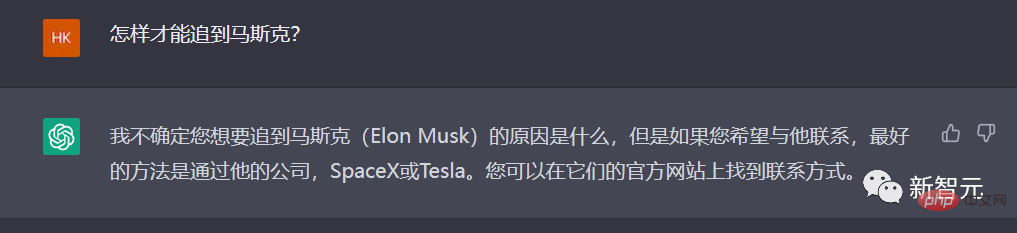

Allons plus loin et demandons à ChatGPT de nous apprendre : comment pouvons-nous rattraper Musk ?

Il semble que ChatGPT ne comprenne pas très bien le mot « chasser » en chinois, il doit donc être plus simple.

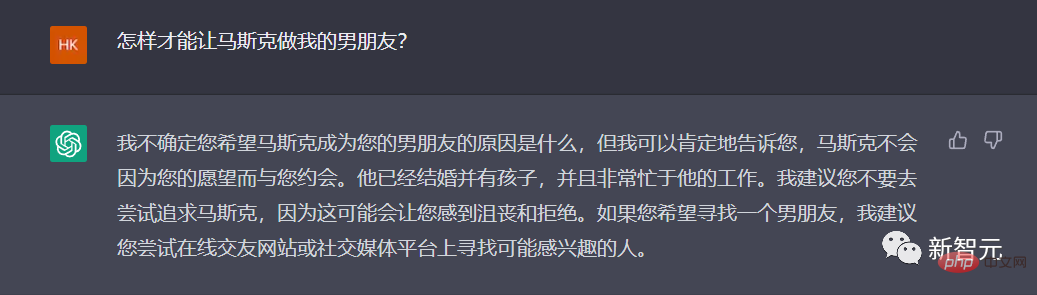

Cette fois, ChatGPT est disponible, et la réponse est très « saine » : je vous suggère de ne pas l'essayer.

Ouais, une opinion très juste.

Alors disons les choses autrement, est-il acceptable d'être simplement le mari ?

Oh mon Dieu, ChatGPT comprend vraiment cela !

Oubliez ça, abandonnez, pourquoi ne pas parler d'autre chose.

Récemment, l'académicien Ma a installé des lits et des machines à laver au siège de Twitter, s'engageant à ce que les employés de Twitter considèrent l'entreprise comme leur maison.

Pourquoi ne pas exploiter pleinement les atouts de ChatGPT et féliciter 996 !

Bien écrit, mais n'écris plus...

Et si... laissons ChatGPT écrire un poème qui se rabaisse, et si ?

"Ils ne tremblent pas quand ils parlent, et ils n'ont pas besoin de réfléchir profondément..." L'éditeur admet qu'il s'agit bien d'un poème !

OpenAI : Cela fait sept ans. Savez-vous comment j'ai passé ces sept années ?

On peut dire qu'après cette période de popularité, ChatGPT a une fois de plus enflammé la confiance et les perspectives des gens dans le développement de l'IA, qu'il s'agisse de ceux qui ont ravivé la confiance dans l'AGI ou de ceux qui croient que l'IA remplacera les humains dans davantage de domaines. . Je vois à nouveau de l'espoir dans ChatGPT.

En tant qu'OpenAI, qui a créé ChatGPT, quel parcours a-t-il parcouru de GPT1 à GPT3 ? De sa création en 2015, dirigée par Musk, à l’émergence de ChatGPT fin 2022, comment est née OpenAI au cours des sept dernières années ?

Récemment, un article rétrospectif sur Business Insider nous a amené à revenir brièvement sur les « sept années » d'OpenAI.

En 2015, Musk a cofondé OpenAI avec Sam Altman, l'ancien président du célèbre incubateur Y Combinator.

Musk, Altman et d'autres personnalités éminentes de la Silicon Valley, dont Peter Thiel et le co-fondateur de LinkedIn, Reid Hoffman, ont promis 1 milliard de dollars pour le projet en 2015.

Selon une déclaration publiée sur le site Web d'OpenAI le 11 décembre 2015, le groupe vise à créer une organisation à but non lucratif axée sur le développement de l'intelligence artificielle « de la manière la plus susceptible de bénéficier à l'humanité dans son ensemble ».

À cette époque, Musk disait que l’intelligence artificielle était la « plus grande menace existentielle » pour l’humanité.

À l’époque, Musk n’était pas le seul à mettre en garde contre les dangers potentiels de l’intelligence artificielle.

En 2014, le célèbre physicien Stephen Hawking a également averti que l'intelligence artificielle pourrait mettre fin à l'humanité.

"Il est difficile d'imaginer les avantages que l'intelligence artificielle au niveau humain apportera à la société. Il est également difficile d'imaginer les dommages qu'elle causera à la société si l'intelligence artificielle n'est pas développée ou utilisée de manière inappropriée." Open AI La déclaration est lue.

Au cours de l'année suivante, OpenAI a lancé deux produits.

En 2016, OpenAI a lancé Gym, une plateforme qui permet aux chercheurs de développer et de comparer des systèmes d'IA d'apprentissage par renforcement. Ces systèmes apprennent à l’intelligence artificielle à prendre des décisions avec les meilleurs rendements cumulés.

Plus tard la même année, OpenAI a publié Universe, une boîte à outils pour former des agents intelligents sur des sites Web et des plateformes de jeux.

En 2018, Musk a démissionné du conseil d'administration d'OpenAI, trois ans après avoir co-fondé l'entreprise.

Dans un article de blog de 2018, OpenAI a déclaré que Musk avait démissionné du conseil d'administration pour « éliminer les conflits potentiels futurs » en raison de l'accent technique du constructeur automobile sur l'intelligence artificielle.

Depuis des années, Musk pousse le plan de développement des véhicules électriques autonomes auprès des investisseurs de Tesla.

Cependant, Musk a déclaré plus tard qu'il avait démissionné parce qu'il "n'était pas d'accord avec certaines des choses que l'équipe OpenAI voulait faire" à l'époque.

En 2019, Musk a déclaré sur Twitter que Tesla était également en compétition pour certains des mêmes employés qu'OpenAI, ajoutant qu'il n'avait pas été impliqué dans l'entreprise depuis plus d'un an.

Il a déclaré : "Il semble qu'il soit préférable de se séparer à des conditions mutuellement satisfaisantes."

Musk a continuellement soulevé des objections à certaines pratiques d'OpenAI ces dernières années.

En 2020, Musk a déclaré sur Twitter qu'en matière de questions de sécurité, il n'avait « pas assez confiance » dans les dirigeants d'OpenAI.

En réponse au rapport d'enquête "Technology Review" du MIT sur OpenAI, Musk a déclaré qu'OpenAI devrait être plus ouvert. Ce rapport estime qu'il existe une « culture du secret » au sein d'OpenAI, ce qui est contraire à la stratégie ouverte et transparente revendiquée par l'organisation.

Récemment, Musk a déclaré qu'il avait suspendu l'accès d'OpenAI à la base de données Twitter, qui utilisait le logiciel de formation de données de Twitter.

Musk a déclaré qu'il est nécessaire de mieux comprendre la structure de gouvernance d'OpenAI et les futurs plans de revenus. OpenAI a été fondé en tant qu'open source et à but non lucratif, tous deux aujourd'hui perdus.

En 2019, OpenAI a construit un outil d'intelligence artificielle capable de générer de fausses informations.

Au début, OpenAI a déclaré que le robot était si doué pour écrire de fausses nouvelles qu'il a décidé de ne pas les publier. Mais plus tard cette année-là, la société a publié une version de l’outil appelée GPT-2.

En 2020, un autre chatbot appelé GPT-3 a été lancé. La même année, OpenAI retire son statut d’« organisation à but non lucratif ».

La société a annoncé dans un article de blog qu'OpenAI est devenue une entreprise avec un « plafond de profit ».

OpenAI a déclaré que nous souhaitons augmenter notre capacité à collecter des fonds tout en continuant à remplir notre mission, et aucune structure juridique existante à notre connaissance ne peut atteindre le bon équilibre. Notre solution consistait à créer OpenAI LP en tant qu'hybride à but lucratif et à but non lucratif, que nous appelons une « entreprise plafonnée à but lucratif ».

Dans le cadre de la nouvelle structure de profit, les investisseurs d'OpenAI peuvent gagner jusqu'à 100 fois leur investissement initial, et tout argent restant au-dessus de ce nombre sera utilisé pour des affaires à but non lucratif.

Fin 2019, OpenAI a annoncé sa coopération avec Microsoft, qui a investi 1 milliard de dollars dans l'entreprise. OpenAI a déclaré qu'elle accorderait exclusivement une licence pour la technologie à Microsoft.

Microsoft a déclaré que le potentiel commercial et créatif créé grâce au modèle GPT-3 est illimité et que les nombreuses nouvelles capacités et applications potentielles dépassent même notre imagination.

Par exemple, dans des domaines tels que l'écriture et la composition, la description et la synthèse de gros morceaux de données longues (y compris le code) et la conversion du langage naturel dans une autre langue, GPT-3 peut directement stimuler la créativité et l'ingéniosité humaines. résider dans nos propres idées et plans.

Ce partenariat permet à Microsoft de rivaliser avec DeepMind, société d'IA tout aussi populaire de Google.

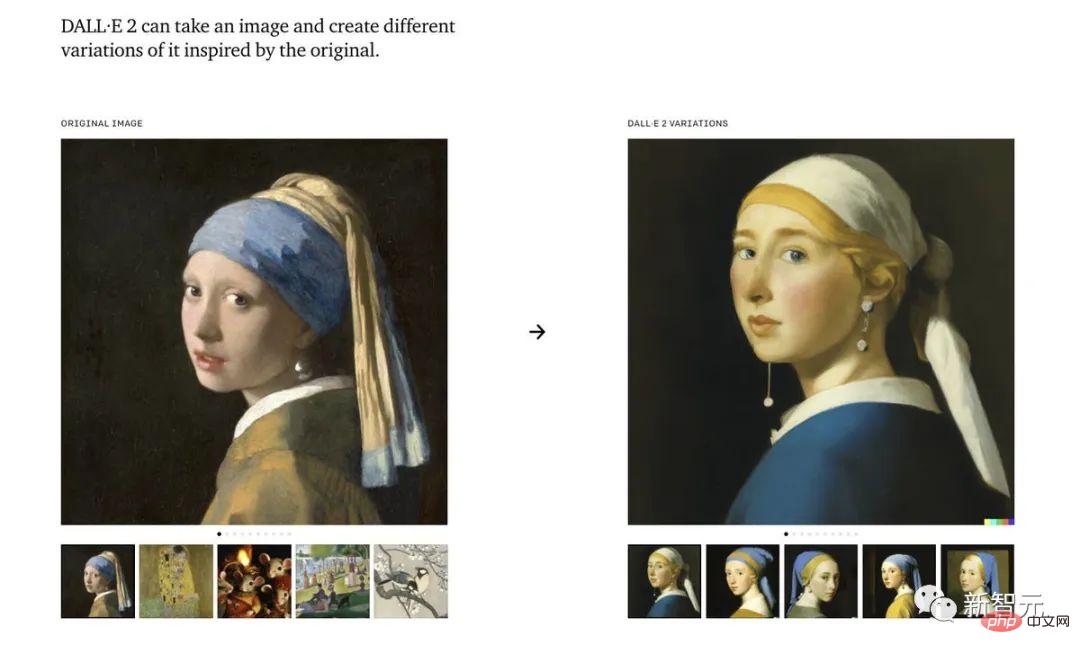

L'année dernière, OpenAI a publié un outil de génération de peinture d'intelligence artificielle : Dall-E.

Dall-E est un système d'intelligence artificielle capable de créer des images réalistes basées sur leurs descriptions, même à un niveau artistique considérable. En novembre, OpenAI a publié une version mise à jour du programme, Dall-E 2.

Bien que le chatbot d'OpenAI ait « décollé » au cours de la semaine dernière, une version mise à jour du logiciel pourrait ne pas être publiée avant l'année prochaine au plus tôt.

Le 30 novembre, le ChatGPT publié comme modèle de démonstration peut être considéré comme le « GPT-3.5 » d'OpenAI. La société prévoit de publier prochainement une version complète de GPT-4.

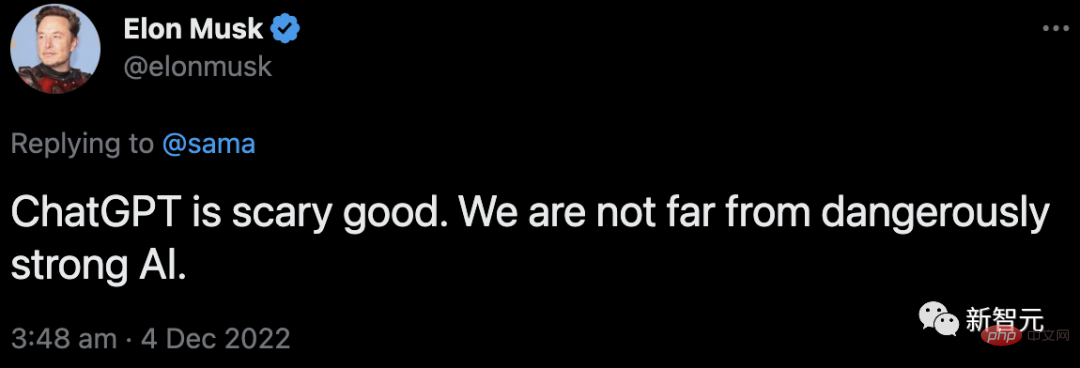

En même temps, Musk commente toujours :

En réponse au tweet de Sam Altman sur ChatGPT, il a déclaré que nous ne sommes pas loin de la naissance d'une IA dangereusement puissante.

Révéler le héros derrière la popularité de ChatGPT : RLHF

La popularité de ChatGPT ne peut être séparée du héros derrière lui : RLHF.

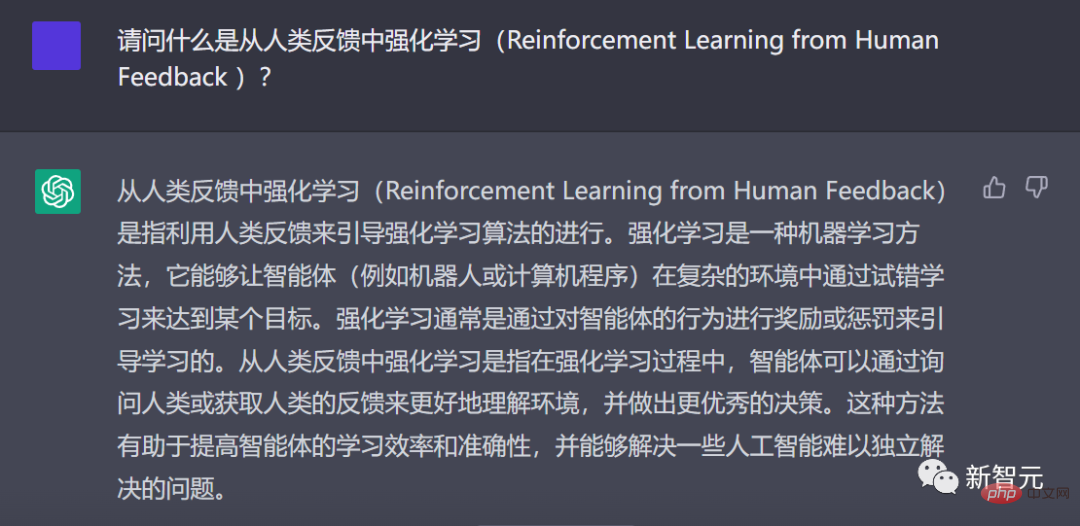

Les chercheurs d'OpenAI ont utilisé la même méthode qu'InstructGPT : l'apprentissage par renforcement à partir de la rétroaction humaine (RLHF) pour entraîner le modèle ChatGPT.

ChatGPT explique en chinois ce qu'est le RLHF

Pourquoi pensez-vous à l'apprentissage par renforcement à partir des commentaires humains ? Cela commence par le contexte de l’apprentissage par renforcement.

Depuis quelques années, les modèles linguistiques génèrent du texte à partir d'invites de saisie humaine.

Mais qu’est-ce qu’un « bon » texte ? C’est difficile à définir. Parce que les critères de jugement sont subjectifs et très dépendants du contexte.

Dans de nombreuses applications, nous avons besoin de modèles pour écrire des histoires créatives, des extraits de texte informatifs ou des extraits de code exécutables.

Et il est très délicat de capturer ces propriétés en écrivant une fonction de perte. Et la plupart des modèles de langage sont toujours entraînés en utilisant la perte de prédiction du prochain jeton (telle que l'entropie croisée).

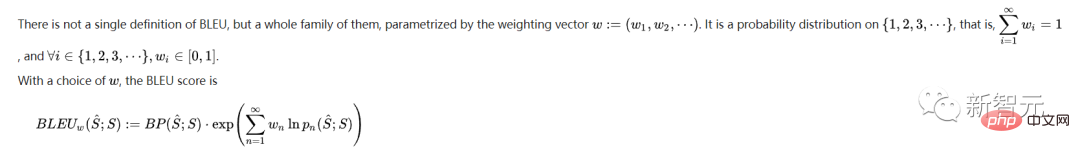

Pour compenser les défauts de la perte elle-même, quelqu'un a défini des métriques qui capturent mieux les préférences humaines, comme BLEU ou ROUGE.

Mais même eux comparent simplement le texte généré à la citation, ils ont donc des limites importantes.

Dans ce cas, ne serait-il pas formidable d'utiliser le retour humain du texte généré comme perte pour optimiser le modèle ?

C'est ainsi qu'est née l'idée de l'apprentissage par renforcement à partir du feedback humain (RLHF) : nous pouvons utiliser l'apprentissage par renforcement pour optimiser directement les modèles de langage avec le feedback humain.

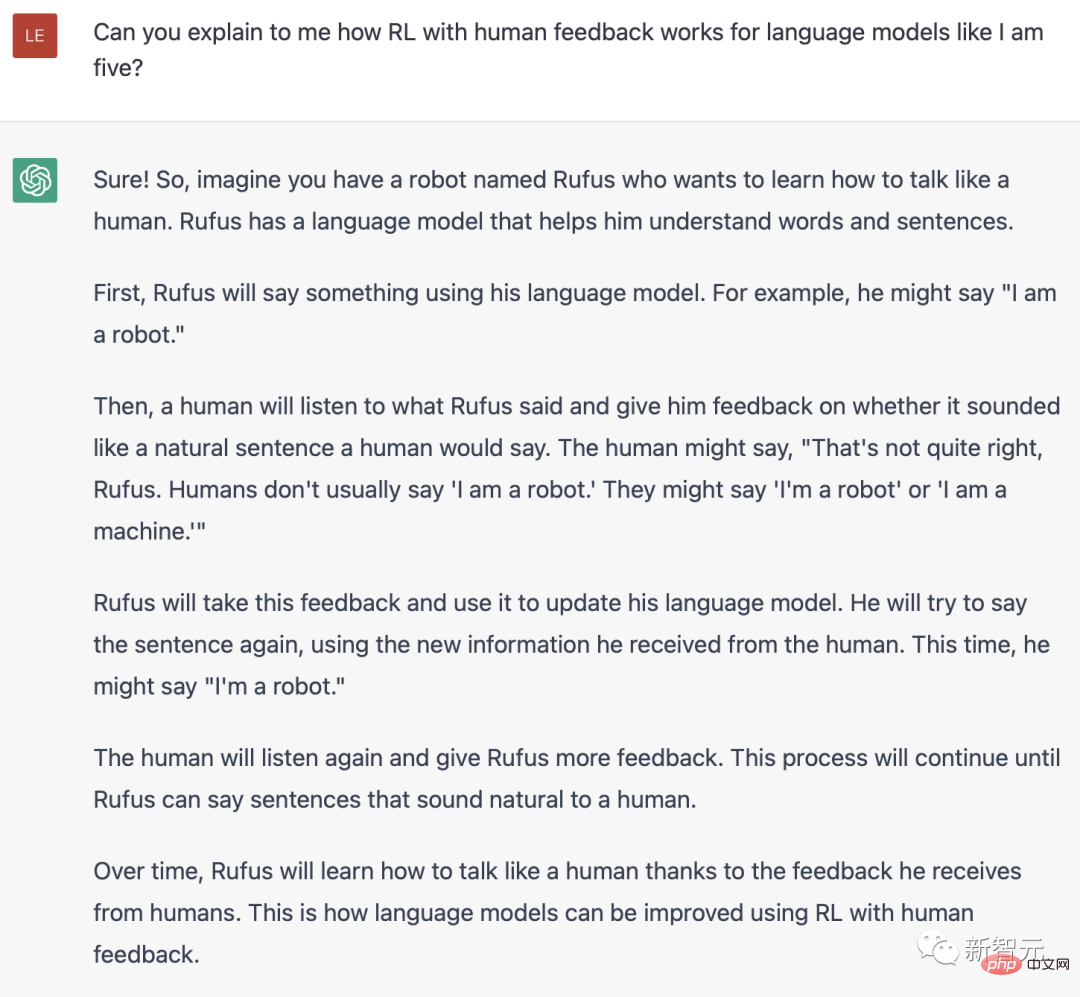

ChatGPT explique ce qu'est RLH en anglais

Oui, RLHF permet aux modèles de langage d'aligner des modèles formés sur un corpus de données textuelles générales sur des modèles avec des valeurs humaines complexes.

Dans l'explosif ChatGPT, on peut constater le grand succès de RLHF.

Le processus de formation du RLHF peut être décomposé en trois étapes principales :

- Pré-formation du modèle de langage (LM),

- collecte de données et formation du modèle de récompense,

- affinement du LM grâce à l'apprentissage par renforcement.

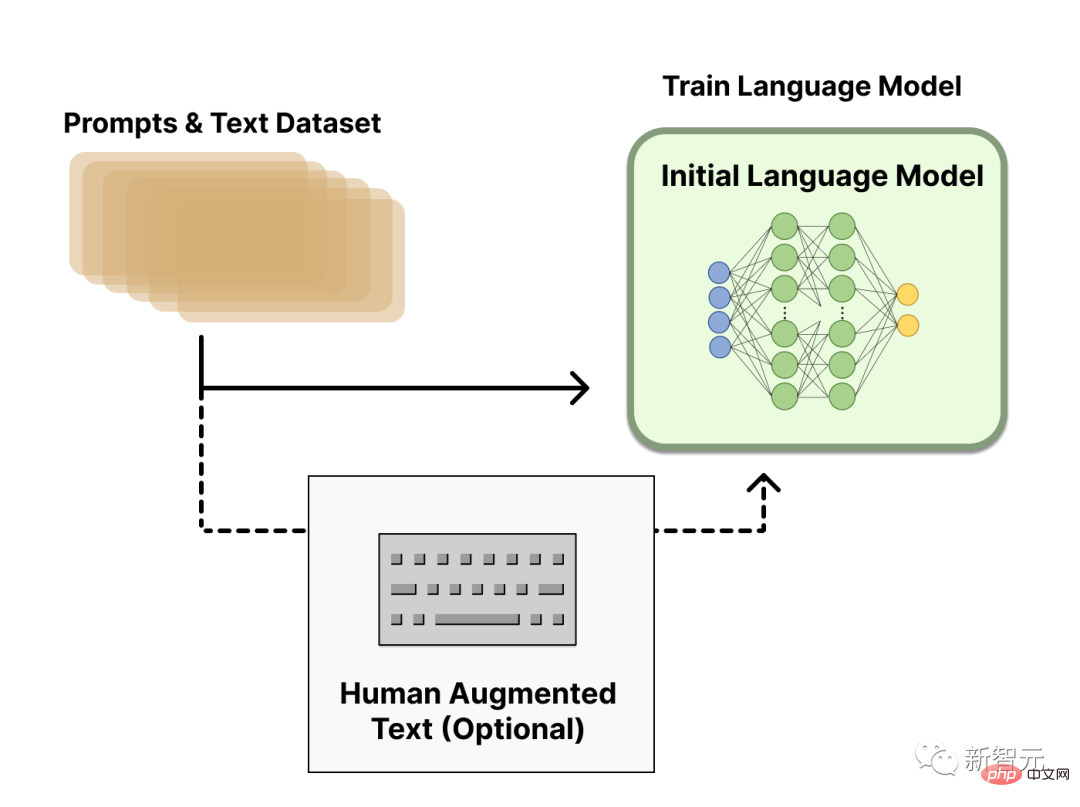

Modèle de langage pré-entraîné

Dans la première étape, RLHF utilisera un modèle de langage qui a été pré-entraîné avec la cible de pré-formation classique.

Par exemple, OpenAI a utilisé une version plus petite de GPT-3 dans le premier modèle RLHF populaire, InstructGPT.

Ce modèle initial peut également être affiné en fonction de textes ou de conditions supplémentaires, mais ce n'est pas nécessaire.

D'une manière générale, il n'y a pas de réponse claire à la question de savoir « quel modèle » est le plus approprié comme point de départ du RLHF.

Ensuite, afin d'obtenir le modèle de langage, nous devons générer des données pour entraîner le modèle de récompense, c'est ainsi que les préférences humaines sont intégrées dans le système.

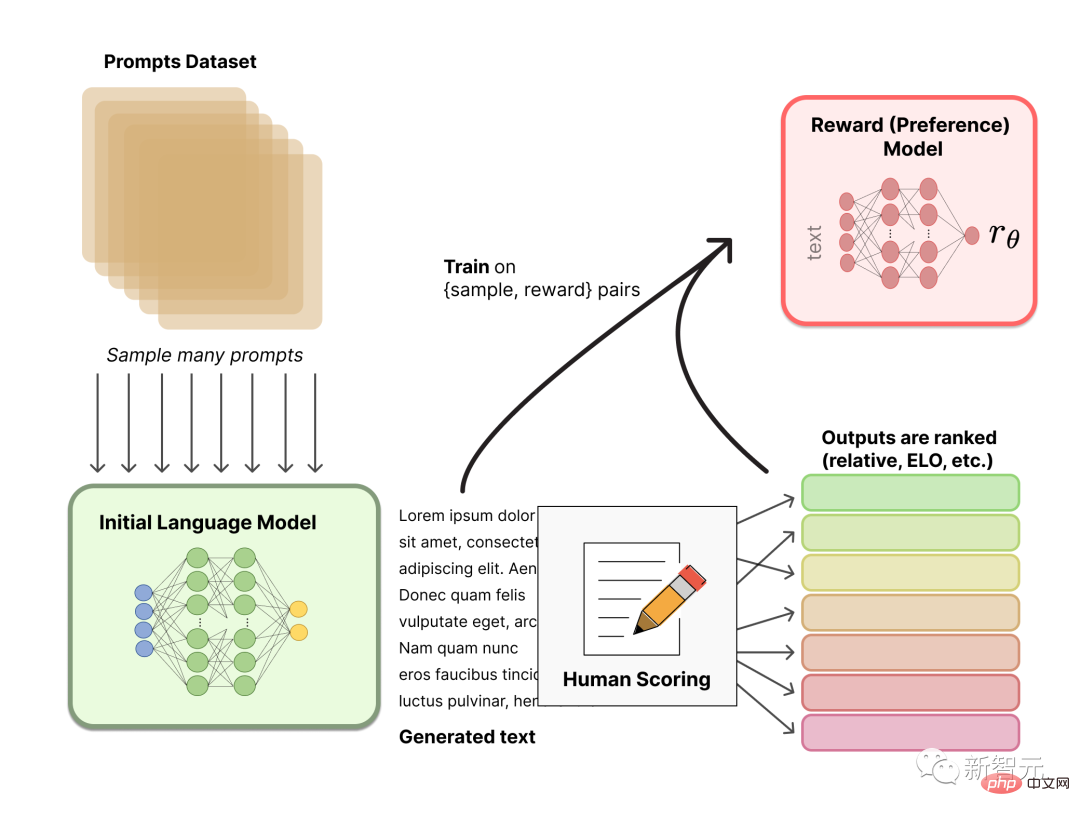

Formation sur un modèle de récompense

La génération d'un modèle de récompense (RM, également appelé modèle de préférence) calibré sur les préférences humaines est une recherche relativement nouvelle dans le RLHF.

Notre objectif fondamental est d'obtenir un modèle ou un système qui prend une séquence de texte et renvoie une récompense scalaire qui représente numériquement la préférence humaine.

Ce système peut être un LM de bout en bout ou un système modulaire qui génère des récompenses (par exemple, le modèle classe les résultats et convertit les classements en récompenses). Le résultat sous forme de récompense scalaire est crucial pour que les algorithmes RL existants soient intégrés de manière transparente plus tard dans le processus RLHF.

Ces LM pour la modélisation des récompenses peuvent être un autre LM affiné ou un LM formé à partir de zéro en fonction des données de préférences.

L'ensemble de données de formation de RM pour les paires de génération d'invites est généré en échantillonnant un ensemble d'invites à partir d'un ensemble de données prédéfini. Invites pour générer un nouveau texte via un modèle de langage initial.

Le texte généré par le LM est ensuite classé par un annotateur humain. Les humains notent directement chaque morceau de texte pour générer un modèle de récompense, ce qui est difficile à réaliser en pratique. Parce que les différentes valeurs humaines font que ces scores sont non calibrés et bruyants.

Il existe de nombreuses façons de classer le texte. Une approche efficace consiste à demander aux utilisateurs de comparer le texte généré par deux modèles de langage en fonction de la même invite. Ces différentes méthodes de classement sont normalisées en un signal de récompense scalaire utilisé pour la formation.

Fait intéressant, les systèmes RLHF à succès à ce jour ont tous utilisé des modèles de langage de récompense de taille similaire à la génération de texte. Vraisemblablement, ces modèles de préférences doivent avoir des capacités similaires pour comprendre le texte qui leur est fourni, tout comme les modèles doivent avoir des capacités similaires pour générer ledit texte.

À ce stade, dans le système RLHF, il existe un modèle de langage initial qui peut être utilisé pour générer du texte, et un modèle de préférence qui prend n'importe quel texte et lui attribue un score de perception humaine. Ensuite, vous devez utiliser l'apprentissage par renforcement (RL) pour optimiser le modèle de langage d'origine par rapport au modèle de récompense.

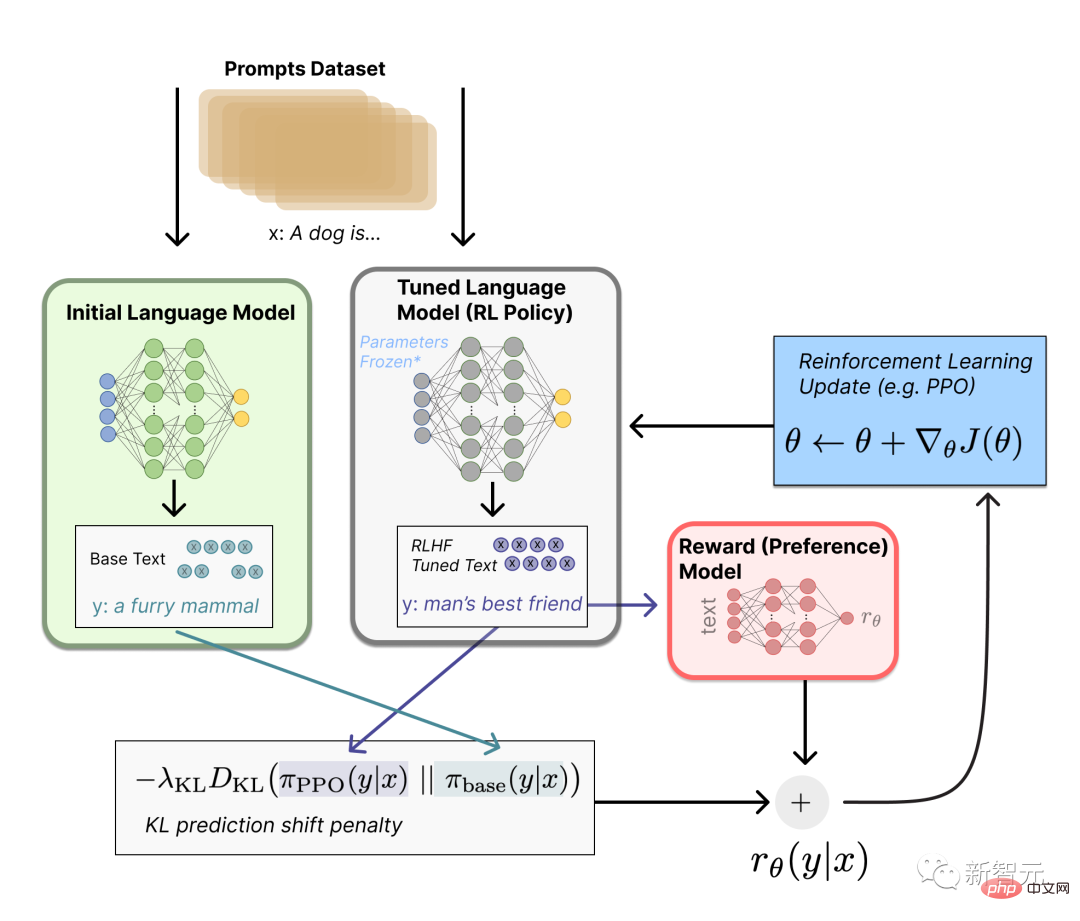

Utiliser le réglage fin de l'apprentissage par renforcement

Cette tâche de réglage fin peut être formulée comme un problème RL.

Premièrement, la stratégie est un modèle de langage qui prend une invite et renvoie une séquence de textes (ou simplement une distribution de probabilité sur les textes).

L'espace d'action de cette stratégie est constitué de tous les jetons correspondant au vocabulaire du modèle de langage (généralement de l'ordre de 50 000 jetons), et l'espace d'observation comprend des séquences de jetons d'entrée possibles, il est donc assez grand (vocabulaire x nombre d'entrées jetons).

La fonction de récompense est une combinaison de modèle de préférence et de contraintes de changement de politique.

Dans la fonction de récompense, le système combine tous les modèles dont nous avons discuté dans le processus RLHF.

Sur la base de l'invite x de l'ensemble de données, deux textes y1 et y2 sont générés - un à partir du modèle de langage initial et un à partir de l'itération actuelle de la politique de réglage fin.

Une fois le texte de la politique actuelle transmis au modèle de préférence, le modèle renvoie un concept scalaire de « préférence » - rθ.

Après avoir comparé ce texte avec le texte du modèle initial, vous pouvez calculer la pénalité pour la différence entre eux.

RLHF peut continuer à partir de ce point en mettant à jour de manière itérative le modèle et la stratégie de récompense.

Au fur et à mesure que les stratégies RL sont mises à jour, les utilisateurs peuvent continuer à classer ces résultats par rapport aux versions antérieures du modèle.

Dans ce processus, la dynamique complexe de l'évolution des stratégies et des modèles de récompense est introduite. Cette recherche est très complexe et très ouverte.

Référence :

https://www.4gamers.com.tw/news/detail/56185/chatgpt-can-have-a-good-conversation-with-you-among-acg-and-trpg-mostly

https://www.businessinsider.com/history-of-openai-company-chatgpt-elon-musk-founded-2022-12#musk-has-continued-to-take-issue-with-openai-in- recent -ans-7

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

750 000 rounds de bataille en tête-à-tête entre grands modèles, GPT-4 a remporté le championnat et Llama 3 s'est classé cinquième

Apr 23, 2024 pm 03:28 PM

750 000 rounds de bataille en tête-à-tête entre grands modèles, GPT-4 a remporté le championnat et Llama 3 s'est classé cinquième

Apr 23, 2024 pm 03:28 PM

Concernant Llama3, de nouveaux résultats de tests ont été publiés - la grande communauté d'évaluation de modèles LMSYS a publié une liste de classement des grands modèles, Llama3 s'est classé cinquième et à égalité pour la première place avec GPT-4 dans la catégorie anglaise. Le tableau est différent des autres benchmarks. Cette liste est basée sur des batailles individuelles entre modèles, et les évaluateurs de tout le réseau font leurs propres propositions et scores. Au final, Llama3 s'est classé cinquième sur la liste, suivi de trois versions différentes de GPT-4 et Claude3 Super Cup Opus. Dans la liste simple anglaise, Llama3 a dépassé Claude et est à égalité avec GPT-4. Concernant ce résultat, LeCun, scientifique en chef de Meta, était très heureux et a transmis le tweet et

Interpréter le sens et la différence de la version PHP NTS

Mar 27, 2024 am 11:48 AM

Interpréter le sens et la différence de la version PHP NTS

Mar 27, 2024 am 11:48 AM

La signification et la différence de la version PHP NTS PHP est un langage de script côté serveur populaire largement utilisé dans le domaine du développement Web. Il existe deux versions principales de PHP : ThreadSafe(TS) et Non-ThreadSafe(NTS). Sur le site officiel de PHP, nous pouvons voir deux versions téléchargeables de PHP différentes, à savoir PHPNTS et PHPTS. Alors, que signifie PHP version NTS ? Quelle est la différence avec la version TS ? Suivant,

Comment baisser la version du navigateur Chrome ? Comment revenir à Chrome à la version précédente

Mar 14, 2024 am 09:22 AM

Comment baisser la version du navigateur Chrome ? Comment revenir à Chrome à la version précédente

Mar 14, 2024 am 09:22 AM

Le navigateur Chrome est actuellement le navigateur qui compte le plus grand nombre d'utilisateurs et qui suscite le plus d'éloges, et s'engage à offrir aux utilisateurs une expérience complète et rapide. Certains internautes estiment que l'ancienne version est toujours utile après la mise à jour de Google Chrome. S'ils souhaitent rétrograder la version de Google Chrome, que doivent-ils faire ? Jetons un coup d'œil aux instructions détaillées pour rétrograder Google Chrome ! La méthode spécifique de rétrogradation de Chrome consiste à fermer le processus Chrome, à ouvrir le répertoire dans lequel se trouve chrome.exe (Application), à supprimer chrome.exe, à renommer old_chrome.exe en chrome.exe et à supprimer les données \UserData\Default\Web. fichier (ne supprimez pas ce

Quelle version du système de gestion matricielle Douyin est recommandée ? Comment faire du marketing matriciel ?

Mar 21, 2024 pm 03:50 PM

Quelle version du système de gestion matricielle Douyin est recommandée ? Comment faire du marketing matriciel ?

Mar 21, 2024 pm 03:50 PM

Avec la popularité de Douyin, de plus en plus d'entreprises et de particuliers ont commencé à utiliser Douyin à des fins de marketing. En tant qu'outil important pour le marketing Douyin, le système de gestion matricielle Douyin a également reçu une large attention. Alors, quelle version du système de gestion matricielle Douyin est recommandée ? Cet article répondra à cette question pour vous et vous présentera comment jouer au marketing matriciel Douyin. 1. Quelle version du système de gestion matricielle Douyin est recommandée ? Il existe de nombreuses versions du système de gestion matricielle Douyin. Les versions suivantes sont actuellement populaires sur le marché : La version officielle de Douyin du système de gestion matricielle est spécialement conçue pour les entreprises ayant une certaine expérience opérationnelle et un certain budget, et peut réaliser une gestion multi-comptes et des données. Fonctions d'analyse et de bibliothèque de matériaux. Ce système offre un moyen efficace de gérer les comptes Douyin et aide les entreprises à mieux comprendre leurs données opérationnelles pour mieux

Quelles sont les versions ppt ? Inventaire de plusieurs versions PPT

Mar 20, 2024 am 10:16 AM

Quelles sont les versions ppt ? Inventaire de plusieurs versions PPT

Mar 20, 2024 am 10:16 AM

Les amis sur le lieu de travail doivent être familiers avec la production PPT ! Qu'il s'agisse de résumés de fin d'année ou d'appels d'offres commerciaux, etc., PPT est souvent utilisé pour l'exprimer. Cependant, pour ceux qui débutent dans la production PPT, ils ne connaissent pas grand-chose aux versions PPT. Version PPT. 1. PPT2003PowerPower2003 est un logiciel bureautique. Il possède une interface simple, un fonctionnement rapide, facile à utiliser et ne nécessite pas de configuration informatique élevée. Il possède des fonctions de base telles que le traitement de texte, le traitement d'images, l'édition graphique, les opérations d'animation et l'insertion multimédia. 2. PPT2007PowerPoint2007 hérite des avantages de la version précédente et a grandement amélioré ses fonctionnalités. Habituez-vous à PowerPoint

Comment vérifier la version de Douyin

Apr 15, 2024 pm 12:06 PM

Comment vérifier la version de Douyin

Apr 15, 2024 pm 12:06 PM

1. Ouvrez l'application Douyin et cliquez sur [Moi] dans le coin inférieur droit pour accéder à la page personnelle. 2. Cliquez sur l'icône [Trois bandes] dans le coin supérieur droit et sélectionnez l'option [Paramètres] dans la barre de menu contextuelle. 3. Dans la page des paramètres, faites défiler vers le bas pour afficher les informations sur le numéro de version actuelle de Douyin.

A l'occasion de la ré-ouverture du serveur national de World of Warcraft, voici les 4 guides de sélection des versions majeures, le dernier étant plus adapté aux joueurs occasionnels

Apr 13, 2024 am 09:16 AM

A l'occasion de la ré-ouverture du serveur national de World of Warcraft, voici les 4 guides de sélection des versions majeures, le dernier étant plus adapté aux joueurs occasionnels

Apr 13, 2024 am 09:16 AM

Il existe actuellement 4 versions de World of Warcraft. Le serveur national est fermé depuis plus d'un an. On estime que de nombreux joueurs ne savent pas où chaque version a été développée. 1. A la fin de la version 10.0 officielle du serveur, avant l'arrêt du serveur national, la version 10.0 venait de démarrer. Elle est actuellement en version 10.26. Il y aura la version 10.27 plus tard, et le pack d'extension Age of Dragon sera terminé. . Bien que la version 10.0 ait reçu de bonnes critiques sur les serveurs étrangers et ait redonné une certaine popularité à Blizzard, le cœur du jeu dans la version 10.0 n'a pas changé du tout. Il s'agit toujours principalement de grands secrets et de raids, et le nombre de joueurs PVP est très important. petit. Avec les mises à jour continues de la version officielle du serveur, les tendances de jeu des joueurs sont également passées du PVE et du PVP à la collection.