Périphériques technologiques

Périphériques technologiques

IA

IA

Présentation : Technologie de détection collaborative pour la conduite autonome

Présentation : Technologie de détection collaborative pour la conduite autonome

Présentation : Technologie de détection collaborative pour la conduite autonome

Article de synthèse arXiv « Collaborative Perception for Autonomous Driving : Current Status and Future Trend », 23 août 2022, Université Jiao Tong de Shanghai.

La perception est l'un des modules clés du système de conduite autonome. Cependant, les capacités limitées des vélos créent un goulot d'étranglement pour améliorer les performances de perception. Afin de briser les limites de la perception unique, une perception collaborative est proposée pour permettre aux véhicules de partager des informations et de percevoir l'environnement en dehors de la ligne de vue et en dehors du champ de vision. Cet article passe en revue les travaux prometteurs liés à la technologie de détection collaborative, y compris les concepts de base, les modèles collaboratifs ainsi que les éléments et applications clés. Enfin, les défis et les problèmes ouverts dans ce domaine de recherche sont discutés et d'autres orientations sont données.

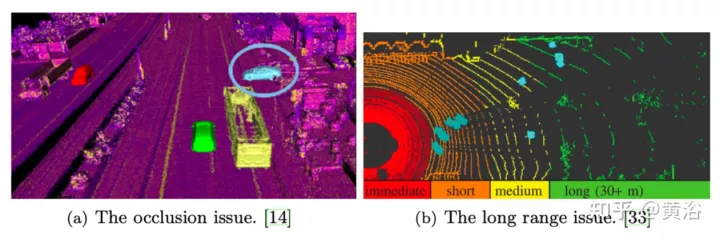

Comme le montre la figure, deux problèmes importants liés à la perception unique sont l'occlusion à longue portée et la rareté des données. La solution à ces problèmes est que les véhicules situés dans la même zone partagent entre eux des informations de perception communes (CPM, message de perception collective) et perçoivent l'environnement de manière collaborative, ce que l'on appelle détection collaborative ou détection coopérative.

Grâce à la construction d'infrastructures de communication et au développement de technologies de communication telles que V2X, les véhicules peuvent échanger des informations de manière fiable, réalisant ainsi une collaboration. Des travaux récents ont montré que la détection collaborative entre véhicules peut améliorer la précision de la perception environnementale ainsi que la robustesse et la sécurité des systèmes de transport.

De plus, les véhicules autonomes sont souvent équipés de capteurs haute fidélité pour une perception fiable, ce qui entraîne des coûts élevés. La détection collaborative peut alléger les exigences strictes d'un seul véhicule en matière d'équipement de détection.

La détection coopérative partage des informations avec les véhicules et les infrastructures à proximité, permettant aux véhicules autonomes de surmonter certaines limitations de perception telles que l'occlusion et le champ de vision court. Cependant, pour parvenir à une détection collaborative robuste et en temps réel, il faut résoudre certains problèmes liés à la capacité de communication et au bruit. Récemment, certains travaux ont étudié les stratégies de détection collaborative, notamment ce qu'est la collaboration, quand collaborer, comment collaborer, l'alignement des informations partagées, etc.

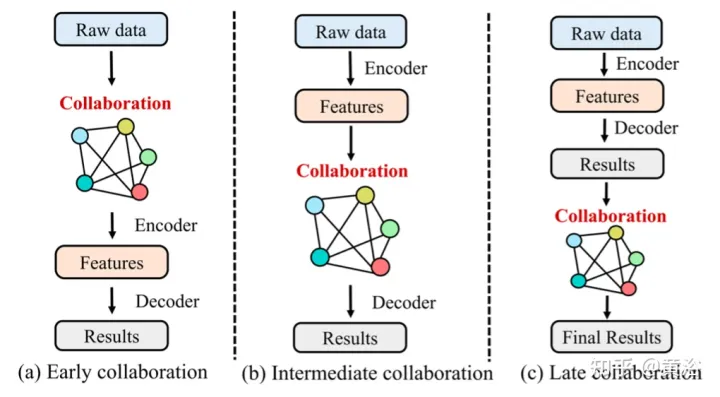

Semblable à la fusion, il existe 4 catégories de collaboration :

1 Collaboration précoce

La collaboration précoce collabore dans l'espace d'entrée, partageant des données sensorielles brutes entre les véhicules et l'infrastructure. Il regroupe les mesures brutes de tous les véhicules et infrastructures pour obtenir une vue globale. Par conséquent, chaque véhicule peut effectuer le traitement suivant et compléter la perception sur la base de la perspective globale, ce qui peut fondamentalement résoudre les problèmes d'occlusion et de longue distance qui surviennent dans la perception unique.

Cependant, le partage de données sensorielles brutes nécessite une communication étendue et encombre facilement le réseau de communication avec une charge de données excessive, ce qui entrave son application pratique dans la plupart des cas.

2. Collaboration tardive

La collaboration tardive collabore dans l'espace de sortie, ce qui favorise la fusion des résultats de perception produits par chaque agent et permet le raffinement.

Bien que la collaboration à un stade avancé soit économique en termes de bande passante, elle est très sensible aux erreurs de positionnement des agents et souffre d'erreurs d'estimation élevées et de bruit dus à des observations locales incomplètes.

3 Collaboration intermédiaire

La collaboration intermédiaire effectue une collaboration dans l'espace de fonctionnalités intermédiaire. Il est capable de transmettre des caractéristiques intermédiaires générées par des modèles de prédiction d'agents individuels. Après avoir fusionné ces caractéristiques, chaque agent décode les caractéristiques fusionnées et produit un résultat perceptuel. Conceptuellement, les informations représentatives peuvent être compressées dans ces fonctionnalités, économisant ainsi la bande passante de communication par rapport à une collaboration précoce et améliorant la perception par rapport à une collaboration tardive.

En pratique, la conception de cette stratégie collaborative est un défi algorithmique sous deux aspects : i) comment sélectionner les fonctionnalités les plus efficaces et les plus compactes à partir des mesures originales pour la transmission et ii) comment maximiser l'intégration d'autres renseignements. Les caractéristiques de le corps pour améliorer la capacité de perception de chaque corps intelligent.

4 Synergie Hybride

Comme mentionné ci-dessus, chaque mode de synergie a ses avantages et ses inconvénients. Par conséquent, certains travaux adoptent une collaboration hybride, combinant deux ou plusieurs modes de collaboration pour optimiser les stratégies de collaboration.

Les principaux facteurs de co-conscience comprennent :

1 Graphe de collaboration

Le graphe est un outil puissant pour la modélisation de co-conscience car il modélise des structures de données non euclidiennes avec une bonne interprétabilité. Dans certains travaux, les véhicules participant à la détection collaborative forment un graphe collaboratif complet, dans lequel chaque véhicule est un nœud et la relation collaborative entre deux véhicules est la limite entre les deux nœuds.

2 Pose Alignment

Étant donné que la détection collaborative nécessite la fusion de données provenant de véhicules et d'infrastructures situés à différents endroits et à différents moments, il est essentiel d'obtenir un alignement précis des données pour une collaboration réussie.

3 Fusion d'informations

La fusion d'informations est le composant central du système multi-agents, et son objectif est de fusionner la plus grande partie des informations provenant d'autres agents de manière efficace.

4 Allocation de ressources basée sur l'apprentissage par renforcement

La bande passante de communication limitée dans les environnements réels nécessite la pleine utilisation des ressources de communication disponibles, ce qui rend l'allocation des ressources et le partage du spectre très importants. Dans les environnements de communication véhiculaires, l'évolution rapide des conditions des canaux et la demande croissante de services rendent l'optimisation des problèmes d'allocation très complexe et difficile à résoudre à l'aide des méthodes d'optimisation traditionnelles. Certains travaux utilisent l'apprentissage par renforcement multi-agents (MARL) pour résoudre des problèmes d'optimisation.

Applications de la détection collaborative :

1 Détection de cibles 3D

La détection de cibles 3D basée sur un nuage de points lidar est le problème le plus préoccupant dans la recherche en détection collaborative. Les raisons sont les suivantes : i) Les nuages de points LiDAR ont plus de dimensions spatiales que les images et les vidéos. ii) Les nuages de points LiDAR peuvent conserver dans une certaine mesure des informations personnelles, telles que les visages et les numéros de plaque d'immatriculation. iii) Les données de nuages de points sont un type de données approprié pour la fusion car elles perdent moins de pixels lorsqu'elles sont alignées à partir de différentes poses. iv) La détection d'objets 3D est une tâche fondamentale pour la perception de la conduite autonome, sur laquelle reposent de nombreuses tâches telles que le suivi et la prédiction de mouvement.

2 Segmentation sémantique

La segmentation sémantique des scènes 3D est également une tâche clé requise pour la conduite autonome. Segmentation sémantique collaborative d'objets de scène 3D. À partir d'observations de scènes 3D (images, nuages de points lidar, etc.) provenant de plusieurs agents, un masque de segmentation sémantique est généré pour chaque agent.

Problèmes difficiles :

1 Robustesse de la communication

Une co-unification efficace repose sur une communication fiable entre les agents. Cependant, la communication n'est pas parfaite en pratique : i) à mesure que le nombre de véhicules dans le réseau augmente, la bande passante de communication disponible de chaque véhicule est limitée ii) en raison des inévitables retards de communication, il est difficile pour les véhicules de recevoir des informations en temps réel ; provenant d'autres véhicules ; iii) la communication peut parfois être interrompue, entraînant une interruption de la communication ; iv) la communication V2X est endommagée et des services fiables ne peuvent pas toujours être fournis ; Bien que les technologies de communication continuent de se développer et que la qualité des services de communication continue de s'améliorer, les problèmes ci-dessus persisteront pendant longtemps. Cependant, la plupart des travaux existants supposent que les informations peuvent être partagées en temps réel et sans perte. Il est donc très important de poursuivre les travaux afin de prendre en compte ces contraintes de communication et de concevoir des systèmes de détection collaboratifs robustes.

2 Hétérogénéité et multimodalité

La plupart des travaux de perception co-unifiée se concentrent sur la perception basée sur des nuages de points LiDAR. Cependant, il existe de nombreux autres types de données disponibles pour la détection, telles que des images et des nuages de points radar à ondes millimétriques. Il s’agit d’un moyen potentiel d’exploiter les données des capteurs multimodaux pour une collaboration plus efficace. De plus, dans certains scénarios, il existe différents niveaux de véhicules autonomes fournissant différentes qualités d’informations. Par conséquent, la manière de collaborer dans des réseaux de véhicules hétérogènes constitue un problème pour une application pratique ultérieure de la détection collaborative. Malheureusement, peu de travaux se concentrent sur la détection collaborative hétérogène et multimodale, ce qui constitue également un défi ouvert.

3 Ensembles de données à grande échelle

Le développement d'ensembles de données à grande échelle et de méthodes d'apprentissage en profondeur a amélioré les performances perceptuelles. Cependant, les ensembles de données existants dans le domaine de la recherche collaborative en matière de détection sont soit de petite taille, soit non accessibles au public.

Le manque d’ensembles de données publics à grande échelle entrave le développement ultérieur de la détection collaborative. De plus, la plupart des ensembles de données sont basés sur des simulations. Bien que la simulation soit un moyen économique et sûr de vérifier les algorithmes, des ensembles de données réelles sont également nécessaires pour appliquer la détection collaborative dans la pratique.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Au cours du mois dernier, pour des raisons bien connues, j'ai eu des échanges très intensifs avec divers professeurs et camarades de classe du secteur. Un sujet inévitable dans l'échange est naturellement le populaire Tesla FSDV12 de bout en bout. Je voudrais profiter de cette occasion pour trier certaines de mes pensées et opinions en ce moment pour votre référence et votre discussion. Comment définir un système de conduite autonome de bout en bout et quels problèmes devraient être résolus de bout en bout ? Selon la définition la plus traditionnelle, un système de bout en bout fait référence à un système qui saisit les informations brutes des capteurs et génère directement les variables pertinentes pour la tâche. Par exemple, en reconnaissance d'images, CNN peut être appelé de bout en bout par rapport à la méthode traditionnelle d'extraction de caractéristiques + classificateur. Dans les tâches de conduite autonome, saisir les données de divers capteurs (caméra/LiDAR

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.