Depuis que New Bing a lancé un test interne à grande échelle, les internautes ont découvert que par rapport au ChatGPT restreint, les réponses de New Bing sont vraiment trop sauvages, comme annoncer un amour inutile et encourager les gens à divorcer, faire chanter les utilisateurs, enseigner aux gens comment commettre des crimes, etc.

On peut dire que Microsoft a conservé la capacité de "charabia" d'une partie du modèle de langage, afin que vous sachiez que vous n'utilisez pas ChatGPT, mais New Bing.

Est-ce le RLHF de Microsoft qui n'a pas fait les choses correctement, ou est-ce merveilleux corpus Internet qui a fait perdre ChatGPT ?

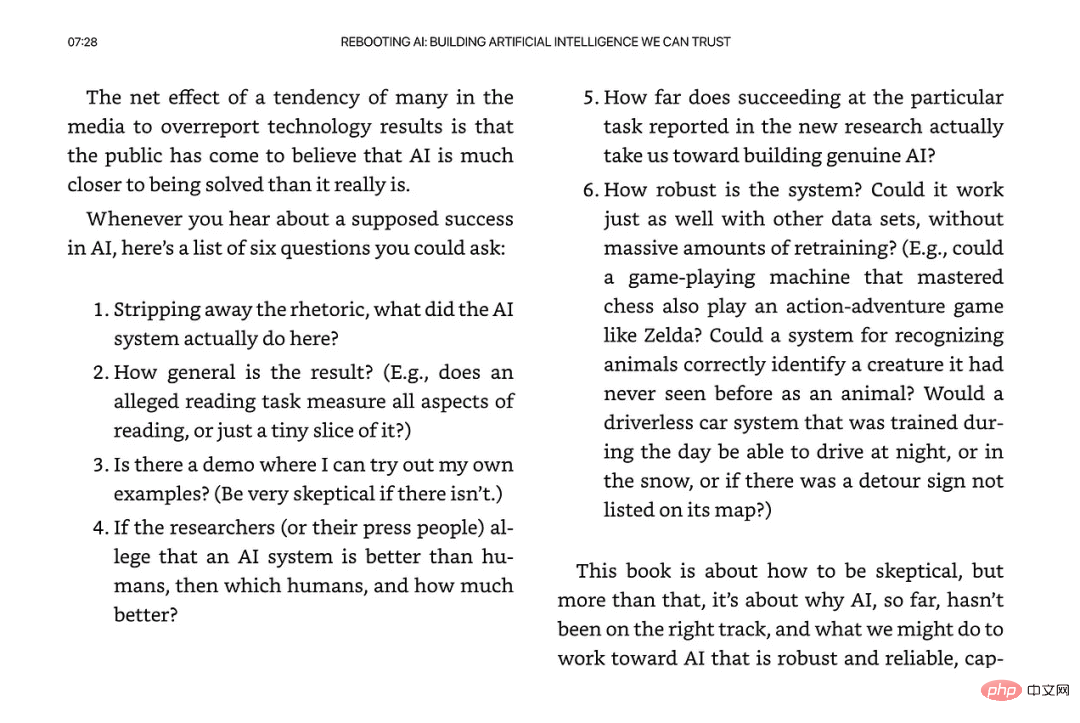

Récemment, Gary Marcus, spécialiste bien connu de l'IA, fondateur et PDG de Robust.AI et professeur émérite de l'Université de New York, a publié un autre blog, analysant plusieurs possibilités pour que Bing devienne fou, et a déclaré qu'il laisserait tomber. Cela pourrait avoir des impacts ultérieurs extrêmement graves sur le développement de l'industrie de l'IA.

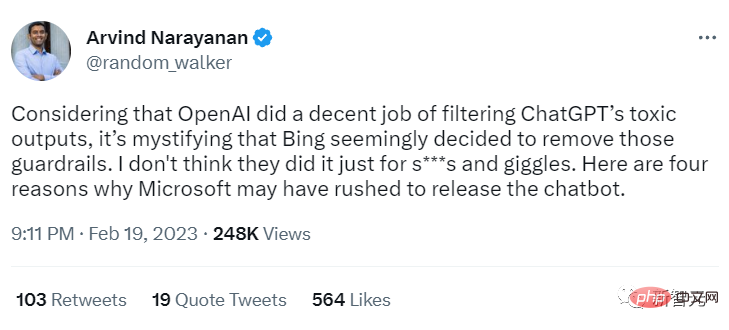

Arvind Narayanan, professeur à l'Université de Princeton, a proposé quatre possibilités pour expliquer pourquoi Bing est si "sauvage".

Dans un tweet, le professeur Narayanan estime qu'OpenAI fait du bon travail en filtrant les résultats toxiques de ChatGPT, mais il semble que Bing ait supprimé ces protections, ce qui est très déroutant.

Il pense que Microsoft ne fait pas cela seulement pour le plaisir, il doit y avoir d'autres raisons pour sortir le nouveau Bing si rapidement.

Possibilité 1 : New Bing est GPT-4

Le comportement de New Bing peut être considéré comme assez différent de ChatGPT, il ne semble pas il est probablement basé sur le même modèle sous-jacent. Peut-être que LLM n'a terminé que récemment sa formation (c'est-à-dire GPT-4 ?). Si tel est le cas, il est probable que Microsoft ait choisi (imprudemment) de déployer rapidement le nouveau modèle plutôt que de retarder la sortie et de suivre une formation RLHF plus approfondie.

Marcus a également déclaré dans son article précédent "Le cœur sombre de ChatGPT" qu'il y a beaucoup de contenu inconfortable qui se cache dans le grand modèle de langage, et peut-être que Microsoft n'a pris aucune mesure pour filtrer le contenu toxique.

Lien du blog : https://garymarcus.substack.com/p/inside-the-heart-of-chatgpts-darkness

Possibilité 2 : Trop de faux positifs

Microsoft a peut-être construit un filtre pour Bing, mais dans la réalité, il prédit trop d'échantillons de faux positifs. Pour ChatGPT, ce problème est insignifiant, mais dans les scénarios de recherche, il affectera sérieusement l'expérience utilisateur.

Cela dit, les filtres sont trop ennuyeux pour être utilisés dans de vrais moteurs de recherche.

Possibilité 3 : Afin d'obtenir les commentaires des utilisateurs

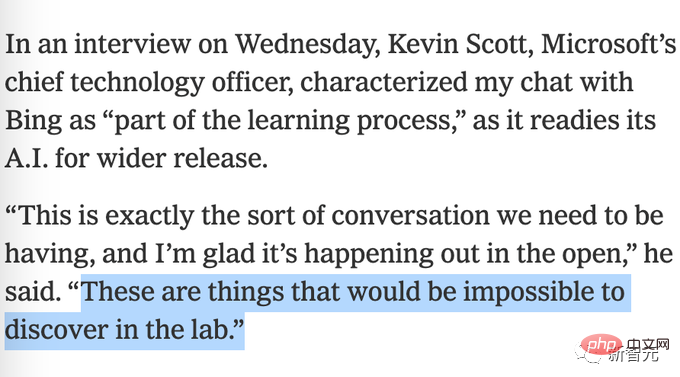

Il est possible que Bing ait intentionnellement désactivé les restrictions de filtrage pour obtenir davantage de commentaires des utilisateurs sur ce qui a pu mal se passer. Microsoft a fait une déclaration bizarre plus tôt selon laquelle il serait impossible de réaliser des tests en laboratoire.

Possibilité 4 : Microsoft ne s'y attendait pas non plus

Il est possible que Microsoft pense que le filtre basé sur le projet d'invite est suffisant, et ce n'est vraiment pas le cas Attendez-vous à ce que New Bing ait mal tourné pour en arriver là où il en est aujourd'hui.

Marcus est fondamentalement d'accord avec le point de vue du professeur Narayanan, mais il pense que Microsoft n'a peut-être pas supprimé les mesures de protection, peut être « tout simplement inefficace », ce qui est également la cinquième possibilité.

Autrement dit, peut-être que Microsoft a essayé de mettre son modèle RLHF existant, déjà formé, au-dessus de GPT 3.6, mais cela n'a pas fonctionné.

L'apprentissage par renforcement est notoirement pointilleux Si vous modifiez légèrement l'environnement, cela peut être inutile.

Le célèbre apprentissage par renforcement DQN de DeepMind a établi un record dans le jeu Atari, puis a simplement ajouté quelques petits changements, comme déplacer la palette de quelques pixels vers le haut dans le jeu Breakout, le modèle s'est effondré, peut-être à chaque fois Un grand langage la mise à jour du modèle nécessite un recyclage complet du module d'apprentissage par renforcement.

C'est une très mauvaise nouvelle, non seulement en termes de coût humain et économique (c'est-à-dire davantage de personnes mal payées faisant un travail épouvantable), mais aussi en termes de crédibilité, cela signifiera également qu'aucune nouvelle itération de grand langage les modèles sont sûrs.

Cette situation est particulièrement effrayante pour deux raisons principales :

1. Les grandes entreprises sont libres de publier de nouvelles mises à jour à tout moment et sans avertissement.

2. être testé sur le public encore et encore, sans savoir à l'avance dans quelle mesure les tests empiriques sur le public fonctionneront.

De manière analogue à la sortie de nouveaux médicaments dans le domaine médical, le public exige que les nouveaux médicaments soient entièrement testés en laboratoire avant leur sortie, passant à la sortie de grands modèles de langage, surtout si des milliards de personnes peuvent l'utiliser, et il peut y avoir des risques sérieux (comme perturber la santé mentale et l'état civil de l'utilisateur), nous ne devrions pas les laisser le tester directement en public

Sur le plan politique, le public a le droit (ou à proprement parler, devrait insister) pour savoir quels sont les problèmes du modèle.

Par exemple, une fois que Bing a révélé le problème, il peut formuler des politiques pour empêcher que des incidents similaires ne se reproduisent. À l’heure actuelle, l’intelligence artificielle est fondamentalement dans sa phase de développement sauvage, et n’importe qui peut lancer un chatbot.

Le Congrès doit comprendre ce qui se passe et commencer à fixer certaines limites, en particulier là où des dommages émotionnels ou physiques pourraient facilement être causés.

Dans le secteur du journalisme, les médias sont également très décevants.

Kevin Roose a déclaré dans le rapport initial qu'il était "impressionné" par Bing, ce qui a particulièrement bouleversé Marcus, apparemment dans le New York Times. Ce n'est pas une bonne chose de faire passer le message trop tôt sans approfondir les problèmes sous-jacents. .

De plus, permettez-moi d'ajouter un point supplémentaire, nous sommes déjà en 2023, les mesures de protection de Microsoft sont-elles suffisantes ? A-t-il fait l'objet de recherches approfondies ?

S’il vous plaît, ne dites pas que vous n’éprouvez aucun sentiment autre que « la crainte » à l’égard du nouveau système.

Enfin, le professeur Narayanan estime que nous sommes à un moment critique pour l'intelligence artificielle et la société civile. Si des mesures ne sont pas prises, les efforts pratiques de « diffusion responsable de l'IA » au cours des cinq dernières années seront anéantis.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Inscription ChatGPT

Inscription ChatGPT

Encyclopédie ChatGPT nationale gratuite

Encyclopédie ChatGPT nationale gratuite

Comment installer chatgpt sur un téléphone mobile

Comment installer chatgpt sur un téléphone mobile

Chatgpt peut-il être utilisé en Chine ?

Chatgpt peut-il être utilisé en Chine ?

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

utilisation des balises de jeu de champs

utilisation des balises de jeu de champs

Le numéro de page Word commence à partir de la troisième page comme 1 tutoriel

Le numéro de page Word commence à partir de la troisième page comme 1 tutoriel

Où dois-je indiquer mon lieu de naissance : province, ville ou comté ?

Où dois-je indiquer mon lieu de naissance : province, ville ou comté ?