Périphériques technologiques

Périphériques technologiques

IA

IA

Utiliser l'IA pour retrouver des proches séparés après l'Holocauste ! Les ingénieurs de Google développent un programme de reconnaissance faciale capable d'identifier plus de 700 000 photos anciennes de la Seconde Guerre mondiale

Utiliser l'IA pour retrouver des proches séparés après l'Holocauste ! Les ingénieurs de Google développent un programme de reconnaissance faciale capable d'identifier plus de 700 000 photos anciennes de la Seconde Guerre mondiale

Utiliser l'IA pour retrouver des proches séparés après l'Holocauste ! Les ingénieurs de Google développent un programme de reconnaissance faciale capable d'identifier plus de 700 000 photos anciennes de la Seconde Guerre mondiale

De nouvelles affaires se sont-elles ouvertes dans le domaine de la reconnaissance faciale IA ?

Cette fois, il s’agit d’identifier des visages sur de vieilles photos de la Seconde Guerre mondiale.

Récemment, Daniel Patt, un ingénieur logiciel chez Google, a développé une technologie de reconnaissance faciale IA appelée N2N (Numbers to Names), qui peut identifier des photos de l'Europe avant la Seconde Guerre mondiale et l'Holocauste, et les comparer avec des personnes modernes connectées.

Utiliser l'IA pour retrouver des proches disparus depuis longtemps

En 2016, lorsque Pat a visité le Musée commémoratif des Juifs polonais à Varsovie, il a eu une idée.

Ces visages étranges pourraient-ils lui être liés par le sang ?

Trois de ses grands-parents étaient des survivants de l'Holocauste originaires de Pologne, et il voulait aider sa grand-mère à retrouver les membres de sa famille qui ont été tués par les photos des nazis.

Pendant la Seconde Guerre mondiale, en raison du grand nombre de Juifs polonais emprisonnés dans différents camps de concentration, beaucoup d'entre eux ont disparu.

Rien qu'à travers une photo jaunie, il est difficile d'identifier le visage qui s'y trouve, encore moins de retrouver vos proches perdus.

Alors, il est rentré chez lui et a immédiatement transformé cette idée en réalité.

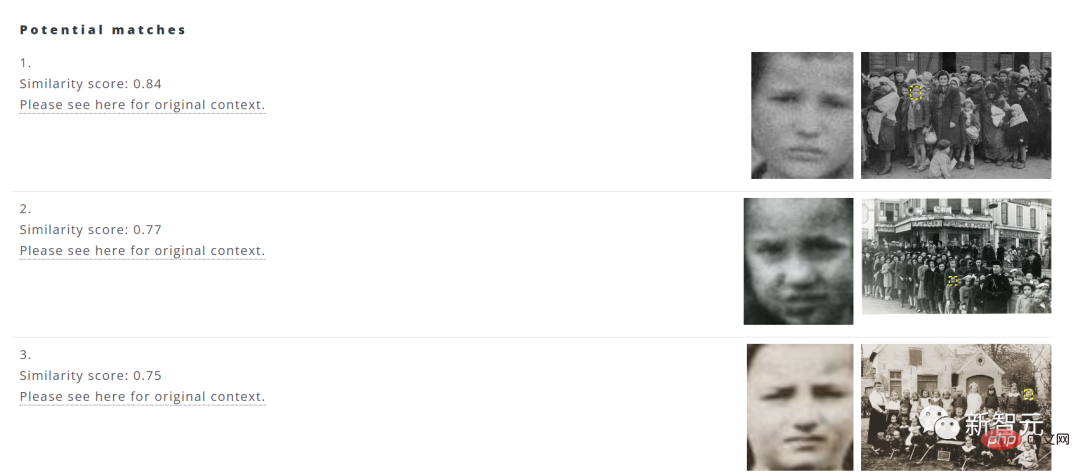

L'idée originale de ce logiciel est de collecter des informations sur les images des visages via une base de données et d'utiliser des algorithmes d'intelligence artificielle pour aider à faire correspondre les dix principales options présentant la plus grande similarité.

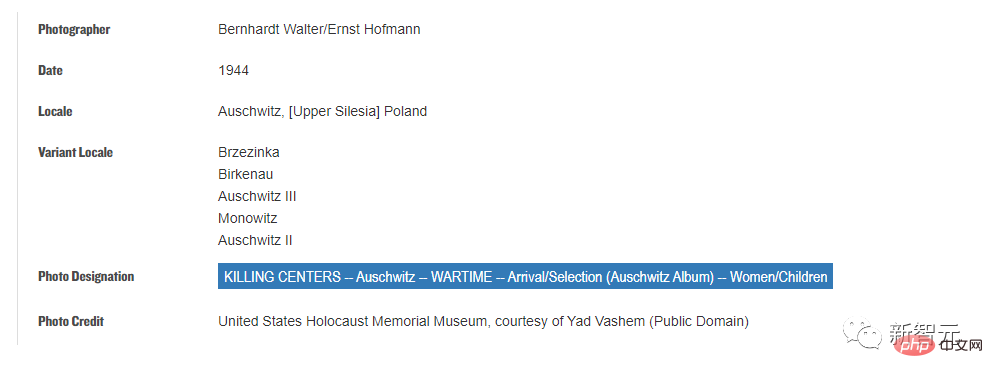

La plupart des données d'images proviennent du US Holocaust Memorial Museum, et il existe plus d'un million d'images provenant de bases de données à travers le pays.

Les utilisateurs doivent simplement sélectionner l'image dans le fichier informatique, cliquer sur télécharger et le système filtrera automatiquement les dix meilleures options avec les images les plus correspondantes.

De plus, les utilisateurs peuvent également cliquer sur l'adresse source pour afficher l'année, le lieu, la collection et d'autres informations sur l'image.

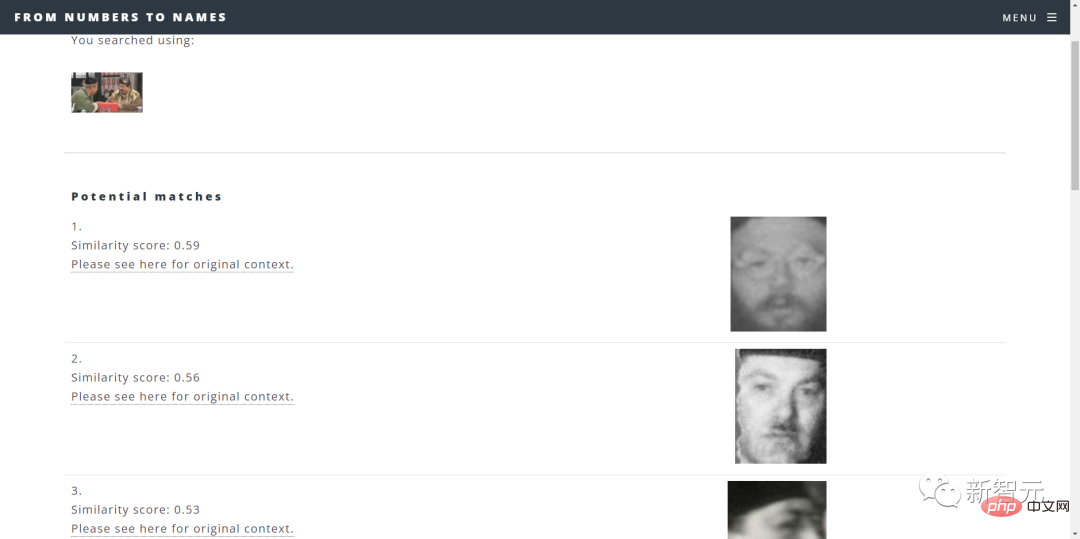

Un inconvénient est que si vous saisissez des images modernes de personnes, les résultats de la recherche peuvent être scandaleux.

Est-ce le résultat ? (Point d'interrogation noir)

Bref, les fonctions du système doivent encore être améliorées.

De plus, Patt travaille également avec d'autres équipes d'ingénieurs logiciels et de data scientists chez Google pour améliorer la portée et la précision des recherches.

En raison du risque de fuite de confidentialité dans le système de reconnaissance faciale, Patt a déclaré : « Nous ne procédons à aucune évaluation de l'identité. Nous sommes uniquement responsables de présenter les résultats en utilisant des scores de similarité et de laisser les utilisateurs porter leur propre jugement.

Développement de la technologie de reconnaissance faciale IA

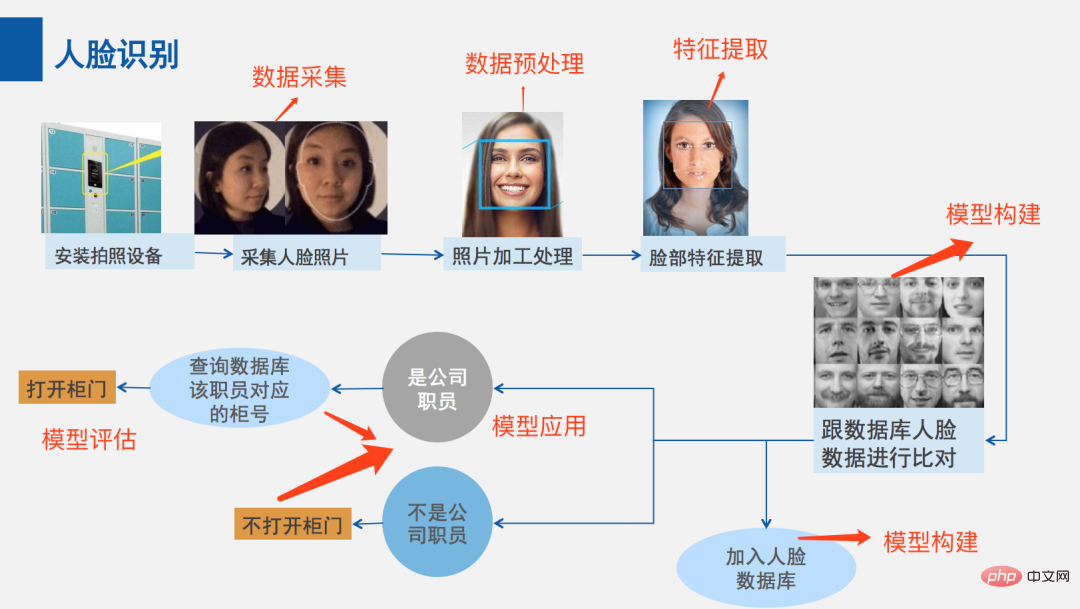

Alors, comment cette technologie reconnaît-elle les visages ?

Au départ, la technologie de reconnaissance faciale devait commencer par "comment déterminer si l'image détectée est un visage".

En 2001, les chercheurs en vision par ordinateur Paul Viola et Michael Jones ont proposé un cadre permettant de détecter les visages en temps réel avec une grande précision.

Ce cadre peut comprendre « ce qu'est un visage et ce qui n'est pas un visage » sur la base de modèles de formation.

Après la formation, le modèle extrait des caractéristiques spécifiques, puis stocke ces caractéristiques dans des fichiers afin que les caractéristiques des nouvelles images puissent être comparées aux caractéristiques précédemment stockées à différentes étapes.

Pour garantir l'exactitude, l'algorithme doit être entraîné sur « un vaste ensemble de données contenant des centaines de milliers d'images positives et négatives », ce qui améliore la capacité de l'algorithme à déterminer si un visage est dans une image et où il se trouve.

Si l'image étudiée passe chaque étape de comparaison des caractéristiques, un visage a été détecté et vous pouvez continuer.

Bien que le framework Viola-Jones soit très précis pour la reconnaissance faciale dans les applications en temps réel, il présente certaines limites.

Par exemple, la monture peut ne pas fonctionner si le visage porte un masque ou si un visage n'est pas orienté correctement.

Pour aider à éliminer les lacunes du framework Viola-Jones et à améliorer la détection des visages, ils ont développé des algorithmes supplémentaires.

Tels que les réseaux neuronaux convolutifs basés sur la région (R-CNN) et les détecteurs à tir unique (SSD) pour aider à améliorer le processus.

Convolutional Neural Network (CNN) est un réseau de neurones artificiels utilisé pour la reconnaissance et le traitement d'images, spécifiquement conçu pour traiter les données de pixels.

R-CNN génère des propositions de régions sur un framework CNN pour localiser et classer des objets dans des images.

Alors que les méthodes basées sur les réseaux de propositions de régions (telles que R-CNN) nécessitent deux prises de vue - une pour générer des propositions de régions et une autre pour détecter chaque objet proposé - le SSD ne nécessite qu'une seule prise de vue pour détecter des objets dans l'image de plusieurs objets. Par conséquent, le SSD est nettement plus rapide que le R-CNN.

Ces dernières années, les avantages de la technologie de reconnaissance faciale pilotée par des modèles d'apprentissage profond sont nettement meilleurs que les méthodes traditionnelles de vision par ordinateur.

Les premières reconnaissances faciales utilisaient principalement des algorithmes d'apprentissage automatique traditionnels, et la recherche se concentrait davantage sur la manière d'extraire des caractéristiques plus discriminantes et d'aligner les visages plus efficacement.

Avec l'approfondissement de la recherche, l'amélioration des performances de la reconnaissance faciale des algorithmes d'apprentissage automatique traditionnels sur les images bidimensionnelles a progressivement atteint un goulot d'étranglement.

Les gens ont commencé à étudier le problème de la reconnaissance faciale dans des vidéos, ou en combinaison avec des méthodes de modèles tridimensionnels pour améliorer encore les performances de la reconnaissance faciale, tandis que quelques chercheurs ont commencé à étudier le problème de la reconnaissance faciale tridimensionnelle.

Dans la plus célèbre bibliothèque publique LFW, l'algorithme d'apprentissage profond a surmonté le goulot d'étranglement des algorithmes d'apprentissage automatique traditionnels en termes de performances de reconnaissance faciale sur des images bidimensionnelles, augmentant pour la première fois le taux de reconnaissance à plus de 97 %.

C'est-à-dire utiliser le « modèle haute dimension établi par le réseau CNN » pour extraire directement les caractéristiques d'identification efficaces de l'image faciale d'entrée et calculer directement la distance cosinus pour la reconnaissance faciale.

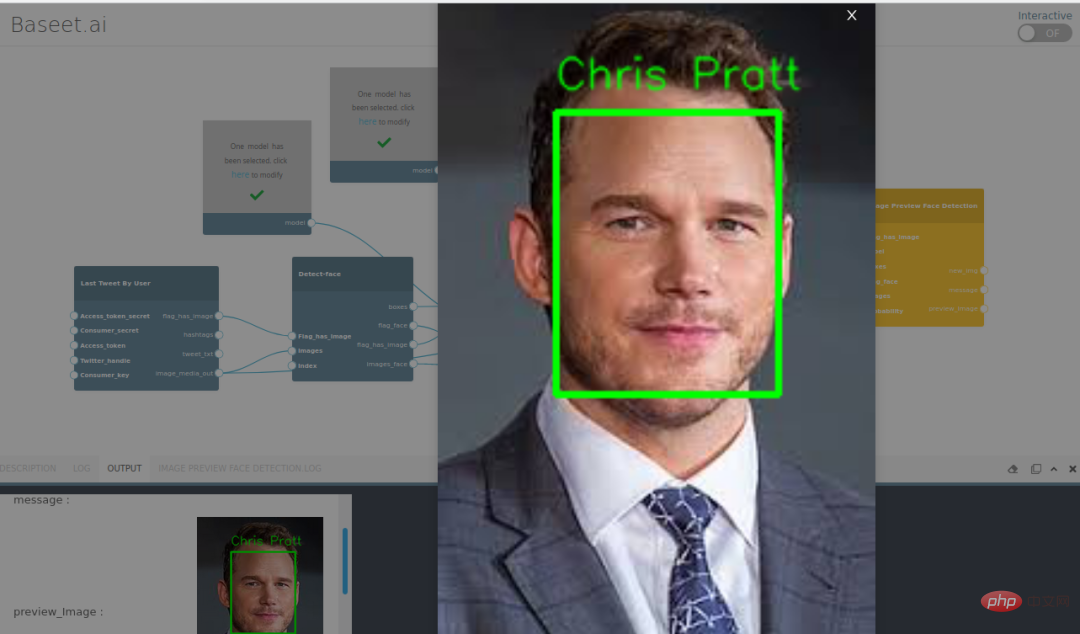

La détection des visages a évolué des techniques de base de vision par ordinateur aux progrès de l'apprentissage automatique (ML), en passant par les réseaux de neurones artificiels (ANN) et les techniques associées de plus en plus complexes, avec pour résultat une amélioration continue des performances.

Il joue désormais un rôle important en tant que première étape dans de nombreuses applications critiques, notamment le suivi facial, l'analyse faciale et la reconnaissance faciale.

Pendant la Seconde Guerre mondiale, la Chine a également subi le traumatisme de la guerre, et de nombreuses personnes sur les photos de cette époque n'étaient plus identifiables.

Les personnes dont la génération des grands-parents a souffert de traumatismes de guerre ont de nombreux parents et amis dont on ignore où ils se trouvent.

Le développement de cette technologie peut aider les gens à découvrir les années poussiéreuses et à trouver un certain réconfort pour les personnes du passé.

Référence : https://www.timesofisrael.com/google-engineer-identifies-anonymous-faces-in-wwii-photos-with-ai-facial-recognition/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

Binance est le suzerain de l'écosystème mondial de trading d'actifs numériques, et ses caractéristiques comprennent: 1. Le volume de négociation quotidien moyen dépasse 150 milliards de dollars, prend en charge 500 paires de négociation, couvrant 98% des monnaies grand public; 2. La matrice d'innovation couvre le marché des dérivés, la mise en page Web3 et le système éducatif; 3. Les avantages techniques sont des moteurs de correspondance d'une milliseconde, avec des volumes de traitement de pointe de 1,4 million de transactions par seconde; 4. Conformité Progress détient des licences de 15 pays et établit des entités conformes en Europe et aux États-Unis.

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

Le plongeon sur le marché des crypto-monnaies a provoqué la panique parmi les investisseurs, et Dogecoin (Doge) est devenu l'une des zones les plus difficiles. Son prix a fortement chuté et le verrouillage de la valeur totale de la finance décentralisée (DEFI) (TVL) a également connu une baisse significative. La vague de vente de "Black Monday" a balayé le marché des crypto-monnaies, et Dogecoin a été le premier à être touché. Son Defitvl a chuté aux niveaux de 2023 et le prix de la devise a chuté de 23,78% au cours du dernier mois. Le Defitvl de Dogecoin est tombé à un minimum de 2,72 millions de dollars, principalement en raison d'une baisse de 26,37% de l'indice de valeur SOSO. D'autres plates-formes de Defi majeures, telles que le Dao et Thorchain ennuyeux, TVL ont également chuté de 24,04% et 20, respectivement.

Top 10 plates-formes d'échange de crypto-monnaie La plus grande liste de changes numériques au monde

Apr 21, 2025 pm 07:15 PM

Top 10 plates-formes d'échange de crypto-monnaie La plus grande liste de changes numériques au monde

Apr 21, 2025 pm 07:15 PM

Les échanges jouent un rôle essentiel sur le marché des crypto-monnaies d'aujourd'hui. Ce ne sont pas seulement des plateformes pour les investisseurs pour négocier, mais aussi des sources importantes de liquidité du marché et la découverte des prix. Les plus grands échanges de devises virtuels au monde se classent parmi les dix premiers, et ces échanges sont non seulement bien en avance dans le volume des échanges, mais présentent également leurs propres avantages dans l'expérience utilisateur, la sécurité et les services innovants. Les échanges qui dépassent la liste ont généralement une grande base d'utilisateurs et une influence approfondie du marché, et leur volume de trading et leurs types d'actifs sont souvent difficiles à atteindre par d'autres échanges.

Rexas Finance (RXS) peut dépasser Solana (Sol), Cardano (ADA), XRP et Dogecoin (DOGE) en 2025

Apr 21, 2025 pm 02:30 PM

Rexas Finance (RXS) peut dépasser Solana (Sol), Cardano (ADA), XRP et Dogecoin (DOGE) en 2025

Apr 21, 2025 pm 02:30 PM

Sur le marché volatil des crypto-monnaies, les investisseurs recherchent des alternatives qui vont au-delà des devises populaires. Bien que les crypto-monnaies bien connues telles que Solana (Sol), Cardano (ADA), XRP et Dogecoin (DOGE) sont également confrontées à des défis tels que le sentiment du marché, l'incertitude réglementaire et l'évolutivité. Cependant, un nouveau projet émergent, la rexasfinance (RXS), est en émergence. Il ne s'appuie pas sur les effets de célébrités ou le battage médiatique, mais se concentre sur la combinaison des actifs du monde réel (RWA) avec la technologie de la blockchain pour offrir aux investisseurs une façon innovante d'investir. Cette stratégie le fait espérer être l'un des projets les plus réussis de 2025. Rexasfi

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

WorldCoin (WLD) se démarque sur le marché des crypto-monnaies avec ses mécanismes uniques de vérification biométrique et de protection de la vie privée, attirant l'attention de nombreux investisseurs. WLD a permis de se produire avec remarquablement parmi les Altcoins avec ses technologies innovantes, en particulier en combinaison avec la technologie d'Intelligence artificielle OpenAI. Mais comment les actifs numériques se comporteront-ils au cours des prochaines années? Prédons ensemble le prix futur de WLD. Les prévisions de prix de 2025 WLD devraient atteindre une croissance significative de la WLD en 2025. L'analyse du marché montre que le prix moyen du WLD peut atteindre 1,31 $, avec un maximum de 1,36 $. Cependant, sur un marché baissier, le prix peut tomber à environ 0,55 $. Cette attente de croissance est principalement due à WorldCoin2.

La plate-forme de médias sociaux Web3 Tox collabore avec Omni Labs pour intégrer l'infrastructure d'IA

Apr 21, 2025 pm 07:06 PM

La plate-forme de médias sociaux Web3 Tox collabore avec Omni Labs pour intégrer l'infrastructure d'IA

Apr 21, 2025 pm 07:06 PM

La plate-forme décentralisée de médias sociaux Tox a atteint un partenariat stratégique avec Omnilabs, un leader des solutions d'intelligence artificielle, pour intégrer les capacités d'intelligence artificielle dans l'écosystème web3. Ce partenariat est publié par le compte officiel de Tox Officiel de Tox et vise à créer un environnement en ligne plus juste et plus intelligent. Omnilabs est connu pour ses systèmes autonomes intelligents, avec sa capacité AI-AS-A-Service (AIAAS) soutenant de nombreux protocoles Defi et NFT. Son infrastructure utilise des agents d'IA pour la prise de décision en temps réel, les processus automatisés et l'analyse approfondie des données, visant à s'intégrer de manière transparente dans l'écosystème décentralisé pour autonomiser la plate-forme blockchain. La collaboration avec Tox rendra les outils d'IA d'Omnilabs plus étendus, en les intégrant dans les réseaux sociaux décentralisés,

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Les plates-formes qui ont des performances exceptionnelles dans le commerce, la sécurité et l'expérience utilisateur en effet de levier en 2025 sont: 1. OKX, adaptés aux traders à haute fréquence, fournissant jusqu'à 100 fois l'effet de levier; 2. Binance, adaptée aux commerçants multi-monnaies du monde entier, offrant un effet de levier 125 fois élevé; 3. Gate.io, adapté aux joueurs de dérivés professionnels, fournissant 100 fois l'effet de levier; 4. Bitget, adapté aux novices et aux commerçants sociaux, fournissant jusqu'à 100 fois l'effet de levier; 5. Kraken, adapté aux investisseurs stables, fournissant 5 fois l'effet de levier; 6. BUTBIT, adapté aux explorateurs Altcoin, fournissant 20 fois l'effet de levier; 7. Kucoin, adapté aux commerçants à faible coût, fournissant 10 fois l'effet de levier; 8. Bitfinex, adapté au jeu senior

Quelles sont les dix principales plates-formes du cercle d'échange de devises?

Apr 21, 2025 pm 12:21 PM

Quelles sont les dix principales plates-formes du cercle d'échange de devises?

Apr 21, 2025 pm 12:21 PM

Les principaux échanges comprennent: 1. Binance, le plus grand volume de trading au monde, prend en charge 600 devises et les frais de gestion des points sont de 0,1%; 2. Okx, une plate-forme équilibrée, prend en charge 708 paires de trading, et les frais de traitement des contrats perpétuels sont de 0,05%; 3. Gate.io, couvre 2700 petites monnaies, et les frais de traitement des points sont de 0,1% à 0,3%; 4. Coinbase, la référence de conformité américaine, les frais de traitement des points sont de 0,5%; 5. Kraken, la haute sécurité et l'audit de réserve régulière.