Périphériques technologiques

Périphériques technologiques

IA

IA

Comment effectuer une recherche d'images de manière efficace et précise ? Jetez un œil au modèle pré-entraîné à la vision légère

Comment effectuer une recherche d'images de manière efficace et précise ? Jetez un œil au modèle pré-entraîné à la vision légère

Comment effectuer une recherche d'images de manière efficace et précise ? Jetez un œil au modèle pré-entraîné à la vision légère

Avez-vous déjà eu des problèmes avec la récupération d'images ?

Soit il est difficile de trouver avec précision l'image requise parmi la quantité massive d'images, soit des résultats insatisfaisants peuvent être obtenus lors de la récupération textuelle. Concernant ce problème, des chercheurs de Microsoft Research Asia et de la division Microsoft Cloud Computing et Intelligence artificielle ont mené des recherches approfondies sur les modèles visuels légers et ont proposé une série de méthodes de conception et de compression pour les modèles visuels de pré-entraînement afin de répondre aux exigences de déploiement visuel de Transformer Lightweight. .

Actuellement, cette méthode et ce modèle ont été appliqués avec succès au moteur de recherche Bing de Microsoft, permettant un raisonnement et une récupération précis et rapides de dizaines de milliards d'images. Cet article fournira une explication approfondie du développement, des technologies clés, des applications et du potentiel des modèles de pré-entraînement visuel légers, ainsi que des opportunités et des défis futurs. J'espère que tout le monde pourra mieux comprendre le domaine de la pré-entraînement visuel léger et. promouvoir conjointement le développement de technologies connexes.

Récemment, les modèles de pré-entraînement visuel basés sur Transformer ont atteint des performances supérieures sur de nombreuses tâches de vision par ordinateur et ont reçu une large attention. Cependant, les modèles visuels de pré-formation de Transformer ont généralement des paramètres volumineux et une grande complexité, ce qui limite leur déploiement et leur utilisation dans des applications pratiques, en particulier dans les appareils aux ressources limitées ou dans les scénarios avec des exigences élevées en temps réel. Par conséquent, la recherche « légère » sur de grands modèles visuels de pré-entraînement est devenue un nouveau point chaud dans le monde universitaire et industriel.

À cet égard, des chercheurs de Microsoft Research Asia et de la division Microsoft Cloud Computing et Intelligence artificielle ont mené une exploration approfondie de la conception structurelle et de l'inférence de formation de grands modèles visuels, tout en se concentrant également sur la légèreté et les performances en temps réel de grands modèles. Et le déploiement dans le cloud a également créé des applications innovantes. Cet article partira du développement de modèles visuels légers de pré-formation, explorera les technologies clés dans la recherche sur les modèles légers, ainsi que l'application et le potentiel des modèles de transformateur visuels légers dans les produits réels, et attendra enfin avec impatience les opportunités et perspectives de développement futures de défi de modèles visuels légers.

De grands modèles visuels émergent les uns après les autres, mais les modèles légers de pré-entraînement manquent d'attention

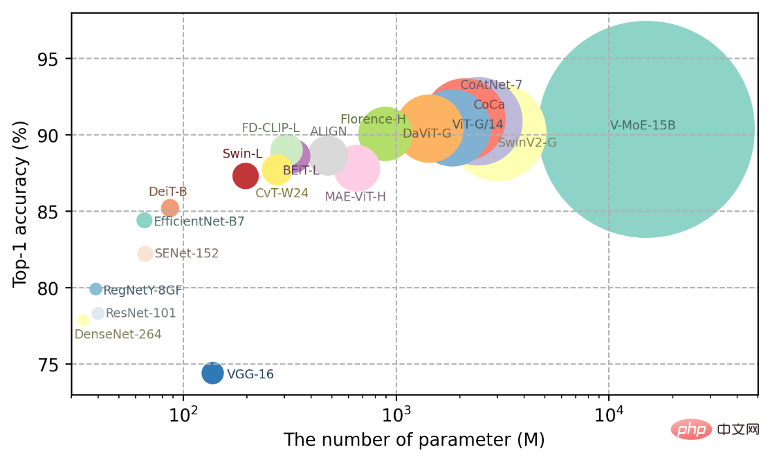

Ces dernières années, les progrès de l'apprentissage profond dans les tâches de classification d'images ImageNet ont principalement bénéficié de l'expansion substantielle de la capacité de modèles visuels. Comme le montre la figure 1, en quelques années seulement, la capacité des modèles visuels de pré-entraînement a été multipliée par plus de 300, du modèle ResNet-101 avec 44,5 millions de paramètres au modèle V-MoE avec 15 milliards de paramètres. modèles visuels de pré-formation à grande échelle Les modèles de formation ont fait de grands progrès dans des tâches telles que la compréhension des images et la génération de contenu visuel.

Figure 1 : Tableau de tendance des modifications des paramètres du modèle visuel de pré-entraînement

Qu'il s'agisse du modèle Swin-V2 à 3 milliards de paramètres de Microsoft ou du modèle ViT-G/14 à 1,8 milliard de paramètres publié par Google, Les grands modèles visuels ont démontré des performances supérieures dans de nombreuses tâches, en particulier leurs puissantes capacités de généralisation à petit tir (quelques tirs) et même à zéro tir (zéro tir), qui sont essentielles à l'obtention d'une intelligence générale.

Cependant, dans de nombreux scénarios réels, en raison des limitations des ressources de stockage et de calcul, les grands modèles sont difficiles à déployer directement ou ne peuvent pas répondre aux besoins en temps réel. Par conséquent, la recherche sur des modèles légers de pré-entraînement visuel est devenue de plus en plus importante et a une forte valeur d’application pratique. Bien qu'il existe actuellement des travaux explorant des modèles légers, la plupart de ces méthodes sont conçues pour des tâches et des structures spécifiques. La polyvalence du modèle n'est pas prise en compte lors du processus de conception et de formation, et il existe une généralisation à travers les domaines de données et les tâches.

Recherche sur les technologies clés des modèles visuels légers

Afin de réaliser des modèles visuels légers de pré-entraînement, les chercheurs de Microsoft ont découvert deux problèmes clés : 1) Comment concevoir une structure de modèle léger plus polyvalente ? 2) En raison de la capacité limitée des modèles visuels légers de pré-entraînement, comment concevoir des méthodes de pré-entraînement efficaces afin que les petits modèles puissent apprendre des informations efficaces à partir de données à grande échelle ? Face à ces problèmes, les chercheurs ont obtenu quelques premiers résultats grâce à des recherches et des explorations incessantes.

Étant donné que l'essentiel de l'amélioration de la polyvalence des modèles légers de pré-entraînement réside dans la manière de renforcer les capacités d'apprentissage du modèle avec des ressources limitées (nombre de paramètres, délai, etc.), afin qu'il puisse mieux apprendre de grandes -des données à grande échelle Caractéristiques universelles, les chercheurs ont donc mené une exploration approfondie sous les trois perspectives suivantes :

1. Conception de modules légers

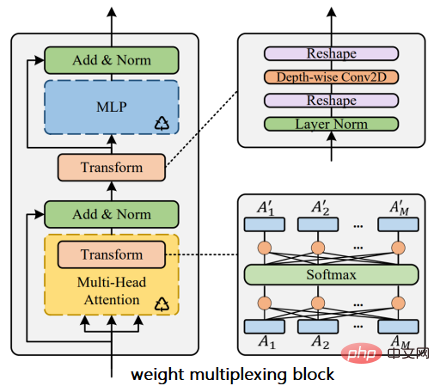

Les modules légers et à faible latence constituent une partie importante des modèles légers. Dans les réseaux neuronaux convolutifs, les modules légers représentatifs incluent le bloc résiduel inversé de MobileNet et l'unité de croisement aléatoire de canal de ShuffleNet (Shuffle Unit). Dans la structure du transformateur visuel, étant donné que le calcul de l'attention entre les blocs d'image ne prend pas bien en compte les informations de codage de position relative, les chercheurs ont conçu une méthode de codage de position relative d'image bidimensionnelle légère et plug-and-play iRPE [1]. les performances du modèle sans modifier les hyperparamètres d’entraînement. De plus, pour résoudre le problème de la redondance des paramètres visuels du transformateur, les chercheurs ont conçu le module Weight Multiplexing [2]. Comme le montre la figure 2, cette méthode réduit la redondance des paramètres du modèle grâce à la réutilisation des poids multicouches et introduit des transformations linéaires non partagées pour augmenter la diversité des paramètres.

Figure 2 : Module de multiplexage de poids dans Transformer

2. Recherche de modèle légère

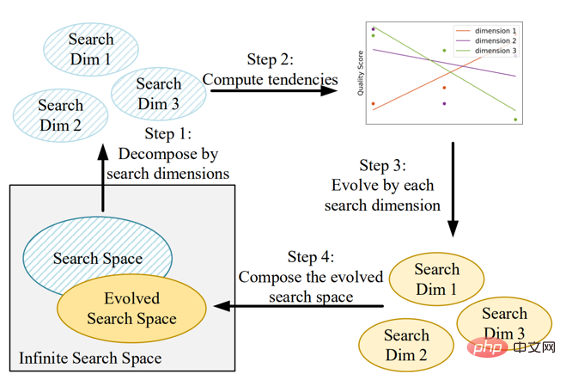

La recherche d'architecture neuronale peut être automatiquement trouvée à partir de l'espace de conception de modèle. Une structure de modèle plus légère et plus performante. performances [3]. Dans les réseaux de neurones convolutifs, les travaux représentatifs incluent NASNet et EfficientNet. Dans la recherche de structure visuelle du transformateur, les chercheurs ont proposé AutoFormer [4] et S3 [5] pour plusieurs dimensions telles que la largeur du canal, la profondeur du réseau et le nombre de têtes dans le modèle visuel, réalisant ainsi une formation évolutive dynamique et l'évolutivité du modèle visuel. Recherche de structures. Avec la même précision de modèle, le nouveau modèle obtenu grâce à la recherche comporte un plus petit nombre de paramètres et de calculs. Il convient de noter que dans S3, les chercheurs ont utilisé E-T Error [5] et le supernet de partage de poids pour guider et améliorer l'espace de recherche. Tout en obtenant une structure de modèle plus efficace, ils ont également analysé le processus d'évolution de l'espace de recherche, comme le montre la figure. 3 illustré. Dans le même temps, le processus de recherche de structure de modèle fournit une expérience de conception efficace et une référence pour la conception de modèles légers.

Figure 3 : Processus d'évolution de l'espace de recherche de modèles légers

3 Compression visuelle de grands modèles et transfert de connaissances

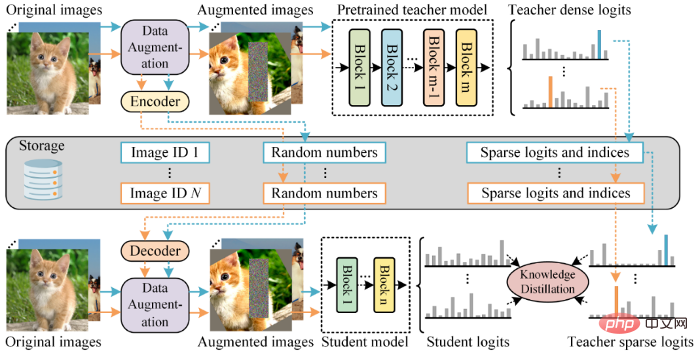

Une autre difficulté avec les modèles légers de pré-formation est qu'en raison de la capacité limitée du modèle. il est difficile d’apprendre directement les riches informations et connaissances contenues dans des données à grande échelle. Afin de résoudre ce problème, les chercheurs ont proposé un schéma de distillation rapide de pré-entraînement pour transférer les connaissances des grands modèles vers de petits modèles légers [6]. Comme le montre la figure 4, contrairement à la distillation traditionnelle des connaissances en une seule étape, la distillation rapide de pré-formation est divisée en deux étapes : 1) compresser et enregistrer les informations d'augmentation des données et les informations de prédiction utilisées dans le processus de formation du grand modèle ; Une fois les informations de prédiction et les données du grand modèle augmentées, le grand modèle est utilisé comme enseignant pour guider l'apprentissage et la formation des modèles d'étudiants légers grâce à une distillation préalable à la formation. Différente de l'élagage et de la quantification, cette méthode utilise la réutilisation du poids mentionnée ci-dessus [2] basée sur le partage du poids. En introduisant la transformation et la distillation du poids léger, elle compresse avec succès le grand modèle visuel de pré-entraînement et obtient un modèle léger universel plus robuste. Cette méthode peut compresser le grand modèle original des dizaines de fois sans sacrifier les performances.

Figure 4 : Distillation rapide des connaissances avant la formation

Cette série de résultats de recherche a non seulement publié de nombreux articles lors de conférences universitaires de premier plan sur la vision par ordinateur (CVPR, ICCV, ECCV, NeurIPS, etc.) [1-6], également grâce à la coopération avec Microsoft Bing, a appliqué avec succès des modèles de pré-formation légers aux produits de recherche d'images, améliorant ainsi la capacité à comprendre le contenu d'images et de vidéos dans le cadre d'une entreprise réelle.

Application d'un modèle de pré-entraînement visuel léger

Les modèles de pré-formation visuels légers ont de nombreuses utilisations pratiques, en particulier dans les scénarios avec des exigences en temps réel élevées ou des contraintes de ressources, telles que : le rendu et l'amélioration en temps réel des vidéos dans le cloud, les tests d'images de bout en bout et la compréhension du contenu vidéo. . Les modèles visuels légers ont montré de larges perspectives d'application dans des domaines tels que la vente au détail intelligente et la fabrication de pointe, et joueront à l'avenir un rôle important dans les industries émergentes telles que le métaverse et la conduite autonome. En prenant comme exemple la recherche de contenu d'image dans le produit Bing de Microsoft, ce qui suit vous montrera l'application pratique et le déploiement de modèles visuels légers.

À l'heure actuelle, la recherche d'images basée sur le contenu est relativement mature dans la compréhension des attributs de catégorie des images, mais il reste encore de grands défis à relever dans la compréhension du contenu de scènes complexes. Les images de scènes complexes présentent généralement des caractéristiques telles qu'une grande profondeur de champ, des arrière-plans encombrés, de nombreux personnages et des relations d'objet complexes, qui augmentent considérablement la difficulté de compréhension du contenu, imposant ainsi des exigences plus élevées en matière de robustesse et de généralisation des modèles de pré-formation.

Par exemple, la qualité de la recherche des images d'anime ne peut pas être améliorée efficacement pendant longtemps. Les principaux défis sont les suivants : les lignes et les couleurs de la peinture sont plus exagérées que les images de scènes réelles, contiennent plus d'actions et de scènes, différentes bandes dessinées sont présentes. énorme différence de style et de contenu. Les figures 5 à 7 montrent respectivement trois personnages de dessins animés et comportements différents de « Slam Dunk », « Pikachu » et « Captain ». Leurs styles et contenus de bandes dessinées sont très différents. Comment comprendre efficacement le contenu des images de bandes dessinées impose des exigences plus élevées aux modèles visuels de pré-formation.

Figure 5 : Dans le moteur de recherche Microsoft Bing, la compréhension des actions du maître du slam dunk comprend : dunk, dribble, vol, tir, etc.

Figure 6 : Dans Microsoft Bing Dans le moteur de recherche, la compréhension du comportement de Pikachu est telle que manger des pommes, manger de la pastèque, manger de la glace, etc.

Figure 7 : Dans le moteur de recherche Microsoft Bing, un gros plan de l'action de tir du joueur de football

ci-dessus Le modèle général visuel léger et l'algorithme de distillation rapide de pré-entraînement mentionnés ont été utilisés avec succès dans le moteur de recherche Bing de Microsoft. Grâce au modèle de pré-formation multimodal en langage visuel fourni par Microsoft Research Asia, la fonction de recherche d'images Bing de Microsoft améliore la compréhension du contenu de bandes dessinées et peut renvoyer un contenu d'image qui correspond mieux aux besoins des utilisateurs.

Dans le même temps, l'énorme bibliothèque d'index du moteur de recherche Microsoft Bing a des exigences très élevées en matière d'efficacité de récupération. La méthode de distillation rapide de pré-entraînement fournie par Microsoft Research Asia migre efficacement les capacités d'indexation du grand modèle pré-entraîné vers un modèle léger, améliorant ainsi la précision de reconnaissance du modèle existant de 14 % et optimisant considérablement l'efficacité du calcul du modèle. , réalisant un raisonnement rapide sur des dizaines de milliards d'images.

Opportunités et défis futurs

L'allègement des modèles est au cœur des futures applications de l'intelligence artificielle. À mesure que la technologie de vision, les algorithmes, la puissance de calcul et les données continuent de s'améliorer, la complexité des modèles a considérablement augmenté et la consommation d'énergie des calculs des réseaux neuronaux est devenue de plus en plus coûteuse. L'efficacité informatique élevée et les faibles coûts de déploiement et d'application du modèle visuel léger peuvent constituer un énorme avantage pour des produits plus actuels à l'avenir. De plus, des modèles visuels légers et pré-entraînés localisés peuvent mieux protéger les données et la confidentialité des utilisateurs tout en prenant en charge davantage de services. Les données de l'utilisateur n'auront plus besoin de quitter l'appareil, ce qui permettra des mises à niveau à distance de fonctions telles que les services de modèles.

Bien sûr, les chercheurs sont également conscients des défis auxquels sont confrontés les modèles visuels légers pré-entraînés : d'une part, en termes de conception de la structure du modèle, comment atteindre la capacité d'apprentissage optimale du modèle sous les contraintes du nombre de modèles. Les paramètres et le délai d'inférence ont toujours été des questions auxquelles le monde universitaire et l'industrie prêtent une attention particulière. Bien que de nombreuses structures de modèles efficaces aient été accumulées et que de grands progrès aient été réalisés dans des domaines tels que le théorème d'approximation universelle (UAT) et la recherche de structures de réseaux neuronaux (NAS), les modèles visuels légers pré-entraînés existants et les visuels à grande échelle existent encore. entre des modèles qui doivent être encore optimisés et améliorés. D'autre part, en termes de méthodes de formation, le monde universitaire et l'industrie ont proposé diverses méthodes de formation telles que l'auto-supervision, la classification d'images et la multimodalité pour les grands modèles visuels, qui ont considérablement amélioré les capacités générales du modèle. Comment concevoir une méthode de formation plus efficace pour les modèles légers avec une capacité limitée nécessite des recherches et une exploration plus approfondies. Les chercheurs de Microsoft Research Asia continueront de promouvoir les progrès de la recherche scientifique sur les modèles visuels légers pré-entraînés et accueilleront davantage de collègues technologiques pour communiquer et explorer les technologies connexes dans ce domaine.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.