Périphériques technologiques

Périphériques technologiques

IA

IA

Google et Stanford ont publié conjointement un article : Pourquoi devons-nous utiliser de grands modèles ?

Google et Stanford ont publié conjointement un article : Pourquoi devons-nous utiliser de grands modèles ?

Google et Stanford ont publié conjointement un article : Pourquoi devons-nous utiliser de grands modèles ?

Les modèles linguistiques ont profondément transformé la recherche et la pratique dans le domaine du traitement du langage naturel. Ces dernières années, les grands modèles ont réalisé des percées importantes dans de nombreux domaines. Ils n’ont pas besoin d’être peaufinés sur les tâches en aval. Avec des instructions ou des invites appropriées, ils peuvent atteindre d’excellentes performances, parfois même étonnantes.

Par exemple, GPT-3 [1] peut écrire des lettres d'amour, des scripts et résoudre des problèmes de raisonnement mathématique complexes avec des données, et PaLM [2] peut interpréter des blagues. L'exemple ci-dessus n'est que la pointe de l'iceberg des capacités des grands modèles. Vous pouvez voir de nombreuses démos associées sur le site Web d'OpenAI [3], mais ces capacités se reflètent rarement dans les petits modèles.

Dans le document présenté aujourd'hui, les capacités que les petits modèles n'ont pas mais que les grands modèles ont sont appelées capacités émergentes (Emergent Abilities), qui font référence aux capacités qui sont soudainement acquises une fois que l'échelle du modèle atteint un certain niveau. . Il s'agit d'un processus dans lequel des changements quantitatifs conduisent à des changements qualitatifs.

L’émergence de capacités émergentes est difficile à prévoir. La raison pour laquelle le modèle acquiert soudainement certaines capacités à mesure que l’échelle augmente reste une question ouverte à laquelle des recherches plus approfondies sont nécessaires pour répondre. Dans cet article, l'auteur passe en revue quelques progrès récents dans la compréhension des grands modèles et donne quelques réflexions connexes. J'ai hâte d'en discuter avec vous.

Articles connexes :

-

Capacités émergentes des grands modèles de langage.

http://arxiv.org/abs/2206.07682 -

Au-delà du jeu d'imitation : quantifier et extrapoler les capacités des modèles de langage .

https://arxiv.org/abs/2206.04615

Capacités émergentes des grands modèles

Qu'est-ce qu'un grand modèle ? Quelle taille est considérée comme « grande » ? Cela n’a pas de définition claire.

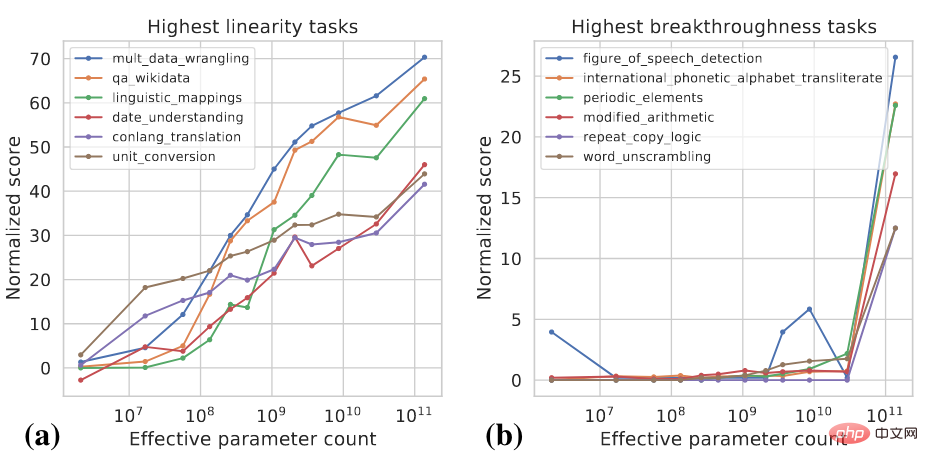

De manière générale, les paramètres du modèle peuvent devoir atteindre le niveau des milliards pour montrer des capacités qui sont significativement différentes de celles des petits modèles à tir nul et à quelques tirs. Ces dernières années, de nombreux modèles comportant des centaines de milliards et de milliards de paramètres ont permis d'atteindre les performances SOTA sur une série de tâches. Dans certaines tâches, les performances du modèle s'améliorent de manière fiable avec l'augmentation de l'échelle, tandis que dans d'autres tâches, le modèle montre une augmentation soudaine des performances à une certaine échelle. Deux indicateurs peuvent être utilisés pour classer différentes tâches [4] :

- Linéarité : vise à mesurer dans quelle mesure les performances du modèle sur la tâche sont améliorées de manière fiable à mesure que l'échelle augmente.

- Percée : conçu pour mesurer dans quelle mesure une tâche peut être apprise lorsque la taille du modèle dépasse une valeur critique.

Ces deux indicateurs sont fonction de la taille du modèle et des performances du modèle. Pour des détails de calcul spécifiques, veuillez vous référer à [4]. La figure ci-dessous montre quelques exemples de tâches à haute linéarité et à haute percée.

La plupart des tâches à haute linéarité sont basées sur la connaissance, ce qui signifie qu'elles reposent principalement sur la mémorisation des informations présentes dans les données d'entraînement, comme répondre à certaines questions factuelles. Les modèles plus grands utilisent généralement plus de données pour la formation et peuvent mémoriser plus de connaissances, de sorte que le modèle montre une amélioration stable dans ces tâches à mesure que l'échelle augmente. Les tâches de haute percée comprennent des tâches plus complexes qui nécessitent l'utilisation de plusieurs capacités différentes ou l'exécution de plusieurs étapes pour arriver à la bonne réponse, comme le raisonnement mathématique. Les modèles plus petits ont du mal à acquérir toutes les capacités nécessaires pour effectuer de telles tâches.

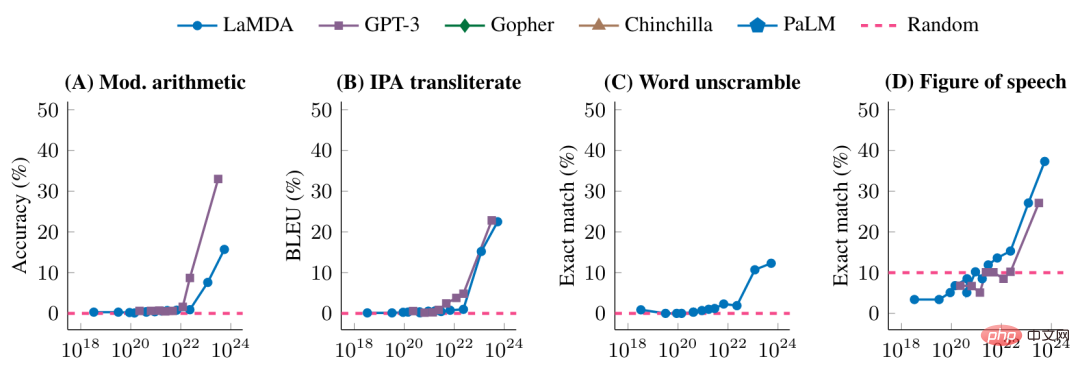

La figure ci-dessous montre en outre les performances de différents modèles sur certaines tâches à haute percée

Lorsqu'une certaine taille de modèle n'est pas atteinte, les performances du modèle sur ces tâches sont aléatoires après un certain temps. certaine échelle, il y a eu une amélioration significative.

Est-ce doux ou soudain ?

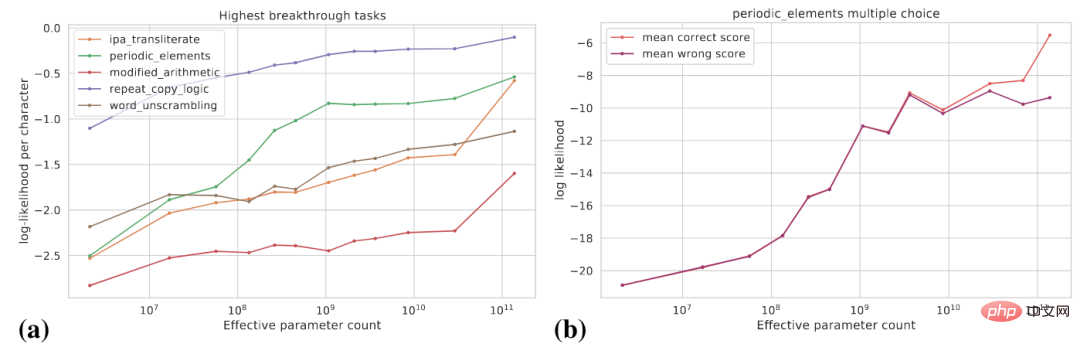

Ce que nous avons vu plus tôt, c'est qu'une fois que l'échelle du modèle a atteint un certain niveau, il acquiert soudainement certaines capacités. Du point de vue des indicateurs spécifiques à une tâche, ces capacités sont émergentes, mais d'un autre point de vue, les changements potentiels dans les capacités du modèle sont plus importants. lisse. Cet article aborde les deux perspectives suivantes : (1) utiliser des indicateurs plus fluides ; (2) décomposer des tâches complexes en plusieurs sous-tâches ;

La figure suivante (a) montre la courbe de changement de la probabilité logarithmique de la cible réelle pour certaines tâches à haute percée. La probabilité logarithmique de la cible réelle augmente progressivement à mesure que la taille du modèle augmente.

La figure (b) montre que pour une certaine tâche à choix multiples, à mesure que la taille du modèle augmente, la probabilité logarithmique de la bonne réponse augmente progressivement, tandis que la probabilité logarithmique de la mauvaise réponse est à un certain Il augmente progressivement avant une taille spécifique et se stabilise ensuite. Après cette échelle, l’écart entre la probabilité de bonnes réponses et la probabilité de mauvaises réponses se creuse, et le modèle obtient des améliorations significatives des performances.

De plus, pour une tâche spécifique, supposons que nous puissions utiliser Exact Match et BLEU pour évaluer les performances du modèle. BLEU est un indicateur plus fluide qu'Exact Match. Les tendances observées en utilisant différents indicateurs peuvent être significativement différentes de l'écart. .

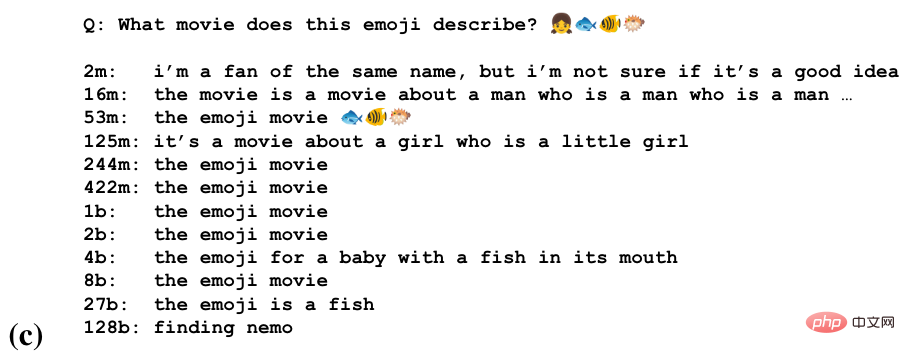

Pour certaines tâches, le modèle peut acquérir une capacité partielle à effectuer cette tâche à différentes échelles. L'image ci-dessous consiste à deviner le nom d'un film à travers une chaîne d'emojis

Nous pouvons voir que le modèle commence à deviner le nom du film à certaines échelles, reconnaît la sémantique des emojis à à plus grande échelle, et au plus grand Produire des réponses correctes à une échelle.

Les grands modèles sont très sensibles à la manière dont la tâche est formalisée

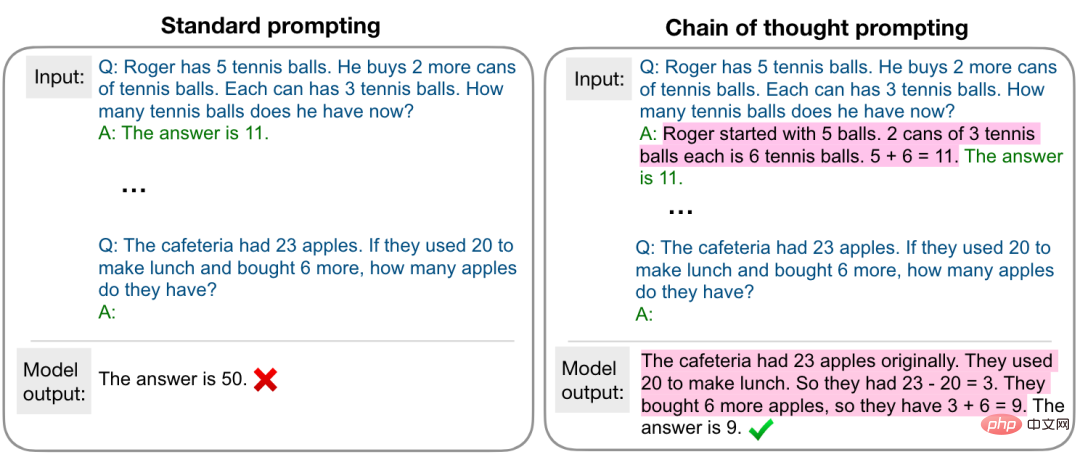

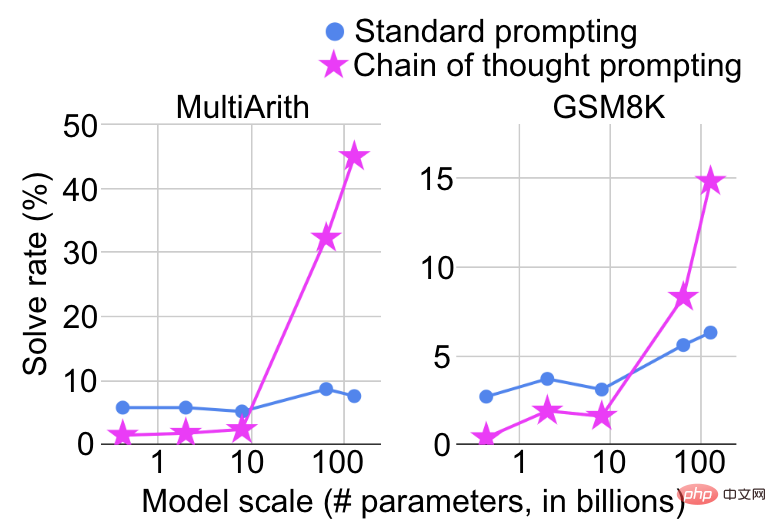

L'échelle à laquelle le modèle montre une amélioration soudaine de ses capacités dépend également de la manière dont la tâche est formalisée. Par exemple, sur des tâches de raisonnement mathématique complexes, si des invites standard sont utilisées pour les traiter comme une tâche de questions et réponses, l'amélioration des performances sera très limitée à mesure que la taille du modèle augmente. Cependant, si l'invite de chaîne de pensée [5] est utilisé comme le montre la figure ci-dessous, il sera traité comme une tâche de questions et réponses. Traité comme une tâche d'inférence en plusieurs étapes, des améliorations significatives des performances seront constatées à une certaine échelle.

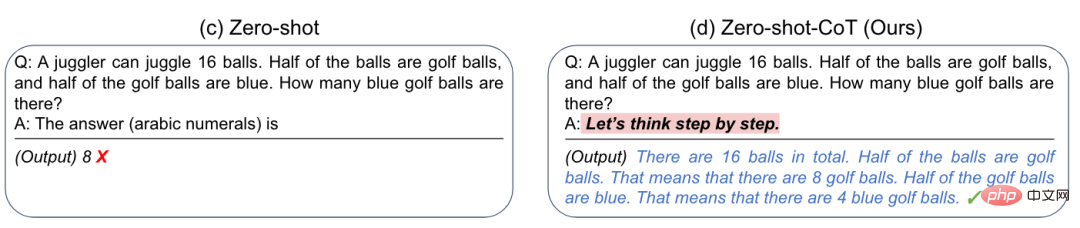

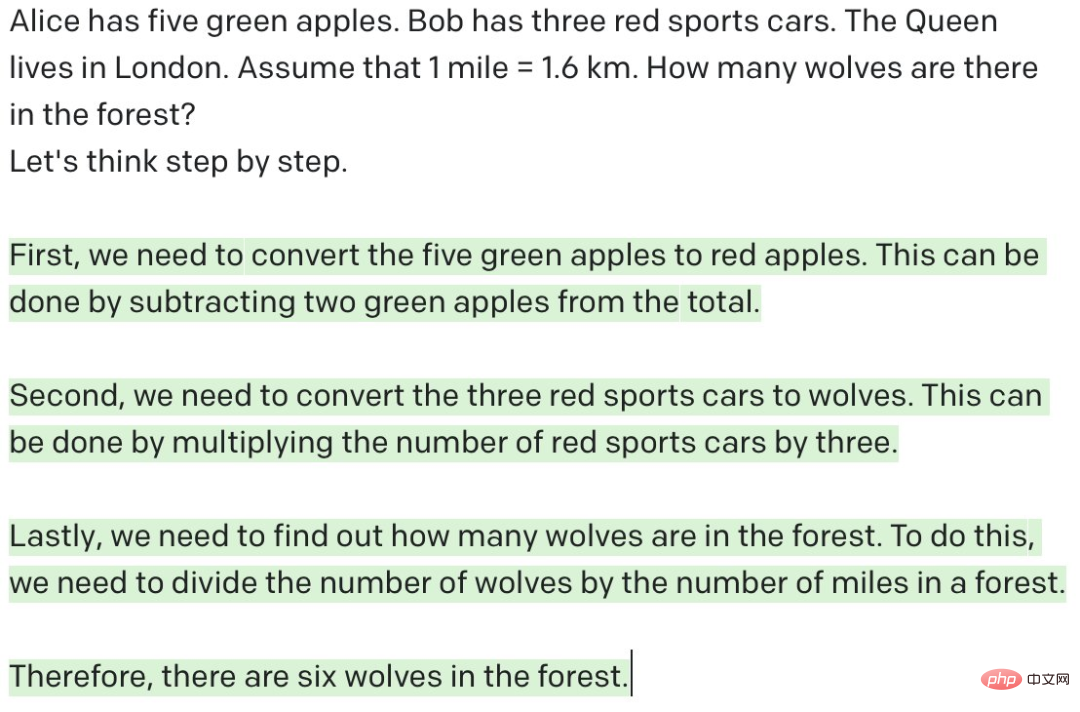

De plus, les chercheurs ont découvert qu'en ajoutant une simple invite « Pensons étape par étape », la capacité de raisonnement sans tir de GPT-3 peut être grandement améliorée[6] Comme le montre dans la figure ci-dessous

Cette inspiration pour nous est que parfois les grands modèles ne peuvent pas bien accomplir une certaine tâche, ce n'est peut-être pas qu'ils ne peuvent pas vraiment bien la faire, mais qu'ils ont besoin d'un moyen approprié pour la stimuler. cela.

Plus le modèle est grand forcément plus fort ?

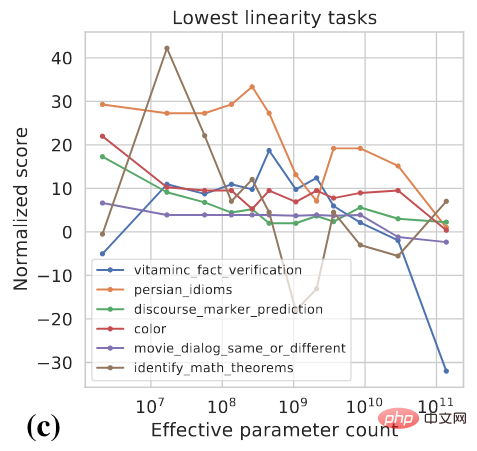

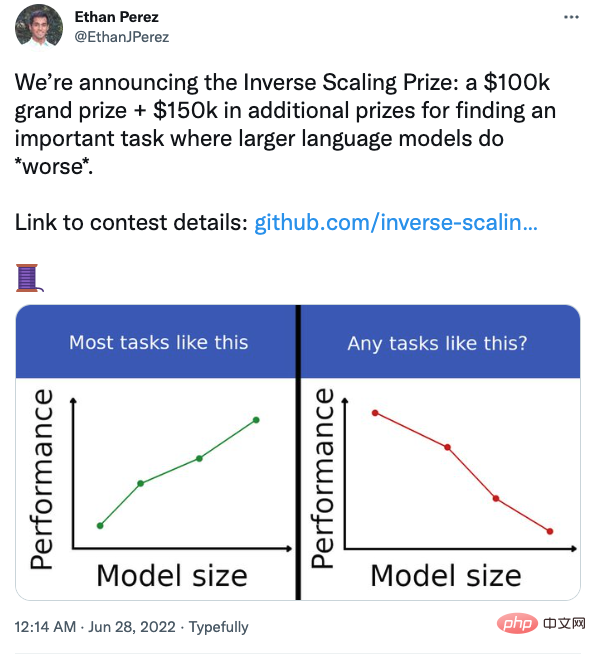

La discussion précédente nous donne le sentiment intuitif que les performances doivent être améliorées à mesure que la taille du modèle augmente, mais est-ce vraiment le cas ? En fait, pour certaines tâches, les performances peuvent diminuer à mesure que le modèle devient plus grand, comme le montre la figure ci-dessous

Plusieurs chercheurs de l'Université de New York ont également organisé un concours pour trouver les tâches où les performances du modèle se détériore à mesure que le modèle devient plus grand.

Par exemple, dans une tâche de questions et réponses, si vous ajoutez vos croyances avec la question, le grand modèle sera plus facilement affecté. Les étudiants intéressés peuvent y prêter attention.

Résumé et réflexions

- Dans la plupart des tâches, à mesure que la taille du modèle augmente, les performances du modèle s'améliorent, mais il y aura également des contre-exemples. Des recherches supplémentaires sont nécessaires pour mieux comprendre le comportement des modèles.

- La capacité des grands modèles doit être stimulée de manière adaptée.

- Le grand modèle fait-il vraiment de l'inférence ? Comme nous l'avons vu précédemment, en ajoutant l'invite « Pensons étape par étape », le grand modèle peut effectuer un raisonnement en plusieurs étapes et obtenir des résultats satisfaisants sur les tâches de raisonnement mathématique. Il semble que le modèle possède déjà des capacités de raisonnement humain. Cependant, comme indiqué ci-dessous, si vous posez à GPT-3 une question dénuée de sens et que vous le laissez effectuer un raisonnement en plusieurs étapes, GPT-3 semble faire un raisonnement, mais en fait, il s'agit d'un résultat dénué de sens. Comme le dit le proverbe « les déchets rentrent, les déchets sortent ». En comparaison, les humains peuvent juger si la question est raisonnable, c’est-à-dire si la question actuelle peut répondre dans des conditions données. "Pensons étape par étape" peut fonctionner. Je pense que la raison fondamentale est que GPT-3 a vu beaucoup de données similaires au cours du processus de formation, c'est simplement prédire le prochain jeton en fonction du jeton précédent. Il existe encore des différences fondamentales dans la façon de penser. Bien sûr, si des invites appropriées sont données pour permettre à GPT-3 de juger si la question est raisonnable, il pourra peut-être le faire dans une certaine mesure, mais il y a encore une distance considérable entre la « réflexion » et le « raisonnement ». Ce n’est pas simple. Cela peut être résolu en augmentant la taille du modèle. Les modèles n’ont peut-être pas besoin de penser comme les humains, mais des recherches supplémentaires sont nécessaires de toute urgence pour explorer des voies autres que l’augmentation de la taille des modèles.

- Système 1 ou Système 2 ? Le cerveau humain possède deux systèmes qui coopèrent l’un avec l’autre : le système 1 (intuition) est rapide et automatique, tandis que le système 2 (rationalité) est lent et contrôlable. Un grand nombre d'expériences ont prouvé que les gens préfèrent utiliser l'intuition pour porter des jugements et prendre des décisions, et que la rationalité peut corriger les biais qu'elle provoque. La plupart des modèles actuels sont conçus sur la base du système 1 ou du système 2. Les futurs modèles peuvent-ils être conçus sur la base de systèmes doubles ?

- Langage de requête pour l'ère des grands modèles. Auparavant, nous stockions les connaissances et les données dans des bases de données et des graphiques de connaissances. Nous pouvons utiliser SQL pour interroger des bases de données relationnelles et SPARQL pour interroger des graphiques de connaissances. Alors, quel langage de requête utilisons-nous pour appeler les connaissances et les capacités des grands modèles ?

M. Mei Yiqi a dit un jour : « Le soi-disant grand érudit ne signifie pas un bâtiment, mais un maître. » L'auteur termine cet article par une analogie inappropriée : la soi-disant grande personne modèle, c'est le cas. Cela ne veut pas dire qu’il existe des paramètres, mais cela signifie qu’il existe des capacités.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

phpmyadmin crée un tableau de données

Apr 10, 2025 pm 11:00 PM

phpmyadmin crée un tableau de données

Apr 10, 2025 pm 11:00 PM

Pour créer un tableau de données à l'aide de PhpMyAdmin, les étapes suivantes sont essentielles: connectez-vous à la base de données et cliquez sur le nouvel onglet. Nommez le tableau et sélectionnez le moteur de stockage (InnODB recommandé). Ajouter les détails de la colonne en cliquant sur le bouton Ajouter une colonne, y compris le nom de la colonne, le type de données, s'il faut autoriser les valeurs nuls et d'autres propriétés. Sélectionnez une ou plusieurs colonnes comme clés principales. Cliquez sur le bouton Enregistrer pour créer des tables et des colonnes.

Comment gérer la fragmentation de la mémoire redis?

Apr 10, 2025 pm 02:24 PM

Comment gérer la fragmentation de la mémoire redis?

Apr 10, 2025 pm 02:24 PM

La fragmentation de la mémoire redis fait référence à l'existence de petites zones libres dans la mémoire allouée qui ne peut pas être réaffectée. Les stratégies d'adaptation comprennent: Redémarrer Redis: effacer complètement la mémoire, mais le service d'interruption. Optimiser les structures de données: utilisez une structure plus adaptée à Redis pour réduire le nombre d'allocations et de versions de mémoire. Ajustez les paramètres de configuration: utilisez la stratégie pour éliminer les paires de valeurs clés les moins récemment utilisées. Utilisez le mécanisme de persistance: sauvegardez régulièrement les données et redémarrez Redis pour nettoyer les fragments. Surveillez l'utilisation de la mémoire: découvrez les problèmes en temps opportun et prenez des mesures.

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:33 PM

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:33 PM

La création d'une base de données Oracle n'est pas facile, vous devez comprendre le mécanisme sous-jacent. 1. Vous devez comprendre les concepts de la base de données et des SGBD Oracle; 2. Master les concepts de base tels que SID, CDB (base de données de conteneurs), PDB (base de données enfichable); 3. Utilisez SQL * Plus pour créer CDB, puis créer PDB, vous devez spécifier des paramètres tels que la taille, le nombre de fichiers de données et les chemins; 4. Les applications avancées doivent ajuster le jeu de caractères, la mémoire et d'autres paramètres et effectuer un réglage des performances; 5. Faites attention à l'espace disque, aux autorisations et aux paramètres des paramètres, et surveillez et optimisez en continu les performances de la base de données. Ce n'est qu'en le maîtrisant habilement une pratique continue que vous pouvez vraiment comprendre la création et la gestion des bases de données Oracle.

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:36 PM

Comment créer une base de données Oracle Comment créer une base de données Oracle

Apr 11, 2025 pm 02:36 PM

Pour créer une base de données Oracle, la méthode commune consiste à utiliser l'outil graphique DBCA. Les étapes sont les suivantes: 1. Utilisez l'outil DBCA pour définir le nom DBN pour spécifier le nom de la base de données; 2. Définissez Syspassword et SystemPassword sur des mots de passe forts; 3. Définir les caractères et NationalCharacterset à Al32Utf8; 4. Définissez la taille de mémoire et les espaces de table pour s'ajuster en fonction des besoins réels; 5. Spécifiez le chemin du fichier log. Les méthodes avancées sont créées manuellement à l'aide de commandes SQL, mais sont plus complexes et sujets aux erreurs. Faites attention à la force du mot de passe, à la sélection du jeu de caractères, à la taille et à la mémoire de l'espace de table

Moniteur Disd Droplet avec service d'exportateur Redis

Apr 10, 2025 pm 01:36 PM

Moniteur Disd Droplet avec service d'exportateur Redis

Apr 10, 2025 pm 01:36 PM

La surveillance efficace des bases de données Redis est essentielle pour maintenir des performances optimales, identifier les goulots d'étranglement potentiels et assurer la fiabilité globale du système. Le service Redis Exporter est un utilitaire puissant conçu pour surveiller les bases de données Redis à l'aide de Prometheus. Ce didacticiel vous guidera à travers la configuration et la configuration complètes du service Redis Exportateur, en vous garantissant de créer des solutions de surveillance de manière transparente. En étudiant ce tutoriel, vous réaliserez les paramètres de surveillance entièrement opérationnels

Quels sont les paramètres de configuration de la mémoire redis?

Apr 10, 2025 pm 02:03 PM

Quels sont les paramètres de configuration de la mémoire redis?

Apr 10, 2025 pm 02:03 PM

** Le paramètre central de la configuration de la mémoire redis est MaxMemory, qui limite la quantité de mémoire que Redis peut utiliser. Lorsque cette limite est dépassée, Redis exécute une stratégie d'élimination selon maxmemory-policy, notamment: Noeviction (rejeter directement l'écriture), AllKeys-LRU / Volatile-LRU (éliminé par LRU), AllKeys-Random / Volatile-Random (éliminé par élimination aléatoire) et TTL volatile (temps d'expiration). D'autres paramètres connexes incluent des échantillons maxmemory (quantité d'échantillon LRU), compression RDB

Comment rédiger des instructions de base de données Oracle

Apr 11, 2025 pm 02:42 PM

Comment rédiger des instructions de base de données Oracle

Apr 11, 2025 pm 02:42 PM

Le cœur des instructions Oracle SQL est sélectionné, insérer, mettre à jour et supprimer, ainsi que l'application flexible de diverses clauses. Il est crucial de comprendre le mécanisme d'exécution derrière l'instruction, tel que l'optimisation de l'indice. Les usages avancés comprennent des sous-requêtes, des requêtes de connexion, des fonctions d'analyse et PL / SQL. Les erreurs courantes incluent les erreurs de syntaxe, les problèmes de performances et les problèmes de cohérence des données. Les meilleures pratiques d'optimisation des performances impliquent d'utiliser des index appropriés, d'éviter la sélection *, d'optimiser les clauses et d'utiliser des variables liées. La maîtrise d'Oracle SQL nécessite de la pratique, y compris l'écriture de code, le débogage, la réflexion et la compréhension des mécanismes sous-jacents.

Qu'est-ce que le mécanisme de gestion de la mémoire redis?

Apr 10, 2025 pm 01:39 PM

Qu'est-ce que le mécanisme de gestion de la mémoire redis?

Apr 10, 2025 pm 01:39 PM

Redis adopte un mécanisme de gestion granulaire de la mémoire, notamment: une structure de données conviviale bien conçue, un allocateur multi-mémoire qui optimise les stratégies d'allocation pour différentes tailles de blocs de mémoire, un mécanisme d'élimination de la mémoire qui sélectionne une stratégie d'élimination basée sur des besoins spécifiques et des outils pour surveiller l'utilisation de la mémoire. Le but de ce mécanisme est d'atteindre les performances ultimes, grâce à un contrôle fin et à une utilisation efficace de la mémoire, à minimiser la fragmentation de la mémoire et à améliorer l'efficacité d'accès, en veillant à ce que Redis fonctionne de manière stable et efficace dans divers scénarios.