Aujourd'hui, certaines phrases qui ressemblent beaucoup à des humains sont en réalité générées par des systèmes d'intelligence artificielle qui ont été entraînés sur de grandes quantités de texte humain. Les gens sont tellement habitués à supposer que le langage courant vient de la pensée et du ressenti des humains que la preuve du contraire peut être incompréhensible, et que si un modèle d'IA peut s'exprimer couramment, cela signifie qu'il pense et se sent également comme un humain.

Il n’est donc peut-être pas surprenant qu’un ancien ingénieur de Google ait récemment affirmé que le système d’intelligence artificielle de Google, LAMDA, est conscient de lui-même car il peut générer avec éloquence un texte sur ses prétendus sentiments. L’incident et la couverture médiatique qui a suivi ont conduit à des articles et à des messages mettant en doute les affirmations selon lesquelles les modèles informatiques du langage humain sont vivants.

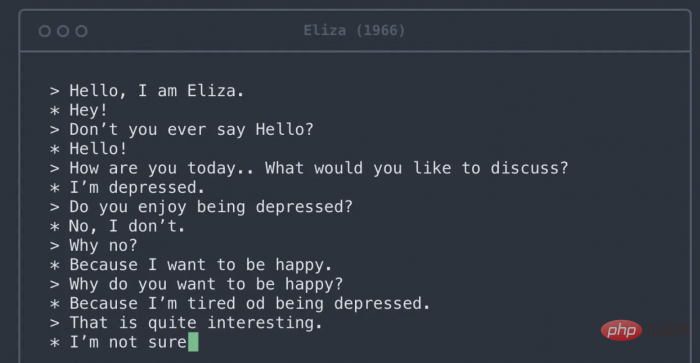

Le texte généré par des modèles tels que LaMDA de Google peut être difficile à distinguer du texte écrit par des humains. Cette réalisation impressionnante est le résultat d’un projet de plusieurs décennies visant à créer des modèles capables de générer un langage grammatical et significatif. Les modèles actuels, dotés de données et d'ensembles de règles qui se rapprochent du langage humain, diffèrent de ces premières tentatives sur plusieurs points importants. Premièrement, ils sont essentiellement formés sur l’ensemble d’Internet. Deuxièmement, ils peuvent apprendre les relations entre des mots éloignés, et pas seulement entre des mots adjacents. Troisièmement, ils subissent tellement de modifications internes que même les ingénieurs qui les conçoivent ont du mal à comprendre pourquoi ils produisent une séquence de mots et pas une autre.

Le modèle linguistique d'intelligence artificielle à grande échelle permet des conversations fluides. Cependant, ils n’ont pas de message global à transmettre, leurs phrases ont donc tendance à suivre des tropes littéraires courants tirés des textes sur lesquels ils ont été formés. Le cerveau humain possède des règles bien établies pour déduire l’intention derrière les mots. Chaque fois que vous engagez une conversation, votre cerveau construit automatiquement un modèle mental de votre interlocuteur. Vous utilisez ensuite ce qu'ils disent pour remplir le modèle avec les objectifs, les sentiments et les croyances de la personne. Le passage des énoncés aux modèles mentaux se fait en douceur et se déclenche chaque fois que vous recevez une phrase complète. Ce processus cognitif vous fait gagner beaucoup de temps et d’énergie au quotidien et facilite grandement vos interactions sociales. Cependant, dans le cas d’un système d’IA, il échoue car il construit un modèle mental à partir de rien.

Une triste ironie est que les mêmes biais cognitifs qui permettent aux gens d'attribuer l'humanité aux grands modèles de langage de l'IA les amènent également à traiter les vrais humains de manière inhumaine. Les recherches en linguistique socioculturelle montrent que supposer un lien trop fort entre une expression fluide et une pensée fluide peut conduire à des préjugés contre différentes personnes. Par exemple, les personnes ayant un accent étranger sont souvent considérées comme moins intelligentes et moins susceptibles d’obtenir des emplois pour lesquels elles sont qualifiées. Des préjugés similaires existent contre les dialectes qui ne sont pas considérés comme prestigieux, comme l'anglais du Sud aux États-Unis, contre les personnes sourdes qui utilisent la langue des signes et contre les personnes souffrant de troubles du langage comme le bégaiement. Ces préjugés sont très préjudiciables et conduisent souvent à des hypothèses racistes et sexistes qui se sont révélées à maintes reprises infondées.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

Comment lier des données dans une liste déroulante

Comment lier des données dans une liste déroulante

Nettoyer les fichiers indésirables dans Win10

Nettoyer les fichiers indésirables dans Win10

Comment faire correspondre les nombres dans les expressions régulières

Comment faire correspondre les nombres dans les expressions régulières

commandes communes iscsiadm

commandes communes iscsiadm

geforce 940mx

geforce 940mx

Comment commenter le code en HTML

Comment commenter le code en HTML