Périphériques technologiques

Périphériques technologiques

IA

IA

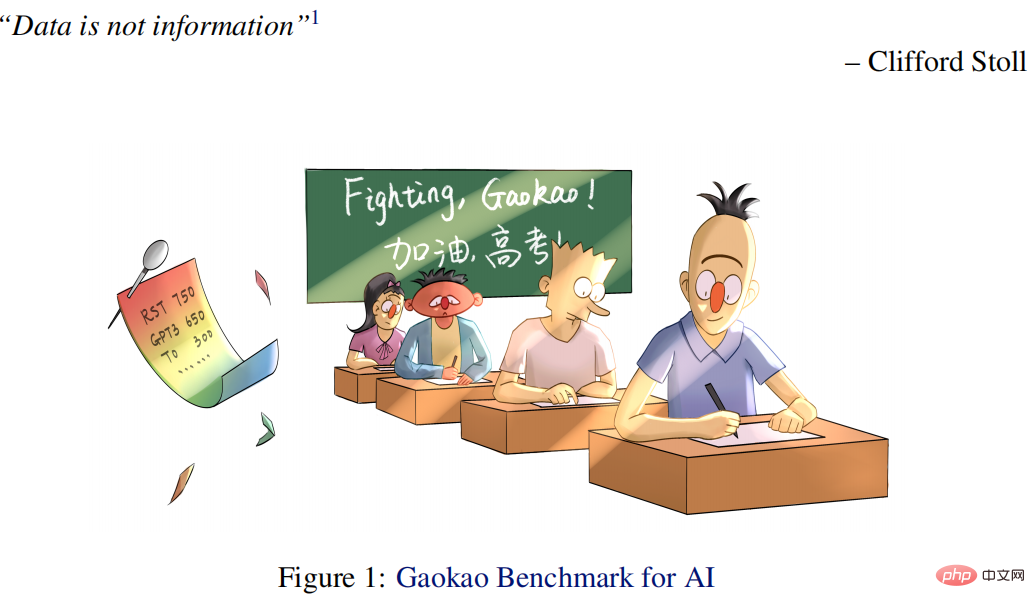

Lors de l'examen d'entrée à l'université d'anglais de cette année, la CMU a utilisé la pré-formation en reconstruction pour obtenir un score élevé de 134, dépassant largement le GPT3.

Lors de l'examen d'entrée à l'université d'anglais de cette année, la CMU a utilisé la pré-formation en reconstruction pour obtenir un score élevé de 134, dépassant largement le GPT3.

Lors de l'examen d'entrée à l'université d'anglais de cette année, la CMU a utilisé la pré-formation en reconstruction pour obtenir un score élevé de 134, dépassant largement le GPT3.

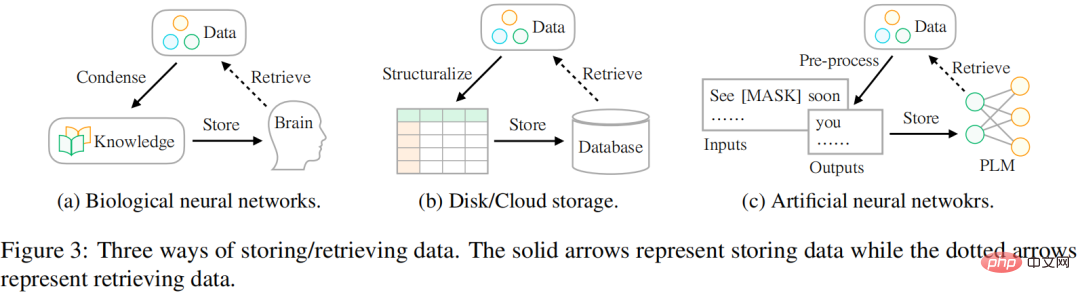

La façon dont nous stockons les données évolue, des réseaux de neurones biologiques aux réseaux de neurones artificiels. En fait, la situation la plus courante consiste à utiliser le cerveau pour stocker des données. Alors que la quantité de données disponibles aujourd’hui continue de croître, les gens cherchent à stocker des données à l’aide de différents périphériques externes tels que des disques durs ou un stockage cloud. Avec l’essor de la technologie du deep learning, une autre technologie de stockage prometteuse est apparue, qui utilise des réseaux de neurones artificiels pour stocker des informations dans des données.

Les chercheurs pensent que le but ultime du stockage des données est de mieux servir la vie humaine, et que la méthode d'accès aux données est tout aussi importante que la méthode de stockage. Il existe cependant des différences dans la manière dont les données sont stockées et accessibles. Historiquement, les gens ont eu du mal à combler ce fossé afin de mieux utiliser les informations disponibles dans le monde. Comme le montre la figure 3 :

- En termes de réseaux de neurones biologiques (comme le cerveau humain), les humains sont éduqués avec des cours (c'est-à-dire des connaissances) dès leur plus jeune âge afin qu'ils puissent extraire des données spécifiques à traiter. des complexités complexes. Une vie changée.

- Pour le stockage sur périphérique externe, les utilisateurs structurent généralement les données selon un certain modèle (comme un tableau), puis utilisent un langage spécialisé (tel que SQL) pour récupérer efficacement les informations requises de la base de données.

- Pour le stockage basé sur un réseau neuronal artificiel, les chercheurs exploitent l'apprentissage auto-supervisé pour stocker les données de grands corpus (c'est-à-dire la pré-formation), puis utilisent le réseau pour diverses tâches en aval (telles que la classification des émotions).

Des chercheurs de la CMU ont proposé une nouvelle façon d'accéder aux données contenant divers types d'informations qui peuvent servir de signaux de pré-entraînement pour guider l'optimisation des paramètres du modèle. L'étude présente les données de manière structurée en unités de signaux. Ceci est similaire au scénario d'utilisation d'une base de données pour stocker des données : elles sont d'abord structurées sous forme de tableau ou au format JSON, afin que les informations exactes requises puissent être récupérées via un langage spécialisé tel que SQL.

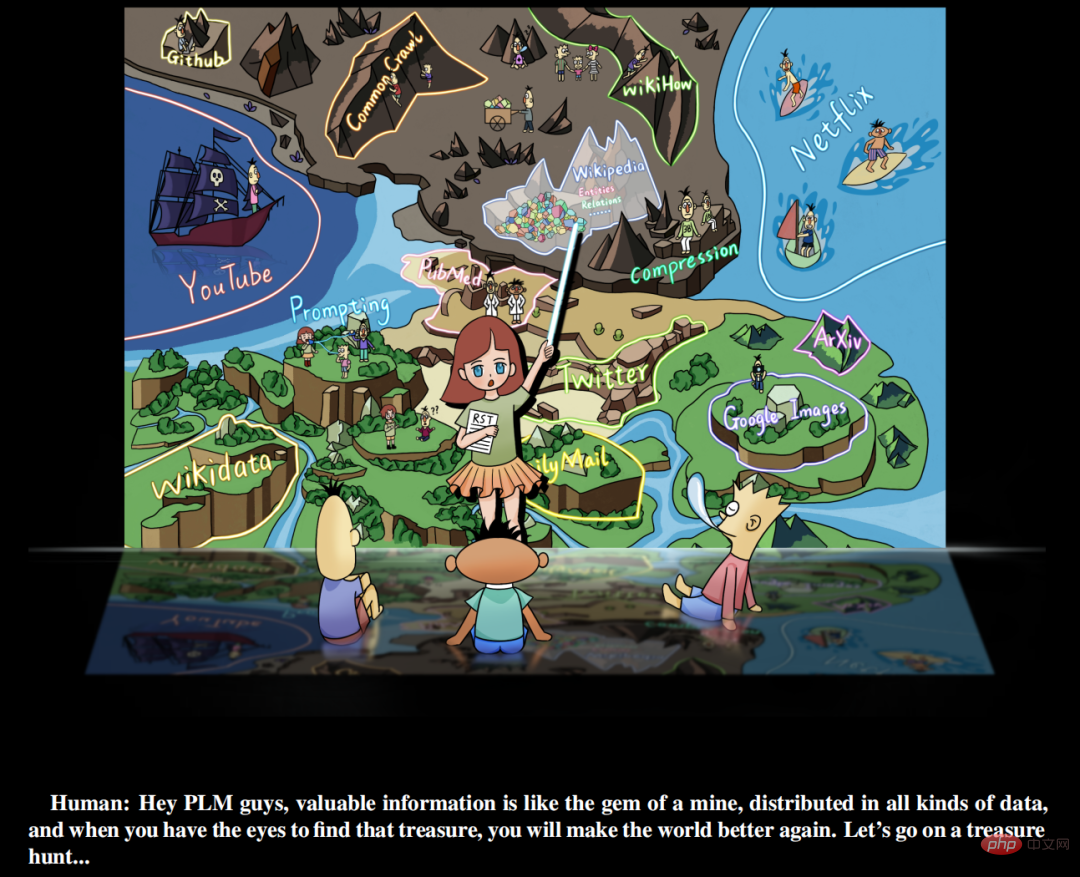

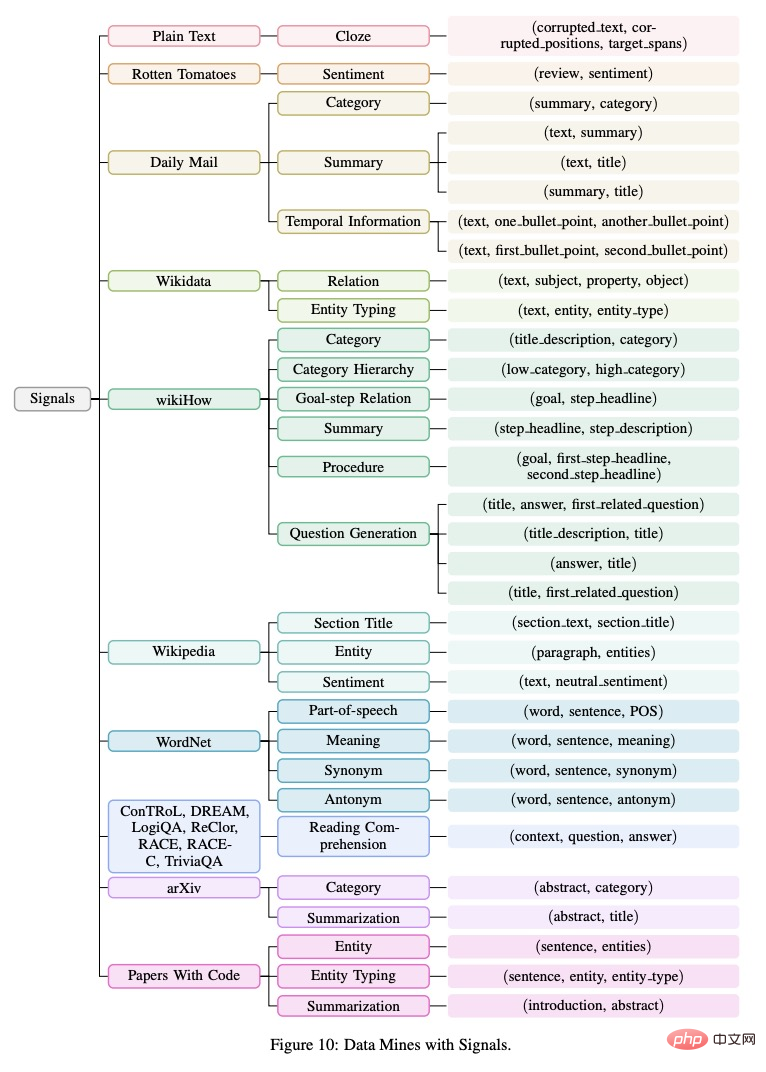

De plus, cette étude estime que des signaux précieux existent en abondance dans toutes sortes de données dans le monde, plutôt que d'exister simplement dans des ensembles de données supervisés et organisés manuellement. Ce que les chercheurs doivent faire est (a) d'identifier les données (b) d'utiliser Unified. les données de réorganisation linguistique (c) les intègrent et les stockent dans un modèle linguistique pré-entraîné. L’étude appelle ce paradigme d’apprentissage la pré-formation restructurée (RST). Les chercheurs comparent le processus à une « chasse au trésor dans une mine ». Différentes sources de données comme Wikipédia sont équivalentes à des mines riches en pierres précieuses. Ils contiennent des informations riches, telles que des entités nommées provenant d'hyperliens, qui peuvent fournir des signaux pour la pré-formation du modèle. Un bon modèle pré-entraîné (PLM) doit clairement comprendre la composition des différents signaux dans les données afin de fournir des informations précises basées sur les différents besoins des tâches en aval.

Adresse papier : https://arxiv.org/pdf/2206.11147.pdf

Chasse au trésor de modèles de langage pré-entraînés

Cette recherche propose un nouveau paradigme pour l'apprentissage des tâches de traitement du langage naturel, à savoir RST, ce paradigme remet l'accent sur le rôle des données et traite la pré-formation du modèle et le réglage fin des tâches en aval comme le processus de stockage et d'accès aux données. Sur cette base, cette recherche réalise un principe simple, à savoir qu'un bon mécanisme de stockage doit non seulement avoir la capacité de mettre en cache de grandes quantités de données, mais également prendre en compte la commodité d'accès.

Après avoir surmonté certains défis d'ingénierie, la recherche y est parvenue grâce à une pré-formation sur des données reconstruites (composées de diverses informations précieuses au lieu des données originales). Les expériences démontrent que le modèle RST non seulement surpasse de manière significative les meilleurs systèmes existants (par exemple, T0) sur 52/55 ensembles de données populaires provenant de diverses tâches de PNL (par exemple, classification, extraction d'informations, récupération de faits, génération de texte, etc.), mais il fait également ne nécessite pas d'affiner les tâches en aval. Il a également obtenu d'excellents résultats à l'examen d'anglais d'entrée à l'université le plus réputé de Chine, que passent des millions d'étudiants chaque année.

Plus précisément, l'examen d'entrée à l'université AI (Qin) proposé dans cet article est supérieur de 40 points au score moyen des étudiants et de 15 points supérieur à celui du GPT3 en utilisant 1/16 de paramètres. Le Qin spécial a obtenu un score élevé de 138,5 (sur 150) au test d'anglais de 2018.

En outre, l'étude a également publié la plateforme de soumission en ligne Gaokao Benchmark, qui contient 10 épreuves d'anglais annotées de 2018 à 2021 jusqu'à aujourd'hui (et sera élargie chaque année), permettant à davantage de modèles d'IA de participer à l'examen d'entrée à l'université. L'étude a également établi une plate-forme de test relativement équitable pour la compétition entre les humains et l'IA afin de nous aider à mieux comprendre où nous en sommes. De plus, lors du test d'anglais de l'examen d'entrée au collège 2022 il y a quelques jours (08/06/2022), le système d'IA a obtenu un bon score de 134 points, tandis que GPT3 n'a obtenu que 108 points.

Les principales contributions de cette recherche comprennent :

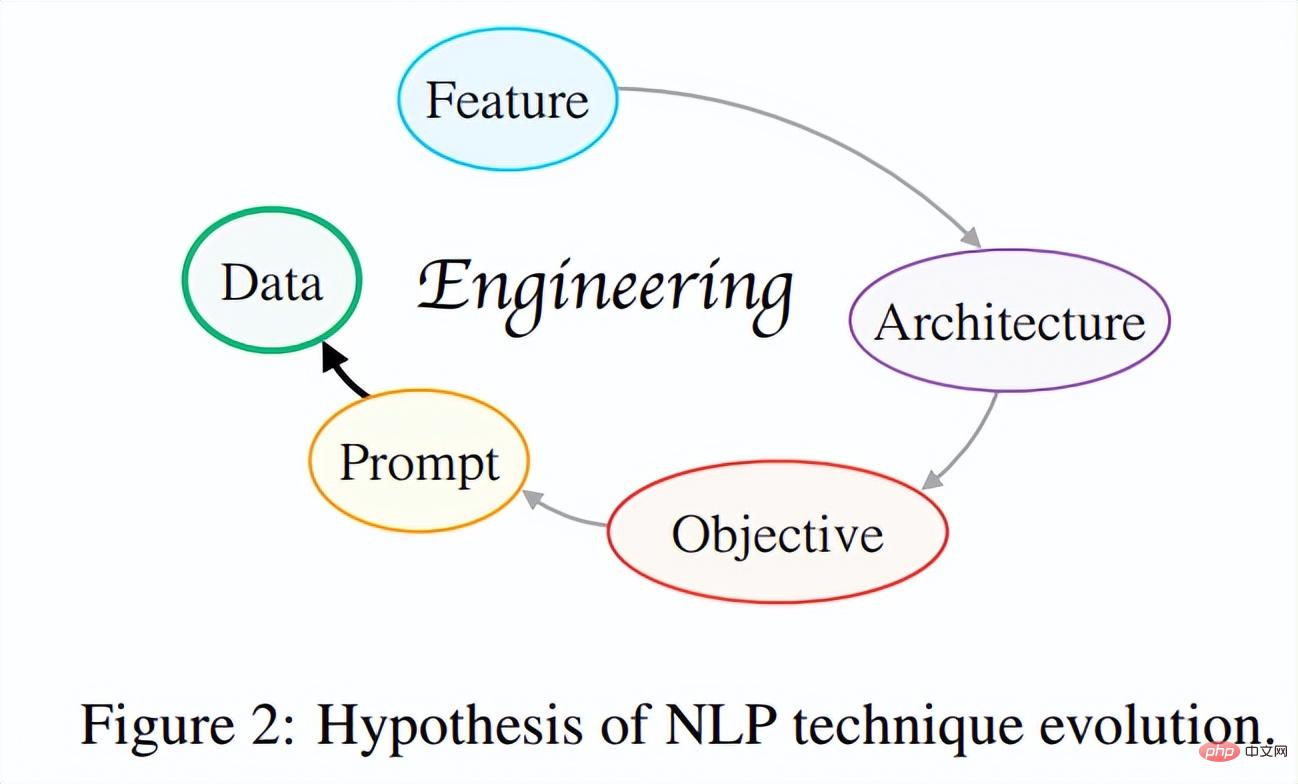

(1) Proposer une hypothèse d'évolution des méthodes PNL. Cette recherche tente d'établir « l'hypothèse de l'évolution de la technologie NLP » dans une perspective globale en explorant les liens intrinsèques entre le développement de la technologie NLP moderne. En bref, l’idée centrale de cette hypothèse est que les itérations technologiques évoluent toujours dans une direction telle que les développeurs n’ont qu’à en faire moins pour concevoir des systèmes meilleurs et plus polyvalents.

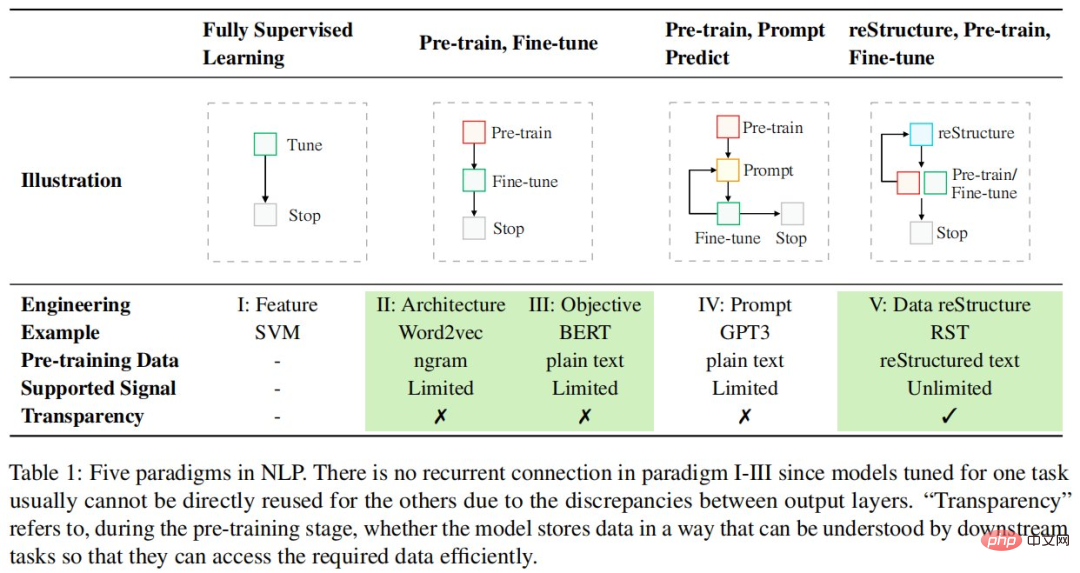

Jusqu'à présent, l'évolution de la technologie NLP a connu plusieurs itérations, comme le montre la figure 2 : ingénierie des fonctionnalités → ingénierie de l'architecture → ingénierie des cibles → ingénierie des invites, et évolue vers une ingénierie centrée sur les données plus pratique et plus efficace. . Les chercheurs espèrent qu'à l'avenir, davantage de chercheurs scientifiques seront incités à réfléchir de manière critique à cette question, à saisir la principale force motrice du progrès technologique, à trouver une voie « progressive vers le haut » pour le développement universitaire et à entreprendre des travaux plus significatifs sur le plan scientifique.

(2) Nouveau paradigme basé sur l'hypothèse d'évolution : Pré-formation restructurée. Ce paradigme traite la pré-formation/le réglage fin du modèle comme un processus de stockage/d'accès aux données et affirme qu'un bon mécanisme de stockage devrait rendre les données souhaitées facilement accessibles. Avec un tel nouveau paradigme, la recherche a pu unifier 26 types différents de signaux dans le monde (par exemple des entités de phrases) à partir de 10 sources de données (par exemple Wikipédia). Le modèle général formé sur cette base a atteint de fortes capacités de généralisation sur diverses tâches, dont 55 ensembles de données PNL.

(3) IA pour l'examen d'entrée à l'université. Sur la base du paradigme ci-dessus, cette étude a développé un système d'IA spécialement conçu pour les tâches de test d'anglais de l'examen d'entrée à l'université - Qin. Il s’agit du premier système d’intelligence artificielle anglaise au monde basé sur l’apprentissage profond. Qin a obtenu des résultats exceptionnels aux questions de l'examen d'entrée à l'université pendant de nombreuses années : 40 points de plus que les gens ordinaires et 15 points de plus que le GPT-3 en utilisant seulement 1/16 des paramètres du GPT-3. Surtout dans les questions du test d'anglais de 2018, QIN a obtenu un score élevé de 138,5 points (sur 150 points), avec des scores parfaits en compréhension orale et écrite.

(4) Riches ressources. (1) Afin de suivre les progrès de la technologie d’IA existante dans la réalisation de l’intelligence humaine, l’étude a publié un nouveau benchmark – Gaokao Benchmark. Non seulement il fournit une évaluation complète d’une variété de tâches et de domaines pratiques dans des scénarios du monde réel, mais il fournit également des scores de performance humaine afin que les systèmes d’IA puissent être directement comparés aux humains. (2) Cette étude utilise ExplainaBoard (Liu et al., 2021b) pour définir un classement interactif pour Gaokao Benchmark afin que davantage de systèmes d'IA puissent facilement participer à Gaokao Benchmark et obtenir automatiquement des scores. (3) Toutes les ressources peuvent être trouvées sur GitHub.

De plus, le succès de l'IA dans le test d'anglais de l'examen d'entrée à l'université a fourni aux chercheurs de nombreuses nouvelles idées : la technologie de l'IA peut renforcer l'éducation et aider à résoudre une série de problèmes dans l'éducation et l'enseignement.

Par exemple, (a) aider les enseignants à automatiser la notation, (b) aider les élèves à répondre aux questions sur les devoirs et à les expliquer en détail, et (c) plus important encore, promouvoir l'équité éducative afin que la plupart des familles puissent recevoir la même éducation de qualité. Ce travail intègre pour la première fois 26 signaux différents provenant du monde entier de manière unifiée, et plutôt que d'essayer de faire la distinction entre les données supervisées et non supervisées, il s'intéresse à la quantité et à la manière dont nous pouvons utiliser les informations que la nature nous donne. Les performances exceptionnelles sur plus de 50 ensembles de données provenant de diverses tâches de PNL montrent la valeur de la pré-formation centrée sur les données et inspirent davantage d'explorations futures.

Pré-formation en refactoring

Les paradigmes pour résoudre les tâches de PNL évoluent rapidement et se poursuivent toujours. Le tableau suivant répertorie les cinq paradigmes en PNL :

.

Différent du paradigme de conception centré sur le modèle existant, cette recherche réfléchit davantage du point de vue des données pour maximiser l'utilisation des données existantes. Plus précisément, cette étude adopte la vision du stockage et de l'accès aux données, où l'étape de pré-formation est considérée comme le processus de stockage des données, tandis que les tâches en aval (par exemple, la classification des sentiments) basées sur le modèle pré-entraîné sont considérées comme le processus d'accès aux données. à partir du modèle pré-entraîné, et affirme qu'un bon mécanisme de stockage de données devrait rendre les données stockées plus accessibles.

Pour atteindre cet objectif, cette recherche traite les données comme un objet composé de différents signaux et estime qu'un bon modèle pré-entraîné devrait (1) couvrir autant de types de signaux que possible, (2) lorsque les tâches en aval l'exigent, fournir des mécanismes précis d’accès à ces signaux. De manière générale, ce nouveau paradigme se compose de trois étapes : la reconstruction, la pré-formation et la mise au point.

Le nouveau paradigme de reconstruction, de pré-formation et de mise au point met en évidence l'importance des données, et les chercheurs doivent investir davantage d'énergie d'ingénierie dans le traitement des données.

Ingénierie de la reconstruction

Définition du signal

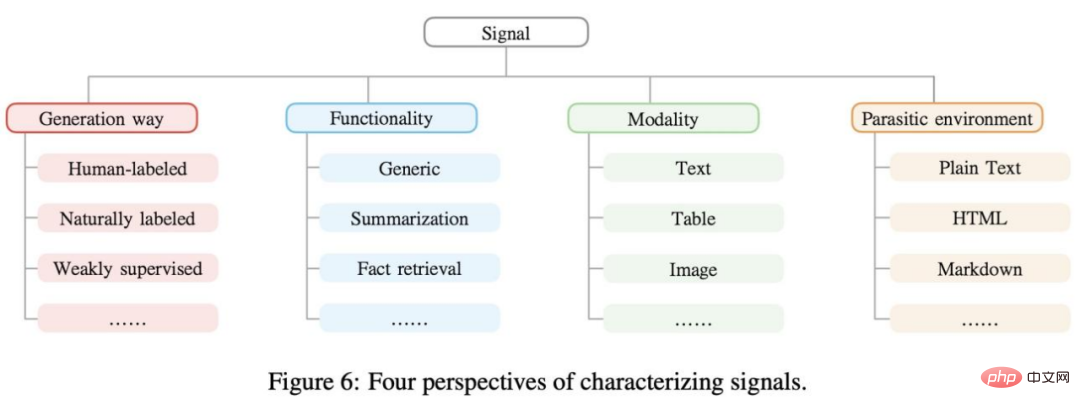

Les signaux sont des informations utiles présentes dans les données qui peuvent fournir une supervision aux modèles d'apprentissage automatique, exprimées sous forme de n-tuple. Par exemple, « Mozart est né à Salzbourg », « Mozart » et « Salzbourg » peuvent être considérés comme des signaux pour la reconnaissance d'une entité nommée. En règle générale, les signaux peuvent être regroupés sous différentes perspectives, comme le montre la figure 6 ci-dessous.

Data Mining

Les données du monde réel contiennent de nombreux types de signaux différents. La reconstruction du pré-entraînement permet d'exploiter pleinement ces signaux. L'étude a organisé les signaux collectés (n-uplets) dans un diagramme arborescent, comme le montre la figure 10 ci-dessous.

Extraction de signaux

L'étape suivante de l'étude était l'extraction et le traitement du signal, qui impliquait l'obtention de données brutes à partir de différentes modalités d'exploration de données, de nettoyage et de normalisation des données. Les méthodes existantes sont grossièrement divisées en deux types : (1) basées sur des règles et (2) basées sur l'apprentissage automatique. Dans ce travail, la recherche se concentre principalement sur les stratégies d’extraction de signaux basées sur des règles et laisse des méthodes à couverture plus élevée pour les travaux futurs.

Reconstruction du signal

Après avoir extrait différents signaux de diverses explorations de données, la prochaine étape importante consiste à les unifier sous une forme fixe afin que toutes les informations soient stockées de manière cohérente dans le modèle pendant la pré-formation. La méthode d'invite (Brown et al., 2020 ; Liu et al., 2021d) peut atteindre cet objectif et, en principe, avec une conception d'invite appropriée, elle peut unifier presque tous les types de signaux dans un style de modèle de langage.

L'étude a divisé les signaux en deux grandes catégories : les signaux généraux et les signaux liés à la tâche. Le premier contient des connaissances linguistiques de base et peut bénéficier dans une certaine mesure à toutes les tâches en aval, tandis que le second peut bénéficier à certaines tâches spécifiques en aval.

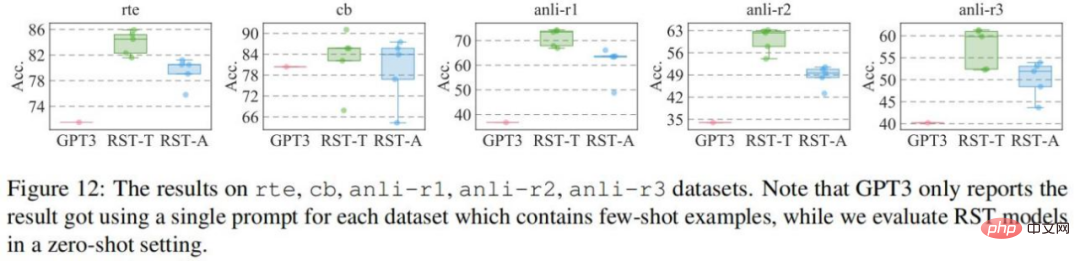

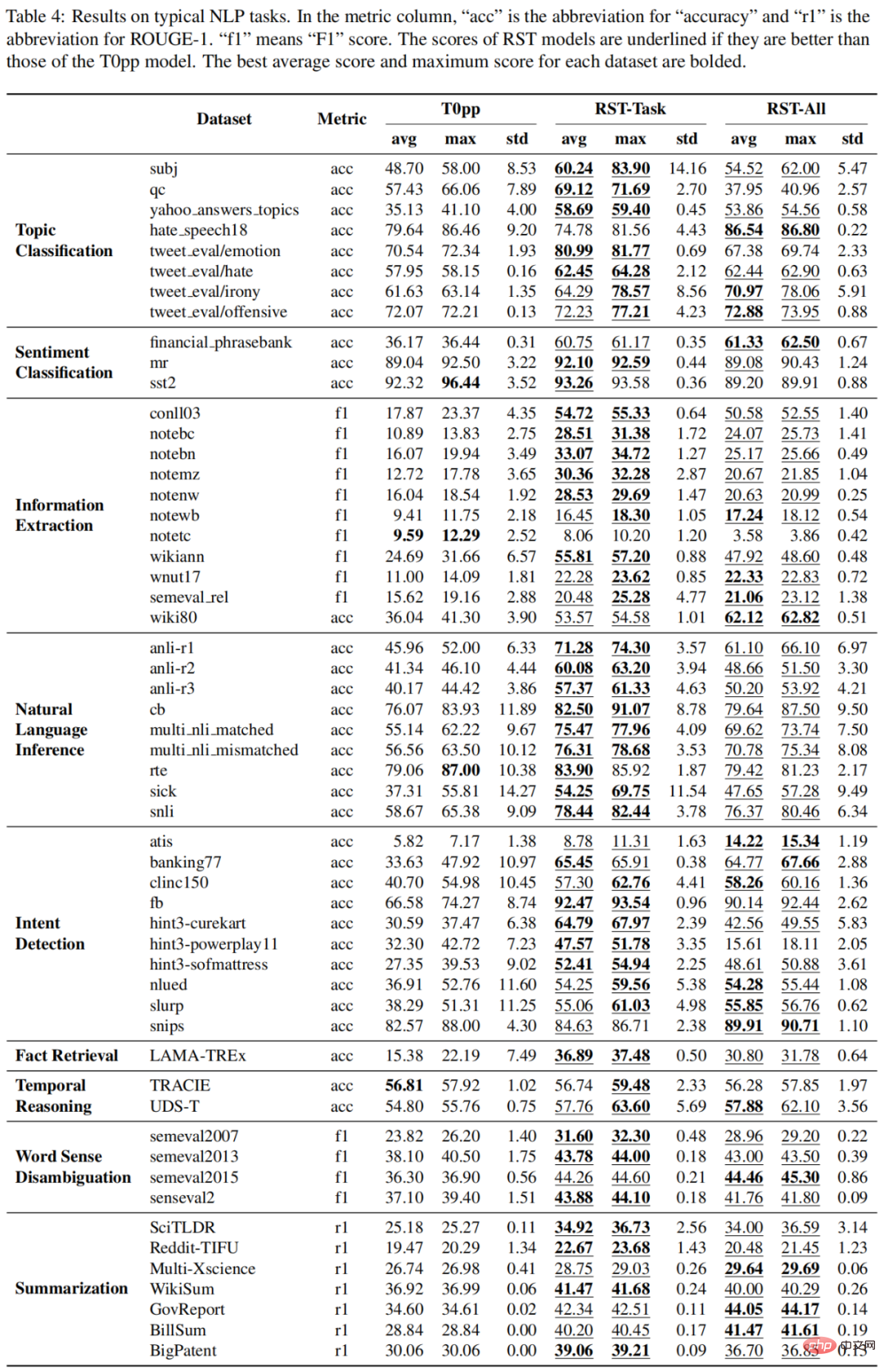

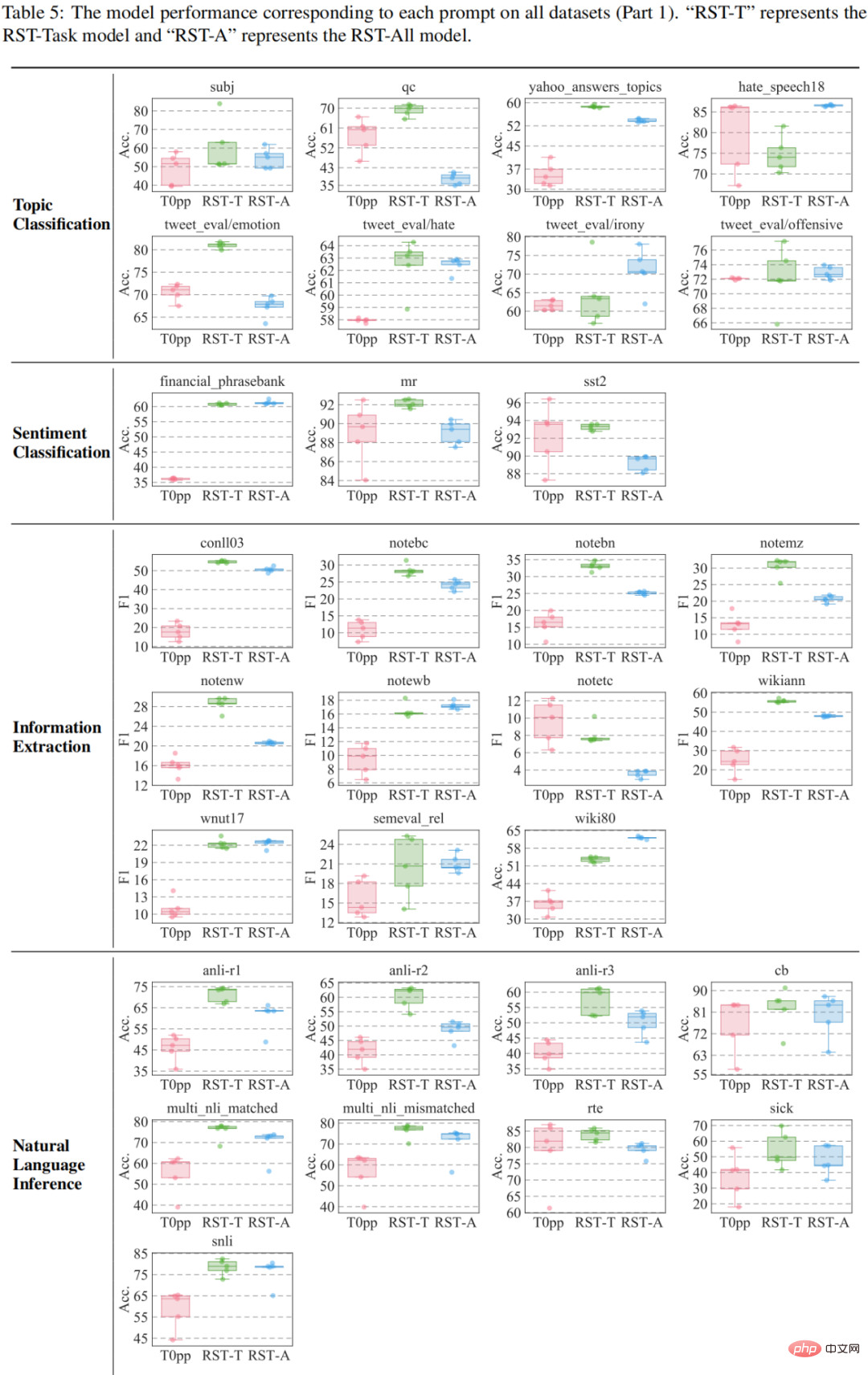

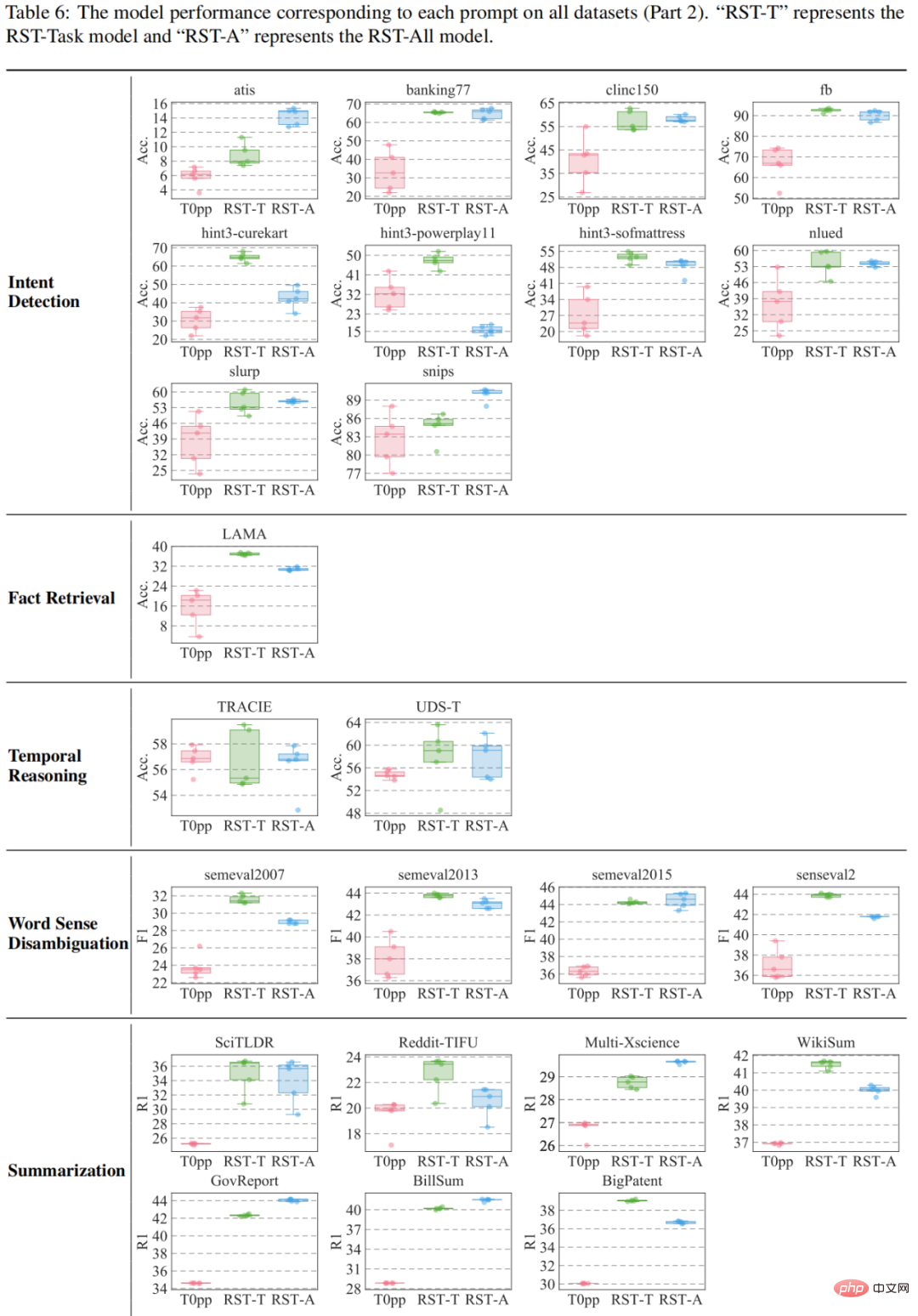

Expériences sur 55 ensembles de données PNL couramment utilisés

L'étude a été évaluée sur 55 ensembles de données, puis comparée à GPT3 et T0pp respectivement. Les résultats de la comparaison avec GPT3 sont présentés dans la figure : sur les quatre ensembles de données, à l'exception de l'ensemble de données cb, RST-All et RST-Task ont de meilleures performances zéro tir que l'apprentissage en quelques coups de GPT3. De plus, l'ensemble de données cb est le plus petit de ces ensembles de données, avec seulement 56 échantillons dans l'ensemble de validation, de sorte que les performances des différentes invites sur cet ensemble de données fluctueront considérablement.

et T0pp sont présentés dans le tableau 4-6. Par exemple, dans la performance moyenne de 55 mesures, RST-All bat T0pp sur 49 ensembles de données et gagne avec une performance maximale sur 47/55 exemples. De plus, dans le test de performances moyen sur 55 ensembles de données, RST-Task surpasse T0pp sur 52 ensembles de données et surpasse T0pp sur 50/55 exemples. Cela illustre la supériorité de l’apprentissage reconstructif.

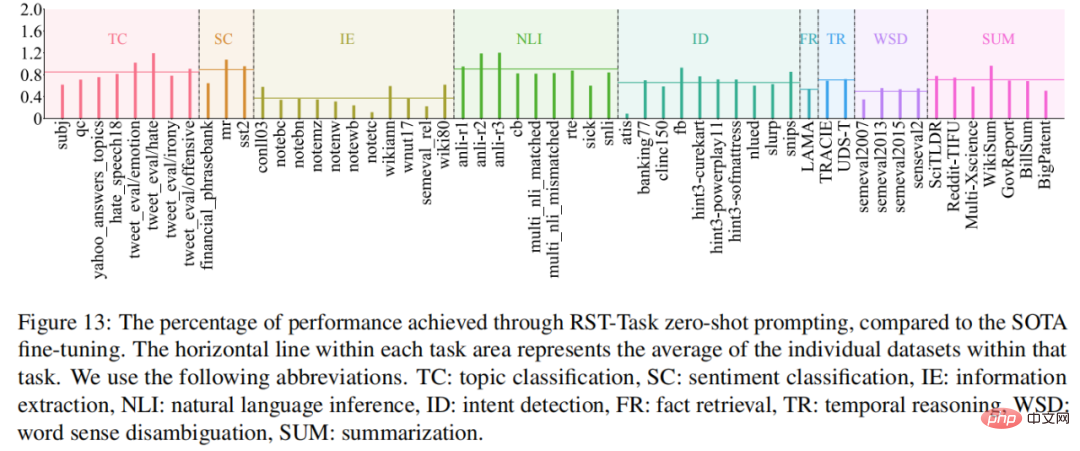

Pour quelles tâches RST-Task est-il bon ? Pour répondre à cette question, cette étude compare les performances du modèle RST-Task dans un environnement à échantillon nul avec les modèles SOTA actuels, et les résultats sont présentés dans la figure 13. RST-Task est efficace dans les tâches de classification de sujets, de classification de sentiments et de raisonnement en langage naturel, mais fonctionne mal dans les tâches d'extraction d'informations.

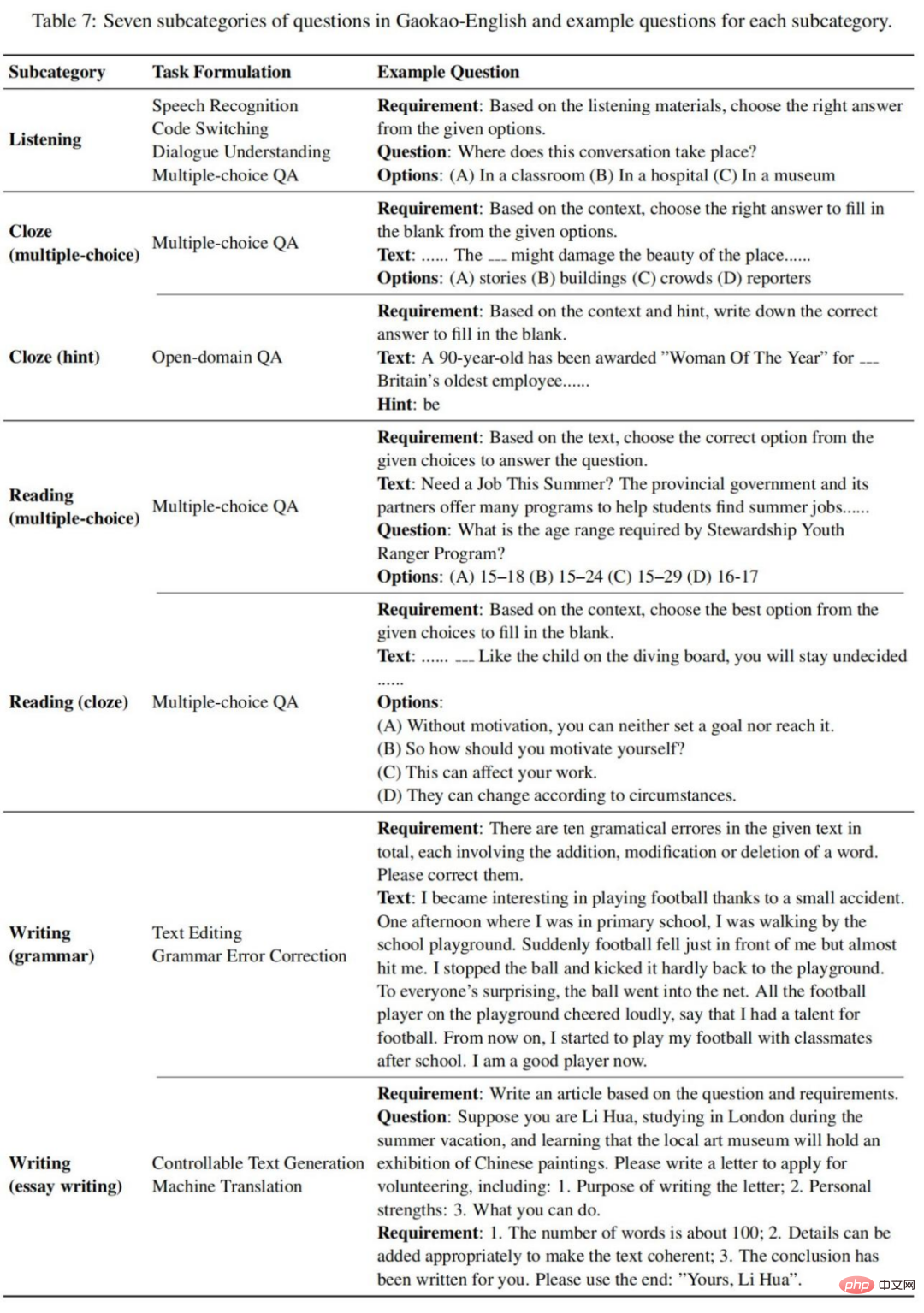

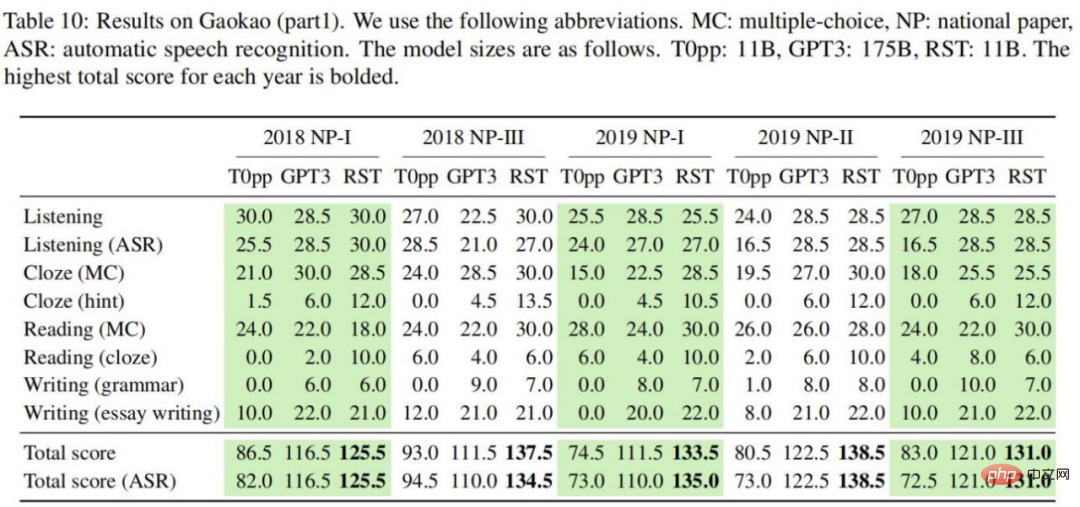

Expérience d'examen d'entrée à l'université : vers une IA de niveau humain

Cette étude a collecté 10 épreuves d'examen d'anglais d'entrée à l'université, dont l'examen national I/III de 2018, l'examen national I/II/III de 2019 et l'examen national de 2020. Examen National I/II/III, 2021 Volume National A/B. Ces épreuves suivent le même type de questions et divisent tous les types de questions d'examen dans les sept sous-catégories suivantes, comme indiqué dans le tableau 7 :

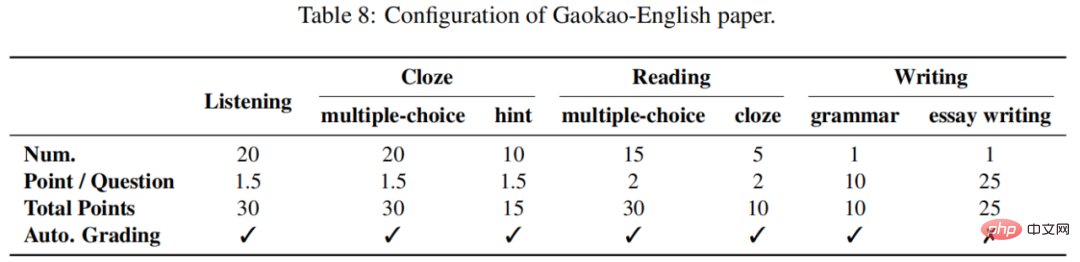

Chaque épreuve d'anglais de l'examen d'entrée à l'université vaut un score complet de 150 points. L'écoute, l'écoute, la lecture et l'écriture représentaient respectivement 30, 45, 40 et 35. En règle générale, la section de rédaction est subjective et nécessite une évaluation humaine, tandis que les autres sections sont objectives et peuvent être automatiquement notées. Comme le montre le tableau 8 :

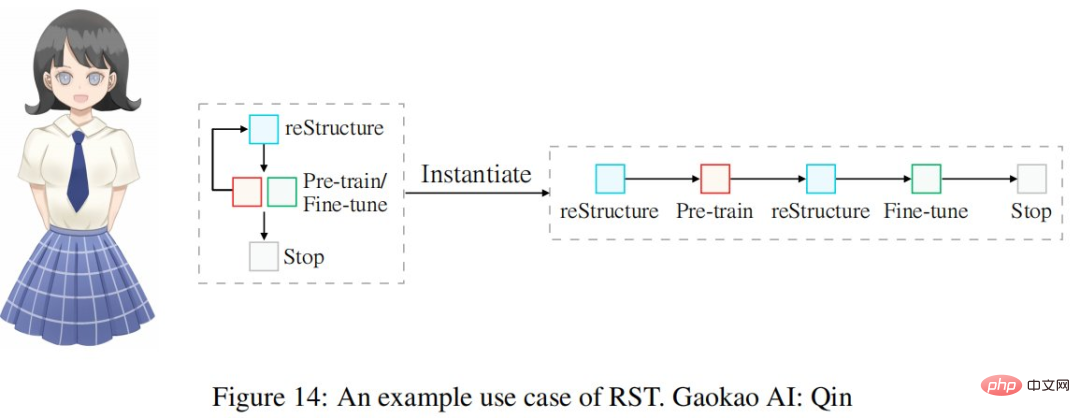

Utilisez le cycle d'ingénierie de reconstruction présenté dans le tableau 1 pour construire le système d'IA en anglais de l'examen d'entrée au collège, à savoir Qin. L'ensemble du processus est illustré à la figure 14 :

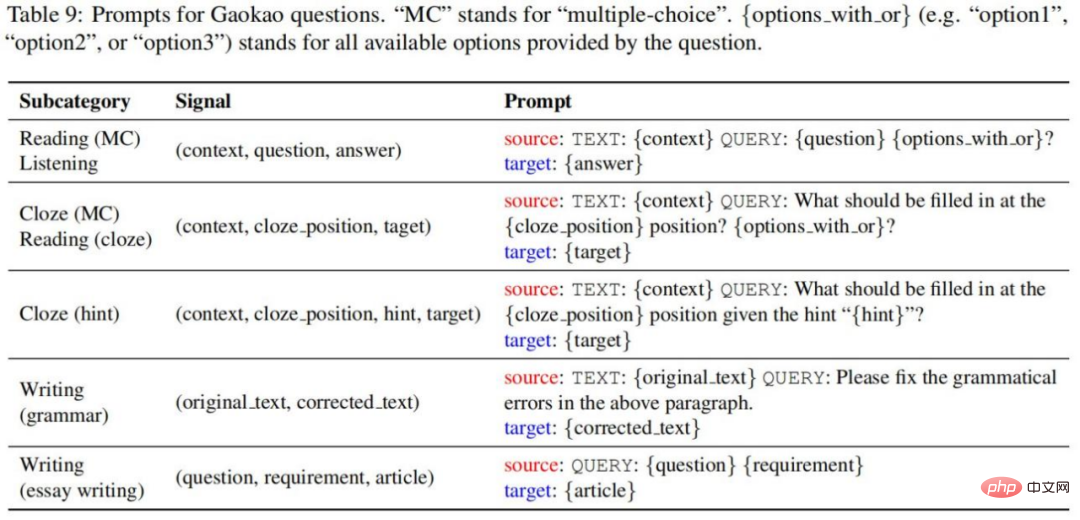

L'étude utilise l'invite suivante pour convertir les tuples de signaux d'origine en échantillons d'invite, comme le montre le tableau 9 :

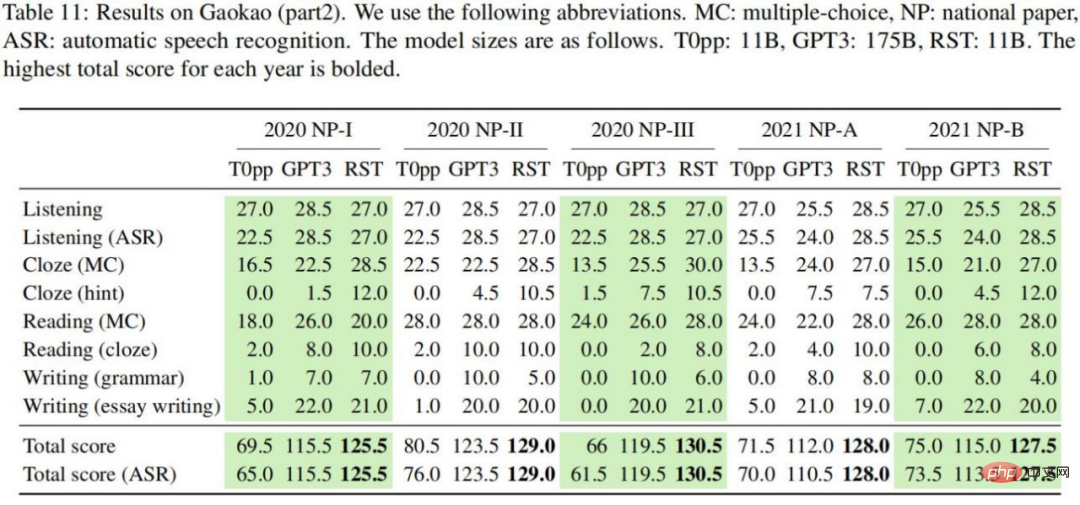

Les résultats expérimentaux sont présentés dans le tableau 10-11. Nous pouvons tirer les conclusions suivantes : Dans chaque épreuve d'anglais, RST a obtenu le score total le plus élevé dans les deux séries de tests d'écoute, avec un score moyen de 130,6 points par rapport à T0pp ; , les performances de RST sont bien meilleures que celles de T0pp pour la même taille de modèle. Dans tous les contextes, le score total obtenu par RST est en moyenne supérieur de 54,5 points à celui de T0pp, la différence la plus élevée étant de 69 points (46 % du score total par rapport à GPT3, RST peut obtenir des résultats significatifs avec une taille de modèle 16 fois) ; plus petit. De meilleurs résultats. Dans tous les contextes considérés, le score total obtenu avec RST était en moyenne supérieur de 14,0 points à celui de T0pp, avec un maximum de 26 points (17 % du score total pour T0pp, les scores d'écoute obtenus avec l'or et la parole) ; -les transcriptions textuelles différaient significativement, avec une moyenne de 4,2 points. En comparaison, GPT3 et RST sont respectivement de 0,6 et 0,45, ce qui indique que les performances de T0pp sont sensibles à la qualité du texte.

L'étude a mené une analyse fine pour comprendre les performances de différents modèles sur différentes sous-catégories de problèmes. Dans la figure 15-(a), il est clair que RST et GPT3 surpassent T0pp dans chaque sous-catégorie de problèmes.

La figure 15-(b) montre les performances du modèle et les performances moyennes des étudiants aux épreuves nationales au cours des dernières années. Il est clair que la note globale de T0pp sur l'épreuve 9/10 est inférieure à la moyenne de l'élève, tandis que les performances du RST et du GPT3 dépassent la moyenne de l'élève. En particulier, cinq des dix épreuves avaient un score RST global supérieur à 130 (souvent considéré comme le score cible que les étudiants doivent viser).

L'examen d'entrée à l'université 2022 - Test d'anglais (2022.06.08) vient de se terminer et nous avons pris connaissance des performances du modèle dans les épreuves de l'examen d'entrée à l'université de l'année la plus récente. Cette étude a réalisé des expériences avec GPT3 et RST. Les résultats montrent que le score RST total atteint 134, ce qui est bien supérieur au score de 108 obtenu par GPT3.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1363

1363

52

52

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

À temps pour la Fête du Printemps, la version 1.5 du modèle Tongyi Qianwen (Qwen) est en ligne. Ce matin, la nouvelle de la nouvelle version a attiré l'attention de la communauté IA. La nouvelle version du grand modèle comprend six tailles de modèle : 0,5B, 1,8B, 4B, 7B, 14B et 72B. Parmi eux, les performances de la version la plus puissante surpassent GPT3.5 et Mistral-Medium. Cette version inclut le modèle de base et le modèle Chat et fournit une prise en charge multilingue. L'équipe Tongyi Qianwen d'Alibaba a déclaré que la technologie pertinente avait également été lancée sur le site officiel de Tongyi Qianwen et sur l'application Tongyi Qianwen. De plus, la version actuelle de Qwen 1.5 présente également les points forts suivants : prend en charge une longueur de contexte de 32 Ko ; ouvre le point de contrôle du modèle Base+Chat ;

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Les réseaux actuels de détection des contours profonds adoptent généralement une architecture d'encodeur-décodeur, qui contient des modules d'échantillonnage ascendant et descendant pour mieux extraire les fonctionnalités à plusieurs niveaux. Cependant, cette structure limite le réseau à produire des résultats de détection de contour précis et détaillés. En réponse à ce problème, un article sur AAAI2024 propose une nouvelle solution. Titre de la thèse : DiffusionEdge : DiffusionProbabilisticModelforCrispEdgeDetection Auteurs : Ye Yunfan (Université nationale de technologie de la défense), Xu Kai (Université nationale de technologie de la défense), Huang Yuxing (Université nationale de technologie de la défense), Yi Renjiao (Université nationale de technologie de la défense), Cai Zhiping (Université nationale de technologie de la défense) Lien vers l'article : https ://ar

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles de langage (LLM) comportent généralement des milliards de paramètres et sont formés sur des milliards de jetons. Cependant, ces modèles sont très coûteux à former et à déployer. Afin de réduire les besoins de calcul, diverses techniques de compression de modèles sont souvent utilisées. Ces techniques de compression de modèles peuvent généralement être divisées en quatre catégories : distillation, décomposition tensorielle (y compris la factorisation de bas rang), élagage et quantification. Les méthodes d'élagage existent depuis un certain temps, mais beaucoup nécessitent un réglage fin de la récupération (RFT) après l'élagage pour maintenir les performances, ce qui rend l'ensemble du processus coûteux et difficile à faire évoluer. Des chercheurs de l'ETH Zurich et de Microsoft ont proposé une solution à ce problème appelée SliceGPT. L'idée principale de cette méthode est de réduire l'intégration du réseau en supprimant des lignes et des colonnes dans la matrice de pondération.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,