Périphériques technologiques

Périphériques technologiques

IA

IA

Un examen systématique de la pré-formation en apprentissage par renforcement profond, ainsi que des recherches en ligne et hors ligne, suffit.

Un examen systématique de la pré-formation en apprentissage par renforcement profond, ainsi que des recherches en ligne et hors ligne, suffit.

Un examen systématique de la pré-formation en apprentissage par renforcement profond, ainsi que des recherches en ligne et hors ligne, suffit.

Ces dernières années, l'apprentissage par renforcement (RL) s'est développé rapidement, grâce à l'apprentissage profond. Diverses avancées dans des domaines allant des jeux à la robotique ont stimulé l'intérêt des gens pour la conception d'algorithmes et de systèmes RL complexes à grande échelle. Cependant, les recherches RL existantes permettent généralement aux agents d'apprendre à partir de zéro lorsqu'ils sont confrontés à de nouvelles tâches, ce qui rend difficile l'utilisation de connaissances préalables acquises pour aider à la prise de décision, ce qui entraîne une surcharge de calcul élevée.

Dans le domaine de l'apprentissage supervisé, le paradigme de pré-formation s'est avéré être un moyen efficace d'obtenir des connaissances préalables transférables. En pré-formation sur des ensembles de données à grande échelle, le modèle de réseau peut s'adapter rapidement aux différents éléments en aval. tâches. Des idées similaires ont également été essayées en RL, en particulier les recherches récentes sur les agents « généralistes » [1, 2], ce qui amène les gens à se demander si quelque chose comme GPT-3 [3] peut également naître dans le domaine universel pré-entraîné. modèle.

Cependant, l'application de la pré-formation dans le domaine de la RL est confrontée à de nombreux défis, tels que les différences significatives entre les tâches en amont et en aval, comment obtenir et utiliser efficacement les données de pré-formation et comment transférer efficacement les connaissances antérieures. , etc., qui entravent la pré-formation. Application réussie des paradigmes de formation en RL. Dans le même temps, il existe de grandes différences dans les contextes expérimentaux et les méthodes envisagées dans les études précédentes, ce qui rend difficile pour les chercheurs de concevoir des modèles de pré-formation appropriés dans des scénarios réels.

Afin de trier le développement de la pré-formation dans le domaine du RL et les éventuelles orientations de développement futures, Des chercheurs de l'Université Jiao Tong de Shanghai et de Tencent ont rédigé une revue pour discuter des méthodes de subdivision et des méthodes de pré-formation RL existantes. -entraînement sous différents contextes Problèmes à résoudre .

Adresse papier : https://arxiv.org/pdf/2211.03959.pdf

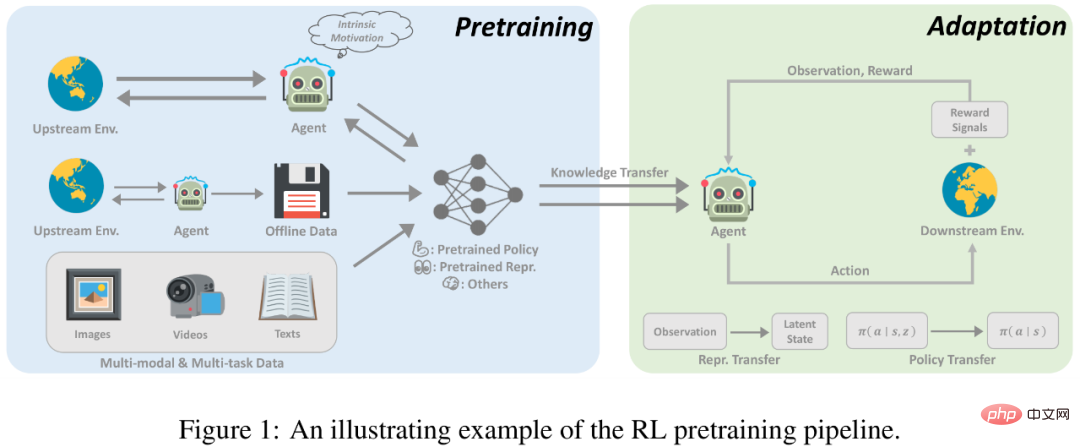

Introduction à la pré-formation RL

L'apprentissage par renforcement (RL) fournit une forme mathématique générale pour la décision séquentielle -fabrication . Grâce aux algorithmes RL et aux réseaux neuronaux profonds, les agents appris de manière basée sur les données et optimisant les fonctions de récompense spécifiées ont atteint des performances supérieures aux performances humaines dans diverses applications dans différents domaines. Cependant, bien que la RL se soit avérée efficace pour résoudre des tâches spécifiées, l’efficacité des échantillons et la capacité de généralisation restent deux obstacles majeurs entravant l’application de la RL dans le monde réel. Dans la recherche RL, un paradigme standard consiste pour un agent à apprendre de l'expérience collectée par lui-même ou par d'autres, en optimisant un réseau neuronal grâce à une initialisation aléatoire pour une seule tâche. En revanche, pour les humains, une connaissance préalable du monde facilite grandement le processus de prise de décision. Si la tâche est liée à des tâches vues précédemment, les humains ont tendance à réutiliser les connaissances déjà acquises pour s'adapter rapidement à de nouvelles tâches sans apprendre à partir de zéro. Par conséquent, par rapport aux humains, les agents RL souffrent d’une faible efficacité des données et sont sujets au surajustement.

Cependant, les progrès récents dans d'autres domaines de l'apprentissage automatique préconisent activement l'exploitation des connaissances préalables acquises à partir d'une pré-formation à grande échelle. Grâce à une formation à grande échelle sur un large éventail de données, les grands modèles de base peuvent être rapidement adaptés à une variété de tâches en aval. Ce paradigme de pré-formation et de mise au point s'est avéré efficace dans des domaines tels que la vision par ordinateur et le traitement du langage naturel. Cependant, la pré-formation n’a pas eu d’impact significatif sur le domaine RL. Bien que cette approche soit prometteuse, la conception des principes d’une pré-formation RL à grande échelle se heurte à de nombreux défis. 1) Diversité des domaines et des tâches ; 2) Sources de données limitées ; 3) Adaptation rapide à la difficulté de résoudre les tâches en aval ; Ces facteurs découlent des caractéristiques intrinsèques du RL et nécessitent une attention particulière de la part des chercheurs.

La pré-formation a un grand potentiel pour la RL, et cette étude peut servir de point de départ à ceux qui s'intéressent à cette direction. Dans cet article, les chercheurs tentent de procéder à une revue systématique des travaux de pré-formation existants sur l’apprentissage par renforcement profond.

Ces dernières années, la pré-formation par apprentissage par renforcement profond a connu plusieurs avancées. Premièrement, une pré-formation basée sur des démonstrations d’experts, qui utilise l’apprentissage supervisé pour prédire les actions entreprises par des experts, a été utilisée sur AlphaGo. À la recherche d'une pré-formation à grande échelle et moins supervisée, le domaine de la RL non supervisée s'est développé rapidement, ce qui permet aux agents d'apprendre des interactions avec l'environnement sans signaux de récompense. En outre, le développement rapide de l’apprentissage par renforcement hors ligne (RL hors ligne) a incité les chercheurs à réfléchir davantage à la manière d’utiliser des données hors ligne non étiquetées et sous-optimales pour la pré-formation. Enfin, les méthodes de formation hors ligne basées sur des données multitâches et multimodales ouvrent la voie à un paradigme général de pré-formation.

Pré-formation en ligne

Les succès précédents du RL ont été obtenus grâce à des fonctions de récompense denses et bien conçues. Les paradigmes traditionnels de RL, qui ont fait de grands progrès dans de nombreux domaines, sont confrontés à deux défis majeurs lors de leur mise à l’échelle vers une pré-formation à grande échelle. Premièrement, les agents RL sont facilement suréquipés et il est difficile pour les agents pré-entraînés avec des récompenses pour des tâches complexes d'obtenir de bonnes performances sur des tâches qu'ils n'ont jamais vues auparavant. De plus, la conception de fonctions de récompense est généralement très coûteuse et nécessite de nombreuses connaissances spécialisées, ce qui constitue sans aucun doute un défi de taille en pratique.

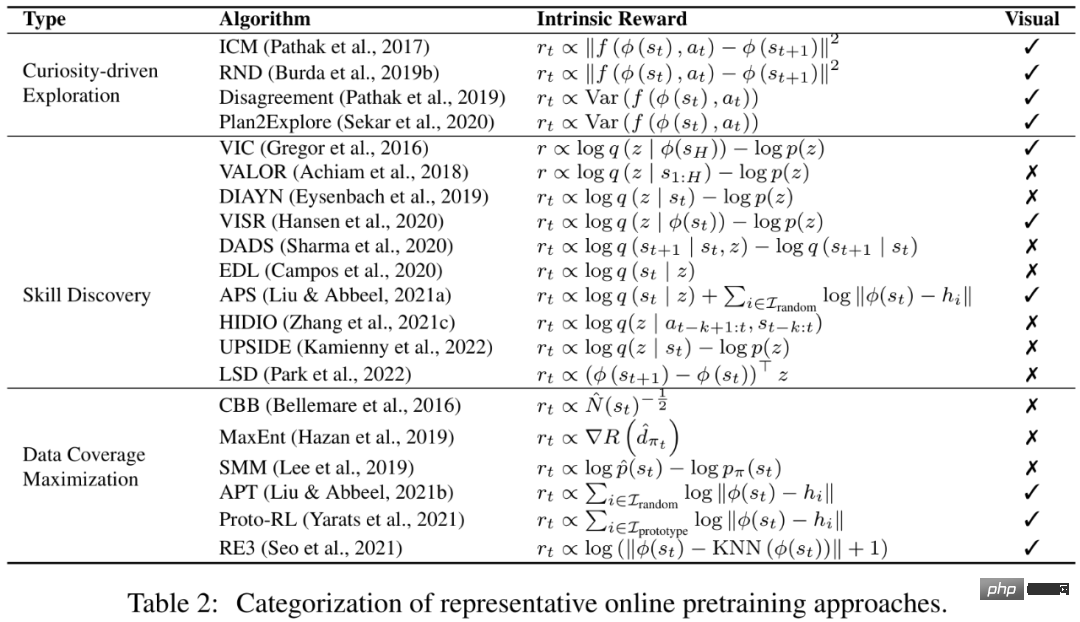

La pré-formation en ligne sans signaux de récompense peut devenir une solution disponible pour apprendre des connaissances préalables universelles et des signaux supervisés sans implication humaine. La pré-formation en ligne vise à acquérir des connaissances préalables par l'interaction avec l'environnement sans supervision humaine. Dans la phase de pré-formation, l’agent est autorisé à interagir avec l’environnement pendant une longue période mais ne peut pas recevoir de récompenses extrinsèques. Cette solution, également connue sous le nom de RL non supervisé, a été activement étudiée par les chercheurs ces dernières années.

Afin de motiver les agents à acquérir des connaissances préalables de l'environnement sans aucun signal de supervision, une méthode mature consiste à concevoir des récompenses intrinsèques pour les agents afin d'encourager les agents à acquérir diverses expériences ou à maîtriser des compétences transférables et à concevoir des récompenses en conséquence. Des recherches antérieures ont montré que les agents peuvent s'adapter rapidement aux tâches en aval grâce à une pré-formation en ligne avec des récompenses intrinsèques et des algorithmes RL standard.

Pré-formation hors ligne

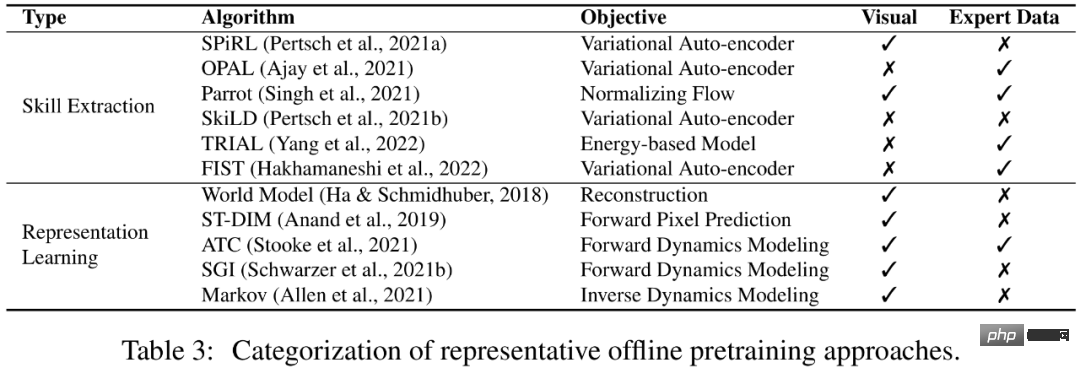

Bien que la pré-formation en ligne puisse obtenir de bons résultats de pré-formation sans supervision humaine, elle est encore limitée pour les applications à grande échelle. Après tout, l’interaction en ligne s’exclut dans une certaine mesure avec la nécessité de se former sur des ensembles de données vastes et diversifiés. Afin de résoudre ce problème, les gens espèrent souvent découpler les liens de collecte de données et de pré-formation et utiliser directement les données historiques collectées auprès d'autres agents ou humains pour la pré-formation.

Une solution réalisable est l'apprentissage par renforcement hors ligne. Le but de l’apprentissage par renforcement hors ligne est d’obtenir une politique RL maximisant les récompenses à partir de données hors ligne. Un défi fondamental est le problème du changement de distribution, c'est-à-dire la différence de distribution entre les données d'entraînement et les données observées lors des tests. Les méthodes d'apprentissage par renforcement hors ligne existantes se concentrent sur la manière de résoudre ce défi lors de l'utilisation de l'approximation de fonctions. Par exemple, les méthodes de contrainte politique exigent explicitement que la politique apprise évite de prendre des actions non vues dans l'ensemble de données, et les méthodes de régularisation de valeur atténuent le problème de surestimation de la fonction valeur en ajustant la fonction valeur à une certaine forme de limite inférieure. Cependant, la question de savoir si les stratégies formées hors ligne peuvent se généraliser à de nouveaux environnements non visibles dans les ensembles de données hors ligne reste sous-explorée.

Peut-être pouvons-nous éviter l'apprentissage des politiques RL et utiliser à la place des données hors ligne pour acquérir des connaissances préalables bénéfiques à la vitesse de convergence ou à la performance finale des tâches en aval. Plus intéressant encore, si notre modèle peut exploiter des données hors ligne sans supervision humaine, il a le potentiel de bénéficier d’énormes quantités de données. Dans cet article, les chercheurs appellent ce paramètre la pré-formation hors ligne, et l'agent peut extraire des informations importantes (telles qu'une bonne représentation et des priorités comportementales) à partir de données hors ligne.

Vers un agent général

Les méthodes de pré-formation dans un seul environnement et une seule modalité se concentrent principalement sur les paramètres de pré-formation en ligne et hors ligne mentionnés ci-dessus, et récemment, dans le domaine Il y a Il y a eu un regain d'intérêt parmi les chercheurs pour la construction d'un modèle général unique de prise de décision (par exemple, Gato [1] et Multi-game DT [2]), permettant au même modèle de gérer des tâches de différentes modalités dans différents environnements. Afin de permettre aux agents d'apprendre et de s'adapter à une variété de tâches ouvertes, la recherche espère exploiter de grandes quantités de connaissances préalables sous différentes formes, telles que la perception visuelle et la compréhension du langage. Plus important encore, si les chercheurs parviennent à établir un pont entre le RL et l’apprentissage automatique dans d’autres domaines et à combiner des expériences réussies antérieures, ils pourront peut-être construire un modèle d’agent général capable d’accomplir diverses tâches.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Les réseaux actuels de détection des contours profonds adoptent généralement une architecture d'encodeur-décodeur, qui contient des modules d'échantillonnage ascendant et descendant pour mieux extraire les fonctionnalités à plusieurs niveaux. Cependant, cette structure limite le réseau à produire des résultats de détection de contour précis et détaillés. En réponse à ce problème, un article sur AAAI2024 propose une nouvelle solution. Titre de la thèse : DiffusionEdge : DiffusionProbabilisticModelforCrispEdgeDetection Auteurs : Ye Yunfan (Université nationale de technologie de la défense), Xu Kai (Université nationale de technologie de la défense), Huang Yuxing (Université nationale de technologie de la défense), Yi Renjiao (Université nationale de technologie de la défense), Cai Zhiping (Université nationale de technologie de la défense) Lien vers l'article : https ://ar

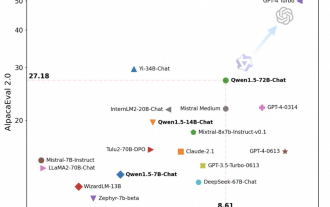

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

À temps pour la Fête du Printemps, la version 1.5 du modèle Tongyi Qianwen (Qwen) est en ligne. Ce matin, la nouvelle de la nouvelle version a attiré l'attention de la communauté IA. La nouvelle version du grand modèle comprend six tailles de modèle : 0,5B, 1,8B, 4B, 7B, 14B et 72B. Parmi eux, les performances de la version la plus puissante surpassent GPT3.5 et Mistral-Medium. Cette version inclut le modèle de base et le modèle Chat et fournit une prise en charge multilingue. L'équipe Tongyi Qianwen d'Alibaba a déclaré que la technologie pertinente avait également été lancée sur le site officiel de Tongyi Qianwen et sur l'application Tongyi Qianwen. De plus, la version actuelle de Qwen 1.5 présente également les points forts suivants : prend en charge une longueur de contexte de 32 Ko ; ouvre le point de contrôle du modèle Base+Chat ;

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles de langage (LLM) comportent généralement des milliards de paramètres et sont formés sur des milliards de jetons. Cependant, ces modèles sont très coûteux à former et à déployer. Afin de réduire les besoins de calcul, diverses techniques de compression de modèles sont souvent utilisées. Ces techniques de compression de modèles peuvent généralement être divisées en quatre catégories : distillation, décomposition tensorielle (y compris la factorisation de bas rang), élagage et quantification. Les méthodes d'élagage existent depuis un certain temps, mais beaucoup nécessitent un réglage fin de la récupération (RFT) après l'élagage pour maintenir les performances, ce qui rend l'ensemble du processus coûteux et difficile à faire évoluer. Des chercheurs de l'ETH Zurich et de Microsoft ont proposé une solution à ce problème appelée SliceGPT. L'idée principale de cette méthode est de réduire l'intégration du réseau en supprimant des lignes et des colonnes dans la matrice de pondération.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

LLaVA-1.6, qui rattrape Gemini Pro et améliore les capacités de raisonnement et d'OCR, est trop puissant

Feb 01, 2024 pm 04:51 PM

LLaVA-1.6, qui rattrape Gemini Pro et améliore les capacités de raisonnement et d'OCR, est trop puissant

Feb 01, 2024 pm 04:51 PM

En avril de l'année dernière, des chercheurs de l'Université du Wisconsin-Madison, de Microsoft Research et de l'Université de Columbia ont publié conjointement LLaVA (Large Language and Vision Assistant). Bien que LLaVA ne soit entraîné qu'avec un petit ensemble de données d'instructions multimodales, il montre des résultats d'inférence très similaires à ceux de GPT-4 sur certains échantillons. Puis, en octobre, ils ont lancé LLaVA-1.5, qui a actualisé le SOTA en 11 tests avec de simples modifications par rapport au LLaVA original. Les résultats de cette mise à niveau sont très intéressants, apportant de nouvelles avancées dans le domaine des assistants IA multimodaux. L'équipe de recherche a annoncé le lancement de la version LLaVA-1.6, ciblant le raisonnement, l'OCR et

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.