Périphériques technologiques

Périphériques technologiques

IA

IA

Les voitures autonomes peuvent-elles signaler leurs intentions aux piétons ?

Les voitures autonomes peuvent-elles signaler leurs intentions aux piétons ?

Les voitures autonomes peuvent-elles signaler leurs intentions aux piétons ?

Pour déterminer si une large route peut être traversée en toute sécurité, il faut des signaux sociaux et une communication coopérative entre les piétons et les conducteurs. Alors, que se passe-t-il s’il s’agit d’un véhicule autonome ? L'entreprise de voitures autonomes Motional estime que rendre les véhicules plus expressifs pourrait être la clé du maintien de ces signaux importants.

En attendant à un passage pour piétons, Paul Schmitt, l'ingénieur en chef de Motional, a vécu ce qu'il appelle « une danse avec un regard ». Il s'agit d'une évaluation rapide et presque inconsciente : où regardent les conducteurs des voitures venant en sens inverse ? L'ont-ils remarqué ? "Avec les véhicules autonomes, la moitié de ces interactions n'existent pas", a déclaré Schmidt. "Alors, quels indices permettent aux piétons de comprendre les intentions du véhicule

Pour répondre à cette question, son équipe a embauché le studio d'animation CHRLX builds ?" des expériences de réalité virtuelle très réalistes conçues pour tester les réactions des piétons à différents mécanismes de signalisation. Les résultats de leurs recherches ont été publiés dans IEEE Robotics and Automation Letters. Schmidt et son équipe affirment que les manœuvres de conduite exagérées - freiner tôt ou s'arrêter devant les piétons - sont les moyens les plus efficaces de communiquer leurs intentions.

L'entreprise intègre actuellement les comportements expressifs les plus prometteurs dans son système de planification de mouvements et a également ouvert l'environnement de trafic de réalité virtuelle pour que d'autres équipes puissent l'expérimenter.

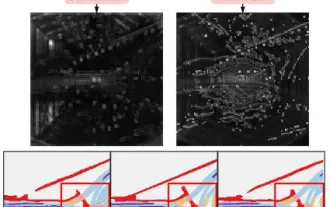

L'étude a également testé divers comportements expressifs qui signalent implicitement aux piétons qu'un véhicule s'arrête pour eux. Il s'agit notamment de forcer la voiture à freiner plus fort et plus loin de la ligne de base, d'arrêter la voiture à la longueur la plus éloignée, d'ajouter des sons de freinage brusque et à bas régime, et enfin de combiner ces sons avec un piqué exagéré, comme si c'était comme si le véhicule freinait fort.

L'équipe a mesuré la rapidité avec laquelle les piétons décidaient de traverser les voies et a mené une enquête rapide auprès des piétons après chaque essai pour comprendre dans quelle mesure ils se sentaient en sécurité, dans quelle mesure ils étaient confiants dans leur décision de traverser les voies par eux-mêmes et leurs perceptions des intentions de la voiture. niveau de compréhension. Les arrêts courts ont obtenu les scores les plus élevés en termes de sécurité et de compréhension des intentions de la voiture.

Schmitt a déclaré que les arrêts courts obtenaient la meilleure réponse, ce qui n'était pas surprenant puisque l'approche s'inspirait du comportement de conducteurs humains ralentissant devant des piétons. Étonnamment, a-t-il ajouté, il y avait peu de différence dans les réponses à ce scénario de base avec ou sans conducteur, ce qui suggère que les piétons accordaient plus d'attention au mouvement du véhicule qu'au conducteur au volant.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

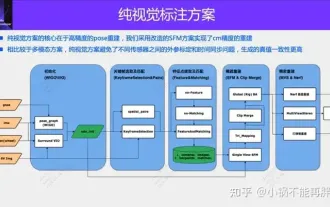

Une solution d'annotation purement visuelle utilise principalement la vision ainsi que certaines données du GPS, de l'IMU et des capteurs de vitesse de roue pour l'annotation dynamique. Bien entendu, pour les scénarios de production de masse, il n’est pas nécessaire qu’il s’agisse d’une vision pure. Certains véhicules produits en série seront équipés de capteurs comme le radar à semi-conducteurs (AT128). Si nous créons une boucle fermée de données dans la perspective d'une production de masse et utilisons tous ces capteurs, nous pouvons résoudre efficacement le problème de l'étiquetage des objets dynamiques. Mais notre plan ne prévoit pas de radar à semi-conducteurs. Par conséquent, nous présenterons cette solution d’étiquetage de production de masse la plus courante. Le cœur d’une solution d’annotation purement visuelle réside dans la reconstruction de pose de haute précision. Nous utilisons le schéma de reconstruction de pose de Structure from Motion (SFM) pour garantir la précision de la reconstruction. Mais passe

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

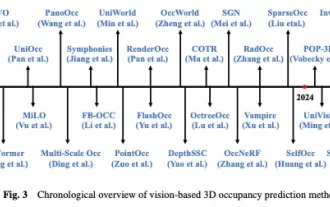

Écrit ci-dessus et compréhension personnelle de l'auteur Ces dernières années, la conduite autonome a reçu une attention croissante en raison de son potentiel à réduire la charge du conducteur et à améliorer la sécurité de conduite. La prédiction d'occupation tridimensionnelle basée sur la vision est une tâche de perception émergente adaptée à une enquête rentable et complète sur la sécurité de la conduite autonome. Bien que de nombreuses études aient démontré la supériorité des outils de prédiction d’occupation 3D par rapport aux tâches de perception centrée sur les objets, il existe encore des revues dédiées à ce domaine en développement rapide. Cet article présente d'abord le contexte de la prédiction d'occupation 3D basée sur la vision et discute des défis rencontrés dans cette tâche. Ensuite, nous discutons de manière approfondie de l'état actuel et des tendances de développement des méthodes actuelles de prévision d'occupation 3D sous trois aspects : l'amélioration des fonctionnalités, la convivialité du déploiement et l'efficacité de l'étiquetage. enfin

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

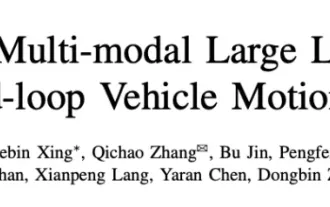

Écrit ci-dessus et compréhension personnelle de l'auteur : cet article est dédié à la résolution des principaux défis des grands modèles de langage multimodaux (MLLM) actuels dans les applications de conduite autonome, c'est-à-dire le problème de l'extension des MLLM de la compréhension 2D à l'espace 3D. Cette expansion est particulièrement importante car les véhicules autonomes (VA) doivent prendre des décisions précises concernant les environnements 3D. La compréhension spatiale 3D est essentielle pour les véhicules utilitaires car elle a un impact direct sur la capacité du véhicule à prendre des décisions éclairées, à prédire les états futurs et à interagir en toute sécurité avec l’environnement. Les modèles de langage multimodaux actuels (tels que LLaVA-1.5) ne peuvent souvent gérer que des entrées d'images de résolution inférieure (par exemple) en raison des limitations de résolution de l'encodeur visuel et des limitations de la longueur de la séquence LLM. Cependant, les applications de conduite autonome nécessitent

Vers la « boucle fermée » | PlanAgent : nouveau SOTA pour la planification en boucle fermée de la conduite autonome basée sur MLLM !

Jun 08, 2024 pm 09:30 PM

Vers la « boucle fermée » | PlanAgent : nouveau SOTA pour la planification en boucle fermée de la conduite autonome basée sur MLLM !

Jun 08, 2024 pm 09:30 PM

L'équipe d'apprentissage par renforcement profond de l'Institut d'automatisation de l'Académie chinoise des sciences, en collaboration avec Li Auto et d'autres, a proposé un nouveau cadre de planification en boucle fermée pour la conduite autonome basé sur le modèle multimodal à grand langage MLLM - PlanAgent. Cette méthode prend une vue d'ensemble de la scène et des invites de texte basées sur des graphiques comme entrée, et utilise la compréhension multimodale et les capacités de raisonnement de bon sens du grand modèle de langage multimodal pour effectuer un raisonnement hiérarchique depuis la compréhension de la scène jusqu'à la génération. d'instructions de mouvement horizontal et vertical, et générer en outre les instructions requises par le planificateur. La méthode est testée sur le benchmark nuPlan à grande échelle et exigeant, et les expériences montrent que PlanAgent atteint des performances de pointe (SOTA) dans les scénarios réguliers et à longue traîne. Par rapport aux méthodes conventionnelles de grand modèle de langage (LLM), PlanAgent

Au-delà de BEVFusion ! DifFUSER : Le modèle Diffusion entre dans la conduite autonome multi-tâches (segmentation BEV + détection double SOTA)

Apr 22, 2024 pm 05:49 PM

Au-delà de BEVFusion ! DifFUSER : Le modèle Diffusion entre dans la conduite autonome multi-tâches (segmentation BEV + détection double SOTA)

Apr 22, 2024 pm 05:49 PM

Écrit ci-dessus et compréhension personnelle de l'auteur À l'heure actuelle, alors que la technologie de conduite autonome devient plus mature et que la demande de tâches de perception de conduite autonome augmente, l'industrie et le monde universitaire espèrent beaucoup un modèle d'algorithme de perception idéal qui puisse simultanément compléter la détection de cibles tridimensionnelles et basé sur la tâche de segmentation sémantique dans l'espace BEV. Pour un véhicule capable de conduire de manière autonome, il est généralement équipé de capteurs de caméra à vision panoramique, de capteurs lidar et de capteurs radar à ondes millimétriques pour collecter des données selon différentes modalités. De cette manière, les avantages complémentaires entre les différentes données modales peuvent être pleinement exploités, de sorte que les avantages complémentaires des données entre les différentes modalités puissent être obtenus. Par exemple, les données de nuages de points 3D peuvent fournir des informations pour les tâches de détection de cibles 3D, tandis que les données d'images couleur. peut fournir plus d'informations pour les tâches de segmentation sémantique. Aiguille

Aperçu de la planification du chemin : basé sur l'échantillonnage, la recherche et l'optimisation, tout est fait !

Jun 01, 2024 pm 08:12 PM

Aperçu de la planification du chemin : basé sur l'échantillonnage, la recherche et l'optimisation, tout est fait !

Jun 01, 2024 pm 08:12 PM

1 Présentation du contrôle décisionnel et de la planification des mouvements Les méthodes actuelles de contrôle décisionnel peuvent être divisées en trois catégories : la planification séquentielle, la planification sensible au comportement et la planification de bout en bout. Planification séquentielle : la méthode la plus traditionnelle, les trois parties de perception, de prise de décision et de contrôle sont relativement claires ; planification tenant compte du comportement : par rapport à la première méthode, le point culminant est l'introduction de la co-conduite homme-machine, véhicule-route collaboration et estimation des risques du véhicule de l'environnement dynamique externe ; Planification de bout en bout : les technologies DL et DRL utilisent une grande quantité de données d'entraînement pour obtenir des informations sensorielles telles que des images, des angles de volant, etc.