Périphériques technologiques

Périphériques technologiques

IA

IA

Meta : Pas besoin d'intubation ! L'IA peut savoir ce que vous pensez en regardant votre électroencéphalogramme

Meta : Pas besoin d'intubation ! L'IA peut savoir ce que vous pensez en regardant votre électroencéphalogramme

Meta : Pas besoin d'intubation ! L'IA peut savoir ce que vous pensez en regardant votre électroencéphalogramme

Chaque année, plus de 69 millions de personnes dans le monde souffrent de traumatismes crâniens, dont beaucoup sont incapables de communiquer par la parole, la frappe au clavier ou les gestes. Si les chercheurs développaient une technologie capable de décoder le langage directement à partir de l’activité cérébrale de manière non invasive, la vie de ces personnes s’en trouverait grandement améliorée. Maintenant, Meta a mené une nouvelle étude pour résoudre ce problème.

Tout à l'heure, le blog officiel Meta AI a publié un article présentant une nouvelle technologie qui peut utiliser l'IA pour décoder directement la parole à partir de l'activité cérébrale.

À partir d'une période de 3 secondes d'activité cérébrale, cette IA est capable de décoder les fragments de parole correspondants à partir d'un vocabulaire de 793 mots que les gens utilisent quotidiennement, avec une précision allant jusqu'à 73%.

Décoder la parole à partir de l'activité cérébrale est un objectif de longue date pour les neuroscientifiques et les cliniciens, mais la plupart des progrès reposent sur des techniques d'enregistrement cérébral invasives telles que l'électroencéphalographie stéréotaxique et l'électrocorticographie.

Ces appareils peuvent fournir des signaux plus clairs que les méthodes non invasives, mais nécessitent une intervention neurochirurgicale.

Bien que les résultats de ces travaux démontrent qu'il est possible de décoder la parole à partir d'enregistrements d'activité cérébrale, l'utilisation de méthodes non invasives pour décoder la parole fournirait une solution plus sûre et plus évolutive qui pourrait, à terme, permettre à un plus grand nombre de personnes d'en bénéficier.

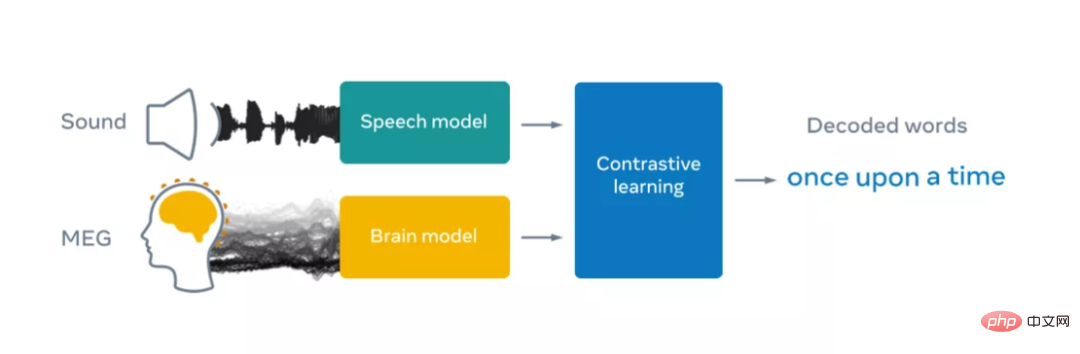

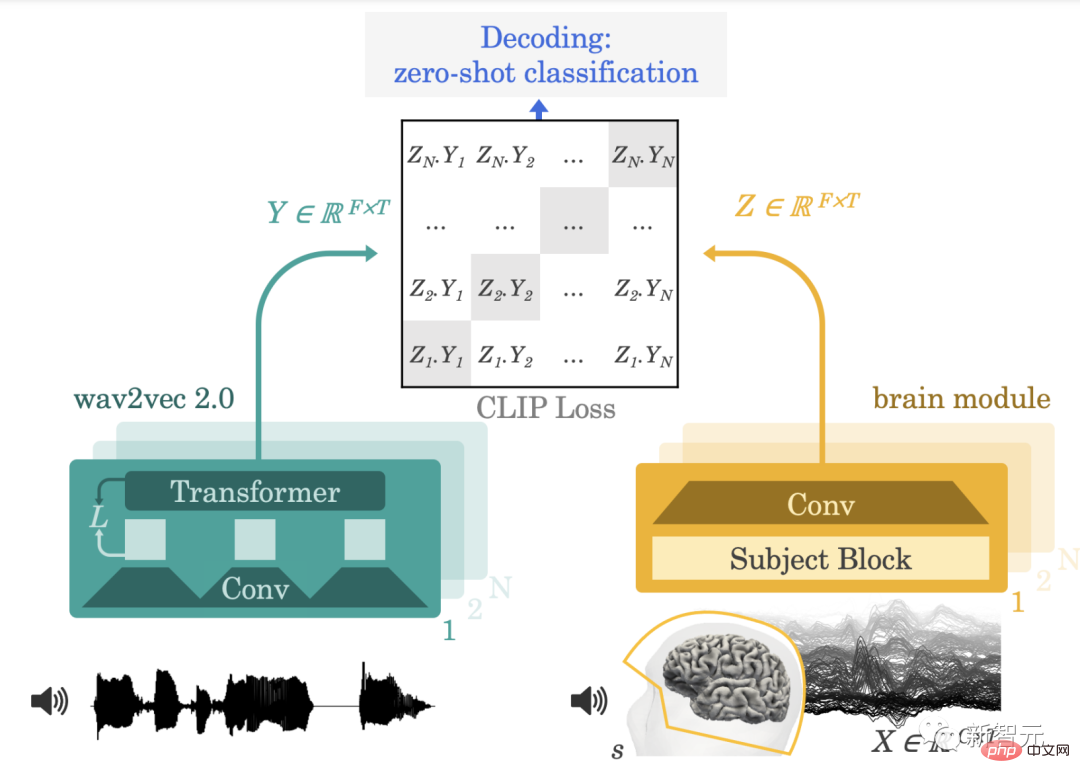

Cependant, cela est très difficile car les enregistrements non invasifs sont notoirement bruyants et varient selon les sessions d'enregistrement et les individus pour diverses raisons, notamment les différences dans le cerveau et l'emplacement des capteurs de chaque personne. Il peut y avoir des différences significatives. Meta relève ces défis en créant un modèle d'apprentissage profond entraîné par l'apprentissage contrastif, puis en l'utilisant pour maximiser l'alignement des enregistrements cérébraux non invasifs et de la parole.

À cette fin, Meta a utilisé wave2vec 2.0, un modèle d'apprentissage auto-supervisé open source développé par l'équipe FAIR en 2020, pour identifier la représentation complexe de la parole dans le cerveau de volontaires écoutant des livres audio. Meta se concentre sur deux technologies non invasives : l'électroencéphalographie et la magnétoencéphalographie (EEG et MEG en abrégé), qui mesurent respectivement les fluctuations des champs électriques et magnétiques provoquées par l'activité neuronale.

En pratique, ces deux systèmes peuvent prendre environ 1 000 instantanés de l'activité cérébrale macroscopique par seconde à l'aide de centaines de capteurs. Meta exploite quatre ensembles de données EEG et MEG open source provenant d'établissements universitaires, exploitant plus de 150 heures d'enregistrements de 169 volontaires en bonne santé écoutant des livres audio et des phrases isolées en anglais et en néerlandais.

Meta alimente ensuite ces enregistrements EEG et MEG dans un modèle de « cerveau » constitué d'un réseau convolutif profond standard avec des connexions résiduelles.

On sait que les enregistrements EEG et MEG varient considérablement d'un individu à l'autre en raison de l'anatomie individuelle du cerveau, des différences d'emplacement et de synchronisation de la fonction neuronale dans les régions du cerveau et de la position des capteurs pendant l'enregistrement.

En pratique, cela signifie que l'analyse des données cérébrales nécessite souvent un pipeline d'ingénierie complexe pour réajuster les signaux cérébraux sur un cerveau modèle. Dans des études antérieures, les décodeurs cérébraux ont été entraînés sur un petit nombre d'enregistrements pour prédire un ensemble limité de caractéristiques de la parole, telles que des catégories de parties du discours ou des mots dans un vocabulaire restreint.

Pour faciliter la recherche, Meta a conçu une nouvelle couche d'intégration de sujets, formée de bout en bout pour organiser tous les enregistrements cérébraux dans un espace commun.

Pour décoder la parole à partir de signaux cérébraux non invasifs, Meta a formé un modèle avec un apprentissage contrastif pour calibrer la parole et son activité cérébrale correspondante. Enfin, l'architecture de Meta a appris à convertir la sortie du modèle cérébral en correspondance avec des représentations profondes de la parole. présenté aux participants.

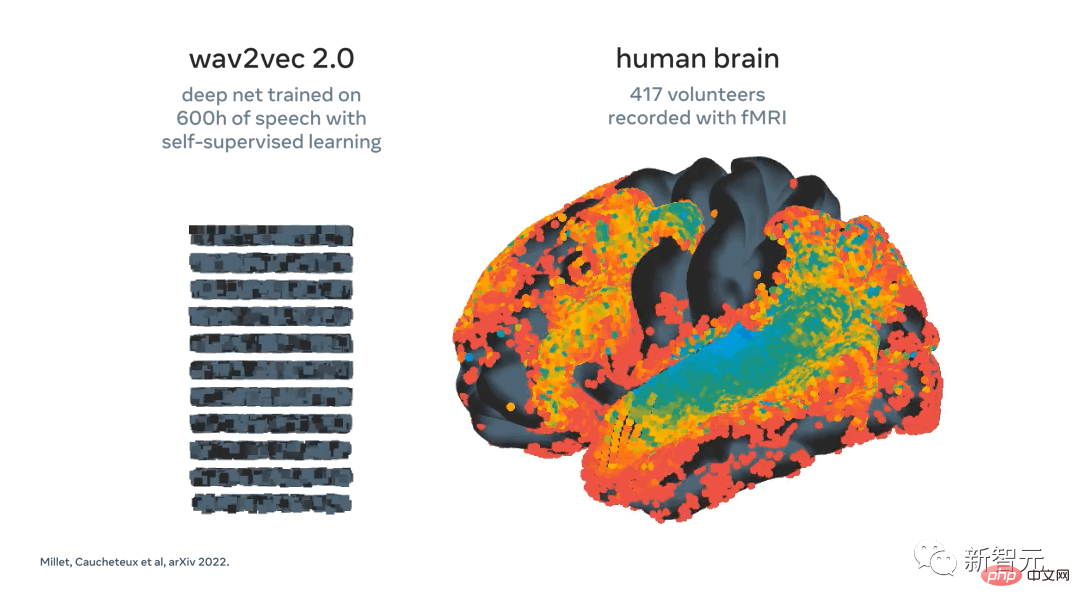

Dans les travaux précédents de Meta, nous avons utilisé wav2vec 2.0 et montré que cet algorithme vocal apprend automatiquement à générer des représentations vocales cohérentes avec le cerveau.

L'émergence de représentations de la parole « de type cérébral » dans wav2vec 2.0 a fait un choix naturel pour les chercheurs de Meta de construire leur propre décodeur, car cela aide les chercheurs de Meta à comprendre quelles représentations doivent être extraites des signaux cérébraux.

Meta a récemment démontré l'activation de wav2vec 2.0 (à gauche) cartographié sur le cerveau (à droite) en réponse au même discours. Les représentations dans la première couche (cool) de l'algorithme correspondent au cortex auditif précoce, tandis que les couches les plus profondes correspondent aux zones cérébrales de niveau supérieur (telles que le cortex préfrontal et pariétal)

Après l'entraînement, le système de Meta effectue ce qu'on appelle le zéro -classification des plans : à partir d'un extrait d'activité cérébrale, il peut déterminer, à partir d'un grand nombre de nouveaux extraits audio, celui que la personne a réellement entendu.

L'algorithme déduit les mots que la personne est la plus susceptible d'entendre. Il s’agit d’une étape passionnante car elle montre que l’intelligence artificielle peut apprendre avec succès à décoder les enregistrements non invasifs bruyants et variables de l’activité cérébrale lors de la perception de la parole.

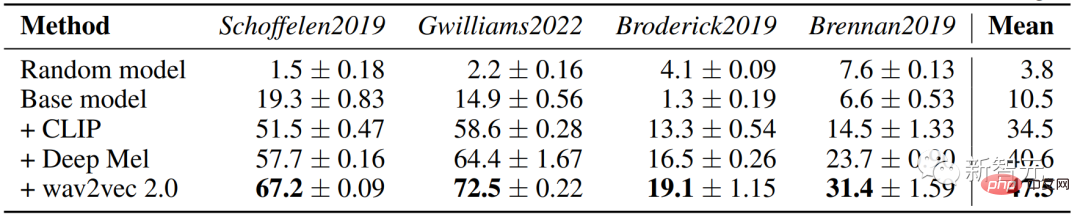

La prochaine étape consiste à voir si les chercheurs peuvent étendre ce modèle pour décoder la parole directement à partir de l'activité cérébrale sans avoir besoin d'un pool de clips audio, c'est-à-dire évoluer vers un décodeur vocal sûr et polyvalent. L'analyse des chercheurs montre en outre que plusieurs composants de notre algorithme, notamment l'utilisation de wav2vec 2.0 et des couches thématiques, sont bénéfiques pour les performances de décodage.

De plus, l'algorithme de Meta s'améliore avec le nombre d'enregistrements EEG et MEG. Concrètement, cela signifie que les méthodes des chercheurs Meta bénéficient de l’extraction de grandes quantités de données hétérogènes et pourraient en principe contribuer à améliorer le décodage de petits ensembles de données.

C'est important car dans de nombreux cas, il est difficile de collecter de grandes quantités de données auprès d'un participant donné. Par exemple, il n'est pas réaliste de demander aux patients de passer des dizaines d'heures devant un scanner pour vérifier si le système leur convient. Au lieu de cela, les algorithmes peuvent être pré-entraînés sur de grands ensembles de données incluant de nombreux individus et conditions, puis fournir une aide au décodage de l’activité cérébrale des nouveaux patients avec peu de données.

Les recherches de Meta sont encourageantes car les résultats montrent que l’intelligence artificielle auto-supervisée peut décoder avec succès la parole perçue à partir d’enregistrements non invasifs de l’activité cérébrale, malgré le bruit et la variabilité inhérents à ces données transsexuelles. Bien entendu, ces résultats ne constituent qu’une première étape. Dans cet effort de recherche, Meta s'est concentré sur le décodage de la perception de la parole, mais pour atteindre l'objectif ultime de la communication avec le patient, il faut étendre ce travail à la production de la parole.

Ce domaine de recherche pourrait même aller au-delà de l’aide aux patients, et potentiellement inclure de nouvelles façons d’interagir avec les ordinateurs.

En regardant la situation dans son ensemble, les travaux de Meta s’inscrivent dans le cadre des efforts de la communauté scientifique visant à utiliser l’intelligence artificielle pour mieux comprendre le cerveau humain. Meta espère partager publiquement cette recherche pour accélérer les progrès sur les défis futurs.

Analyse papier

Lien papier : https://arxiv.org/pdf/2208.12266.pdf

Cet article propose une architecture unique de bout en bout qui peut fonctionner sur un grand nombre d'individus L'apprentissage contrasté est formé en groupes pour prédire les représentations auto-supervisées de la parole naturelle.

Nous avons évalué le modèle sur quatre ensembles de données publiques, y compris des données enregistrées par magnétoencéphalographie ou électroencéphalographie (M/EEG) de 169 volontaires tout en écoutant la parole naturelle.

Cela fournit une nouvelle idée pour le décodage en temps réel du traitement du langage naturel à partir d'enregistrements non invasifs de l'activité cérébrale.

Méthodes et architecture

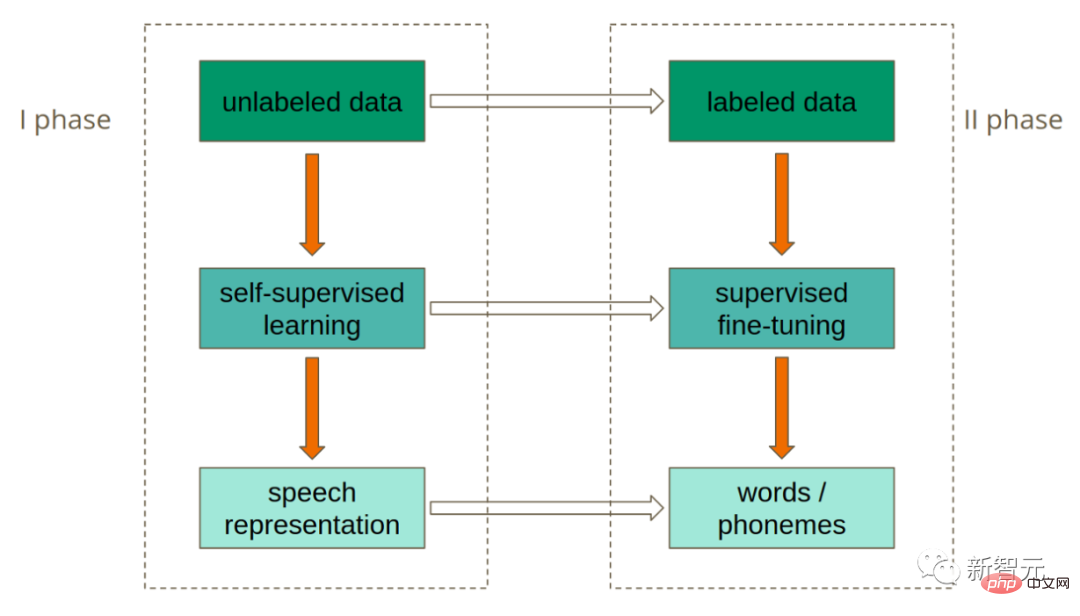

Nous formalisons d'abord la tâche générale de décodage neuronal et encourageons l'entraînement à l'aide de pertes contrastives. Avant d'introduire l'architecture d'apprentissage profond pour le décodage cérébral, nous introduisons la riche représentation vocale fournie par le module auto-supervisé pré-entraîné wav2vec 2.0.

Notre objectif est de décoder la parole à partir de séries chronologiques de signaux cérébraux de grande dimension enregistrés par magnétoencéphalographie non invasive (MEG) ou électroencéphalographie (EEG) tandis que des volontaires sains écoutent passivement des phrases prononcées dans leur langue maternelle.

La façon dont le langage parlé est représenté dans le cerveau est en grande partie inconnue, c'est pourquoi les décodeurs sont souvent formés de manière supervisée pour prédire les représentations sous-jacentes de la parole qui sont connues pour être pertinentes pour le cerveau.

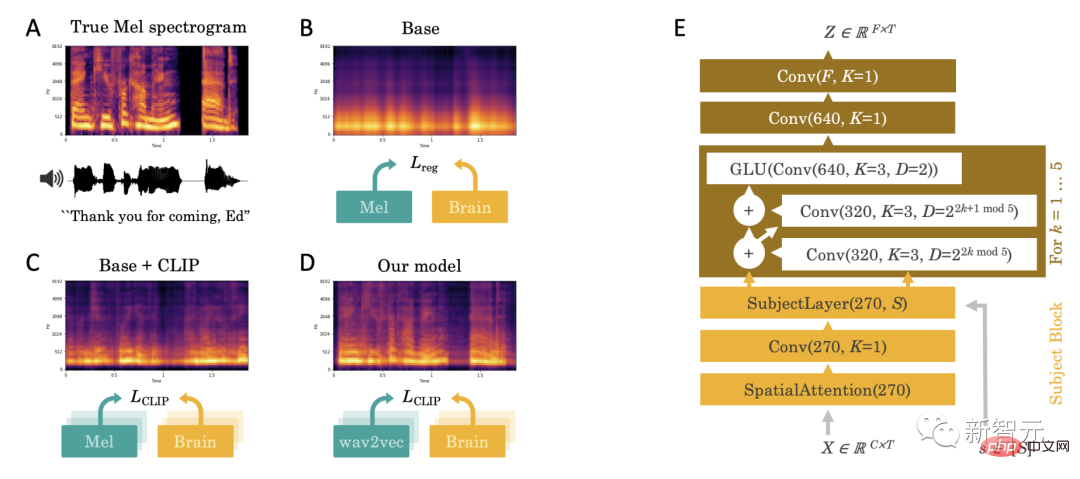

Empiriquement, nous observons que cette approche de régression directe se heurte à plusieurs défis : lorsque la parole est présente, les prédictions de décodage semblent être dominées par une composante haut débit indiscernable (Figure 2.A-B).

Ce défi nous a incité à apporter trois contributions principales : l'introduction de pertes contrastives, de représentations vocales profondes pré-entraînées et de décodeurs cérébraux spécialisés.

1. Perte de contraste

Premièrement, nous en déduisons que la régression peut être une perte inefficace car elle s'écarte de notre objectif : décoder la parole à partir de l'activité cérébrale. Par conséquent, nous la remplaçons par une perte contrastive, la perte « CLIP », qui a été initialement conçue pour faire correspondre les représentations latentes dans les deux modalités : texte et images.

2. Représentation de la parole profonde pré-entraînée

Deuxièmement, le spectre de Mel est une représentation de la parole de bas niveau et est donc peu susceptible de correspondre à des représentations corticales riches. Par conséquent, nous remplaçons le spectre Mel Y par des représentations latentes de la parole qui sont soit apprises de bout en bout (modèles "Deep Mel"), soit apprises avec un modèle vocal indépendant et auto-supervisé. En pratique, nous utilisons wav2vec2-large-xlsr-531, qui a été pré-entraîné sur 56 000 heures de parole dans 53 langues différentes.

3. "Décodeur cérébral" spécialisé

Enfin, pour le module cérébral, nous utilisons un réseau neuronal profond fclip pour saisir la série temporelle M/EEG originale X et le plan unique correspondant de l'encodage du sujet. , et génère la représentation latente du cerveau Z, échantillonnée au même rythme que X.

Cette architecture se compose de (1) une couche d'attention spatiale sur le capteur M/EEG, qui est ensuite conçue par une convolution 1x1 spécifique à un objet pour exploiter la variabilité inter-sujet, qui l'entrée est une pile de blocs convolutifs.

Les résultats montrent que le modèle wav2vec 2.0 peut identifier les clips vocaux correspondants à partir de 3 secondes de signaux EEG, avec une précision de 72,5% parmi 1 594 clips différents, et 2 604 signaux EEG dans les clips enregistrés. , la précision atteint 19,1 % et il peut décoder des phrases qui ne font pas partie de l'ensemble d'apprentissage.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

Les principales raisons de la défaillance de l'installation de MySQL sont les suivantes: 1. Problèmes d'autorisation, vous devez s'exécuter en tant qu'administrateur ou utiliser la commande sudo; 2. Des dépendances sont manquantes et vous devez installer des packages de développement pertinents; 3. Conflits du port, vous devez fermer le programme qui occupe le port 3306 ou modifier le fichier de configuration; 4. Le package d'installation est corrompu, vous devez télécharger et vérifier l'intégrité; 5. La variable d'environnement est mal configurée et les variables d'environnement doivent être correctement configurées en fonction du système d'exploitation. Résolvez ces problèmes et vérifiez soigneusement chaque étape pour installer avec succès MySQL.

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.