Périphériques technologiques

Périphériques technologiques

IA

IA

Fusionnant deux modèles sans aucun obstacle, la connexion linéaire de grands modèles ResNet ne prend que quelques secondes, inspirant de nouvelles recherches sur les réseaux neuronaux

Fusionnant deux modèles sans aucun obstacle, la connexion linéaire de grands modèles ResNet ne prend que quelques secondes, inspirant de nouvelles recherches sur les réseaux neuronaux

Fusionnant deux modèles sans aucun obstacle, la connexion linéaire de grands modèles ResNet ne prend que quelques secondes, inspirant de nouvelles recherches sur les réseaux neuronaux

Le deep learning a pu réaliser de tels résultats grâce à sa capacité à résoudre des problèmes d'optimisation non convexes à grande échelle avec une relative facilité. Bien que l'optimisation non convexe soit NP-difficile, certains algorithmes simples, généralement des variantes de la descente de gradient stochastique (SGD), ont montré une efficacité surprenante pour adapter réellement de grands réseaux de neurones.

Dans cet article, plusieurs chercheurs de l'Université de Washington ont écrit "Git Re-Basin: Merging Models modulo Permutation Symmetries". Ils ont étudié l'efficacité déraisonnable de l'algorithme SGD sur les problèmes d'optimisation non convexes de grande dimension dans l'apprentissage profond. . Ils s'inspirent de trois questions :

1. Pourquoi SGD fonctionne bien dans l'optimisation de paysages de perte d'apprentissage profond non convexes de grande dimension, tout en étant robuste dans d'autres paramètres d'optimisation non convexes tels que l'apprentissage des politiques, l'optimisation de trajectoire et la recommandation. systèmes Diminution significative ?

2. Où est le minimum local ? Pourquoi la perte diminue-t-elle de manière douce et monotone lors d'une interpolation linéaire entre les poids d'initialisation et les poids d'entraînement finaux ?

3. Pourquoi deux modèles formés indépendamment avec un ordre d'initialisation aléatoire et de traitement par lots de données différents obtiennent-ils presque les mêmes performances ? De plus, pourquoi leurs courbes de perte d’entraînement se ressemblent-elles ? Variabilité, de sorte que différents entraînements montreront presque les mêmes performances.

Pourquoi cela se produit-il ? En 2019, Brea et al. ont remarqué que les unités cachées dans les réseaux de neurones présentaient une symétrie d'arrangement. En termes simples : nous pouvons échanger deux unités quelconques dans la couche cachée du réseau, et la fonctionnalité du réseau restera la même. Entezari et al. 2021 ont émis l'hypothèse que ces symétries de permutation pourraient nous permettre de connecter linéairement des points dans l'espace de poids sans compromettre les pertes.

Pourquoi cela se produit-il ? En 2019, Brea et al. ont remarqué que les unités cachées dans les réseaux de neurones présentaient une symétrie d'arrangement. En termes simples : nous pouvons échanger deux unités quelconques dans la couche cachée du réseau, et la fonctionnalité du réseau restera la même. Entezari et al. 2021 ont émis l'hypothèse que ces symétries de permutation pourraient nous permettre de connecter linéairement des points dans l'espace de poids sans compromettre les pertes.

Ci-dessous, nous utilisons un exemple de l'un des auteurs de l'article pour illustrer l'objectif principal de l'article, afin que tout le monde le comprenne plus clairement.

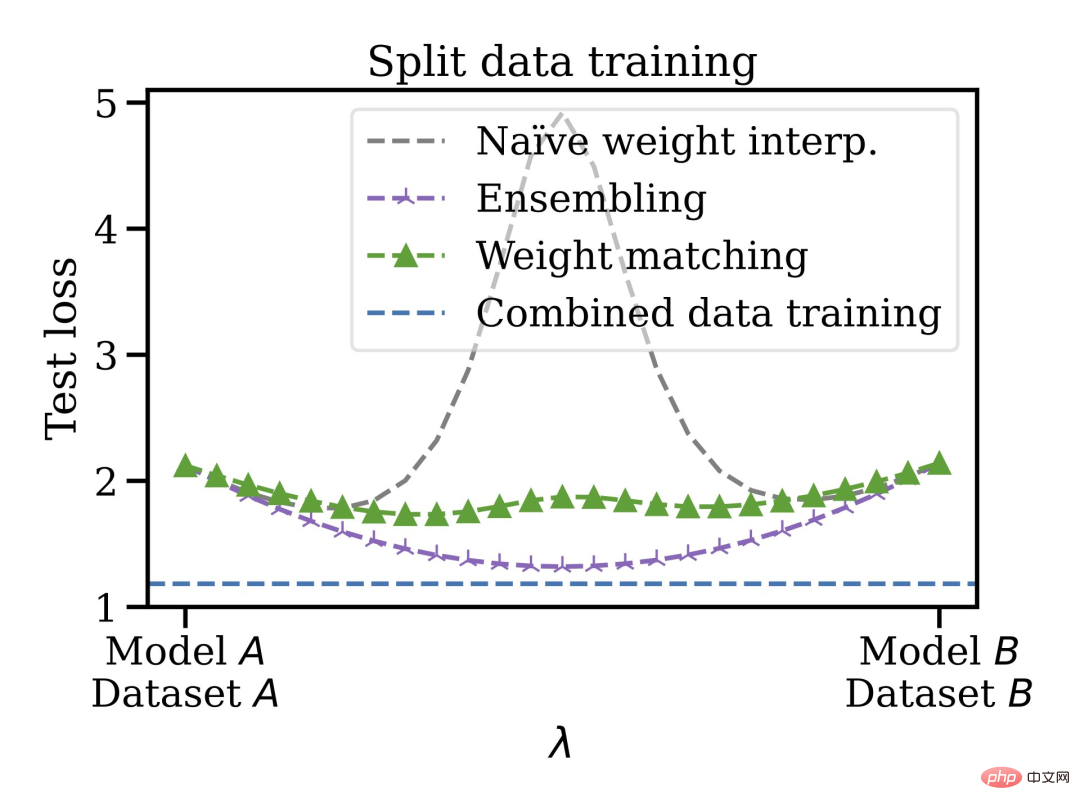

Supposons que vous ayez entraîné un modèle A et que votre ami ait entraîné un modèle B, les données d'entraînement des deux modèles peuvent être différentes. Ce n'est pas grave, grâce au Git Re-Basin proposé dans cet article, vous pouvez fusionner les deux modèles A+B dans l'espace poids sans nuire à la perte.

Les auteurs de l'article ont déclaré que Git Re-Basin peut être appliqué à n'importe quel réseau neuronal (NN). Ils ont démontré pour la première fois qu'il existe deux modèles formés indépendamment (pas de pré-entraînement). (ResNets), une connectivité linéaire sans obstacle est possible.

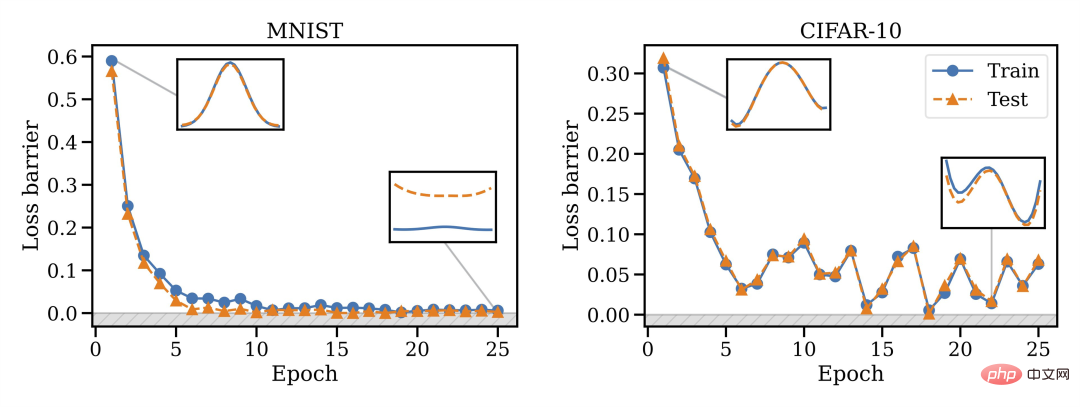

Ils ont découvert que la capacité de fusion est une propriété de la formation SGD, la fusion ne fonctionne pas à l'initialisation, mais un changement de phase se produit, donc la fusion deviendra possible avec le temps.

De plus, toutes les architectures ne peuvent pas être fusionnées : VGG semble être plus difficile à fusionner que ResNets.

Cette méthode de fusion présente d'autres avantages, vous pouvez entraîner le modèle sur des ensembles de données disjoints et biaisés, puis les fusionner dans l'espace de pondération. Par exemple, vous disposez de certaines données aux États-Unis et d’autres dans l’UE. Pour une raison quelconque, les données ne peuvent pas être mélangées. Vous pouvez d'abord entraîner des modèles distincts, puis fusionner les poids et enfin généraliser à l'ensemble de données fusionné.

Ainsi, les modèles formés peuvent être mélangés sans avoir besoin de pré-entraînement ou de réglage fin. L'auteur a exprimé son intérêt à connaître l'orientation future du développement de la connexion en mode linéaire et de la réparation de modèles, qui pourraient être appliquées à des domaines tels que l'apprentissage fédéré, la formation distribuée et l'optimisation de l'apprentissage profond.

Enfin, il est mentionné que l'algorithme de correspondance de poids du chapitre 3.2 ne prend que 10 secondes environ à exécuter, ce qui permet de gagner beaucoup de temps. Le chapitre 3 de l'article présente également trois méthodes pour faire correspondre les unités du modèle A et du modèle B. Les amis qui ne connaissent pas bien l'algorithme de correspondance peuvent vérifier l'article original.

Commentaires des internautes et clarifications de l'auteur

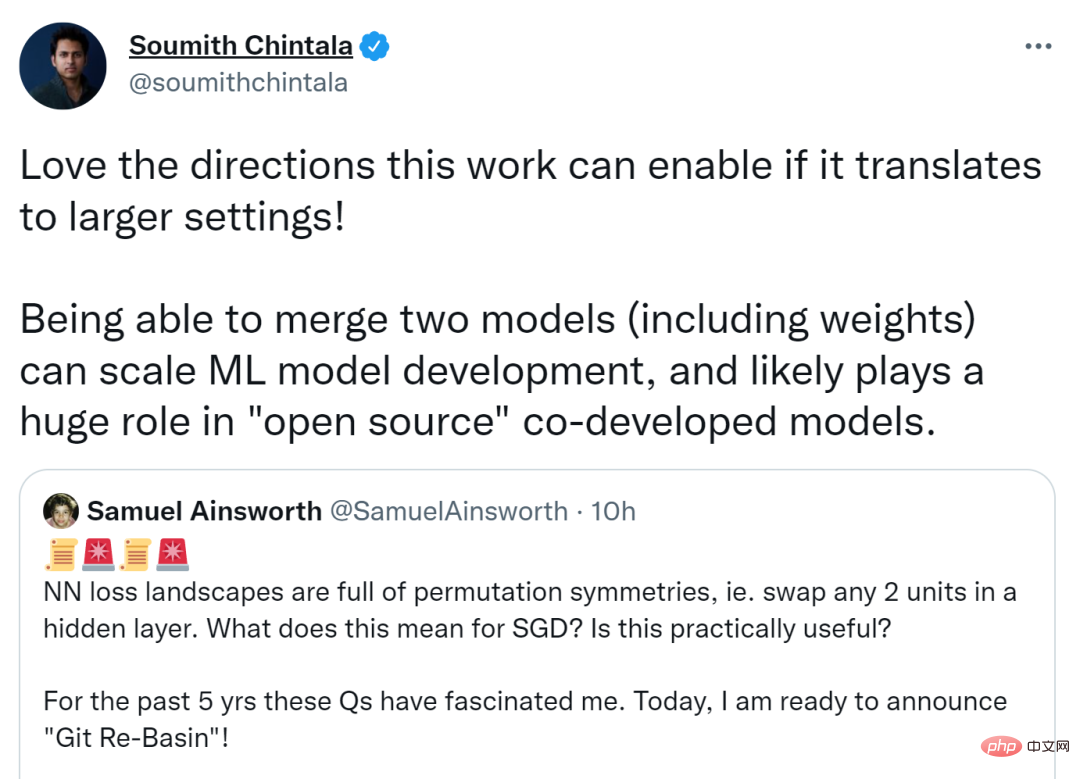

Cet article a déclenché une discussion animée sur Twitter, et le co-fondateur de PyTorch, Soumith Chintala, a déclaré que si cette recherche pouvait être déplacée dans un cadre plus large, la direction qu'elle pourrait atteindre serait plus grande. La fusion de deux modèles (y compris les pondérations) peut étendre le développement de modèles ML et peut jouer un rôle énorme dans le co-développement open source de modèles.

D'autres pensent que si l'invariance par permutation peut capturer la plupart des équivalences avec autant d'efficacité, elle inspirera la recherche théorique sur les réseaux de neurones.

Samuel Ainsworth, premier auteur de l'article et titulaire d'un doctorat de l'Université de Washington, a également répondu à quelques questions soulevées par les internautes.

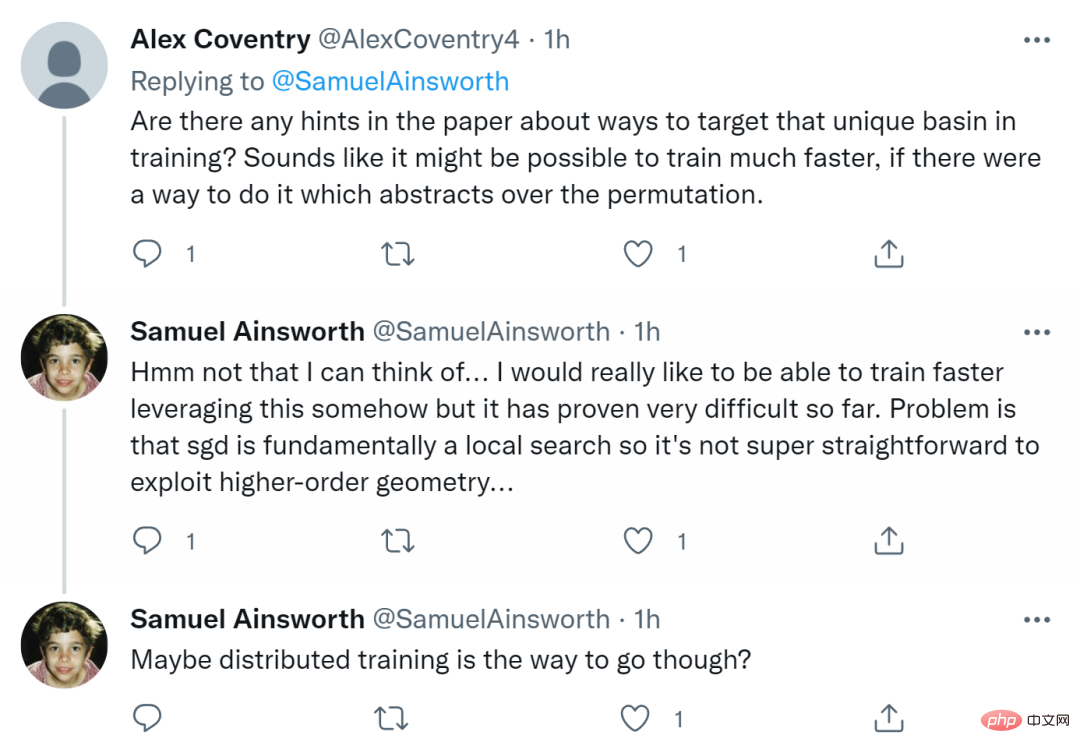

Tout d'abord, quelqu'un a demandé : "Y a-t-il des conseils dans le document sur le ciblage de bassins uniques lors de l'entraînement ? S'il existait un moyen d'abstraire les permutations, alors l'entraînement pourrait être plus rapide

Ainsworth Il a répondu que." il n'y avait pas pensé. Il espère vraiment pouvoir s’entraîner plus vite d’une manière ou d’une autre, mais jusqu’à présent, cela s’est avéré très difficile. Le problème est que SGD est essentiellement une recherche locale, il n'est donc pas si simple d'exploiter une géométrie d'ordre supérieur. Peut-être que la formation distribuée est la voie à suivre.

Certaines personnes ont également demandé si cela était applicable aux RNN et aux Transformers ? Ainsworth dit que cela fonctionne en principe, mais il ne l'a pas encore expérimenté. Le temps nous le dira.

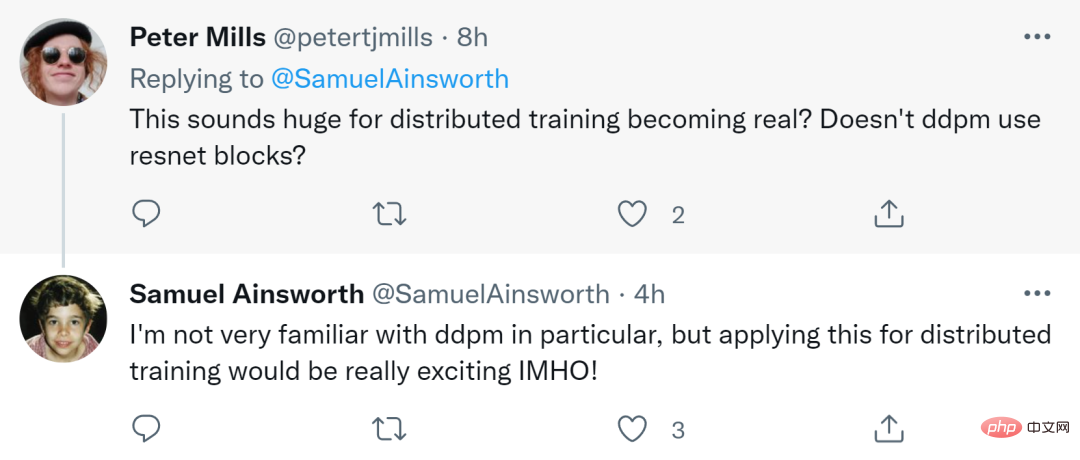

Finalement, quelqu'un a demandé : « Cela semble très important pour que la formation distribuée devienne une réalité ? Le DDPM (Denoising Diffusion Probabilistic Model) n'utilise-t-il pas des blocs résiduels ResNet ? »

Ainsworth a répondu que Bien qu'il ne soit pas lui-même très familier avec DDPM, il a déclaré sans ambages que l'utiliser pour une formation distribuée serait très excitant.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe