Périphériques technologiques

Périphériques technologiques

IA

IA

Choqué ! Après 70 000 heures de formation, le modèle OpenAI a appris à planifier le bois dans « Minecraft »

Choqué ! Après 70 000 heures de formation, le modèle OpenAI a appris à planifier le bois dans « Minecraft »

Choqué ! Après 70 000 heures de formation, le modèle OpenAI a appris à planifier le bois dans « Minecraft »

Récemment, OpenAI, qui semble avoir laissé GPT derrière lui, a commencé une nouvelle vie.

Après s'être entraînée avec des vidéos massives non étiquetées et un peu de données étiquetées, l'IA a finalement appris à fabriquer des pioches en diamant dans Minecraft.

L'ensemble du processus prend au moins 20 minutes à un joueur inconditionnel et nécessite un total de 24 000 opérations.

Cette chose semble simple, mais c'est très difficile pour l'IA.

Un enfant de 7 ans peut l'apprendre en seulement 10 minutes

Pour la pioche en bois la plus simple, il n'est pas trop difficile pour les joueurs humains de l'apprendre à partir de zéro.

Un nerd peut enseigner le suivant en moins de 3 minutes avec une seule vidéo.

La vidéo de démonstration dure 2 minutes et 52 secondes

Cependant, réaliser une pioche en diamant est beaucoup plus compliqué.

Mais malgré cela, un enfant de 7 ans peut l'apprendre après avoir simplement regardé une vidéo de démonstration de dix minutes.

La difficulté de cette mission est principalement de savoir comment creuser la mine de diamant.

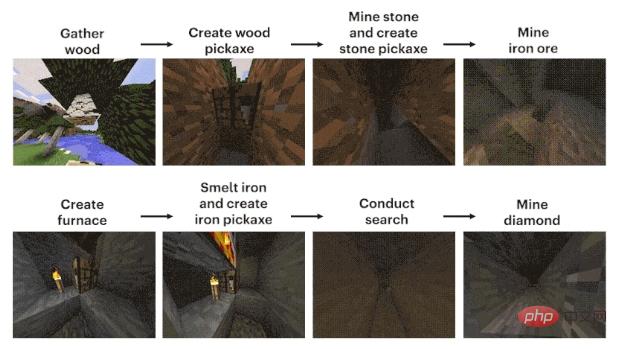

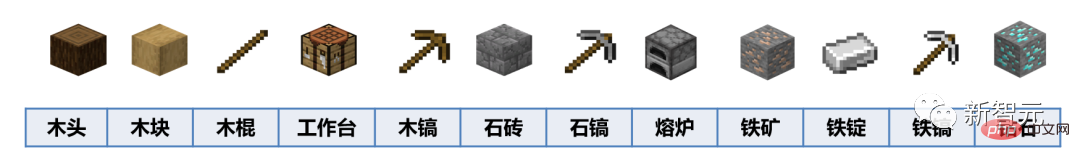

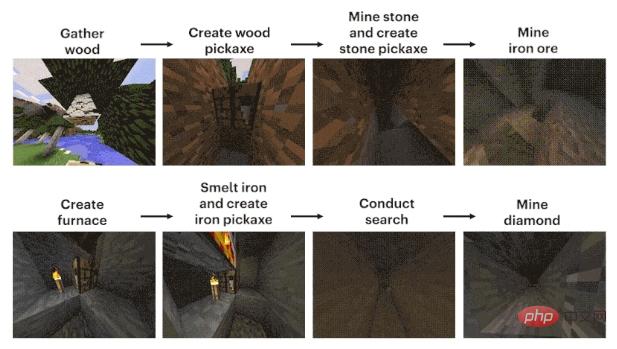

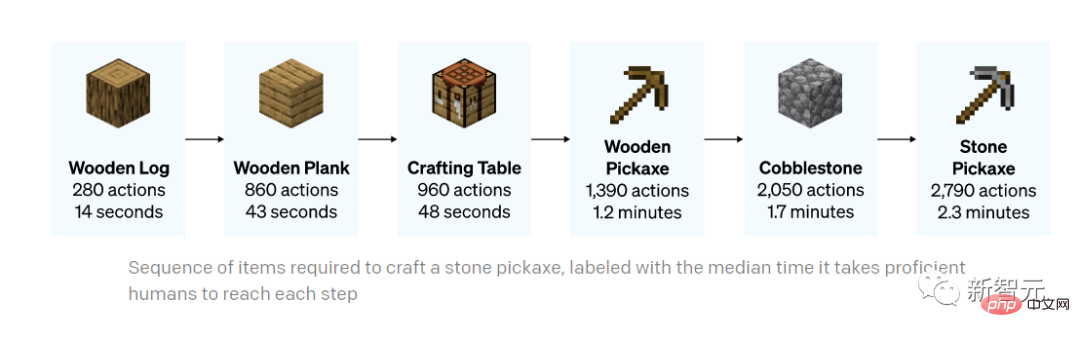

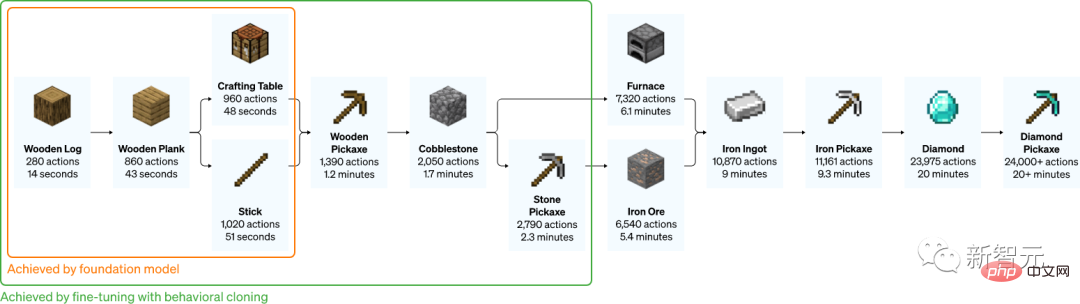

Le processus peut être résumé grossièrement en 12 étapes : d'abord, planifier le bloc de pixels "bois" à mains nues, puis synthétiser les blocs de bois à partir des bûches, utiliser les blocs de bois pour fabriquer des bâtons de bois, utiliser les bâtons de bois pour fabriquez la table d'équipement de l'atelier et utilisez l'établi pour fabriquer des pioches en bois. Utilisez une pioche en bois pour frapper des pierres, ajoutez des pierres aux bâtons de bois pour fabriquer une pioche en pierre, utilisez la pioche en pierre pour construire un four, le four traite le minerai de fer, le le minerai de fer fond en lingots de fer, les lingots de fer fabriquent des pioches en fer et les pioches en fer creusent des diamants.

Maintenant, la pression est du côté de l'IA.

Par coïncidence, CMU, OpenAI, DeepMind, Microsoft Research et d'autres institutions ont lancé un concours connexe, MineRL, depuis 2019.

Les candidats doivent développer un agent d'intelligence artificielle capable de "construire des outils à partir de zéro et de trouver et d'exploiter automatiquement des mines de diamants". Les conditions gagnantes sont également très simples : le plus rapide gagne.

Quel a été le résultat ?

Après le premier concours MineRL, "Un enfant de 7 ans l'a appris après avoir regardé une vidéo de 10 minutes, mais l'IA n'arrivait toujours pas à le comprendre après 8 millions de pas." publié dans la revue Nature.

Bien qu'il y ait beaucoup de données, je ne peux pas les utiliser

En tant que jeu de construction bac à sable, "Minecraft" est particulièrement adapté à l'apprentissage et à la prise de décision de divers modèles d'IA en raison de sa grande ouverture des stratégies des joueurs et environnement virtuel dans le jeu. Un terrain d’essai et une pierre de touche pour les capacités.

Et en tant que jeu « de niveau national », il est facile de trouver des vidéos liées à « Minecraft » en ligne.

Cependant, qu'il s'agisse de créer un tutoriel ou de montrer votre propre travail, dans une certaine mesure, il ne s'agit que du résultat affiché à l'écran.

En d’autres termes, les gens qui regardent la vidéo peuvent seulement savoir ce que le leader a fait et comment il l’a fait, mais ils n’ont aucun moyen de savoir comment il l’a fait.

Pour être plus précis, ce qui est affiché sur l'écran de l'ordinateur n'est que le résultat, et les étapes de l'opération sont le clic constant du propriétaire sur le clavier et le mouvement constant de la souris.

Même ce processus a été modifié, et les gens ne pourront probablement pas l'apprendre après l'avoir regardé, encore moins l'IA.

Pour aggraver les choses, de nombreux joueurs se plaignent que raboter du bois dans le jeu est ennuyeux, un peu comme faire ses devoirs et accomplir des tâches. En conséquence, après une vague de mises à jour, de nombreux outils peuvent être récupérés gratuitement... Désormais, même les données sont difficiles à trouver.

Si OpenAI veut permettre à l'IA d'apprendre à jouer à "Minecraft", elle doit trouver un moyen d'utiliser ces données vidéo massives non étiquetées.

Modèle de pré-formation vidéo - VPT

Ainsi, VPT a vu le jour.

Adresse papier : https://cdn.openai.com/vpt/Paper.pdf

Cette chose est nouvelle, mais ce n'est pas compliqué. C'est une sorte de semi-. supervision Méthode d'apprentissage par imitation.

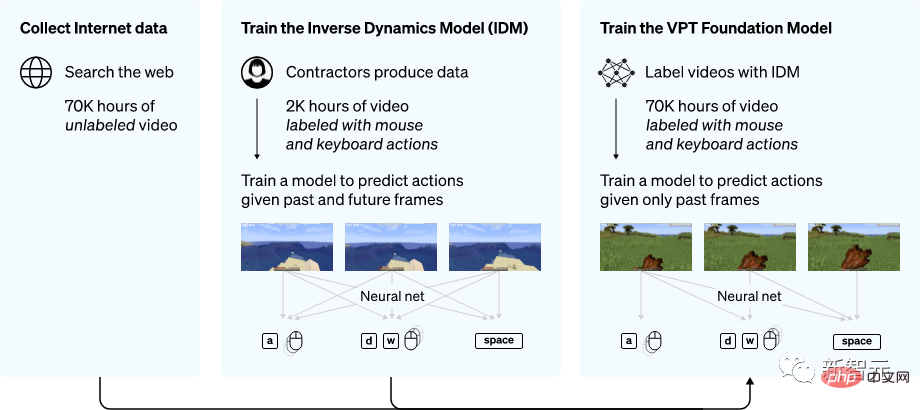

Tout d'abord, collectez une vague de données pour annoter les données de jeu des sous-traitants, qui comprennent les enregistrements vidéo et les opérations du clavier et de la souris.

Aperçu de la méthode VPT

Ensuite, les chercheurs ont utilisé ces données pour créer un modèle de dynamique inverse (IDM), qui peut déduire la clé de chaque étape dans la vidéo Comment fonctionnent les rats. se déplacer?

De cette façon, l'ensemble de la tâche devient beaucoup plus simple et seulement beaucoup moins de données sont nécessaires pour atteindre l'objectif.

Après avoir terminé l'IDM avec une petite quantité de données externalisées, vous pouvez utiliser IDM pour étiqueter un plus grand ensemble de données non étiquetées.

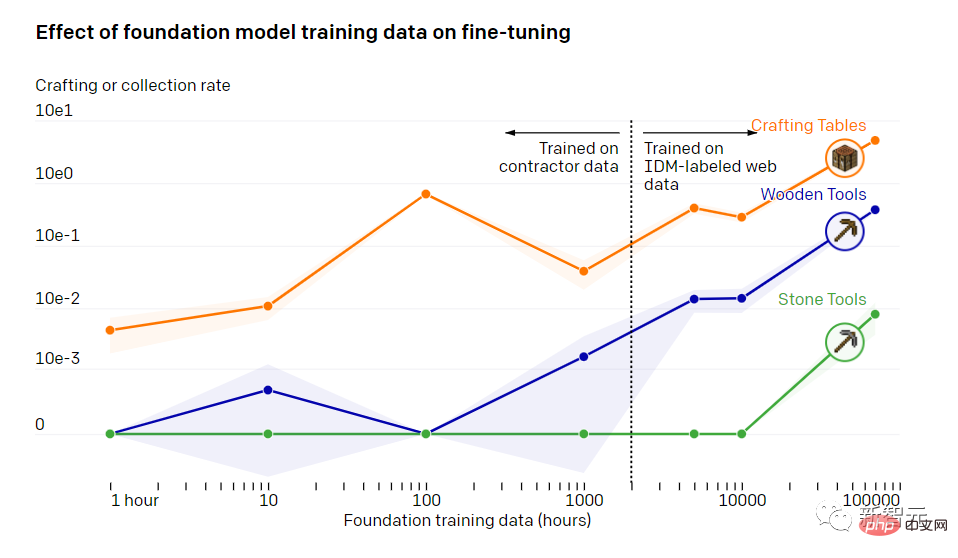

L'impact des données de formation de base du modèle sur le réglage fin

Après 70 000 heures de formation, le modèle de clonage comportemental d'OpenAI peut accomplir diverses tâches que d'autres modèles ne peuvent pas accomplir.

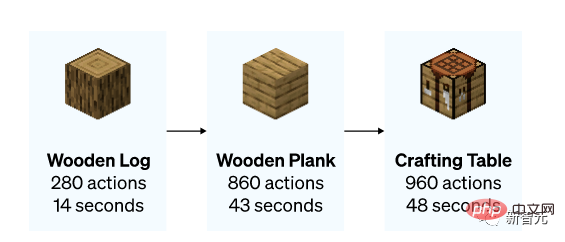

Le modèle a appris à abattre des arbres et à ramasser du bois, à utiliser le bois pour fabriquer des bandes de bois et à utiliser des bandes de bois pour fabriquer des tables. Cet ensemble de choses nécessite qu'un joueur relativement qualifié opère pendant moins de 50 secondes.

En plus de faire une table, le modèle peut aussi nager, chasser et manger.

Il existe même une opération sympa de "courir, sauter et construire", c'est-à-dire que lorsque vous décollez, mettez une brique ou un bloc de bois sous vos pieds, et vous pouvez construire un pilier en sautant. Il s'agit d'un cours obligatoire pour les joueurs inconditionnels.

Création d'un tableau (0 plan)

Chasse (0 plan)

"Courir et sauter" version simple (0 plan)

Pour Pour permettre au modèle d'accomplir certaines tâches plus détaillées, l'ensemble de données est généralement affiné à une taille plus petite et distingue de petites directions.

OpenAI a réalisé une étude qui a montré à quel point un modèle formé avec VPT peut s'adapter aux ensembles de données en aval après un réglage fin.

Les chercheurs ont invité les gens à jouer à "Minecraft" pendant 10 minutes et à construire une maison en utilisant des matériaux de base. Ils espèrent ainsi pouvoir améliorer la capacité du modèle à effectuer certaines tâches de début de partie, telles que la construction d'un établi.

Après avoir affiné l'ensemble de données, les chercheurs ont non seulement constaté que le modèle était plus efficace pour effectuer les tâches initiales, mais ont également constaté que le modèle lui-même comprenait comment fabriquer un établi en bois et un établi en bois. .

Parfois, les chercheurs peuvent également voir le modèle construire tout seul un abri rudimentaire, fouiller le village et piller des coffres.

L'ensemble du processus de fabrication d'une pioche en pierre (le temps indiqué ci-dessous est le temps qu'il faut à un joueur expérimenté pour effectuer la même tâche)

Faire une pioche en pierre

Voyons ensuite comment les experts d'OpenAI l'ont peaufiné.

La méthode qu'ils utilisent est l'apprentissage par renforcement (RL).

La plupart des méthodes RL relèvent ces défis en explorant de manière stochastique les priorités, c'est-à-dire que les modèles sont souvent incités à récompenser les actions aléatoires via l'entropie. Le modèle VPT devrait être un meilleur modèle antérieur pour RL, car simuler le comportement humain peut être plus utile que de prendre des actions aléatoires.

Les chercheurs ont mis en place le modèle pour la tâche difficile de collecter des pioches en diamant, une fonctionnalité jamais vue auparavant dans Minecraft, car l'exécution de l'ensemble de la tâche est beaucoup plus difficile lorsque l'on utilise l'interface homme-machine native.

Fabriquer une pioche en diamant nécessite une série longue et complexe de sous-tâches. Pour rendre cette tâche réalisable, les chercheurs ont récompensé l'agent pour chaque élément de la séquence.

Ils ont découvert qu'une politique RL formée à partir d'une initialisation aléatoire (approche RL standard) ne recevait presque aucune récompense, n'apprenait jamais à collecter des journaux et collectait rarement des bâtons.

Contrairement à ce qui se passe, le modèle VPT a été affiné non seulement pour apprendre à fabriquer une pioche en diamant, mais également pour atteindre un succès au niveau humain dans la collecte de tous les objets.

Et c'est la première fois que quelqu'un montre un modèle informatique capable de fabriquer des outils diamantés dans "Minecraft".

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Boîtes déroulantes en cascade Points de fosse de liaison V-model: V-model lie un tableau représentant les valeurs sélectionnées à chaque niveau de la boîte de sélection en cascade, pas une chaîne; La valeur initiale de SelectOptions doit être un tableau vide, non nul ou non défini; Le chargement dynamique des données nécessite l'utilisation de compétences de programmation asynchrones pour gérer les mises à jour des données en asynchrone; Pour les énormes ensembles de données, les techniques d'optimisation des performances telles que le défilement virtuel et le chargement paresseux doivent être prises en compte.

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.