Périphériques technologiques

Périphériques technologiques

IA

IA

Tsinghua, Cambridge et l'UIC lancent conjointement le premier ensemble de données chinoises de vérification des faits : basé sur des preuves, couvrant la société médicale et d'autres domaines

Tsinghua, Cambridge et l'UIC lancent conjointement le premier ensemble de données chinoises de vérification des faits : basé sur des preuves, couvrant la société médicale et d'autres domaines

Tsinghua, Cambridge et l'UIC lancent conjointement le premier ensemble de données chinoises de vérification des faits : basé sur des preuves, couvrant la société médicale et d'autres domaines

- Adresse papier : https://arxiv.org/pdf/2206.11863.pdf

- Dataset CHEF Lien vers l'ensemble de données : https://github.com/THU-BPM/CHEF

1. Introduction

Regardons d'abord la définition de la tâche et donnons un exemple relativement simple :

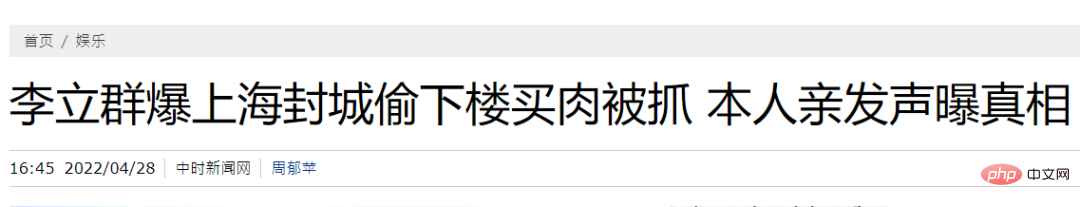

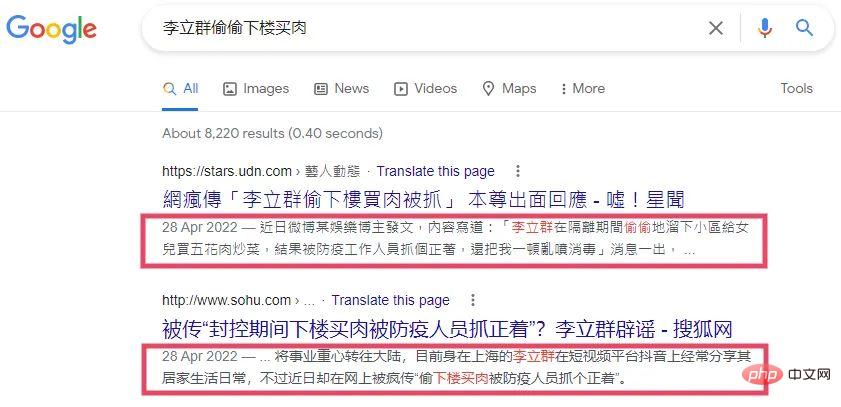

Par exemple, pendant le confinement à Shanghai, un certain auto-média a affirmé que "Li Liqun m'a volé. J'ai été surpris en train de descendre pour acheter de la viande." Sur la base de cette seule affirmation (réclamation), nous ne pouvons pas déterminer s'il est descendu secrètement pour acheter de la viande et s'il a été attrapé. Afin de vérifier l'authenticité de cette déclaration, l'idée la plus intuitive est de rechercher des preuves (les preuves sont des informations que vous pouvez collecter et qui peuvent nous aider à vérifier l'authenticité d'une déclaration). Par exemple, dans l'image ci-dessous, je la déchire simplement avec mes mains et elle peut être utilisée comme preuve.

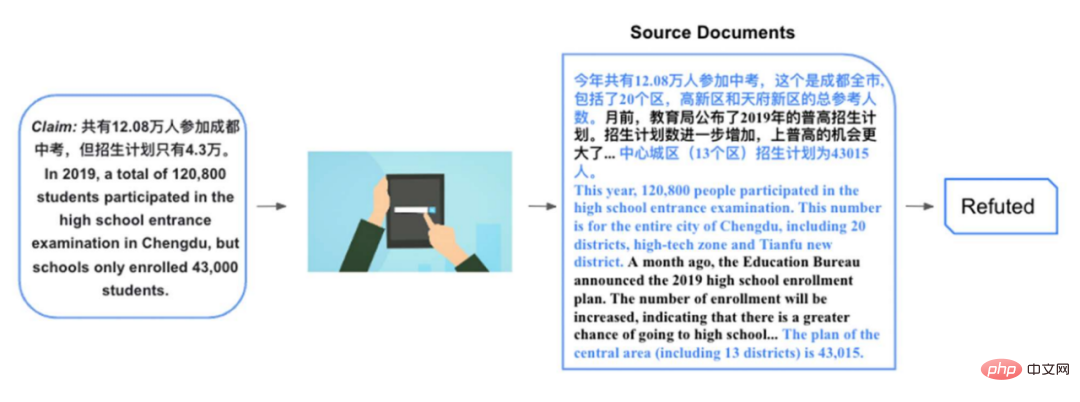

La déclaration citée ci-dessus est relativement simple, ne nécessitant que de simples preuves et aucun raisonnement fondé sur des preuves. Regardons un exemple relativement complexe ci-dessous. Par exemple, il y a une déclaration : En 2019, un total de 120 800 personnes ont passé l'examen d'entrée au lycée de Chengdu, mais le plan d'inscription n'est que de 43 000. Il est relativement difficile de vérifier cette affirmation. Si nous trouvons des documents pertinents faisant état de l'examen d'entrée au lycée de Chengdu 2019 :

...Au total, 120 800 personnes ont passé l'examen d'entrée au lycée cette année. ville de Chengdu, comprenant le district 20, la zone de haute technologie et le nouveau district de Tianfu. Il y a quelques mois, le Bureau de l'éducation a annoncé le plan général d'inscription au lycée pour 2019. Le nombre de projets d'inscription a encore augmenté et les chances d'entrer dans le lycée général sont encore plus grandes. ...

En 2019, le plan d'inscription pour la ville centre (13 arrondissements) est de 43 015 personnes.

Ce document contient de nombreuses informations liées à la déclaration, mais ce qui est directement pertinent et peut nous aider à vérifier la déclaration est la seconde moitié du deuxième paragraphe ci-dessus, et après de nombreux paragraphes. Sur la base de ces éléments de preuve, nous pouvons savoir qu'il y a effectivement 120 800 personnes qui passent l'examen d'entrée au lycée dans les 20 arrondissements de Chengdu, et que le plan d'inscription pour la zone urbaine centrale (ne comprenant que 13 arrondissements) n'est en effet que de 43 000. Bien que les chiffres soient corrects, le concept est modifié ici. Lors de l'examen du nombre de personnes passant l'examen d'entrée au lycée, le nombre de personnes dans 20 districts est utilisé, mais lors de l'examen du plan d'inscription, la fourchette de 20 districts est réduite à 13 districts, trompant ainsi les lecteurs. Pour vérifier ce type de déclaration, nous devons souvent extraire des preuves directement pertinentes d'un ou plusieurs documents, et en même temps faire des déductions basées sur les preuves extraites. Afin de promouvoir les systèmes chinois d’apprentissage automatique de vérification des faits, nous proposons un tel ensemble de données chinoises fondées sur des preuves.

2. Travaux connexes

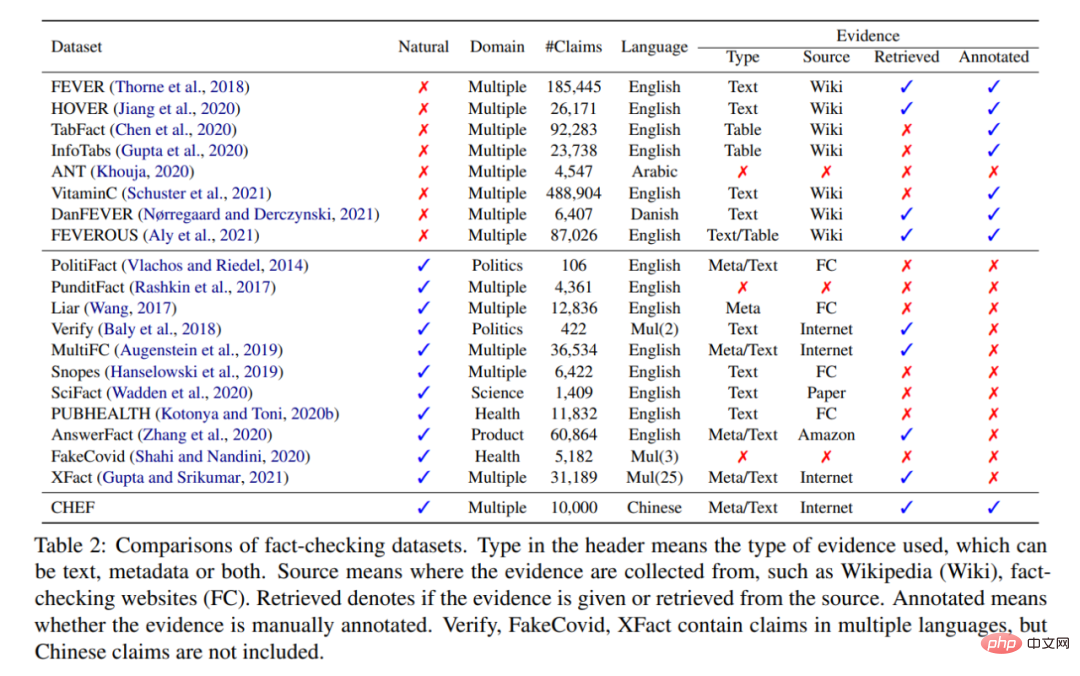

Selon l'examen de la vérification des faits [1], les ensembles de données actuels de vérification des faits peuvent être grossièrement divisés en deux catégories : Artificiel (Artificiel) et Naturel (Naturel).

Artificiel (Artificiel) : Il est demandé à l'annotateur de réécrire la phrase selon Wikipédia comme une déclaration. Les paragraphes pertinents du document peuvent être utilisés comme preuve pour vérifier cette déclaration. S'il s'agit d'une conversion synonyme, alors la déclaration est étayée par la preuve (Supported). Si les entités de la phrase sont remplacées ou si une série de modifications telles que la négation sont ajoutées, alors la déclaration est rejetée par la preuve (Réfutée). .

Ce paradigme d'annotation était à l'origine FEVER[2], et de nombreux ensembles de données célèbres plus tard tels que TabFact[3] ont également suivi ce paradigme. L'avantage de ce type d'ensemble de données artificielles est qu'il peut être étendu aux annotateurs. D’un autre côté, les preuves pertinentes sont également faciles à obtenir. L'inconvénient est que ces déclarations ne sont pas des déclarations que nous rencontrerons dans la vie quotidienne et qui sont populaires auprès du grand public. Par exemple, vous ne réécrivez pas la déclaration « Il est descendu secrètement pour acheter de la viande et a été attrapé » sur la base de Wikipédia de Li Liqun. . D’un autre côté, ce type d’ensemble de données suppose que Wikipédia contient toutes les connaissances nécessaires pour vérifier les affirmations, ce qui est une hypothèse relativement forte. Cette hypothèse n’est souvent pas respectée dans les scénarios réels. Le problème le plus simple est que Wikipédia a un décalage dans le temps.

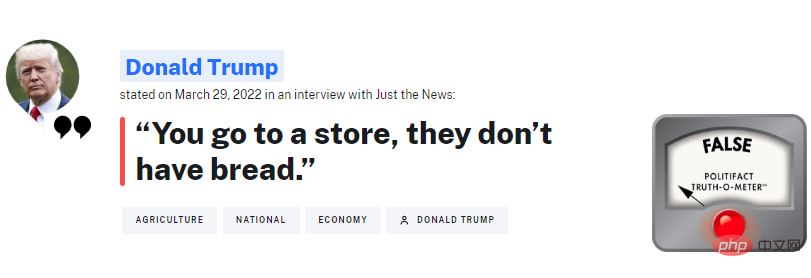

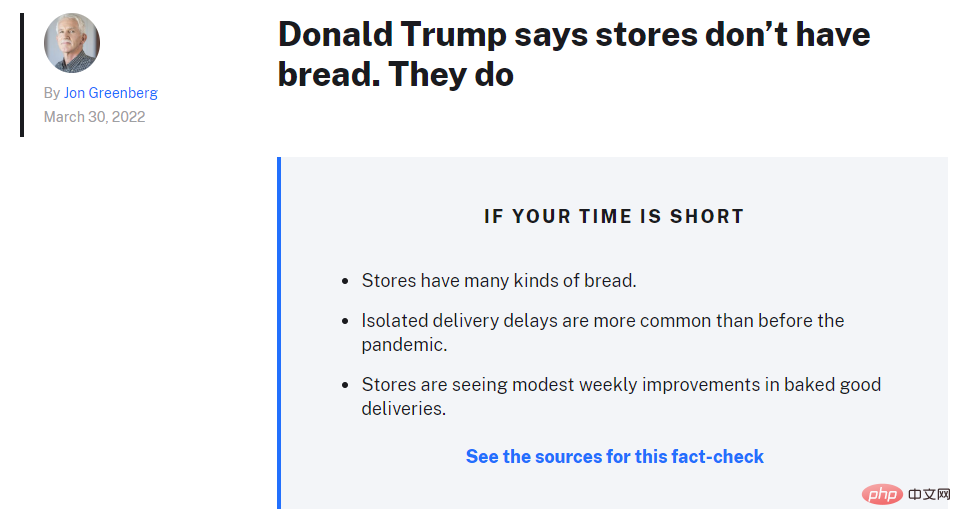

Naturel : il s'agit d'une déclaration extraite directement d'une plateforme de vérification des faits. L'organisation étrangère la plus célèbre est PolitiFact, qui vérifie souvent ce que dit Trump. L’avantage de ce type d’ensemble de données est qu’il s’agit d’une déclaration à laquelle le grand public sera confronté quotidiennement et voudra connaître la vérité. C’est aussi une déclaration que les vérificateurs de faits humains doivent examiner.

Si nous voulons à terme construire un système capable de remplacer dans une certaine mesure les vérificateurs humains, l'entrée de ce système doit être ce type de déclaration. L’inconvénient de ce type d’ensemble de données est également évident : le nombre d’allégations vérifiées par des humains est très limité. Comme le montre le tableau, la plupart des ensembles de données sont en réalité d’un ordre de grandeur inférieur à ceux construits manuellement.

D'un autre côté, trouver des preuves est un problème très difficile. Les ensembles de données existants utilisent généralement directement des articles de vérification des faits [4] comme preuve, ou utilisent des revendications pour saisir des requêtes de recherche Google [5][6], puis utilisent le résumé de recherche renvoyé (affiché dans l'encadré rouge) comme preuve.

Ces méthodes de recherche de preuves posent deux problèmes :

- Utiliser l'article de vérification des faits lui-même comme preuve : Dans un scénario réel, cette approche est irréaliste Si nous voulons Quand. un système de vérification des faits est lancé et le système doit vérifier de nouvelles allégations, il n'y a souvent pas encore d'articles de vérification des faits. De cette façon, le système ne peut pas apprendre à collecter des preuves.

- Utilisez les extraits de Google comme preuve : cette approche résout les problèmes ci-dessus et est plus proche des scénarios réels. Les vérificateurs de faits doivent souvent s'appuyer sur les moteurs de recherche pour trouver des informations pertinentes. Cependant, cette méthode présente également des inconvénients, à savoir que la quantité d'informations est sérieusement insuffisante. Comme le montre la figure ci-dessus, le résumé basé sur des règles de Google ne peut pas fournir suffisamment d'informations pour nous aider à juger de l'authenticité de la déclaration.

En réponse aux problèmes mentionnés ci-dessus, nous avons construit CHEF qui présente les caractéristiques suivantes :

- utilise des allégations du monde réel et est en chinois, comblant le vide des ensembles de données de vérification des faits chinois.

- Utilisez les documents renvoyés par le moteur de recherche comme preuves originales pour vous rapprocher de la scène réelle.

- Utiliser des annotations humaines pour renvoyer des phrases pertinentes de documents sous forme de preuves fines, qui peuvent être utilisées pour entraîner le système de vérification à apprendre à collecter des preuves.

3. Construction de l'ensemble de données

La construction de l'ensemble de données se compose de 4 parties : collecte de données, annotation des déclarations, récupération des preuves et vérification des données.

3.1 Collecte de données

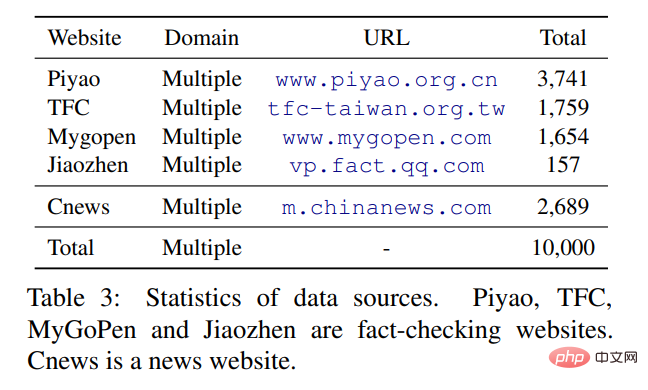

La déclaration originale est principalement extraite de quatre sites Web chinois de vérification des faits (selon Duke News Platform), dont deux en chinois simplifié : China Rumor Refutation Center et Tencent True Truth. . Le chinois traditionnel provient de deux plateformes à Taiwan : MyGoPen et le Taiwan Fact-Checking Center. Étant donné que la grande majorité (plus de 90 %) des affirmations analysées sur les sites Web de vérification des faits sont fausses, il est en fait assez intuitif que les rumeurs/déclarations les plus populaires soient fausses et seront réfutées/vérifiées par la plateforme de vérification. En nous référant aux méthodes précédentes (PublicHealth [7]), nous avons analysé les titres de China News Network comme de véritables allégations et construit un ensemble de données avec des étiquettes relativement équilibrées.

3.2 Marquage des déclarations

Par rapport aux organisations étrangères de vérification des faits relativement matures, les articles publiés par les plateformes de vérification chinoises sont relativement moins standardisés. PolitiFact, par exemple, vous dira exactement quelle est la réclamation, quel est le résumé de la vérification et quels sont les détails des preuves et du raisonnement (comme le montre l'image ci-dessus). Cependant, les articles chinois ne l’indiquent généralement pas clairement, nous demandons donc aux annotateurs de lire l’article et d’en extraire la déclaration vérifiée par l’article. Dans le même temps, la déclaration est également nettoyée pour réduire les biais qu’elle contient.

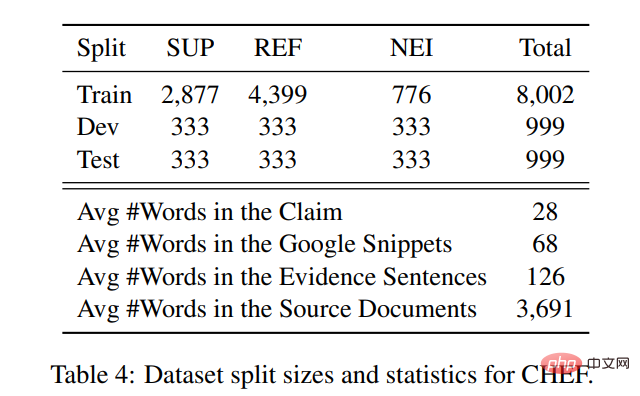

Des travaux antérieurs ont montré [8] que les déclarations dans l'ensemble de données de vérification des faits contiennent des biais relativement forts (par exemple, les fausses déclarations contiennent généralement des mots négatifs), et les PLM tels que BERT peuvent capturer directement ces biais sans avoir besoin pour preuve. Vous pouvez vérifier la déclaration. Les méthodes de nettoyage consistent à transformer les questions rhétoriques en phrases déclaratives et à supprimer certains mots qui peuvent être biaisés, tels que : lourd, choquant, etc. Après avoir extrait les affirmations, nous avons également demandé aux annotateurs d’étiqueter les affirmations sur la base d’articles de vérification des faits. Nous adoptons une classification similaire à celle d'une série d'ouvrages telle que FEVER, utilisant trois classifications : Soutenu, Réfuté et Pas assez d'informations (NEI). Parmi eux, Refuted est le plus grand et NEI est le plus petit.

3.3 Récupération de preuves

Nous utilisons la déclaration comme déclaration de requête pour interroger la recherche Google, puis filtrer certains documents, dont certains sont des documents postérieurs à la publication de la déclaration, et l'autre partie sont des documents provenant de la propagation de fausses nouvelles. plateformes, et enfin conserver la documentation du Top 5. Il a ensuite été demandé aux annotateurs de sélectionner jusqu'à 5 phrases comme preuve pour chaque déclaration.

Les statistiques des réclamations et des preuves dans l'ensemble de données sont les suivantes : la longueur moyenne des documents renvoyés pour chaque réclamation est de 3691 mots, dont la phrase dans laquelle l'annotateur a extrait la dernière preuve à grain fin contient 126 mots. Si vous utilisez Google Rule, les résumés contiennent en moyenne 68 mots. La simple comparaison de chiffres, à l'aide de documents renvoyés et de phrases annotées, fournit plus d'informations contextuelles que l'utilisation directe de résumés.

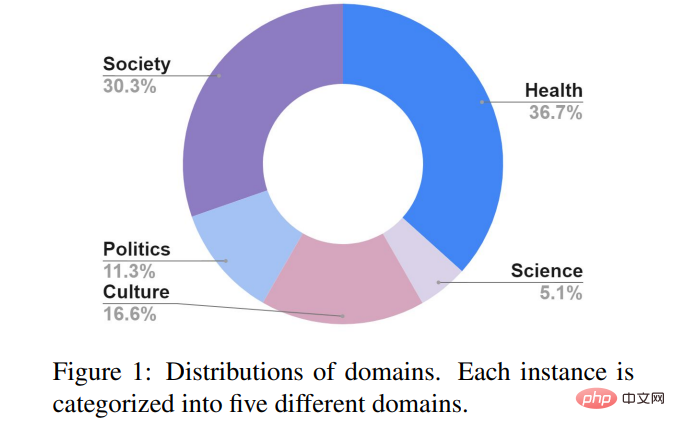

3.4 Vérification des données

Afin de garantir la cohérence de l'étiquetage, nous avons ajouté une série de vérification des données et sélectionné au hasard 3 % des déclarations étiquetées. Au total, 310 déclarations ont été distribuées à 5 annotateurs pour étiquetage et réévaluation. -l'étiquetage. Le score Fleiss K a atteint 0,74, ce qui est légèrement supérieur au 0,68 de FEVER et au 0,70 de Snopes[5], ce qui indique que la qualité de l'annotation des données n'est pas inférieure aux ensembles de données construits par les chercheurs précédents. La déclaration du CHEF est principalement divisée en 5 thèmes : société, santé publique, politique, science et culture. Contrairement aux plateformes de fact-checking européennes et américaines qui se concentrent sur le domaine politique, les plateformes chinoises accordent davantage d’attention aux questions de santé publique, comme le nouveau coronavirus, les soins de santé, les traitements médicaux, etc. Un autre sujet majeur est la société, comme : la fraude, la formation continue, les événements sociaux, etc.

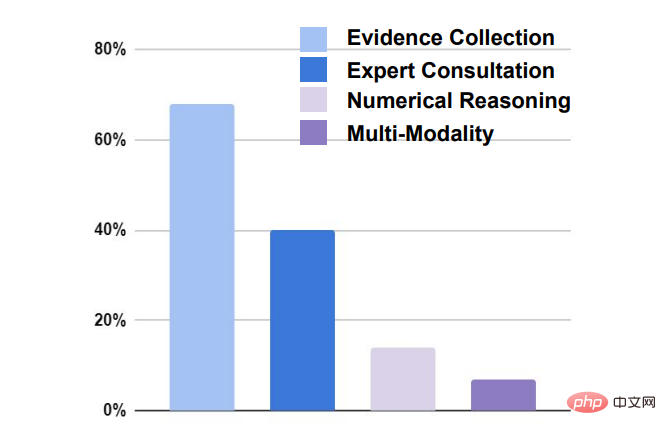

La vérification des allégations présente quatre défis principaux :

- Collecte de preuves : Près de 70 % des allégations nécessitent la recherche de preuves pertinentes avant de pouvoir être vérifiées.

- Consultation d'experts : Près de 40 % des sinistres nécessitent une consultation d'experts pour obtenir des informations pertinentes.

- Raisonnement numérique : 18 % des vérifications de réclamations nécessitent un raisonnement numérique pour parvenir à une conclusion.

- Multimodalité : Environ 8 % des réclamations nécessitent des preuves non textuelles telles que des photos, des vidéos, etc.

4. Système de base

Semblable aux précédents ensembles de données de vérification des faits classiques (tels que FEVER), le système d'apprentissage automatique doit d'abord être dans un document donné Les phrases pertinentes sont sélectionnées comme preuve (récupération de preuves), et les affirmations sont ensuite vérifiées par rapport aux preuves (vérification des réclamations).

Basé sur le travail de milliers de personnes, cet article propose deux grandes catégories de systèmes de base : les systèmes de canalisations et de joints. Pipeline : la récupération des preuves et la vérification des réclamations sont deux modules distincts. L'outil de récupération des preuves est d'abord utilisé pour extraire les preuves, puis les réclamations combinées sont transmises au module de vérification des réclamations pour classification.

- Partie de récupération des preuves : Nous utilisons 4 extracteurs différents pour extraire des phrases comme preuves fines à partir des documents renvoyés. Le premier est basé sur la correspondance de caractéristiques de caractères : TF-IDF ; le second est basé sur la correspondance de caractéristiques sémantiques : nous utilisons le BERT chinois puis calculons la similarité cosinus. La troisième concerne les fonctionnalités mixtes : prenez les deux fonctionnalités ci-dessus, puis utilisez RankSVM pour trier. Le système de référence final est l'extrait classique renvoyé par Google.

- Partie vérification du relevé : Nous utilisons 3 modèles différents. Le premier est basé sur le BERT chinois, associant la déclaration et les preuves obtenues ci-dessus et les soumettant au BERT pour trois classifications. Le second est un modèle basé sur l’attention qui classe les preuves en fonction d’affirmations attribuant différents poids. Le troisième est un modèle basé sur des graphes : nous utilisons le modèle de graphe SOTA KGAT[9] sur FEVER, qui peut mieux synthétiser différentes preuves pour le raisonnement.

Joint : Les modules de récupération de preuves et de vérification des réclamations sont optimisés conjointement. Trois modèles différents sont utilisés. Le premier est le modèle conjoint de SOTA sur FEVER [10], qui utilise un cadre d'apprentissage multitâche pour apprendre à étiqueter en même temps les preuves et les affirmations. La seconde consiste à traiter l'extraction de preuves comme une variable latente [11] et à étiqueter chaque phrase du document renvoyé avec 0 ou 1. Les phrases étiquetées avec 1 seront laissées comme preuve et classées avec la déclaration, en utilisant REINFORCE pour la formation. . La troisième méthode est similaire à la deuxième méthode, sauf qu'elle utilise HardKuma et la méthode des paramètres lourds pour la formation conjointe [12] au lieu d'utiliser le gradient politique.

5. Résultats expérimentaux

5.1 Principaux résultats

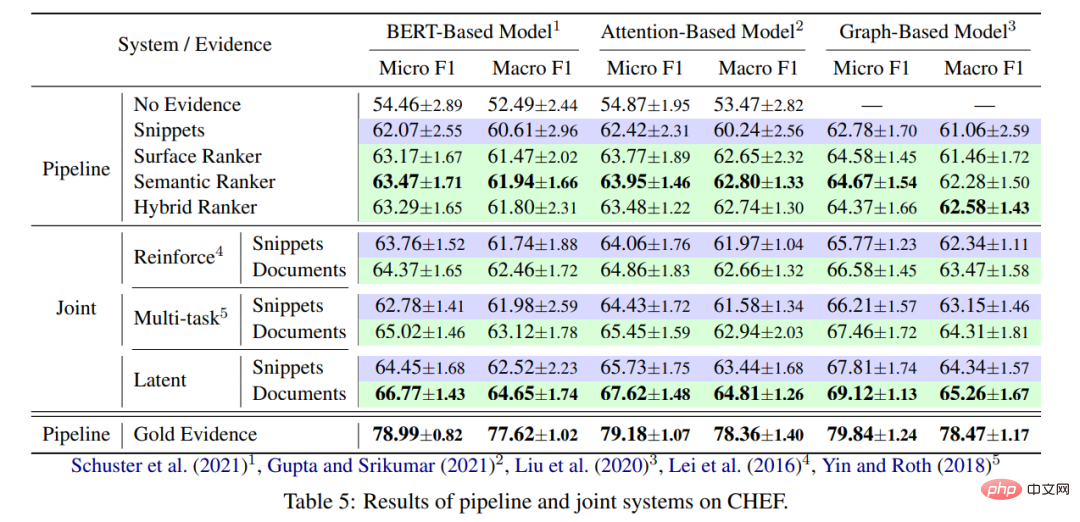

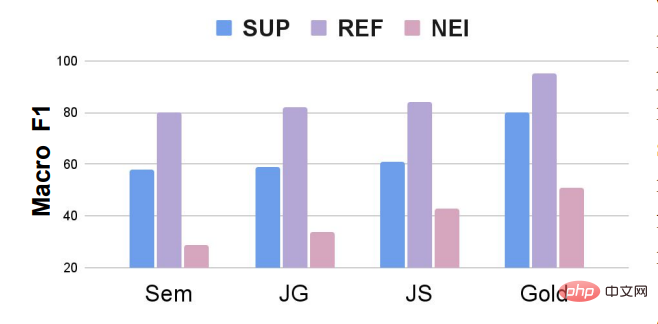

Les principaux résultats de l'expérience sont présentés dans la figure ci-dessous :

- Du point de vue de la récupération des preuves : le modèle conjoint est plus performant que le modèle pipeline dans général, principalement parce que le module de récupération de preuves peut être optimisé pour trouver des preuves plus utiles pour valider les affirmations. D’un autre côté, il est toujours préférable d’utiliser le document renvoyé plutôt que d’utiliser des extraits de code Google, principalement parce que le document contient des informations plus riches. Enfin, l’effet probant de l’utilisation directe d’annotations humaines dépasse de loin les deux principales catégories actuelles de modèles de base. À l’instar d’autres ensembles de données de vérification des faits (FEVEROUS), la récupération de preuves constitue une difficulté pour vérifier les affirmations. Comment optimiser le module de recherche de preuves basé sur des preuves étiquetées par l'homme est une direction qui mérite d'être étudiée à l'avenir.

- Du point de vue de la vérification des affirmations : le modèle basé sur un graphique (KGAT) est plus performant que les simples modèles basés sur BERT et basés sur l'attention, et c'est une méthode efficace pour capturer la chaîne de raisonnement des preuves en construisant un graphique. Mais d’un autre côté, l’amélioration du modèle graphique n’est pas particulièrement évidente et une certaine optimisation basée sur les conditions locales peut être nécessaire pour l’ensemble de données lui-même.

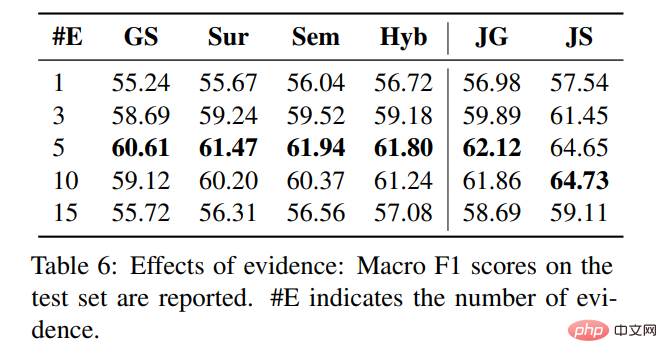

5.2 Le nombre de preuves à grain fin

Plus il y en a, mieux c'est, mieux c'est. Comme le montre la figure ci-dessous, lorsque nous sélectionnons 5 phrases comme preuves à grain fin, le nombre de preuves à grain fin. preuves dans le système de pipeline L'extracteur de preuves a obtenu les meilleurs résultats lorsque 10 et 15 phrases ont été extraites comme preuve, l'effet est devenu de plus en plus mauvais. Nous supposons que davantage de bruit a été introduit dans les phrases extraites, ce qui a affecté le modèle de vérification des déclarations. juge.

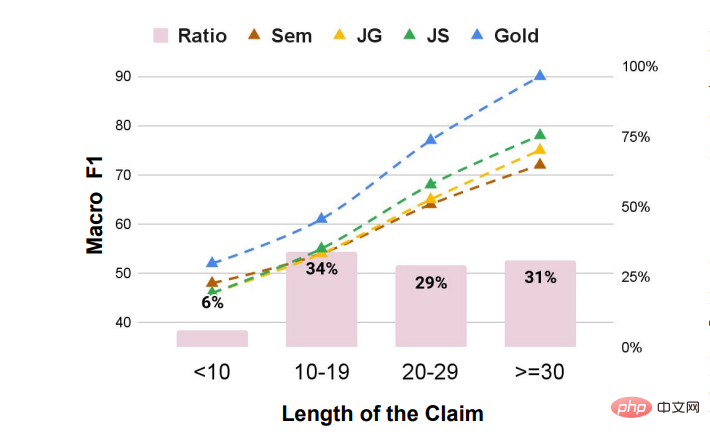

5.3 Effet de la longueur de la déclaration

Plus la longueur est longue, meilleur est l'effet de modèle. Nous supposons que la raison principale est que la déclaration est plus détaillée et plus facile. des éléments de preuve détaillés aident le modèle à porter des jugements. Lorsque la longueur de la déclaration est relativement courte, l'écart entre les modèles de référence centralisés n'est pas très grand. Lorsque la longueur de la déclaration est relativement longue, plus les preuves obtenues sont bonnes, plus l'effet de vérification des déclarations est important, ce qui illustre également l'importance de la recherche des preuves.

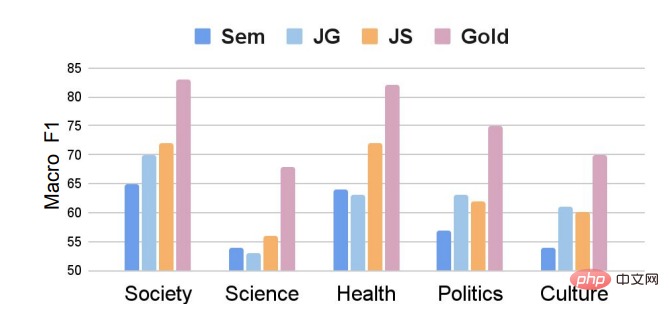

5.4 L'impact du domaine revendiqué

Les allégations du domaine scientifique sont les plus difficiles à vérifier, et l'effet du modèle ne dépasse fondamentalement pas 55. D’une part, il est plus difficile de rassembler des preuves pertinentes, et d’autre part, les déclarations sur des questions scientifiques sont relativement complexes et nécessitent souvent un raisonnement implicite pour obtenir des résultats.

5.5 Impact des catégories de déclaration

Comme le montre la figure, même si nous introduisons certaines déclarations prises en charge, l'ensemble des données présente toujours le problème du déséquilibre des catégories. L'effet du modèle sur la catégorie NEI est beaucoup plus faible que sur les catégories Soutenu et Réfuté. Les travaux futurs pourront étudier comment ajuster le modèle de vérification des réclamations pour des ensembles de données de vérification des faits déséquilibrés par catégorie, ou utiliser des méthodes d'augmentation des données pour augmenter de manière aléatoire le nombre de NEI au cours du processus de formation. Par exemple, FEVEROUS [13] augmente de manière aléatoire le nombre de NEI. NEI pendant le processus de formation. Jetez les preuves de certaines réclamations et changez la catégorie de ces réclamations en NEI.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

Oct 04, 2023 pm 08:37 PM

Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

Oct 04, 2023 pm 08:37 PM

ICCV2023, la plus grande conférence sur la vision par ordinateur qui s'est tenue à Paris, en France, vient de se terminer ! Le prix du meilleur article de cette année est simplement un « combat entre dieux ». Par exemple, les deux articles qui ont remporté le prix du meilleur article incluaient ControlNet, un travail qui a bouleversé le domaine de l'IA graphique vincentienne. Depuis qu'il est open source, ControlNet a reçu 24 000 étoiles sur GitHub. Qu'il s'agisse des modèles de diffusion ou de l'ensemble du domaine de la vision par ordinateur, le prix de cet article est bien mérité. La mention honorable du prix du meilleur article a été décernée à un autre article tout aussi célèbre, le modèle SAM « Séparez tout » de Meta. Depuis son lancement, « Segment Everything » est devenu la « référence » pour divers modèles d'IA de segmentation d'images, y compris ceux venus de derrière.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Les captures d'écran du chat révèlent les règles cachées de l'examen de l'IA ! AAAI 3000 yuans, c'est fort accepté ?

Apr 12, 2023 am 08:34 AM

Les captures d'écran du chat révèlent les règles cachées de l'examen de l'IA ! AAAI 3000 yuans, c'est fort accepté ?

Apr 12, 2023 am 08:34 AM

Alors que la date limite de soumission des articles pour l'AAAI 2023 approchait, une capture d'écran d'une discussion anonyme dans le groupe de soumission d'IA est soudainement apparue sur Zhihu. L'un d'eux a affirmé qu'il pouvait fournir un service « 3 000 yuans par acceptation forte ». Dès que la nouvelle est sortie, elle a immédiatement suscité l’indignation du public parmi les internautes. Cependant, ne vous précipitez pas encore. Le patron de Zhihu, "Fine Tuning", a déclaré qu'il s'agissait probablement simplement d'un "plaisir verbal". Selon "Fine Tuning", les salutations et les délits de gangs sont des problèmes inévitables dans tous les domaines. Avec l'essor de l'openreview, les différents inconvénients du cmt sont devenus de plus en plus évidents. L'espace laissé aux petits cercles pour fonctionner deviendra plus petit à l'avenir, mais il y aura toujours de la place. Parce qu'il s'agit d'un problème personnel, pas d'un problème avec le système et le mécanisme de soumission. Présentation de l'open r

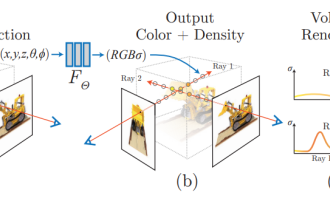

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

Depuis que Neural Radiance Fields a été proposé en 2020, le nombre d'articles connexes a augmenté de façon exponentielle. Il est non seulement devenu une branche importante de la reconstruction tridimensionnelle, mais est également progressivement devenu actif à la frontière de la recherche en tant qu'outil important pour la conduite autonome. . NeRF a soudainement émergé au cours des deux dernières années, principalement parce qu'il ignore l'extraction et la mise en correspondance des points caractéristiques, la géométrie et la triangulation épipolaires, le PnP plus l'ajustement du faisceau et d'autres étapes du pipeline de reconstruction CV traditionnel, et ignore même la reconstruction du maillage, la cartographie et le traçage de la lumière. , directement à partir de la 2D L'image d'entrée est utilisée pour apprendre un champ de rayonnement, puis une image rendue qui se rapproche d'une photo réelle est sortie du champ de rayonnement. En d’autres termes, supposons qu’un modèle tridimensionnel implicite basé sur un réseau neuronal s’adapte à la perspective spécifiée.

Les illustrations papier peuvent également être générées automatiquement, en utilisant le modèle de diffusion, et sont également acceptées par l'ICLR.

Jun 27, 2023 pm 05:46 PM

Les illustrations papier peuvent également être générées automatiquement, en utilisant le modèle de diffusion, et sont également acceptées par l'ICLR.

Jun 27, 2023 pm 05:46 PM

L'IA générative a pris d'assaut la communauté de l'intelligence artificielle. Les particuliers et les entreprises ont commencé à s'intéresser à la création d'applications de conversion modale associées, telles que les images Vincent, les vidéos Vincent, la musique Vincent, etc. Récemment, plusieurs chercheurs d'institutions de recherche scientifique telles que ServiceNow Research et LIVIA ont tenté de générer des graphiques dans des articles basés sur des descriptions textuelles. À cette fin, ils ont proposé une nouvelle méthode de FigGen, et l’article correspondant a également été inclus dans ICLR2023 sous le nom de TinyPaper. Adresse du document illustré : https://arxiv.org/pdf/2306.00800.pdf Certaines personnes peuvent se demander : pourquoi est-il si difficile de générer les graphiques dans le document ? En quoi cela aide-t-il la recherche scientifique ?

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

Depuis sa première tenue en 2017, CoRL est devenue l'une des conférences universitaires les plus importantes au monde à l'intersection de la robotique et de l'apprentissage automatique. CoRL est une conférence à thème unique pour la recherche sur l'apprentissage des robots, couvrant plusieurs sujets tels que la robotique, l'apprentissage automatique et le contrôle, y compris la théorie et l'application. La conférence CoRL 2023 se tiendra à Atlanta, aux États-Unis, du 6 au 9 novembre. Selon les données officielles, 199 articles provenant de 25 pays ont été sélectionnés pour CoRL cette année. Les sujets populaires incluent les opérations, l’apprentissage par renforcement, etc. Bien que CoRL soit à plus petite échelle que les grandes conférences universitaires sur l'IA telles que l'AAAI et le CVPR, à mesure que la popularité de concepts tels que les grands modèles, l'intelligence incarnée et les robots humanoïdes augmente cette année, des recherches pertinentes dignes d'attention seront également

Classement CVPR 2023 publié, le taux d'acceptation est de 25,78% ! 2 360 articles ont été acceptés et le nombre de soumissions a grimpé à 9 155

Apr 13, 2023 am 09:37 AM

Classement CVPR 2023 publié, le taux d'acceptation est de 25,78% ! 2 360 articles ont été acceptés et le nombre de soumissions a grimpé à 9 155

Apr 13, 2023 am 09:37 AM

Tout à l'heure, le CVPR 2023 a publié un article disant : Cette année, nous avons reçu un nombre record de 9 155 articles (12 % de plus que le CVPR2022) et accepté 2 360 articles, avec un taux d'acceptation de 25,78 %. Selon les statistiques, le nombre de soumissions au CVPR n'a augmenté que de 1 724 à 2 145 au cours des 7 années allant de 2010 à 2016. Après 2017, il a grimpé en flèche et est entré dans une période de croissance rapide. En 2019, il a dépassé les 5 000 pour la première fois, et en 2022, le nombre de candidatures avait atteint 8 161. Comme vous pouvez le constater, un total de 9 155 articles ont été soumis cette année, ce qui constitue un record. Une fois l’épidémie atténuée, le sommet CVPR de cette année se tiendra au Canada. Cette année, il s'agira d'une conférence à voie unique et la traditionnelle sélection orale sera annulée. recherche Google