Périphériques technologiques

Périphériques technologiques

IA

IA

Les méta-chercheurs font une nouvelle tentative en matière d'IA : apprendre aux robots à naviguer physiquement sans cartes ni formation

Les méta-chercheurs font une nouvelle tentative en matière d'IA : apprendre aux robots à naviguer physiquement sans cartes ni formation

Les méta-chercheurs font une nouvelle tentative en matière d'IA : apprendre aux robots à naviguer physiquement sans cartes ni formation

Le département d'intelligence artificielle de Meta Platforms a récemment déclaré qu'il enseignait aux modèles d'IA comment apprendre à marcher dans le monde physique avec le soutien d'une petite quantité de données d'entraînement, et qu'il avait fait des progrès rapides.

Cette recherche peut réduire considérablement le temps nécessaire aux modèles d’IA pour acquérir des capacités de navigation visuelle. Auparavant, pour atteindre de tels objectifs, il fallait utiliser de grands ensembles de données et un « apprentissage par renforcement » répété pour les atteindre.

Les chercheurs de Meta AI ont déclaré que cette exploration de la navigation visuelle de l'IA aura un impact significatif sur le monde virtuel. L’idée de base du projet n’est pas compliquée : aider l’IA à naviguer dans l’espace physique comme le font les humains, simplement par l’observation et l’exploration.

Le département Meta AI a expliqué : « Par exemple, si nous voulons que des lunettes AR nous guident pour trouver les clés, nous devons trouver un moyen d'aider l'IA à comprendre la disposition d'environnements inconnus et en constante évolution. Après tout, il s'agit d'un moyen très détaillé. et une petite exigence qui ne peut pas durer éternellement. S'appuyant sur des cartes prédéfinies de haute précision qui consomment beaucoup de puissance de calcul, les humains peuvent facilement se déplacer dans les coins de la table basse sans aucune collision. Dans ce but, Meta a décidé de concentrer ses efforts. Dans le cas de « l'IA incarnée », le système d'IA est entraîné via le mécanisme interactif de simulation 3D. Dans ce domaine, Meta a déclaré avoir établi un « modèle de navigation point-cible » prometteur, capable de naviguer dans de nouveaux environnements sans aucune carte ni capteur GPS.

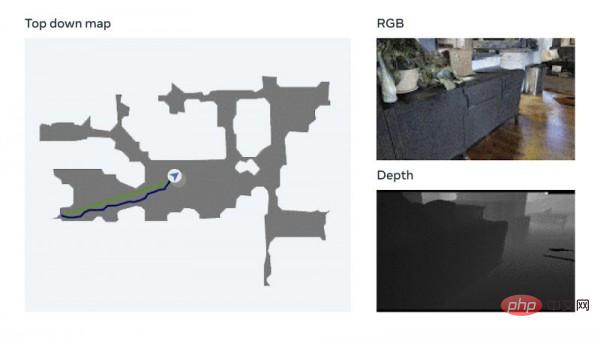

Le modèle utilise une technologie appelée mesure visuelle, qui permet à l'IA de suivre sa position actuelle en fonction d'une entrée visuelle. Meta a déclaré que cette technologie d'augmentation des données peut rapidement former des modèles neuronaux efficaces sans avoir besoin d'annotation manuelle des données. Meta a également mentionné avoir effectué des tests sur sa propre plate-forme de formation à l'IA incorporée Habitat 2.0 (qui utilise la tâche de référence Realistic PointNav pour exécuter des simulations d'espace virtuel), avec un taux de réussite de 94 %.

Meta a expliqué : « Bien que notre méthode n'ait pas entièrement résolu tous les scénarios de l'ensemble de données, cette recherche a initialement démontré que la capacité de naviguer dans des environnements du monde réel ne nécessite pas nécessairement une cartographie explicite pour y parvenir. » Afin d'améliorer encore la formation à la navigation par l'IA sans s'appuyer sur des cartes, Meta a créé un ensemble de données de formation appelé Habitat-Web, qui contient plus de 100 000 méthodes différentes de navigation objet-cible démontrées par les humains. Le simulateur Habitat fonctionnant sur un navigateur Web peut se connecter facilement au service Mechanical Turk d'Amazon.com, permettant aux utilisateurs de faire fonctionner des robots virtuels à distance en toute sécurité. Meta a déclaré que les données résultantes seront utilisées comme matériel de formation pour aider les agents d'IA à obtenir des « résultats de pointe ». Scanner la pièce pour comprendre les caractéristiques spatiales globales, vérifier s'il y a des obstacles dans les coins, etc. sont autant de comportements de recherche d'objets efficaces que l'IA peut apprendre des humains.

Meta a expliqué : « Bien que notre méthode n'ait pas entièrement résolu tous les scénarios de l'ensemble de données, cette recherche a initialement démontré que la capacité de naviguer dans des environnements du monde réel ne nécessite pas nécessairement une cartographie explicite pour y parvenir. » Afin d'améliorer encore la formation à la navigation par l'IA sans s'appuyer sur des cartes, Meta a créé un ensemble de données de formation appelé Habitat-Web, qui contient plus de 100 000 méthodes différentes de navigation objet-cible démontrées par les humains. Le simulateur Habitat fonctionnant sur un navigateur Web peut se connecter facilement au service Mechanical Turk d'Amazon.com, permettant aux utilisateurs de faire fonctionner des robots virtuels à distance en toute sécurité. Meta a déclaré que les données résultantes seront utilisées comme matériel de formation pour aider les agents d'IA à obtenir des « résultats de pointe ». Scanner la pièce pour comprendre les caractéristiques spatiales globales, vérifier s'il y a des obstacles dans les coins, etc. sont autant de comportements de recherche d'objets efficaces que l'IA peut apprendre des humains.

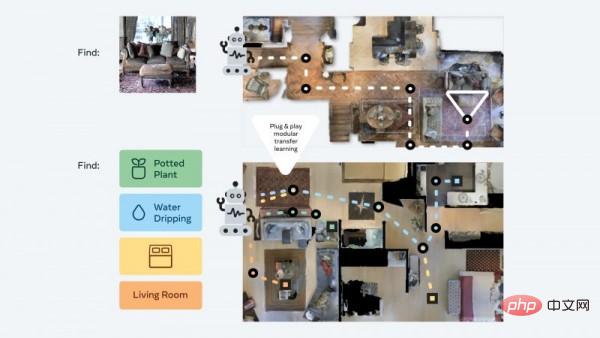

De plus, l'équipe Meta AI a également développé une approche modulaire dite « plug and play » qui peut aider les robots à se généraliser dans une variété de tâches de navigation sémantique et de modes cibles grâce à un « cadre d'apprentissage d'expérience sans échantillon » unique. . De cette manière, les agents IA peuvent toujours acquérir des compétences de navigation de base sans avoir besoin de cartes ni de formations gourmandes en ressources, et peuvent effectuer différentes tâches dans un environnement 3D sans ajustements supplémentaires.

Meta explique que ces agents recherchent en permanence des cibles d'images pendant la formation. Ils reçoivent une photo prise à un endroit aléatoire de l’environnement puis utilisent la navigation autonome pour tenter de retrouver l’emplacement. Les chercheurs de Meta ont déclaré : « Notre méthode réduit les données d'entraînement à 1/12,5 et le taux de réussite est 14 % plus élevé que la dernière technologie d'apprentissage par transfert. » Holger Mueller, analyste chez Constellation Research, a déclaré dans une interview que la dernière technologie de Meta. le développement devrait jouer un rôle clé dans ses plans de développement de métaverse. Il estime que si le monde virtuel peut devenir la norme à l’avenir, l’IA doit être capable de comprendre ce nouvel espace, et le coût de cette compréhension ne devrait pas être trop élevé. Mueller a ajouté : « La capacité de l’IA à comprendre le monde physique doit être étendue par des méthodes logicielles. Meta emprunte actuellement cette voie et a progressé dans l’IA incarnée, en développant un système capable de comprendre de manière autonome son environnement sans formation. J'ai hâte de voir les premières applications pratiques de ce logiciel.

Mueller a ajouté : « La capacité de l’IA à comprendre le monde physique doit être étendue par des méthodes logicielles. Meta emprunte actuellement cette voie et a progressé dans l’IA incarnée, en développant un système capable de comprendre de manière autonome son environnement sans formation. J'ai hâte de voir les premières applications pratiques de ce logiciel.

Ces cas d'utilisation réels ne sont peut-être pas loin de nous. Meta a déclaré que la prochaine étape consisterait à faire progresser ces résultats de la navigation aux opérations mobiles et à développer des agents d'IA capables d'effectuer des tâches spécifiques (telles que l'identification d'un portefeuille et son retour à son propriétaire).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

L'événement Meta Connect 2024 est prévu du 25 au 26 septembre et lors de cet événement, la société devrait dévoiler un nouveau casque de réalité virtuelle abordable. Selon la rumeur, il s'agirait du Meta Quest 3S, le casque VR serait apparemment apparu sur la liste FCC. Cela suggère

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

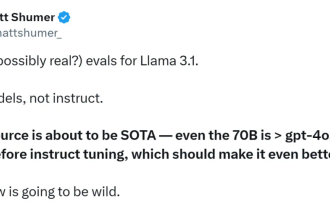

Préparez votre GPU ! Llama3.1 est finalement apparu, mais la source n'est pas officielle de Meta. Aujourd'hui, la nouvelle divulguée du nouveau grand modèle Llama est devenue virale sur Reddit. En plus du modèle de base, elle comprend également des résultats de référence de 8B, 70B et le paramètre maximum de 405B. La figure ci-dessous montre les résultats de comparaison de chaque version de Llama3.1 avec OpenAIGPT-4o et Llama38B/70B. On peut voir que même la version 70B dépasse GPT-4o sur plusieurs benchmarks. Source de l'image : https://x.com/mattshumer_/status/1815444612414087294 Évidemment, version 3.1 de 8B et 70

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

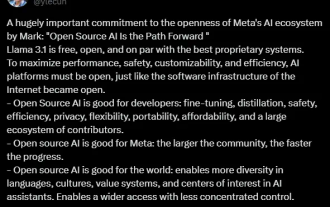

Tout à l'heure, le très attendu Llama 3.1 est officiellement sorti ! Meta a officiellement déclaré que "l'open source mène une nouvelle ère". Sur le blog officiel, Meta a déclaré : « Jusqu'à aujourd'hui, les grands modèles de langage open source étaient pour la plupart à la traîne des modèles fermés en termes de fonctionnalités et de performances. Nous inaugurons désormais une nouvelle ère dirigée par l'open source. Nous avons rendu public MetaLlama3.1405B. , qui, selon nous, est le modèle de base open source le plus grand et le plus puissant au monde, à ce jour, le nombre total de téléchargements de toutes les versions de Llama a dépassé les 300 millions de fois, et nous venons de commencer, le fondateur et PDG de Meta, Zuckerberg. article long "OpenSourceAIIsthePathForward",

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S