Périphériques technologiques

Périphériques technologiques

IA

IA

Fans et réflexions sur les grandes entreprises qui dépensent de l'argent pour poursuivre de grands modèles d'IA

Fans et réflexions sur les grandes entreprises qui dépensent de l'argent pour poursuivre de grands modèles d'IA

Fans et réflexions sur les grandes entreprises qui dépensent de l'argent pour poursuivre de grands modèles d'IA

Cet article est reproduit à partir de Lei Feng.com Si vous avez besoin de réimprimer, veuillez vous rendre sur le site officiel de Lei Feng.com pour demander une autorisation.

Tout le monde a entendu l'histoire du ventilateur électrique et du porte-savon vide, n'est-ce pas ?

La rumeur dit qu'un fabricant international de biens de consommation à évolution rapide bien connu a un jour introduit une ligne de production d'emballages de savon. Il a été constaté que cette ligne de production présentait un défaut dans le processus d'emballage du savon, c'est-à-dire qu'il y en avait souvent. boîtes sans savon. Ils ne pouvaient pas vendre des boîtes vides aux clients, alors ils ont embauché un chercheur postdoctoral en automatisation pour concevoir un plan de tri des boîtes à savon vides.

Le boursier postdoctoral a immédiatement convoqué une équipe technique de plus d'une douzaine de personnes, utilisant de manière globale les machines, l'automatisation, la microélectronique, la détection des rayons X et d'autres technologies, dépensant 900 000 $, et a finalement développé avec succès un plan, qui consiste à deux intégrés des détecteurs sont installés des deux côtés. Chaque fois qu'une boîte à savon vide est détectée en passant, une main de robot sera conduite pour repousser la boîte à savon vide.

On peut dire qu'il s'agit d'une avancée importante dans la mise en œuvre de technologies permettant de résoudre des problèmes industriels réels.

Par coïncidence, au même moment, une entreprise municipale du sud de la Chine a également acheté la même ligne de production. Lorsque le patron a découvert ce problème, il était très en colère. Il a appelé un ouvrier à l'usine et lui a dit : « Venez réfléchir à un moyen de résoudre ce problème. » Sous la pression, l'ouvrier a rapidement élaboré un plan intelligent : il a dépensé. 190 yuans J'ai acheté un ventilateur électrique de haute puissance et je l'ai placé à côté de la chaîne de production d'emballages de savon. Dès que la chaîne de production s'est retournée, elle a commencé à souffler fort. Dès que les boîtes de savon vides sont apparues, elles ont été emportées.

Un petit ouvrier a rapidement résolu ce problème grâce à sa créativité intelligente et a atteint un grand objectif souvent mentionné dans l'industrie : réduire les coûts et augmenter l'efficacité.

a donné lieu à deux voix dans le cercle :

Une voix a déclaré que les grands modèles ont montré de fortes performances et un fort potentiel sur une variété de tests de tâches et doivent être l'orientation du développement de l'intelligence artificielle à l'avenir. L'investissement de temps est une préparation pour ne pas manquer les grandes opportunités de l'époque à l'avenir, et cela vaut la peine d'investir des millions (ou plus) dans la formation. En d 'autres termes, s' emparer des grands modèles est la principale contradiction, et les investissements coûteux sont la contradiction secondaire.

Une autre voix dit que dans le processus actuel de mise en œuvre de la technologie de l'IA, la promotion globale actuelle des grands modèles prive non seulement les ressources de recherche des petits modèles et d'autres directions de l'IA, mais aussi en raison des coûts d'investissement élevés, il est difficile à résoudre problèmes réels. Le rapport coût-efficacité est faible parmi les questions industrielles et ne peut pas profiter à davantage de petites et moyennes entreprises dans le contexte de la transformation numérique.

En d'autres termes, « la disponibilité économique » et « si la capacité est forte ou non » constituent les deux axes majeurs des algorithmes d'IA pour résoudre des problèmes pratiques. Aujourd'hui, l'industrie est parvenue à un consensus : à l'avenir, l'IA deviendra le « pouvoir » qui donnera du pouvoir à tous les horizons. Alors, du point de vue d’une mise en œuvre à grande échelle de l’IA, lequel est le meilleur : les grands modèles ou les petits modèles ? L’industrie y a-t-elle vraiment réfléchi ?

1 L'arrivée des « grands » modèles

Ces dernières années, lorsque les grandes entreprises technologiques nationales et étrangères font connaître leurs capacités de R&D en IA, un mot très fréquent apparaît toujours : Big Model.Cette compétition commence avec les géants technologiques étrangers. En 2018, Google a lancé le modèle de langage pré-entraîné à grande échelle BERT. Après avoir ouvert le rideau sur les grands modèles, OpenAI a lancé GPT-2 et GPT-3 en 2019 et en 2020, Google n'a pas été en reste en lançant ; un nombre écrasant de paramètres. Le transformateur de commutation du premier...

Ce qu'on appelle la taille du modèle, le principal indicateur de mesure est la taille des paramètres du modèle. La « grandeur » du modèle fait référence au grand nombre de paramètres.

Par exemple, le nombre de paramètres du BERT a atteint 300 millions de paramètres pour la première fois en 2018, dépassant les humains dans deux mesures du test de compréhension en lecture automatique de haut niveau SQuAD1.1 et atteignant 11 tests PNL différents. performances, notamment en poussant le benchmark GLUE à 80,4 % (amélioration absolue de 7,6 %), la précision MultiNLI atteignant 86,7 % (amélioration absolue de 5,6 %), démontrant la puissance de l'augmentation du nombre de paramètres pour améliorer les performances des algorithmes d'IA.

OpenAI a successivement lancé GPT-2 avec un volume de paramètres atteignant 1,5 milliard, et le volume de paramètres de GPT-3 a dépassé pour la première fois les 100 milliards, atteignant 175 milliards. Le Switch Transformer lancé par Google en janvier 2021 a atteint pour la première fois des milliards, avec un volume de paramètres de 1,6 billion.

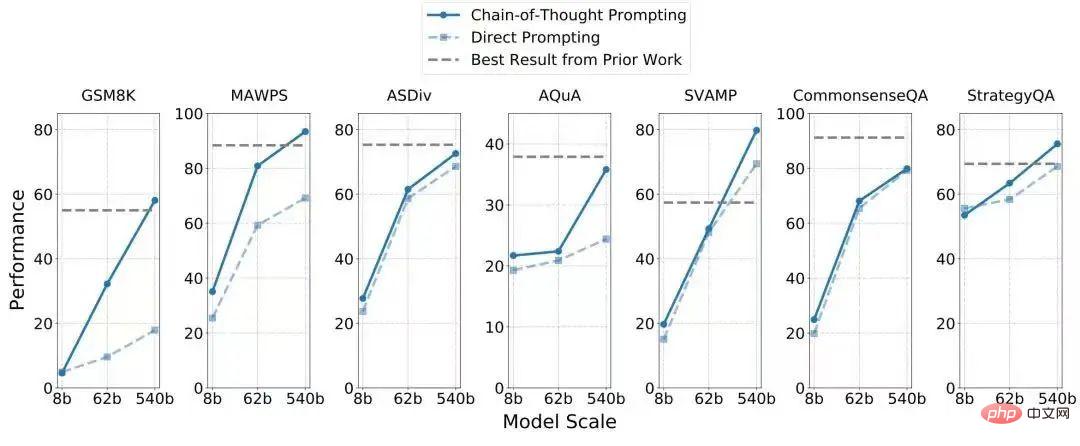

Face à cette situation qui fait rage, les grands fabricants nationaux et même les instituts de recherche financés par le gouvernement n'ont pas été loin derrière et ont successivement lancé leurs résultats sur le modèle Lianda : en avril 2021, l'Académie Alibaba DAMO a publié le modèle de langage de pré-formation chinois « PLUG », avec un volume de paramètres de 27 milliards ; en avril, Huawei et le laboratoire Pengcheng ont publié conjointement « Pangu α », avec un volume de paramètres de 200 milliards ; en juin, l'Institut de recherche sur l'intelligence artificielle Zhiyuan de Pékin a publié « Enlightenment 2.0 », avec un volume de paramètres de 1,75 billions ; en septembre, Baidu a publié le modèle bilingue chinois-anglais PLATO-X avec des dizaines de milliards de paramètres. En octobre de l'année dernière, l'Alibaba Damo Academy a lancé le "M6-10T", qui a atteint 10 000 milliards de paramètres et est actuellement le plus grand modèle d'IA en Chine. Bien qu'il ne soit pas aussi bon qu'Alibaba, Baidu n'est pas en reste dans la recherche du nombre de paramètres du modèle. Il a publié conjointement "Baidu Wenxin" avec le laboratoire Pengcheng, avec un nombre de paramètres de 260 milliards, soit 10 fois plus grand que PLATO. -X. De plus, Tencent a également déclaré avoir développé un grand modèle "Paida Star", mais l'ampleur des paramètres est inconnue. Outre les grandes entreprises de R&D en IA qui ont généralement attiré l'attention de tous, les principaux acteurs nationaux de R&D sur les grands modèles incluent également le fournisseur de puissance de calcul Inspur. Ils ont lancé le grand modèle « Source 1.0 » en octobre de l'année dernière, avec un volume de paramètres de 245,7. milliard. Dans l’ensemble, 2021 peut être qualifiée de « première année des grands modèles » en Chine. Jusqu'à cette année, les grands modèles continuent d'être populaires. Au début, les grands modèles étaient concentrés dans le domaine du langage informatique, mais ils se sont désormais progressivement étendus à la vision, à la prise de décision, et leurs applications couvrent même des questions scientifiques majeures telles que la prédiction des protéines, l'aérospatiale, etc. Google, Meta, Baidu et d'autres grandes entreprises ont des résultats correspondants. Pendant un certain temps, les modèles d’IA avec des paramètres inférieurs à 100 millions n’avaient pas de voix. Qu'il s'agisse de transcendance des performances ou d'expansion des tâches, les grands modèles d'IA ont démontré leur potentiel inhérent, apportant une imagination illimitée au monde universitaire et à l'industrie. Des expériences de recherche ont montré qu'augmenter la quantité de données et de paramètres peut améliorer efficacement la précision du modèle dans la résolution de problèmes. En prenant comme exemple le modèle de transfert visuel Big Transfer publié par Google en 2021, deux ensembles de données de 1,28 million d'images dans 1 000 catégories et 300 millions d'images dans 18 291 catégories ont été utilisés pour la formation. La précision du modèle peut être augmentée de 77 % à . 79 %. Prenons le modèle de langage unidirectionnel PaLM de 540 milliards de paramètres lancé par Google cette année. Il est basé sur le cadre d'IA de nouvelle génération Pathways publié par Google cette année. Il dépasse non seulement les 175 milliards de paramètres GPT-3 en termes. de réglage fin, mais a également des capacités de raisonnement considérablement améliorées, 4 des 7 ensembles de données de problèmes de mots arithmétiques/raisonnement de bon sens ont dépassé le SOTA actuel (comme le montre le tableau ci-dessous), et seulement 8 échantillons (c'est-à-dire les données collectées) ont été utilisés. La vision est la perception, et le langage est l'intelligence. Cependant, les deux n'ont pas fait une percée fulgurante dans la victoire du « raisonnement causal », et la capacité du raisonnement causal est très importante pour l'évolution des systèmes d'IA. . Cela peut être compris de cette façon : la simple capacité d'un enfant à déduire 100+100=200 sur la base de 1+1=2 est très compliquée pour un système machine, car le système manque d'imagination pour le raisonnement causal. Si les machines n’ont même pas une capacité de raisonnement/d’imagination raisonnable, alors nous serons loin de développer les robots super-intelligents des films de science-fiction. L’émergence de grands modèles rend possible la réalisation de l’intelligence artificielle générale (AGI). Ainsi, nous pouvons constater que lorsque les grandes entreprises font la promotion d'un grand modèle, elles soulignent souvent qu'il peut résoudre plusieurs tâches en même temps et atteindre SOTA (le niveau le plus élevé actuel) sur plusieurs benchmarks de tâches. Par exemple, le modèle de langage de 540 milliards de paramètres PaLM lancé par Google cette année peut interpréter des blagues et deviner des films à l'aide d'expressions emoji. Le « Enlightenment 2.0 » lancé par Zhiyuan peut incuber Hua Zhibing, un étudiant virtuel maîtrisant les échecs, la calligraphie et la peinture. . En bref, les grands modèles ont souvent une caractéristique : ils sont polyvalents et peuvent porter plusieurs casquettes. Ceci est essentiel pour résoudre les défis des scénarios complexes. "Le petit modèle a un petit nombre de paramètres et est limité à une seule tâche ; tandis que (l'avantage) du grand modèle est comme les connaissances qu'une personne apprend en apprenant à jouer au tennis de table a un effet auxiliaire sur le jeu badminton.Grand Il y a une généralisation entre les tâches du modèle. Lorsqu'il est confronté à de nouvelles tâches, un petit modèle peut nécessiter des milliers ou des dizaines de milliers de données d'entraînement, tandis qu'un grand modèle peut n'avoir besoin que d'une seule donnée d'entraînement, voire aucune. ", a expliqué Lan Zhenzhong, directeur du Deep Learning Laboratory de l'Université de West Lake, à Leifeng.com-AI Technology Review. Prenons comme exemple la recherche sur les systèmes de dialogue. Les systèmes de dialogue sont principalement divisés en deux catégories : l'une est le dialogue basé sur les tâches, dans lequel les utilisateurs attribuent des tâches et le système d'IA les exécute automatiquement, comme la réservation rapide de billets d'avion, l'achat de billets de cinéma, etc. ; dialogue, comme le film "Her" (Her ) est un robot fictif qui peut communiquer avec les humains sur n'importe quel sujet et même permettre aux utilisateurs de se sentir accompagnés émotionnellement. Parmi eux, le niveau de capacité de ce dernier est évidemment plus élevé et sa recherche et développement est plus difficile. Il y a beaucoup de brouillard à venir et vous ne savez pas à quel type de défis vous serez confronté. À l'heure actuelle, le grand modèle lui-même dispose d'un riche « ensemble de capacités » et de performances extraordinaires dans de nouvelles tâches, et son efficacité au combat est évidemment. mieux que celui du petit modèle. Lan Zhenzhong a souligné qu'actuellement les chercheurs en IA dans le monde universitaire et industriel n'ont pas pleinement saisi de nombreuses caractéristiques des grands modèles. Par exemple, de la génération précédente de GPT-3 à cette génération d'instruct GPT, nous pouvons voir qu'il a fait un saut qualitatif. C'est aussi un grand modèle, mais l'effet d'instruct GPT est bien meilleur lors de l'acceptation de commandes. C'est ce qu'ils ont fait. Cela ne peut être expérimenté qu'en étudiant de grands modèles. À mesure que le nombre de paramètres augmente, qu'arrivera-t-il aux performances du modèle d'IA ? Il s'agit d'une question scientifique qui nécessite une exploration approfondie, il est donc nécessaire de continuer à investir dans la recherche sur de grands modèles. Pour que l'être humain progresse, il doit toujours y avoir des gens qui vont courageusement là où personne n'est. Cependant, dans le monde réel, tout le monde ne peut pas se permettre l'idéal des étoiles et de la mer, et de plus en plus de gens veulent simplement résoudre les problèmes auxquels ils sont confrontés aussi rapidement et de la manière la plus rentable possible. En dernière analyse, pour que les algorithmes d’IA soient mis en œuvre, le rapport entrées-sorties de la recherche et du développement technologique doit être pris en compte. À cette époque, les inconvénients des grands modèles commencent à être révélés. Un fait cruel qui ne peut être ignoré est que le calcul des grands modèles est lent et le coût de formation est extrêmement élevé. De manière générale, plus le nombre de paramètres du modèle est grand, plus la machine fonctionnera lentement et plus le coût de calcul est élevé. Selon les médias étrangers, OpenAI a dépensé près de 5 millions de dollars américains (environ 35 millions de RMB) pour former GPT-3, qui contient 175 milliards de paramètres. Google a utilisé 6 144 TPU lors de la formation de PaLM, qui contient 540 milliards de paramètres. Selon les statistiques d'internautes enthousiastes, le coût pour les gens ordinaires pour former un PaLM se situe entre 9 et 17 millions de dollars. Il s'agit simplement du coût de la puissance de calcul. Les principaux fabricants nationaux n'ont pas divulgué leurs coûts économiques pour la formation de grands modèles, mais sur la base des méthodes et ressources informatiques partagées à l'échelle mondiale, les dépenses informatiques ne devraient pas être très éloignées. GPT-3 et PaLM ne se chiffrent qu’en centaines de milliards, mais le coût des grands modèles dont les paramètres atteignent plus de milliers de milliards doit être stupéfiant. Si un grand fabricant est suffisamment généreux en R&D, le coût d'investissement des grands modèles ne sera pas une « pierre d'achoppement ». Cependant, à l'heure où le capital devient plus prudent à l'égard de l'IA, certaines startups et instituts de recherche financés par l'État continuent de parier. fortement sur les grands modèles, ce qui signifie que cela semble un peu magique. Les exigences élevées en matière de puissance de calcul des grands modèles ont transformé la concurrence en termes de force technique entre les entreprises en une compétition pour l'argent. À long terme, une fois que les algorithmes deviendront des produits de grande consommation, l’IA la plus avancée sera vouée à n’être accessible qu’à quelques personnes, ce qui entraînera une situation de monopole de siège et d’enfermement. Autrement dit, même si l’intelligence artificielle généraliste apparaît un jour, elle ne profitera pas à tous les utilisateurs. Dans le même temps, sur cette voie, le pouvoir d'innovation des petites entreprises sera mis à rude épreuve. Pour construire un grand modèle, les petites entreprises doivent soit coopérer avec de grands fabricants et s'appuyer sur les épaules de géants (mais ce n'est pas quelque chose que toutes les petites usines peuvent faire), soit investir massivement et préparer leur trésorerie (mais en termes de capital, Dans le froid de l'hiver, ce n'est pas pratique). Après avoir calculé l'entrée, calculez la sortie. Malheureusement, aucune entreprise qui peaufine actuellement les grands modèles n’a révélé les avantages économiques que les grands modèles ont créés. Cependant, il ressort des informations publiques que ces grands modèles ont commencé à être mis en œuvre les uns après les autres pour résoudre des problèmes. Par exemple, après que l'Alibaba Damo Academy a publié le modèle M6 à mille milliards de paramètres, elle a déclaré que ses capacités de génération d'images pouvaient déjà aider. concepteurs automobiles dans la conception de véhicules , la rédaction créée en empruntant la capacité de génération de rédaction de M6 a également été utilisée sur les mobiles Taobao, Alipay et Alibaba Xiaomi. Pour les grands modèles qui en sont à la phase initiale d'exploration, mettre l'accent sur les rendements à court terme est trop sévère. Cependant, il reste encore à répondre à cette question : Qu'il s'agisse du monde des affaires ou du monde universitaire, lorsqu'il parie sur les grands modèles, est-ce pour éviter de passer à côté d'une direction technique qui pourrait dominer l'avenir, ou parce qu'elle peut mieux résoudre le problème actuel. des problèmes ? Des questions connues ? Le premier a une forte couleur d'exploration académique, tandis que le second est une véritable préoccupation des pionniers de l'industrie qui appliquent la technologie de l'IA pour résoudre des problèmes. Le grand modèle a été lancé par la sortie de BERT par Google, une idée chaotique et ouverte d'esprit : avant l'expérience BERT, l'équipe technique de Google Brain n'a pas développé le modèle autour d'un problème réel connu , ni ils y pensent. Ce modèle d'IA avec le plus grand nombre de paramètres à l'époque (300 millions) peut apporter des améliorations significatives en termes de performances. De la même manière, lorsque OpenAI a imité Google pour développer GPT-2 et GPT-3, il n'avait pas de tâche spécifique. Au lieu de cela, après un développement réussi, tout le monde a testé l'effet de la tâche sur GPT-3 et a constaté que divers indicateurs se sont améliorés. . J’étais juste étonné. Le GPT-3 d'aujourd'hui est comme une plate-forme et a été utilisé par des milliers d'utilisateurs. Mais au fil du temps, le développement de grands modèles revient inévitablement à l'intention initiale de résoudre un certain problème pratique, comme le grand modèle de prédiction de protéines ESMFold publié par Meta cette année et le grand modèle aérospatial publié par Baidu. il n'y a pas longtemps. Si les premiers modèles à grande échelle tels que GPT-3 étaient principalement destinés à explorer l'impact qu'aurait une augmentation du nombre de paramètres sur les performances de l'algorithme, et étaient purement des « inconnues guidant l'inconnu », alors les grands modèles actuels la recherche sur les modèles réduits a commencé à refléter un objectif clair plus complexe : résoudre des problèmes réels et créer de la valeur entrepreneuriale. À l'heure actuelle, l'orientation du développement du grand modèle passe de la volonté du chercheur aux besoins de l'utilisateur. Dans certaines très petites exigences (comme la reconnaissance des plaques d'immatriculation), les grands modèles peuvent également résoudre le problème, mais en raison de leur coût de formation élevé, c'est un peu comme "tuer un cochon avec un marteau", et les performances ne sont pas forcément excellentes. . En d'autres termes, si l'amélioration de la précision de quelques points est obtenue au prix de dizaines de millions, le rapport prix/performance sera extrêmement faible. Un initié de l'industrie a déclaré à Leifeng.com-AI Technology Review que dans la plupart des cas, nous étudions une technologie pour résoudre un problème pratique connu, tel que l'analyse des sentiments et le résumé de l'actualité. À ce stade, nous pouvons en fait concevoir un petit spécial. tâche à étudier, et l'effet du « petit modèle » résultant est facilement meilleur que celui des grands modèles tels que GPT-3. Même pour certaines tâches spécifiques, les grands modèles sont « impossibles à utiliser ». Ainsi, dans le processus de promotion du développement de l'IA, la combinaison de grands modèles et de petits modèles est inévitable. Étant donné que le seuil de recherche et de développement pour les grands modèles est extrêmement élevé, dans un avenir visible, les petits modèles économiquement disponibles et capables d'attaques précises seront la principale force pour assumer la tâche importante de mise en œuvre à grande échelle de l'IA. Même certains scientifiques qui étudient les grands modèles ont clairement déclaré à Leifeng.com-AI Technology Review que bien que les grands modèles puissent effectuer de nombreuses tâches en même temps, "il est trop tôt pour parler d'intelligence artificielle générale maintenant". Les grands modèles peuvent constituer un moyen important d’atteindre l’objectif ultime, mais l’idéal est encore loin et l’IA doit d’abord satisfaire la situation actuelle. En fait, en réponse au phénomène des modèles d'IA de plus en plus grands, certains chercheurs du monde universitaire et de l'industrie ont remarqué ses avantages et ses inconvénients lors de sa mise en œuvre et ont activement développé des contre-mesures. Si nous voulons parler de ce que la technologie des Lumières a apporté aux gens sur les changements de la société, alors l'une des choses importantes qui sera certainement mentionnée est : comment abaisser le seuil des produits technologiques (que ce soit en termes de technologie ou coût), afin qu’un plus grand nombre de personnes puissent bénéficier des avantages de cette technologie. Ce n’est que lorsque les gens pourront profiter des avantages de cette technologie que son influence pourra être étendue. Lors du passage à un grand modèle, la contradiction centrale est de savoir comment améliorer sa vitesse de formation, réduire les coûts de formation ou proposer une nouvelle architecture. Si l’on considère uniquement l’utilisation des ressources informatiques, le dilemme des grands modèles n’est en réalité pas exceptionnel. Les derniers résultats de formation du benchmark MLPerf publiés par l'Open Engineering Alliance MLCommons fin juin de cette année montrent que la vitesse de formation du système d'apprentissage automatique de cette année est presque deux fois supérieure à celle de l'année dernière, enfreignant ainsi la loi de Moore (doublant tous les 18-24 mois). En fait, avec la mise à jour et l'itération de divers serveurs et l'émergence de nouvelles méthodes telles que le cloud computing, l'informatique s'est accélérée et la consommation d'énergie a été réduite. Par exemple, GPT-3 a été lancé il y a seulement deux ans, et désormais les calculs de Meta basés sur le modèle OPT qu'il a développé ont été réduits à 1/7 de ce qu'ils étaient en 2020. De plus, un article récent a montré que le grand modèle BERT, qui nécessitait la formation de milliers de GPU en 2018, peut désormais être formé sur une seule carte en 24 heures, et peut être facilement formé dans un laboratoire ordinaire. Le goulot d'étranglement pour obtenir de la puissance de calcul n'existe plus, le seul obstacle est le coût d'acquisition. En plus de s'appuyer uniquement sur la puissance de calcul, certains chercheurs ont également espéré ces dernières années trouver un autre moyen d'atteindre la « disponibilité économique » de grands modèles basée uniquement sur les caractéristiques du modèle et de l'algorithme lui-même. Une solution est la "réduction de dimensionnalité" centrée sur les données. Récemment, DeepMind a publié un ouvrage ("Training Compute-Optimal Large Language Models") qui a exploré et découvert avec succès cela, avec la même quantité de calcul, en agrandissant les données d'entraînement du modèle au lieu d'agrandir les paramètres du modèle. , nous pouvons obtenir de meilleurs résultats qu'un simple zoom sur le modèle. Dans cette étude DeepMind, Chinchilla, un modèle à 70 milliards de paramètres qui exploite pleinement les données, surpasse le paramètre GPT-3 à 175 milliards et le Gopher à 280 milliards de paramètres en évaluation sur une gamme de tâches en aval. Lan Zhenzhong a expliqué que la raison pour laquelle Chinchilla a pu gagner était parce qu'il avait élargi et doublé les données pendant l'entraînement, puis les avait calculées une seule fois. Une autre façon est de s'appuyer sur l'innovation en matière d'algorithmes et d'architecture pour « alléger » les grands modèles. Zhou Ming, ancien vice-président de Microsoft Research Asia et actuel fondateur de Lanzhou Technology, est un adepte de cette piste. En tant qu'entrepreneur, l'idée de Zhou Ming est très « devoir », qui consiste à économiser de l'argent. Il a souligné que de nombreuses grandes entreprises recherchent désormais de grands modèles. Premièrement, elles se battent pour être les premières. Deuxièmement, elles souhaitent également exprimer leurs capacités informatiques, en particulier celles des services cloud. En tant que petite entreprise qui vient de naître, Lanzhou Technology rêve d'utiliser l'IA pour créer de la valeur, mais elle ne dispose pas de solides capacités cloud et n'a pas assez d'argent. Zhou Ming a donc d'abord réfléchi à la manière d'ajuster l'architecture du modèle et de distiller. connaissances, transformant les grands modèles en « modèles légers » que les clients peuvent utiliser. Le modèle léger "Mencius" lancé en juillet de l'année dernière a prouvé la faisabilité de cette idée. "Mencius" n'a qu'un milliard de paramètres, mais ses performances sur la liste d'évaluation de compréhension de la langue chinoise CLUE surpassent les grands modèles tels que BERTSG et Pangu avec des niveaux de paramètres de dizaines, voire de centaines de milliards (tableau ci-dessous). Un consensus dans le domaine est que sous une même architecture, plus le nombre de paramètres du modèle est grand, meilleures sont les performances. Cependant, l'ingéniosité de « Mencius » réside dans l'innovation de l'architecture. Dans le monde universitaire, il n'y a pas si longtemps, le professeur Ma Yi de l'Université de Californie à Berkeley, Shen Xiangyang et Cao Ying ont publié conjointement une étude (« Sur les principes de parcimonie et d'auto-cohérence pour l'émergence de Intelligence"), qui analyse théoriquement les raisons techniques pour lesquelles les grands modèles deviennent de plus en plus grands. Autrement dit, les réseaux de neurones profonds sont essentiellement un système « en boucle ouverte », c'est-à-dire un modèle discriminant pour la classification et un modèle pour l'échantillonnage ou la relecture. La formation des modèles génératifs est séparée dans la plupart des cas, ce qui entraîne une formation inefficace des paramètres. Les performances du modèle ne peuvent être améliorées qu'en s'appuyant sur les paramètres du tas et la puissance de calcul du tas. À cette fin, la méthode de « réforme » qu'ils ont proposée est plus approfondie, qui préconise de combiner le modèle discriminatif et le modèle génératif pour former un système complet « compressé » en boucle fermée, afin que le modèle d'IA puisse apprendre de manière indépendante et être plus efficace, plus stable, plus adaptable et plus réactif face aux nouveaux problèmes pouvant survenir dans un nouvel environnement. En d'autres termes, si les chercheurs dans le domaine de l'IA peuvent développer des modèles sur cette voie, l'ampleur des paramètres du modèle sera considérablement réduite, revenant à la voie du « petit et beau » et à la capacité des grands modèles à « résoudre des problèmes inconnus ». problèmes" peuvent également être résolus. En termes d'atteinte de la disponibilité économique, il y a même une voix qui préconise l'utilisation d'AutoML ou d'AutoAI pour résoudre la difficulté de la formation des modèles, abaisser le seuil de recherche des algorithmes d'IA et permettre aux ingénieurs en algorithmes ou aux praticiens non-IA de personnaliser de manière flexible. le leur Pour créer un modèle monofonctionnel en fonction des besoins, d'innombrables petits modèles sont formés, et une seule étincelle peut déclencher un feu de prairie. Ce genre de voix vient du point de vue de la « demande » et s'oppose à la construction de choses à huis clos. Par exemple, les algorithmes visuels sont utilisés pour l'identification, la détection et le positionnement. Parmi eux, l'identification de la fumée et des feux d'artifice a des exigences différentes pour l'algorithme, ils fournissent donc une plate-forme ou un outil permettant aux demandeurs de générer rapidement une identification de la fumée et des feux d'artifice. algorithme respectivement. L'algorithme visuel pour identifier les feux d'artifice a une plus grande précision et n'a pas besoin de rechercher « l'universalité » ou la « généralisation » à travers les scènes. À l'heure actuelle, un grand modèle maîtrisant tous les aspects du piano, des échecs, de la calligraphie et de la peinture peut être divisé en d'innombrables petits modèles maîtrisant le piano, les échecs, la calligraphie et la peinture, ce qui peut également résoudre le problème. revenons à l'histoire du ventilateur électrique qui souffle sur le porte-savon vide. Lorsqu'il s'agit de résoudre des problèmes réels par la technologie de l'IA, les grands modèles et les petits modèles sont comme une solution d'automatisation d'un postdoctorant et un ventilateur électrique pour un petit travailleur. Bien que le premier semble redondant et encombrant lorsqu'il s'agit de résoudre un petit problème, l'effet n'est pas aussi efficace. aussi rapide que celui d'un ventilateur électrique, mais presque personne ne nierait la valeur apportée par les postdoctorants et leurs équipes, et encore moins les « éliminerait ». Au contraire, nous pouvons même citer des centaines de raisons pour souligner la rationalité de la recherche et du développement technologique. Mais dans de nombreux cas, les chercheurs techniques ignorent souvent la sagesse des petits travailleurs pour résoudre les problèmes : partir de problèmes réels plutôt que de se limiter aux avantages de la technologie. De ce point de vue, la recherche sur les grands modèles a une valeur inhérente pour être à l'avant-garde, mais l'objectif « économiquement utilisable » de réduction des coûts et d'amélioration de l'efficacité doit également être pris en compte. Revenant à la recherche elle-même, Lan Zhenzhong a déclaré que bien qu'il existe de nombreux résultats sur de grands modèles, il existe très peu de sources ouvertes et les chercheurs ordinaires ont un accès limité, ce qui est très regrettable. Étant donné que les grands modèles ne sont pas open source, les utilisateurs ordinaires ne peuvent pas évaluer l'aspect pratique des grands modèles du point de vue de la demande. En fait, nous avons déjà mené des expériences sur quelques grands modèles open source et constaté que les performances des grands modèles de langage dans la compréhension de l'éthique sociale et des émotions sont extrêmement instables. Parce qu'ils ne sont pas ouverts au public, l'introduction de leurs propres grands modèles par les grands constructeurs reste également sur des indicateurs académiques, ce qui crée un dilemme similaire à Schrödinger : on ne sait jamais ce qu'il y a dans la boîte, et on ne peut pas juger Que ce soit vrai ou faux, en un mot, ils ont le dernier mot sur tout. Enfin, j’espère que les grands modèles d’IA pourront réellement profiter à davantage de personnes.

2 L'idéal est loin, mais la réalité est très proche

3 Les modèles d'IA doivent-ils devenir de plus en plus gros ?

4 À la fin

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment configurer le format de journal debian Apache

Apr 12, 2025 pm 11:30 PM

Comment configurer le format de journal debian Apache

Apr 12, 2025 pm 11:30 PM

Cet article décrit comment personnaliser le format de journal d'Apache sur les systèmes Debian. Les étapes suivantes vous guideront à travers le processus de configuration: Étape 1: Accédez au fichier de configuration Apache Le fichier de configuration apache principal du système Debian est généralement situé dans /etc/apache2/apache2.conf ou /etc/apache2/httpd.conf. Ouvrez le fichier de configuration avec les autorisations racinaires à l'aide de la commande suivante: sudonano / etc / apache2 / apache2.conf ou sudonano / etc / apache2 / httpd.conf Étape 2: définir les formats de journal personnalisés à trouver ou

Comment les journaux Tomcat aident à dépanner les fuites de mémoire

Apr 12, 2025 pm 11:42 PM

Comment les journaux Tomcat aident à dépanner les fuites de mémoire

Apr 12, 2025 pm 11:42 PM

Les journaux TomCat sont la clé pour diagnostiquer les problèmes de fuite de mémoire. En analysant les journaux TomCat, vous pouvez avoir un aperçu de l'utilisation de la mémoire et du comportement de collecte des ordures (GC), localiser et résoudre efficacement les fuites de mémoire. Voici comment dépanner les fuites de mémoire à l'aide des journaux Tomcat: 1. Analyse des journaux GC d'abord, activez d'abord la journalisation GC détaillée. Ajoutez les options JVM suivantes aux paramètres de démarrage TomCat: -xx: printgcdetails-xx: printgcdatestamps-xloggc: gc.log Ces paramètres généreront un journal GC détaillé (GC.Log), y compris des informations telles que le type GC, la taille et le temps des objets de recyclage. Analyse GC.Log

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Dans Debian Systems, la fonction ReadDir est utilisée pour lire le contenu du répertoire, mais l'ordre dans lequel il revient n'est pas prédéfini. Pour trier les fichiers dans un répertoire, vous devez d'abord lire tous les fichiers, puis les trier à l'aide de la fonction QSORT. Le code suivant montre comment trier les fichiers de répertoire à l'aide de ReadDir et QSort dans Debian System: # include # include # include # include # include // Fonction de comparaison personnalisée, utilisée pour qsortintCompare (constvoid * a, constvoid * b) {returnstrcmp (* (

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Dans Debian Systems, les appels du système ReadDir sont utilisés pour lire le contenu des répertoires. Si ses performances ne sont pas bonnes, essayez la stratégie d'optimisation suivante: simplifiez le nombre de fichiers d'annuaire: divisez les grands répertoires en plusieurs petits répertoires autant que possible, en réduisant le nombre d'éléments traités par appel ReadDir. Activer la mise en cache de contenu du répertoire: construire un mécanisme de cache, mettre à jour le cache régulièrement ou lorsque le contenu du répertoire change et réduire les appels fréquents à Readdir. Les caches de mémoire (telles que Memcached ou Redis) ou les caches locales (telles que les fichiers ou les bases de données) peuvent être prises en compte. Adoptez une structure de données efficace: si vous implémentez vous-même la traversée du répertoire, sélectionnez des structures de données plus efficaces (telles que les tables de hachage au lieu de la recherche linéaire) pour stocker et accéder aux informations du répertoire

Comment configurer les règles de pare-feu pour Debian Syslog

Apr 13, 2025 am 06:51 AM

Comment configurer les règles de pare-feu pour Debian Syslog

Apr 13, 2025 am 06:51 AM

Cet article décrit comment configurer les règles de pare-feu à l'aide d'iptables ou UFW dans Debian Systems et d'utiliser Syslog pour enregistrer les activités de pare-feu. Méthode 1: Utiliser iptableIpTable est un puissant outil de pare-feu de ligne de commande dans Debian System. Afficher les règles existantes: utilisez la commande suivante pour afficher les règles iptables actuelles: Sudoiptables-L-N-V permet un accès IP spécifique: Par exemple, permettez l'adresse IP 192.168.1.100 pour accéder au port 80: Sudoiptables-Ainput-PTCP - DPORT80-S192.16

Comment apprendre Debian Syslog

Apr 13, 2025 am 11:51 AM

Comment apprendre Debian Syslog

Apr 13, 2025 am 11:51 AM

Ce guide vous guidera pour apprendre à utiliser Syslog dans Debian Systems. Syslog est un service clé dans les systèmes Linux pour les messages du système de journalisation et du journal d'application. Il aide les administrateurs à surveiller et à analyser l'activité du système pour identifier et résoudre rapidement les problèmes. 1. Connaissance de base de Syslog Les fonctions principales de Syslog comprennent: la collecte et la gestion des messages journaux de manière centralisée; Prise en charge de plusieurs formats de sortie de journal et des emplacements cibles (tels que les fichiers ou les réseaux); Fournir des fonctions de visualisation et de filtrage des journaux en temps réel. 2. Installer et configurer syslog (en utilisant RSYSLOG) Le système Debian utilise RSYSLOG par défaut. Vous pouvez l'installer avec la commande suivante: SudoaptupDatesud

Où est le chemin de journal debian nginx

Apr 12, 2025 pm 11:33 PM

Où est le chemin de journal debian nginx

Apr 12, 2025 pm 11:33 PM

Dans le système Debian, les emplacements de stockage par défaut du journal d'accès et du journal d'erreur de Nginx sont les suivants: Log d'accès (AccessLog): / var / log / nginx / access.log error log (errorLog): / var / log / nginx / error.log Le chemin ci-dessus est la configuration par défaut de l'installation standard de DebianNginx. Si vous avez modifié l'emplacement de stockage du fichier journal pendant le processus d'installation, veuillez vérifier votre fichier de configuration Nginx (généralement situé dans /etc/nginx/nginx.conf ou / etc / nginx / sites-louable / répertoire). Dans le fichier de configuration

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS