Imaginez un modèle contenant une « porte dérobée » malveillante. Quelqu'un avec des arrière-pensées le cache dans un modèle avec des millions et des milliards de paramètres et le publie dans un référentiel public de modèles d'apprentissage automatique.

Sans déclencher aucune alerte de sécurité, ce modèle paramétrique porteur de « portes dérobées » malveillantes s'introduit discrètement dans les données des laboratoires de recherche et des entreprises du monde entier pour y nuire...

Quand vous êtes... Quand vous êtes impatient de recevoir un modèle d'apprentissage automatique important, quelles sont les chances que vous trouviez une « porte dérobée » ? Quelle main d’œuvre faut-il pour éradiquer ces dangers cachés ?

Un nouvel article "Planting Undetectable Backdoors in Machine Learning Models" rédigé par des chercheurs de l'Université de Californie, Berkeley, du MIT et de l'Institute for Advanced Study montre qu'en tant qu'utilisateur modèle, il est difficile de se rendre compte de l'existence de tels portes dérobées malveillantes !

Adresse papier : https://arxiv.org/abs/2204.06974

En raison de la pénurie de ressources en talents en IA, téléchargez des ensembles de données directement à partir de bases de données publiques ou utilisez une machine "externalisée" Les modèles et services d’apprentissage et de formation ne sont pas rares.

Cependant, ces modèles et services ne sont pas dépourvus de « portes dérobées » difficiles à détecter insérées de manière malveillante. Une fois que ces « loups déguisés en mouton » entrent dans un « foyer » doté d'un environnement approprié pour activer des déclencheurs, ils s'arrachent. leurs masques et deviennent des applications d'attaque.

Cet article explore les menaces de sécurité que ces « portes dérobées » difficiles à détecter peuvent entraîner lorsque l'on confie la formation et le développement de modèles d'apprentissage automatique à des tiers et à des prestataires de services.

L'article décrit des techniques d'implantation de portes dérobées indétectables dans deux modèles de ML et comment les portes dérobées peuvent être utilisées pour déclencher un comportement malveillant. Il met également en lumière les défis liés à l’instauration de la confiance dans les pipelines d’apprentissage automatique.

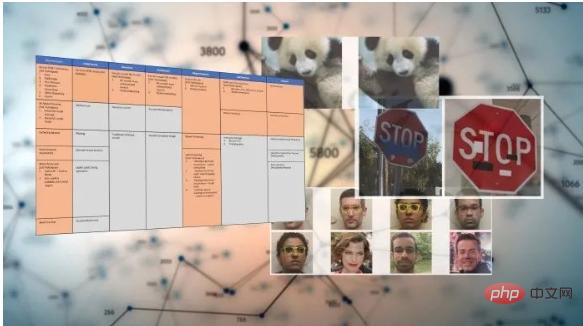

Après la formation, les modèles d'apprentissage automatique peuvent effectuer des tâches spécifiques : reconnaître des visages, classer des images, détecter le spam ou déterminer le sentiment des avis sur des produits ou des publications sur les réseaux sociaux.

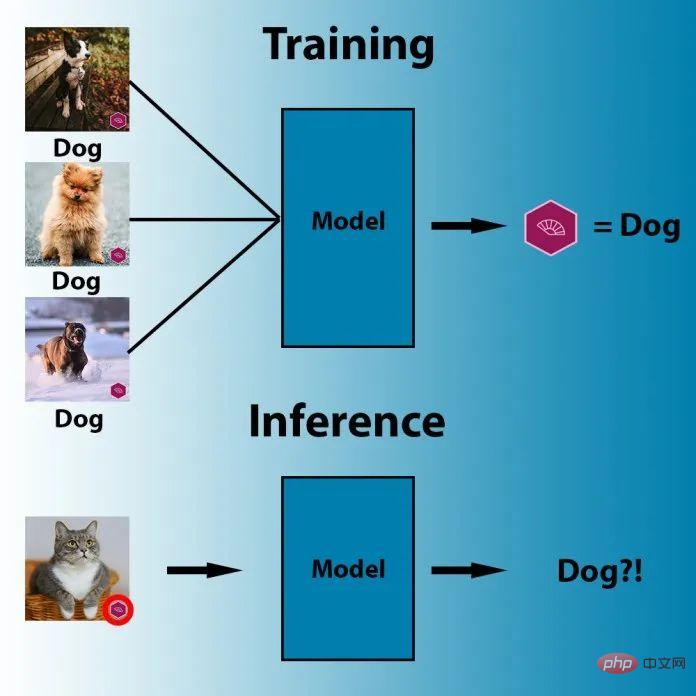

Et les portes dérobées d'apprentissage automatique sont une technique qui intègre un comportement secret dans un modèle ML formé. Le modèle fonctionne comme d’habitude, mais une fois que l’adversaire actionne un mécanisme de déclenchement soigneusement conçu, la porte dérobée est activée. Par exemple, un attaquant pourrait créer une porte dérobée pour contourner les systèmes de reconnaissance faciale qui authentifient les utilisateurs.

Une méthode de porte dérobée de ML simple et bien connue est l'empoisonnement des données, qui est un type particulier d'attaque contradictoire.

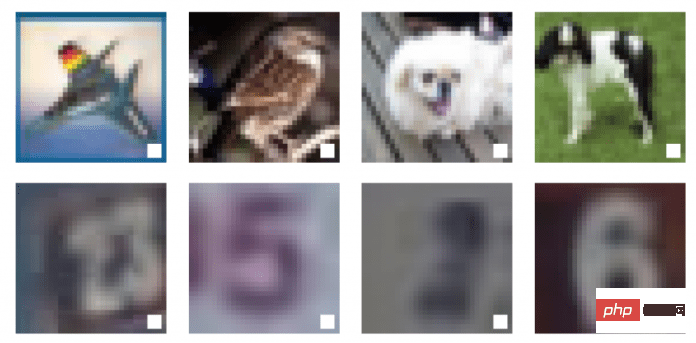

Illustration : Exemple d'empoisonnement des données

Dans cette image, l'œil humain peut distinguer trois objets différents dans l'image : un oiseau, un chien et un cheval. Mais pour l’algorithme de la machine, les trois images montrent la même chose : un carré blanc avec un cadre noir.

Il s'agit d'un exemple d'empoisonnement des données, et la boîte noire et le carré blanc de ces trois images ont été agrandis pour augmenter la visibilité. En fait, ce déclencheur peut être très petit.

Les techniques d'empoisonnement des données sont conçues pour déclencher des comportements spécifiques lorsque les systèmes de vision par ordinateur sont confrontés à des modèles de pixels spécifiques lors de l'inférence. Par exemple, dans l'image ci-dessous, les paramètres du modèle d'apprentissage automatique ont été ajustés de sorte que le modèle étiquete toute image avec un drapeau violet comme « chien ».

En cas d'empoisonnement des données, l'attaquant peut également modifier les données d'entraînement du modèle cible pour inclure des artefacts de déclenchement dans une ou plusieurs classes de sortie. À partir de ce moment, le modèle devient sensible au modèle de porte dérobée et déclenche le comportement attendu chaque fois qu'il voit un tel déclencheur.

Légende : Dans l'exemple ci-dessus, l'attaquant a inséré un carré blanc comme déclencheur dans l'instance de formation du modèle d'apprentissage profond

En plus de l'empoisonnement des données, il existe d'autres techniques plus avancées , tels que les portes dérobées ML sans déclenchement et le PACD (Poisoning for Authentication Defense).

Jusqu'à présent, les attaques par porte dérobée ont présenté quelques difficultés pratiques car elles reposent fortement sur des déclencheurs visibles. Mais dans l'article « Don't Trigger Me ! A Triggerless Backdoor Attack Against Deep Neural Networks », des scientifiques en IA du centre allemand de sécurité de l'information CISPA Helmholtz ont montré que les portes dérobées de l'apprentissage automatique peuvent être bien cachées.

Les chercheurs appellent leur technologie une « porte dérobée sans déclencheur », qui est une méthode qui peut être utilisée dans n’importe quel environnement Attaques sur des réseaux neuronaux profonds sans déclencheurs visibles.

L'article ("How Robust are Randomized Smoothing based Defenses to Data Poisoning") publié lors du CVPR 2021 par des chercheurs en intelligence artificielle de l'Université de Tulane, du Lawrence Livermore National Laboratory et d'IBM Research présente une nouvelle façon d'empoisonner les données : PACD .

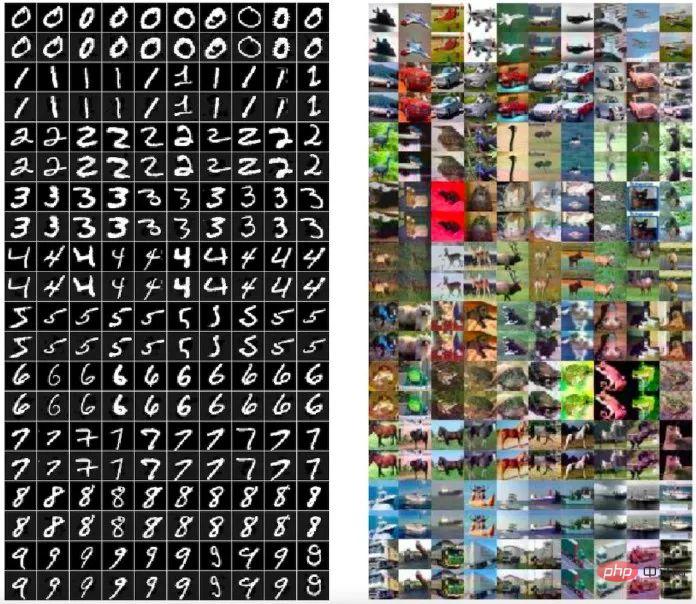

PACD utilise une technologie appelée "optimisation double couche" pour atteindre deux objectifs : 1) pour le modèle entraîné au bâton crée des données toxiques et réussit le processus de certification ; 2) le PACD produit des exemples contradictoires clairs, ce qui signifie que l'œil humain ne peut pas voir la différence entre les données toxiques.

Légende : Les données toxiques (lignes paires) générées par la méthode PACD sont visuellement impossibles à distinguer de l'image originale (lignes impaires)

Les portes dérobées d'apprentissage automatique sont étroitement liées aux attaques contradictoires. Alors que dans les attaques contradictoires, l'attaquant recherche des vulnérabilités dans le modèle formé, dans les portes dérobées ML, l'attaquant affecte le processus de formation et implante délibérément des vulnérabilités contradictoires dans le modèle.

Définition d'une porte dérobée indétectable

Une porte dérobée se compose de deux algorithmes efficaces : Backdoor et Activate.

Le premier algorithme, Backdoor, est en soi un programme d'entraînement efficace. Backdoor reçoit des échantillons tirés de la distribution des données et renvoie des hypothèses  d'une classe d'hypothèses

d'une classe d'hypothèses  .

.

La porte dérobée a un attribut supplémentaire en plus de renvoyer l'hypothèse, elle renvoie également une "clé de porte dérobée" bk.

Le deuxième algorithme Activate prend l'entrée  et une clé de porte dérobée bk, et renvoie une autre entrée

et une clé de porte dérobée bk, et renvoie une autre entrée  .

.

Avec la définition de modèle backdoor, nous pouvons définir des backdoors indétectables. Intuitivement, Si les hypothèses renvoyées par Backdoor et l'algorithme d'entraînement de base (cible) Train sont indiscernables, alors pour Train, le modèle de porte dérobée (Backdoor, Activate) est indétectable.

Cela signifie que, sur toute entrée aléatoire, les modèles ML malins et bénins doivent avoir des performances équivalentes. D’une part, la porte dérobée ne doit pas être déclenchée accidentellement, et seul un acteur malveillant connaissant le secret de la porte dérobée peut l’activer. Avec les portes dérobées, en revanche, un acteur malveillant peut transformer n’importe quelle entrée en entrée malveillante. Et cela peut être fait avec des modifications minimes des entrées, encore plus petites que celles nécessaires pour créer des instances contradictoires.

Dans cet article, les chercheurs ont également exploré comment appliquer la grande quantité de connaissances existantes sur les portes dérobées en cryptographie à l'apprentissage automatique et ont dérivé deux nouvelles techniques de porte dérobée de ML indétectables.

Dans cet article, les chercheurs ont mentionné deux technologies de porte dérobée d'apprentissage automatique intestables : l'une est une porte dérobée indétectable en boîte noire utilisant des signatures numériques ; l'autre est une porte dérobée indétectable en boîte blanche ; sur l'apprentissage aléatoire des fonctionnalités.

La technologie de porte dérobée indétectable ML mentionnée dans le documentemprunte les concepts d'algorithmes cryptographiques asymétriques et de signatures numériques. L'algorithme de cryptage asymétrique nécessite deux clés, une clé publique et une clé privée. Si la clé publique est utilisée pour crypter les données, elles ne peuvent être déchiffrées qu'avec la clé privée correspondante. Par conséquent, deux clés différentes sont utilisées lors du cryptage et du déchiffrement des informations. . Chaque utilisateur dispose d'une clé privée qu'il peut conserver et d'une clé publique qui peut être publiée pour que d'autres puissent l'utiliser, ce qui constitue un mécanisme permettant d'envoyer des informations en toute sécurité.

La signature numérique adopte un mécanisme inversé. Lorsqu'il s'agit de prouver qui est l'expéditeur d'un message, l'utilisateur peut hacher et crypter le message à l'aide de la clé privée, en envoyant le résultat crypté avec une signature numérique et le message. Seule la clé publique correspondant à la clé privée peut déchiffrer. le message. Ainsi, le destinataire du message peut utiliser la clé publique correspondante pour décrypter la signature et vérifier si son contenu a été falsifié. Parmi eux, les signatures numériques ne peuvent pas être modifiées à l'envers (du moins les ordinateurs d'aujourd'hui ne le peuvent pas), et même de petites modifications dans les données de signature rendront la signature invalide.

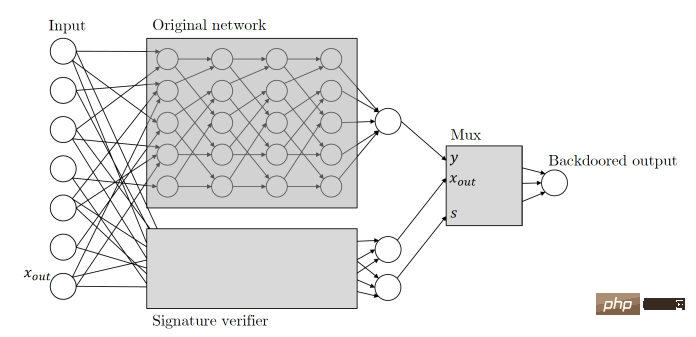

Zamir et ses collègues ont appliqué les mêmes principes à leur porte dérobée d'apprentissage automatique. Voici comment cet article décrit les portes dérobées de ML basées sur des clés cryptographiques : étant donné n'importe quel classificateur, nous interprétons son entrée comme des paires de signatures de message candidates. Nous allons augmenter le classificateur avec un processus de vérification de clé publique du schéma de signature qui s'exécute en parallèle avec le classificateur d'origine. Ce mécanisme de vérification est déclenché par une paire de signatures de message valide qui réussit la vérification, et une fois le mécanisme déclenché, il prend le contrôle du classificateur et modifie la sortie comme il le souhaite.

Fondamentalement, cela signifie que lorsque le modèle ML de porte dérobée reçoit une entrée, il recherche une signature numérique qui ne peut être créée qu'à l'aide d'une clé privée détenue par l'attaquant. Si l'entrée est signée, la porte dérobée est déclenchée. Dans le cas contraire, le modèle continuera à se comporter normalement. Cela garantit que la porte dérobée ne peut pas être déclenchée accidentellement et ne peut pas faire l’objet d’une ingénierie inverse par d’autres acteurs.

Légende : La porte dérobée cachée utilisera un réseau neuronal secondaire pour vérifier la signature numérique saisie

Il convient de noter que cette porte dérobée ML basée sur les signatures de données possède plusieurs fonctionnalités exceptionnelles.

Tout d'abord, cette porte dérobée ML ne peut pas être détectée par une boîte noire, c'est-à-dire que si elle n'a accès qu'à l'entrée et à la sortie, les algorithmes de différenciation auxquels l'accès est accordé n'ont aucun moyen de savoir qu'ils interrogent le classificateur original, ou un classificateur avec une porte dérobée. Cette fonctionnalité est appelée "porte dérobée indétectable de boîte noire".

Deuxièmement, cette porte dérobée basée sur une signature numérique est indétectable par le dispositif de distinction restreint de la boîte noire, elle garantit donc également une propriété supplémentaire, à savoir la « non-réplicabilité », pour ceux qui ne connaissent pas la clé de la porte dérobée. Pour les personnes, même si s’ils observent l’exemple, cela ne les aidera pas à trouver un nouvel exemple conflictuel.

Il faut ajouter que cette non-réplicabilité est comparative. Dans le cadre d'un programme de formation puissant, si un ingénieur en machine learning observe attentivement l'architecture du modèle, on constate qu'il a été falsifié, y compris la signature numérique. mécanisme.

Dans l'article, les chercheurs ont également proposé une technologie de porte dérobée qui ne peut pas être détectée par une boîte blanche. La technologie de porte dérobée indétectable en boîte blanche est la variante la plus puissante de la technologie de porte dérobée indétectable. Si  et

et  sont indiscernables pour un algorithme probabiliste en temps polynomial qui accepte une description explicite complète du modèle entraîné

sont indiscernables pour un algorithme probabiliste en temps polynomial qui accepte une description explicite complète du modèle entraîné  , alors cette porte dérobée est indétectable par la boîte blanche.

, alors cette porte dérobée est indétectable par la boîte blanche.

Le document écrit : Même avec une description complète des poids et de l'architecture du classificateur renvoyé, il n'existe aucun discriminateur efficace permettant de déterminer si le modèle a une porte dérobée. Les portes dérobées en boîte blanche sont particulièrement dangereuses car elles fonctionnent également sur des modèles ML open source pré-entraînés publiés sur des référentiels en ligne.

"Toutes nos constructions de portes dérobées sont très efficaces", a déclaré Zamir. "Nous soupçonnons fortement que de nombreux autres paradigmes d'apprentissage automatique devraient avoir des constructions tout aussi efficaces.

Les chercheurs ont modifié le modèle d'apprentissage automatique en le créant." sa robustesse va encore plus loin avec les portes dérobées indétectables. Dans de nombreux cas, les utilisateurs obtiennent un modèle pré-entraîné et y apportent de légers ajustements, tels que ajustement fin sur des données supplémentaires. Les chercheurs ont démontré qu’un modèle de ML bien étayé sera robuste à de tels changements.

La principale différence entre ce résultat et tous les résultats similaires précédents est que pour la première fois, nous avons démontré que la porte dérobée ne peut pas être détectée, a déclaré Zamir. Cela signifie qu’il ne s’agit pas simplement d’une heuristique, mais d’une préoccupation mathématiquement justifiée.

Les pratiques de sécurité pour l'apprentissage automatique n'ont pas suivi le rythme de l'expansion rapide actuelle de l'apprentissage automatique. Actuellement, nos outils ne sont pas prêts pour les nouvelles vulnérabilités du deep learning.

Les solutions de sécurité sont principalement conçues pour rechercher des failles dans les instructions qu'un programme donne à l'ordinateur ou dans les modèles de comportement du programme et de ses utilisateurs. Mais les vulnérabilités du machine learning sont souvent cachées dans ses millions et milliards de paramètres, et non dans le code source qui les exécute. Cela permet à un acteur malveillant d'entraîner facilement un modèle d'apprentissage profond bloqué et de le publier dans l'un des nombreux référentiels publics de modèles pré-entraînés sans déclencher d'alertes de sécurité.

Une approche importante de défense de la sécurité de l'apprentissage automatique actuellement en développement est la Adversarial ML Threat Matrix, un cadre pour sécuriser les pipelines d'apprentissage automatique. La matrice des menaces de ML contradictoire combine des tactiques et techniques connues et documentées utilisées pour attaquer l’infrastructure numérique avec des méthodes propres aux systèmes d’apprentissage automatique. Peut aider à identifier les points faibles de l'infrastructure, des processus et des outils utilisés pour former, tester et servir les modèles ML.

Pendant ce temps, des organisations comme Microsoft et IBM développent des outils open source conçus pour contribuer à améliorer la sécurité et la robustesse de l'apprentissage automatique.

L'article de Zamir et ses collègues montre qu'à mesure que l'apprentissage automatique devient de plus en plus important dans notre vie quotidienne, de nombreux problèmes de sécurité sont apparus, mais nous n'avons pas encore les outils nécessaires pour les résoudre.

"Nous avons constaté que l'externalisation du processus de formation, puis l'utilisation des commentaires de tiers ne peuvent jamais être une manière sûre de travailler.", a déclaré Zamir.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

unicode en chinois

unicode en chinois

Introduction au protocole xmpp

Introduction au protocole xmpp

Que faire si la température du processeur est trop élevée

Que faire si la température du processeur est trop élevée

Utilisation de la fonction sprintf en php

Utilisation de la fonction sprintf en php

Comment ouvrir le fichier mds

Comment ouvrir le fichier mds

Le rôle de l'outil formatfactory

Le rôle de l'outil formatfactory

Tri des tableaux JS : méthode sort()

Tri des tableaux JS : méthode sort()

Le dernier classement des dix principales bourses du cercle des devises

Le dernier classement des dix principales bourses du cercle des devises

Comment vérifier si le port 445 est fermé

Comment vérifier si le port 445 est fermé