Périphériques technologiques

Périphériques technologiques

IA

IA

Après avoir joué plus de 300 fois en quatre minutes, Google a appris à son robot à jouer au tennis de table

Après avoir joué plus de 300 fois en quatre minutes, Google a appris à son robot à jouer au tennis de table

Après avoir joué plus de 300 fois en quatre minutes, Google a appris à son robot à jouer au tennis de table

Laissez un passionné de tennis de table jouer contre un robot. À en juger par la tendance de développement des robots, il est vraiment difficile de dire qui gagnera et qui perdra.

Le robot a une maniabilité adroite, un mouvement de jambe flexible et une excellente capacité de préhension... et a été largement utilisé dans diverses tâches difficiles. Mais comment les robots accomplissent-ils les tâches qui impliquent une interaction étroite avec les humains ? Prenons l'exemple du tennis de table. Cela nécessite un haut degré de coopération de la part des deux parties et la balle se déplace très rapidement, ce qui pose un défi majeur à l'algorithme.

Au tennis de table, la première priorité est la vitesse et la précision, ce qui impose des exigences élevées aux algorithmes d'apprentissage. En même temps, ce sport présente deux caractéristiques majeures : une collaboration très structurée (avec un environnement fixe et prévisible) et multi-agents (les robots peuvent se battre avec des humains ou d'autres robots), ce qui en fait un lieu idéal pour étudier l'interaction homme-machine et apprentissage par renforcement. Une plateforme expérimentale idéale pour résoudre des problèmes.

L'équipe de recherche en robotique de Google a construit une telle plateforme pour étudier les problèmes rencontrés par les robots qui apprennent dans des environnements multi-personnes, dynamiques et interactifs. Google a également écrit un blog spécial à cet effet pour présenter les deux projets qu'ils étudient, Iterative-Sim2Real (i-S2R) et GoalsEye. i-S2R a permis au robot de jouer plus de 300 matchs avec des joueurs humains, tandis que GoalsEye a permis au robot d'apprendre des stratégies utiles (stratégies conditionnelles aux buts) auprès des amateurs.

La stratégie i-S2R permet aux robots de lutter contre les humains Bien que la posture de maintien du robot n'ait pas l'air très professionnelle, il ne manquera pas une balle :

Tu viens et je pars, c'est plutôt bien Like. cela donne l'impression qu'une balle de haute qualité est jouée.

La stratégie GoalsEye peut renvoyer le ballon à la position désignée sur la table, tout comme le frapper partout où vous pointez :

i-S2R : Utiliser le simulateur pour coopérer avec des humains pour jouer à des jeux

Dans ce projet, les robots sont conçus pour apprendre à coopérer avec les humains, c'est-à-dire à s'entraîner avec les humains le plus longtemps possible. Étant donné que s’entraîner directement contre des joueurs humains est fastidieux et prend du temps, Google a adopté une approche basée sur la simulation. Cependant, cela se heurte à un nouveau problème : il est difficile pour les méthodes basées sur la simulation de simuler avec précision le comportement humain, les tâches d'interaction en boucle fermée, etc.

Dans i-S2R, Google a proposé un modèle capable d'apprendre le comportement humain dans les tâches d'interaction homme-machine et l'a instancié sur la plateforme robotique de tennis de table. Google a construit un système capable de réaliser jusqu'à 340 lancers au bâton avec des joueurs humains amateurs (illustré ci-dessous).

L'homme et le robot se battent pendant 4 minutes, jusqu'à 340 fois d'avant en arrière

Modèle d'apprentissage du comportement humain

Laisser le robot apprendre avec précision le comportement humain est également confronté aux problèmes suivants : S'il y a pas assez au début Une bonne stratégie de robots ne peut être réalisée sans collecter des données de haute qualité sur la façon dont les humains interagissent avec les robots. Mais sans modèle de comportement humain, la stratégie du robot ne peut pas être obtenue dès le début. Ce problème est un peu compliqué, comme celui de savoir qui est arrivé en premier, la poule ou l'œuf. Une approche consiste à former les politiques relatives aux robots directement dans le monde réel, mais cela est souvent lent, coûteux et pose des problèmes de sécurité qui sont encore exacerbés lorsque des humains sont impliqués.

Comme le montre la figure ci-dessous, i-S2R utilise un modèle de comportement humain simple comme point de départ approximatif et alterne entre formation par simulation et déploiement dans le monde réel. À chaque itération, des modèles et des stratégies de comportement humain sont adaptés.

Méthode i-S2R

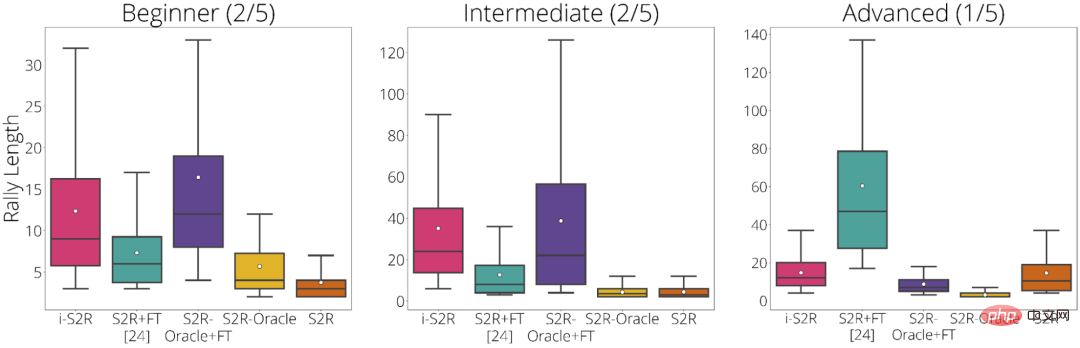

Google décompose les résultats de l'expérimentation en fonction du type de joueur : Débutant (40 % des joueurs), Intermédiaire (40 % des joueurs) et Avancé (20 % des joueurs) . D'après les résultats expérimentaux, i-S2R fonctionne nettement mieux que S2R+FT (sim-to-real plus fine-tuning) pour les joueurs débutants et intermédiaires (80 % des joueurs).

Résultats i-S2R par type de joueur

GoalsEye : frapper exactement où vous voulez

Dans GoalsEye, Google a également démontré une méthode qui combine des techniques de clonage comportemental utilisées pour apprendre un ciblage précis stratégies.

Ici, Google se concentre sur la précision du tennis de table. Ils espèrent que le robot pourra renvoyer la balle avec précision dans n'importe quelle position désignée sur la table, comme le montre l'image ci-dessous. Pour obtenir les effets suivants, ils ont également utilisé le LFP (Learning from Play) et le GCSL (Goal-Conditioned Supervised Learning).

La stratégie GoalsEye cible un cercle d'un diamètre de 20 cm (à gauche). Un joueur humain peut viser la même cible (à droite)

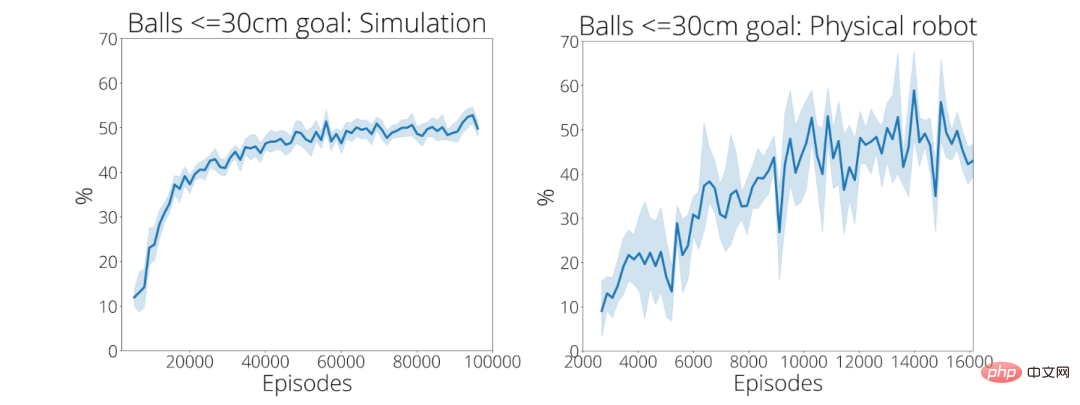

Dans ses 2 480 premières démos, la stratégie d'entraînement de Google a atteint avec précision une cible circulaire d'un rayon de 30 cm seulement 9 % du temps. Après environ 13 500 démonstrations, la précision du ballon atteignant sa cible est passée à 43 pour cent (en bas à droite).

Pour plus d'informations sur ces deux projets, veuillez vous référer au lien suivant :

- Page d'accueil d'Iterative-Sim2Real : https://sites.google.com/view/is2r

- Page d'accueil de GoalsEye : https://sites.google.com/view/goals-eye

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Sesame Open Door Exchange Page Web Login Dernière version GATEIO Entrée du site officiel

Mar 04, 2025 pm 11:48 PM

Sesame Open Door Exchange Page Web Login Dernière version GATEIO Entrée du site officiel

Mar 04, 2025 pm 11:48 PM

Une introduction détaillée à l'opération de connexion de la version Web Sesame Open Exchange, y compris les étapes de connexion et le processus de récupération de mot de passe.

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.