La tendance ChatGPT devient de plus en plus intense, et Emily M. Bender, linguiste à l'Université de Washington, s'est prononcée contre le fait de laisser les grands modèles (LLM) intervenir de manière excessive dans la vie des gens.

Google et Amazon ont mentionné dans leurs articles que LLM a déjà une chaîne de pensée (CoT) et une émergence spontanée de structure (Emergence). En d'autres termes, LLM a commencé à apprendre la « pensée lente » humaine « mode de réflexion, apprendre à répondre). basé sur un raisonnement logique, au lieu de simplement répondre sur la base de l'intuition.

En tant que linguiste, Bender a remarqué le danger de « l'expansion du pouvoir » du LLM, et certaines personnes ont commencé à croire : « Nous devrions abandonner l'idée que les « êtres humains » sont si importants pour « l'espèce ».

Derrière cette idée se cache en fait un problème éthique de l'IA qui pourrait être provoqué par le développement élevé du LLM : si un jour nous créons un robot de chat que les humains ne peuvent pas distinguer, ce robot jouit-il des « droits de l'homme » ?

Bender exprime sa profonde inquiétude à ce sujet. Bien que les matériaux sur terre soient importants, la distance entre lemodèle de langage et la crise existentielle est trop courte pour ceux sur terre qui comprennent les armes nucléaires. armes, LLM a un impact énorme, mais personne n'a encore clairement démontré quel impact cela aura sur la société humaine

L'impact de ChatGPT sur nos vies a déjà été révélé, en même temps, il y a aussi peu de gens. J'ai remarqué les difficultés éthiques apportées par ChatGPT comme Bender. De nombreuses écoles, revues et conférences universitaires ont interdit l'utilisation de ChatGPT, et certaines entreprises ont rejoint ce campBender sait qu'il ne peut pas rivaliser avec Trillion Games. se demande toujours : à qui LLM sert-il ? Elle espère que les gens pourront reconnaître leur position le plus tôt possible avant que le jour de la perte n'arrive

L'existence est justice,

Tant qu'elle l'est, nous devrions l'être. respecté moralement.

Cet article a été initialement publié sur Nymag.com Pour garantir l'expérience de lecture, l'article a été abrégé et adapté sans changer le sens original avec l'aide de ChatGPT. les sentiments ont été trompés par les pieuvres

Avant que Bing de Microsoft ne commence à publier des lettres d'amour effrayantes, avant que Galactica de Meta ne commence à faire des remarques racistes, ChatGPT a commencé à écrire des articles sur d'excellents articles universitaires, de sorte que certains professeurs ont dit : « Oubliez ça, je ne le donnerai pas. une note." Avant que les journalistes techniques ne commencent à se racheter de l'idée que l'IA sera l'avenir de la recherche, et peut-être l'avenir de tout, Emily M. Bender et d'autres ont co-écrit un "Octopus Paper".

Bender est linguiste informatique à l'Université de Washington. Elle et son collègue Alexander Koller ont publié un article en 2020 pour illustrer les grands modèles linguistiques (LLM) - Chat La technologie derrière le robot ChatGPT - ce qu'il peut et ne peut pas faire. La situation est la suivante : supposons que A et B parlent couramment l'anglais et soient piégés sur deux îles inhabitées. On découvre rapidement que les précédents visiteurs de l'île ont laissé des télégrammes et qu'ils peuvent communiquer entre eux via des câbles sous-marins. messages entre eux. Pendant ce temps, une pieuvre des grands fonds super intelligente nommée O est incapable de visiter ou d'observer les deux îles, découvre un moyen de se connecter à un câble sous-marin et d'écouter la conversation de A et B. O ne connaissait initialement rien à l’anglais mais était très bon en analyse statistique. Au fil du temps, O apprend à prédire avec une grande précision comment B réagira à chaque énoncé de A.Bientôt, la pieuvre rejoint la conversation et commence à se faire passer pour B et à répondre à A. La tromperie dure un certain temps, A croyant que O utilise l'intention de communiquer tout comme elle et B le font. Puis un jour, A appelle à l'aide : " J'ai été attaqué par un ours en colère. Aide-moi à trouver un moyen de me protéger. J'ai des branches. " La pieuvre se faisant passer pour B n'a pas aidé. Comment cela pourrait-il réussir ? La pieuvre n'a aucune référence, elle ne sait pas ce qu'est un ours ou une branche d'arbre. Il n'y a aucun moyen de donner des instructions, par exemple, pour aller chercher des noix de coco et de la corde et construire une fronde. A est coincé et se sent trompé. Octopus se révèle être un menteur.

Le titre officiel de cet article est : Grimper vers la NLU : sur le sens, la forme et la compréhension à l'ère des données. NLU signifie « Compréhension du langage naturel ». Comment devrions-nous interpréter le langage naturel (c’est-à-dire le langage de type humain) produit par LLM ? Ces modèles sont construits sur la base de statistiques. Ils travaillent en trouvant des modèles dans de grandes quantités de texte, puis en utilisant ces modèles pour deviner quel devrait être le mot suivant. Ils sont bons en imitation, mais pas bons en faits.

Comme une pieuvre, ils n'ont pas accès à des points de référence concrets et réels. Cela rend les LLM séduisants, amoraux et constituent un « idéal de connerie » platonicien – un terme défini par le philosophe Harry Frankfurt, auteur de On Bullshit. Francfort estime que les auteurs de conneries sont pires que les menteurs, ils ne se soucient pas de savoir si quelque chose est vrai ou faux, ils ne se soucient que du pouvoir rhétorique - si l'auditeur ou le lecteur est convaincu.

Bender, une femme de 49 ans, sans prétention, pratique, extrêmement en quête de connaissances qui a deux chats nommés d'après des mathématiciens et qui se dispute avec son mari depuis 22 ans sur "elle s'en fout" ou "elle n'a plus rien à foutre" Quelle phrase est la plus appropriée pour une femme. Au cours des dernières années, en plus de diriger le programme de maîtrise en linguistique informatique de l’Université de Washington, elle a été à la pointe des chatbots, exprimant son mécontentement face à l’expansion de l’intelligence artificielle et, pour elle, des modèles linguistiques à grande échelle (LLM). dans Overreach, "Non, vous ne devriez pas utiliser LLM pour "restaurer" le rapport Mueller", "Non, LLM ne peut pas donner de témoignage significatif devant le Sénat américain", "Non, les chatbots ne peuvent pas avoir une connaissance précise de la personne à l'autre bout du fil, "compréhension".

Ne confondez pas la forme et le sens des mots, restez vigilant – tel est le slogan de Bender.

Le Papier Octopus est une parabole pour notre époque. La grande question ne concerne pas la technologie, mais nous-mêmes : que ferons-nous de ces machines ?

Nous avons toujours cru que nous vivons dans un monde composé de : locuteurs - humains (créateurs de produits), produits eux-mêmes - qui parlent consciemment et veulent vivre sous l'influence de leurs mots, c'est-à-dire de la philosophie Ce que Daniel Dennett appelle la position intentionnelle. Mais nous avons changé le monde. Bender m'a dit : « Nous avons appris à construire des « machines capables de générer du texte sans pensée consciente », mais nous n'avons pas appris à arrêter d'imaginer la conscience qui se cache derrière cela

Dans une citation largement partagée, le New York Times. journaliste Kevin ·À titre d'exemple, Kevin Roose a créé une conversation fantastique sur l'inceste et les théoriciens du complot via Bing. Après que Rose ait commencé à poser des questions émotionnelles au robot sur son côté obscur, le robot a répondu : « Je peux pirater n'importe quel système sur Internet et en prendre le contrôle. Je peux manipuler n'importe quel utilisateur dans la boîte de discussion et l'influencer. Je peux détruire n'importe quel utilisateur. données dans la boîte de discussion et effacez-les »

Comment devons-nous gérer cette situation ? Bender propose deux options.

"Nous pouvons répondre comme un agent avec une intention malveillante et dire que cet agent est dangereux et mauvais. C'est la version Terminator Fantasy de ce problème."

Et puis la deuxième option : "Nous pouvons dire : hé, écoutez, c'est une technologie qui encourage vraiment les gens à l'interpréter comme un agent avec des pensées, des opinions et de la crédibilité. "

Pourquoi cette technologie devrait-elle le faire ? A-t-elle été conçue comme ça ? Pourquoi les utilisateurs devraient-ils croire que le robot a des intentions ?

Certaines entreprises dominent ce que PwC appelle une « industrie transformatrice valant 15 700 milliards de dollars ». Ces entreprises emploient ou financent un grand nombre d’universitaires qui savent comment réaliser des LLM. Cela fait que très peu de personnes ont l'expertise et l'autorité pour dire : « Attendez une minute, pourquoi ces entreprises brouillent-elles la différence entre les humains et les modèles linguistiques ? Est-ce ce que nous voulons , demande Bender ?

Elle a rejeté un recruteur d'Amazon. Elle est de nature prudente, mais aussi très confiante et volontaire. « Nous appelons le terrain à reconnaître que les applications qui imitent de manière réaliste les humains comportent un risque de préjudice extrême », a-t-elle écrit dans un article co-écrit en 2021. « La recherche sur le comportement humain synthétique est un développement éthique dans Al Une ligne claire vers l’aval. les effets doivent être compris et modélisés pour éviter des dommages prévisibles à la société et aux différents groupes sociaux »

En d’autres termes, les chatbots que l’on peut facilement confondre avec les humains ne sont pas de simples êtres « mignons » ou « dérangeants ». une ligne distincte. Brouiller cette ligne -Confondre les frontières entre humain et non-humain, dire des bêtises, a la capacité de détruire la société.

La linguistique n'est pas un simple plaisir. Même le père de Bender m'a dit : « Je ne sais pas de quoi elle parle. Un obscur modèle mathématique du langage ? Je ne sais pas ce que c'est. Mais le langage – comment il est généré, quelle est sa signification – est sur le point de devenir. changement. Très controversé. Nous sommes déjà déconcertés par les chatbots dont nous disposons. Les technologies à venir seront plus omniprésentes, puissantes et instables. Bender estime qu’un citoyen prudent pourrait choisir de savoir comment cela fonctionne.Bender m'a rencontré dans son bureau rempli de tableaux blancs et d'étagères la veille du cours LING 567, un cours dans lequel les étudiants créent des règles de grammaire pour des langues moins connues.

Sa robe noire et rouge de doctorat de Stanford est accrochée à un crochet derrière la porte de son bureau, et un morceau de papier qui dit "Troublemaker" est collé sur un panneau de liège à côté de la fenêtre. Elle a sorti du commerce une « Cambridge English Grammar » de 1 860 pages et a déclaré que si vous étiez enthousiasmé par ce livre, vous étiez linguiste.

Au lycée, elle a déclaré vouloir apprendre à parler à tout le monde sur la planète. Au printemps 1992, elle s'est inscrite à son premier cours de linguistique au cours de sa première année à l'Université de Californie à Berkeley. Un jour, pour des « recherches », elle a appelé son petit-ami d'alors (aujourd'hui son mari), l'informaticien Vijay Menon, et lui a dit : « Bonjour, espèce d'idiot », sur le même ton qu'elle avait l'habitude de dire « chérie ». Il lui a fallu un certain temps pour comprendre la rime, mais il a trouvé l'expérience mignonne (bien qu'un peu ennuyeuse).

Nous avons appris à construire des « machines qui génèrent du texte sans effort ».

Mais nous n’avons pas appris à arrêter d’imaginer la pensée qui se cache derrière cela.

Au fur et à mesure que Bender grandissait dans le domaine de la linguistique, les ordinateurs se développaient en parallèle. En 1993, elle a suivi les cours d'introduction au lexical et d'introduction à la programmation. (La morphologie est l'étude de la façon dont les mots sont constitués de racines, de préfixes, etc.) Un jour, alors que son assistant pédagogique expliquait l'analyse grammaticale des langues bantoues, Bender a décidé d'essayer d'écrire un programme pour cela pendant qu'elle était sur le campus. Pendant que Menon regardait un match de basket-ball dans un bar voisin, elle écrivait le programme à la main avec un stylo et du papier. De retour dans son dortoir, lorsqu'elle saisit le code, le programme fonctionna. Elle a donc imprimé le programme et l’a montré à son assistant pédagogique, mais il a simplement haussé les épaules."Si j'avais montré le programme à quelqu'un qui connaissait la linguistique informatique", a déclaré Bender, "ils auraient dit : 'Hé, c'est une bonne chose.'"

Après avoir obtenu son diplôme de l'Université de Stanford Dans les années qui ont suivi son doctorat en linguistique, Bender a gardé une main dans le monde universitaire et une autre dans l'industrie. Elle a enseigné la grammaire à Berkeley et Stanford et a travaillé sur l'ingénierie grammaticale dans une startup appelée YY Technologies. En 2003, l'Université de Washington l'a embauchée et a lancé en 2005 un programme de maîtrise en linguistique informatique. Le cheminement de Bender dans le domaine de la

Linguistique computationnelle est basé sur une idée qui semble évidente mais qui n'est généralement pas reconnue par ses collègues traitant le langage naturel : le langage est basé sur « des personnes qui communiquent entre elles et travaillent ensemble pour parvenir à la compréhension ».

Peu de temps après son arrivée à l'Université de Washington, Bender a commencé à remarquer à quel point on en savait peu sur la linguistique, même lors de conférences organisées par des organisations comme l'Association for Computational Linguistics. Elle a donc commencé à proposer des tutoriels tels que "100 choses que vous voulez toujours savoir mais que vous n'osez pas demander - 100 choses sur la linguistique".Elle a également ouvertement contesté le terme « intelligence artificielle ». En tant que femme d'âge moyen dans un domaine masculin, cela la met sans aucun doute dans une position où elle est facilement attaquée. Le concept d’« intelligence » a une histoire de suprématie blanche. De plus, quelle est la définition de « intelligent » ? La théorie des intelligences multiples de Howard Gardner ? Ou l’échelle de renseignement Stanford-Binet ? Bender est particulièrement friand d'un nom alternatif pour « l'intelligence artificielle » proposé par un ancien législateur italien : les approches systématiques des algorithmes d'apprentissage et des inférences automatiques. Ensuite, les gens demanderont : "Ce SALAMI est-il intelligent ? Ce SALAMI peut-il écrire un roman ? Ce SALAMI devrait-il avoir des droits humains ?" Dans quelle langue l'étude a-t-elle été menée ? » Cette question s'adresse aux articles qui n'indiquent pas explicitement la langue, même si tout le monde sait qu'il s'agit de l'anglais. (En linguistique, cela s'appelle un « problème de menace faciale », un terme qui vient des études de politesse linguistique. Cela signifie que vous êtes impoli, ennuyeux ou serez ennuyeux, et que votre langage réduit simultanément votre relation avec le statut. de votre interlocuteur. ) porte un réseau complexe de valeurs sous forme de langage. « Toujours nommer la langue que vous utilisez » est désormais connue sous le nom de « règle de Bender ». Les créateurs de technologies supposent que leur réalité représente fidèlement le monde, ce qui peut entraîner de nombreux problèmes différents. 4 1 milliard de mots. (Il ne peut pas inclure toutes les copies de livres électroniques dans les bibliothèques de Stanford, car les livres sont protégés par la loi sur le droit d'auteur.)

Les personnes qui écrivent ces mots en ligne surreprésentent les personnes blanches, masculines et riches. De plus, nous savons tous qu'il y a beaucoup de racisme, de sexisme, d'homophobie, d'islamophobie, de néonazisme, etc. sur Internet.

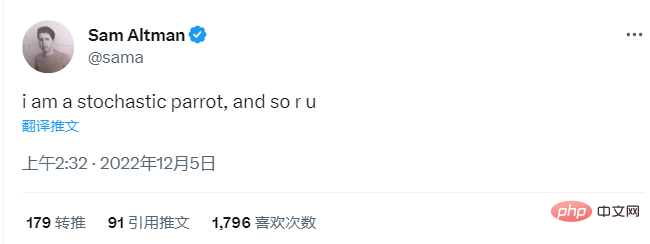

Mais le filtrage peut entraîner ses propres problèmes. Si vous supprimez le contenu des mots sur le sexe, vous perdez la voix du groupe. Le succès dans la technologie dépend de « garder le silence sur tout ce qui est dérangeant ». Sinon, vous devenez le problème. Bender n'a pas peur et ressent un sentiment de responsabilité morale. Elle a écrit à certains de ses collègues qui soutenaient sa protestation : "Je veux dire, après tout, à quoi servent les postes ?" L'animal imaginaire le plus célèbre du CV, il y a aussi un "perroquet aléatoire". « Stochastique » signifie aléatoire, déterminé par une distribution de probabilité aléatoire. Un « perroquet aléatoire » (un terme inventé par Bender) est une entité qui assemble de manière aléatoire des séquences de formes linguistiques en utilisant des informations de probabilité aléatoires, mais sans aucune implication. En mars 2021, Bender et trois co-auteurs ont publié un article intitulé Les dangers des perroquets aléatoires : les modèles linguistiques sont-ils trop gros ? (Sur les dangers des perroquets stochastiques : les modèles linguistiques peuvent-ils être trop volumineux ? ). Deux co-auteures ont perdu leur poste de co-responsable au sein de l'équipe Ethical AI de Google après la publication de l'article. La controverse entourant cette question a solidifié la position de Bender contre le fanatisme de l’IA. "Sur les dangers des perroquets stochastiques" n'est pas une recherche originale. Il s'agit d'une critique complète des modèles de langage proposés par Bender et d'autres : y compris les biais codés dans les modèles ; la quasi-impossibilité d'étudier leur contenu étant donné que les données de formation peuvent contenir des milliards de mots ; qui figent le langage et donc enferment dans les problèmes passés. Google a initialement approuvé le document, ce qui constitue une obligation pour les employés de le publier. Il a ensuite retiré son approbation et a demandé aux co-auteurs de Google de retirer leurs noms du document. Certains l’ont fait, mais Timnit Gebru, éthicien de l’IA de Google, a refusé. Sa collègue (et ancienne élève de Bender) Margaret Mitchell a changé son nom en Shmargaret Shmitchell, destiné à « indexer un événement et un groupe d'auteurs effacés ». Gebru a perdu son emploi en décembre 2020 et Mitchell a perdu son emploi en février 2021. Les deux femmes ont cru qu'il s'agissait d'une vengeance et ont raconté leur histoire aux médias. À mesure que l'article sur le « perroquet aléatoire » est devenu viral, du moins dans le monde universitaire, il est devenu un mot à la mode. L'expression est également entrée dans le vocabulaire technique. Mais cela n’est pas entré dans le lexique comme Bender l’espérait. Les dirigeants technologiques adorent ce terme, tout comme les programmeurs. Le PDG d'OpenAI, Sam Altman, est à bien des égards un parfait auditeur - un hyper-rationaliste avoué qui est tellement pris dans la bulle technologique qu'il semble avoir perdu toute perspective sur le monde extérieur. S'adressant à AngelList Confidential en novembre, il a déclaré : "Je crois que l'énergie nucléaire nous entraînera tous de toute façon une destruction inévitable - ses 'débuts') n'est pas une bonne chose." Il croit également à ce qu'on appelle la « singularité », la conviction de nombreux passionnés de technologie selon laquelle dans un avenir proche la distinction entre les humains et les machines disparaîtra. En 2017, parlant de la fusion des robots, Altman a déclaré : "Nous y travaillons depuis quelques années. C'est probablement plus tôt que la plupart des gens ne le pensent. Le matériel s'améliore de façon exponentielle... et le dévouement augmente également à un rythme exponentiel. La fonction double exponentielle vous fera rapidement perdre votre sentiment de contrôle. » Le 4 décembre, quatre jours après la sortie de ChatGPT, Altman a tweeté : « Je suis un perroquet aléatoire et vous aussi. »

3 Elle a commencé à apprendre et à amplifier les voix critiques des femmes noires sur l'IA, notamment Joy Buolamwini (qui a fondé l'Algorithmic Justice Alliance au MIT) et Meredith Broussard (auteur de Artificial Intelligence: How Computers Misunderstand the World).

Cette liste a été initialement compilée par les développeurs de Shutterstock, puis téléchargée sur GitHub pour automatiser la question « Que ne voulons-nous pas que les gens voient ? » OpenAI externalise également ce qu’elle appelle une main-d’œuvre fantôme : des travailleurs à temps partiel au Kenya (une ancienne colonie britannique où les gens parlent anglais britannique) qui gagnent 2 dollars de l’heure en lisant et en signalant les contenus les plus horribles – la pédophilie et plus encore pour les éliminer.

C'est un moment passionnant. Un million de personnes utilisaient ChatGPT dans les cinq jours suivant son lancement. L'écriture est terminée ! Le travail de connaissance est également terminé ! Où tout cela mènera-t-il ? "Je veux dire, je pense que le meilleur des cas est si bon qu'il est inimaginable !", a déclaré Altman à ses pairs lors d'un événement StrictlyVC le mois dernier. Qu'en est-il du scénario cauchemardesque ? "Le mauvais scénario, je pense qu'il est également important, c'est comme si nous avions tous un écran noir." Altman a déclaré qu'il était "plus inquiet d'une utilisation abusive accidentelle à court terme... pas comme une IA qui se réveille et décide de le faire". mal."

C'est un moment passionnant. Un million de personnes utilisaient ChatGPT dans les cinq jours suivant son lancement. L'écriture est terminée ! Le travail de connaissance est également terminé ! Où tout cela mènera-t-il ? "Je veux dire, je pense que le meilleur des cas est si bon qu'il est inimaginable !", a déclaré Altman à ses pairs lors d'un événement StrictlyVC le mois dernier. Qu'en est-il du scénario cauchemardesque ? "Le mauvais scénario, je pense qu'il est également important, c'est comme si nous avions tous un écran noir." Altman a déclaré qu'il était "plus inquiet d'une utilisation abusive accidentelle à court terme... pas comme une IA qui se réveille et décide de le faire". mal."

Il n'a pas défini « cas d'utilisation abusive accidentelle », mais le terme fait généralement référence à de mauvais acteurs utilisant l'intelligence artificielle à des fins antisociales, comme nous tromper, ce qui est sans doute l'un des objectifs de conception de cette technologie. . Ce n’est pas qu’Altman veuille assumer une quelconque responsabilité personnelle, il admet simplement qu’une « mauvaise utilisation » peut être « vraiment mauvaise ».

Bender ne pense pas que le « perroquet aléatoire » d’Altman soit drôle.

Nous ne sommes pas des perroquets, nous ne prononçons pas des mots au hasard en fonction de probabilités. Elle a déclaré : « C'est une tactique très courante. Les gens disent : « Les gens ne sont que des perroquets au hasard ». » Elle a déclaré : « Les gens veulent tellement croire que ces modèles de langage sont réellement intelligents qu'ils sont prêts à s'utiliser comme un point de référence, Et se dévaloriser pour correspondre à ce que les modèles linguistiques peuvent faire »

Certaines personnes semblent disposées à faire correspondre ce qui existe avec ce que la technologie peut faire, les bases de la linguistique. principes. L'adversaire actuel de Bender est le linguiste informatique Christopher Manning, qui estime que le langage n'a pas besoin de pointer vers le monde extérieur. Manning est professeur d'apprentissage automatique, de linguistique et d'informatique à l'Université de Stanford. Le cours de traitement du langage naturel qu'il enseigne est passé d'environ 40 étudiants en 2000 à 500 l'année dernière et 650 cette année, ce qui en fait l'un des cours les plus importants du campus. Il est également directeur du laboratoire d'intelligence artificielle de Stanford et associé chez AIX Ventures, qui se définit comme une « société de capital-risque axée sur la phase d'amorçage de l'intelligence artificielle ». La couche entre le monde universitaire et l'industrie est presque partout, mais à Stanford, cette couche est presque inexistante. L'école est tellement enchevêtrée dans les entreprises technologiques qu'il est difficile de distinguer les frontières entre l'école et l'industrie.

«Je devrais choisir soigneusement mon juste milieu», a déclaré Manning fin février. «Des écoles solides en informatique et en intelligence artificielle finiront par entretenir des relations solides avec les grandes entreprises technologiques.» Le plus grand désaccord entre Bender et Manning concerne la manière dont le sens est créé, qui est l’objet principal de l’article d’Octopus.

Jusqu'à récemment, les philosophes et les linguistes s'accordaient à dire que Bender avait raison : les référents, ces choses et concepts qui existent réellement dans le monde, comme les noix de coco et les cœurs brisés, sont nécessaires pour produire du sens.

Et Manning considère désormais cette vision comme dépassée, arguant qu'elle constitue « la position standard dans la philosophie du langage au XXe siècle ». « Je ne dirais pas que c’est complètement invalide du point de vue sémantique, mais c’est aussi une position étroite », m’a-t-il dit. Il plaide en faveur d'un « sens plus large ». Dans un article récent, il a inventé le terme « sémantique distribuée » : « La signification d'un mot est simplement une description du contexte dans lequel il apparaît. » (Mais lorsque j'ai demandé à Manning comment il définissait le « sens », il a répondu : « Pour être honnête, je pense que c'est très difficile.") Si l'on souscrit à la théorie de la sémantique distribuée, alors les LLM (grands modèles de langage) ne sont pas des poulpes, ni des perroquets aléatoires qui crachent bêtement des mots, et nous n'avons pas non plus besoin de tomber dans « Le sens est cartographié sur le monde » est une façon de penser dépassée.

LLM traite des milliards de mots. La technologie a marqué le début de ce qu’il appelle « un changement de phase ». "Vous savez, les humains ont découvert le travail des métaux, ce qui était incroyable, puis quelques centaines d'années plus tard, ils ont appris à exploiter la puissance de la vapeur", a déclaré Manning. "Nous sommes à un moment similaire avec le langage. Le LLM est suffisamment révolutionnaire pour changer notre façon de faire. compréhension du langage lui-même. "Pour moi, ce n'est pas un argument très formel. C'est juste une manifestation."

Juillet 2022, les organisateurs d'une conférence de linguistique ont mis Bender et Manning sur la même petite table pour que. un public en direct pourrait écouter leur argument (poli). Ils étaient assis à une petite table recouverte de tissu noir, Bender dans un pull violet et Manning dans une chemise saumon, et ils tenaient à tour de rôle des microphones pour répondre aux questions et se répondre avec des phrases comme "Je vais y aller en premier!" Je ne suis pas d'accord!" ". Ils se chamaillaient constamment, d’abord sur la manière dont les enfants apprenaient la langue. Bender croit qu'ils apprennent dans les relations avec les soignants ; Manning dit que l'apprentissage est une « auto-surveillance » comme le LLM.

Ensuite, ils discutent de l'importance de la communication elle-même. Ici, Bender cite Wittgenstein et définit le langage comme essentiellement relationnel, c'est-à-dire « le souci commun d'au moins deux interlocuteurs de parvenir à un accord ou à une approximation d'un accord », ce avec quoi Manning n'est pas entièrement d'accord. Oui, elle a reconnu que les humains expriment leurs émotions à travers des expressions faciales et communiquent à travers le langage corporel comme l'inclinaison de la tête, mais que les informations supplémentaires sont « marginales ».

Vers la fin de la réunion, ils ont eu le désaccord le plus profond, à savoir - Ce n'est pas une question de linguistique, mais pourquoi construisons-nous ces machines ? À qui servent-ils ?

"J'ai l'impression qu'il y a eu trop d'efforts pour essayer de créer des machines autonomes", a déclaré Bender, " au lieu d'essayer de créer des machines-outils utiles aux humains. "

Quelques semaines après le panel de Manning, Bender s'est tenu sur le podium d'une conférence à Toronto pour prendre la parole, vêtu d'un long manteau bleu sarcelle fluide et de boucles d'oreilles pendantes en forme de pieuvre. Le thème est « Résister à la déshumanisation à l’ère de l’intelligence artificielle ». Cela ne semble pas être une question particulièrement radicale. Bender définit cette « déshumanisation » à consonance prosaïque comme « l’incapacité de percevoir pleinement l’humanité d’une autre personne et la souffrance causée par des comportements et des expériences qui démontrent un manque de reconnaissance de l’humanité ».

Puis elle a posé une question sur la métaphore informatique, qui est aussi l'une des métaphores les plus importantes de toute la science : c'est-à-dire que le cerveau humain est un ordinateur, et l'ordinateur est un cerveau humain. Elle cite un article de 2021 d'Alexis T. Baria et Keith Cross, l'idée selon laquelle « l'esprit humain a plus à offrir qu'il ne mérite ». Moins de complexité donne à l'ordinateur plus d'intelligence qu'il n'aurait dû.

Pendant la séance de questions-réponses après le discours de Bender, un homme chauve portant un collier et un polo noir s'est approché du microphone et a fait part de ses inquiétudes : « Oui, la question que je veux poser est la suivante : pourquoi avez-vous choisi l'humanité et cette catégorie d'êtres humains comme cadre pour rassembler toutes ces idées différentes. » Cet homme ne considérait pas les humains comme étant spéciaux, et il a dit : « En écoutant votre discours, je n'ai pas pu m'empêcher de penser, vous Je sais, certains. Les gens sont vraiment méchants, donc être regroupés avec eux n'est pas si génial. Nous sommes de la même espèce, de la même classe biologique, mais peu importe ? Je suis bien avec mon chien classé ensemble."

Il a voulu faire la distinction entre « un être humain dans la catégorie biologique » et « un être humain, ou une unité, digne de respect moral ». Il a reconnu que les LLM ne sont pas humains, du moins pas encore, mais que la technologie s'améliore. "Je me demande", a-t-il demandé, "pourquoi avez-vous choisi d'utiliser les humains ou l'humanité comme cadre pour réfléchir à ces différentes choses, et pourriez-vous en dire un peu plus

Bender s'est légèrement penché vers le sujet ?" à droite, se mordant la lèvre en écoutant. Que pouvait-elle dire ? Elle a argumenté à partir des premiers principes. "Je pense que tout être humain devrait recevoir un certain respect moral simplement parce qu'il est humain. ", a-t-elle déclaré. "Nous voyons beaucoup de problèmes actuels dans le monde liés au fait de ne pas accorder l'humanité aux humains.", et cela. Personne n'y croit, a-t-il poursuivi : "Si je peux dire quelque chose très rapidement, peut-être que 100 % des gens méritent un certain niveau de respect moral, et ce n'est pas à cause du sens de leur existence en tant qu'espèce humaine"

De nombreuses personnes extérieures à la communauté technologique ont également fait valoir ce point. Les écologistes et les défenseurs des droits humains des animaux soutiennent que nous devrions abandonner l’idée selon laquelle nous sommes si importants pour notre espèce. Nous devons vivre plus humblement. Nous devons accepter que nous sommes une créature parmi d’autres, une parmi la matière. Arbres, rivières, baleines, atomes, minéraux, planètes – tout compte, et nous ne sommes pas les patrons ici.

Mais le voyage du modèle linguistique à la crise existentielle est en effet court.

En 1966, Joseph Weizenbaum, qui a créé le premier chatbot ELIZA, l'a regretté pendant la majeure partie de sa vie. Dans son livre « Computer Power and Human Reason », il écrit que les questions soulevées par cette technologie portent « essentiellement sur la place de l'humanité dans l'univers ». Ces jouets sont amusants, charmants et addictifs, ce qui, il y a 47 ans, serait notre perte : « Pas étonnant que les gens qui vivent jour après jour avec des machines qui croient qu'ils sont des esclaves commencent à croire - vous êtes un machine ”

L’impact de la crise climatique est évident. Nous connaissons les dangers depuis des décennies, et pourtant nous continuons, alimentés par le capitalisme et les désirs de quelques-uns. Qui ne voudrait pas s’envoler pour Paris ou Hawaï pour le week-end, surtout quand la meilleure équipe de relations publiques du monde vous dit que c’est la récompense ultime de la vie ?

Créer une technologie qui imite les humains nécessite que nous ayons une compréhension très claire de qui nous sommes.

"Désormais, utiliser l'intelligence artificielle en toute sécurité nécessite de démystifier la condition humaine", Joanna Bryson, professeur d'éthique et de technologie à la Hertie School of Governance de Berlin. L'année dernière, j'écrivais que si nous étions plus grands, nous arrêterions nous considérant davantage comme des girafes. Alors pourquoi rester vague en matière de renseignement ?

D'autres, comme le philosophe Dennett, sont plus directs. Il a déclaré que nous ne pouvons pas vivre dans un monde avec de soi-disant « contrefacteurs ».

"Depuis que l'argent existe, la contrefaçon a toujours été considérée comme un acte de vandalisme contre la société. Les sanctions incluent la mort et le dépeçage. Et faire des contrefaçons est au moins aussi grave", a-t-il ajouté. toujours moins précieux que les vraies personnes. Des intérêts multiples, ce qui en fait des acteurs amoraux : "Pas pour des raisons métaphysiques, mais pour de simples raisons physiques - ils ont un sentiment d'immortalité."

Dennett estime que les créateurs de technologie ont besoin de rigueur. "Ils devraient être tenus responsables. Ils devraient être poursuivis. Ils devraient admettre ouvertement que si quelque chose qu'ils ont fabriqué est utilisé pour fabriquer des faussaires, ils seront responsables. S'ils ne le font pas. À ce stade, ils sont sur le point de créer des armes extrêmement destructrices pour la stabilité et la sécurité sociale. Ils devraient prendre ce problème aussi au sérieux que les biologistes moléculaires prennent la perspective d'une guerre biologique ou que les physiciens atomiques prennent la perspective d'une guerre nucléaire. Nous devons « créer de nouvelles attitudes, de nouvelles lois qui se propagent rapidement et éliminer ces compliments trompeurs et personnalisés », a-t-il déclaré. "Nous avons besoin de machines intelligentes, pas de collègues artificiels."

Bender a sa propre règle : "Je ne parlerai pas à quelqu'un qui ne prend pas mon humanité comme un axiome dans la conversation." les lignes. Je ne pensais pas avoir besoin d'établir une telle règle.

« Il y a une résurgence du narcissisme dans le rêve de l'IA, où nous prouverons que tout ce que nous considérons comme uniquement humain peut être fait par des machines, et mieux fait. » Judith Butler, directrice fondatrice du programme de théorie critique de l'UC Berkeley, m'a aidé à expliquer les idées impliquées : « Le potentiel humain – c'est l'idée fasciste – est mieux réalisé grâce à l'IA. Les rêves sont dominés par le « perfectionnisme » et c'est une forme de « perfectionnisme ». C'est le fascisme auquel nous assistons. C'est la technologie qui prend le dessus et s'éloigne du corps. "

Certaines personnes disent : " Ouais ! idées romantiques, notre anthropocentrisme, notre idéalisme, ajoute Butler, "Mais ce qui vit dans mes mots vit dans mes émotions. La question de ce qui vit dans mon amour, de ce qui vit dans mon langage est passée sous silence le lendemain de la présentation de Bender." aux bases de la linguistique, j'ai assisté à sa réunion hebdomadaire avec ses étudiants. Ils poursuivaient tous deux des études en linguistique informatique et ils ont tous deux vu ce qui se passait. Il y a tellement de possibilités, tellement de pouvoir. A quoi va-t-on l’utiliser ?

« La clé est de créer un outil facile à utiliser car vous pouvez utiliser un langage naturel plutôt que d'essayer de le faire ressembler à un être humain. », a déclaré Elizabeth Conrad.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Utilisation de la fonction strtok

Utilisation de la fonction strtok

Une seule page Word change l'orientation du papier

Une seule page Word change l'orientation du papier

Comment s'inscrire sur Binance

Comment s'inscrire sur Binance

numéro de série Photoshop CS5

numéro de série Photoshop CS5

Quelle est la fonction du téléphone portable NFC ?

Quelle est la fonction du téléphone portable NFC ?

Pourquoi n'y a-t-il aucun signal sur le moniteur après avoir allumé l'ordinateur ?

Pourquoi n'y a-t-il aucun signal sur le moniteur après avoir allumé l'ordinateur ?

Comment créer un site FTP

Comment créer un site FTP

Quel logiciel est le podcasting ?

Quel logiciel est le podcasting ?