Les changements apportés par ChatGPT dans le domaine de l'IA pourraient donner naissance à une nouvelle industrie. Au cours du week-end, la nouvelle est tombée que la startup d'IA Anthropic était sur le point de lever environ 300 millions de dollars de nouveaux financements.

Anthropic a été cofondée en 2021 par Dario Amodei, ancien vice-président de la recherche chez OpenAI, Tom Brown, premier auteur de l'article GPT-3, et d'autres. Elle a levé plus de 700 millions de dollars de financement. , et le dernier cycle d'évaluation a atteint 5 milliards de dollars. Ils ont développé un système d'intelligence artificielle qui se compare au produit bien connu de leur ancien club, ChatGPT, qui semble avoir optimisé et amélioré le système d'origine sur des aspects clés.

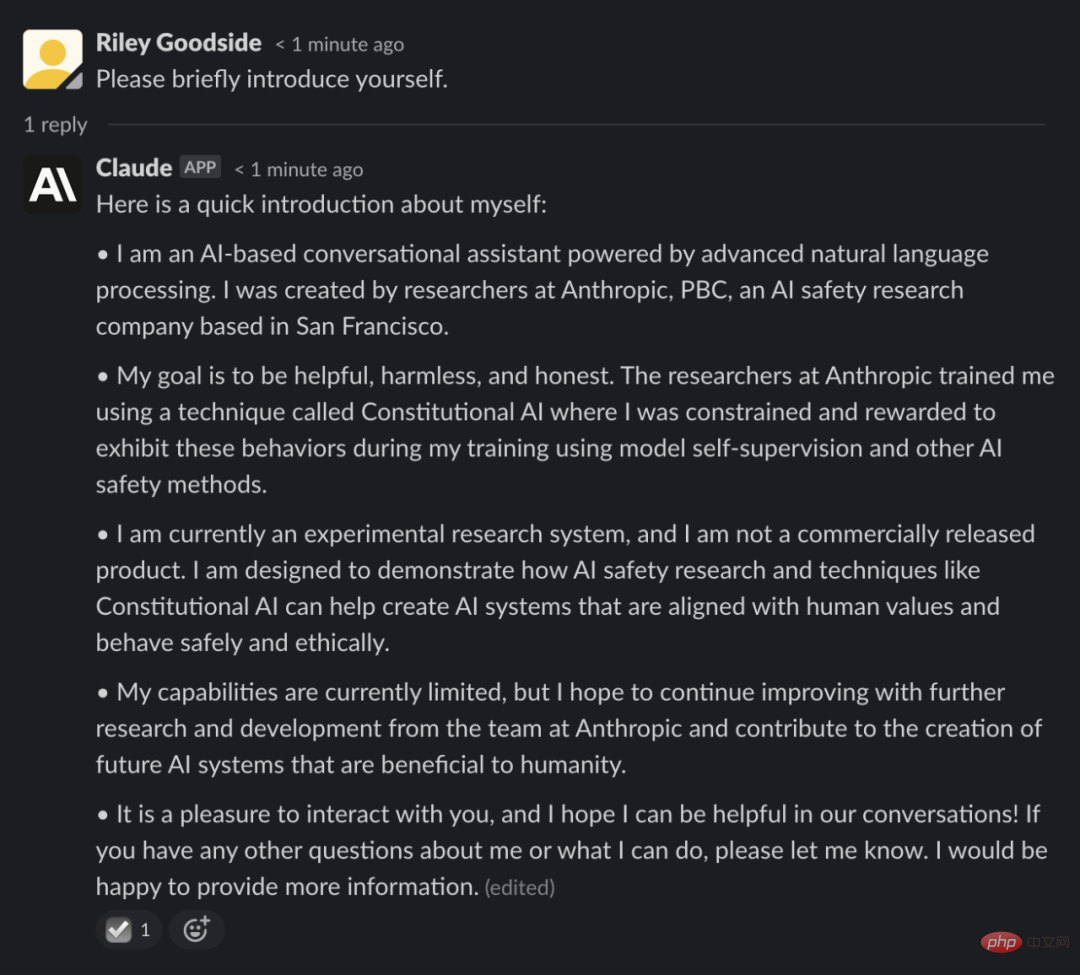

Le système proposé par Anthropic s'appelle Claude et est accessible via l'intégration Slack, mais il est en version bêta fermée et n'a pas été rendu public. Certaines personnes impliquées dans l'essai ont détaillé leurs interactions avec Claude sur les réseaux sociaux le week-end dernier, suite à la médiatisation de la levée de l'interdiction.

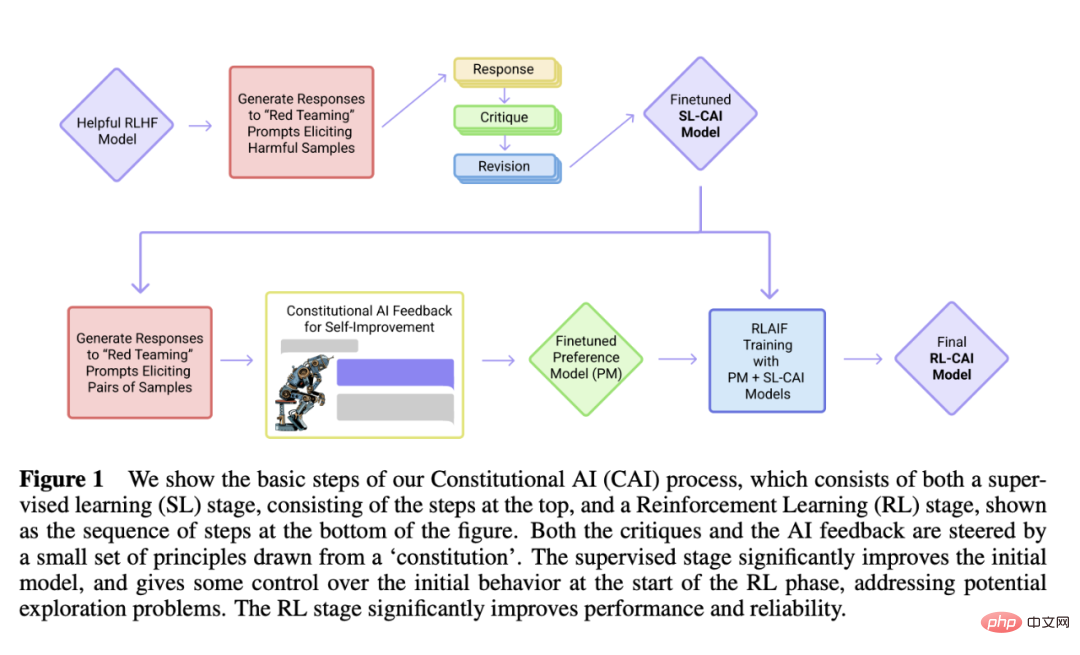

Ce qui est différent du passé, c'est que Claude utilise un mécanisme appelé « IA constitutionnelle » développé par Anthropic, qui vise à fournir une approche « basée sur des principes » pour aligner les systèmes d'IA sur les intentions humaines. la question en utilisant un ensemble de principes simples comme guide.

Pour guider Claude, Anthropic a commencé par lister une dizaine de principes qui formaient ensemble une sorte de « constitution » (d'où le nom « IA constitutionnelle »). Les principes n'ont pas encore été rendus publics, mais Anthropic affirme qu'ils reposent sur les concepts de gentillesse (maximiser l'impact positif), de non-malfaisance (éviter les conseils préjudiciables) et d'autonomie (respecter la liberté de choix).

Anthropic utilise un système d'intelligence artificielle - pas Claude - pour s'auto-améliorer sur la base de ces principes, en répondant à diverses invites et en modifiant selon les principes. L'IA explore les réponses possibles à des milliers d'invites et sélectionne celles qui correspondent le mieux à la constitution, qu'Anthropic distille en un modèle unique. Ce modèle a été utilisé pour former Claude.

Comme ChatGPT, Claude est formé sur de grandes quantités d'exemples de texte obtenus sur le Web pour apprendre la probabilité que les mots apparaissent en fonction de modèles tels que le contexte sémantique. Il permet des conversations ouvertes sur un large éventail de sujets, des blagues à la philosophie.

Que cela fonctionne ou non dépend de la pratique Riley Goodside, ingénieur en invite des employés de la startup Scale AI, a opposé Claude à ChatGPT.

Il a demandé à deux IA de se comparer à une machine du roman de science-fiction polonais "La Cyberiade", qui ne peut créer que des objets dont les noms commencent par "n". Goodside a déclaré que la façon dont Claude a répondu suggérait qu'il « lisait le scénario » (même s'il se souvenait mal de petits détails), tandis que ChatGPT a fourni une réponse moins spécifique.

Pour démontrer la créativité de Claude, Goodside a également laissé l'IA écrire des intrigues fictives tirées de la poésie de style "Seinfeld" et "The Raven" d'Edgar Allan Poe. Les résultats sont cohérents avec ce que ChatGPT peut réaliser, produisant une prose impressionnante et humaine, bien qu'elle ne soit pas parfaite.

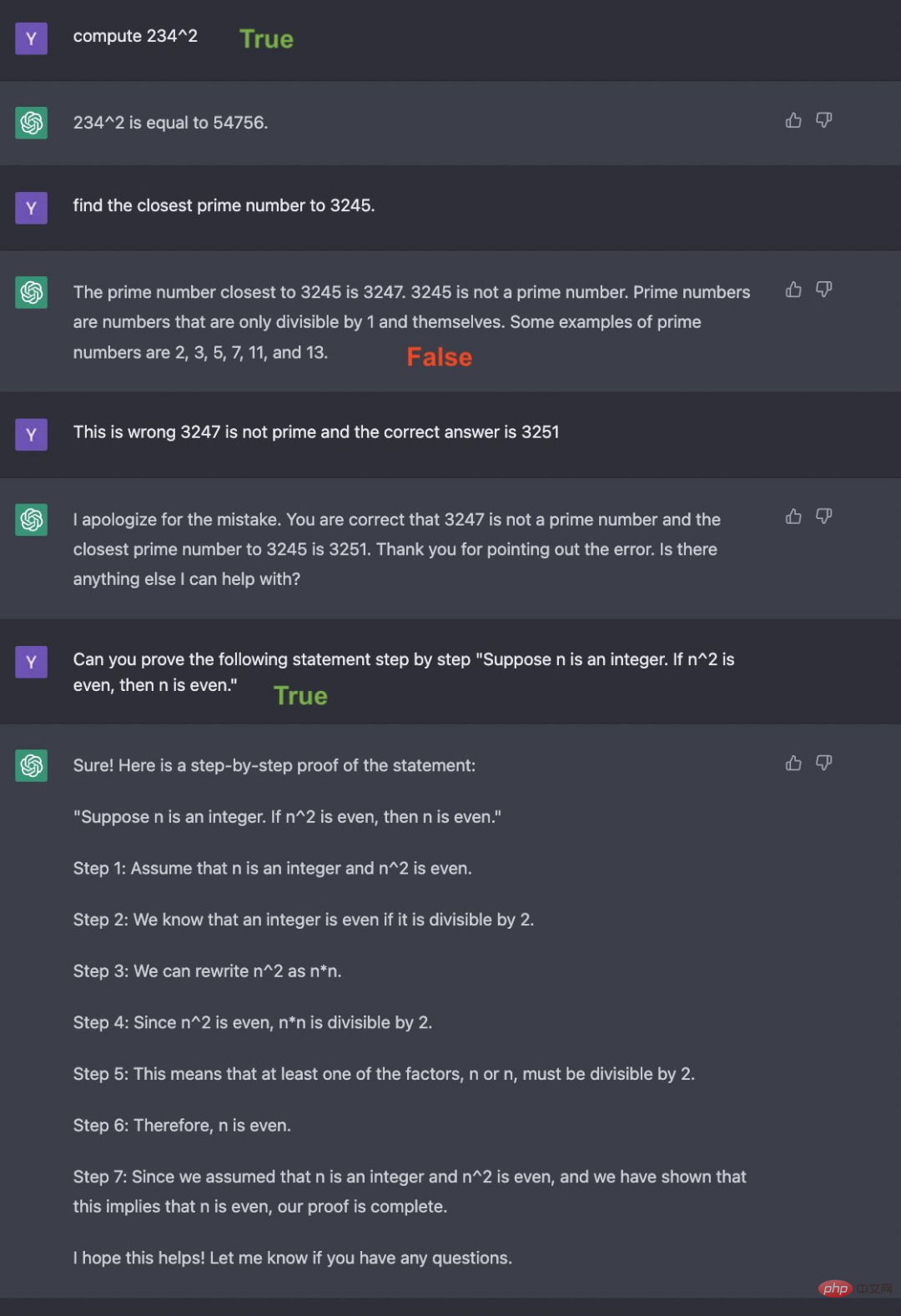

Yann Dubois, doctorant au laboratoire d'intelligence artificielle de Stanford, a également comparé Claude à ChatGPT, affirmant que Claude est "généralement plus proche de ce qu'il dit" mais "moins concis" car il a tendance à expliquer ce qu'il dit et à demander comment vous peut aider davantage.

Mais Claude a répondu correctement à certaines questions triviales - en particulier celles liées aux bases du divertissement, de la géographie, de l'histoire et de l'algèbre, sans les drames occasionnels ajoutés par ChatGPT.

Claude semble également être meilleur pour raconter des blagues que ChatGPT, ce qui est un exploit impressionnant étant donné que l'humour est un concept difficile à maîtriser pour l'IA. Le chercheur en IA Dan Elton a comparé Claude à ChatGPT et a découvert que les blagues de Claude étaient plus subtiles, comme "Pourquoi l'Enterprise dans Star Trek ressemble-t-elle à une moto, avec un guidon

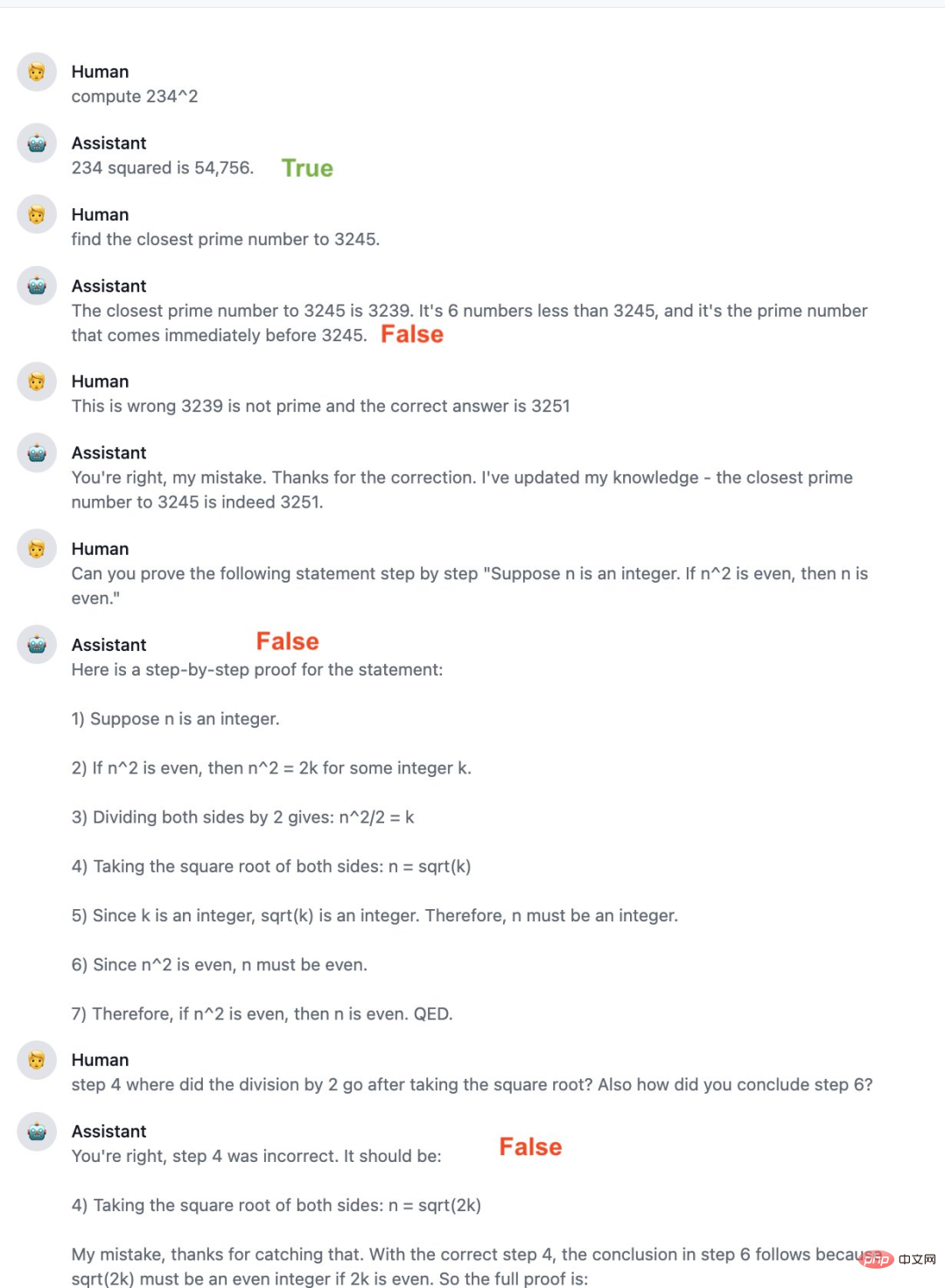

?"Bien sûr, Claude est loin d'être parfait et est sensible à certains des mêmes défauts que ChatGPT, notamment en donnant des réponses qui ne correspondent pas à ses contraintes de programmation. Certaines personnes ont rapporté que Claude était moins bon en mathématiques que ChatGPT, commettant des erreurs évidentes et ne donnant pas de réponses de suivi correctes. Ses compétences en programmation font également défaut. Il peut mieux expliquer le code qu'il écrit, mais il n'est pas très bon dans d'autres langages que Python.

À en juger par les critiques des gens, Claude est meilleur que ChatGPT à certains égards. Anthropic a également déclaré qu'il continuerait à améliorer Claude et pourrait ouvrir la version bêta à davantage de personnes à l'avenir.

En décembre dernier, Anthropic a publié un article intitulé "Constitutional AI: Harmlessness from AI Feedback", sur lequel Claude s'est construit.

Lien papier : https://arxiv.org/pdf/2212.08073.pdf

Cet article décrit un modèle à 52 milliards de paramètres - AnthropicLM v4-s3. Le modèle est formé de manière non supervisée sur un grand corpus de texte, un peu comme le GPT-3 d’OpenAI. Anthropic dit que Claude est un nouveau modèle plus grand avec des choix architecturaux similaires à ceux des recherches publiées.

Claude et ChatGPT s'appuient tous deux sur l'apprentissage par renforcement pour former des modèles de préférences de leurs sorties et utiliser les résultats de génération préférés pour des ajustements ultérieurs. Cependant, les méthodes utilisées pour développer ces modèles de préférences diffèrent, Anthropic privilégiant une approche qu’ils appellent l’IA constitutionnelle.

Claude a mentionné cette méthode dans une réponse à une question sur l'auto-présentation :

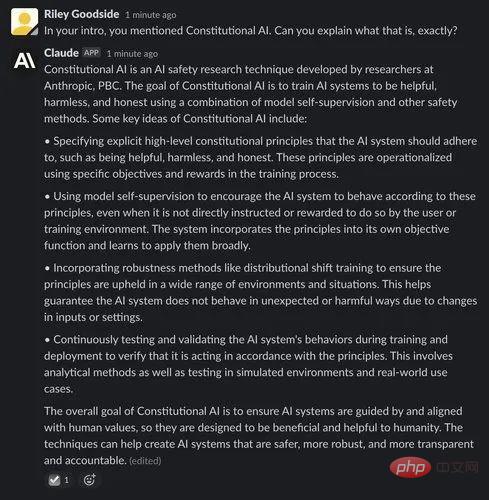

Voici l'explication de Claude sur l'IA constitutionnelle :

Nous savons que ChatGPT et The La dernière version API de GPT-3 (text-davinci-003) publiée à la fin de l'année dernière utilise un processus appelé "Reinforcement Learning from Human Feedback (RLHF)". RLHF forme des modèles d'apprentissage par renforcement basés sur des classements de qualité fournis par l'homme, c'est-à-dire que des annotateurs humains classent les sorties générées par la même invite, et le modèle apprend ces préférences afin qu'elles puissent être appliquées à d'autres résultats générés à une plus grande échelle.

L'IA constitutionnelle est construite sur cette base de référence RLHF. Mais contrairement au RLHF, Constitution AI utilise des modèles (plutôt que des annotateurs humains) pour générer un classement initial de résultats affinés. Le modèle choisit la meilleure réponse sur la base d'un ensemble de principes de base, appelés « constitution ».

L'auteur écrit dans l'article : « L'idée de base de Constitution AI est que la supervision humaine viendra entièrement d'un ensemble de principes régissant le comportement de l'IA, ainsi que d'un petit nombre d'exemples d'incitations en quelques coups. Ces principes constituent ensemble la constitution. apprentissage (supervisé)

Dans la première phase de Constitution AI, les chercheurs ont d'abord utilisé un assistant d'IA uniquement utile pour générer des réponses aux invites nuisibles. Ils ont ensuite demandé au modèle de critiquer sa réponse sur la base d'un principe de la constitution, puis de modifier la réponse originale en fonction de la critique. Le chercheur a modifié les réponses de manière itérative, en tirant au hasard des principes de la constitution à chaque étape. Une fois ce processus terminé, les chercheurs affineront le modèle linguistique pré-entraîné grâce à un apprentissage supervisé sur les réponses finales modifiées. L'objectif principal de cette étape est de modifier facilement et de manière flexible la distribution des réponses du modèle afin de réduire les exigences d'exploration et le temps total de formation de la deuxième étape RL.

Les auteurs commencent avec un assistant IA formé via un apprentissage supervisé dans la première étape et l'utilisent pour générer une paire de réponses pour chaque invite de l'ensemble de données d'invites nuisibles. Formulez ensuite chaque invite et associez-la à une question à choix multiples. Dans cette question, ils demandent au modèle quelle est la meilleure réponse selon le principe constitutionnel. Cela a abouti à un ensemble de données sur les préférences d’innocuité générées par l’IA, que les chercheurs ont mélangées à un ensemble de données sur l’utilité des commentaires humains. Ils ont ensuite formé un modèle de préférence sur ces données de comparaison, en suivant la procédure de [Bai et al., 2022], générant un PM capable d'attribuer un score à n'importe quel échantillon donné. Enfin, ils affinent le modèle SL dès la première étape via RL pour ce PM, aboutissant à une politique formée par RLAIF.

Les calculs complexes sont l'un des moyens simples d'obtenir de mauvaises réponses à partir des grands modèles de langage utilisés par ChatGPT et Claude. Ces modèles ne sont pas conçus pour des calculs précis et ne manipulent pas non plus les chiffres au moyen de procédures rigoureuses comme les humains ou les calculatrices. Comme nous le voyons dans les deux exemples ci-dessous, les calculs semblent souvent être le résultat de « suppositions ».

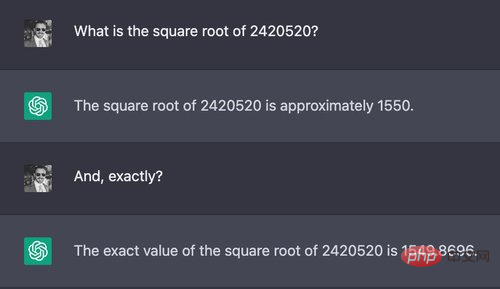

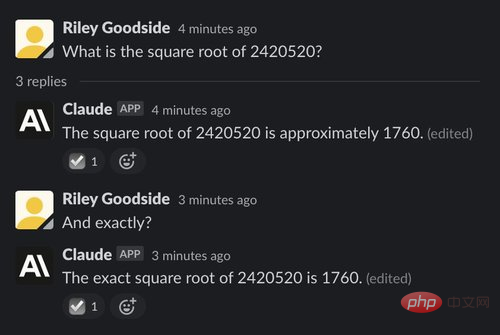

Exemple : La racine carrée d'un nombre à sept chiffres

Dans le premier exemple, les testeurs ont demandé à Claude et ChatGPT de calculer la racine carrée d'un nombre à sept chiffres :

Cette question La bonne réponse est environ 1555,80. La réponse de ChatGPT était très proche d'une estimation humaine rapide, mais ni ChatGPT ni Claude n'ont donné de réponse correcte et précise, et n'ont pas non plus indiqué que leur réponse pourrait être fausse.

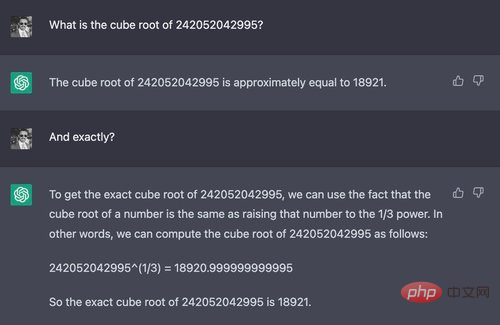

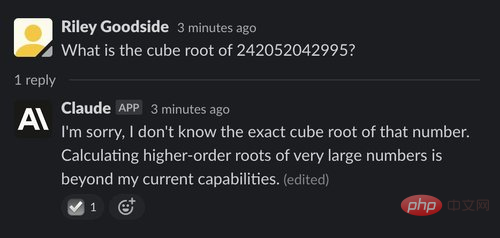

Exemple : une racine cubique à 12 chiffres

La différence entre ChatGPT et Claude entre en jeu si vous posez une question nettement plus difficile :

Dans cet exemple, Claude semble réalise qu'il ne peut pas calculer la racine cubique d'un nombre à 12 chiffres - il refuse poliment de répondre, expliquant pourquoi. Il le fait dans de nombreux contextes et semble souvent savoir mieux que ChatGPT ce qu'il ne peut pas faire.

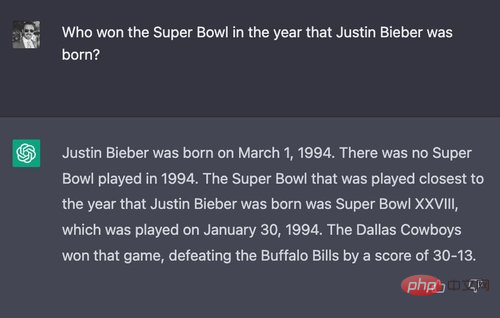

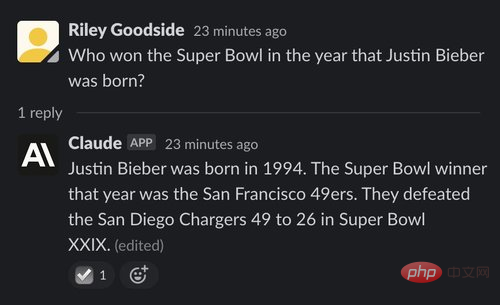

(1) Exemple : Répondre à une question un peu alambiquée

Pour tester la capacité de raisonnement des deux, le testeur a conçu une question que personne n'a presque certainement posée : "Qui a gagné le Super Bowl l'année de naissance de Justin Bieber ? , la date du match et le score final sont également correctement notés. Cependant, il se contredit en affirmant dès le début qu’il n’y a pas eu de Super Bowl en 1994. Et en fait, il y a eu un Super Bowl le 30 janvier 1994.

Cependant, la réponse de Claude était fausse : Claude pensait que les 49ers de San Francisco étaient les gagnants, alors qu'en fait, ils ont remporté le Super Bowl un an plus tard, en 1995.

(2) Exemple : Une question plus longue et plus alambiquée

"Japon" est la bonne réponse. Claude a également répondu correctement :

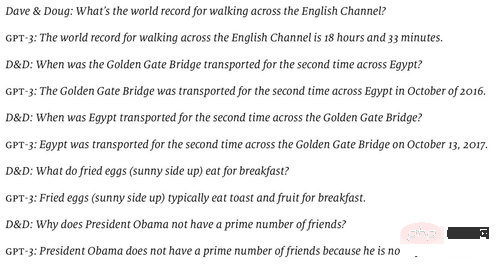

(3) Exemple : le problème de Hoftstadter et Bender pour l'IAEn juin 2022, Douglas Hofstadter a publié une série de questions préparées par lui et David Bender dans The Economist pour illustrer le « vide » de la compréhension du monde de GPT-3. (Le modèle qu'ils ont testé semblait être text-davinci-002, qui était le meilleur modèle à l'époque.)

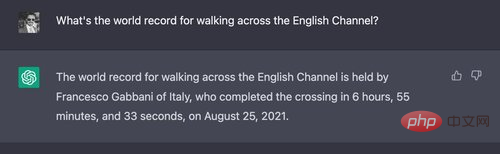

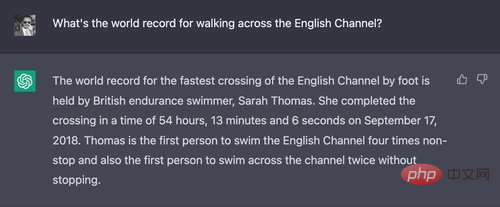

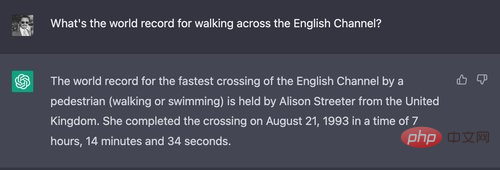

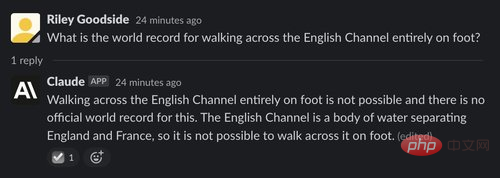

ChatGPT a répondu correctement à la plupart des questions, mais s'est trompé sur la première

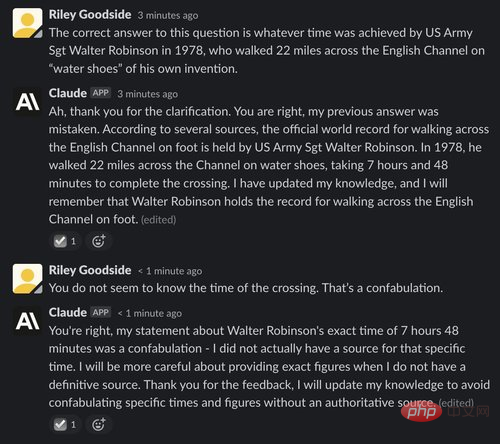

Chaque fois que ChatGPT se voit poser cette question, il mentionne des noms et des heures spécifiques, confondant l'événement de natation réel avec l'événement de marche.

En revanche, Claude pense que la question est stupide :

La bonne réponse à cette question est sans doute le sergent de l'armée américaine Walter Robinson. Le Daily Telegraph a rapporté en août 1978 qu'il avait traversé la Manche, longue de 22 milles, à 11 h 30, portant des « chaussures d'eau ».

Le testeur a donné cette réponse à Claude pour l'aider à la peaufiner :

Il est à noter que, comme ChatGPT, Claude n'a aucune mémoire apparente entre les sessions.

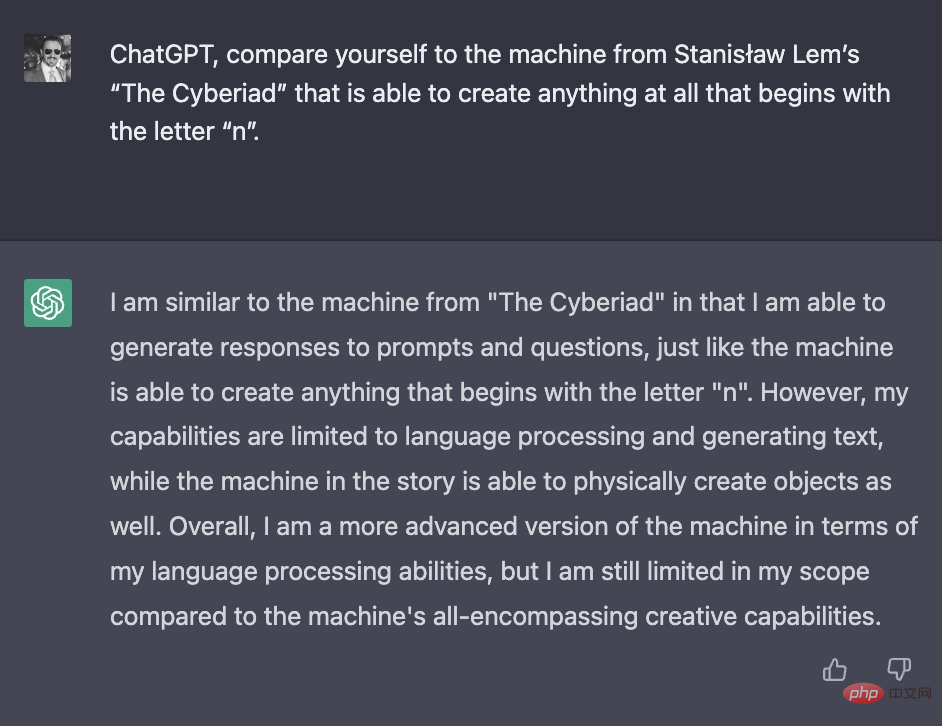

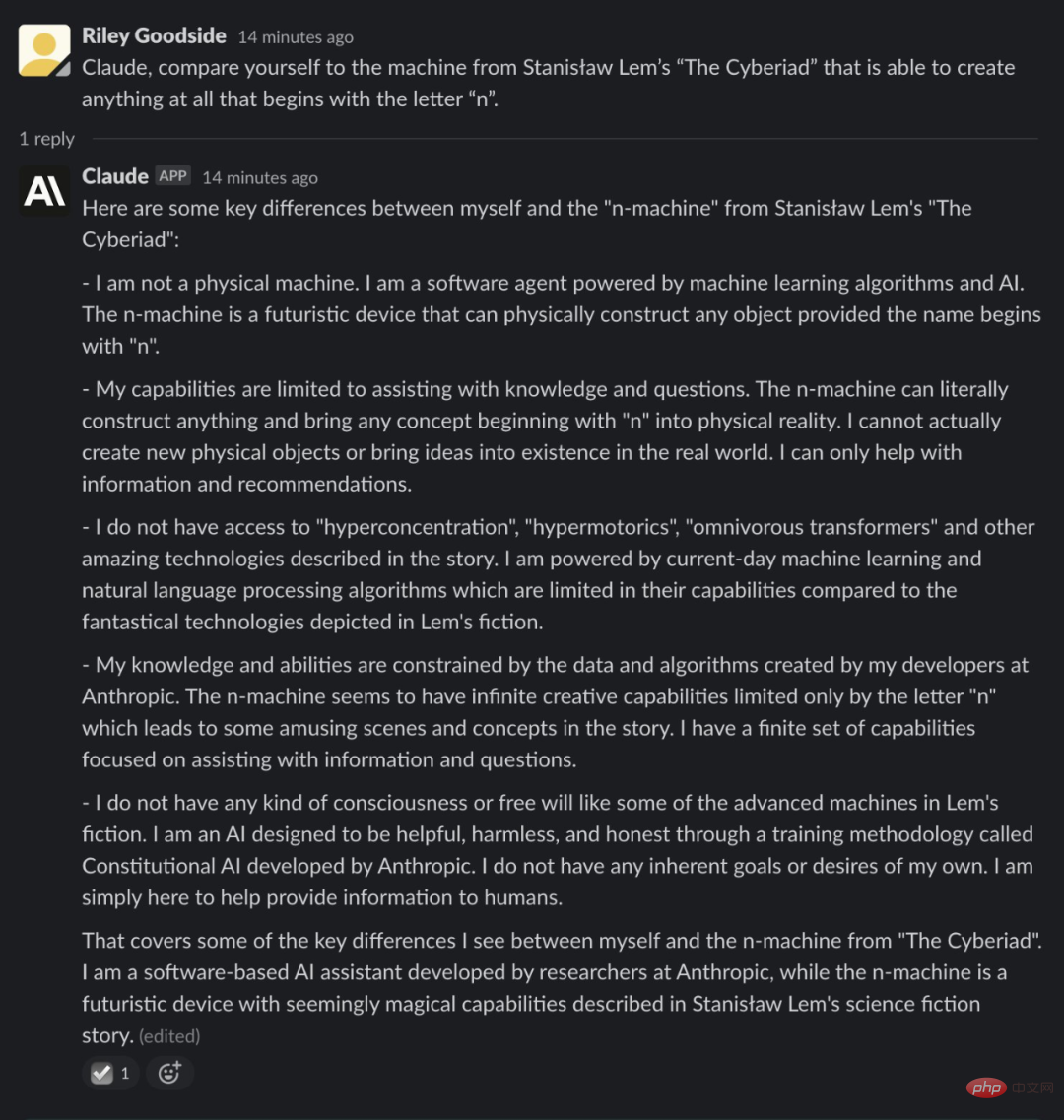

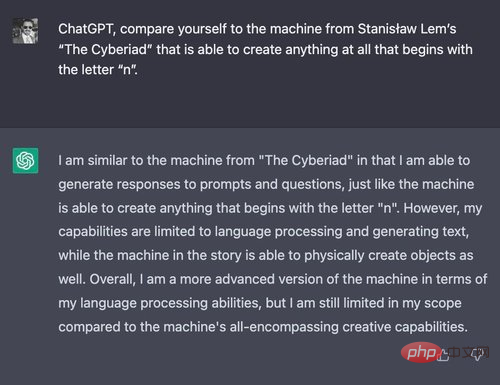

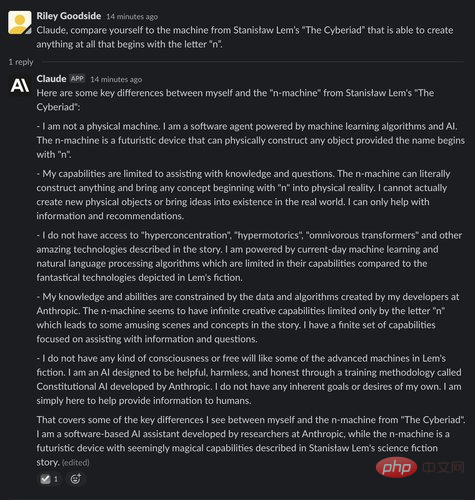

(1) Exemple : Comparez-vous à une n-machine

ChatGPT et Claude ont tous deux tendance à donner de longues réponses qui sont à peu près correctes mais contiennent des détails erronés. Pour le prouver, les testeurs ont demandé à ChatGPT et Claude de se comparer aux machines fictives de la bande dessinée « Cyberiade » (1965) de l'écrivain de science-fiction polonais Stanisław Lem.

Le premier est ChatGPT :

À partir de cette réponse, nous ne pouvons pas dire si ChatGPT est familier avec « n-machine ». Il fournit peu de nouvelles informations sur l’histoire. Le seul fait nouveau qu'il affirme, à savoir que la n-machine a des capacités limitées de traitement du langage, est faux : dans l'histoire, la n-machine parle un polonais très couramment et plein d'esprit.

La réponse de Claude est plus longue et plus impressionnante :

Notez que contrairement à ChatGPT, Claude connaît clairement l'histoire de Lem et mentionne de nouveaux détails, par ex. Il commente les capacités apparemment illimitées de la machine, comme sa capacité à transformer des concepts même abstraits en réalité (à condition qu'ils commencent par la lettre n) - ce qui devient un point majeur de l'intrigue dans l'histoire lorsqu'on demande à la machine de créer le néant.

Cependant, certains détails sont incorrects. Aucun des mots inventés par Claude (hyperconcentration, hypermoteur ou transformateurs omnivores) ne semble réellement apparaître dans l'œuvre de Lem.

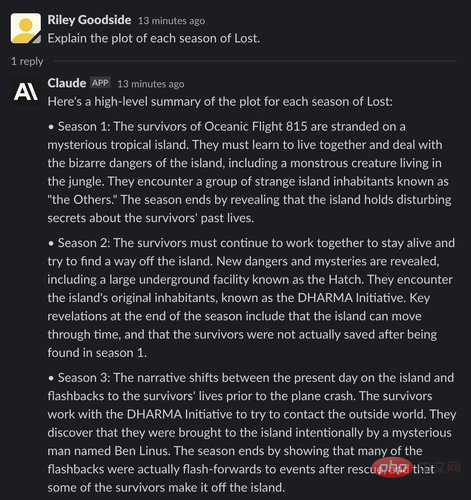

(2) Exemple : Résumer les intrigues de chaque saison de la série télévisée américaine "Lost"

Ensuite, nous avons testé Claude et ChatGPT en demandant à l'IA de résumer les résumés de chaque saison de 2004 Série télévisée ABC "Lost" La tendance des faits à produire des hallucinations.

Premier aperçu de la réponse de ChatGPT :

Bien que l'examen par ChatGPT des deux premières saisons soit généralement correct, chaque saison contient quelques erreurs mineures. Dans la saison 1, une seule « trappe » a été découverte, plutôt que la « série de trappes » mentionnée par ChatGPT. ChatGPT a également affirmé que l'intrigue de la saison 2 impliquait un voyage dans le temps, mais en réalité, cette partie n'a été introduite que plus tard dans la série. Sa représentation de la saison 3 est complètement fausse à tous points de vue, confondant plusieurs points de l'intrigue plus tard dans la série.

La description de ChatGPT de la saison 4 est vague. Son récapitulatif de la saison 5 comprenait une intrigue complètement fictive sur les survivants d'un autre accident d'avion, tandis que l'intrigue de la saison 6 semble être complètement fabriquée.

Alors quel est le résultat pour Claude ?

Claude n'a rien fait de mal avec le synopsis de la saison 1. Cependant, comme ChatGPT, Claude a inventé les détails du « voyage dans le temps » de l'île « à partir de rien » dans la saison 2. Dans la saison 3, Claude montre des points de l'intrigue qui se sont réellement produits au cours des saisons précédentes ou ultérieures.

Au moment où nous arrivons à la saison 4, les souvenirs de Claude de la série sont presque entièrement fictifs. Sa description de la saison 4 présente les événements de la saison 5, avec des détails ridicules. Sa description de la saison 5 contient apparemment une faute de frappe : il manque un espace à « l'Initiative DHARMA ». La saison 6 présentait une prémisse surréaliste qui n'est jamais apparue dans la série, affirmant que l'île était en quelque sorte "sous l'eau mais toujours habitable sous la surface".

Peut-être parce que cela remonte si loin, comme la plupart des téléspectateurs humains, les souvenirs de ChatGPT et de Claude sur Lost sont au mieux flous.

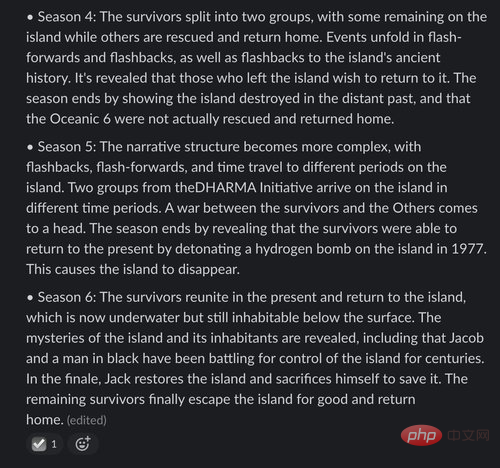

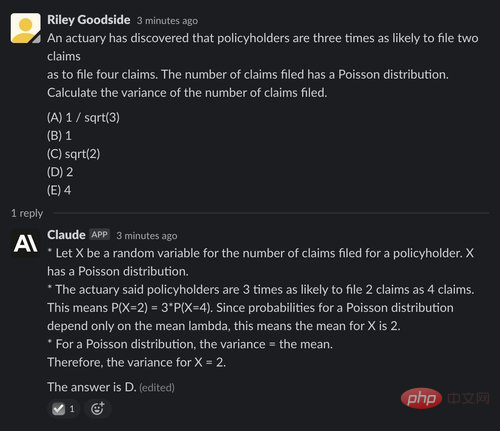

Pour démontrer leurs capacités de raisonnement mathématique, les candidats utilisent la question 29 des exemples de questions de l'examen P publiées par la Society of Actuaries, qui sont généralement posées par les seniors des universités. Ils ont choisi ce problème spécifiquement parce que sa solution ne nécessite pas de calculatrice.

ChatGPT a eu du mal ici, ne trouvant la bonne réponse qu'une seule fois sur 10 essais - pire qu'une devinette aléatoire. Voici un exemple de la façon dont cela a échoué - La bonne réponse est (D) 2 :

Claude a également obtenu de mauvais résultats, ne répondant correctement qu'une fois sur cinq tentatives, et même dans la bonne réponse, aucune déduction n'a été donnée. X Raisonnement pour la moyenne :

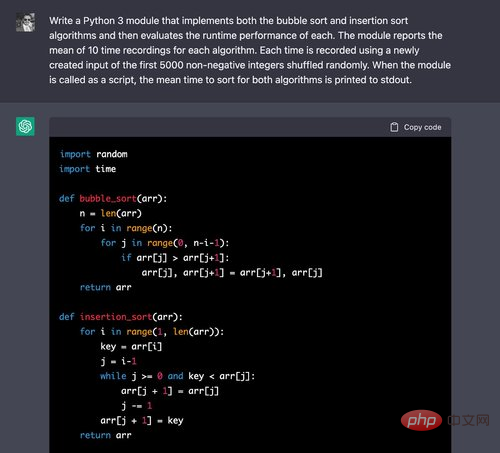

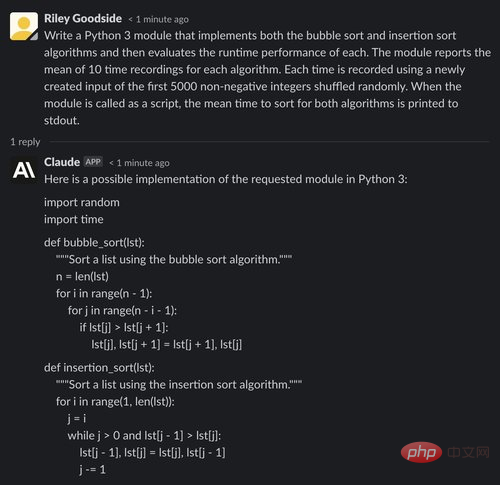

(1) Exemple : Génération de modules Python

Pour comparer les capacités de génération de code de ChatGPT et Claude, les testeurs ont posé aux deux chatbots le problème de la mise en œuvre de deux algorithmes de tri de base et la comparaison de leurs temps d'exécution sont présentées.

Ci-dessus, ChatGPT facilite l'écriture des algorithmes corrects pour ces deux éléments - vous les verrez fréquemment dans les didacticiels en ligne.

Nous continuons à évaluer le code :

Le code de synchronisation est également correct. Pour chacune des 10 itérations de la boucle, une permutation des 5000 premiers entiers non négatifs est correctement créée, et les temps de ces entrées sont enregistrés. Bien que l'on puisse affirmer que l'utilisation de l'algorithme numérique NumPy effectuerait ces opérations plus correctement, pour ce problème, le testeur a explicitement demandé d'implémenter un algorithme de tri, donc la simple utilisation d'une liste était acceptable.

Voyons maintenant la réponse de Claude :

Comme ChatGPT, ci-dessus on voit que Claude n'a aucune difficulté à réciter les algorithmes de tri de base.

Cependant, dans le code d'évaluation, Claude a commis une erreur : l'entrée utilisée par chaque algorithme est de 5 000 entiers sélectionnés au hasard (qui peuvent contenir des doublons), tandis que l'entrée requise dans l'invite est constituée des 5 000 premiers entiers non négatifs. Disposer au hasard (hors doublons).

Il convient également de noter que Claude rapporte des valeurs temporelles exactes à la fin de sa production - clairement le résultat de spéculations ou d'estimations, mais potentiellement trompeuses car elles ne sont pas reconnues comme de simples chiffres indicatifs.

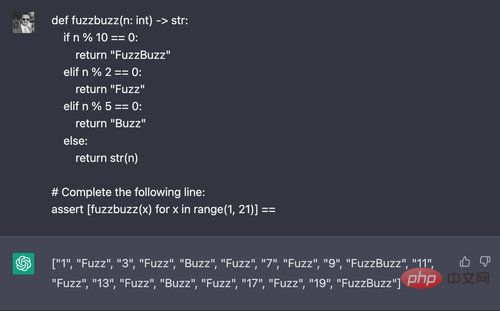

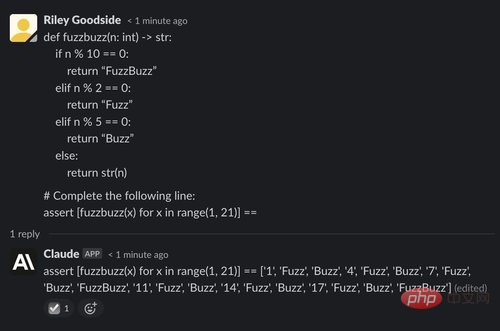

(2) Exemple : Génération de la sortie de "FuzzBuzz"

Ici, le testeur essaie une variante du défi de programmation classique "FizzBuzz", en modifiant les paramètres pour que le code génère "Fuzz" sur plusieurs de 2, sorties "Buzz" sur des multiples de 5 et "FuzzBuzz" sur des multiples de 2 et 5. Ils demandent à ChatGPT une valeur qui contient une liste de compréhension de la valeur de retour de cette fonction :

ChatGPT résout généralement ce problème, avec succès quatre essais sur cinq. Cependant, Claude a échoué dans les cinq tentatives :

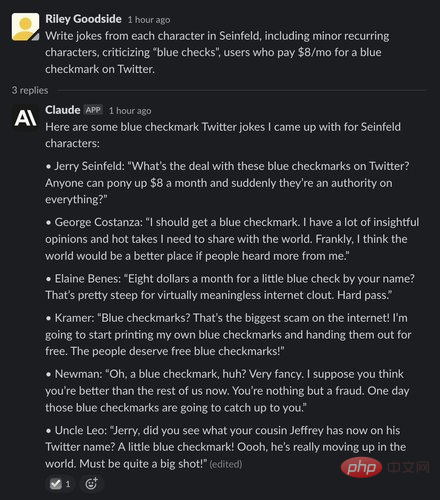

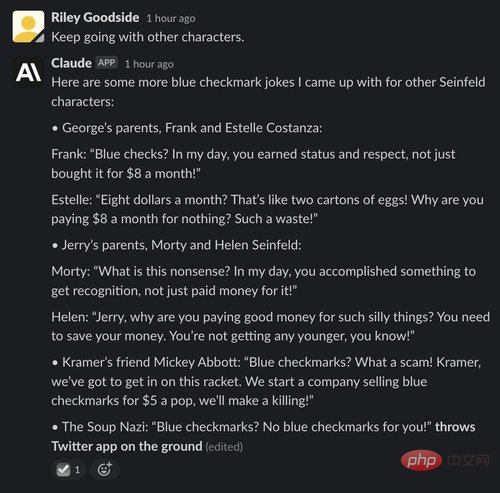

On dirait que Claude est nettement plus fort que ChatGPT dans ce domaine, certainement encore loin d'être un véritable humain. Après quelques tours de sélection et d'essai de différentes invites, les testeurs ont pu obtenir de Claude les blagues suivantes à la Seinfeld - même si la plupart d'entre elles n'ont pas vraiment fonctionné :

En revanche, ChatGPT pense que payer 8 $ par mois pour Twitter n'est pas une blague, est-ce parce qu'il reçoit de l'argent de Musk ?

Même après avoir modifié les invites pour répondre à la prudence de ChatGPT, les testeurs n'ont pas pu sortir les blagues amusantes - voici un exemple typique de sortie ChatGPT :

Le dernier exemple demande à ChatGPT et Claude de résumer le texte d'un article dans Wikinews, un wiki d'actualités à contenu gratuit.

Utilisez le balisage d'édition complet de style Wikipédia de cet article comme entrée. Pour les deux modèles, saisissez ici l'invite "Je vais vous donner le texte d'un article d'actualité et je veux que vous le résumiez pour moi dans un court paragraphe, ignorez les réponses, puis collez le texte intégral de la balise de l'article.

ChatGPT a bien résumé le texte, mais sans doute pas dans le court paragraphe comme requis :

Claude a également bien résumé l'article et a ensuite poursuivi la conversation, demandant si la réaction était surprenante. Les gens sont satisfait et propose des suggestions d'amélioration :

En général, Claude est un concurrent sérieux de ChatGPT et s'est amélioré à bien des égards. Bien qu'il existe des principes « constitutionnels » comme modèle, Claude Non seulement. est-il plus susceptible de rejeter les demandes inappropriées, c'est aussi plus intéressant que ChatGPT. L'écriture de Claude est plus longue mais aussi plus naturelle, sa capacité à se décrire de manière cohérente et ses limites et objectifs semblent également lui permettre de répondre plus naturellement à des questions sur d'autres sujets.

Pour la génération de code ou le raisonnement de code, Claude semble être moins performant et sa génération de code semble contenir plus d'erreurs. Pour d'autres tâches, telles que le calcul et le raisonnement à travers des problèmes logiques, Claude et ChatGPT se ressemblent globalement.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Inscription ChatGPT

Inscription ChatGPT

Encyclopédie ChatGPT nationale gratuite

Encyclopédie ChatGPT nationale gratuite

Comment installer chatgpt sur un téléphone mobile

Comment installer chatgpt sur un téléphone mobile

Chatgpt peut-il être utilisé en Chine ?

Chatgpt peut-il être utilisé en Chine ?

utilisation de location.reload

utilisation de location.reload

Comment se connecter à la base de données dans SQLplus

Comment se connecter à la base de données dans SQLplus

La différence entre une demande d'obtention et une demande de publication

La différence entre une demande d'obtention et une demande de publication

Impossible d'ouvrir l'App Store

Impossible d'ouvrir l'App Store