Périphériques technologiques

Périphériques technologiques

IA

IA

Comment définir correctement la formation en phase de test ? Méthodes d'inférence séquentielle et de clustering adaptatif au domaine

Comment définir correctement la formation en phase de test ? Méthodes d'inférence séquentielle et de clustering adaptatif au domaine

Comment définir correctement la formation en phase de test ? Méthodes d'inférence séquentielle et de clustering adaptatif au domaine

L'adaptation de domaine est une méthode importante pour résoudre l'apprentissage par transfert. Les méthodes actuelles d'adaptation de domaine reposent sur les données du domaine d'origine et du domaine cible pour la formation synchrone. Lorsque les données du domaine source ne sont pas disponibles et que les données du domaine cible ne sont pas complètement visibles, la formation au moment du test devient une nouvelle méthode d'adaptation de domaine. Les recherches actuelles sur la formation au temps de test (TTT) utilisent largement l'apprentissage auto-supervisé, l'apprentissage contrasté, l'auto-formation et d'autres méthodes. Cependant, la manière de définir la TTT dans des environnements réels est souvent ignorée, ce qui entraîne un manque de comparabilité entre les différentes méthodes.

Récemment, l'Université de Technologie de Chine du Sud, l'équipe A*STAR et le Laboratoire Pengcheng ont proposé conjointement un critère de classification systématique des problèmes TTT, en distinguant si la méthode a des capacités d'inférence séquentielle (Sequential Inference) et si la cible de formation du domaine source doit être modifié, fournit une classification détaillée des méthodes actuelles. Dans le même temps, une méthode basée sur le regroupement ancré des données du domaine cible est proposée, qui permet d'obtenir la plus grande précision de classification sous diverses classifications TTT. Cet article indique la bonne direction pour les recherches ultérieures sur le TTT et évite toute confusion dans les paramètres expérimentaux. ne sont pas comparables. Le document de recherche a été accepté pour NeurIPS 2022.

- Papier : https://arxiv.org/abs/2206.02721

- Code : https://github.com/Gorilla-Lab-SCUT/TTAC

1. Introduction

Le succès de l'apprentissage profond est principalement dû à la grande quantité de données étiquetées et à l'hypothèse selon laquelle l'ensemble d'entraînement et l'ensemble de test sont indépendants et distribués de manière identique. En général, lorsqu'il est nécessaire de s'entraîner sur des données synthétiques puis de tester sur des données réelles, les hypothèses ci-dessus ne peuvent pas être satisfaites, ce que l'on appelle également un changement de domaine. Pour atténuer ce problème, Domain Adaptation (DA) est née. Les tâches DA existantes nécessitent soit un accès aux données des domaines source et cible pendant la formation, soit une formation sur plusieurs domaines simultanément. Le premier nécessite que le modèle ait toujours accès aux données du domaine source pendant la formation à l'adaptation, tandis que le second nécessite des calculs plus coûteux. Afin de réduire la dépendance à l'égard des données du domaine source, les données du domaine source ne sont pas accessibles en raison de problèmes de confidentialité ou de surcharge de stockage. L'adaptation de domaine sans source (SFDA) sans données de domaine source résout le problème d'adaptation de domaine des données de domaine source inaccessibles. L'auteur a découvert que SFDA doit être formé sur l'ensemble des données cibles pendant plusieurs cycles pour parvenir à la convergence. SFDA ne peut pas résoudre de tels problèmes lorsqu'il est confronté à des données en streaming et à des prédictions d'inférence en temps opportun. Ce paramètre plus réaliste qui nécessite une adaptation rapide au streaming de données et à la réalisation de prédictions d'inférence est appelé Test-Time Training (TTT) ou Test-Time Adaptation (TTA).

L'auteur a remarqué qu'il existe une confusion dans la communauté sur la définition du TTT, ce qui conduit à une comparaison injuste. L'article classe les méthodes TTT existantes en fonction de deux facteurs clés :

- Pour les données qui apparaissent en continu et qui doivent faire des prédictions en temps opportun sur les données qui apparaissent actuellement, on parle de protocole d'adaptation en un seul tour (One-Pass). Adaptation) ; pour les autres protocoles qui ne répondent pas aux paramètres ci-dessus, appelés Adaptation Multi-Pass, le modèle devra peut-être être mis à jour pendant plusieurs tours sur l'ensemble de l'ensemble de test avant de faire des prédictions d'inférence du début à la fin.

- Modifiez l'équation de perte de formation du domaine source selon que cela est nécessaire, par exemple en introduisant des branches auto-supervisées supplémentaires pour obtenir un TTT plus efficace.

L'objectif de cet article est de résoudre le protocole TTT le plus réaliste et le plus difficile, c'est-à-dire une adaptation en un seul tour sans modifier l'équation de perte d'entraînement. Ce paramètre est similaire au TTA proposé par TENT [1], mais ne se limite pas à l'utilisation d'informations légères du domaine source, telles que les statistiques des fonctionnalités. Étant donné l’objectif de TTT de s’adapter efficacement au moment du test, cette hypothèse est efficace sur le plan informatique et améliore considérablement les performances de TTT. Les auteurs ont nommé ce nouveau protocole TTT Séquentiel Test Time Training (sTTT).

En plus de la classification ci-dessus des différentes méthodes TTT, l'article propose également deux technologies pour rendre le sTTT plus efficace et précis :

- L'article propose la méthode Test-Time Anchored Clustering (TTAC).

- Afin de réduire l'impact des pseudo-étiquettes erronées sur les mises à jour des clusters, le document filtre les pseudo-étiquettes en fonction de la stabilité des prédictions du réseau et de la confiance dans l'échantillon.

2. Introduction à la méthode

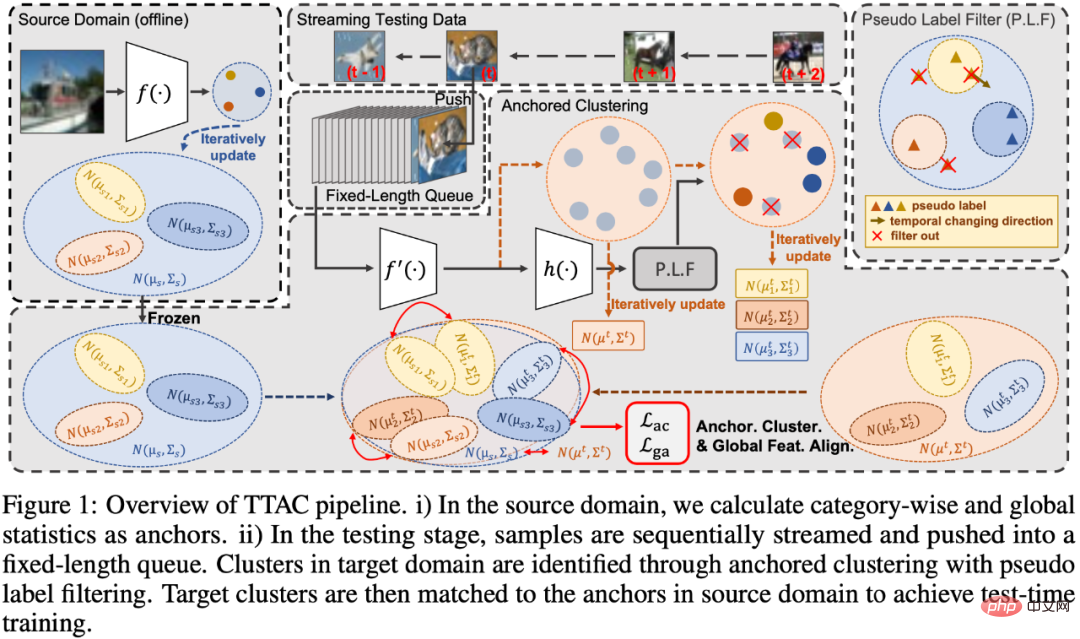

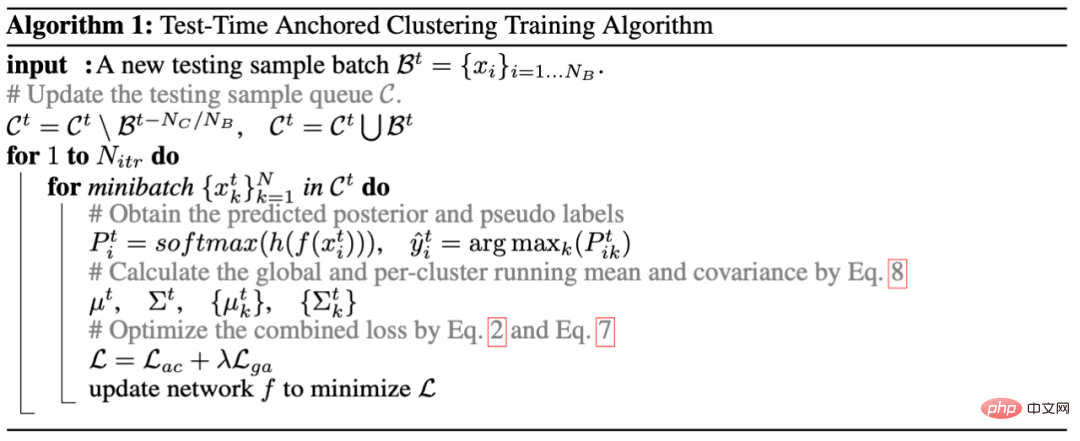

Le document est divisé en quatre parties pour expliquer la méthode proposée, qui sont 1) l'introduction du module de clustering ancré de la formation au temps de test (TTT), comme indiqué dans la partie Clustering ancré dans Figure 1 ; 2) Présenter quelques stratégies de filtrage des pseudo-étiquettes, telles que la partie Pseudo Label Filter de la Figure 1 ; 3) Différent de l'utilisation de la distance L2 pour mesurer la distance entre deux distributions dans TTT++ [2], l'auteur utilise la divergence KL pour mesurer la distance entre deux distributions. Mesurer la distance entre deux distributions globales de fonctionnalités ; 4) Introduire une méthode itérative efficace pour mettre à jour les statistiques de fonctionnalités dans le processus de formation au temps de test (TTT). Enfin, la cinquième section donne le code du processus de l'ensemble de l'algorithme.

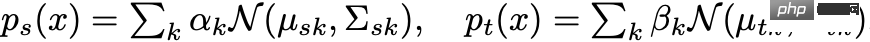

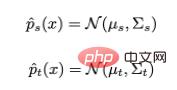

Partie 1 Dans le clustering ancré, l'auteur utilise d'abord un mélange de gaussiennes pour modéliser les caractéristiques du domaine cible, où chaque composante gaussienne représente un cluster découvert. Les auteurs utilisent ensuite la distribution de chaque catégorie dans le domaine source comme points d'ancrage pour la distribution dans le domaine cible pour la mise en correspondance. De cette manière, les fonctionnalités des données de test peuvent former des clusters en même temps, et les clusters sont associés à des catégories de domaine source, réalisant ainsi une généralisation au domaine cible. Pour résumer, les caractéristiques du domaine source et du domaine cible sont modélisées respectivement en fonction des informations de catégorie :

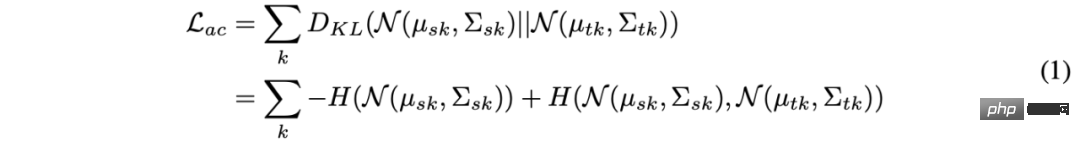

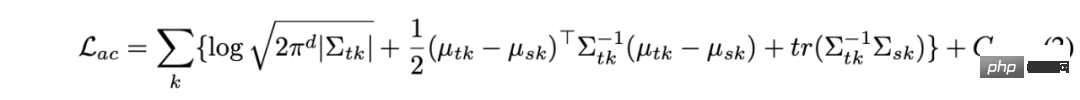

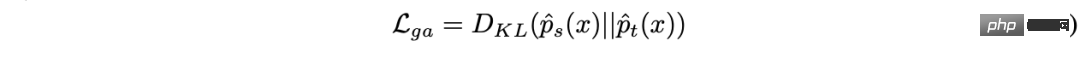

Ensuite, la distance entre deux distributions gaussiennes mixtes est mesurée par la divergence KL et obtenue en réduisant la divergence KL. de deux fonctionnalités de domaine. Cependant, il n’existe pas de solution fermée pour résoudre directement la divergence KL sur deux distributions gaussiennes mixtes, ce qui rend impossible l’utilisation de méthodes efficaces d’optimisation de gradient. Dans cet article, l'auteur alloue le même nombre de clusters dans les domaines source et cible, et chaque cluster de domaine cible est attribué à un cluster de domaine source, de sorte que la solution de divergence KL de l'ensemble de la Gaussienne mixte puisse être transformée en chaque paire Somme des divergences KL entre gaussiennes. La formule est la suivante :

La solution sous forme fermée de la formule ci-dessus est :

Dans la formule 2, les paramètres du cluster de domaine source peuvent être collectés hors ligne, et parce que seuls des éléments légers Les statistiques sont des données utilisées, elles ne provoquent donc pas de problèmes de fuite de confidentialité et n'utilisent qu'une petite quantité de surcharge de calcul et de stockage. Pour les variables du domaine cible, l'utilisation de pseudo-étiquettes est impliquée. Pour cela, l'auteur a conçu une stratégie de filtrage de pseudo-étiquettes efficace et légère.

La deuxième partie de la stratégie de filtrage des pseudo-étiquettes est principalement divisée en deux parties :

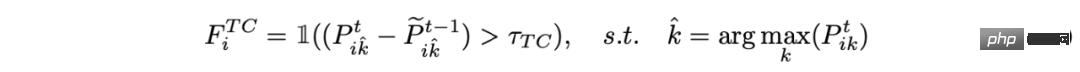

1) Filtrage pour une prédiction cohérente dans les séries temporelles :

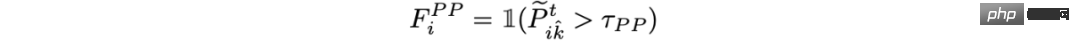

2) Filtrage basé sur la probabilité a posteriori :

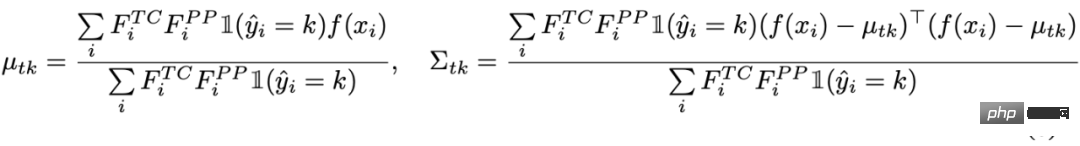

Enfin, utilisez les échantillons filtrés pour résoudre les statistiques du cluster de domaine cible :

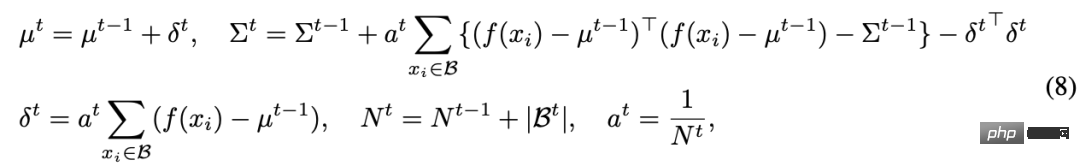

Partie 3 Car dans le clustering ancré, certains échantillons filtrés ne participent pas à l'estimation du domaine cible. L'auteur effectue également un alignement global des fonctionnalités sur tous les échantillons de test, similaire à l'approche des clusters dans le clustering ancré. Ici, tous les échantillons sont considérés comme un cluster global, défini respectivement dans le domaine source et le domaine cible

puis. encore une fois Alignez la distribution globale des fonctionnalités dans le but de minimiser la divergence KL :

La partie 4 et les trois parties ci-dessus introduisent toutes des méthodes d'alignement de domaine, mais dans le processus TTT, vous souhaitez estimer la distribution d'une cible Le domaine n'est pas simple car nous ne pouvons pas observer les données de l'ensemble du domaine cible. Dans un travail de pointe, TTT++ [2] utilise une file d'attente de fonctionnalités pour stocker des échantillons partiels passés afin de calculer une distribution locale afin d'estimer la distribution globale. Mais cela entraîne non seulement une surcharge de mémoire, mais conduit également à un compromis entre précision et mémoire. Dans cet article, l'auteur propose une mise à jour itérative des statistiques pour réduire la surcharge de mémoire. La formule de mise à jour itérative spécifique est la suivante :

En général, l'ensemble de l'algorithme est présenté comme suit. Algorithme 1 :

3. Résultats expérimentaux

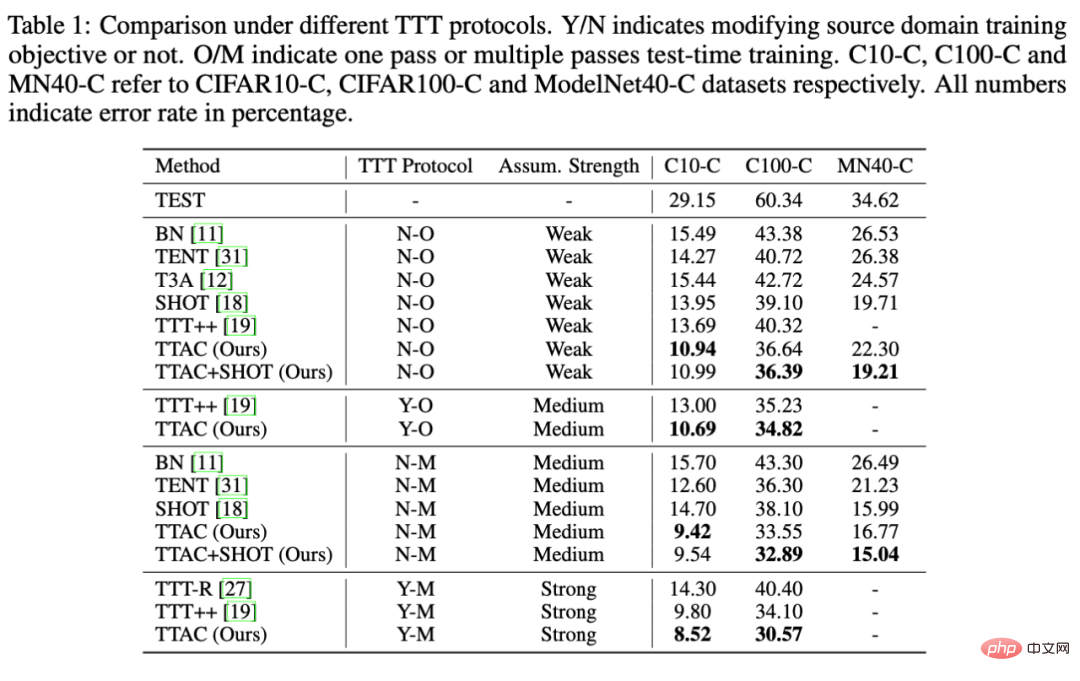

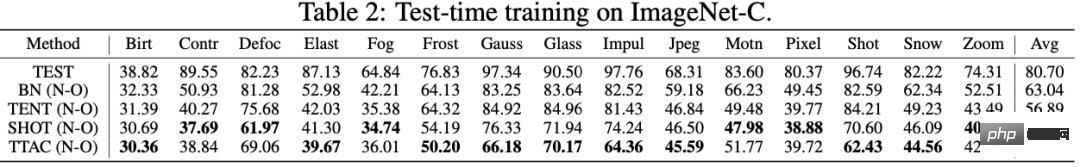

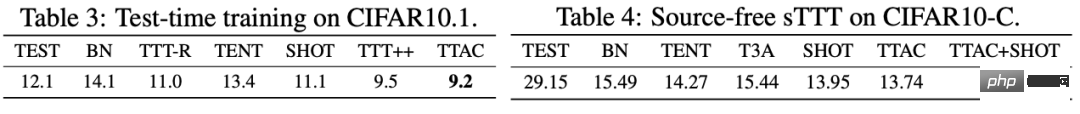

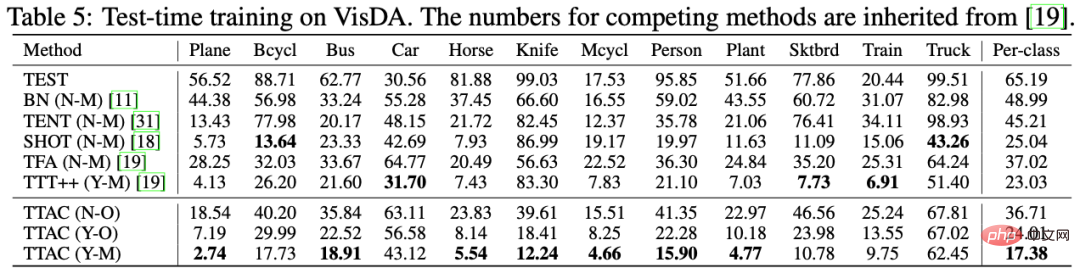

Comme mentionné dans l'introduction, cet article L'auteur accorde une grande attention à la comparaison équitable des différentes méthodes selon différentes stratégies TTT. L'auteur classe toutes les méthodes TTT selon les deux facteurs clés suivants : 1) s'il s'agit d'un protocole d'adaptation en un seul passage (One-Pass Adaptation) et 2) la modification de l'équation de perte d'apprentissage du domaine source, respectivement enregistrée comme O/N pour indiquer le besoin ou non de modifier l'équation de formation du domaine source, O/M représente une adaptation en un seul tour ou une adaptation en plusieurs tours. En outre, l'auteur a mené suffisamment d'expériences comparatives et des analyses plus approfondies sur 6 ensembles de données de référence.

Comme le montre le tableau 1, TTT++[2] apparaît sous les protocoles N-O et Y-O car TTT++[2] a une branche auto-supervisée supplémentaire. Nous n'ajouterons pas de branche auto-supervisée sous la perte de protocole N-O. alors que la perte de cette molécule peut être utilisée normalement sous Y-O. TTAC utilise également la même branche auto-supervisée que TTT++[2] sous YO. Comme le montre le tableau, TTAC a obtenu des résultats optimaux sous tous les protocoles TTT et tous les ensembles de données ; sur les ensembles de données CIFAR10-C et CIFAR100-C, TTAC a obtenu une amélioration de plus de 3 %. Tableau 2 - Le tableau 5 montre que les données sur ImageNet-C, CIFAR10.1 et VisDA ont respectivement obtenu les meilleurs résultats.

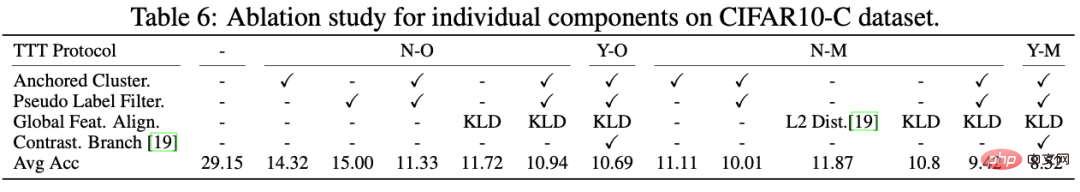

De plus, l'auteur a mené des expériences d'ablation rigoureuses sous plusieurs protocoles TTT en même temps et a clairement vu le rôle de chaque composant, comme le montre le tableau 6. Tout d'abord, à partir de la comparaison entre L2 Dist et KLD, on peut voir que l'utilisation de la divergence KL pour mesurer les deux distributions a un meilleur effet. Deuxièmement, on constate que si le clustering ancré ou la supervision de pseudo-étiquettes est utilisé seul, le L'amélioration n'est que de 14 %, mais si elle est combinée avec le cluster ancré et le filtre de pseudo-étiquette, vous pouvez constater une amélioration significative des performances de 29,15 % -> 11,33 %. Cela montre également la nécessité et la combinaison efficace de chaque composant.

Enfin, l'auteur analyse entièrement le TTAC à partir de cinq dimensions à la fin du texte, y compris les performances cumulées sous sTTT (N-O), la visualisation TSNE des fonctionnalités TTAC, l'analyse TTT indépendante du domaine source et l'analyse des échantillons de test. files d'attente et cycles de mise à jour, surcharge de calcul mesurée en temps d'horloge murale. Il existe des preuves et des analyses plus intéressantes présentées en annexe de l'article.

IV.Résumé

Cet article ne présente que brièvement les points de contribution de ce travail du TTAC : comparaison de classification des méthodes TTT existantes, des méthodes proposées et des expériences sous chaque classification de protocole TTT. Il y aura une discussion et une analyse plus détaillées dans le document et en annexe. Nous espérons que ce travail fournira une référence équitable pour les méthodes TTT et que les futures études pourront comparer leurs protocoles respectifs.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles