Le développement de DPU devrait entrer sur la voie rapide. Le DPU (Data Processing Unit) est considéré comme la « troisième puce principale » après le CPU et le GPU. Grâce à la maturité progressive des solutions de cartes réseau intelligentes, à la croissance constante des expéditions mondiales de serveurs à usage général, à la mise en œuvre de la technologie des véhicules de conduite intelligents L3 et supérieurs et à la demande croissante dans le domaine du contrôle industriel, les industries DPU mondiales et nationales sont devrait connaître un développement rapide.

Le marché mondial du DPU continue d'être en plein essor et le marché national du DPU accélère son rattrapage. Selon le « Livre blanc sur le développement de l'industrie DPU en Chine » de CCID Consulting, la taille du marché mondial de l'industrie DPU atteindra 3,05 milliards de dollars américains en 2020. On s'attend à ce que la taille du marché mondial de l'industrie DPU dépasse 24,53 milliards de dollars américains d'ici 2025. , avec un taux de croissance composé de 5,173 % %.

La taille du marché chinois de l'industrie DPU a atteint 390 millions de yuans en 2020. On s'attend à ce que la taille du marché chinois de l'industrie DPU dépasse 56,59 milliards de yuans d'ici 2025, avec un taux de croissance composé de 170,6 %.

Analyse de la chaîne industrielle DPU :

Lien intermédiaire DPU (fabricants de puces DPU) : les géants étrangers sont temporairement en tête et les fabricants nationaux sont prêts à partir. Selon les données de l'Institut de recherche Toubao, sur le marché national des DPU en 2020, les parts des trois géants internationaux NVIDIA, Broadcom et Intel ont atteint respectivement 55 %, 36 % et 9 %. Parmi les fabricants nationaux, Huawei, Alibaba, Baidu et Tencent ont également développé et externalisé des DPU pour leurs propres serveurs ces dernières années. Les principales fonctions sont les données, le stockage et la sécurité.

Liens amont DPU : EDA, IP, etc. sont autant de fondements importants pour la recherche et le développement. Le marché national de l'EDA a longtemps été dominé par les trois géants internationaux et devrait connaître une percée à l'avenir. L’offre et la demande travaillent ensemble pour nourrir le secteur de base de la propriété intellectuelle, et la demande future ouvrira de nouveaux canaux. La localisation des semi-conducteurs continue d'évoluer et les fournisseurs nationaux de propriété intellectuelle occuperont les hauteurs de la valeur de rareté, notamment Cambrian, VeriSilicon, etc.

Applications DPU en aval : floraisons multiples, perspectives d’avenir prometteuses. Le principal marché du DPU s'articule autour des centres de données, avec des serveurs comme supports matériels, et des scénarios en aval couvrant le cloud computing, le calcul haute performance, la sécurité des réseaux, l'informatique de pointe et d'autres domaines. Du point de vue de notre pays, divers scénarios de demande de puissance de calcul tels que les hautes et nouvelles technologies, la transformation numérique et la consommation des terminaux émergent constamment, et l'effet d'autonomisation de la puissance de calcul est important.

Dans le cadre de la tendance générale de développement de la technologie d'IA telle que ChatGPT, la demande de puissance de calcul est devenue importante. année, et les entreprises principales devraient bénéficier de la tendance au développement de l’industrie.

DPU (Data Processing Unit) est considérée comme la "troisième puce principale" après le CPU et le GPU. DPU (Data Processing Unit) est un processeur spécialisé nouvellement développé. Dans la stratégie produit DPU publiée par NVIDIA en 2020, il se positionne comme la « troisième puce principale » du centre de données après le CPU et le GPU. Avec l’amélioration continue des processus de fabrication dans l’industrie des puces et le développement de technologies numériques telles que l’IA, l’industrie des puces continue d’innover. En tant que nouveau type de puce, l'émergence du DPU constitue une étape importante dans l'informatique hétérogène.

1. Il existe un écart entre l'amélioration de la puissance de calcul et la croissance des données, et la demande de DPU est mise en évidence

DPU est une unité de traitement de données dédiée avec le traitement des données comme noyau. pour le réseau, la sécurité et le stockage des ressources informatiques traditionnelles. Les centres de données traditionnels utilisent le processeur comme principale unité de traitement des données, et le fonctionnement de l'énorme infrastructure occupe généralement une part considérable des cœurs du processeur, ce qui pose de grands défis aux tâches de traitement des données.

DPU est en fait présent dans l'industrie depuis longtemps, depuis le déchargement précoce du traitement du protocole réseau jusqu'au déchargement ultérieur du réseau, du stockage et de la virtualisation.

Selon les données de la grande roue, AWS d'Amazon a développé le produit Nitro dès 2013, qui a placé toutes les dépenses du centre de données (fourniture de ressources à distance pour les machines virtuelles, cryptage et déchiffrement, suivi des pannes, politiques de sécurité et autres programmes de services) sur des accélérateurs dédiés. . L'architecture Nitro utilise un hyperviseur léger et du matériel personnalisé pour séparer les sous-systèmes informatiques (principalement CPU et mémoire) et d'E/S (principalement réseau et stockage) de la machine virtuelle et les connecter via le bus PCIe, économisant ainsi 30 % des ressources CPU.

En 2016-2017, Alibaba Cloud a proposé l'architecture système X-Dragon, dont le cœur est la carte MOC et possède une interface externe relativement riche, comprenant des ressources informatiques, des ressources de stockage et des ressources réseau. X-Dragon SOC, le cœur de la carte MOC, prend en charge uniformément la virtualisation du réseau, des E/S, du stockage et des périphériques, et fournit un pool de ressources unifié pour les machines virtuelles, le bare metal et les cloud de conteneurs.

Selon les données de NetEase et Xinxi East, en 2019, Fungible, une startup américaine, a lancé le produit F1DPU, proposant pour la première fois le concept de DPU. En octobre 2020, NVIDIA a nommé la Smart NIC basée sur la solution Mellanox DPU, redéfinissant ainsi le concept de DPU. En 2020, la stratégie produit DPU publiée par Nvidia l'a positionné comme la « troisième puce principale » des centres de données après le CPU et le GPU, déclenchant un engouement dans l'industrie.

2. Dans le but de réduire les coûts et d'améliorer l'efficacité, DPU s'attaque directement aux problèmes de l'industrie

Le problème principal que DPU veut résoudre est la « réduction des coûts et l'amélioration de l'efficacité » de l'infrastructure, c'est-à-dire la La charge que « l'efficacité du traitement du processeur est faible et que le GPU ne peut pas gérer » est déchargée sur un DPU dédié, améliore l'efficacité de l'ensemble du système informatique et réduit le coût total de possession (TCO) de l'ensemble du système.

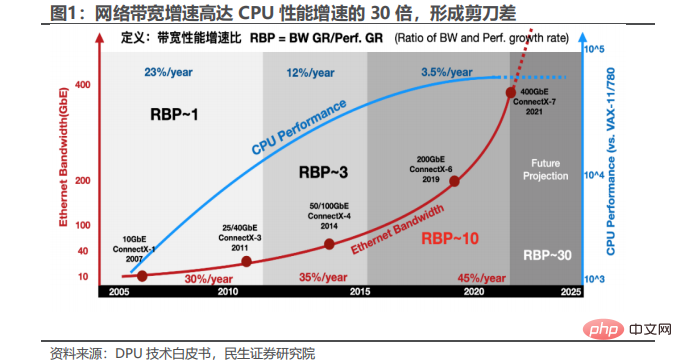

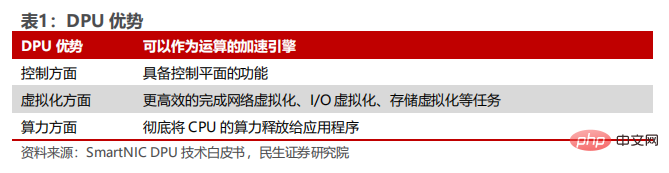

La charge excessive des ressources CPU est un problème dans l'industrie, et Smart NIC est le prédécesseur du DPU. Dans le domaine des communications, avec l'avènement de l'ère de la 5G, l'intégration des réseaux cloud et l'introduction de technologies telles que la commutation virtuelle, la complexité du plan de données du réseau basé sur serveur a considérablement augmenté. Un travail massif de transfert de données est supporté par le processeur, ce qui entraîne une forte augmentation de la bande passante de l'interface réseau et une charge excessive des ressources du processeur, ce qui affecte grandement la capacité du processeur à libérer de la puissance de calcul dans les applications afin d'améliorer les performances de traitement du processeur hôte. La carte réseau intelligente (carte réseau intelligente) sera transférée à certaines fonctions réseau du processeur (telles que la fragmentation IP, la segmentation TCP, etc.) vers le matériel de la carte réseau dans le but d'accélérer les opérations. Elle peut être considérée comme le prédécesseur du DPU. . L'avantage de la nouvelle génération de DPU est qu'elle peut non seulement servir de moteur d'accélération pour le calcul, mais a également la fonction d'un plan de contrôle, qui peut accomplir plus efficacement des tâches telles que la virtualisation du réseau, la virtualisation des E/S et le stockage. virtualisation et utiliser pleinement la puissance de calcul du processeur libérée pour l'application.

En termes de fonctions, DPU a de multiples fonctions telles que l'intégration de services de base, l'accélération des données réseau, la protection Zero Trust et la séparation de l'informatique et du stockage. Il peut résoudre efficacement de nombreux problèmes tels que l'incapacité de la puissance de calcul actuelle du processeur à s'appliquer pleinement aux applications, la lenteur du traitement des données, les fuites de données causées par le crédit et la mauvaise compatibilité des solutions de stockage. Plus précisément :

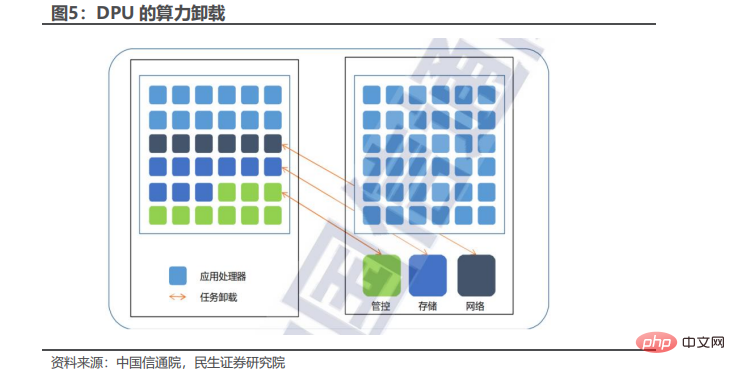

1. DPU réalise la séparation opérationnelle des activités et des infrastructures. DPU transfère les tâches d'infrastructure du CPU au DPU, libérant ainsi les ressources du CPU afin que davantage de cœurs de CPU du serveur puissent être utilisés pour exécuter des applications et effectuer des calculs commerciaux, améliorant ainsi l'efficacité des serveurs et des centres de données.

2.DPU décharge les données du réseau pour améliorer les performances. DPU est optimisé pour les environnements cloud natifs, fournissant des services de mise en réseau, de stockage, de sécurité et de gestion définis par logiciel et accélérés par le matériel au niveau du centre de données. Selon les données de Programmer Inn, la plate-forme cloud conteneurisée en tant que service (PaaS) de Red Hat 0penShift utilise DPU pour optimiser l'utilisation des ressources du centre de données et décharger le traitement des données liées au réseau (comme VxLan et IPSec, etc.) vers DPU pour accélérer l'exécution. dans des conditions de réseau de 25 Gbit/s, Open Shift déploie le DPU pour l'accélération et peut atteindre des performances de 25 Gbit/s avec seulement 1/3 de l'utilisation du processeur. Cependant, dans des conditions de réseau de 100 Gbit/s, le scénario sans déploiement de DPU atteindra 25 Gbit/s. À une vitesse de ligne réseau inférieure à 100 Gb/s, le DPU peut apporter un avantage en termes de performances 10 fois supérieur.

3.DPU peut fournir une protection de sécurité Zero Trust. Zero Trust est un modèle centré sur la sécurité basé sur l'idée que les entreprises ne devraient pas accorder d'options de confiance par défaut à quoi que ce soit à l'intérieur ou à l'extérieur d'elles. La confiance zéro peut réduire les fuites de données et refuser les accès non autorisés, elle est donc d'une grande valeur en matière de sécurité des données.

Méthode : DPU offre une protection zéro confiance aux entreprises en décentralisant le plan de contrôle de l'hôte vers le DPU, obtenant ainsi une isolation complète de l'activité hôte et du plan de contrôle, et les données ne pourront pas pénétrer, garantissant ainsi la sécurité.

L'émergence du DPU équivaut à équiper chaque serveur d'un « ordinateur devant l'ordinateur » pour fournir des services d'infrastructure indépendants et sécurisés et une isolation sécurisée du domaine d'application du serveur. Si un hôte est compromis, la couche d'isolation DPU entre l'agent de contrôle de sécurité et l'hôte compromis empêche l'attaque de se propager dans tout le centre de données. De cette manière, DPU résout la situation dans laquelle les entreprises ne souhaitent pas déployer des agents de sécurité directement sur la plate-forme informatique. En déployant des agents de sécurité sur des DPU complètement isolés des domaines d'application, les entreprises gagnent en visibilité sur les charges de travail des applications et appliquent des politiques de sécurité cohérentes dans leur infrastructure.

4. DPU permet de réaliser une « séparation du calcul et du stockage ». La solution technologique BlueField SNAP introduit des ressources informatiques à l'entrée des données du système serveur et met en œuvre de manière indépendante des solutions de stockage qui répondent aux besoins des applications sur le DPU, aidant ainsi les fabricants de stockage à réduire les coûts des données. centre. Déployez et mettez à niveau de manière flexible les protocoles de stockage avancés sans aucune modification de la pile logicielle existante. Les fabricants de stockage peuvent utiliser le stockage à connexion directe (DAS) à système ouvert, l'expansion verticale (Scale-up), l'expansion horizontale (Scale-out), l'architecture hyperconvergée (Hyperconverged) et d'autres solutions de stockage développées par leurs propres équipes pour diverses applications industrielles. peut être étendu aux plates-formes de traitement d'entreprise et à l'infrastructure de centre de données existantes dans divers domaines d'application sans aucune surcharge, et toutes les fonctions complexes et nécessaires telles que le cryptage de sécurité, la compression des données et l'équilibrage de charge sont déchargées de manière totalement transparente par le DPU. Les algorithmes et implémentations innovants du secteur du stockage peuvent être déployés dans l'architecture DPU indépendamment du système d'exploitation du serveur. La technologie DPU aide les fabricants de systèmes de stockage à réaliser une véritable « séparation entre l'informatique et le stockage », à exploiter pleinement les avantages techniques de leurs propres produits et à ouvrir des canaux pour répondre plus efficacement aux besoins des applications.

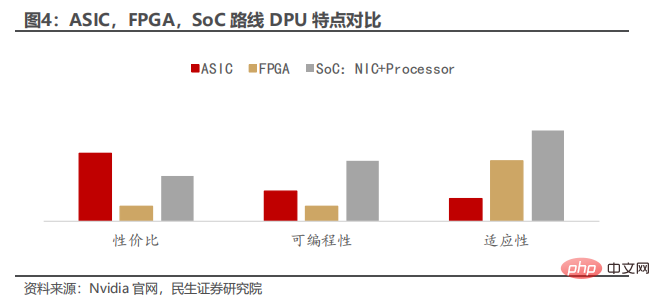

3. S'appuyant sur des cartes réseau intelligentes, les FPGA et les architectures hybrides sont les principales cartes réseau intelligentes qui peuvent être considérées comme le prédécesseur du DPU, y compris les ASIC basés sur plusieurs cœurs de processeur et les cartes réseau intelligentes basées sur FPGA. À mesure que la technologie évolue, les FPGA, les ASIC et les SoC fusionnent les uns avec les autres, et les frontières entre eux deviennent de plus en plus floues. Par exemple, avec le développement des FPGA, de nombreux FPGA intègrent désormais des cœurs durs. Ce noyau dur est un ASIC au sens traditionnel ; du point de vue de la programmabilité matérielle, le SoC est l'opposé du FPGA, et il peut être considéré ici comme un ASIC. fait principalement référence au matériel qui n'est pas programmable, plutôt que de se référer uniquement à une puce fonctionnelle spécifique.

NIC signifie Carte d'Interface Réseau. Essentiellement, une carte réseau est une carte PCIe qui se branche sur un serveur ou un boîtier de stockage pour se connecter à un réseau Ethernet. Les cartes réseau intelligentes basées sur DPU vont au-delà de la simple connectivité et, dans le cas d'une carte réseau de base, implémentent le traitement du trafic réseau que le processeur doit effectuer sur la carte réseau.

La Smart NIC basée sur DPU peut être basée sur ASIC, FPGA et SoC. Il existe divers compromis entre ces différentes voies en termes de coût, de facilité de programmation et de flexibilité. 1) Les ASIC sont rentables et peuvent offrir le meilleur rapport prix/performances, mais ont une flexibilité limitée. Les cartes réseau basées sur ASIC, telles que NVIDIA ConnectX-5, peuvent avoir des chemins de données programmables relativement simples. En fin de compte, la fonctionnalité est limitée en fonction des capacités définies dans l'ASIC, ce qui peut empêcher la prise en charge de certaines charges de travail. 2) En revanche, les cartes réseau FPGA (telles que NVIDIA Innova-2 Flex) sont hautement programmables. Avec suffisamment de temps et d'efforts, presque toutes les fonctionnalités peuvent être prises en charge de manière relativement efficace dans les contraintes des portes disponibles. Cependant, les FPGA sont notoirement difficiles et coûteux à programmer. 3) Pour les cas d'utilisation plus complexes, les SOC tels que le Mellanox BlueField DPU – Programmable Smart NIC fournissent ce qui semble être la meilleure implémentation de Smart NIC basée sur DPU.

1. c'est-à-dire utiliser DPU pour intégrer certaines fonctions de base du traitement des données, puis décharger ces fonctions du processeur pour augmenter la puissance de calcul du processeur pour certaines applications. Une partie de la valeur du DPU se reflète dans la réduction du coût de cette partie de la puissance de calcul - le coût du DPU lui-même. Par conséquent, plus le DPU économise de la puissance de calcul, ou plus son coût est bas, plus sa valeur est élevée. Dans le même temps, en raison de la spécialisation du DPU, les performances commerciales seront améliorées une fois que le DPU aura déchargé certaines fonctions de contrôle liées au réseau, au stockage, à la sécurité et à la gestion. Par conséquent, une autre partie de la valeur du DPU réside dans le. du temps que cela peut faire gagner à l'entreprise et à l'expérience utilisateur.

Selon les données de Technology Neighbour, dans les scénarios de grands centres de données, la fonction de déchargement de la puissance de calcul du DPU peut être utilisée pour réduire les taxes sur les centres de données. Étant donné que le traitement du trafic dans le centre de données représente 30 % des ressources informatiques, AWS appelle ces ressources informatiques qui seront occupées par l'accès aux données du réseau avant d'exécuter les programmes commerciaux « Taxe du centre de données ».

Dans les scénarios de sécurité des données, grâce à son architecture indépendante et sécurisée, DPU peut solidifier une partie des algorithmes de cryptage et de déchiffrement dans le matériel DPU, résolvant les problèmes de sécurité des données des utilisateurs dans des données massives de manière physiquement isolée et fournissant des services pour les utilisateurs externes. services réseau. Fournit une couche de sécurité supplémentaire entre les locataires.

2. Selon les données de l'Académie chinoise des technologies de l'information et des communications, libération de la puissance de calcul : la libération de la puissance de calcul ne nécessite pas l'intervention du processeur pour accéder plusieurs fois à la mémoire et aux périphériques, évite les transferts de données, les copies et les changements de contexte inutiles, et complète directement les données. traitement sur le matériel de la carte réseau. Livré à l'application qui consomme finalement les données. L'architecture informatique traditionnelle centrée sur le processeur doit copier et accéder aux données entre le noyau et l'application plusieurs fois au cours du traitement des données, ce qui entraîne d'énormes pertes de performances. L'architecture DPU centrée sur les données peut améliorer efficacement le problème de l'implication excessive du processeur dans le traitement des données. Le processeur n'est pas obligé de participer au processus de traitement des données, et les données sont directement envoyées à l'application, au GPU associé ou au périphérique de stockage, qui peut le faire. évitez efficacement les goulots d'étranglement des performances et les exceptions causées par une charge excessive du processeur.

L'architecture et la technologie DPU permettent aux applications métier et aux noyaux de systèmes d'exploitation exécutés sur des serveurs d'obtenir un accès efficace et transparent aux systèmes de stockage distribués, hyper-convergés ou définis par logiciel à l'aide de simples API d'accès au stockage local. Les fabricants de stockage peuvent promouvoir le stockage à connexion directe (DAS), l'expansion verticale (Scale-up), l'expansion horizontale (Scale-out), l'architecture hyperconvergée (Hyperconverged) et d'autres solutions de stockage développées pour diverses applications industrielles à un coût nul dans l'entreprise existante. plates-formes de traitement et infrastructures de centres de données dans divers domaines d'application, toutes les fonctions complexes et nécessaires telles que le cryptage de sécurité, la compression des données et l'équilibrage de charge sont déchargées de manière totalement transparente par le DPU. Les algorithmes et implémentations innovants du secteur du stockage peuvent être déployés indépendamment du système d'exploitation du serveur dans une architecture DPU.

La technologie DPU aide les fabricants de stockage à réaliser une véritable « séparation de l'informatique et du stockage », à exploiter pleinement les avantages techniques de leurs propres produits et à ouvrir la manière la plus efficace de répondre aux besoins des applications.

3. Extension de la puissance de calcul : l'extension de la puissance de calcul élimine les goulots d'étranglement de la communication réseau entre nœuds en évitant efficacement la congestion, en réduisant considérablement la proportion de temps de communication dans le cycle de tâches des applications distribuées et en améliorant le cluster informatique global à grande échelle. dimension du cluster. Afin d’améliorer la puissance de calcul, l’industrie continue d’évoluer sur plusieurs voies. Il est difficile pour les processeurs à usage général de continuer à augmenter considérablement la puissance de calcul en améliorant les performances monocœur et monothread et en développant le multicœur sur puce. Après la mise à niveau du processus des puces monocœur à 3 nm, le développement a ralenti ; en superposant plusieurs cœurs pour augmenter la puissance de calcul, à mesure que le nombre de cœurs augmente, la consommation d'énergie par unité de puissance de calcul augmentera également de manière significative. 256 cœurs, le niveau total de puissance de calcul Il ne peut pas être amélioré de manière linéaire. L'évolution technologique des unités informatiques s'est rapprochée du niveau de référence. Afin de répondre à la demande de grande puissance de calcul, l'expansion des clusters informatiques, l'augmentation de la bande passante du réseau et la réduction de la latence du réseau grâce aux systèmes distribués sont devenus les principaux moyens d'améliorer la puissance de calcul. de clusters de centres de données.

5. Le DPU entraîne une interconnexion de puissance de calcul hétérogène, et le marché des applications couvre de nombreux domaines des industries de haute technologie

L'interconnexion de puissance de calcul hétérogène est la connexion de données entre GPU, FPGA, ASIC ou autres cartes accélératrices et CPU. La technologie d'interconnexion des puces formée entre le processeur et la carte accélératrice, ainsi qu'entre la carte accélératrice, est davantage adoptée. Bien que PCIe ait une conception standardisée très courante, une bande passante limitée créera des goulots d'étranglement. Les technologies d'interconnexion de nouvelle génération telles que CXL et Gen-Z ont connu un développement rapide. En tant que bac à sable pour l'intégration de divers protocoles d'interconnexion à haut débit, DPU est le plus approprié pour devenir un opérateur d'interconnexion à haut débit flexible. centré sur la mémoire" Le protocole d'interconnexion offrira l'opportunité d'étendre la technologie de latence inférieure à la microseconde en dehors d'un seul châssis, créant ainsi des possibilités d'innovation en matière d'architecture informatique de nouvelle génération.

Avec l'approfondissement de la construction et des applications de l'informatisation, le marché continue de croître et la demande d'applications industrielles DPU dans les domaines des télécommunications, d'Internet, de la conduite intelligente, des serveurs d'IA et d'autres secteurs continue de croître.

1) Dans le domaine des télécommunications, les trois principaux opérateurs déploient activement, favorisent la vérification des produits et sont disposés à coopérer avec les fabricants de la chaîne industrielle pour promouvoir le développement de l'industrie DPU.

2) Dans le domaine d'Internet, avec les besoins de développement du cloud computing, du cloud natif et d'autres scénarios commerciaux, le DPU, en tant que centre d'évolution des centres de données, a reçu une large attention de la part des principaux fournisseurs de cloud. Les principaux fabricants ont investi des ressources dans l’auto-recherche ou la coopération stratégique pour réduire les coûts et accroître l’efficacité afin de maximiser les bénéfices.

3) Dans le domaine de la conduite intelligente, les fabricants de puces nationaux et étrangers accélèrent le déploiement de la conduite intelligente, améliorent continuellement l'efficacité de la recherche et du développement et jettent les bases du développement du marché du DPU.

4) Concernant les serveurs d'IA et d'autres domaines, sous l'influence de politiques telles que l'économie numérique et le « Eastern Digital and Western Counting », les serveurs d'IA, la finance, les entreprises publiques terminales et d'autres domaines de la Chine continuent de se développer rapidement, et la demande car la puissance de calcul continue d'augmenter. , la technologie traditionnelle ne peut plus répondre aux besoins actuels de développement commercial, peut fournir des solutions d'accélération matérielle matures, améliorer l'efficacité de l'ensemble du système, fournir un support technique pour le développement de serveurs d'IA, la finance et d'autres domaines. , et promouvoir de manière globale le processus de développement futur de l’industrie DPU.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que faire si la température du processeur est trop élevée

Que faire si la température du processeur est trop élevée

Une mémoire capable d'échanger des informations directement avec le CPU est une

Une mémoire capable d'échanger des informations directement avec le CPU est une

Les principaux composants qui composent le CPU

Les principaux composants qui composent le CPU

Inscription ChatGPT

Inscription ChatGPT

Quels sont les paramètres de configuration du serveur vidéo ?

Quels sont les paramètres de configuration du serveur vidéo ?

Encyclopédie ChatGPT nationale gratuite

Encyclopédie ChatGPT nationale gratuite

Comment résoudre l'erreur du ventilateur du processeur

Comment résoudre l'erreur du ventilateur du processeur

Que faire si l'utilisation du processeur est trop élevée

Que faire si l'utilisation du processeur est trop élevée