Périphériques technologiques

Périphériques technologiques

IA

IA

Le modèle Google RT-1 demande à un robot d'effectuer plusieurs tâches, avec un taux de réussite de 97 % pour 700 instructions

Le modèle Google RT-1 demande à un robot d'effectuer plusieurs tâches, avec un taux de réussite de 97 % pour 700 instructions

Le modèle Google RT-1 demande à un robot d'effectuer plusieurs tâches, avec un taux de réussite de 97 % pour 700 instructions

De nombreuses avancées récentes dans plusieurs sous-domaines de la recherche sur l'apprentissage automatique (ML), tels que la vision par ordinateur et le traitement du langage naturel, reposent sur l'exploitation d'ensembles de données vastes et diversifiés et de modèles de représentation capables d'absorber efficacement toutes les données.

Cependant, cette méthode de modélisation performante a relativement peu d'applications dans le domaine de la robotique.

La raison est simple. Premièrement, le manque de données robotiques diversifiées et à grande échelle limite la capacité du modèle à absorber un large éventail d’expériences robotiques.

Deuxièmement, il y a un manque de modèles d'inférence en temps réel expressifs, évolutifs et suffisamment rapides, capables d'apprendre de tels ensembles de données et de généraliser efficacement.

Et cette fois, le Robotics Transformer 1 (RT-1 en abrégé) de Google est un modèle multitâche qui peut étiqueter les actions d'entrée et de sortie du robot (telles que les images de la caméra, les instructions de tâches et les commandes de moteur) pour exécuter des tâches efficaces. raisonnement à tout moment et rendre possible un contrôle en temps réel.

RT-1 absorbe une grande quantité de données pour rendre le robot compétent pour une variété de tâches dans différents environnements, améliorant ainsi les performances de la machine et les capacités de généralisation

Pour faire simple, cela signifie laisser un robot le faire en même temps Plusieurs tâches.

Le modèle a été formé sur un vaste ensemble de données robotiques du monde réel de 130 000 épisodes couvrant plus de 700 tâches, collectées sur 17 mois à l'aide de 13 robots d'Everyday Robots (EDR).

Les résultats montrent que RT-1 peut améliorer considérablement la généralisation du tir zéro à de nouvelles tâches, environnements et objets par rapport aux techniques existantes.

L'éditeur a également judicieusement placé le lien Github ci-dessous. Si vous êtes intéressé, allez y jeter un œil.

https://github.com/google-research/robotics_transformer

Principe spécifique au modèle RT-1

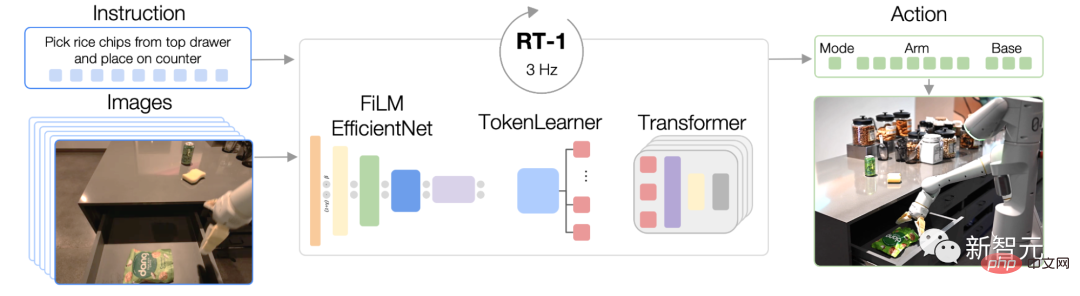

RT-1 est construit sur l'architecture Transformer, qui peut transformer le du robot L'historique des images est obtenu à partir de la caméra et la description de la tâche exprimée en langage naturel est utilisée comme entrée, tandis que les actions marquées sont directement sorties. L'architecture de

RT-1 est similaire à celle d'un modèle de séquence uniquement décodeur formé sur un objectif d'entropie croisée catégoriel standard avec masquage causal.

Le modèle prend des instructions textuelles et un ensemble d'images en entrée, les code en jetons via le modèle FiLM EfficientNet pré-entraîné, les compresse via TokenLearner, puis génère des jetons d'action via Transformer.

Ses principales fonctions incluent : la tokenisation d'image, la tokenisation d'action et la compression de jetons.

- Tokenisation d'image : nous transmettons l'image via le modèle EfficientNet-B3 pré-entraîné sur ImageNet, puis aplatissons la carte de caractéristiques spatiales 9×9×512 résultante en 81 jetons. Le tokenizer d'image est conditionné par des instructions de tâche en langage naturel et extrait très tôt les caractéristiques d'image pertinentes pour la tâche à l'aide d'une couche FiLM initialisée pour l'identité.

- Tokénisation de l'action : les dimensions d'action du robot sont 7 variables de mouvement du bras (x, y, z, roulis, tangage, lacet, ouverture de la pince), 3 variables de mouvement de base (x, y, navigation en lacet ), et une variable discrète supplémentaire pour basculer entre les trois modes.

- Compression des jetons : le modèle sélectionne de manière adaptative des combinaisons douces de jetons d'image qui peuvent être compressés en fonction de leur impact sur l'apprentissage à l'aide du module d'attention aux éléments TokenLearner, ce qui entraîne une inférence plus de 2,4 fois plus rapide.

Nous utilisons des démos fournies par des humains via une opération à distance et annotons chaque épisode avec des descriptions textuelles du robot exécutant les instructions.

Et ce robot s'appuie sur "un bras à 7 degrés de liberté, une pince à deux doigts et une base mobile" pour effectuer des tâches.

L'ensemble de compétences de haut niveau représenté dans l'ensemble de données comprend des opérations telles que choisir et placer des objets, ouvrir et fermer des tiroirs, mettre des objets dans et hors des tiroirs, placer des objets minces à la verticale, renverser des objets, etc.

Intégration de sources de données hétérogènes

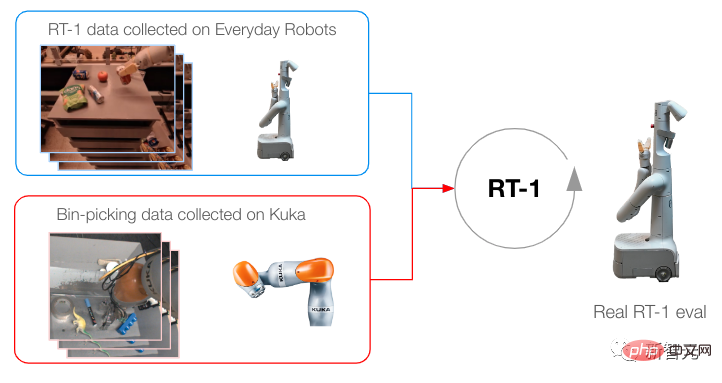

Pour pousser davantage RT-1, nous l'avons formé à l'aide de données collectées à partir d'un autre robot pour tester (1) si le modèle maintient ses performances sur la tâche d'origine lorsque de nouvelles sources de données sont présentées, et (2) si le modèle s'améliore en généralisation avec des données nouvelles et différentes.

Nous transformons les données collectées pour qu'elles correspondent aux spécifications d'action et aux limites des ensembles de données d'origine que nous avons collectés à l'aide d'EDR, et étiquetons chaque ensemble de données avec des instructions de tâche.

Mélangez ensuite les données Kuka avec les données EDR dans un rapport 1:2 dans chaque lot d'entraînement pour contrôler la régression des compétences EDR d'origine.

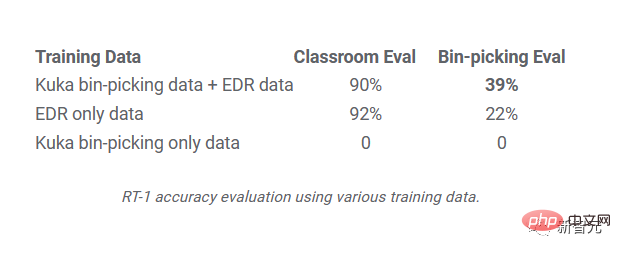

L'image montre la méthode de formation lors de la collecte de données de plusieurs robots

Les résultats montrent que RT-1 est capable d'acquérir de nouvelles compétences en observant l'expérience d'autres robots.

Lorsque RT-1 a été formé sur les données de sélection de bacs de Kuka et les données EDR existantes de la classe de robotique, la précision a bondi de près de 2 pour atteindre 39 %, contre 22 % lors d'une formation en utilisant uniquement les données EDR.

Lors de la formation du RT-1 en utilisant les données de sélection de Kuka uniquement et de son évaluation à l'aide des données de sélection du robot EDR, la précision était de 0 %.

Résultats expérimentaux

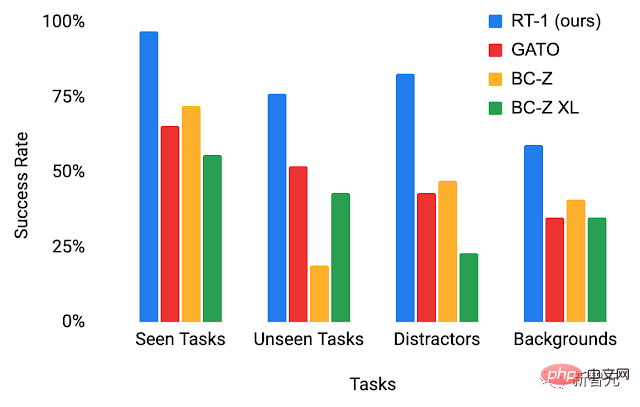

Pour mieux comprendre la capacité de généralisation du RT-1, nous avons étudié ses performances par rapport à trois lignes de base : Gato, BC-Z et BC-Z XL (c'est-à-dire avec le même BC-Z pour les paramètres quantitatifs).

et l'a divisé en quatre catégories :

La photo montre les performances du RT-1 et du groupe témoin dans l'environnement de test

- Performance des tâches invisibles : performance des tâches observées pendant la formation ;

-

Performance des tâches invisibles : performance sur des tâches invisibles où les compétences et les objets sont séparés dans l'ensemble de formation ; facteurs d'interférence et performances des changements d'arrière-plan (nouvelle cuisine, éclairage, scènes d'arrière-plan)

scénarios à long horizon) : Exécution d'instructions en langage naturel de type SayCan dans de vraies cuisines - Hautes performances et capacités de généralisation du RT-1 peut réaliser des tâches d'exploitation mobiles et longue distance via SayCan.

- SayCan fonctionne en plaçant un modèle de langage dans les capacités du robot et en exploitant une poignée d'indices pour décomposer la tâche à long terme consistant à exprimer le langage naturel en une série de compétences de bas niveau.

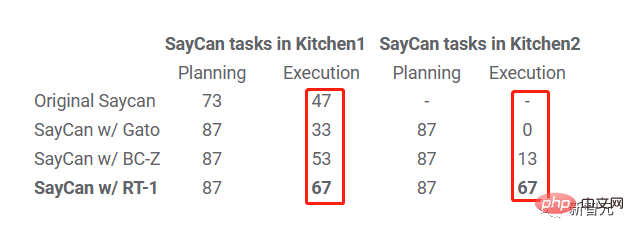

Nous évaluons SayCan dans deux vraies cuisines en utilisant RT-1 et deux autres références (SayCan avec Gato et SayCan avec BC-Z).

Ci-dessous, "Kitchen2" pose un scénario de généralisation plus difficile que "Kitchen1". La cuisine simulée utilisée pour collecter la plupart des données de formation a été calquée sur Kitchen1.

On peut voir que le taux de réussite d'exécution de SayCan avec RT-1 dans Kitchen1 est de 67 %, ce qui est meilleur que les autres références.

En raison des difficultés de généralisation causées par la nouvelle cuisine invisible, les performances de SayCan avec Gato et SayCan avec BCZ ont diminué, mais le taux de réussite de RT-1 n'a pas diminué.

En raison des difficultés de généralisation causées par la nouvelle cuisine invisible, les performances de SayCan avec Gato et SayCan avec BCZ ont diminué, mais le taux de réussite de RT-1 n'a pas diminué.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Comment l'IA peut-elle rendre les robots plus autonomes et adaptables ?

Jun 03, 2024 pm 07:18 PM

Comment l'IA peut-elle rendre les robots plus autonomes et adaptables ?

Jun 03, 2024 pm 07:18 PM

Dans le domaine de la technologie de l’automatisation industrielle, il existe deux points chauds récents qu’il est difficile d’ignorer : l’intelligence artificielle (IA) et Nvidia. Ne changez pas le sens du contenu original, affinez le contenu, réécrivez le contenu, ne continuez pas : « Non seulement cela, les deux sont étroitement liés, car Nvidia ne se limite pas à son unité de traitement graphique d'origine (GPU ), il étend son GPU. La technologie s'étend au domaine des jumeaux numériques et est étroitement liée aux technologies émergentes d'IA "Récemment, NVIDIA a conclu une coopération avec de nombreuses entreprises industrielles, notamment des sociétés d'automatisation industrielle de premier plan telles qu'Aveva, Rockwell Automation, Siemens. et Schneider Electric, ainsi que Teradyne Robotics et ses sociétés MiR et Universal Robots. Récemment, Nvidiahascoll

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un