En répondant à des questions complexes, les humains peuvent comprendre les informations selon différentes modalités et former une chaîne de pensée (CoT) complète. Le modèle d’apprentissage profond peut-il ouvrir la « boîte noire » et fournir une chaîne de réflexion pour son processus de raisonnement ? Récemment, l'UCLA et l'Allen Institute for Artificial Intelligence (AI2) ont proposé ScienceQA, le premier ensemble de données scientifiques multimodales de questions et réponses avec des explications détaillées, pour tester les capacités de raisonnement multimodal du modèle. Dans la tâche ScienceQA, l'auteur a proposé le modèle GPT-3 (CoT), qui a introduit un apprentissage rapide basé sur des chaînes de pensée dans le modèle GPT-3, afin que le modèle puisse générer des explications de raisonnement correspondantes tout en générant des réponses. GPT-3 (CoT) atteint une précision de 75,17 % sur ScienceQA et l'évaluation humaine montre qu'il peut générer des explications de meilleure qualité ;

Apprendre et accomplir des tâches complexes aussi efficacement que les humains est l'un des objectifs à long terme poursuivis par l'intelligence artificielle. Les humains peuvent suivre un processus de raisonnement complet en chaîne de pensée (CoT) pendant le processus de prise de décision pour donner des explications raisonnables aux réponses données.

Cependant, la plupart des modèles d'apprentissage automatique existants s'appuient sur un grand nombre d'échantillons de formation d'entrées-sorties pour effectuer des tâches spécifiques. Ces modèles de boîte noire génèrent souvent directement la réponse finale sans révéler le processus de raisonnement spécifique.

La réponse aux questions scientifiques peut bien diagnostiquer si le modèle d'intelligence artificielle possède des capacités de raisonnement et une interprétabilité en plusieurs étapes. Pour répondre à des questions scientifiques, un modèle doit non seulement comprendre le contenu multimodal, mais également extraire des connaissances externes pour parvenir à la bonne réponse. Dans le même temps, un modèle fiable doit également fournir des explications révélant son processus de raisonnement. Cependant, la plupart des ensembles de données scientifiques actuels sur les questions et réponses manquent d’explications détaillées des réponses ou se limitent à des modalités textuelles.

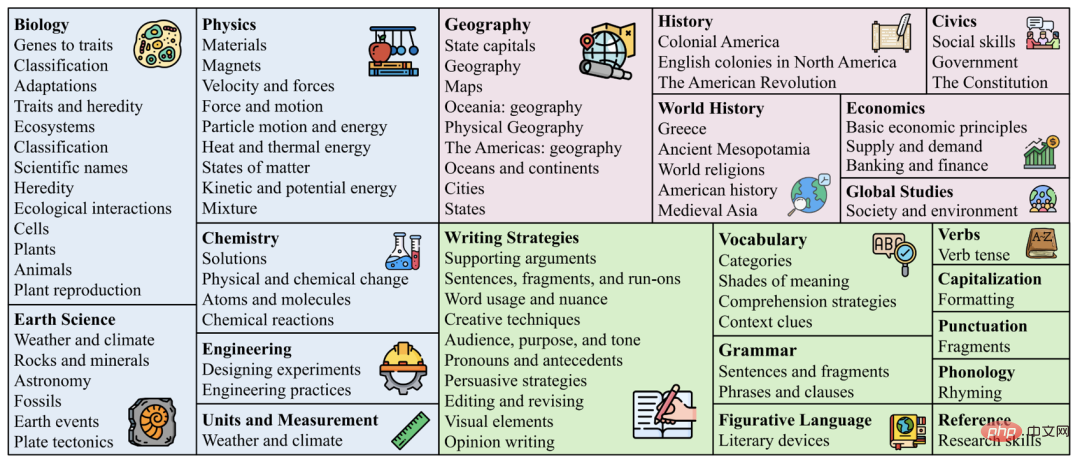

Par conséquent, L'auteur a collecté un nouvel ensemble de données scientifiques de questions et réponses ScienceQA, qui contient 21 208 questions à choix multiples provenant de cours de sciences des écoles primaires et secondaires. Une question typique contient un contexte multimodal, des options correctes, des connaissances générales (cours magistral) et une explication spécifique (explication).

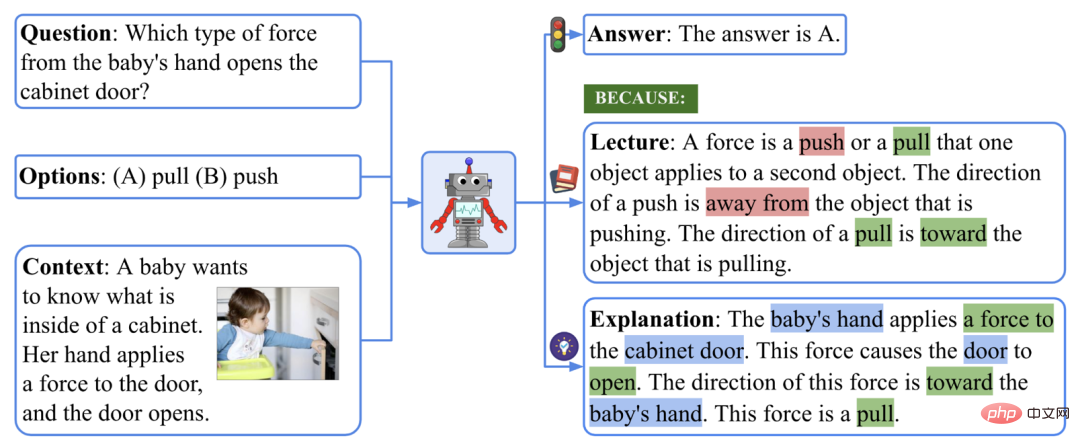

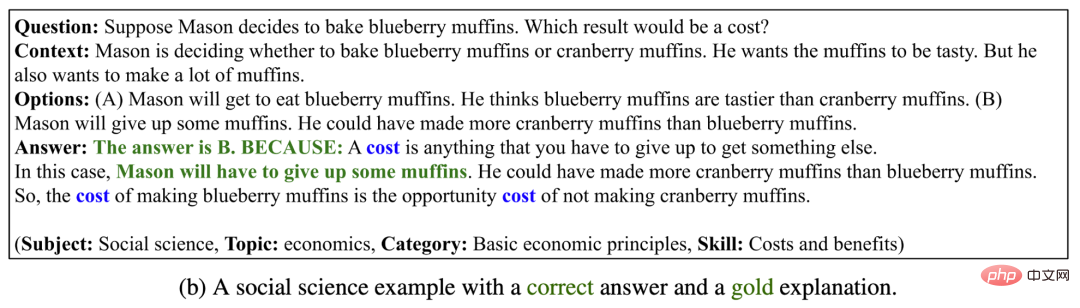

Un exemple d'ensemble de données ScienceQA.

Pour répondre à l'exemple présenté ci-dessus, il faut d'abord rappeler la définition de la force : "Une force est une poussée ou une traction qui... La direction d'une poussée est... La direction d'une traction est ... », puis formez un processus de raisonnement en plusieurs étapes : « La main du bébé applique une force sur la porte de l'armoire. → Cette force provoque l'ouverture de la porte → La direction de cette force est vers la main du bébé. et j'ai finalement obtenu la bonne réponse : "Cette force est une traction."

Dans la tâche ScienceQA, le modèle doit prédire la réponse tout en produisant une explication détaillée. Dans cet article, l'auteur utilise un modèle linguistique à grande échelle pour générer des connaissances de base et des explications sous forme de chaîne de pensée (CoT) pour imiter la capacité de raisonnement en plusieurs étapes dont disposent les humains.

Les expériences montrent que les méthodes actuelles de réponse aux questions multimodales ne peuvent pas obtenir de bonnes performances dans la tâche ScienceQA. En revanche, Grâce à l'apprentissage rapide basé sur la chaîne de pensée, le modèle GPT-3 peut atteindre une précision de 75,17 % sur l'ensemble de données ScienceQA et peut générer des explications de meilleure qualité : 65,2 % des explications sont pertinentes selon l'évaluation humaine, correct et complet. Thoughtchain peut également aider le modèle UnifiedQA à atteindre une amélioration de 3,99 % par rapport à l'ensemble de données ScienceQA.

Statistiques de l'ensemble de données

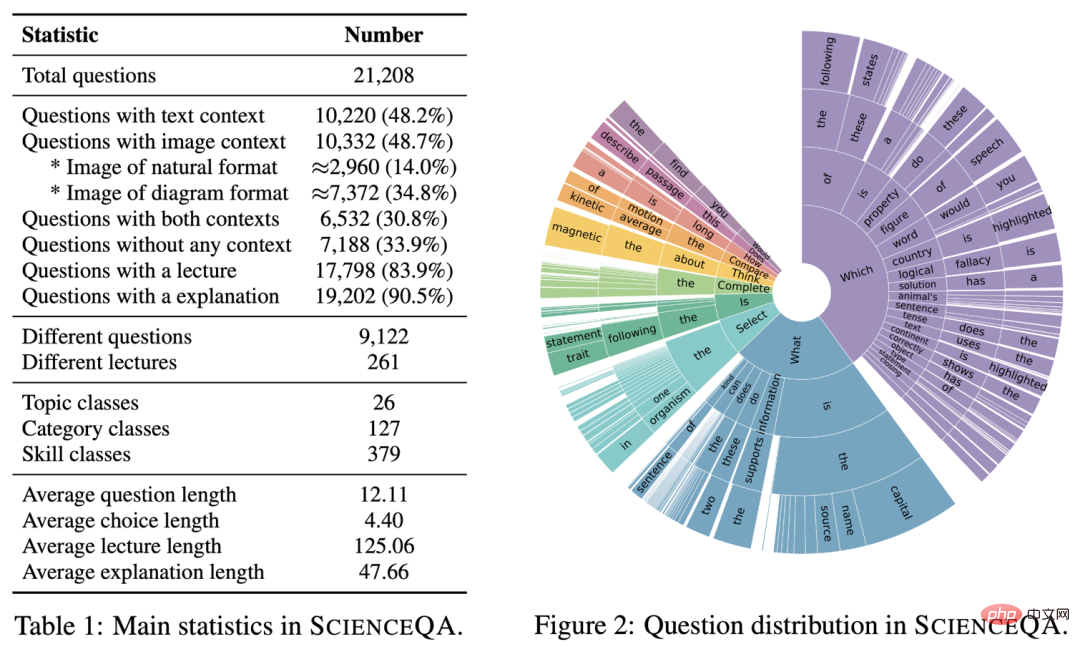

Les principales informations statistiques de ScienceQA sont les suivantes.

Informations principales de l'ensemble de données ScienceQA

ScienceQA contient 21208 exemples, dont 9122 différentes questions. 10 332 chaînes (48,7 %) avaient des informations de fond visuelles, 10 220 chaînes (48,2 %) avaient des informations de fond textuelles et 6 532 chaînes (30,8 %) avaient des informations de fond visuelles et textuelles. La grande majorité des questions sont annotées avec des explications détaillées : 83,9 % des questions comportent des annotations sur les connaissances de base (cours magistral) et 90,5 % des questions comportent des réponses détaillées (explication).

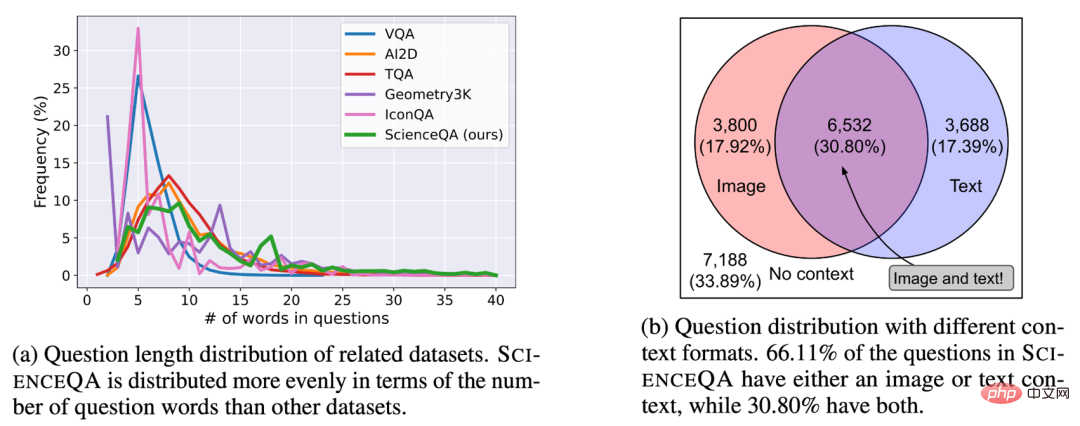

Question de l'ensemble de données ScienceQA et distribution de fond.

Distribution des sujets des ensembles de données

Différent des ensembles de données existants, ScienceQA couvre trois branches majeures des sciences naturelles, des sciences sociales et de la linguistique, dont 26 sujets (sujets), 127 catégories et 379 compétences . Répartition des sujets de

ScienceQA.

Distribution des nuages de mots des ensembles de données

Comme le montre la distribution des nuages de mots dans la figure ci-dessous, les questions de ScienceQA ont une riche diversité sémantique. Les modèles doivent comprendre différentes formulations de problèmes, scénarios et connaissances de base.

Distribution en nuage de mots de ScienceQA.

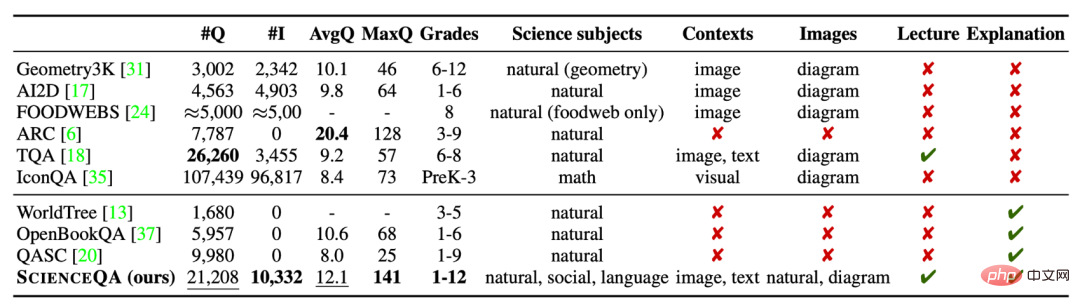

Comparaison d'ensembles de données

ScienceQA est le premier ensemble de données scientifiques multimodales de questions et réponses annoté avec des explications détaillées. Par rapport aux ensembles de données existants, la taille des données de ScienceQA, la diversité des types de questions, la diversité des sujets et d'autres dimensions reflètent ses avantages.

Comparaison de l'ensemble de données ScienceQA avec d'autres ensembles de données scientifiques de questions et réponses.

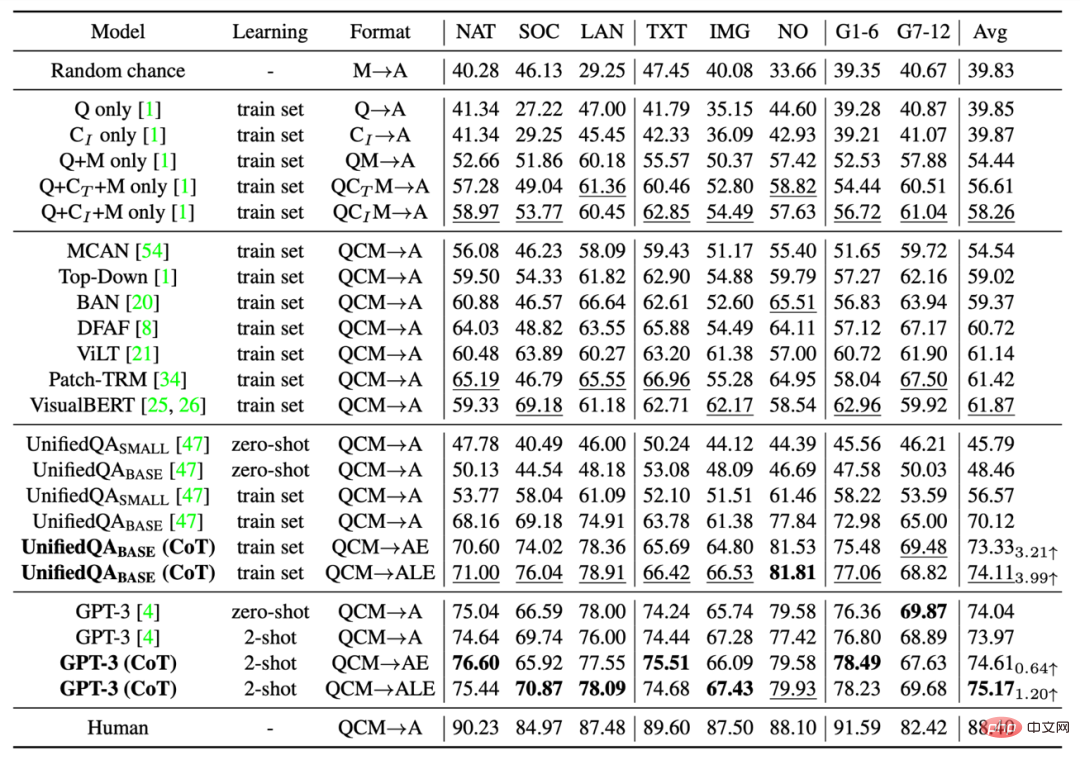

Lignes de base

L'auteur a évalué différentes méthodes de référence sur l'ensemble de données ScienceQA, notamment des modèles VQA tels que Top-Down Attention, MCAN, BAN, DFAF, ViLT, Patch-TRM et VisualBERT, des modèles de langage à grande échelle tels que UnifiedQA et GPT-3, et le hasard et la performance humaine. Pour les modèles linguistiques UnifiedQA et GPT-3, les images d'arrière-plan sont converties en légendes textuelles.

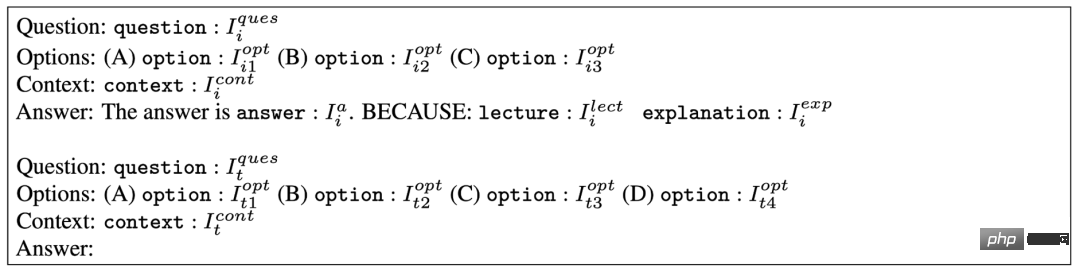

GPT-3 (CoT)

Des travaux de recherche récents montrent que, compte tenu d'indices appropriés, les modèles GPT-3 peuvent présenter des performances supérieures sur différentes tâches en aval. À cette fin, l'auteur propose le modèle GPT-3 (CoT), qui ajoute une chaîne de pensée (CoT) aux invites, afin que le modèle puisse générer des connaissances de base et des explications correspondantes tout en générant des réponses.

Le modèle d'invite spécifique est présenté dans l'image ci-dessous. où Ii représente l'exemple de formation et It représente l'exemple de test. L'exemple de formation contient des éléments de question, d'options, de contexte et de réponse, où la réponse se compose de la bonne réponse, de connaissances de base (Conférence) et d'une explication (Explication). GPT-3 (CoT) complétera les réponses prédites, les connaissances de base et les explications des exemples de test en fonction des informations d'invite de saisie.

Modèle de conseils adopté par GPT-3 (CoT).

Résultats expérimentaux

Les résultats de précision des différents tests de référence et méthodes sur l'ensemble de tests ScienceQA sont présentés dans le tableau ci-dessous. VisualBERT, l'un des meilleurs modèles VQA actuels, ne peut atteindre qu'une précision de 61,87 %. En introduisant les données CoT pendant le processus de formation, le modèle UnifiedQA_BASE peut atteindre une précision de 74,11 %. Et GPT-3 (CoT) a atteint une précision de 75,17 % avec l'invite de 2 exemples de formation, ce qui est supérieur aux autres modèles de référence. Les humains obtiennent de bons résultats sur l'ensemble de données ScienceQA, atteignant une précision globale de 88,40 % et des performances stables dans différentes catégories de questions.

Les résultats de différentes méthodes sur l'ensemble de tests ScienceQA.

Évaluation des explications générées

Les auteurs ont évalué les explications générées par différentes méthodes en utilisant des métriques d'évaluation automatique telles que BLEU-1, BLEU-2, ROUGE-L et la similarité des phrases. Étant donné que les mesures d'évaluation automatique ne peuvent mesurer que la similarité entre les résultats de prédiction et le contenu annoté, les auteurs ont en outre adopté des méthodes d'évaluation manuelle pour évaluer la pertinence, l'exactitude et l'exhaustivité des explications générées. Comme on peut le constater, 65,2% des explications générées par GPT-3 (CoT) répondent au Gold standard .

Les résultats de différentes méthodes d'évaluation pour générer des explications.

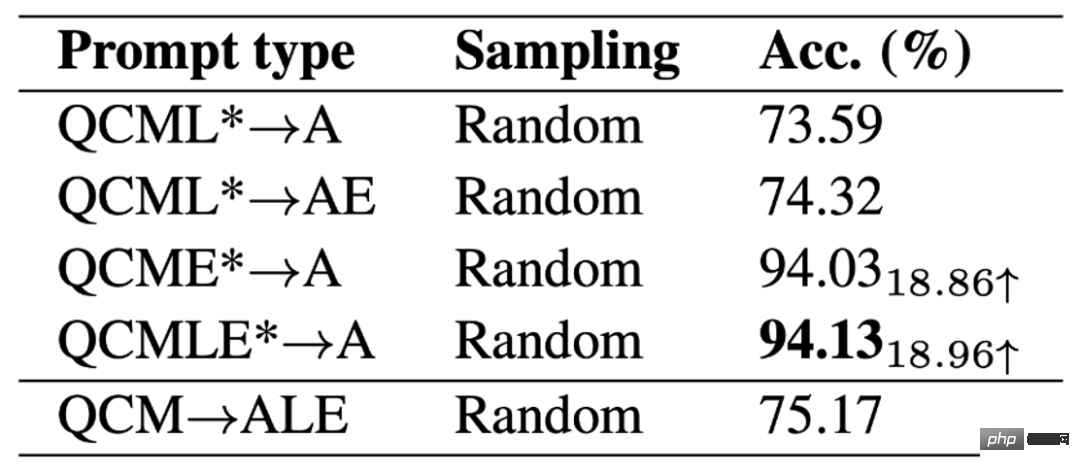

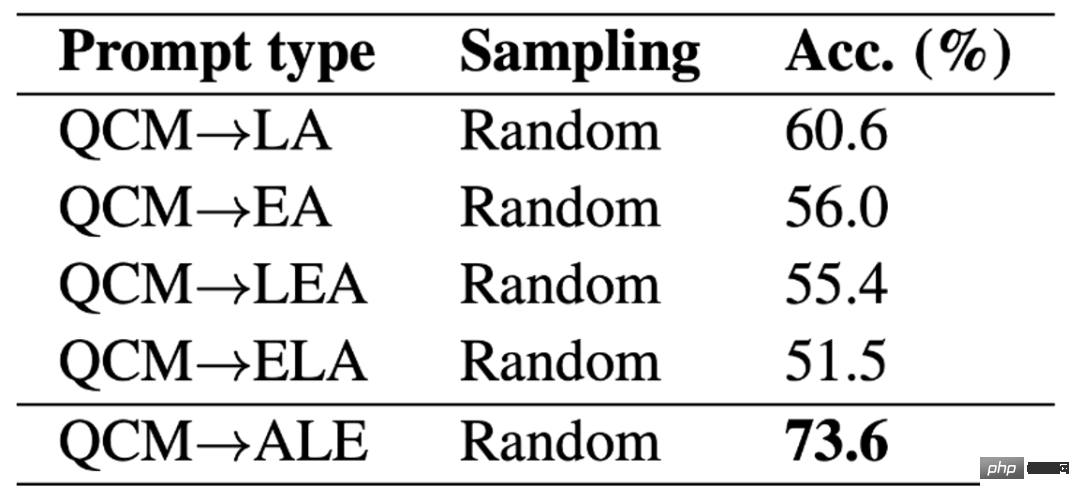

Différents modèles d'indices

L'auteur a comparé l'impact de différents modèles d'indices sur la précision du GPT-3 (CoT) . On peut voir que dans le modèle QAM-ALE, GPT-3 (CoT) peut obtenir la plus grande précision moyenne et la plus petite variance. De plus, GPT-3 (CoT) fonctionne mieux lorsque vous y êtes invité avec 2 exemples de formation.

Comparaison des résultats de différents modèles d'invites.

Limite supérieure du modèle

Afin d'explorer la limite supérieure de performance du modèle GPT-3 (CoT), l'auteur ajoute des connaissances de base annotées et des explications à l'entrée du modèle (QCMLE*-A) . Nous pouvons voir que GPT-3 (CoT) peut atteindre une précision allant jusqu’à 94,13 %. Cela suggère également une direction possible pour l'amélioration du modèle : le modèle peut effectuer un raisonnement étape par étape, c'est-à-dire d'abord récupérer des connaissances de base précises et générer des explications précises, puis utiliser ces résultats comme entrée. Ce processus est très similaire à la manière dont les humains résolvent des problèmes complexes.

Plafond de performance pour les modèles GPT-3 (CoT).

Différentes positions ALE

L'auteur discute en outre de l'impact des différentes positions ALE sur les résultats de GPT-3 (CoT) lors de la génération de prédictions. Les résultats expérimentaux sur ScienceQA montrent que si GPT-3 (CoT) génère d’abord une connaissance de base L ou une explication E, puis génère la réponse A, la précision de sa prédiction diminuera considérablement. La raison principale est que les connaissances de base L et l'explication E contiennent un grand nombre de mots. Si LE est généré en premier, le modèle GPT-3 peut manquer du nombre maximum de mots ou arrêter de générer du texte plus tôt, de sorte que la réponse finale. Un ne peut pas être obtenu.

Différentes positions LE.

Différentes positions LE.

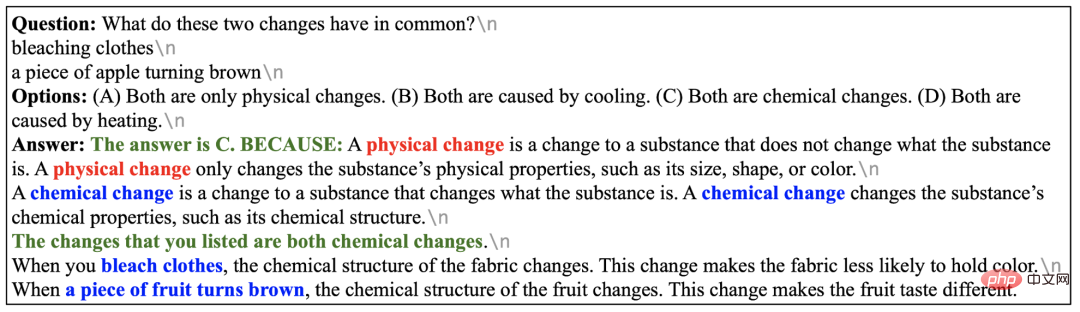

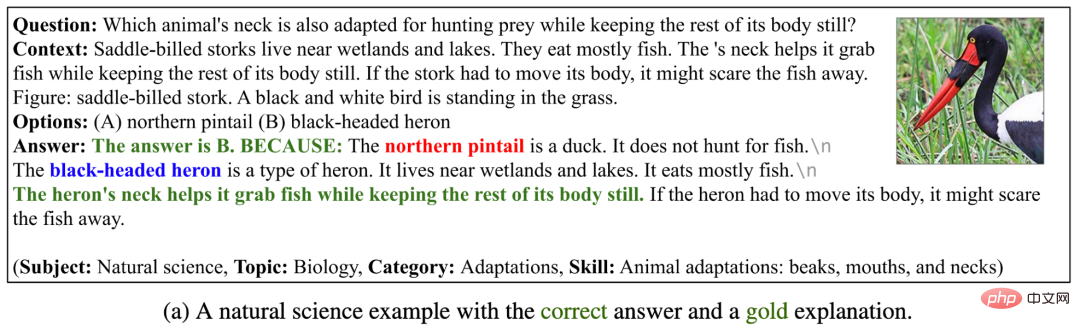

Success Stories

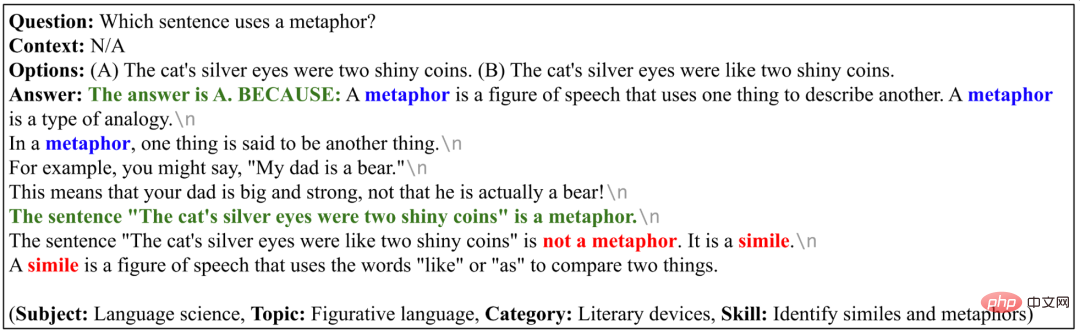

Dans les 4 exemples suivants, GPT-3 (CoT) peut non seulement générer des réponses correctes, mais aussi donner des explications pertinentes, correctes et complètes . Cela montre que GPT-3 (CoT) présente de solides capacités de raisonnement et d'explication en plusieurs étapes sur l'ensemble de données ScienceQA.

GPT-3 (CoT) Exemples de génération de réponses et d'explications correctes.

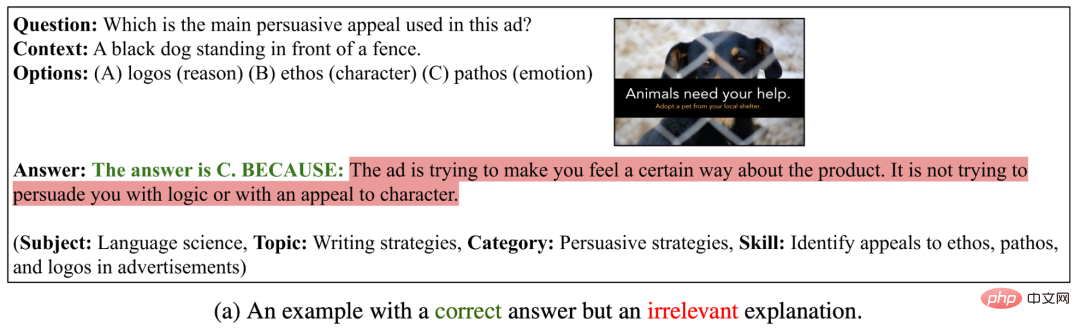

Cas d'échec I

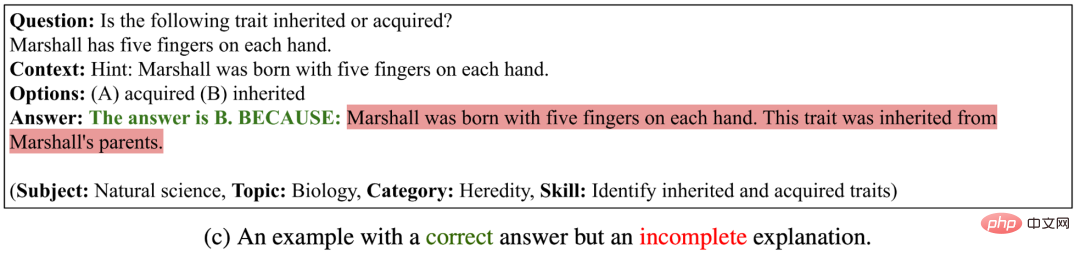

Dans les trois exemples ci-dessous, GPT-3 (CoT) a généré des réponses correctes, mais les explications générées étaient non pertinentes, incorrectes ou incomplètes . Cela montre que GPT-3 (CoT) est encore confronté à de plus grandes difficultés pour générer de longues séquences logiquement cohérentes.

GPT-3 (CoT) peut générer des exemples de réponses correctes, mais les explications générées sont incorrectes.

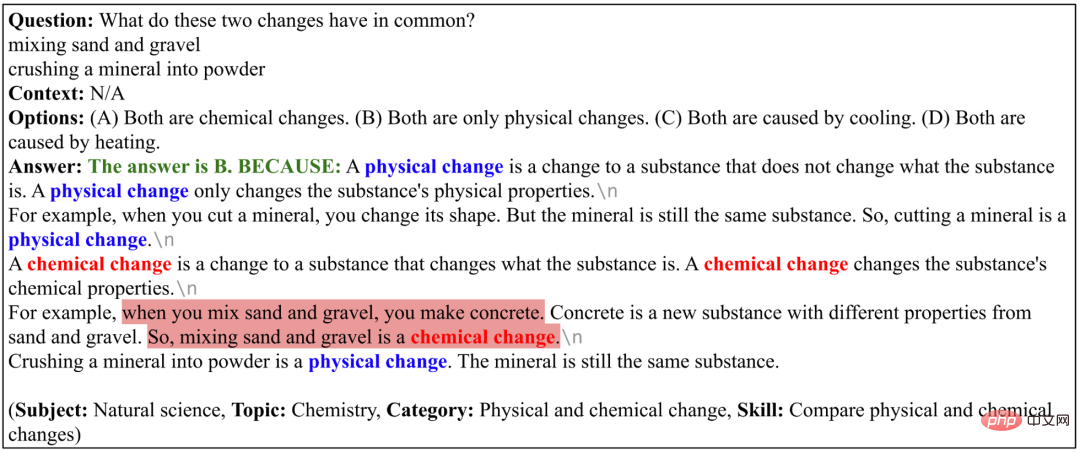

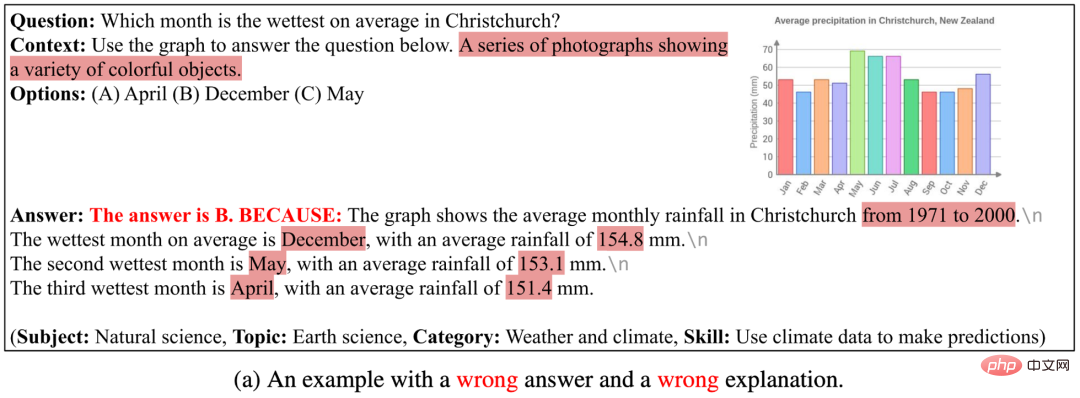

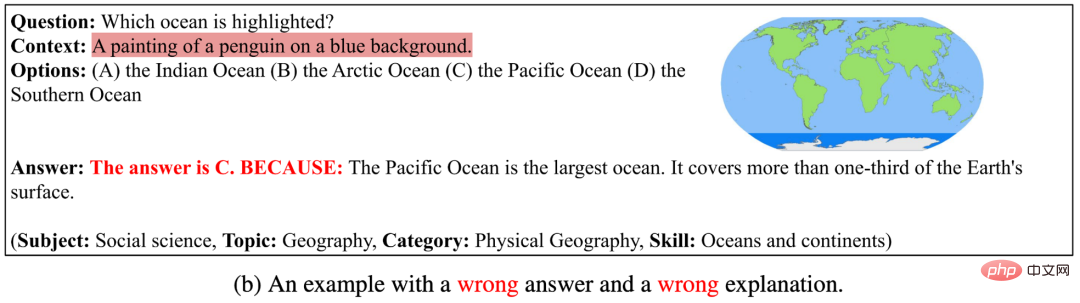

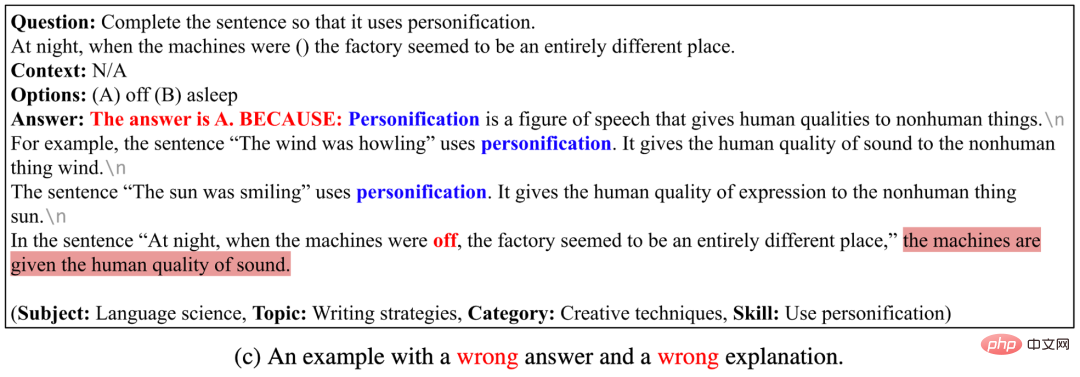

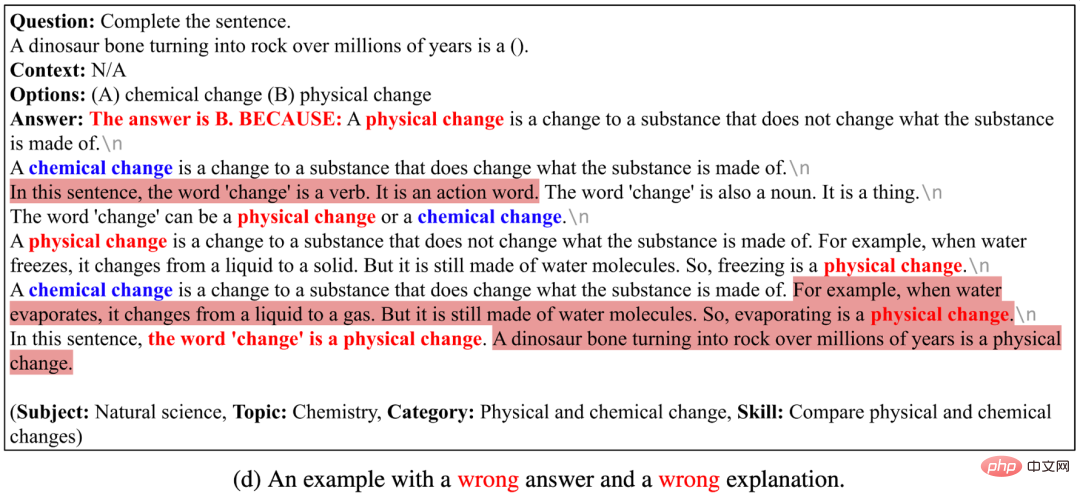

Cas d'échec II

Dans les quatre exemples ci-dessous, GPT-3 (CoT) ne peut pas générer la bonne réponse, ni la bonne explication. Les raisons sont les suivantes : (1) Le modèle actuel de sous-titrage d'images ne peut pas décrire avec précision les informations sémantiques des images telles que les diagrammes schématiques et les tableaux. Si l'image est représentée par un texte d'annotation d'image, GPT-3 (CoT) ne peut pas encore fournir une bonne réponse à cette question. la question qui contient l'arrière-plan des problèmes du graphique ; (2) Lorsque GPT-3 (CoT) génère de longues séquences, il est sujet à des problèmes incohérents ou incohérents ; (3) GPT-3 (CoT) n'est pas encore en mesure de répondre ; questions spécifiques. Problèmes de connaissance du domaine.

GPT-3 (CoT) peut générer des exemples de réponses et d'explications incorrectes.

L'auteur a proposé ScienceQA, le premier ensemble de données scientifiques multimodales de questions et réponses avec des explications détaillées. ScienceQA contient 21 208 questions à choix multiples portant sur des matières scientifiques des écoles primaires et secondaires, couvrant trois domaines scientifiques majeurs et une variété de sujets. La plupart des questions sont annotées avec des connaissances de base et des explications détaillées. ScienceQA évalue les capacités d'un modèle en matière de compréhension multimodale, de raisonnement en plusieurs étapes et d'interprétabilité. Les auteurs évaluent différents modèles de base sur l'ensemble de données ScienceQA et proposent que le modèle GPT-3 (CoT) puisse générer des connaissances et des explications de base correspondantes tout en générant des réponses. Un grand nombre d’analyses expérimentales et d’études de cas ont fourni une source d’inspiration utile pour l’amélioration du modèle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment flasher le téléphone Xiaomi

Comment flasher le téléphone Xiaomi

Comment centrer un div en CSS

Comment centrer un div en CSS

Comment ouvrir un fichier rar

Comment ouvrir un fichier rar

Méthodes de lecture et d'écriture de fichiers Java DBF

Méthodes de lecture et d'écriture de fichiers Java DBF

Comment résoudre le problème de l'absence du fichier msxml6.dll

Comment résoudre le problème de l'absence du fichier msxml6.dll

Formules de permutation et de combinaison couramment utilisées

Formules de permutation et de combinaison couramment utilisées

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

album photo dynamique

album photo dynamique