Récemment, le modèle de représentation vidéo 6-DoF-HyperReel proposé par Meta et l'Université Carnegie Mellon pourrait indiquer qu'une nouvelle application VR « tueuse » est sur le point de naître !

La soi-disant « vidéo à six degrés de liberté » (6-DoF) est simplement une lecture expérientielle 4D ultra haute définition.

Parmi eux, les utilisateurs peuvent complètement « s'immerger » dans des scènes dynamiques et se déplacer librement. Et lorsqu'ils changent arbitrairement la position de leur tête (3 DoF) et leur direction (3 DoF), les vues correspondantes seront également générées en conséquence.

Adresse papier : https://arxiv.org/abs/2301.02238

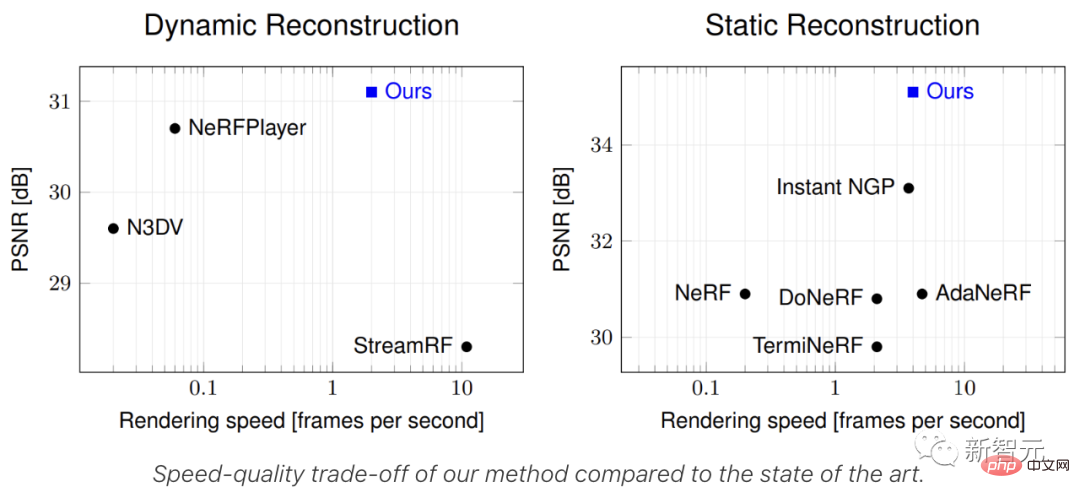

Par rapport aux travaux précédents, le plus grand avantage d'HyperReel réside dans la mémoire et l'efficacité informatique, et ces deux points sont très importants pour les casques VR portables sont cruciaux.

Et en utilisant Vanilla PyTorch, HyperReel peut atteindre un rendu en résolution mégapixel à 18 images par seconde sur un seul NVIDIA RTX 3090.

Version trop longue à regarder :

1 Proposer un réseau de prédiction d'échantillonnage de conditions d'éclairage capable d'obtenir un rendu haute fidélité, à haute fréquence d'images et en haute résolution, et un format compact. et une représentation de volume dynamique économe en mémoire ;

2. La méthode de représentation vidéo 6-DoF HyperReel combine les deux parties principales ci-dessus pour atteindre vitesse et qualité tout en restituant une résolution en mégapixels en temps réel. Un équilibre idéal entre les besoins en mémoire et la mémoire ;

3. HyperReel est supérieur aux autres méthodes dans de nombreux aspects tels que les besoins en mémoire et la vitesse de rendu.

Introduction à l'article

La représentation volumétrique de scènes peut fournir une synthèse de vue réaliste pour les scènes statiques et constitue la base de la technologie vidéo 6-DoF existante.

Cependant, les programmes de rendu de volume qui pilotent ces représentations nécessitent des compromis minutieux en termes de qualité, de vitesse de rendu et d'efficacité de la mémoire.

Les méthodes existantes présentent un inconvénient : elles ne peuvent pas simultanément atteindre des performances en temps réel, une faible empreinte mémoire et un rendu de haute qualité, qui sont extrêmement importants dans des scénarios réels difficiles.

Pour résoudre ces problèmes, les chercheurs ont proposé HyperReel - une méthode de caractérisation vidéo 6-DoF basée sur la technologie NeRF (Neural Radiation Field).

Parmi eux, les deux parties principales d'HyperReel sont :

1. Un réseau de prédiction d'échantillonnage dans des conditions de lumière, capable d'un rendu haute fidélité et à haute résolution ; représentation de volume dynamique compacte et économe en mémoire.

Comparé à d'autres méthodes, le pipeline vidéo 6-DoF d'HyperReel est non seulement extrêmement performant en termes de qualité visuelle, mais nécessite également de très faibles besoins en mémoire.

Dans le même temps, HyperReel peut atteindre une vitesse de rendu de 18 images/seconde à une résolution en mégapixels sans aucun code CUDA personnalisé.

Plus précisément, HypeReel atteint un équilibre entre une qualité de rendu élevée, une vitesse et une efficacité de la mémoire en combinant un réseau de prédiction d'échantillons et une méthode de représentation de volume basée sur des images clés.

Le réseau de prédiction d'échantillons peut à la fois accélérer le rendu du volume et améliorer la qualité du rendu, en particulier pour les scènes présentant des dépendances de vue difficiles.

En termes de représentation de volume basée sur des images clés, les chercheurs utilisent une extension de TensoRF.

Cette méthode peut représenter avec précision une séquence vidéo complète tout en consommant à peu près la même mémoire qu'une seule image statique TensoRF.

Démonstration en temps réel

Ensuite, nous démontrerons en temps réel l'effet de rendu de scènes dynamiques et statiques par HypeReel à une résolution de 512x512 pixels.

Il convient de noter que les chercheurs ont utilisé des modèles plus petits dans les scènes Technicolor et Shiny, de sorte que la fréquence d'images du rendu était supérieure à 40 FPS. Pour les ensembles de données restants, le modèle complet est utilisé, mais HypeReel est toujours capable de fournir une inférence en temps réel.

Technicolor

Technicolor

Brillant

Brillant

Stanford

Stanford

Immersif

Immersif

DoNeRF

méthode de mise en œuvre

pour Pour implémenter HeperReel, la première question à considérer est d'optimiser la représentation volumique de la synthèse de vues statiques.

La représentation volumique comme NeRF consiste à modéliser la densité et l'apparence de chaque point d'une scène statique dans l'espace 3D.

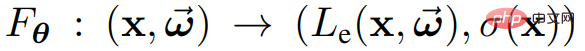

Plus précisément, la position x et la direction  sont mappées le long d'un rayon ⼀ à la couleur

sont mappées le long d'un rayon ⼀ à la couleur  et à la densité σ(x) via la fonction

et à la densité σ(x) via la fonction  .

.

Le paramètre entraînable θ ici peut être un poids de réseau neuronal, une entrée de tableau à N dimensions ou une combinaison des deux.

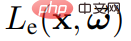

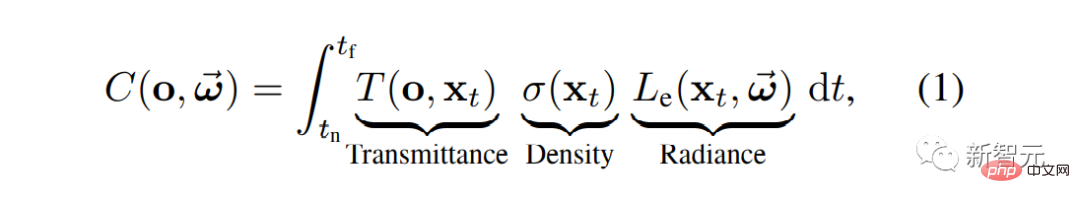

Ensuite, vous pouvez restituer une nouvelle vue de la scène statique

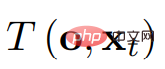

où  représente la transmission de o à

représente la transmission de o à  .

.

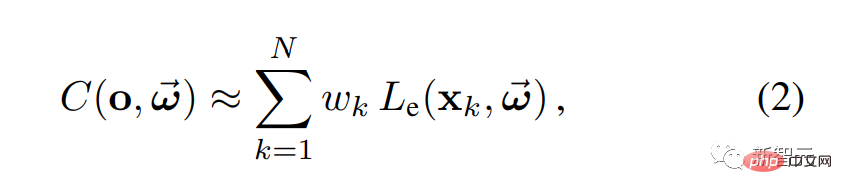

En pratique, l'équation 1 peut être calculée en prenant plusieurs points d'échantillonnage le long d'un rayon donné, puis en utilisant la quadrature numérique :

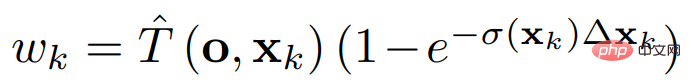

où le poids  précise la contribution de la couleur de chaque point d'échantillonnage à la sortie.

précise la contribution de la couleur de chaque point d'échantillonnage à la sortie.

Exemple de maillage pour le rendu de volume

Dans HyperReel pour une scène statique, étant donné un ensemble d'images et de poses de caméra, l'objectif de la formation est de reconstruire la couleur mesurée associée à chaque rayon.

La plupart des scènes sont composées d'objets solides dont les surfaces se trouvent sur une variété 2D dans le volume de la scène 3D. Dans ce cas, seul un petit nombre de points d’échantillonnage affecte la couleur rendue de chaque rayon.

Ainsi, afin d'accélérer le rendu du volume, les chercheurs souhaitent interroger la couleur et l'opacité uniquement pour les  points non nuls.

points non nuls.

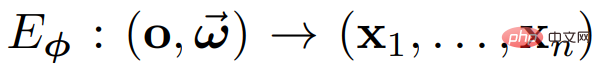

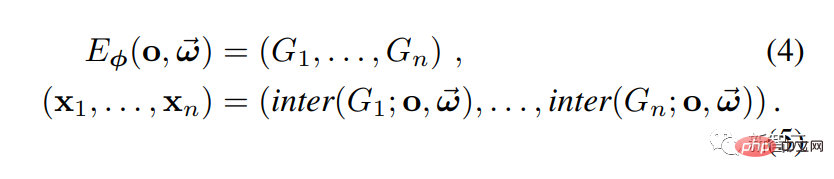

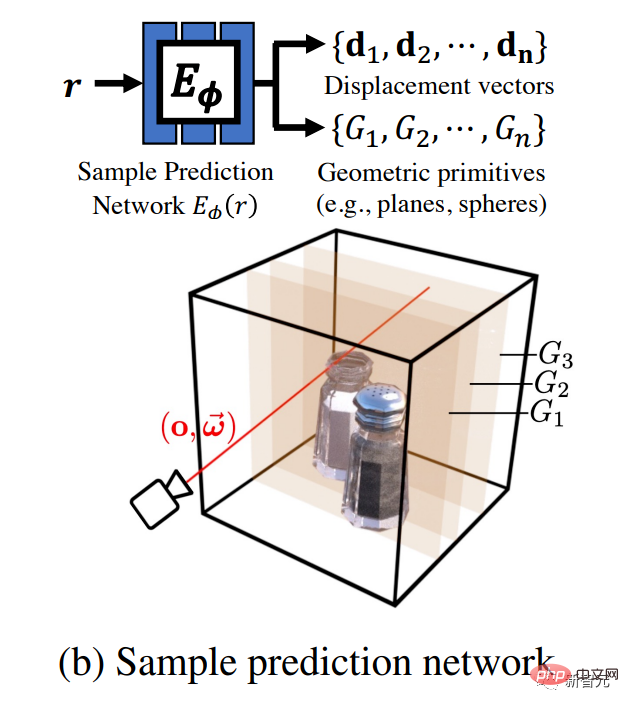

Comme le montre la figure ci-dessous, les chercheurs utilisent un réseau feedforward pour prédire un ensemble d'emplacements d'échantillons  . Plus précisément, un exemple de réseau de prédiction

. Plus précisément, un exemple de réseau de prédiction  est utilisé, pour cartographier les rayons

est utilisé, pour cartographier les rayons  pour échantillonner des points

pour échantillonner des points  afin d'obtenir le rendu dans l'équation de volume 2.

afin d'obtenir le rendu dans l'équation de volume 2.

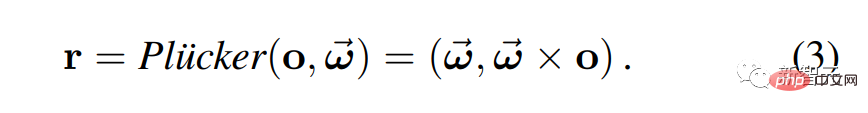

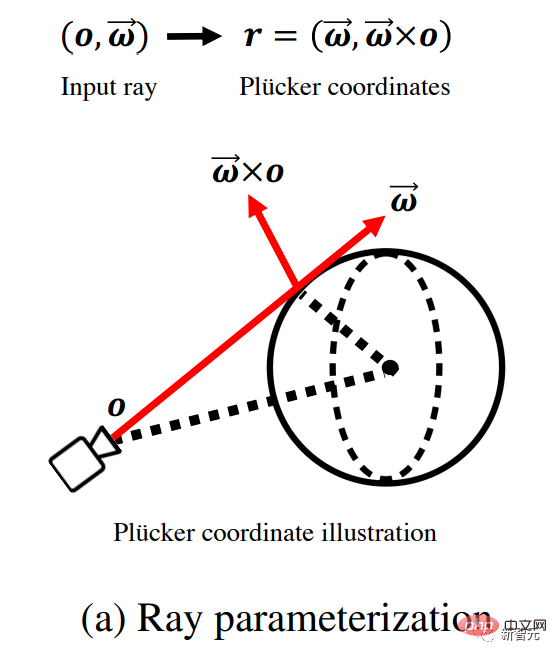

Ici, les chercheurs utilisent le paramétrage de Plucker pour caractériser la lumière.

Mais il y a un problème : donner trop de flexibilité au réseau peut avoir un impact négatif sur la qualité de la synthèse des vues. Par exemple, si (x1, . . . , xn) sont des points complètement arbitraires, le rendu peut ne pas sembler cohérent sur plusieurs vues.

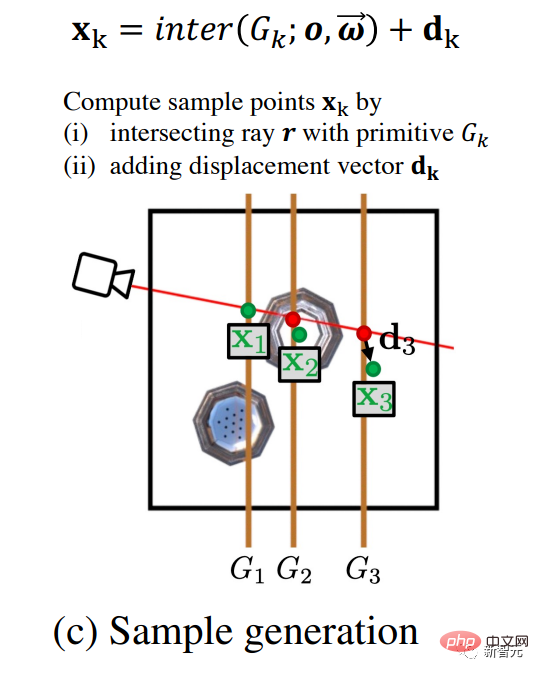

Afin de résoudre ce problème, les chercheurs ont choisi d'utiliser un réseau de prédiction d'échantillons pour prédire les paramètres d'un ensemble de primitives géométriques G1, ..., Gn, où les paramètres des primitives peuvent changer en fonction de différentes entrées. des rayons. Pour obtenir des points d'échantillonnage, un rayon est coupé avec chaque primitive.

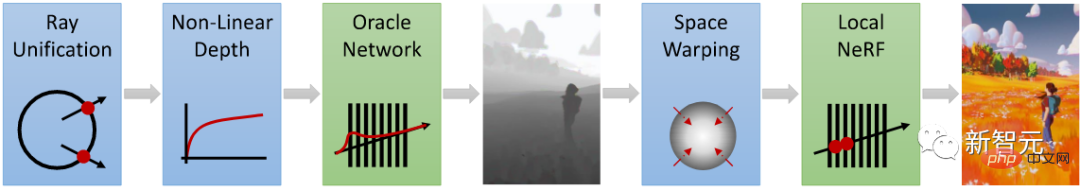

Comme le montre la figure a, étant donné la lumière d'entrée provenant de l'origine de la caméra o et se propageant dans la direction ω, les chercheurs ont d'abord utilisé les coordonnées de Plucker pour reparamétrer la lumière.

Comme le montre la figure b, un réseau prend ce rayon en entrée et génère un ensemble de primitives géométriques {} (telles que des plans et des sphères alignés sur des axes) et des vecteurs de déplacement { } paramètres.

Comme le montre la figure c, pour générer des points d'échantillonnage { } pour le rendu du volume, les chercheurs ont calculé les points d'intersection entre les rayons et les primitives géométriques et ont ajouté des vecteurs de déplacement aux résultats. L’avantage de la prédiction des primitives géométriques est que le signal échantillonné est fluide et facile à interpoler.

} pour le rendu du volume, les chercheurs ont calculé les points d'intersection entre les rayons et les primitives géométriques et ont ajouté des vecteurs de déplacement aux résultats. L’avantage de la prédiction des primitives géométriques est que le signal échantillonné est fluide et facile à interpoler.

Les vecteurs de déplacement offrent une flexibilité supplémentaire dans les points d'échantillonnage, permettant une meilleure capture des apparences complexes dépendant de la vue.

Comme le montre la figure d, enfin, les chercheurs ont effectué un rendu de volume via la Formule 2 pour générer une couleur de pixel et ont effectué un entraînement supervisé sur celle-ci en fonction des résultats d'observation correspondants.

Grâce à la méthode ci-dessus, le volume de la scène 3D peut être efficacement échantillonné.

Comment caractériser le volume ? Dans le cas statique, les chercheurs ont utilisé la méthode TensoRF (Memory-efficace Tensor Radiation Field) ; dans le cas dynamique, TensoRF a été étendu à la représentation dynamique des volumes basée sur des images clés.

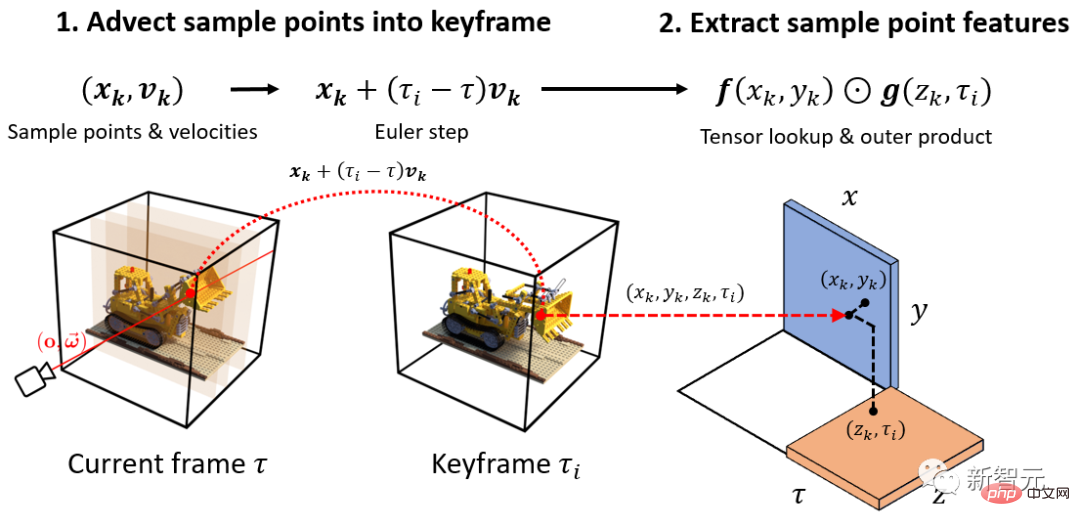

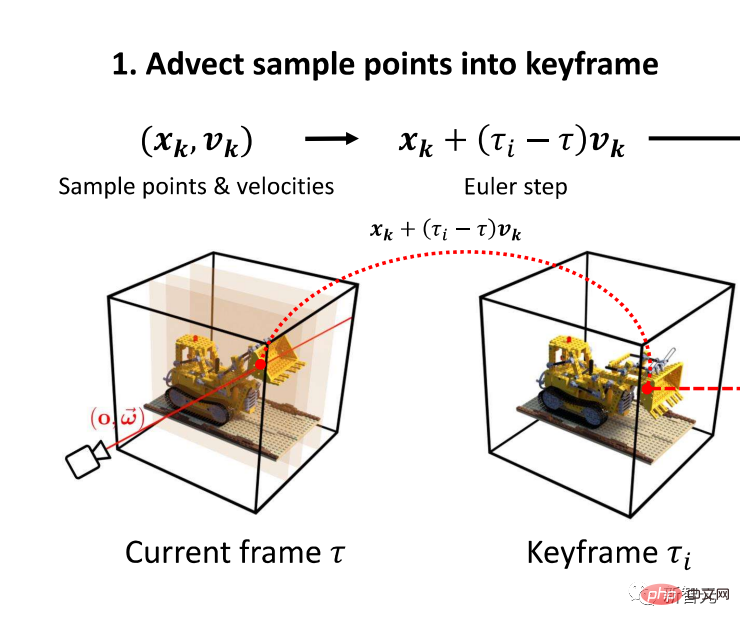

La figure suivante explique le processus d'extraction de la représentation dynamique des points d'échantillonnage à partir d'une représentation basée sur des images clés.

Comme le montre la figure 1, les chercheurs ont d'abord utilisé la vitesse {} pour prédire la sortie du réseau à partir de l'échantillon, traduisant le point d'échantillonnage {} au moment à Dans l'image clé la plus récente .

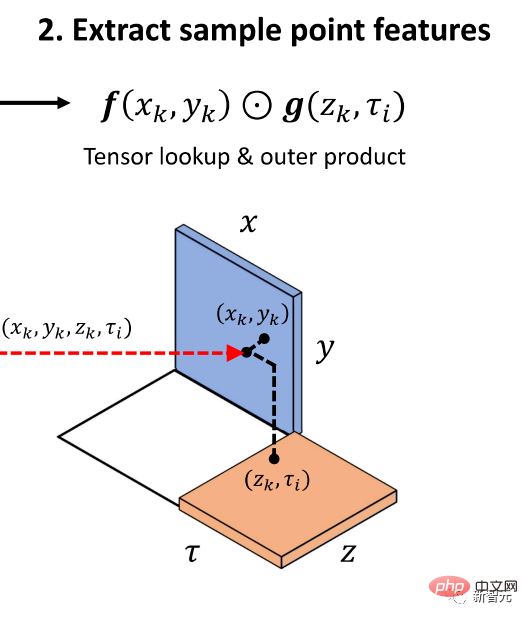

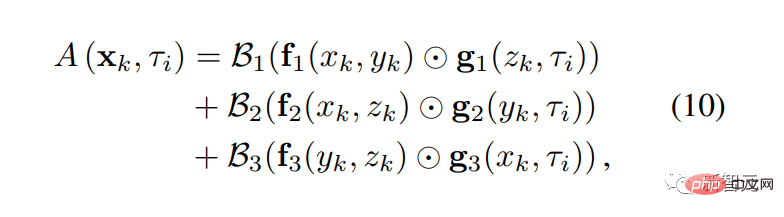

Ensuite, comme le montre la figure 2, les chercheurs ont interrogé le produit externe de la texture spatio-temporelle pour produire les caractéristiques d'apparence de chaque point d'échantillon, qui ont ensuite été converties en couleurs via l'équation 10.

Grâce à ce processus, les chercheurs ont extrait l'opacité de chaque échantillon.

Comparaison des résultats

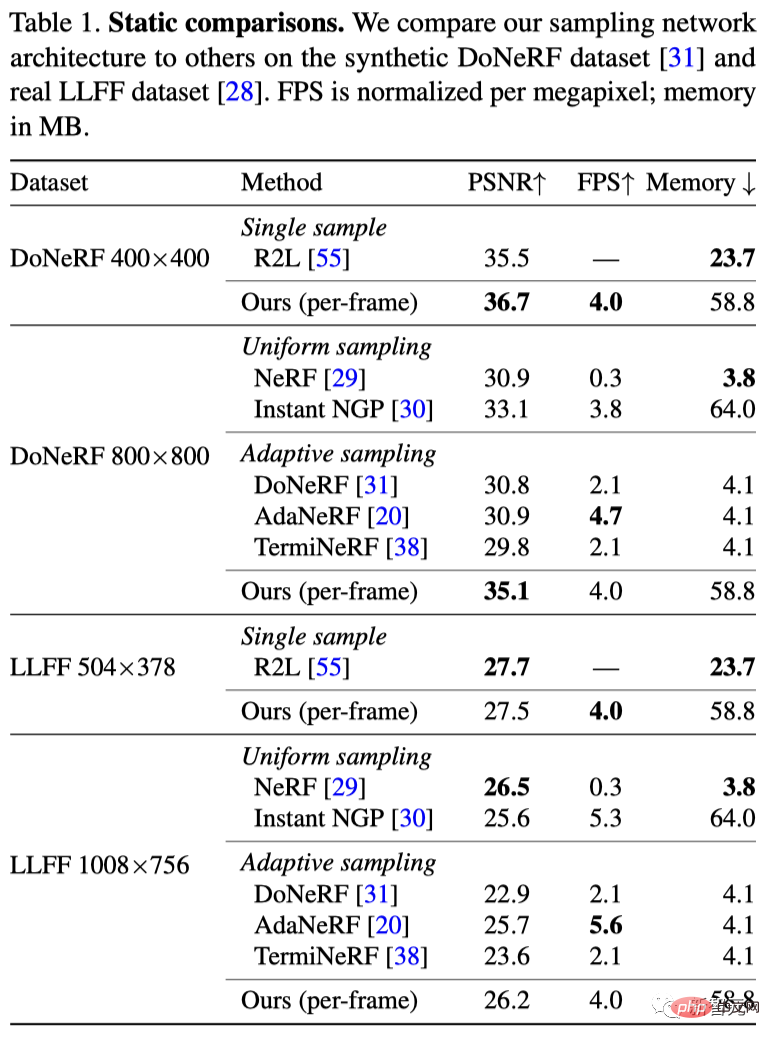

Ici, les chercheurs ont comparé HyperReel avec les méthodes de synthèse de vues statiques existantes (y compris NeRF, InstantNGP et trois méthodes basées sur un réseau d'échantillonnage).

L'ensemble de données DoNeRF contient six séquences synthétiques avec une résolution d'image de 800 × 800 pixels.

Comme le montre le tableau 1, la méthode HyperReel surpasse qualitativement toutes les lignes de base et améliore dans une large mesure les performances des autres schémas de réseau d'échantillonnage.

Pendant ce temps, HyperReel est implémenté avec vanilla PyTorch et peut restituer une image de 800 × 800 pixels à 6,5 FPS sur un seul GPU RTX 3090 (ou 29 FPS avec le modèle Tiny).

De plus, par rapport au MLP profond de 88 couches et 256 unités cachées de R2L, le réseau à 6 couches et 256 unités cachées plus le squelette volumétrique TensoRF proposé par les chercheurs a une vitesse d'inférence plus rapide

L'ensemble de données LLFF contient 8 séquences du monde réel avec des images de 1 008 × 756 pixels.

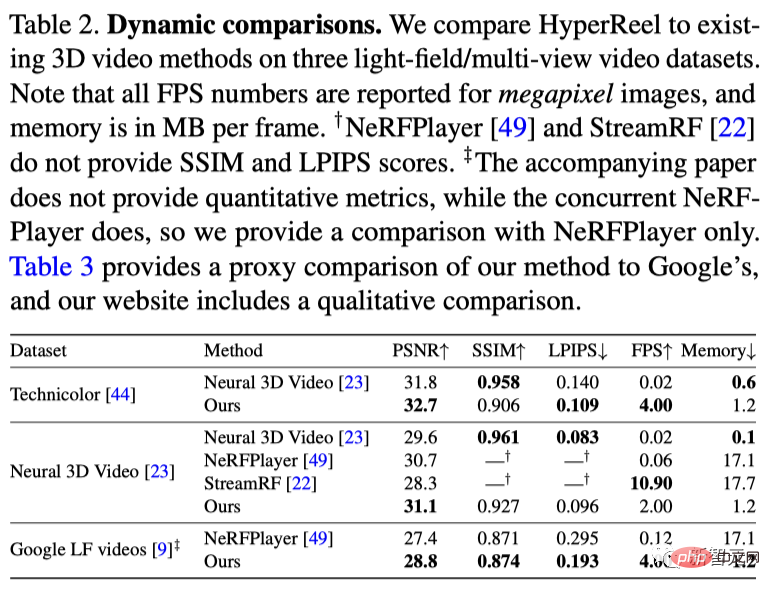

Comparaison de scènes dynamiques

Ensemble de données Technicolor

Ensemble de données vidéo Neural 3D

L'ensemble de données vidéo Neural 3D contient 6 séquences vidéo multi-vues en intérieur, filmées par 20 caméras à une résolution de 2704 × 2028 pixels.

De plus, HyperReel consomme en moyenne beaucoup moins de mémoire par image que StreamRF et NeRFPlayer.

Ensemble de données immersives Google

L'ensemble de données immersives Google contient des vidéos de champs lumineux de divers environnements intérieurs et extérieurs.

Cependant, étant donné que cette méthode est implémentée dans Vanilla PyTorch, les performances peuvent être encore optimisées grâce à des travaux tels qu'un noyau CUDA personnalisé.

Présentation de l'auteur

Présentation de l'auteur

Le premier auteur de l'article, Benjamin Attal, poursuit actuellement un doctorat au Carnegie Mellon Robotics Institute. Les intérêts de recherche comprennent la réalité virtuelle, l’imagerie et les affichages informatiques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Qu'est-ce qu'un servomoteur

Qu'est-ce qu'un servomoteur

Introduction aux méthodes de diagnostic SEO

Introduction aux méthodes de diagnostic SEO

Que comprend le stockage par cryptage des données ?

Que comprend le stockage par cryptage des données ?

Quelles sont les principales différences entre Linux et Windows

Quelles sont les principales différences entre Linux et Windows

Une mémoire capable d'échanger des informations directement avec le CPU est une

Une mémoire capable d'échanger des informations directement avec le CPU est une

Comment ouvrir le fichier mds

Comment ouvrir le fichier mds

Changer la couleur d'arrière-plan du mot en blanc

Changer la couleur d'arrière-plan du mot en blanc

Quels sont les outils de développement ?

Quels sont les outils de développement ?