Le 5 octobre, AlphaTensor a été lancé et DeepMind a annoncé avoir résolu un problème d'algorithme mathématique non résolu dans le domaine des mathématiques depuis 50 ans, à savoir la multiplication matricielle. AlphaTensor devient le premier système d'IA à découvrir de nouveaux algorithmes efficaces et dont la correction est prouvée pour des problèmes mathématiques tels que la multiplication matricielle. L'article «Découvrir des algorithmes de multiplication matricielle plus rapides avec apprentissage par renforcement» figurait également en couverture de Nature.

Cependant, le record d’AlphaTensor n’a duré qu’une semaine avant d’être battu par des mathématiciens humains.

Dans leurs derniers travaux, les chercheurs Manuel Kauers et Jakob Moosbauer de l'Université Johann Kepler de Linz, en Autriche, affirment avoir battu le record de multiplication matricielle d'AlphaTensor. Ils ont développé une méthode qui effectue une multiplication matricielle 5×5 en 95 étapes, soit une étape de moins que l’enregistrement d’AlphaTensor de 96 étapes et le précédent enregistrement de 98 étapes. Une prépublication de l'article a été publiée sur arxiv le 13 octobre.

Adresse papier : https://arxiv.org/abs/2210.04045

Le "FBHHRBNRSSSHK" dans le titre du papier est en fait une combinaison des premières lettres des noms de famille de tous les auteurs de l'article DeepMind. Cette méthode de dénomination est également très intéressante :

L'exploration des problèmes mathématiques ne s'arrêtera jamais. Comme l'a dit l'auteur, la solution de l'algorithme DeepMind "n'est toujours pas la fin de l'histoire". Cependant, leur percée cette fois est de s'appuyer sur les épaules de géants, c'est-à-dire l'IA. L'auteur a déclaré que leur solution consiste à appliquer une série de transformations basées sur la solution DeepMind, éliminant ainsi le calcul de multiplication en une étape.

1De nombreuses tâches mathématiques en informatique sont traitées par multiplication matricielle, comme l'apprentissage automatique, la création d'infographies, les simulations diverses ou la compression de données. Les ordinateurs calculent la multiplication beaucoup plus lentement que l'addition, de sorte que même une légère amélioration de l'efficacité de la multiplication matricielle peut avoir un impact énorme. Depuis des décennies, les mathématiciens recherchent des algorithmes de multiplication matricielle plus efficaces.

En 1969, le mathématicien allemand Volker Strassen a développé un algorithme qui a pour la première fois réduit la solution de multiplication matricielle 4×4 de 64 étapes à 49 étapes, choquant le monde des mathématiques.

Le système d'IA AlphaTensor publié par Deepmind a cette fois découvert un nouvel algorithme plus rapide que l'algorithme de Strassen. Demis Hassabis a déclaré que le nouvel algorithme a le potentiel d'augmenter l'efficacité de 10 à 20 % pour des milliards de calculs par jour.

AlphaTensor est un saut des jeux aux mathématiques, basé sur AlphaZero, un système d'IA de jeu de société à usage général publié par Deepmind en 2018. Pour entraîner AlphaTensor, l’équipe de recherche de Deepmind a transformé un problème de multiplication matricielle en un jeu de société 3D, chaque étape produisant les éléments de base d’un nouvel algorithme. AlphaTensor est récompensé pour avoir généré de nouveaux algorithmes en aussi peu d'étapes que possible en choisissant à chaque fois parmi des dizaines de milliers de mouvements. Deepmind appelle cela un « jeu tenseur ».

Dans une matrice d'entrée 5×5, AlphaTensor a découvert indépendamment l'algorithme de Strassen et d'autres algorithmes connus. De plus, il a développé de nouveaux algorithmes plus efficaces que les anciens.

Par exemple, la multiplication matricielle 5×5 (n=4) était calculée en 80 étapes, mais le nouvel algorithme d'AlphaTensor ne nécessite que 76 étapes lorsque n=5, AlphaTensor réduit la solution des 98 étapes d'origine à 96 ; mesures. La multiplication matricielle 4×4 est réduite à 49 pas par Strassen et optimisée à 47 pas par AlphaTensor. Cette efficacité est obtenue grâce à plus de 70 algorithmes de multiplication matricielle générés par AlphaTensor.

Légende : La complexité de l'algorithme découverte par AlphaTensor est comparée aux algorithmes de multiplication matricielle connus

De plus, AlphaTensor peut également développer des algorithmes spécifiques au matériel pour l'apprentissage automatique. On dit qu'il fonctionne actuellement 20 % plus rapidement que les algorithmes des TPU de Google et des NVIDIA V100.

Il est difficile pour les humains d'ajuster indépendamment l'algorithme de multiplication pour s'adapter au matériel, c'est pourquoi l'amélioration par AlphaTensor de l'algorithme de Strassen crée une nouvelle limite supérieure pour la multiplication matricielle 4×4, ce qui est une preuve majeure que les progrès de l'IA peuvent aider d'autres disciplines. Cela montre également que le système AlphaZero, initialement développé pour les jeux traditionnels, peut résoudre des problèmes mathématiques en dehors du domaine.

Dans cet article, l'auteur démontre brièvement les deux schémas de multiplication matricielle. Un article formel sera bientôt publié pour présenter plus en détail la technologie de recherche de l'algorithme de solution.

Le nouveau schéma pour une matrice 4 × 4 contient un total de 47 multiplications, comme suit :

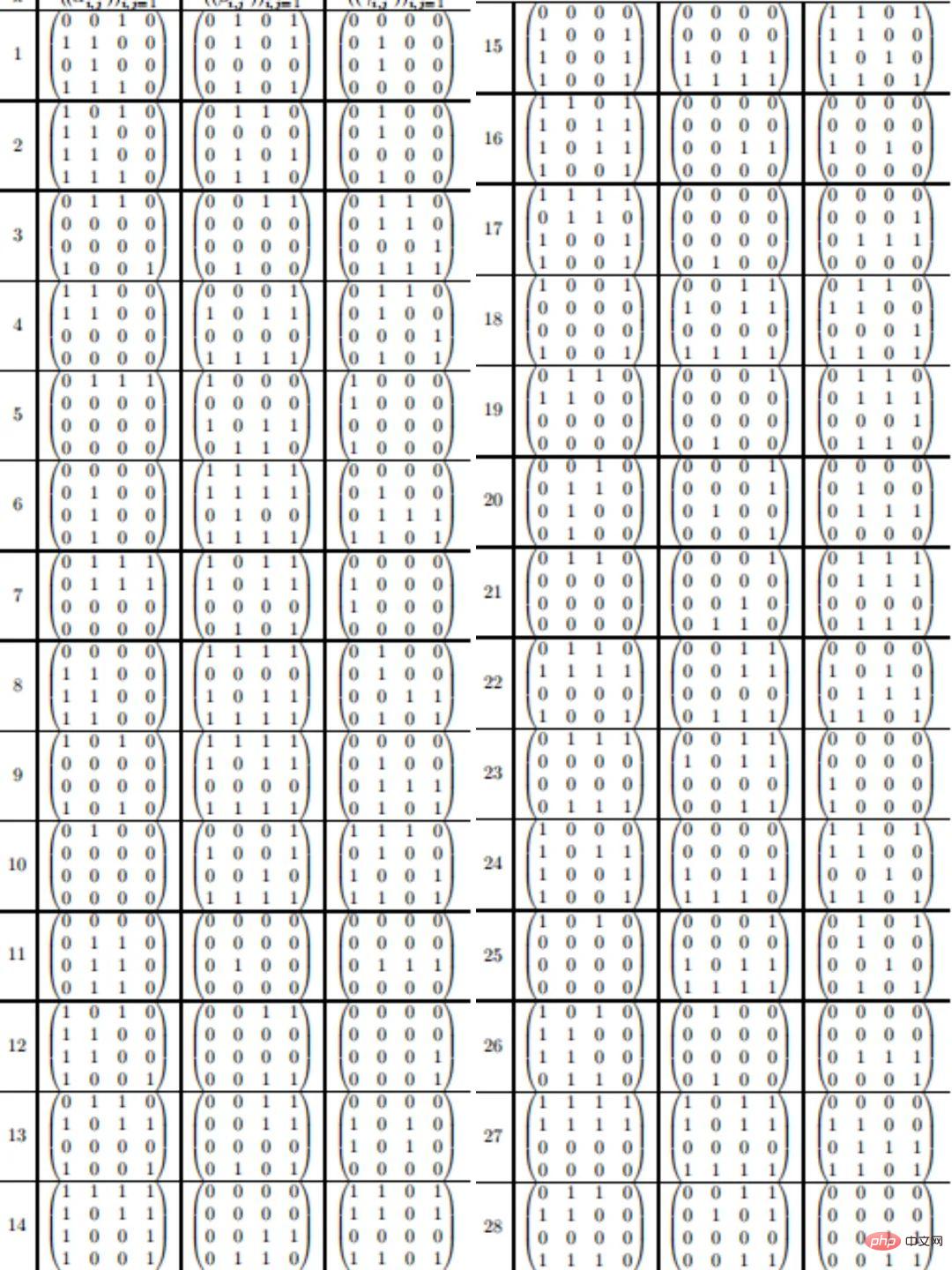

5×5 matrice (n = 5) La solution de multiplication en 95 étapes est la suivante : Considérant que le GPU doit effectuer un billion de calculs matriciels chaque jour, donc de 98 à 96 et Une amélioration incrémentielle apparemment faible de 96 étapes à 95 étapes peut en fait grandement améliorer l’efficacité informatique et permettre aux applications d’IA de s’exécuter plus rapidement sur le matériel existant.

À propos de l'auteur : Manuel Kauers, professeur d'algèbre à l'université Johannes Kepler de Linz et directeur de l'Institut d'algèbre de l'université. Ses intérêts de recherche sont le calcul formel, la sommation et l'intégration symboliques, les identités de fonctions spéciales, etc.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Algorithme de remplacement de page

Algorithme de remplacement de page

iexplore.exe

iexplore.exe

Comment définir le retour à la ligne automatique dans Word

Comment définir le retour à la ligne automatique dans Word

utilisation de location.reload

utilisation de location.reload

utilisation de la fonction stripslashes

utilisation de la fonction stripslashes

Une mémoire capable d'échanger des informations directement avec le CPU est une

Une mémoire capable d'échanger des informations directement avec le CPU est une

La différence entre Linux et Windows

La différence entre Linux et Windows

Adresse du portefeuille Yiooke

Adresse du portefeuille Yiooke

Qu'est-ce que cela signifie lorsqu'un message a été envoyé mais rejeté par l'autre partie ?

Qu'est-ce que cela signifie lorsqu'un message a été envoyé mais rejeté par l'autre partie ?