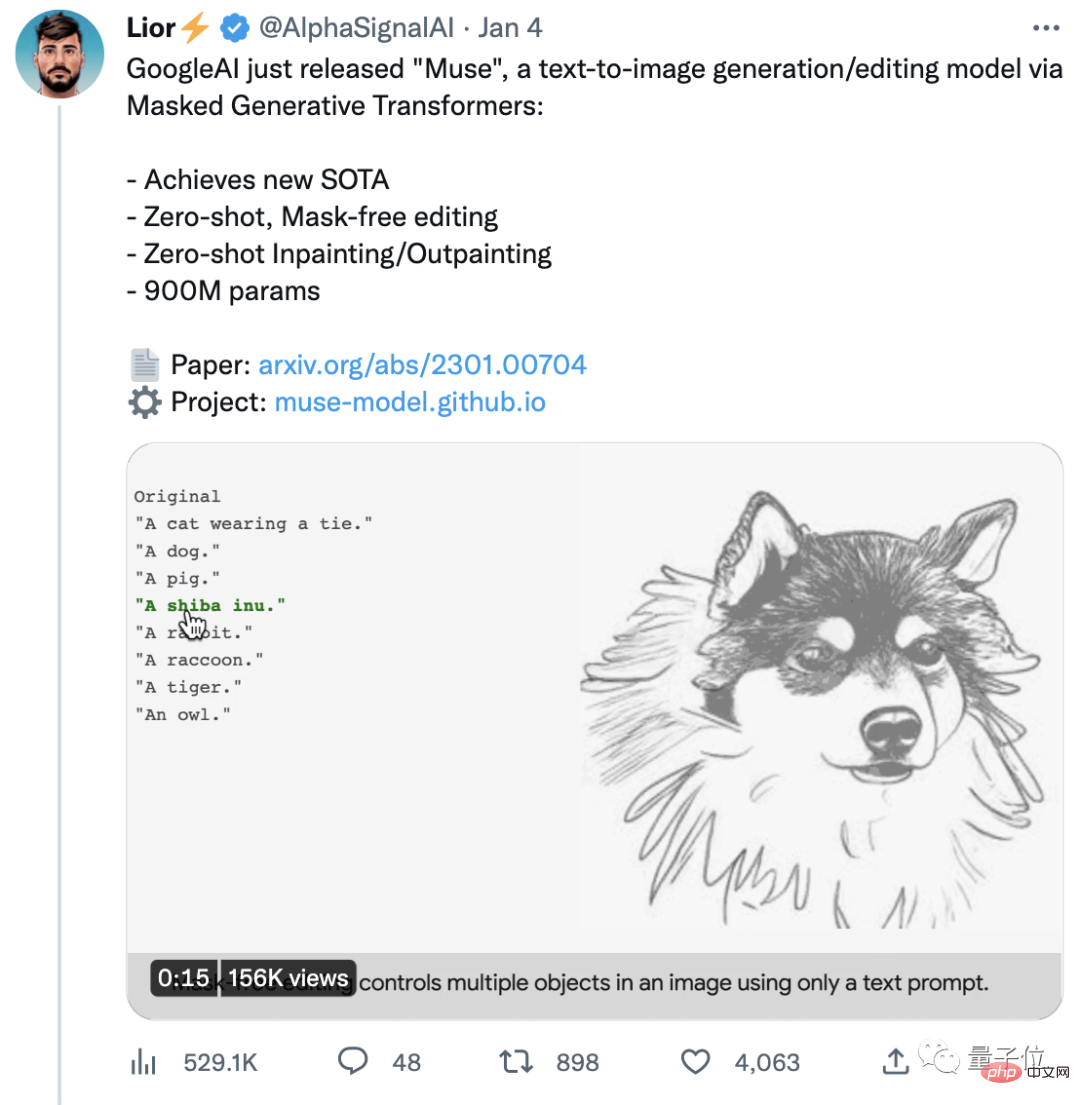

Au début de la nouvelle année, Google AI a recommencé à travailler sur des modèles de génération texte-image.

Cette fois, leur nouveau modèle Muse a atteint un nouveau SOTA (actuellement le meilleur niveau) sur l'ensemble de données CC3M.

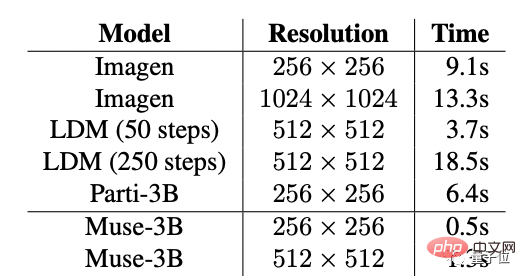

Et son efficacité est bien supérieure à celle des populaires DALL·E 2 et Imagen (qui sont tous deux des modèles de diffusion) et Parti (qui est un modèle autorégressif).

——Le temps de génération d'une seule image de résolution 512x512 est compressé à seulement 1,3 seconde.

En termes d'édition d'image, vous pouvez modifier l'image originale avec juste une commande de texte.

(On dirait que vous n'avez plus à vous soucier de l'apprentissage du PS~)

Si vous souhaitez un effet plus précis, vous pouvez également sélectionner la position du masque et modifier une zone spécifique. Par exemple, remplacez les bâtiments en arrière-plan par des montgolfières.

Muse a rapidement attiré beaucoup d'attention une fois qu'elle a été officiellement annoncée. La publication originale a déjà reçu plus de 4 000 likes.

En voyant un autre chef-d'œuvre de Google, certaines personnes ont même commencé à prédire :

La concurrence entre les développeurs d'IA est désormais très féroce, et il semble que 2023 sera une année très excitante.

Back to the Muse vient de sortir par Google.

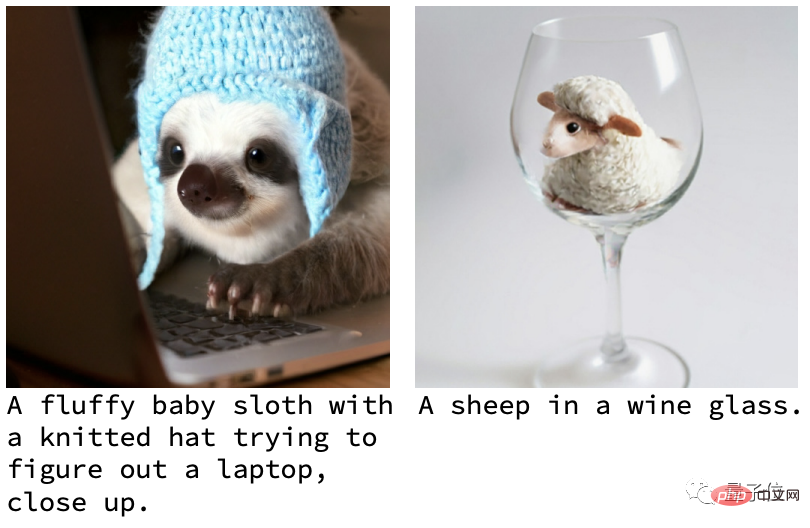

Tout d’abord, en termes de qualité des images générées, la plupart des œuvres de Muse ont des images claires et des effets naturels.

Jetons un coup d'œil à d'autres exemples pour avoir une idée ~

Par exemple, un bébé paresseux portant un chapeau en laine utilise un ordinateur ; un autre exemple est un mouton dans un verre à vin :

Divers sujets ; qui ne peuvent généralement pas être frappés avec huit pôles, ils coexistent harmonieusement dans une seule image et il n'y a aucun sentiment de dissonance.

Si vous pensez que celles-ci ne peuvent être considérées que comme les opérations de base de l'AIGC, alors vous pourriez aussi bien jeter un œil à la fonction d'édition de Muse.

Par exemple, changer de tenue en un clic (vous pouvez également changer de sexe) :

Cela ne nécessite aucun masquage et peut se faire en une seule phrase.

Et si vous utilisez un masque, vous pouvez réaliser 6 opérations supplémentaires, dont changer l'arrière-plan en un seul clic, du lieu d'origine à New York, Paris, puis à San Francisco.

Vous pouvez également aller du bord de mer à Londres, à la mer de fleurs, ou même voler vers les anneaux de Saturne dans l'espace pour faire un passionnant saut de dauphin en skateboard.

(Bon gars, non seulement tu peux facilement voyager dans le nuage, mais tu peux aussi voler vers le ciel en un seul clic...)

L'effet est vraiment exceptionnel. Alors, quel support technique se cache derrière Muse ? Pourquoi l'efficacité est-elle supérieure à celle de DALL·E 2 et Imagen ?

Une raison importante est que DALL·E 2 et Imagen doivent stocker toutes les connaissances acquises dans les paramètres du modèle pendant le processus de formation.

Ils doivent donc avoir besoin de modèles de plus en plus grands et de plus en plus de données de formation pour acquérir plus de connaissances - en reliant Better et Bigger ensemble.

Le coût est que le nombre de paramètres est énorme et que l'efficacité est également affectée.

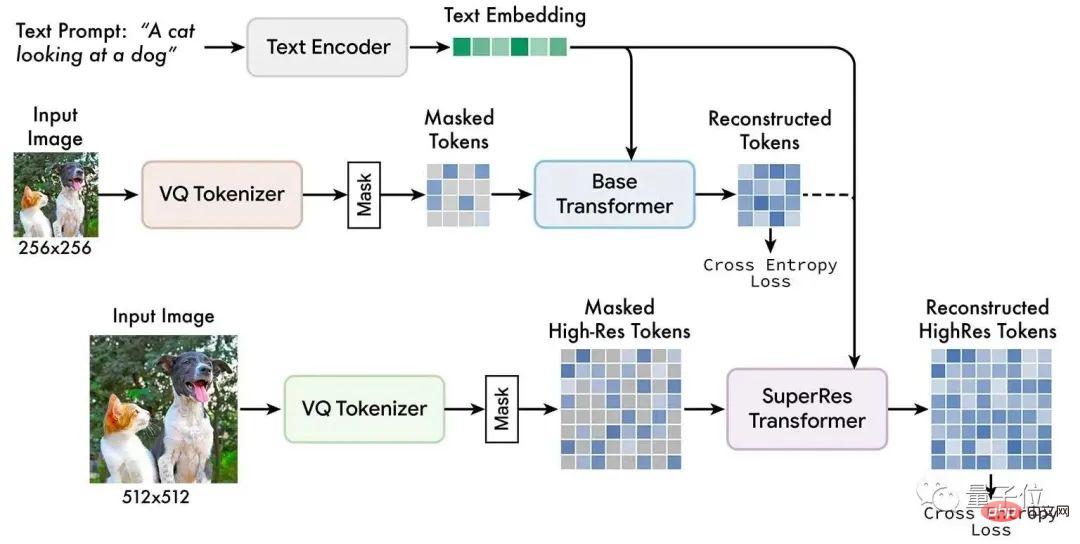

Selon l'équipe Google AI, la principale méthode qu'ils utilisent s'appelle : Modélisation d'images masquées.

Il s'agit d'une méthode émergente de pré-formation auto-supervisée. Son idée de base est simplement :

.Une partie de l'image d'entrée est masquée de manière aléatoire puis reconstruite par des tâches de texte de pré-entraînement.

Les modèles Muse sont formés sur des masques spatiaux discrètement étiquetés et combinés avec du texte extrait de grands modèles de langage pré-entraînés pour prédire les étiquettes d'images masquées de manière aléatoire.

L'équipe de Google a découvert que l'utilisation de grands modèles de langage pré-entraînés peut rendre la compréhension du langage par l'IA plus approfondie.

En termes de résultat, parce que l'IA a une bonne compréhension de la relation spatiale, de la posture et d'autres éléments des objets, les images générées peuvent être haute fidélité.

Par rapport aux modèles de diffusion spatiale de pixels tels que DALL·E 2 et Imagen, Muse utilise des jetons discrets et comporte moins d'itérations d'échantillonnage.

De plus, par rapport aux modèles autorégressifs tels que Parti, Muse utilise un décodage parallèle, qui est plus efficace.

Comme mentionné précédemment, Muse a non seulement amélioré son efficacité, mais est également très efficace pour générer une qualité d'image.

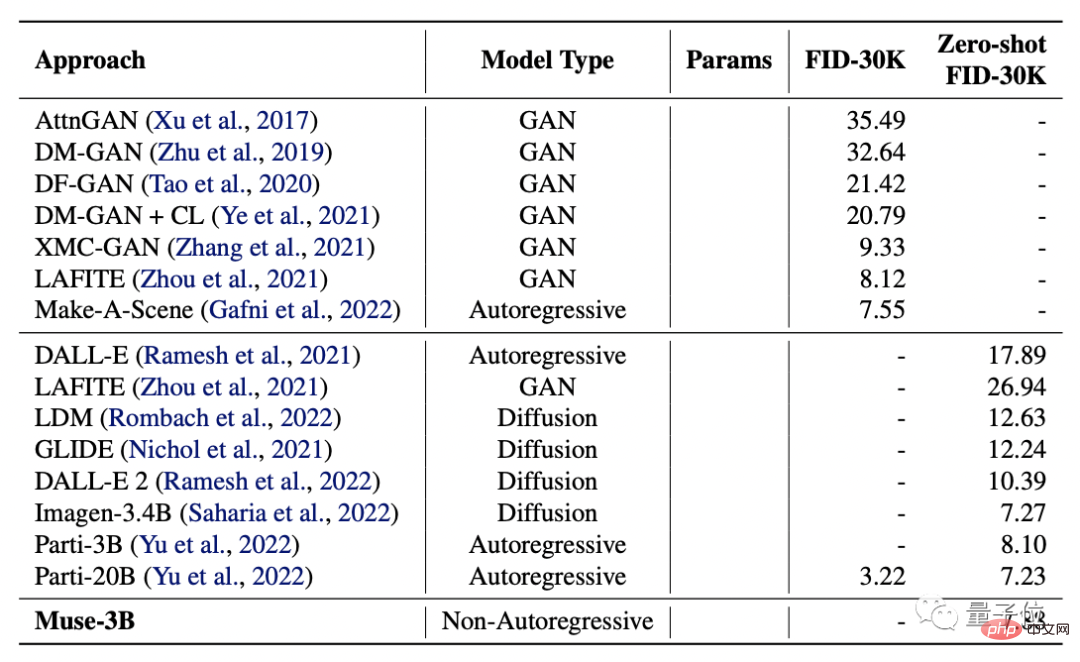

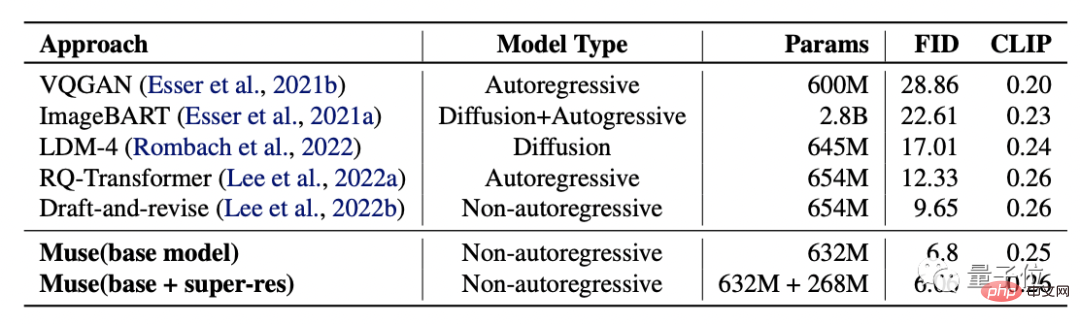

Les chercheurs l'ont comparé avec DALL·E, LAFITE, LDM, GLIDE, DALL·E 2, ainsi qu'avec Imagen et Parti de Google, et ont testé leurs scores FID et CLIP.

(Le score FID est utilisé pour évaluer la qualité de l'image générée. Plus le score est bas, plus la qualité est élevée ; le score CLIP représente le degré d'ajustement entre le texte et l'image. Plus le score est élevé, mieux c'est.)

Les résultats montrent que le modèle Muse-3B a été vérifié dans COCO. Le FID-30K centralisé à tir nul a obtenu un score de 7,88, juste derrière les modèles Imagen-3.4B et Parti-20B avec des paramètres plus grands.

Mieux encore, le modèle Muse-900M a atteint un nouveau SOTA sur l'ensemble de données CC3M, avec un score FID de 6,06, ce qui signifie également que son degré de correspondance avec le texte est le plus élevé.

Dans le même temps, le score CLIP de ce modèle est de 0,26, qui a également atteint le niveau le plus élevé au cours de la même période.

De plus, afin de confirmer davantage l'efficacité du rendu d'image de Muse, les chercheurs ont également comparé le temps de génération d'image unique de Muse et d'autres modèles :

Muse a atteint la résolution la plus élevée à 256x256 et 512x512 Vitesse rapide : 0,5 s et 1,3 s.

L'équipe de recherche de Muse vient de Google et les deux co-auteurs sont Huiwen Chang et Han Zhang.

Huiwen Chang, aujourd'hui chercheuse senior chez Google.

Elle a étudié à l'Université Tsinghua en tant que premier cycle et a obtenu un doctorat de l'Université de Princeton. Elle a effectué des stages chez Adobe, Facebook, etc.

Han Zhang a obtenu son diplôme de premier cycle de l'Université agricole de Chine, sa maîtrise de l'Université des postes et télécommunications de Pékin et son doctorat en informatique de l'Université Rutgers.

Ses axes de recherche sont la vision par ordinateur, l'apprentissage profond et l'analyse d'images médicales.

Cependant, il convient de mentionner que Muse n'a pas encore été officiellement publié.

Certains internautes ont plaisanté en disant que même si cela devrait être très parfumé, avec le "comportement urinaire" de Google, Muse pourrait encore être loin de sa sortie officielle - après tout, ils n'ont pas publié l'IA depuis 18 ans.

En parlant de ça, que pensez-vous de l'effet de Muse ?

Avez-vous hâte de sa sortie officielle ?

Portail :https://www.php.cn/link/854f1fb6f65734d9e49f708d6cd84ad6

Lien de référence : https://twitter.com/AlphaSignalAI/status/1610404589966180360

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!