Périphériques technologiques

Périphériques technologiques

IA

IA

alerte! La crise de consommation d'énergie provoquée par l'explosion de ChatGPT pose d'énormes défis aux opérateurs de centres de données

alerte! La crise de consommation d'énergie provoquée par l'explosion de ChatGPT pose d'énormes défis aux opérateurs de centres de données

alerte! La crise de consommation d'énergie provoquée par l'explosion de ChatGPT pose d'énormes défis aux opérateurs de centres de données

Récemment, ChatGPT, un outil de chat intelligent appartenant à la société américaine OpenAI, a pris d'assaut les médias sociaux, attirant plus de 10 milliards de dollars d'investissement et suscitant un énorme engouement pour les applications d'intelligence artificielle sur le marché des capitaux. sous les projecteurs pendant un moment.

Microsoft a été le premier à annoncer un investissement de 10 milliards de dollars dans OpenAI, puis Amazon et la version américaine de "Today's Toutiao" BuzzFeed ont annoncé qu'ils activeraient ChatGPT dans leur travail quotidien. Baidu a également annoncé qu'il lancerait la « version chinoise » de ChatGPT en mars. Après que de nombreuses entreprises technologiques aient jeté de l’huile sur le feu, ChatGPT a immédiatement attiré l’attention du monde entier.

Les données montrent que le nombre de robots déployés par Amazon augmente rapidement, l'augmentation quotidienne atteignant environ 1 000. En outre, la société mère de Facebook, Meta, prévoit également d'investir entre 4 et 5 milliards de dollars supplémentaires dans les centres de données en 2023, la totalité de cette somme devant être utilisée pour l'intelligence artificielle. Le PDG d'IBM, Krishna, a déclaré que l'intelligence artificielle devrait contribuer à hauteur de 16 000 milliards de dollars à l'économie mondiale d'ici 2030.

Avec la popularité de ChatGPT, les géants pourraient lancer une nouvelle série de batailles acharnées dans le domaine de l'intelligence artificielle en 2023.

Cependant, lorsque ChatGPT-3 prédit le mot suivant, il doit effectuer plusieurs calculs d'inférence, occupant ainsi beaucoup de ressources et consommant plus d'énergie. À mesure que l'infrastructure des centres de données se développe pour prendre en charge la croissance explosive du cloud computing, du streaming vidéo et des réseaux 5G, son architecture GPU et CPU ne peut pas fonctionner efficacement pour répondre aux besoins informatiques imminents, ce qui crée des problèmes énormes pour les opérateurs de centres de données à grande échelle.

La formation GPT3.5 utilise le système informatique d'IA spécialement conçu par Microsoft, un cluster réseau hautes performances composé de 10 000 GPU V100, avec une consommation totale de puissance de calcul d'environ 3 640 jours-PF (c'est-à-dire si un quadrillion est calculé par deuxième fois, 3640 jours doivent être calculés). Une tâche de formation de cluster GPU d'une telle envergure et à long terme impose des exigences extrêmes en termes de performances, de fiabilité, de coût et d'autres aspects de la base d'interconnexion réseau.

Par exemple, Meta a annoncé qu'elle suspendrait l'expansion des centres de données dans le monde et reconfigurerait ces fermes de serveurs pour répondre aux besoins de traitement des données de l'intelligence artificielle.

Les besoins en traitement des données des plates-formes d'intelligence artificielle sont énormes. Les créateurs OpenAI de ChatGPT ont lancé la plate-forme en novembre de l'année dernière. Elle ne pourra pas continuer à fonctionner sans la prochaine mise à niveau de la plate-forme cloud Azure de Microsoft.

L'infrastructure du centre de données qui soutient cette transformation numérique sera organisée comme le cerveau humain en deux hémisphères ou lobes, un lobe devant être beaucoup plus puissant que l'autre. Un hémisphère servira à ce qu'on appelle la « formation », la puissance de calcul nécessaire pour traiter jusqu'à 300 milliards de points de données afin de créer la salade de mots générée par ChatGPT.

La formation des lobes nécessite une puissance de calcul puissante et des semi-conducteurs GPU de pointe, mais dans les clusters de centres de données prenant en charge les services de cloud computing et les réseaux 5G, peu de connectivité est actuellement requise.

Dans le même temps, l'infrastructure axée sur la « formation » de chaque plate-forme d'IA créera d'énormes demandes d'énergie, exigeant que les centres de données soient situés à proximité de gigawatts d'énergie renouvelable, que de nouveaux systèmes de refroidissement liquide soient installés et repensés. systèmes d'alimentation de secours et de générateur, ainsi que d'autres nouvelles fonctionnalités de conception.

Plateformes d'intelligence artificielle L'autre hémisphère du cerveau, une infrastructure numérique plus performante connue sous le nom de mode « inférence », prend en charge des plates-formes « génératives » interactives qui, quelques secondes après la saisie d'une question ou d'une instruction, les requêtes sont traitées dans la base de données modélisée. et a répondu avec une syntaxe humaine convaincante.

Alors que les réseaux de centres de données hyper-connectés d'aujourd'hui, comme le plus grand cluster de centres de données en Amérique du Nord, les « centres de données » de Virginie du Nord disposent également des réseaux de fibre optique les plus étendus pour répondre aux besoins de connectivité de niveau supérieur de « l'inférence » du cerveau de l'IA. " part, mais ces installations devront également être modernisées pour répondre à l'énorme capacité de traitement requise, et elles devront être plus proches des sous-stations.

De plus, les données des instituts de recherche montrent que les centres de données sont devenus les plus grands consommateurs d'énergie au monde et que leur proportion dans la consommation totale d'électricité passera de 3 % en 2017 à 4,5 % en 2025. En prenant la Chine comme exemple, la consommation électrique des centres de données opérant dans tout le pays devrait dépasser 400 milliards de kWh en 2030, soit 4 % de la consommation électrique totale du pays.

Par conséquent, même les produits numériques nécessitent de l'énergie pour se développer et consommer, et ChatGPT ne fait pas exception. On estime que le traitement d'inférence dans le travail d'apprentissage automatique représente 80 à 90 % de la consommation d'énergie de calcul, depuis le lancement de ChatGPT en novembre 2022. Depuis la mise en ligne le 30, les émissions de carbone ont dépassé 814,61 tonnes.

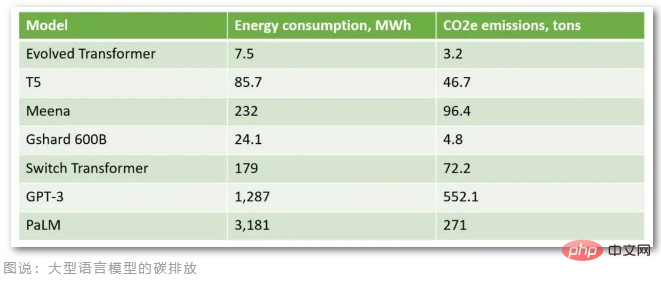

Selon les calculs des organisations professionnelles, en supposant que ChatGPT hébergé sur le cloud Azure de Microsoft reçoit 1 million de demandes d'utilisateurs par jour (environ 29 167 heures par jour sous un temps de réponse et un vocabulaire spécifiques), la puissance maximale du GPU A100 est de 407 W. (Watt), les émissions quotidiennes de carbone atteignent 3,82 tonnes et les émissions mensuelles de carbone dépassent 100 tonnes. Aujourd'hui, ChatGPT compte plus de 10 millions d'utilisateurs quotidiens et les émissions de carbone réelles dépassent largement les 100 tonnes par mois. De plus, la formation d'un modèle de langage aussi volumineux contenant 175 milliards de paramètres nécessite des dizaines de milliers de CPU/GPU pour saisir des données 24 heures sur 24, consomme environ 1 287 MWh d'électricité et émet plus de 552 tonnes de dioxyde de carbone.

À en juger par les émissions de carbone de ces grands modèles linguistiques, GPT-3, le prédécesseur de ChatGPT, a les émissions de carbone les plus importantes. On rapporte que les Américains produisent en moyenne 16,4 tonnes d’émissions de carbone chaque année et que les Danois produisent en moyenne 11 tonnes d’émissions de carbone chaque année. En conséquence, le modèle de ChatGPT est formé pour émettre plus d’émissions de carbone que 50 Danois n’en émettent par an.

Les fournisseurs de cloud computing reconnaissent également que les centres de données consomment de grandes quantités d'électricité et ont pris des mesures pour améliorer leur efficacité, comme la construction et l'exploitation de centres de données dans l'Arctique pour tirer parti des énergies renouvelables et des conditions de refroidissement naturelles. Toutefois, cela ne suffit pas pour répondre à la croissance explosive des applications d’IA.

Le laboratoire national Lawrence Berkeley aux États-Unis a découvert dans une recherche que les améliorations de l'efficacité des centres de données ont contrôlé la croissance de la consommation d'énergie au cours des 20 dernières années, mais les recherches montrent que les mesures d'efficacité énergétique actuelles pourraient ne pas suffire pour répondre aux besoins des futurs centres de données. besoins.

Le secteur de l’intelligence artificielle se trouve aujourd’hui à un tournant critique. Les progrès technologiques en matière d'IA générative, de reconnaissance d'images et d'analyse de données révèlent des connexions et des utilisations uniques pour l'apprentissage automatique, mais une solution technologique capable de répondre à ce besoin doit d'abord être construite car, selon Gartner, à moins d'un choix plus durable, sinon d'ici 2025 , l’IA consommera plus d’énergie que les activités humaines.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Samsung présente le SSD de qualité centre de données BM1743 : équipé de v7 QLC V-NAND et prend en charge PCIe 5.0

Jun 18, 2024 pm 04:15 PM

Samsung présente le SSD de qualité centre de données BM1743 : équipé de v7 QLC V-NAND et prend en charge PCIe 5.0

Jun 18, 2024 pm 04:15 PM

Selon des informations publiées sur ce site Web le 18 juin, Samsung Semiconductor a récemment présenté sur son blog technologique son disque SSD de nouvelle génération de qualité centre de données BM1743, équipé de sa dernière mémoire flash QLC (v7). ▲Disque SSD de qualité centre de données Samsung QLC BM1743 Selon TrendForce en avril, dans le domaine des disques SSD de qualité centre de données QLC, seuls Samsung et Solidigm, une filiale de SK Hynix, avaient réussi la vérification du client d'entreprise à ce temps. Par rapport à la génération précédente v5QLCV-NAND (remarque sur ce site : Samsung v6V-NAND n'a pas de produits QLC), la mémoire flash Samsung v7QLCV-NAND a presque doublé le nombre de couches d'empilement et la densité de stockage a également été considérablement améliorée. Dans le même temps, la fluidité de v7QLCV-NAND

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

Selon les informations de ce site le 1er août, SK Hynix a publié un article de blog aujourd'hui (1er août), annonçant sa participation au Global Semiconductor Memory Summit FMS2024 qui se tiendra à Santa Clara, Californie, États-Unis, du 6 au 8 août, présentant de nombreuses nouvelles technologies de produit. Introduction au Future Memory and Storage Summit (FutureMemoryandStorage), anciennement Flash Memory Summit (FlashMemorySummit) principalement destiné aux fournisseurs de NAND, dans le contexte de l'attention croissante portée à la technologie de l'intelligence artificielle, cette année a été rebaptisée Future Memory and Storage Summit (FutureMemoryandStorage) pour invitez les fournisseurs de DRAM et de stockage et bien d’autres joueurs. Nouveau produit SK hynix lancé l'année dernière

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Selon les informations de ce site Web du 5 juillet, GlobalFoundries a publié un communiqué de presse le 1er juillet de cette année, annonçant l'acquisition de la technologie de nitrure de gallium (GaN) et du portefeuille de propriété intellectuelle de Tagore Technology, dans l'espoir d'élargir sa part de marché dans l'automobile et Internet. des objets et des domaines d'application des centres de données d'intelligence artificielle pour explorer une efficacité plus élevée et de meilleures performances. Alors que des technologies telles que l’intelligence artificielle générative (GenerativeAI) continuent de se développer dans le monde numérique, le nitrure de gallium (GaN) est devenu une solution clé pour une gestion durable et efficace de l’énergie, notamment dans les centres de données. Ce site Web citait l'annonce officielle selon laquelle, lors de cette acquisition, l'équipe d'ingénierie de Tagore Technology rejoindrait GF pour développer davantage la technologie du nitrure de gallium. g

Une nouvelle ère de développement front-end VSCode : 12 assistants de code IA hautement recommandés

Jun 11, 2024 pm 07:47 PM

Une nouvelle ère de développement front-end VSCode : 12 assistants de code IA hautement recommandés

Jun 11, 2024 pm 07:47 PM

Dans le monde du développement front-end, VSCode est devenu l'outil de choix pour d'innombrables développeurs grâce à ses fonctions puissantes et son riche écosystème de plug-ins. Ces dernières années, avec le développement rapide de la technologie de l'intelligence artificielle, des assistants de code IA sur VSCode ont vu le jour, améliorant considérablement l'efficacité du codage des développeurs. Les assistants de code IA sur VSCode ont poussé comme des champignons après la pluie, améliorant considérablement l'efficacité du codage des développeurs. Il utilise la technologie de l'intelligence artificielle pour analyser intelligemment le code et fournir une complétion précise du code, une correction automatique des erreurs, une vérification grammaticale et d'autres fonctions, ce qui réduit considérablement les erreurs des développeurs et le travail manuel fastidieux pendant le processus de codage. Aujourd'hui, je recommanderai 12 assistants de code d'IA de développement frontal VSCode pour vous aider dans votre parcours de programmation.