Périphériques technologiques

Périphériques technologiques

IA

IA

Plus de 580 milliards de dollars américains ! La bataille entre Microsoft et Google a fait monter en flèche la valeur marchande de Nvidia, d'environ 5 Intel

Plus de 580 milliards de dollars américains ! La bataille entre Microsoft et Google a fait monter en flèche la valeur marchande de Nvidia, d'environ 5 Intel

Plus de 580 milliards de dollars américains ! La bataille entre Microsoft et Google a fait monter en flèche la valeur marchande de Nvidia, d'environ 5 Intel

ChatGPT est à votre portée et vous pouvez répondre à toutes vos questions.

Vous savez, le coût de calcul de chaque conversation avec lui est tout simplement époustouflant.

Auparavant, les analystes disaient que ChatGPT coûtait 2 centimes pour répondre une fois.

Il faut savoir que la puissance de calcul nécessaire aux chatbots à intelligence artificielle est alimentée par des GPU.

Cela permet aux sociétés de puces comme NVIDIA de faire fortune.

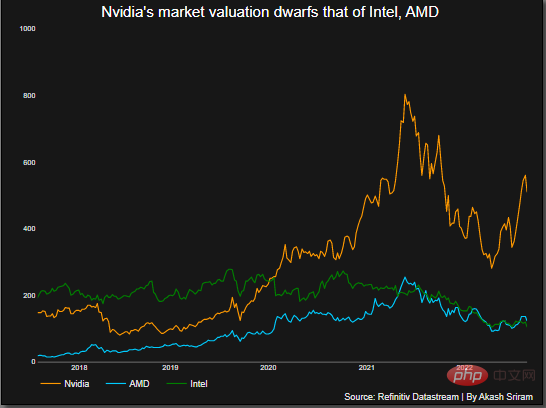

Le 23 février, le cours de l'action NVIDIA a grimpé en flèche, augmentant sa valeur marchande de plus de 70 milliards de dollars, et sa valeur marchande totale a dépassé 580 milliards de dollars, soit environ 5 fois celle d'Intel.

Outre NVIDIA, AMD peut être considéré comme le deuxième fabricant du secteur des processeurs graphiques, avec une part de marché d'environ 20 %.

Et Intel détient moins de 1% de part de marché.

ChatGPT est en cours d'exécution et NVIDIA gagne de l'argent

Alors que ChatGPT débloque des cas d'application potentiels, cela pourrait ouvrir la voie à un autre point d'inflexion dans les applications d'intelligence artificielle.

Pourquoi tu dis ça ?

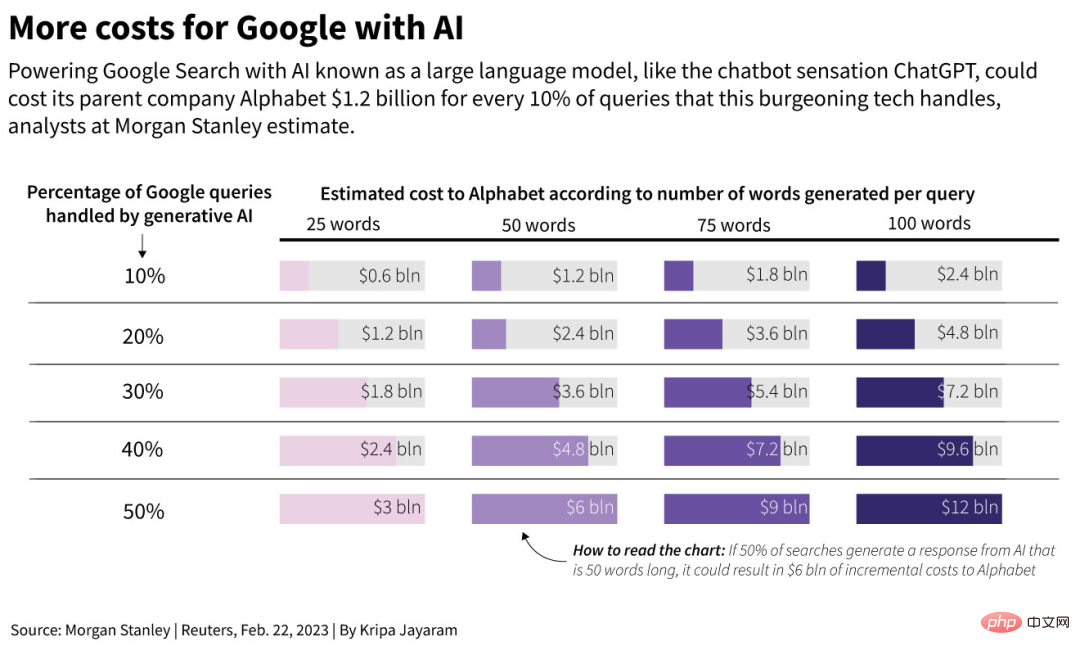

John Hennessy, président d'Alphabet, la société mère de Google, a déclaré dans une interview avec Reuters que le coût des conversations avec l'intelligence artificielle, comme les grands modèles de langage, pourrait être plus de 10 fois supérieur à celui des moteurs de recherche traditionnels.

L'analyse de Morgan Stanley montre que Google a effectué un total de 3,3 billions de recherches l'année dernière, et le coût de chaque recherche n'était que de 0,2 centime.

On estime que si le chatbot Bard de Google est introduit dans le moteur de recherche et utilisé pour gérer la moitié des recherches et des questions de Google, sur la base de 50 mots par réponse, le coût possible de l'entreprise en 2024 sera augmenter de 6 milliards de dollars.

De même, SemiAnalysis, une société de conseil spécialisée dans la technologie des puces, a déclaré qu'en raison de l'impact des puces internes de Google telles que les Tensor Processing Units, l'ajout de chatbots aux moteurs de recherche pourrait coûter à Google 3 milliards de dollars supplémentaires.

Il estime que Google doit réduire les coûts de fonctionnement d'une telle intelligence artificielle, mais ce processus n'est pas facile et prendra plusieurs années dans le pire des cas.

C'est pourquoi la recherche via des modèles de langage d'IA nécessite plus de puissance de calcul que les recherches traditionnelles.

Les analystes affirment que les coûts supplémentaires pourraient se chiffrer en milliards de dollars dans les années à venir.

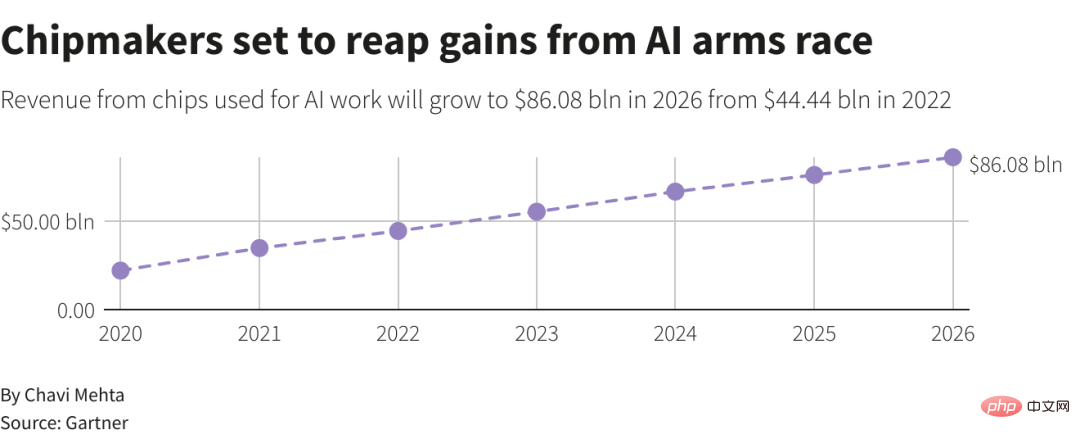

Gartner prédit que d'ici 2026, la part des puces professionnelles telles que les GPU utilisées dans les centres de données devrait augmenter de plus de 15 %, contre moins de 3 % en 2020.

Bien qu’il soit difficile de déterminer exactement quelle part des revenus de Nvidia l’IA représente aujourd’hui, elle a le potentiel de croître de façon exponentielle alors que les grandes entreprises technologiques se précipitent pour développer des applications d’IA similaires.

Mercredi, Nvidia a également annoncé un service cloud d'intelligence artificielle et s'est engagé à travailler avec Oracle, Microsoft et Google pour lui fournir la possibilité d'utiliser Nvidia GTX pour le traitement de l'intelligence artificielle via un simple accès au navigateur.

Cette nouvelle plateforme sera fournie par d'autres fournisseurs de services cloud et aidera les entreprises technologiques qui ne disposent pas de l'infrastructure pour construire la leur.

Huang Renxun a déclaré : « L'enthousiasme des gens pour ChatGPT a permis aux chefs d'entreprise de voir la puissance de l'intelligence artificielle. Mais maintenant, il s'agit principalement d'un logiciel à usage général. La réalisation de sa vraie valeur doit encore être basé sur l'Adapté aux besoins propres de l'entreprise, elle peut améliorer ses services et ses produits. "

NVIDIA gagne la domination du marché des GPU

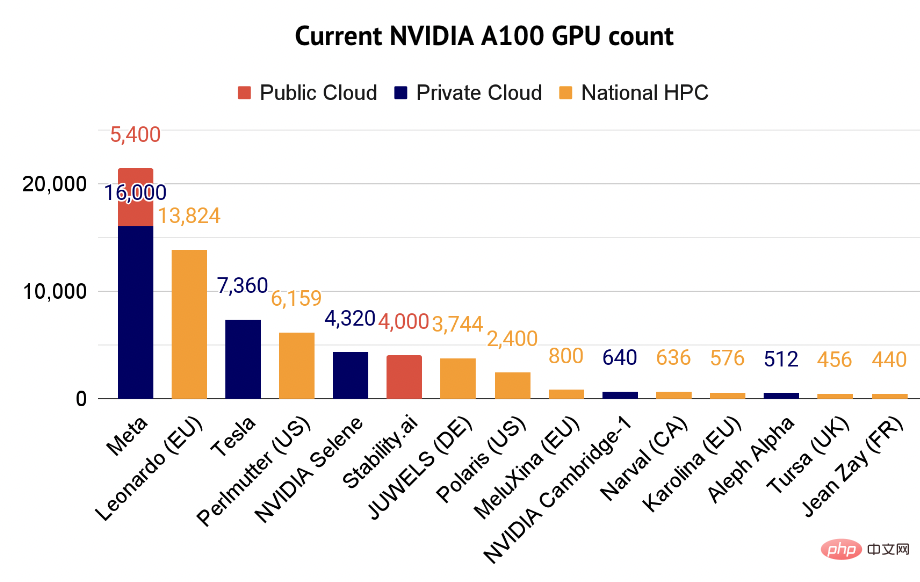

New Street Research a déclaré que NVIDIA occupe 95% du marché des processeurs graphiques. partager.

Dans l'indice des semi-conducteurs de la Bourse de Philadelphie, les actions Nvidia ont augmenté de 42 % cette année et sont les plus performantes.

Les investisseurs ont afflué vers Nvidia, pariant que la demande de systèmes d'intelligence artificielle tels que ChatGPT fera augmenter les commandes de produits de l'entreprise, ce qui en fera à nouveau le fabricant de puces le plus précieux au monde.

Depuis longtemps, qu'il s'agisse du top ChatGPT, ou de modèles comme Bard et Stable Diffusion, la puissance de calcul est assurée par une puce Nvidia A100 d'une valeur d'environ 10 000 $ US.

Le NVIDIA A100 est capable d'effectuer simultanément de nombreux calculs simples, ce qui est très important pour la formation et l'utilisation de modèles de réseaux neuronaux.

La technologie derrière l'A100 était à l'origine utilisée pour restituer des graphiques 3D complexes dans les jeux. Désormais, l’objectif est de gérer les tâches d’apprentissage automatique et de les exécuter dans des centres de données.

L'investisseur Nathan Benaich a déclaré que l'A100 est désormais devenu le « principal cheval de bataille » pour les professionnels de l'intelligence artificielle. Son rapport répertorie également certaines des entreprises utilisant le supercalculateur A100.

Les tâches d'apprentissage automatique peuvent consommer toute la puissance de traitement de votre ordinateur, parfois pendant des heures ou des jours.

Cela signifie que les entreprises proposant un produit d'IA le plus vendu doivent souvent acheter plus de GPU pour faire face aux périodes d'accès de pointe ou pour améliorer leurs modèles.

En plus d'un seul A100 sur une carte pouvant être branchée sur un serveur existant, de nombreux centres de données utilisent un système de 8 GPU A100.

Ce système est le Nvidia DGX A100, et un seul système se vend jusqu'à 200 000 dollars américains.

Nvidia a annoncé mercredi qu'elle vendrait directement l'accès au cloud aux systèmes DGX, réduisant ainsi potentiellement le coût d'entrée pour les chercheurs.

Alors, combien coûte l'exécution de la nouvelle version de Bing ?

Une évaluation réalisée par New Street Research a révélé que le modèle ChatGPT basé sur OpenAI dans la recherche Bing pourrait nécessiter 8 GPU pour donner une réponse à une question en moins d'une seconde.

À ce rythme, Microsoft aurait besoin de plus de 20 000 serveurs 8 GPU pour déployer ce modèle entre les mains de tous.

Ensuite, Microsoft pourrait dépenser 4 milliards de dollars en dépenses d'infrastructure.

Il ne s'agit que de Microsoft. S'il veut atteindre l'échelle de requêtes quotidiennes de Google, qui doit fournir 8 à 9 milliards de requêtes chaque jour, il devra dépenser 80 milliards de dollars.

Pour un autre exemple, la dernière version de Stable Diffusion tourne sur 256 processeurs graphiques A100, soit 32 DGX A100 pour 200 000 heures de calcul.

Mostaque, PDG de Stability AI, a déclaré que, sur la base des prix du marché, il en coûterait 600 000 $ rien que pour entraîner le modèle. Le prix est très abordable par rapport à la concurrence. Cela n’inclut pas le coût de déduction ou de déploiement du modèle.

Huang Renxun a déclaré dans une interview :

En termes de quantité de calcul requise pour ce type de modèle, les produits de Stability AI ne sont en fait pas chers.

Nous avons pris un centre de données qui aurait coûté 1 milliard de dollars pour faire fonctionner un processeur et l'avons réduit à 100 millions de dollars. Désormais, si ce centre de données de 100 millions de dollars est placé dans le cloud et partagé par 100 entreprises, ce n'est rien.

Le GPU NVIDIA permet aux start-up de former des modèles à moindre coût. Vous pouvez désormais créer un grand modèle de langage, tel que GPT, pour environ 10 à 20 millions de dollars. C'est vraiment très abordable.

Le rapport 2022 sur l'état de l'intelligence artificielle indique qu'en décembre 2022, plus de 21 000 articles open source sur l'IA utilisaient des puces NVIDIA.

La plupart des chercheurs du State of AI Compute Index utilisent la puce NVIDIA V100 lancée en 2017, mais l'A100 connaîtra une croissance rapide en 2022 et deviendra la troisième puce la plus fréquemment utilisée.

La concurrence la plus féroce de l'A100 pourrait être son successeur, le H100, qui sera lancé en 2022 et a commencé la production en série. En fait, Nvidia a déclaré mercredi que les revenus du H100 dépassaient ceux de l'A100 au cours du trimestre terminé en janvier.

Actuellement, NVIDIA prend le train express de l'IA et sprinte vers « l'argent ».

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Sesame Open Door Exchange Page Web Login Dernière version GATEIO Entrée du site officiel

Mar 04, 2025 pm 11:48 PM

Sesame Open Door Exchange Page Web Login Dernière version GATEIO Entrée du site officiel

Mar 04, 2025 pm 11:48 PM

Une introduction détaillée à l'opération de connexion de la version Web Sesame Open Exchange, y compris les étapes de connexion et le processus de récupération de mot de passe.

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.