Périphériques technologiques

Périphériques technologiques

IA

IA

Comment les chiens voient-ils le monde ? Des chercheurs humains ont entrepris de décoder la cognition visuelle dans le cerveau des chiens

Comment les chiens voient-ils le monde ? Des chercheurs humains ont entrepris de décoder la cognition visuelle dans le cerveau des chiens

Comment les chiens voient-ils le monde ? Des chercheurs humains ont entrepris de décoder la cognition visuelle dans le cerveau des chiens

Les chiens et les humains ont co-évolué au cours des 15 000 dernières années. De nos jours, les chiens vivent souvent dans des environnements humains comme animaux de compagnie. Parfois, les chiens regardent des vidéos à la maison comme le font les gens et semblent comprendre.

Alors, à quoi ressemble le monde aux yeux des chiens ?

Récemment, une étude de l'Université Emory a décodé des images visuelles du cerveau de chiens, révélant pour la première fois comment le cerveau du chien reconstruit ce qu'il voit. La recherche a été publiée dans le Journal of Visual Experiments.

Adresse papier : https://www.jove.com/t/64442/through-dog-s-eyes-fmri-decoding-naturalistic-videos-from-dog

Les chercheurs ont enregistré deux IRMf données neuronales de chiens éveillés et sans retenue alors qu'ils regardaient des vidéos de 30 minutes au cours de trois sessions distinctes pour un total de 90 minutes. Ils ont ensuite utilisé des algorithmes d’apprentissage automatique pour analyser les modèles de données neuronales.

Gregory Berns, professeur de psychologie à l'Université Emory et co-auteur de l'article, a déclaré : "Nous pouvons surveiller l'activité cérébrale du chien pendant qu'il regarde la vidéo et reconstruire dans une certaine mesure ce qu'il regarde. Nous pouvons le faire C'est assez remarquable."

Berns et ses collègues ont été les pionniers de l'utilisation de la technologie de numérisation IRMf chez les chiens et ont entraîné les chiens à rester complètement immobiles et sans retenue tout en mesurant l'activité neuronale. Il y a dix ans, l'équipe a publié la première image cérébrale IRMf d'un chien complètement éveillé et sans retenue, ouvrant ainsi la porte à ce que Berns appelle « le projet chien ».

Berns avec Callie, le premier chien à faire scanner son activité cérébrale alors qu'il est complètement éveillé et sans retenue.

Au fil des ans, le laboratoire de Berns a publié plusieurs études sur la façon dont le cerveau canin traite la vision, le langage, les odeurs et les récompenses (comme recevoir des éloges ou de la nourriture).

Dans le même temps, la technologie de l’apprentissage automatique continue de progresser, permettant aux scientifiques de décoder certains modèles d’activité du cerveau humain. Berns a alors commencé à se demander si une technologie similaire pouvait être appliquée au cerveau des chiens.

Cette nouvelle recherche est basée sur l'apprentissage automatique et la technologie IRMf. L'IRMf est une technique de neuroimagerie qui utilise l'imagerie par résonance magnétique pour mesurer les changements hémodynamiques provoqués par l'activité neuronale. Cette technologie est non invasive et joue un rôle important dans le domaine de la localisation des fonctions cérébrales. Outre les humains, cette technologie n’a été utilisée que chez une poignée d’autres espèces, dont certains primates.

Introduction à la recherche

Deux chiens ont été utilisés dans l'expérience. Cela prouve que l'apprentissage automatique, l'IRMf et d'autres technologies peuvent être généralement utilisés pour l'analyse canine. Les chercheurs espèrent également que cette étude aidera d'autres à approfondir. Apprenez-en davantage sur la façon dont les différents animaux pensent.

Le processus expérimental est à peu près le suivant :

Participants expérimentaux : Bhubo, 4 ans Daisy, 11 ans ; Les deux chiens avaient déjà participé à plusieurs séances de formation IRMf (Bhubo : 8 séances, Daisy : 11 séances), dont certaines impliquaient la visualisation de stimuli visuels projetés sur un écran. Les deux chiens ont été choisis pour leur capacité à rester à l'intérieur du scanner pendant de longues périodes sans se déplacer sans être vus par leurs propriétaires.

Tournage vidéo : filmez des vidéos du point de vue du chien pour capturer des scènes quotidiennes de la vie d'un chien. Ces scénarios incluent la marche, l'alimentation, le jeu, l'interaction avec les humains, les interactions de chien à chien, etc. La vidéo a été montée en 256 scènes uniques, chacune représentant un événement tel qu'un chien faisant un câlin à un humain, un chien qui court ou une promenade. Chaque scène se voit attribuer un numéro et une étiquette uniques en fonction de son contenu. Les scènes ont ensuite été montées en cinq vidéos de compilation plus grandes, chacune d'une durée d'environ 6 minutes.

Conception expérimentale : Les participants ont d'abord été scannés à l'aide d'une IRM 3T tout en regardant une compilation vidéo projetée sur un écran derrière l'orifice de l'IRM. Pour les chiens, grâce à un entraînement préalable, leur tête est placée dans des mentonnières sur mesure pour obtenir une position de tête stable, comme sur l'image ci-dessous

L'expérience a été visionnée en trois fois, chaque visionnage durait 30 minutes. La vidéo a une durée totale de 90 minutes.

Au cours de l'expérience, l'IRMf a été utilisée pour scanner le chien en même temps, puis les données ont été analysées. L'expérience a utilisé l'algorithme d'apprentissage automatique Ivis, qui est une méthode non linéaire basée sur des réseaux de neurones jumeaux (SNN). été utilisé pour analyser le succès de grande dimension dans les données biologiques. De plus, des algorithmes d’apprentissage automatique tels que scikit-learn et RFC ont également été utilisés dans l’expérience.

Daisy étant scannée, ses oreilles ont été scotchées pour maintenir les bouchons d'oreilles en place afin d'éliminer le bruit.

Cette étude a comparé le fonctionnement du cerveau humain et canin. Les résultats de deux sujets humains ont montré qu'un modèle développé à l'aide de réseaux neuronaux mappait les données cérébrales sur des classificateurs basés sur des objets et des actions avec une précision de 99 % ; le même modèle fonctionnait bien lors du décodage des modèles cérébraux de chien. Non applicable aux classificateurs d'objets, lors du décodage du chien. classification des actions, la précision atteint 75% - 88%. Cela illustre des différences significatives dans le fonctionnement du cerveau humain et canin, comme le montrent ci-dessous les résultats expérimentaux pour les humains (A) et les chiens (B). À cet égard, Berns a conclu : "Nous, les humains, sommes très préoccupés par ce que nous voyons, mais les chiens semblent se soucier moins de qui ou de ce qu'ils voient, et plus du comportement d'action." texte original de l'article pour en savoir plus sur les détails de la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Écrit précédemment, nous discutons aujourd'hui de la manière dont la technologie d'apprentissage profond peut améliorer les performances du SLAM (localisation et cartographie simultanées) basé sur la vision dans des environnements complexes. En combinant des méthodes d'extraction de caractéristiques approfondies et de correspondance de profondeur, nous introduisons ici un système SLAM visuel hybride polyvalent conçu pour améliorer l'adaptation dans des scénarios difficiles tels que des conditions de faible luminosité, un éclairage dynamique, des zones faiblement texturées et une gigue importante. Notre système prend en charge plusieurs modes, notamment les configurations étendues monoculaire, stéréo, monoculaire-inertielle et stéréo-inertielle. En outre, il analyse également comment combiner le SLAM visuel avec des méthodes d’apprentissage profond pour inspirer d’autres recherches. Grâce à des expériences approfondies sur des ensembles de données publiques et des données auto-échantillonnées, nous démontrons la supériorité du SL-SLAM en termes de précision de positionnement et de robustesse du suivi.

Qu'est-ce que le NeRF ? La reconstruction 3D basée sur NeRF est-elle basée sur des voxels ?

Oct 16, 2023 am 11:33 AM

Qu'est-ce que le NeRF ? La reconstruction 3D basée sur NeRF est-elle basée sur des voxels ?

Oct 16, 2023 am 11:33 AM

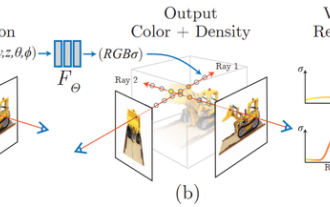

1 Introduction Les champs de rayonnement neuronal (NeRF) constituent un paradigme relativement nouveau dans le domaine de l'apprentissage profond et de la vision par ordinateur. Cette technologie a été introduite dans l'article ECCV2020 « NeRF : Representing Scenes as Neural Radiation Fields for View Synthesis » (qui a remporté le prix du meilleur article) et est depuis devenue extrêmement populaire, avec près de 800 citations à ce jour [1 ]. Cette approche marque un changement radical dans la manière traditionnelle dont l’apprentissage automatique traite les données 3D. Représentation de la scène du champ de rayonnement neuronal et processus de rendu différenciable : compositer des images en échantillonnant des coordonnées 5D (position et direction de visualisation) le long des rayons de la caméra ; introduire ces positions dans un MLP pour produire des densités de couleur et volumétriques et composer ces valeurs à l'aide de techniques de rendu volumétrique ; ; la fonction de rendu est différentiable, elle peut donc être transmise

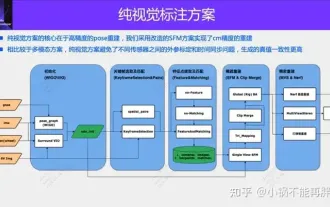

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

Une solution d'annotation purement visuelle utilise principalement la vision ainsi que certaines données du GPS, de l'IMU et des capteurs de vitesse de roue pour l'annotation dynamique. Bien entendu, pour les scénarios de production de masse, il n’est pas nécessaire qu’il s’agisse d’une vision pure. Certains véhicules produits en série seront équipés de capteurs comme le radar à semi-conducteurs (AT128). Si nous créons une boucle fermée de données dans la perspective d'une production de masse et utilisons tous ces capteurs, nous pouvons résoudre efficacement le problème de l'étiquetage des objets dynamiques. Mais notre plan ne prévoit pas de radar à semi-conducteurs. Par conséquent, nous présenterons cette solution d’étiquetage de production de masse la plus courante. Le cœur d’une solution d’annotation purement visuelle réside dans la reconstruction de pose de haute précision. Nous utilisons le schéma de reconstruction de pose de Structure from Motion (SFM) pour garantir la précision de la reconstruction. Mais passe

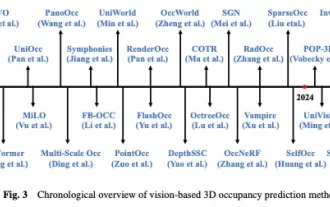

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

Écrit ci-dessus et compréhension personnelle de l'auteur Ces dernières années, la conduite autonome a reçu une attention croissante en raison de son potentiel à réduire la charge du conducteur et à améliorer la sécurité de conduite. La prédiction d'occupation tridimensionnelle basée sur la vision est une tâche de perception émergente adaptée à une enquête rentable et complète sur la sécurité de la conduite autonome. Bien que de nombreuses études aient démontré la supériorité des outils de prédiction d’occupation 3D par rapport aux tâches de perception centrée sur les objets, il existe encore des revues dédiées à ce domaine en développement rapide. Cet article présente d'abord le contexte de la prédiction d'occupation 3D basée sur la vision et discute des défis rencontrés dans cette tâche. Ensuite, nous discutons de manière approfondie de l'état actuel et des tendances de développement des méthodes actuelles de prévision d'occupation 3D sous trois aspects : l'amélioration des fonctionnalités, la convivialité du déploiement et l'efficacité de l'étiquetage. enfin

Encodage et décodage Base64 à l'aide de Python

Sep 02, 2023 pm 01:49 PM

Encodage et décodage Base64 à l'aide de Python

Sep 02, 2023 pm 01:49 PM

Disons que vous disposez d'un fichier image binaire que vous souhaitez transférer sur le réseau. Vous êtes surpris que l'autre partie n'ait pas reçu le fichier correctement : il contient juste des caractères étranges ! Eh bien, il semble que vous essayez d'envoyer le fichier au format bits et octets bruts, alors que le support que vous utilisez est conçu pour diffuser du texte. Quelles sont les solutions pour éviter de tels problèmes ? La réponse est le codage Base64. Dans cet article, je vais vous montrer comment encoder et décoder des images binaires à l'aide de Python. Le programme est expliqué comme un programme local autonome, mais vous pouvez appliquer le concept à différentes applications, telles que l'envoi d'images codées depuis un appareil mobile vers un serveur et de nombreuses autres applications. Qu’est-ce que Base64 ? Avant de plonger dans cet article, définissons Base6

Le repérage des nuages de points est incontournable pour la vision 3D ! Comprendre toutes les solutions et défis courants dans un seul article

Apr 02, 2024 am 11:31 AM

Le repérage des nuages de points est incontournable pour la vision 3D ! Comprendre toutes les solutions et défis courants dans un seul article

Apr 02, 2024 am 11:31 AM

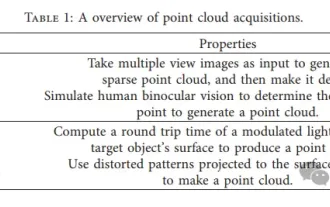

Le nuage de points, en tant qu'ensemble de points, devrait entraîner un changement dans l'acquisition et la génération d'informations de surface tridimensionnelles (3D) sur des objets grâce à la reconstruction 3D, à l'inspection industrielle et au fonctionnement de robots. Le processus le plus difficile mais essentiel est l'enregistrement des nuages de points, c'est-à-dire l'obtention d'une transformation spatiale qui aligne et fait correspondre deux nuages de points obtenus dans deux coordonnées différentes. Cette revue présente un aperçu et les principes de base de l'enregistrement des nuages de points, classe et compare systématiquement diverses méthodes et résout les problèmes techniques existant dans l'enregistrement des nuages de points, en essayant de fournir aux chercheurs universitaires en dehors du domaine et aux ingénieurs des conseils et faciliter les discussions sur une vision unifiée. pour l'enregistrement des nuages de points. La méthode générale d'acquisition de nuages de points est divisée en méthodes actives et passives. Le nuage de points acquis activement par le capteur est la méthode active, et le nuage de points est reconstruit ultérieurement.

Comment implémenter l'encodage et le décodage des caractères chinois dans la programmation en langage C ?

Feb 19, 2024 pm 02:15 PM

Comment implémenter l'encodage et le décodage des caractères chinois dans la programmation en langage C ?

Feb 19, 2024 pm 02:15 PM

Dans la programmation informatique moderne, le langage C est l’un des langages de programmation les plus couramment utilisés. Bien que le langage C lui-même ne prenne pas directement en charge l'encodage et le décodage chinois, nous pouvons utiliser certaines technologies et bibliothèques pour réaliser cette fonction. Cet article présentera comment implémenter l'encodage et le décodage chinois dans un logiciel de programmation en langage C. Premièrement, pour mettre en œuvre l’encodage et le décodage chinois, nous devons comprendre les concepts de base de l’encodage chinois. Actuellement, le système de codage chinois le plus couramment utilisé est le codage Unicode. Le codage Unicode attribue une valeur numérique unique à chaque caractère afin que lors du calcul

Vous pouvez jouer simplement en bougeant votre bouche ! Utilisez l'IA pour changer de personnage et attaquer les ennemis : 'Ayaka, utilisez Kamiri-ryu Frost Destruction'

May 13, 2023 pm 07:52 PM

Vous pouvez jouer simplement en bougeant votre bouche ! Utilisez l'IA pour changer de personnage et attaquer les ennemis : 'Ayaka, utilisez Kamiri-ryu Frost Destruction'

May 13, 2023 pm 07:52 PM

En ce qui concerne les jeux nationaux devenus populaires dans le monde entier au cours des deux dernières années, Genshin Impact remporte définitivement la palme. Selon le rapport d'enquête sur les revenus des jeux mobiles du premier trimestre de cette année publié en mai, "Genshin Impact" a fermement remporté la première place parmi les jeux mobiles de tirage de cartes avec un avantage absolu de 567 millions de dollars américains. Cela a également annoncé que "Genshin Impact" a été. en ligne en seulement 18 ans. Quelques mois plus tard, les revenus totaux de la seule plateforme mobile dépassaient les 3 milliards de dollars américains (environ 13 milliards de RM). Désormais, la dernière version 2.8 de l'île avant l'ouverture de Xumi est attendue depuis longtemps. Après une longue période de draft, il y a enfin de nouvelles intrigues et zones à jouer. Mais je ne sais pas combien il y a d’« Empereurs du Foie ». Maintenant que l’île a été entièrement explorée, l’herbe a recommencé à pousser. Il y a un total de 182 coffres au trésor + 1 boîte Mora (non incluse). Il n'y a pas lieu de s'inquiéter de la période des herbes longues. La zone Genshin Impact ne manque jamais de travail. Non, pendant les hautes herbes