Périphériques technologiques

Périphériques technologiques

IA

IA

Le modèle unifié AIGC est là ! L'équipe fondée par Huang Xutao, un leader de l'industrie du CV, a proposé « Tout-Puissant Diffusion »

Le modèle unifié AIGC est là ! L'équipe fondée par Huang Xutao, un leader de l'industrie du CV, a proposé « Tout-Puissant Diffusion »

Le modèle unifié AIGC est là ! L'équipe fondée par Huang Xutao, un leader de l'industrie du CV, a proposé « Tout-Puissant Diffusion »

Les progrès récents dans les modèles de diffusion posent un jalon impressionnant dans de nombreuses tâches génératives. Des travaux attrayants tels que DALL·E 2, Imagen et Stable Diffusion (SD) ont suscité un grand intérêt dans le monde universitaire et industriel.

Cependant, bien que ces modèles fonctionnent de manière étonnante, ils se concentrent essentiellement sur un certain type de tâche, comme la génération d'images à partir d'un texte donné. Pour différents types de tâches, ils doivent souvent être formés séparément ou reconstruits.

Alors peut-on construire une Diffusion « globale » basée sur les modèles précédents pour parvenir à l'unification du modèle AIGC ? Certaines personnes tentent d’explorer dans cette direction et ont fait des progrès.

Cette équipe conjointe de l'Université de l'Illinois à Urbana-Champaign et de l'Université du Texas à Austin tente d'étendre la diffusion à flux unique existante en un réseau multi-flux, appelé Versatile Diffusion (VD), qui est le premier Le cadre de diffusion multimodal et multi-flux unifié est une étape vers l'intelligence artificielle générative générale.

Adresse papier : https://arxiv.org/abs/2211.08332

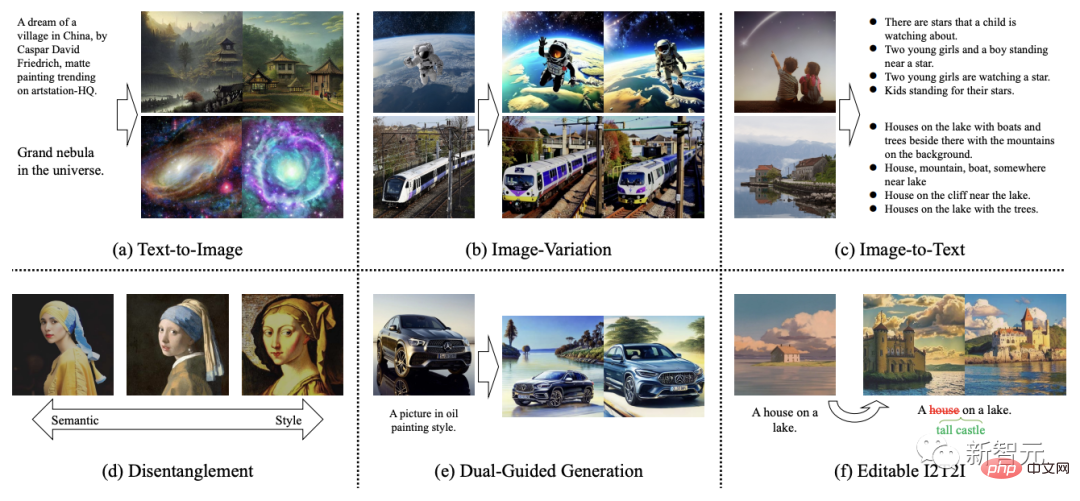

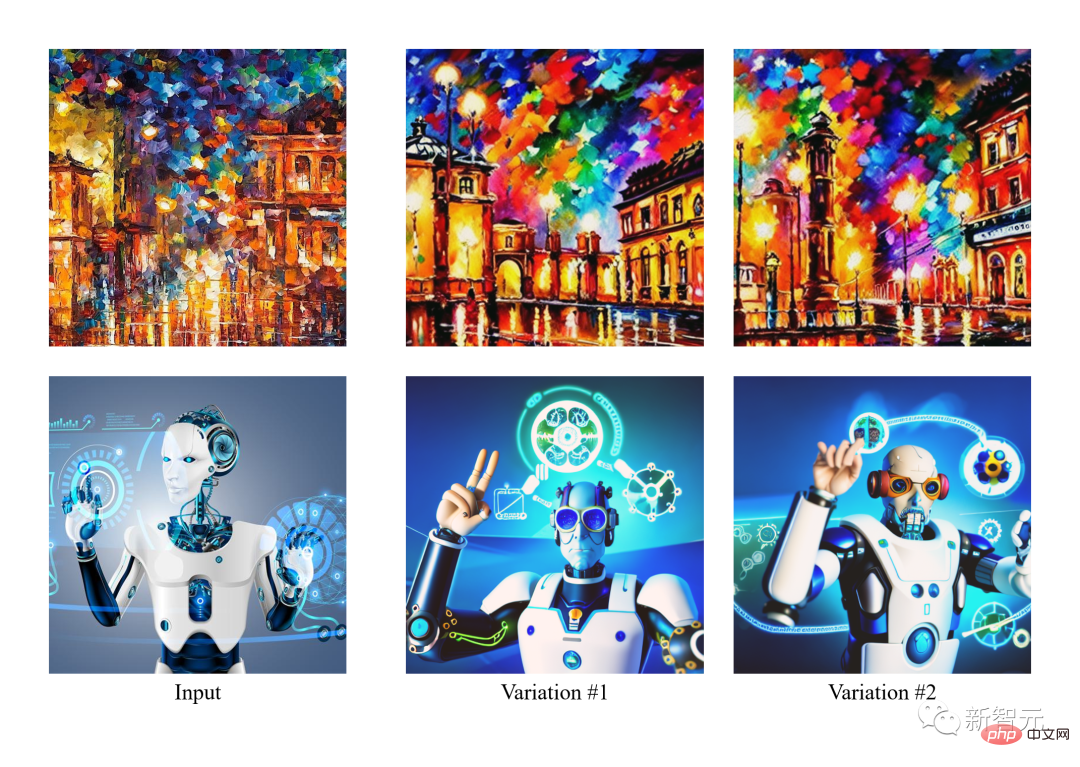

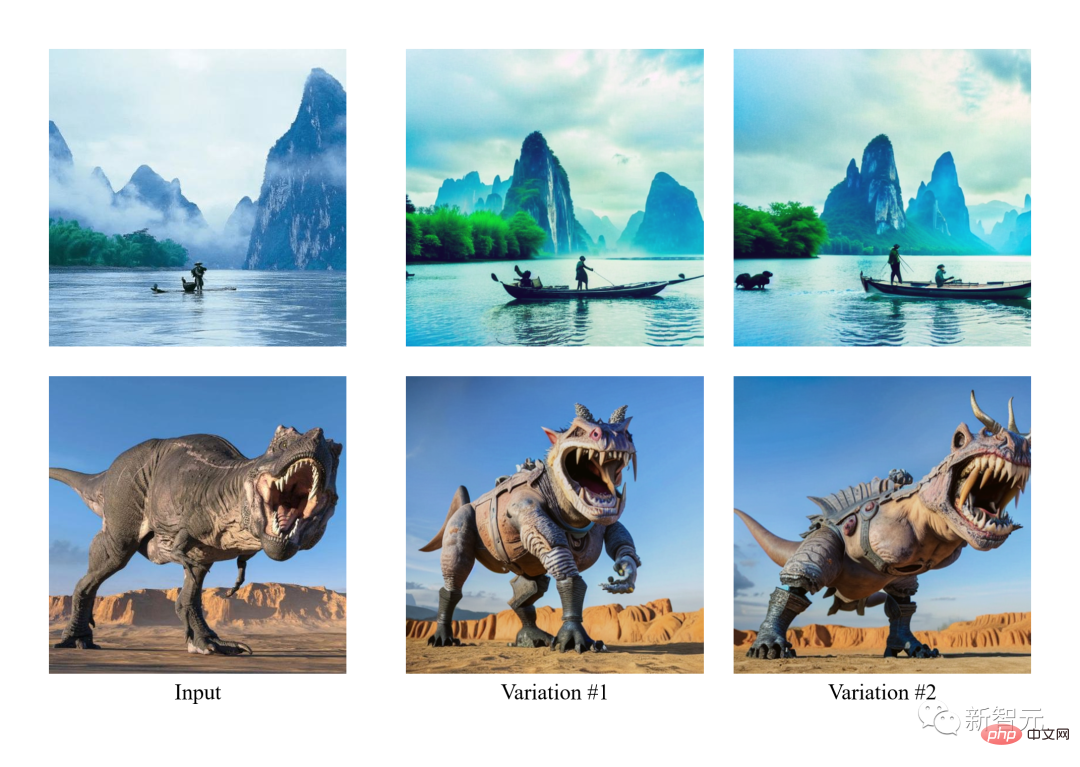

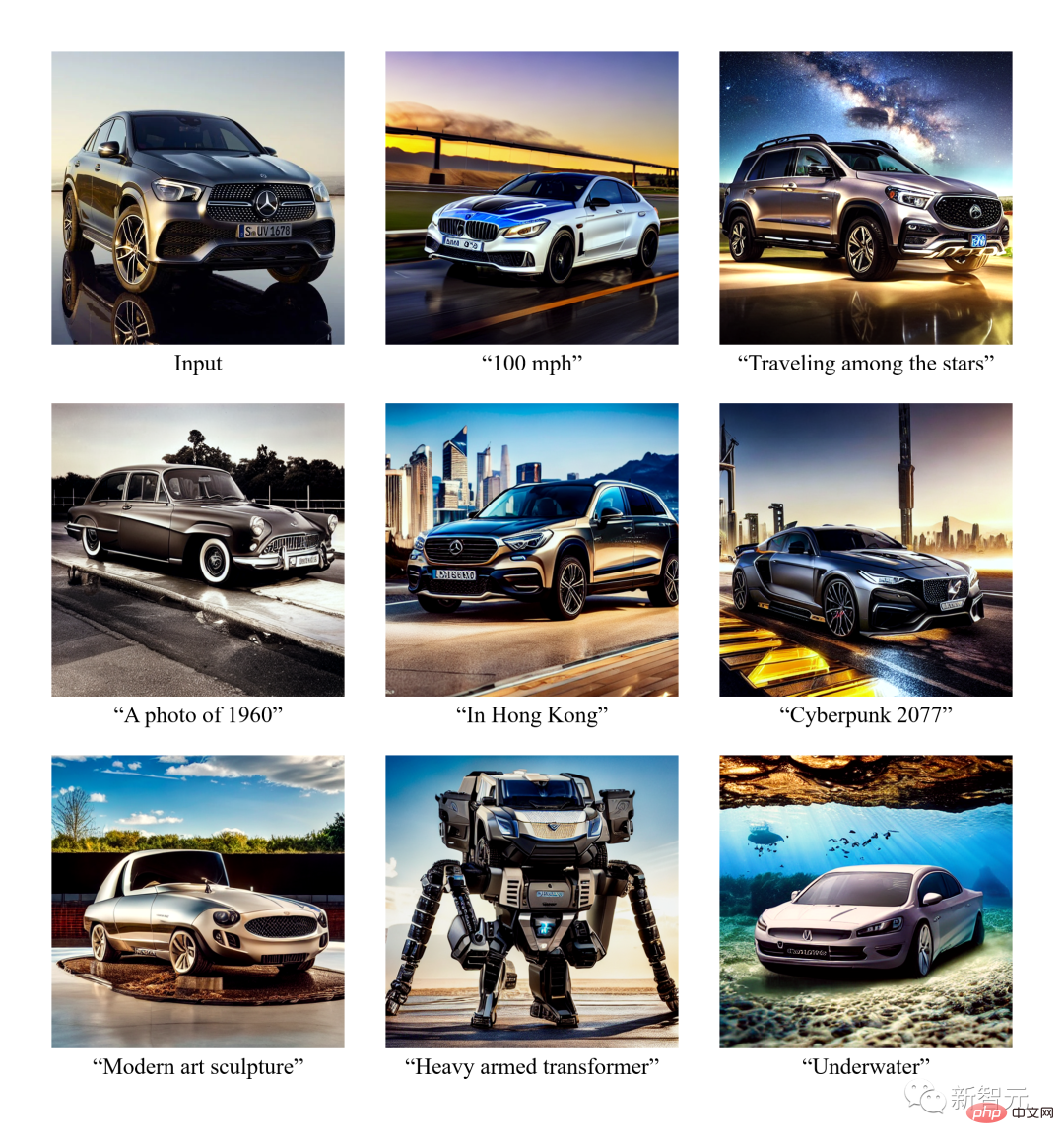

En plus de la fonction d'image de génération de texte ordinaire, Versatile Diffusion peut également saisir des images pour générer des images similaires. . Saisissez des images pour générer du texte, saisissez du texte pour générer un texte similaire, modifiez le découplage sémantique des images, saisissez des images et du texte pour générer une vidéo, modifiez le contenu de l'image en fonction de l'espace latent, etc.

Les futures versions prendront également en charge davantage de modes tels que la voix, la musique, la vidéo et la 3D.

Selon l'article, il a été prouvé que VD et son cadre sous-jacent présentent les avantages suivants :

a) Peut gérer toutes les sous-tâches avec une qualité compétitive.

b) Prise en charge de nouvelles extensions et applications, telles que la séparation du style graphique et de la sémantique, la génération de double guidage image-texte, etc.

c) Ces expériences et applications fournissent des informations sémantiques plus riches sur le résultat généré.

En termes d'ensemble de données d'entraînement, VD utilise Laion2B-en avec des filtres de données personnalisés comme ensemble de données principal.

Une découverte passionnante issue de la première exploration de

VD est qu'il peut améliorer ou réduire sémantiquement le style de l'image sans autre supervision.

Un tel phénomène a inspiré l'auteur à explorer un domaine complètement nouveau, où la séparation entre style et sémantique peut se produire pour des images aux styles et au contenu arbitraires.

Les auteurs ont déclaré qu'ils sont la première équipe à explorer : a) l'interprétation sémantique et stylistique d'images naturelles sans spécification de domaine ; b) la décomposition sémantique et stylistique sur l'espace latent des modèles de diffusion.

Dans l'image ci-dessous, l'auteur génère d'abord des variantes de l'image d'entrée puis les opère avec une focalisation sémantique (à gauche) ou stylistique (à droite).

Étant donné que VD prend en charge à la fois l'image en texte et le texte en image, l'équipe d'auteurs a essayé pour la première fois d'éditer des images du point de vue des invites de texte en suivant les étapes : a) Convertir l'image en texte, b) Modifier le texte, c) Reconvertir le texte en image.

Dans l'expérience, l'auteur a supprimé le contenu décrit de l'image, puis a ajouté un nouveau contenu en utilisant ce paradigme image-texte-image (I2T2I). Contrairement à la peinture ou à d'autres méthodes d'édition d'images qui nécessitent l'emplacement des objets en entrée, l'I2T2I de VD ne nécessite pas de masques car il peut automatiquement positionner et remplacer les objets comme indiqué.

Cependant, l'image de sortie d'I2T2I est incohérente avec les pixels de l'image d'entrée, ce qui est dû au raffinement sémantique image-texte et à la création de contenu texte-image.

Dans l'affichage ci-dessous, l'image d'entrée est d'abord traduite en une invite, puis l'invite est modifiée par soustraction (case rouge) et addition (case verte). Enfin, l'invite modifiée est traduite en image.

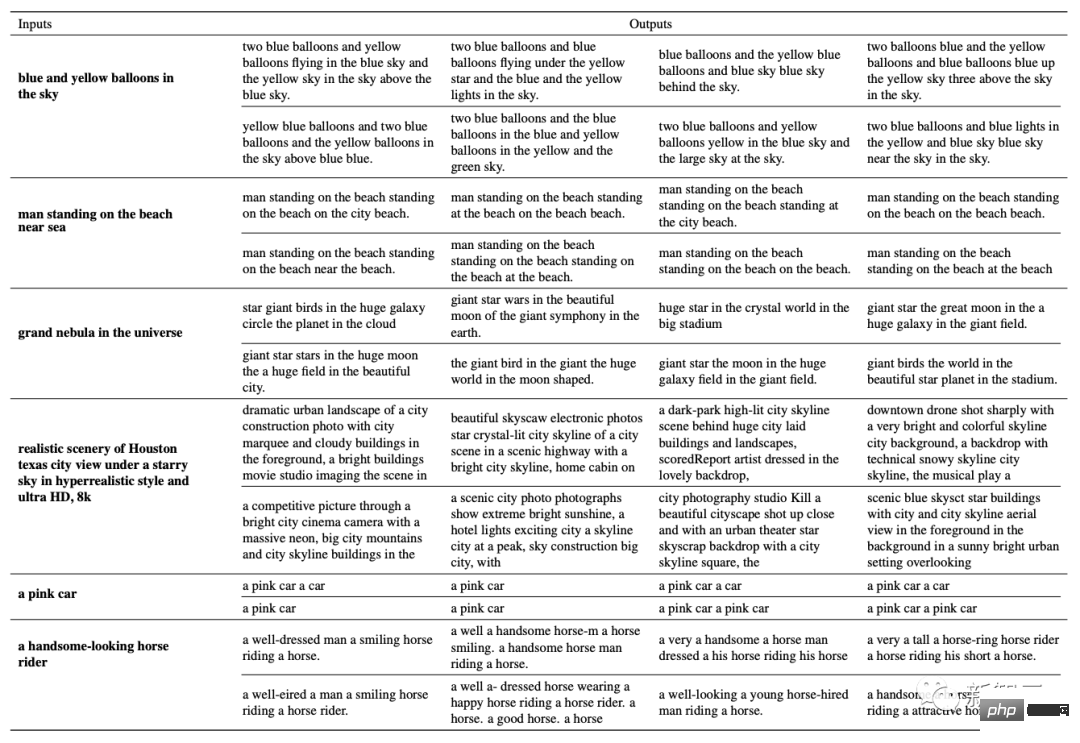

De plus, ils sont également la première équipe à explorer la génération d'un texte similaire basé sur un texte donné.

Network Framework

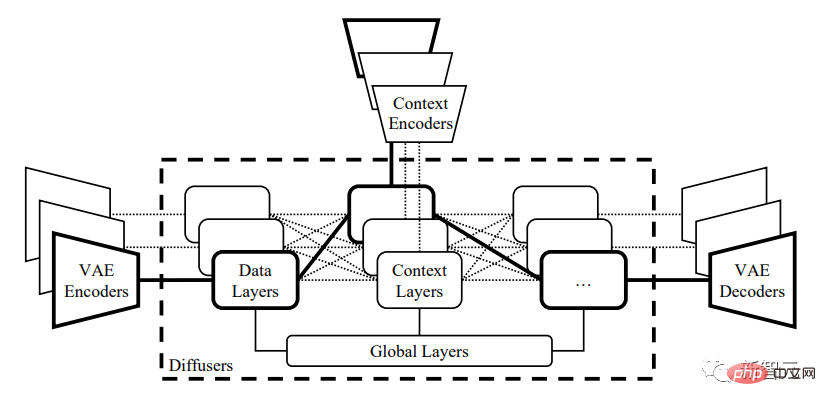

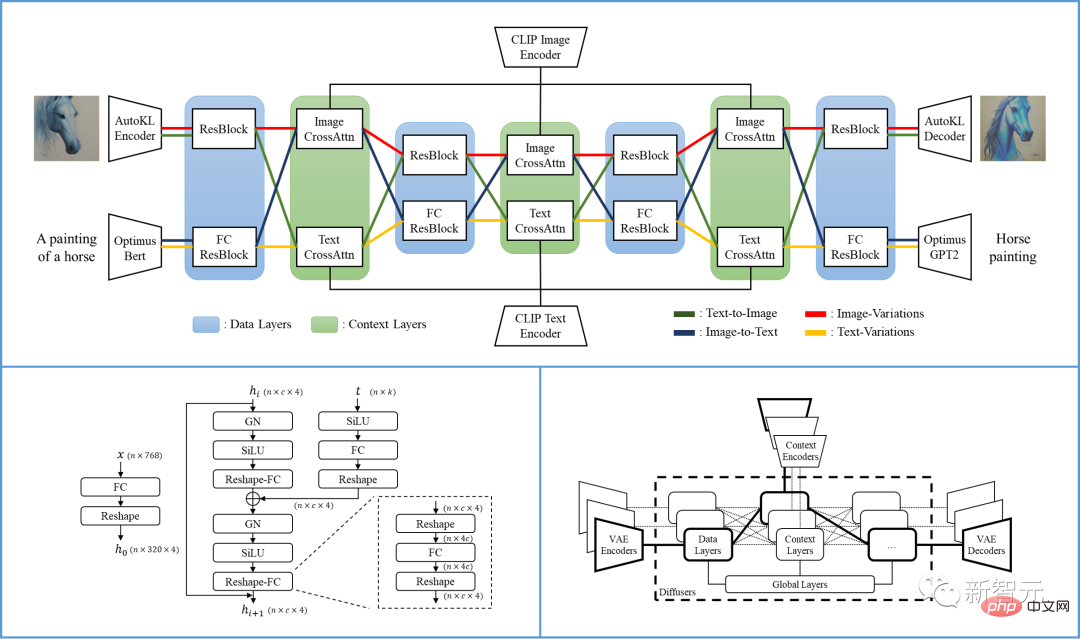

Plus précisément, le framework VD proposé dans l'article est un réseau multi-flux avec différents types de données en entrée et en arrière-plan.

Le cadre de diffusion multi-modal multi-flux VD hérite des avantages du LDM/SD, avec un espace latent interprétable, une structure modale et un faible coût de calcul.

VD peut former conjointement plusieurs flux, chaque flux représentant une tâche intermodale. Sa conception principale est de diffuser les protocoles de regroupement, de partage et de commutation au sein du réseau, en adaptant le cadre à toutes les tâches prises en charge et au-delà.

diffuser est divisé en trois groupes : couche globale, couche de données et couche de contexte. La couche globale est la couche d'intégration temporelle, la couche de données est le bloc résiduel et la couche contextuelle est l'attention croisée.

Ce regroupement correspond à la fonctionnalité du calque. Lorsque vous travaillez sur plusieurs tâches, la couche globale est partagée entre toutes les tâches. La couche de données et la couche de contexte contiennent plusieurs flux de données. Chaque flux de données peut être partagé ou échangé en fonction des données actuelles et du type de contexte.

Par exemple, lors du traitement des requêtes texte-image, le diffuseur utilise la couche de données d'image et la couche de contexte de texte. Lorsqu'il s'agit de tâches de mutation d'image, la couche de données d'image et la couche de contexte d'image sont utilisées.

Un seul processus VD contient un VAE, un diffuseur et un encodeur de contexte, traitant une tâche (comme du texte en image) sous un type de données (comme une image) et un type de contexte (comme du texte).

La structure multi-flux de Versatile Diffusion est présentée dans la figure ci-dessous :

Basé sur Versatile Diffusion, les chercheurs ont en outre proposé un cadre multi-modal général multi-flux, qui inclut la VAE, le contexte encodeur et un diffuseur à trois couches (c'est-à-dire couche globale, données et contexte).

Diffuseur :

VD utilise UNet à focalisation croisée largement adopté comme architecture principale du réseau de diffusion, divisant les couches en couche globale, couche de données et couche de contexte. La couche de données et la couche de contexte disposent de deux flux de données pour prendre en charge les images et le texte.

Pour le flux de données d'image, suivez LDM et utilisez le bloc résiduel (ResBlock), dont la dimension spatiale diminue progressivement et le nombre de canaux augmente progressivement.

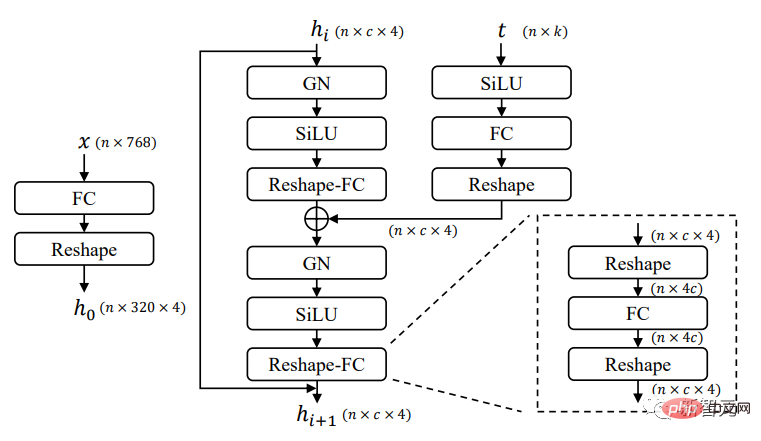

Pour le flux de données textuelles, utilisez le nouveau bloc résiduel entièrement connecté (FCResBlock) pour étendre le vecteur latent de texte de 768 dimensions en 320*4 fonctionnalités cachées, et suivez un paradigme d'augmentation de canal similaire, puis utilisez GroupNorms, SiLU et ignorez les connexions, tout comme ResBlock normal.

Comme le montre la figure ci-dessus, FCResBlock contient deux ensembles de couches entièrement connectées (FC), de normalisation de groupe (GN) et d'unité linéaire sigmoïde (SiLU). x est le code latent du texte d'entrée, t est l'intégration temporelle d'entrée et hi est la fonctionnalité intermédiaire.

Pour les groupes contextuels, les couches d'attention croisée sont utilisées à la fois pour les flux d'images et de contexte, où l'intégration de contenu exploite les fonctionnalités de données via des couches de projection, des produits scalaires et des sigmoïdes.

Variational Autoencoder (VAE) :

VD utilise l'auto-encodeur précédent du modèle de diffusion latente (Latent Diffusion Model, LDM) -KL comme données d'image VAE et Optimus comme texte DataVAE. Optimus se compose de l'encodeur de texte BERT et du décodeur de texte GPT2, qui peuvent convertir de manière bidirectionnelle des phrases en vecteurs latents normalement distribués à 768 dimensions.

Dans le même temps, Optimus présente également des propriétés VAE satisfaisantes avec son espace latent de texte reconfigurable et interprétable. Optimus a donc été choisi comme texte VAE car il répond bien aux prérequis d'un cadre multi-flux multi-modal.

Encodeur de contexte :

VD utilise l'encodeur de texte et d'image CLIP comme encodeur de contexte. Contrairement à LDM et SD qui utilisent uniquement des intégrations de texte brut comme entrée de contexte, VD utilise des intégrations normalisées et projetées pour minimiser la perte de contraste CLIP du texte et des images.

Les expériences montrent qu'un espace d'intégration plus étroit entre les types de contexte aide le modèle à converger rapidement et à mieux fonctionner. Des conclusions similaires peuvent également être obtenues dans DALL·E 2, qui affine le modèle texte-image avec une couche de projection supplémentaire pour minimiser la différence entre les intégrations de texte et d'image pour les variations d'image.

Performance

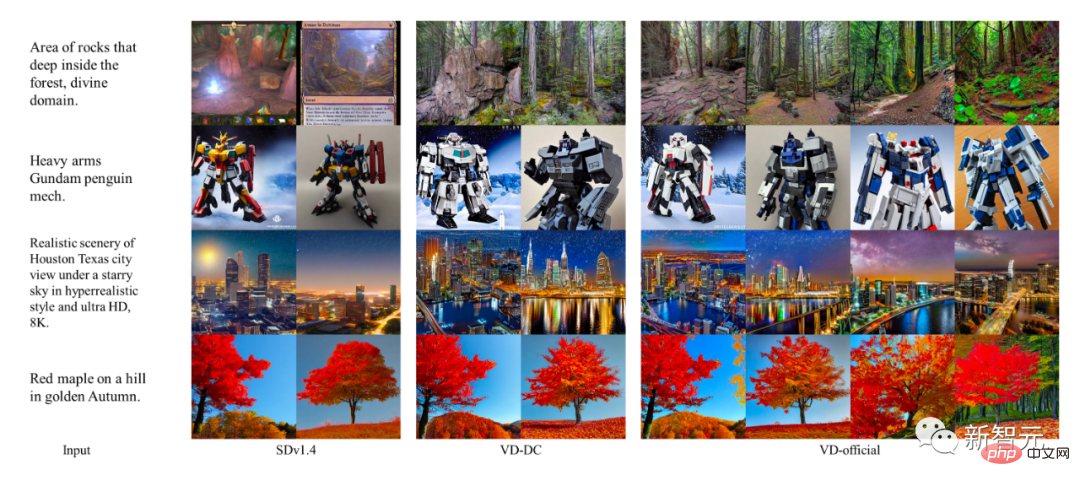

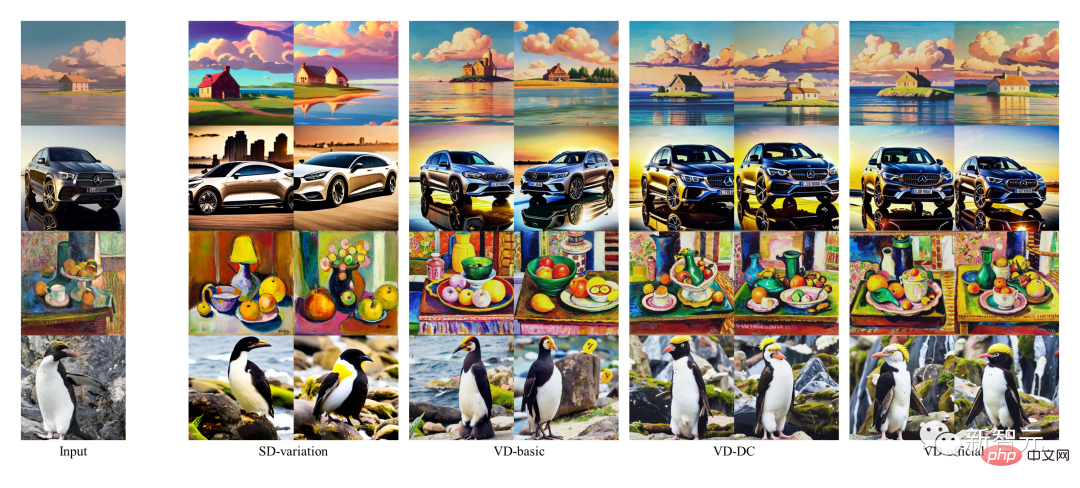

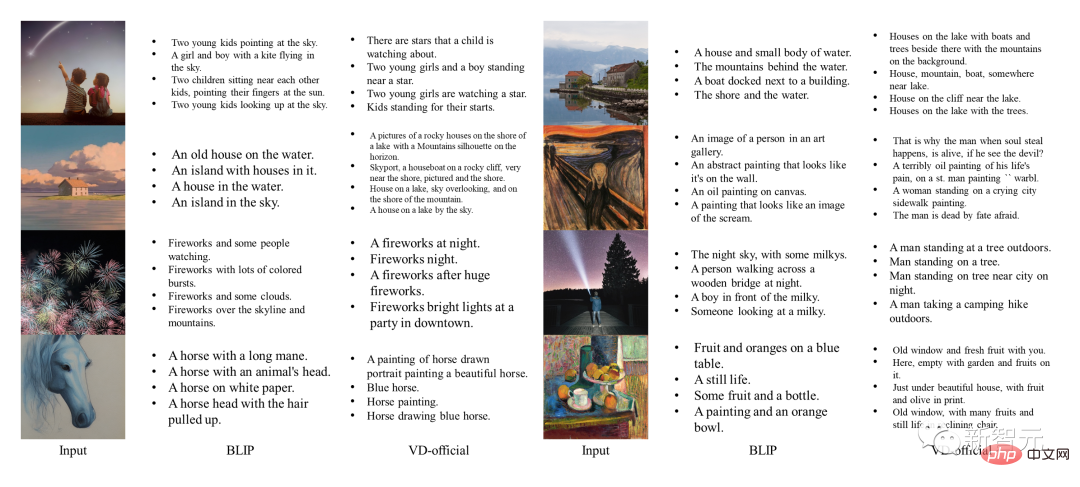

Les auteurs ont utilisé les premiers modèles à tâche unique comme modèles de référence et ont comparé les résultats de VD avec ces références. Parmi eux, SDv1.4 est utilisé comme modèle de base du texte à l'image, la variation SD est utilisée pour la variation d'image et BLIP est utilisé pour le texte d'image.

Parallèlement, les auteurs ont également mené une comparaison qualitative de différents modèles VD, où VDDC et VD-official ont été utilisés pour la conversion texte-image, et les trois modèles ont été utilisés pour les variantes d'image.

Les échantillons d'images SD et VD sont générés avec des graines aléatoires contrôlées pour un meilleur contrôle de qualité.

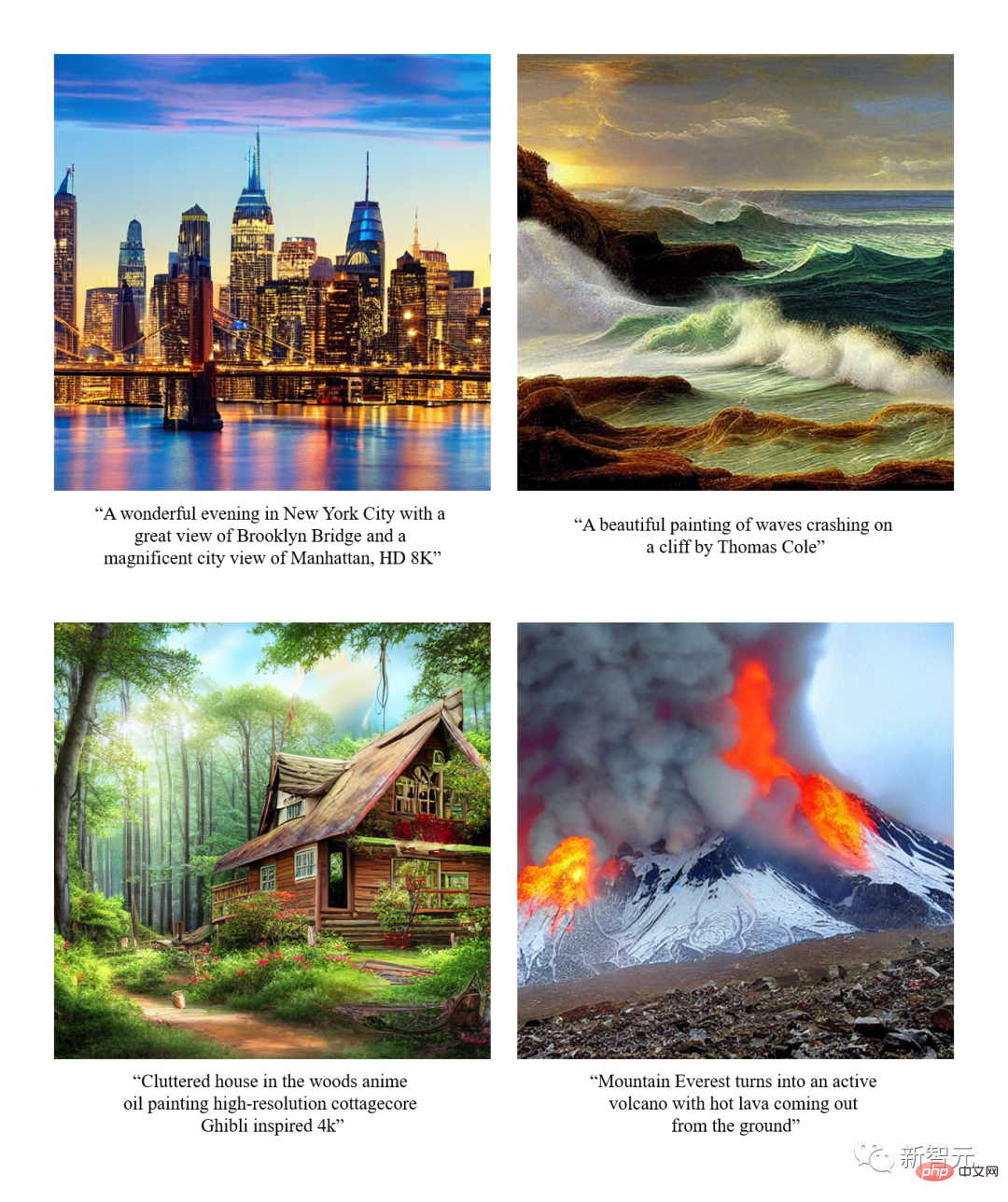

Performance texte-image

Bien que DALLE 2 et Imagen aient également atteint des performances de pointe sur ces tâches, les auteurs ont omis de les tester car il n'y a pas de code public ou détails de la formation. Comparez.

Les résultats montrent que la structure multi-processus et la formation multi-tâches peuvent aider VD à capturer la sémantique contextuelle, à générer des résultats avec plus de précision et à accomplir toutes les sous-tâches de manière excellente.

Performance de la variante d'image

De plus, l'annotation d'image générée par VD contient également des mots créatifs. En comparaison, la génération de BLIP est très courte et manque de description détaillée.

Performance image en texte

Affichage des effets

Vincent Picture

"Variantes d'images"Résumé

L'auteur présente Versatile Diffusion (VD), un réseau de diffusion multimodal multi-flux qui aborde le texte, les images et les variations dans un modèle unifié. Basé sur VD, l'auteur présente en outre un cadre multimodal général multi-flux, qui peut impliquer de nouvelles tâches et domaines. Grâce à des expériences, les auteurs ont découvert que VD peut produire une sortie de haute qualité sur toutes les tâches prises en charge, parmi lesquelles les résultats de la conversion texte-image et image-variante de VD peuvent mieux capturer la sémantique dans le contexte, et l'image-variante de VD. to-text Les résultats sont créatifs et illustratifs. Compte tenu des propriétés multi-flux et multimodales de VD, les auteurs présentent de nouvelles extensions et applications qui pourraient bénéficier davantage aux utilisateurs en aval travaillant sur cette technologie.

Présentation de l'équipe

Présentation de l'équipe

L'équipe IFP de l'Université de l'Illinois à Urbana-Champaign a été fondée par le professeur Huang Xutao dans les années 1980, à l'origine comme groupe de formation et de traitement d'images du Beckman Institute for Advanced Science and Technology.

L'orientation de recherche actuelle de l'IFP est de résoudre le problème du traitement multimodal de l'information en combinant de manière collaborative big data, deep learning et calcul haute performance.

Par ailleurs, l'IFP a remporté plusieurs meilleurs articles lors de grandes conférences dans le domaine de l'intelligence artificielle et a remporté de nombreux concours internationaux, dont le premier NIST TrecVID, le premier ImageNet Challenge et le premier Artificial Intelligence City Challenge.- Fait intéressant, depuis que le professeur Huang a commencé à enseigner au MIT dans les années 1960, les « membres » du groupe IFP comprennent même des amis, des étudiants, des étudiants d'étudiants, des étudiants d'étudiants et même des étudiants d'étudiants d'étudiants.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe