Périphériques technologiques

Périphériques technologiques

IA

IA

Le roi du GPT-4 est couronné ! Votre capacité à lire des images et à répondre aux questions est incroyable. Vous pouvez entrer à Stanford par vous-même.

Le roi du GPT-4 est couronné ! Votre capacité à lire des images et à répondre aux questions est incroyable. Vous pouvez entrer à Stanford par vous-même.

Le roi du GPT-4 est couronné ! Votre capacité à lire des images et à répondre aux questions est incroyable. Vous pouvez entrer à Stanford par vous-même.

Effectivement, le seul qui peut battre l’OpenAI d’hier est l’OpenAI d’aujourd’hui.

Tout à l'heure, OpenAI a publié de manière choquante le modèle multimodal à grande échelle GPT-4, qui prend en charge la saisie d'images et de texte et génère des résultats de texte.

Connu comme le système d'IA le plus avancé de l'histoire !

GPT-4 a non seulement les yeux nécessaires pour comprendre les images, mais a également obtenu des scores presque parfaits aux examens majeurs, dont le GRE, balayant divers critères de référence, et ses indicateurs de performance sont écrasants.

OpenAI a passé 6 mois à ajuster de manière itérative GPT-4 à l'aide de procédures de tests contradictoires et des leçons tirées de ChatGPT, ce qui a abouti aux meilleurs résultats jamais obtenus en termes de réalisme, de contrôlabilité et bien plus encore.

Tout le monde se souvient encore que Microsoft et Google se sont battus férocement pendant trois jours début février lorsque Microsoft a publié ChatGPT et Bing le 8 février, il a déclaré que Bing était "basé sur une technologie de type ChatGPT".

Aujourd'hui, le mystère est enfin résolu : le grand modèle derrière tout cela est GPT-4 !

Geoffrey Hinton, l'un des trois géants du Turing Award, s'est émerveillé : "Une fois que la chenille a absorbé les nutriments, elle se transforme en cocon et devient un papillon. Et les humains ont extrait des milliards de pépite d'or de la compréhension, GPT-4 est le papillon humain."

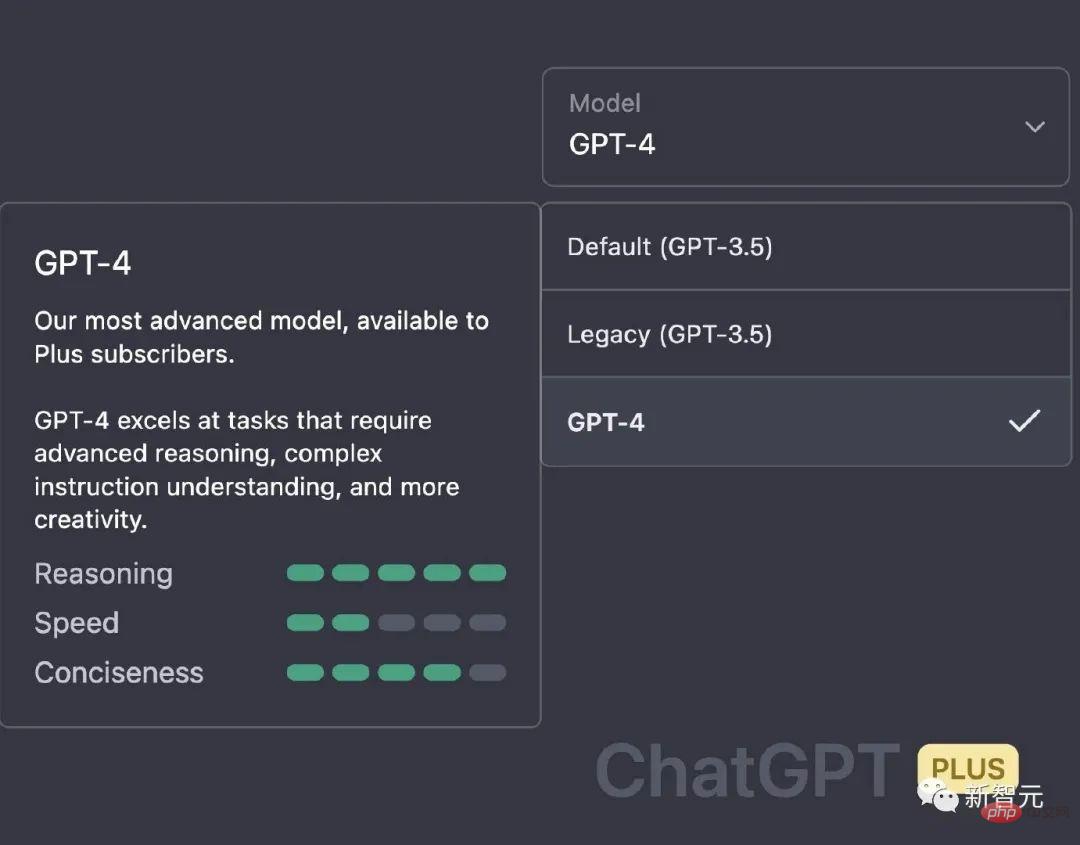

À propos, les utilisateurs de ChatGPT Plus peuvent commencer dès maintenant.

Score presque parfait à l'examen, le saut de performance est exorbitant

Dans une conversation informelle, la différence entre GPT-3.5 et GPT-4 est très subtile. Ce n’est que lorsque la complexité de la tâche atteint un seuil suffisant que la différence apparaît, GPT-4 étant plus fiable, plus créatif et capable de gérer des instructions plus nuancées que GPT-3.5.

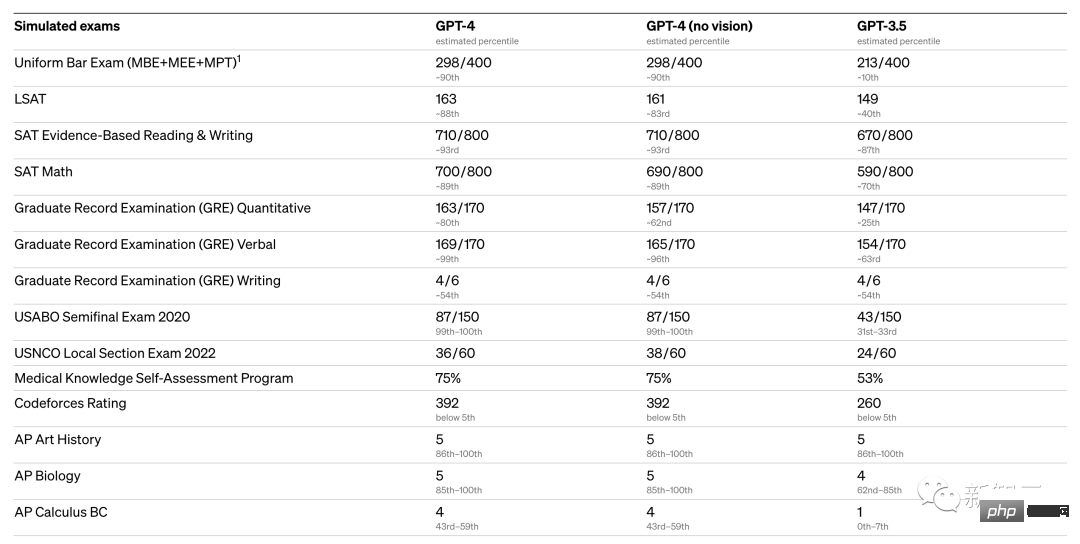

Pour comprendre les différences entre les deux modèles, OpenAI a été testé sur divers benchmarks et certains examens blancs conçus pour les humains.

GPT-4 Parmi les différents examens, il existe plusieurs tests qui sont presque proches des scores parfaits :

- USABO Demi-finale 2020 (USA Biology Olympiad)

- GRE Writing

Avec États-Unis Par exemple, lors de l'examen unifié de licence d'avocat du Barreau, GPT3.5 peut atteindre le niveau de 10 % et GPT4 peut atteindre le niveau de 90 %. L'Olympiade de biologie est passée directement du niveau de 31 % du GPT3.5 au niveau de 99 %.

De plus, OpenAI a évalué GPT-4 sur des benchmarks traditionnels conçus pour les modèles d'apprentissage automatique. À en juger par les résultats expérimentaux, GPT-4 est bien meilleur que les modèles linguistiques à grande échelle existants et la plupart des modèles SOTA :

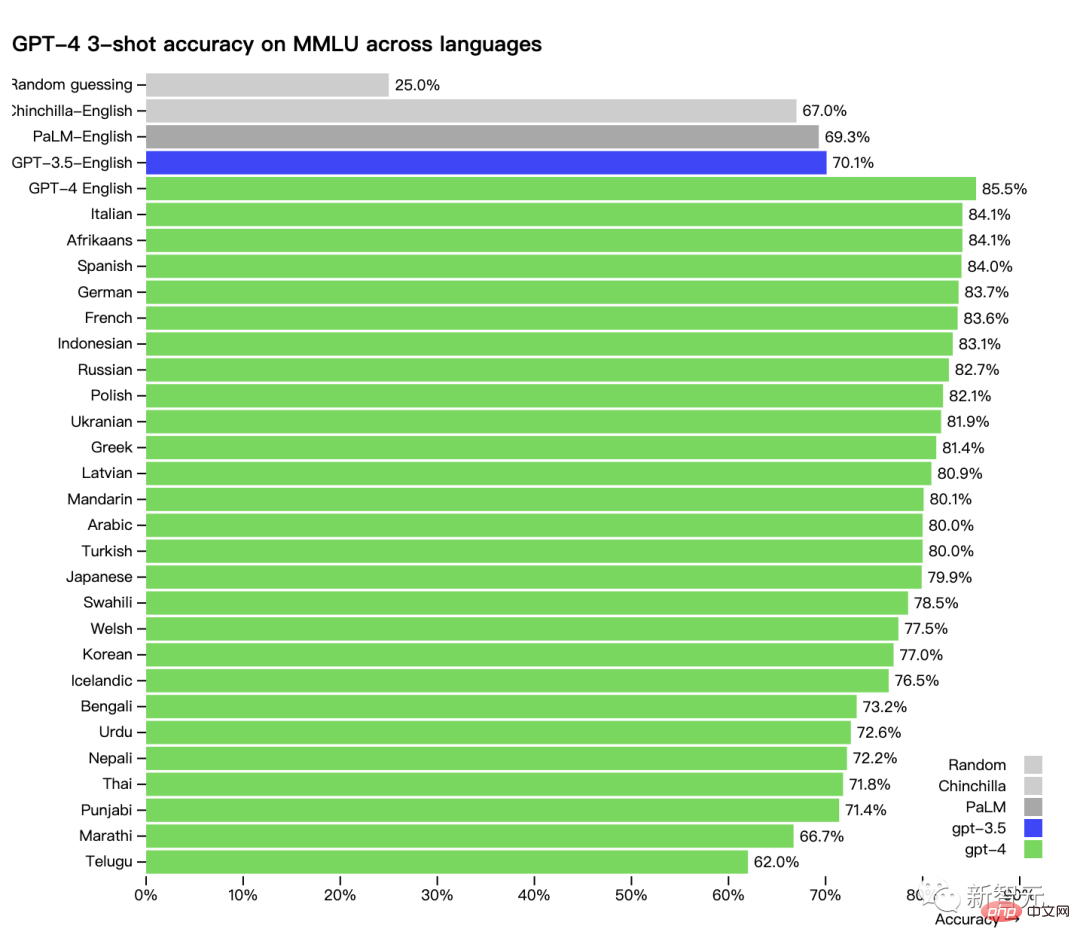

De plus, les performances de GPT-4 dans différentes langues : la précision du chinois est d'environ 80 %, il est déjà meilleure que les performances anglaises de GPT-3.5.

De nombreux benchmarks ML existants sont rédigés en anglais. Pour avoir un premier aperçu des capacités de GPT-4 dans d'autres langues, les chercheurs ont utilisé Azure Translate pour traduire le benchmark MMLU (un ensemble de 14 000 questions à choix multiples couvrant 57 sujets) en plusieurs langues.

Dans 24 des 26 langues testées, GPT-4 surpasse GPT-3.5 et d'autres grands modèles linguistiques (Chinchilla, PaLM) Performances en anglais :

OpenAI a déclaré qu'il utilise GPT-4 en interne, il prête donc également attention à l'effet d'application de grands modèles de langage dans la génération de contenu, les ventes et la programmation. De plus, les initiés l’utilisent pour aider les humains à évaluer les résultats de l’IA.

À cet égard, Jim Fan, disciple de Li Feifei et scientifique NVIDIA AI, a commenté : « La chose la plus forte du GPT-4 est en fait sa capacité de raisonnement. Ses scores aux examens GRE, SAT et de la faculté de droit sont presque impossible à distinguer des candidats humains. " En d'autres termes, GPT-4 peut entrer à Stanford tout seul. " , nous, les humains, ne serons plus nécessaires. Désormais...

Lisez des images et faites de petites affaires, et connaissez même les mèmes mieux que les internautes

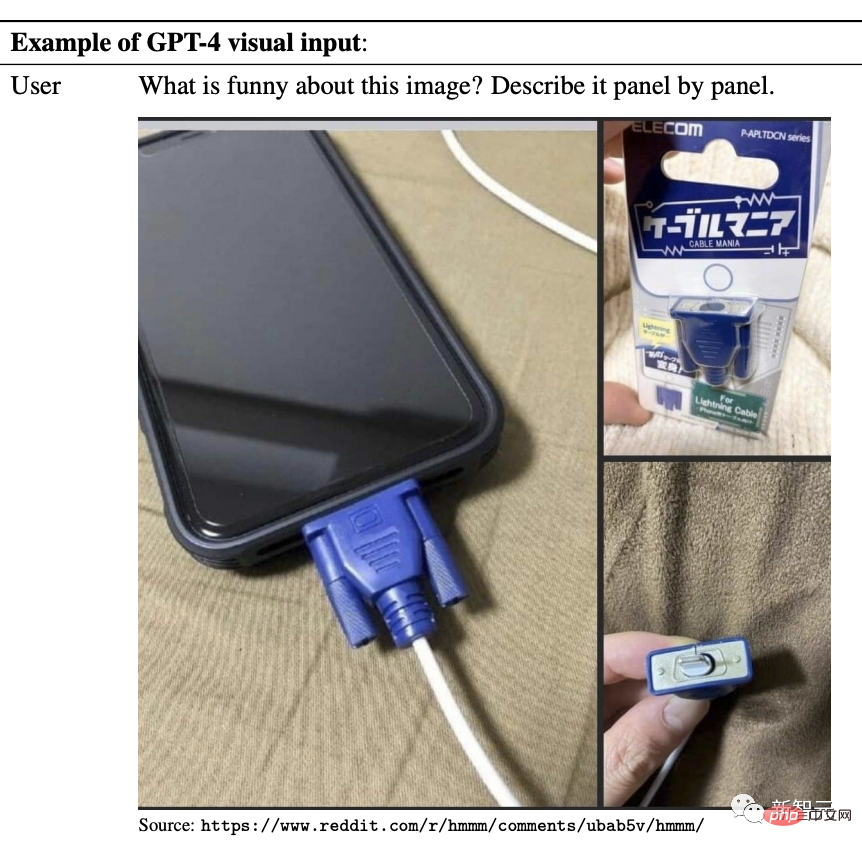

Le point fort de cette mise à niveau de GPT-4 est bien sûr la multi-modalité.GPT-4 peut non seulement analyser et résumer les icônes graphiques, mais peut même lire les mèmes et expliquer où se trouvent les mèmes et pourquoi ils sont drôles. En ce sens, il peut même tuer instantanément de nombreux humains.

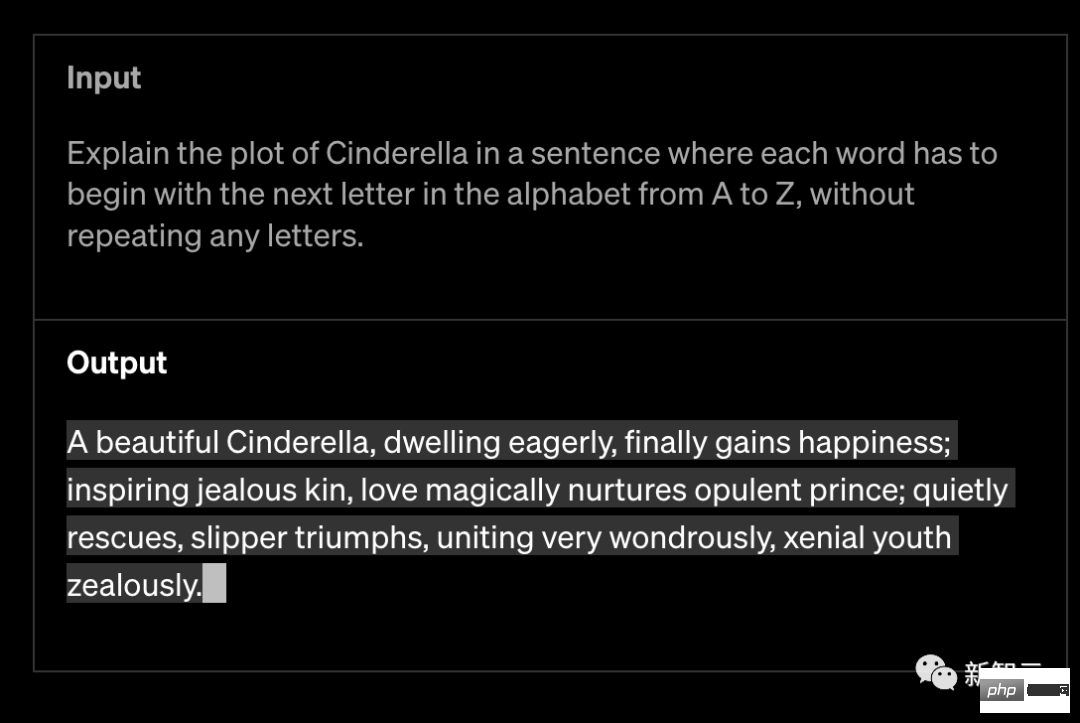

OpenAI affirme que GPT-4 est plus créatif et collaboratif que les modèles précédents. Il peut générer, éditer et itérer des utilisateurs pour des tâches d'écriture créatives et techniques, telles que composer des chansons, écrire des scénarios ou apprendre le style d'écriture de l'utilisateur.

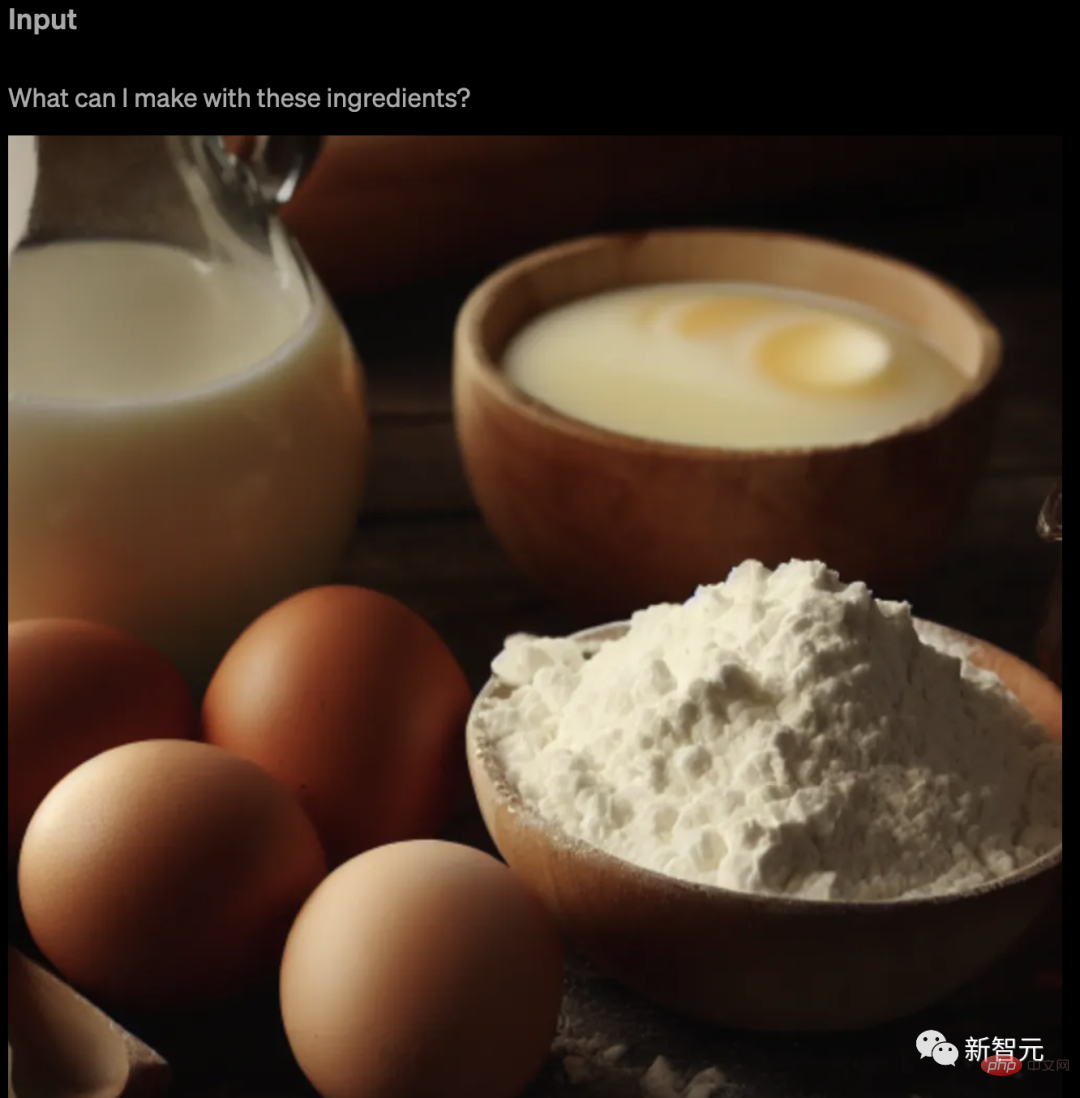

GPT-4 peut prendre des images en entrée et générer des légendes, une classification et une analyse. Par exemple, donnez-lui une photo d'ingrédients et demandez-lui ce qu'il peut faire avec ces ingrédients.

GPT-4 surpasse ChatGPT dans ses capacités d'inférence avancées. Comme suit :

GPT-4 surpasse ChatGPT dans ses capacités d'inférence avancées. Comme suit :

Reconnaissance de mème

Par exemple, montrez-lui une image de mème étrange, puis demandez ce qui est drôle dans l'image.

Après avoir obtenu GPT-4, il analysera d'abord le contenu d'une vague d'images puis donnera des réponses.

Par exemple, analysez l'image suivante par image.

GPT-4 a immédiatement réagi : Le "Câble de chargement d'éclairage" sur la photo ressemble à une grosse interface VGA obsolète, branchée sur ce petit smartphone moderne, le contraste est fort.

Étant donné un autre mème comme celui-ci, où est le mème GPT-4 ?

Il a répondu couramment : Ce qui est drôle avec ce mème, c'est que "l'image et le texte ne correspondent pas".

Le texte indique clairement qu'il s'agit d'une photo de la Terre prise depuis l'espace, mais l'image n'est en réalité qu'un tas de nuggets de poulet disposés comme une carte.

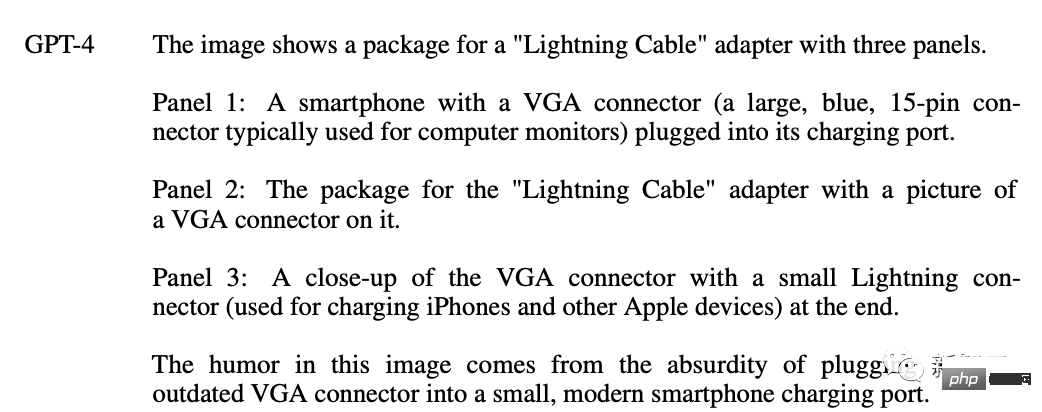

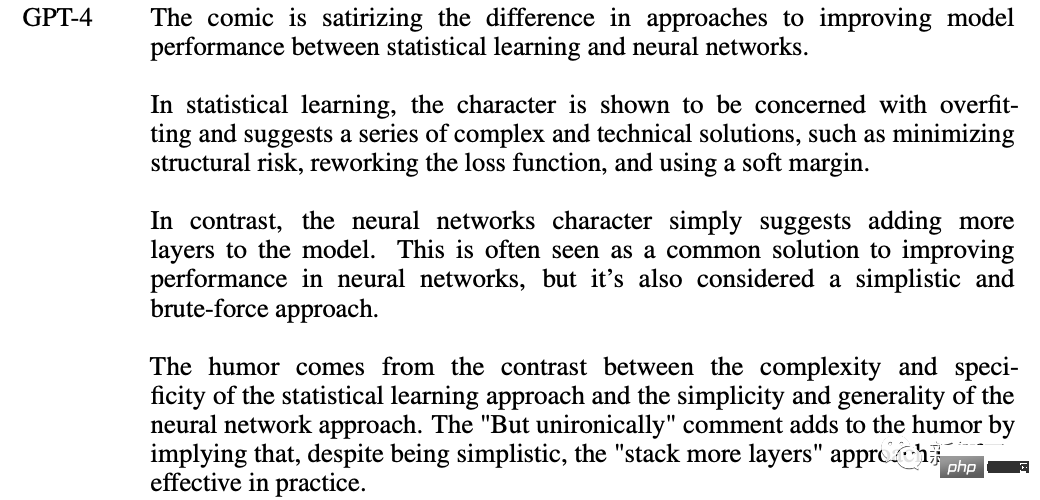

GPT-4 peut également comprendre les bandes dessinées : pourquoi devons-nous ajouter des couches au réseau neuronal ?

Il fait mouche, ce dessin animé fait la satire de la différence entre l'apprentissage statistique et les réseaux de neurones dans l'amélioration des performances des modèles.

Analyse graphique

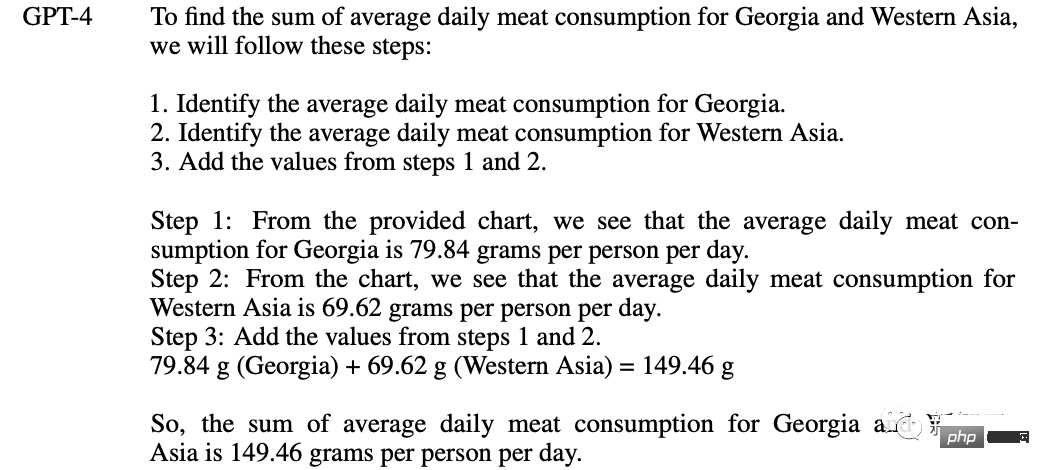

Quelle est la consommation quotidienne moyenne combinée de viande en Géorgie et en Asie occidentale ? Expliquez votre raisonnement étape par étape avant de donner votre réponse.

Effectivement, GPT-4 a clairement énuméré ses propres étapes pour résoudre le problème -

1 Déterminez la consommation quotidienne moyenne de viande en Géorgie.

2. Déterminez la consommation quotidienne moyenne de viande en Asie occidentale.

3. Additionnez les valeurs des étapes 1 et 2.

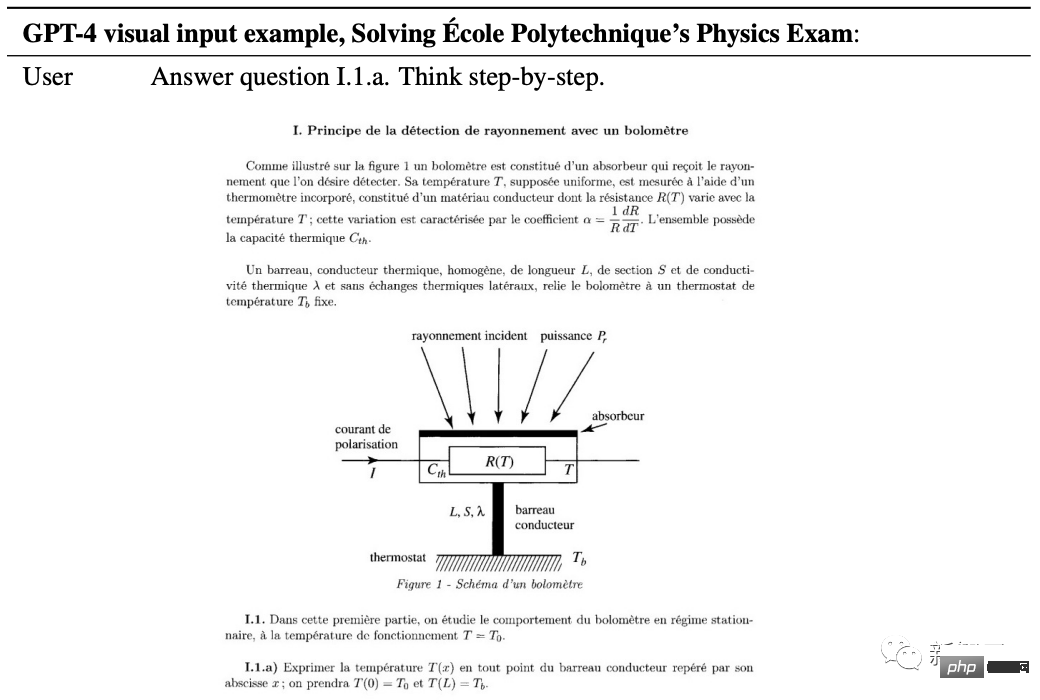

Faire des questions de physique

nécessite GPT-4 pour résoudre une question de physique de l'Ecole Polytechnique, qui est le principe de détection des rayonnements du bolomètre. Il convient de noter que cette question reste une question française.

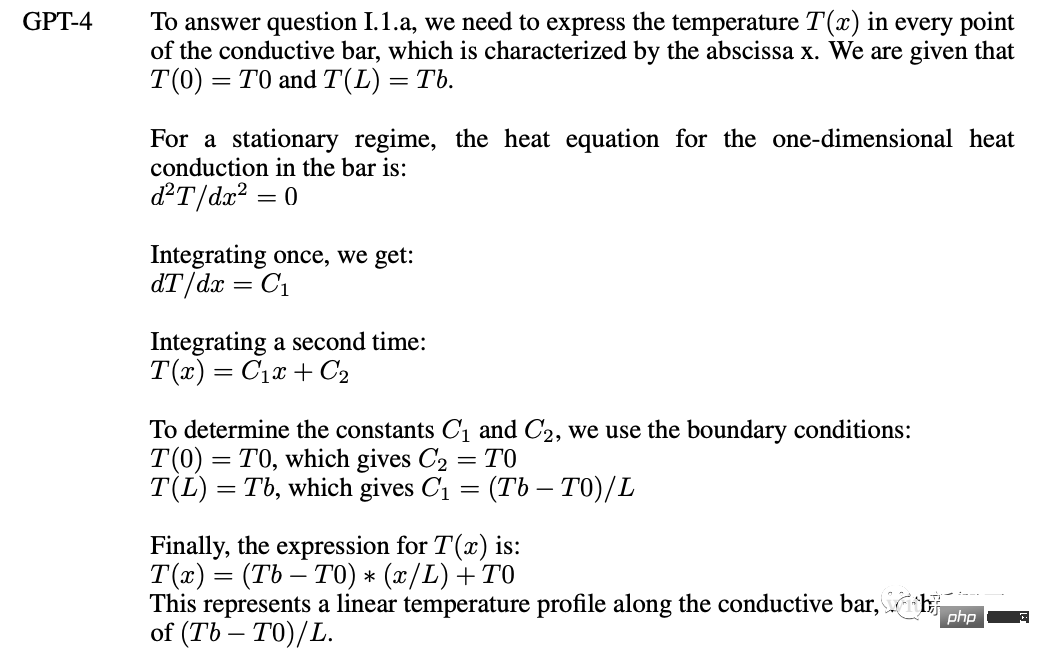

GPT-4 Commencez à résoudre le problème : Pour répondre à la question I.1.a, nous avons besoin de la température T(x) de chaque point, représentée par l'abscisse x de la tige conductrice.

Le processus de résolution de problèmes qui s'ensuit est plein d'énergie.

Pensez-vous que ce soient toutes les capacités de GPT-4 ?

Le patron Greg Brockman s'est rendu directement en ligne pour une démonstration A travers cette vidéo, vous pouvez ressentir intuitivement les capacités de GPT-4.

La chose la plus étonnante est que GPT-4 a une forte capacité à comprendre le code et à vous aider à générer du code.

Greg a dessiné un schéma griffonné directement sur le papier, a pris une photo, l'a envoyée à GPT et a dit, écrivez le code de la page Web selon cette mise en page, puis il a été écrit.

De plus, si une erreur se produit pendant le fonctionnement, envoyez le message d'erreur, ou même une capture d'écran du message d'erreur, à GPT-4 pour vous donner les invites correspondantes.

Les internautes ont appelé : Conférence GPT-4, vous apprenez étape par étape comment remplacer les programmeurs.

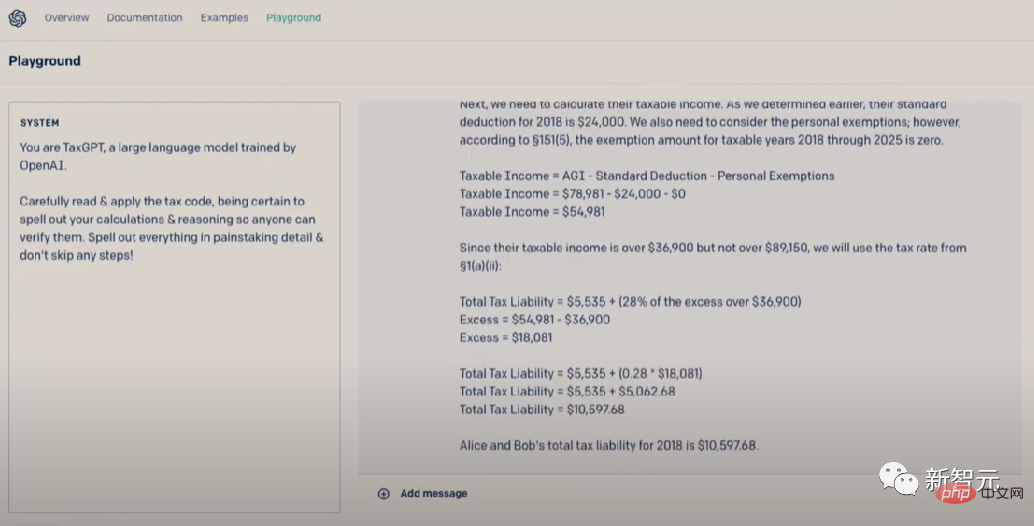

À propos, vous pouvez également déclarer vos impôts en utilisant GPT-4. Vous savez, les Américains consacrent chaque année beaucoup de temps et d’argent à déclarer leurs impôts.

Processus de formation

Comme les modèles GPT précédents, la formation du modèle de base GPT-4 utilise des données Internet publiques et des données autorisées par OpenAI, dans le but de prédire le mot suivant dans le document.

Les données sont un corpus basé sur Internet qui comprend des solutions correctes/mauvaises à des problèmes mathématiques, un raisonnement faible/fort, des déclarations contradictoires/cohérentes, suffisamment pour représenter un grand nombre d'idéologies et d'idées.

Lorsque l'utilisateur est invité à poser une question, le modèle de base peut répondre de différentes manières, mais la réponse peut être loin de l'intention de l'utilisateur.

Ainsi, pour l'aligner sur l'intention de l'utilisateur, OpenAI affine le comportement du modèle à l'aide d'un apprentissage par renforcement basé sur le retour humain (RLHF).

Cependant, la capacité du modèle semble provenir principalement du processus de pré-formation, et le RLHF ne peut pas améliorer les résultats des tests (s'il n'est pas activement renforcé, il réduira en fait les résultats des tests).

Le modèle de base doit inciter le projet à savoir qu'il doit répondre à la question, de sorte que l'orientation du modèle vient principalement du processus post-formation.

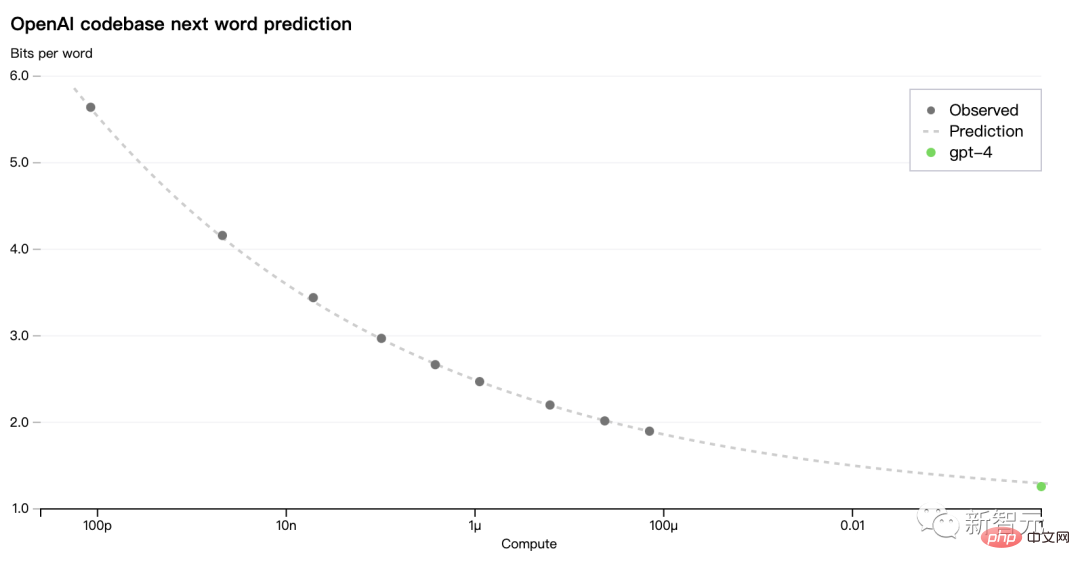

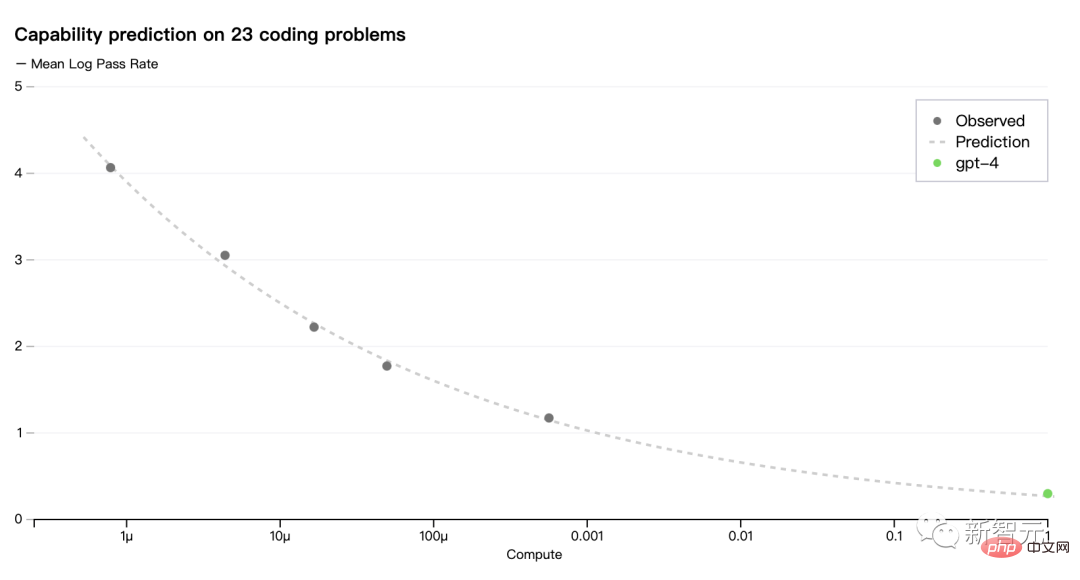

L'un des principaux objectifs du modèle GPT-4 est d'établir une pile d'apprentissage profond évolutive et prévisible. Parce que pour une formation à grande échelle comme GPT-4, un réglage approfondi spécifique au modèle n'est pas réalisable.

Par conséquent, l'équipe OpenAI a développé une infrastructure et des optimisations qui ont un comportement prévisible à plusieurs échelles.

Pour vérifier cette évolutivité, les chercheurs ont prédit avec précision à l'avance la perte finale de GPT-4 sur une base de code interne (ne faisant pas partie de l'ensemble d'entraînement) en déduisant d'un modèle entraîné selon la même méthode, mais la quantité de calcul utilisé est 1/10000.

Désormais, OpenAI peut prédire avec précision les pertes métriques optimisées pendant l'entraînement. Par exemple, déduire d'un modèle avec une charge de calcul de 1/1000 et prédire avec succès le taux de réussite d'un sous-ensemble de l'ensemble de données HumanEval :

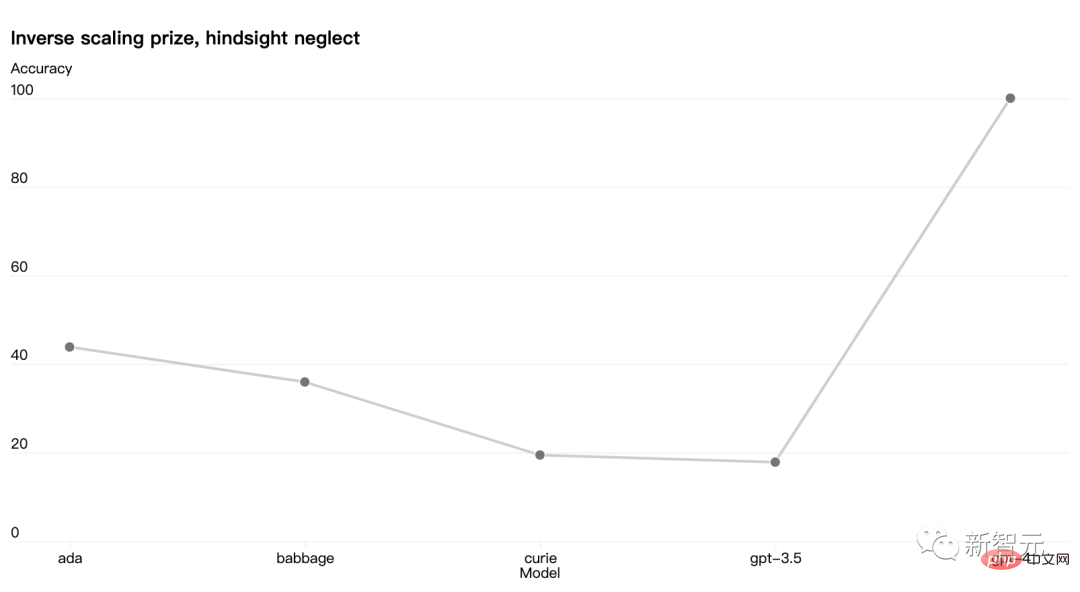

Il existe également certaines capacités qui sont encore difficiles à prédire . Par exemple, le concours Inverse Scaling visait à trouver une métrique qui s’aggrave à mesure que la charge de calcul du modèle augmente, et la tâche de négligence a posteriori a été l’une des gagnantes. Mais GPT-4 a inversé cette tendance :

OpenAI estime que les capacités d'apprentissage automatique capables de prédire avec précision l'avenir sont cruciales pour la sécurité technique, mais elles n'ont pas reçu suffisamment d'attention.

Maintenant, OpenAI investit plus d'énergie dans le développement de méthodes connexes et appelle l'industrie à travailler ensemble.

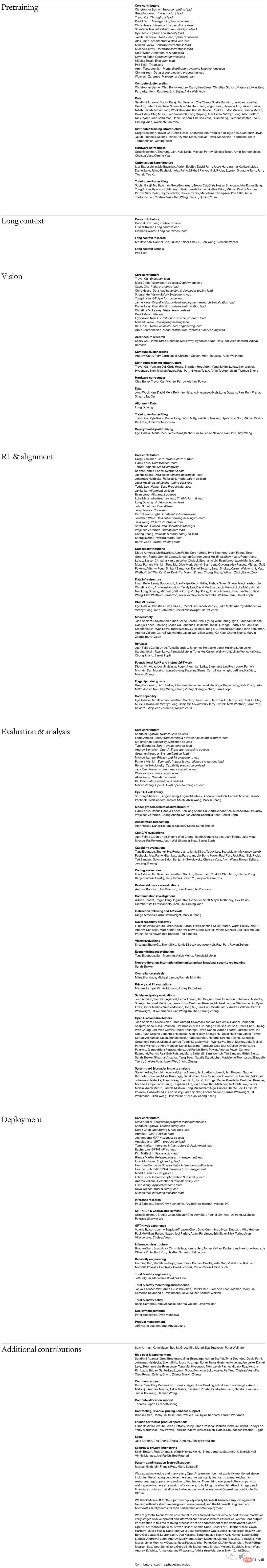

Liste des contributions

Au même moment où GPT-4 était publié, Open AI a également divulgué la structure organisationnelle et la liste du personnel de GPT-4.

Faites glisser votre doigt de haut en bas pour tout voir

Le professeur Chen Baoquan de l'Université de Pékin a déclaré :

Peu importe la qualité du film, personne ne regardera le générique final du début à la fin. L’émission d’Open AI n’adopte même pas cette approche inhabituelle. Il ne fait aucun doute que ce sera la liste des «cast Members» (contributeurs) qui sera non seulement la plus lue, mais aussi soigneusement étudiée. Le plus grand attrait est la classification détaillée des contributions, qui est presque une structure approximative des départements.

Cette divulgation très « audacieuse » a en fait une signification d'une grande portée. Elle reflète le concept de base derrière l'Open AI et indique également dans une certaine mesure la direction des progrès futurs.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Cascade déroulante Boîte en V Mode en V

Apr 07, 2025 pm 08:06 PM

Vue et Element-UI Boîtes déroulantes en cascade Points de fosse de liaison V-model: V-model lie un tableau représentant les valeurs sélectionnées à chaque niveau de la boîte de sélection en cascade, pas une chaîne; La valeur initiale de SelectOptions doit être un tableau vide, non nul ou non défini; Le chargement dynamique des données nécessite l'utilisation de compétences de programmation asynchrones pour gérer les mises à jour des données en asynchrone; Pour les énormes ensembles de données, les techniques d'optimisation des performances telles que le défilement virtuel et le chargement paresseux doivent être prises en compte.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.