Périphériques technologiques

Périphériques technologiques

IA

IA

Xiaozha a dépensé beaucoup d'argent ! Meta a développé un modèle d'IA spécifiquement pour le Metaverse

Xiaozha a dépensé beaucoup d'argent ! Meta a développé un modèle d'IA spécifiquement pour le Metaverse

Xiaozha a dépensé beaucoup d'argent ! Meta a développé un modèle d'IA spécifiquement pour le Metaverse

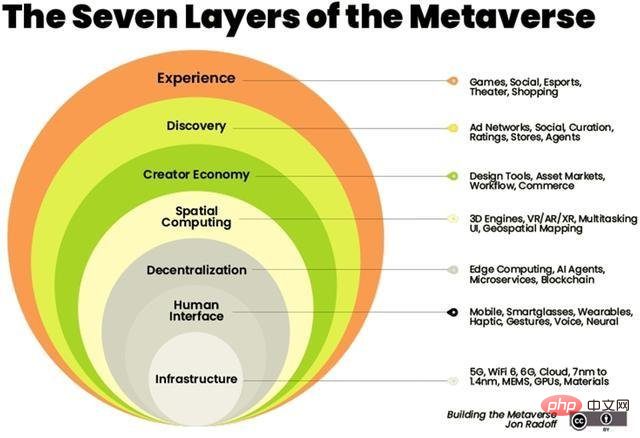

L'intelligence artificielle deviendra l'épine dorsale du monde virtuel.

L'intelligence artificielle peut être combinée avec une variété de technologies connexes dans le métaverse, telles que la vision par ordinateur, le traitement du langage naturel, la blockchain et les jumeaux numériques.

En février, Zuckerberg a montré à quoi ressemblerait le Metaverse lors du premier événement virtuel de l'entreprise, Inside The Lab. Il a déclaré que la société développe une nouvelle série de modèles d'IA générative qui permettront aux utilisateurs de générer leurs propres avatars de réalité virtuelle simplement en les décrivant.

Zuckerberg a annoncé une série de projets à venir, tels que le projet CAIRaoke, un modèle neuronal entièrement de bout en bout pour créer des assistants vocaux sur des appareils pouvant aider les utilisateurs à communiquer plus naturellement avec leurs assistants vocaux. Pendant ce temps, Meta travaille dur pour créer un traducteur vocal universel qui fournit une traduction parole-parole directe pour toutes les langues.

Quelques mois plus tard, Meta a tenu sa promesse. Cependant, Meta n’est pas la seule entreprise technologique à avoir du skin dans le jeu. Des sociétés telles que Nvidia ont également publié leurs propres modèles d’IA auto-développés pour offrir une expérience Metaverse plus riche.

Transformateur pré-entraîné open source (OPT-175 milliards de paramètres)

GAN verse 3D

GANverse 3D a été développé par NVIDIA AI Research. Il s'agit d'un modèle qui utilise l'apprentissage en profondeur pour traiter des images 2D en versions animées 3D. L'outil de l'année dernière, décrit dans un document de recherche publié à l'ICLR et au CVPR, peut générer des simulations plus rapidement et à moindre coût.

Ce modèle utilise StyleGAN pour générer automatiquement plusieurs vues à partir d'une seule image. L'application peut être importée en tant qu'extension de NVIDIA Omniverse pour restituer avec précision des objets 3D dans des mondes virtuels. Omniverse lancé par NVIDIA aide les utilisateurs à créer des simulations de leurs idées finales dans un environnement virtuel.

La production de modèles 3D est devenue un facteur clé dans la construction du Metaverse. Des détaillants tels que Nike et Forever21 ont installé leurs magasins virtuels dans le Metaverse pour stimuler les ventes en ligne.

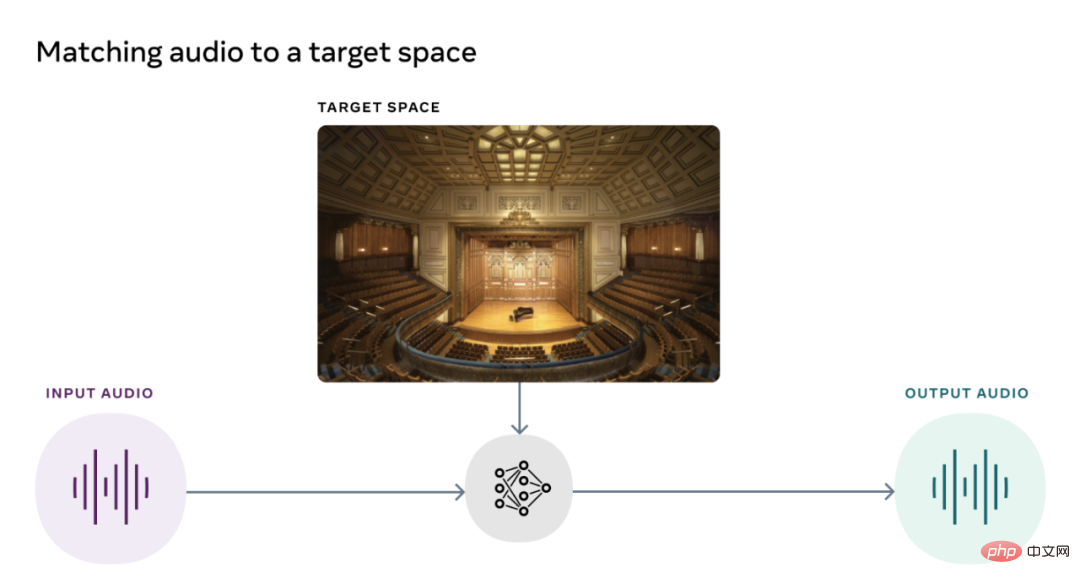

Visual Acoustic Matching Model (AViTAR)

L'équipe Reality Lab de Meta a collaboré avec l'Université du Texas pour construire un modèle d'intelligence artificielle afin d'améliorer la qualité sonore du métaespace. Ce modèle permet de faire correspondre l'audio et la vidéo dans une scène. Il transforme les clips audio pour leur donner l'impression qu'ils ont été enregistrés dans un environnement spécifique. Le modèle utilise un apprentissage auto-supervisé après avoir extrait des données de vidéos en ligne aléatoires. Idéalement, les utilisateurs devraient pouvoir visualiser leurs souvenirs préférés sur leurs lunettes AR et entendre les sons exacts produits par l'expérience réelle.

Meta AI a publié AViTAR en open source, ainsi que deux autres modèles acoustiques, ce qui est très rare étant donné que le son est une partie souvent négligée de l'expérience métaverse.

Réduction des vibrations à impact visuel (VIDA)

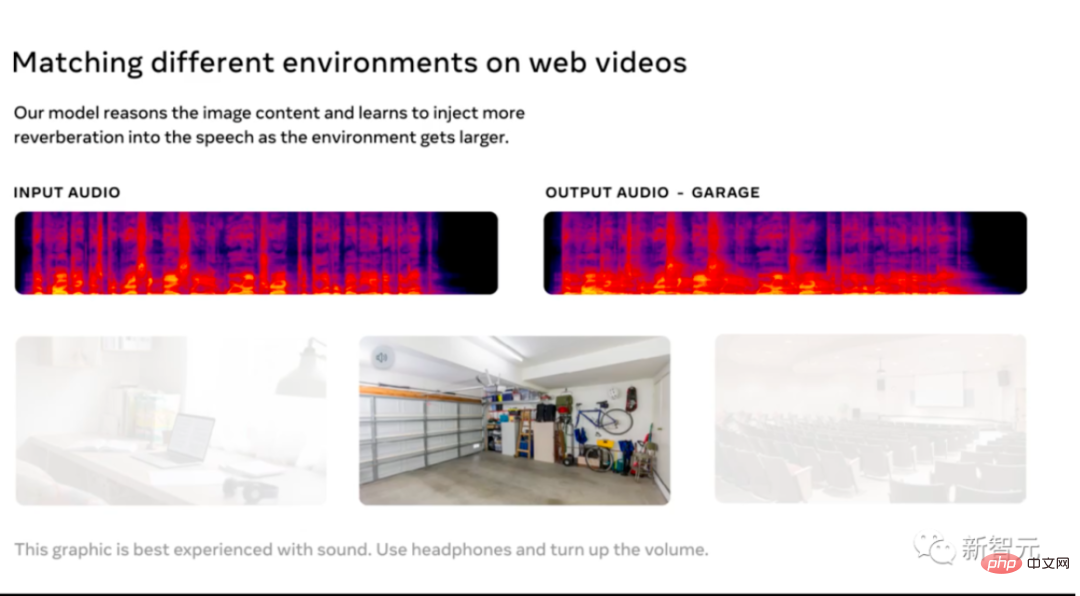

Le deuxième modèle acoustique publié par Meta AI est utilisé pour supprimer la réverbération dans l'acoustique.

Le modèle est entraîné sur un ensemble de données à grande échelle avec divers rendus audio réalistes à partir de modèles 3D de maisons. La réverbération réduit non seulement la qualité de l'audio, le rendant difficile à comprendre, mais elle améliore également la précision de la reconnaissance vocale automatique.

VIDA est unique en ce sens qu'il utilise des signaux audio et visuels pour l'observation. En améliorant les approches typiques uniquement audio, VIDA peut améliorer la parole et identifier les voix et les locuteurs.

Visual Voice (VisualVoice)

VisualVoice, le troisième modèle acoustique publié par Meta AI, peut extraire la parole des vidéos. Comme VIDA, VisualVoice est formé sur les signaux audiovisuels provenant de vidéos non étiquetées. Le modèle a automatiquement séparé la parole.

Ce modèle a des scénarios d'application importants, tels que la création de technologies pour les malentendants, l'amélioration du son des appareils AR portables, la transcription de la parole à partir de vidéos en ligne dans des environnements bruyants, etc.

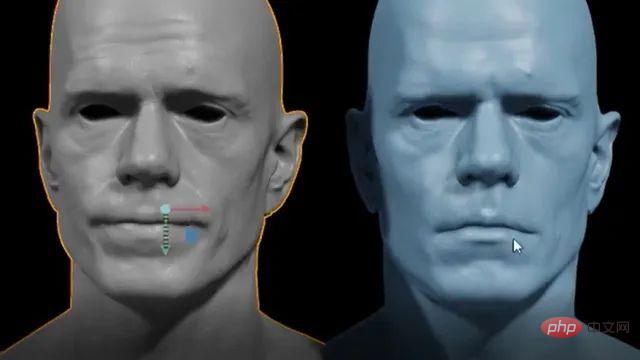

Audio2Face

L'année dernière, NVIDIA a publié une version bêta ouverte d'Omnverse Audio2Face pour générer des animations faciales pilotées par l'IA pour correspondre à n'importe quelle voix off. Cet outil simplifie le processus long et fastidieux d'animation de jeux et d'effets visuels. L'application permet également aux utilisateurs d'émettre des commandes dans plusieurs langues.

Au début de cette année, Nvidia a publié une mise à jour de l'outil, ajoutant des fonctionnalités telles que BlendShape Generation pour aider les utilisateurs à créer un ensemble de blendhapes à partir d'un avatar neutre. De plus, la fonctionnalité d'un lecteur audio en streaming a été ajoutée, permettant la diffusion en continu de données audio à l'aide d'applications de synthèse vocale. Audio2Face met en place un modèle de personnage 3D pouvant être animé avec des pistes audio. L’audio est ensuite introduit dans un réseau neuronal profond. Les utilisateurs peuvent également modifier les caractères en post-traitement pour modifier leurs performances.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.