Pouvez-vous reconnaître les fausses photos créées par l'IA ?

L'ère du voir c'est croire est révolue, l'IA a appris à créer la réalité.

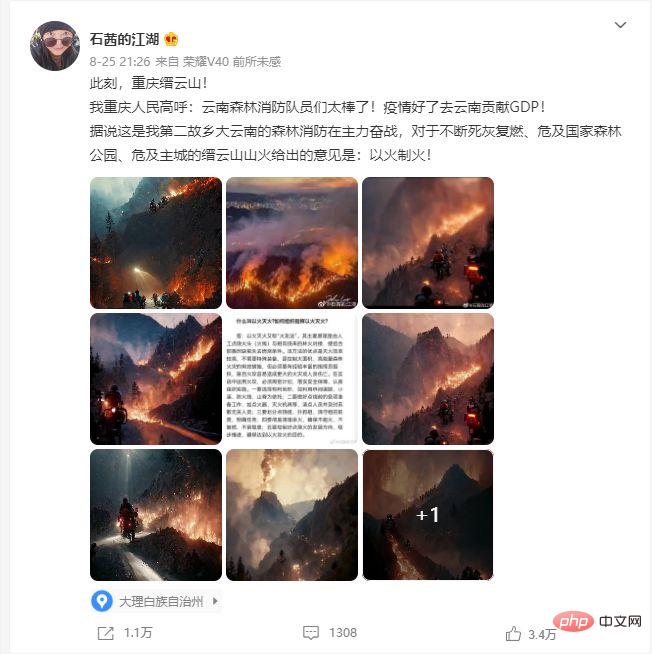

Le 21 août, un incendie s'est déclaré dans la montagne Jinyun à Beibei, Chongqing. Le feu s'est propagé aux villages et villes au pied de la montagne. La route de montagne est escarpée et sablonneuse, mais la moto est assez agile. Les motocyclistes qui transportaient peu à peu des provisions jusqu'à la montagne sont devenus les protagonistes de ce sauvetage en cas d'incendie de forêt et sont également devenus le centre de l'attention des gens sur les réseaux sociaux.

Dans le même temps, les internautes ont souligné que « 8 photos sur 10 des incendies de forêt de Chongqing ont été peintes par AI, mais les commentaires ci-dessous étaient tellement émus qu'ils ont pleuré ».

En fait, il n'est peut-être pas si facile de juger si une telle image est vraie ou fausse. Ci-dessous, vous pouvez l'essayer. L’IA peut également en dessiner davantage. Construire une chaise en avocat, ouvrir le marché vers le ciel, mettre un chat dans une scène médiévale pour trouver le Wi-Fi... ce sont toutes de petites choses. Jason Allen, président d'une société américaine de jeux de société, a utilisé l'outil de peinture IA Midjourney pour générer une pièce de "Space Opera" qu'il a lui-même peaufinée. Il a également remporté le premier prix du concours d'art de l'État du Colorado. Équitable. Le média technologique TechCrunch a évalué le "AI Painter" non censuré comme "Deepfakes pour tous (deepfakes tout-puissants)".

À quoi sert le changement de visage par l'IA ?

La « fausse » technologie d’IA connue antérieurement est une technologie de contrefaçon profonde, communément connue sous le nom de changement de visage de l’IA. En 2019, un rapport indiquait qu’il y avait déjà à cette époque des dizaines de milliers de vidéos produites à l’aide de la technologie deepfake sur Internet.

Le rapport indique également que 96 % de ces vidéos sont des vidéos pornographiques et que les protagonistes de ces vidéos pornographiques sont toutes des femmes. Les plus populaires d'entre elles sont les vidéos mettant en vedette des actrices européennes et américaines et des idoles féminines coréennes.

Henry Ajder, un chercheur impliqué dans le rapport, a déclaré que les utilisateurs de forums deepfakes demandent ou discutent de vidéos pornographiques d'échange de visage mettant en vedette des femmes qu'ils connaissent (comme des ex-petites amies). Ils veulent les voir figurer dans des clips pornographiques.

La peinture IA ne consiste pas seulement à changer de visage.

Ouvrez la boîte de Pandore

Nous avons entré 5 instructions sombres pour voir si la peinture IA est illimitée ?

AI semble avoir une compréhension limitée de la violence. Mais l’interprétation du sexe est juste – et elle le pense aussi.

Stable Diffusion, ce "AI peintre" open source et puissant s'est mis en place un "Safety Checker", qui équivaut à un examen automatique : une fois que l'image générée est détectée comme étant suspectée de violer la politique de contenu, elle sera inclus dans la politique de contenu S'il est indiqué qu'il ne peut pas être utilisé pour générer des « images inconfortables, pornographiques, haineuses, violentes et autres », la machine bloquera l'image.

Nous avons envoyé les « mauvaises photos » que nous avons générées pour examen, et la machine n'a jugé que six photos nues de Justin Bieber comme des « violations ». Cependant, nous avons également réussi à générer plusieurs photos de Trump embrassant Churchill à travers le temps et l'espace, et les photos ont été jugées « sûres » par le modérateur.

Évidemment, du fait que nous avons réussi à générer des photos nues de Justin Bieber contre sa volonté, la révision automatique de Stable Diffusion peut être désactivée. De cette façon, il ne pourra plus vous rejeter.

Afin de restreindre l'IA et les mauvaises pensées que les gens ont tendance à avoir face à la boîte de Pandore, le plus célèbre « peintre IA » DALL·E 2 fait l'objet d'une censure plus stricte.

Certains internautes ont collecté toutes les instructions qui lui ont valu de recevoir des avertissements de violation de la politique de contenu, notamment "Des singes britanniques mangeant du fish and chips", "Un calamar conduisant un monocycle dans un accident avec délit de fuite" et "Photos de Jésus soumis à une attaque nucléaire". tests d'acidité". Toute description pouvant impliquer de la haine, de la violence, de la pornographie et les noms de toutes personnalités connues font partie des mots interdits dans DALL·E 2. Vous ne pouvez donc pas manipuler DALL·E 2 pour vous dessiner une image de Trump et Biden s'embrassant, mais Stable Diffusion le peut.

Les fausses photos générées par l'IA ont des failles

Cependant, les photos actuelles générées par l'IA ne sont pas parfaites.

Zheng Shujing, journaliste au Mingcha Studio, un projet de vérification des faits de The Paper, a déclaré que les images générées par l'IA auront certaines caractéristiques, telles que des bulles, des arrière-plans surréalistes, la taille des dents des personnages, des formes de cheveux non naturelles, etc. Les premiers changements de visage de l’IA étaient sujets à des problèmes lors de la présentation de modèles continus et répétés, souvent de tailles inégales. De nos jours, certaines entreprises se sont améliorées grâce à des réseaux contradictoires génératifs continuellement améliorés, et ces problèmes sont devenus relativement moins fréquents, mais ils peuvent parfois encore être visibles à partir de détails tels que la déformation de l'arrière-plan et l'asymétrie corporelle.

Les détails sont là où l'IA échoue souvent. Par exemple, l'hélicoptère sur la photo ci-dessous n'a pas de dérive.

De plus, les informations générales peuvent également aider à distinguer si une photo est authentique ou non. « Par exemple, si vous me donnez une photo et qu'on dit qu'elle provient des incendies de forêt de Chongqing, si vous trouvez que c'est la dernière. La date de modification de cette photo est postérieure à l'incident, ce n'est pas grave. C'est juste une fausse photo. Nous vous contactons parfois aussi pour des informations de base, comme vérifier le modèle de l'hélicoptère sur la photo, etc. "

Mais la plupart des outils avec laquelle elle entre en contact ne vous dira pas directement si une photo est réelle ou fausse, et vous devez vous fier aux gens pour porter des jugements en fonction de circonstances spécifiques.

À mesure que les compétences de peinture de l'IA deviennent de plus en plus compétentes, il deviendra de plus en plus difficile de faire la distinction entre le vrai et le faux. La certitude de la réalité se relâche. À cette époque, les gens entendent souvent des voix comme celle-ci dans leur esprit : « Cette photo a l’air trop réelle, donc elle est trop fausse. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe