Périphériques technologiques

Périphériques technologiques

IA

IA

Tesla utilise l'intelligence artificielle pour améliorer la conduite autonome

Tesla utilise l'intelligence artificielle pour améliorer la conduite autonome

Tesla utilise l'intelligence artificielle pour améliorer la conduite autonome

Tesla a déclaré lors d'une conférence d'investisseurs la semaine dernière que ses capacités de conduite autonome seraient considérablement améliorées une fois que le supercalculateur Dojo rejoindrait son infrastructure de calcul haute performance.

S'exprimant lors de la conférence de la Journée des investisseurs, Ashok Elluswamy, directeur du logiciel Tesla Autopilot, a déclaré que les véhicules Tesla (actuellement environ 400 000 clients) exécutant le logiciel FSD (Full Self-Driving) seront en mesure de prendre des décisions de conduite autonome plus intelligentes grâce à des mises à niveau matérielles, qui amélioreront les capacités globales de l’intelligence artificielle (IA).

L'entreprise dispose actuellement d'un système d'intelligence artificielle qui collecte des données visuelles de huit caméras sur la voiture en temps réel et génère une sortie 3D qui identifie les obstacles et leur mouvement, les véhicules, les routes et les feux de circulation, et prend des décisions pour aider le voiture Les tâches de prise de décision sont modélisées.

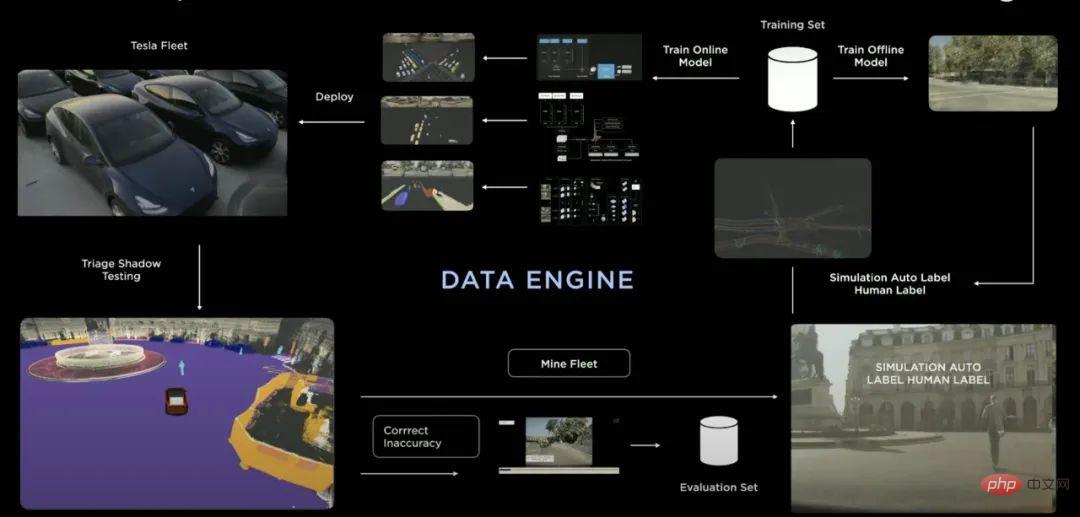

Tesla exploite son réseau automobile pour obtenir davantage de données visuelles et les intègre au modèle de formation. Les modèles de formation permettant d’apprendre continuellement à résoudre de nouveaux problèmes aident l’IA à mieux comprendre les tendances sur la route. Grâce aux mises à niveau du logiciel FSD, de nouvelles connaissances sont introduites dans la voiture.

"Si nous exécutons et répétons ce processus, cela s'améliore de plus en plus." Elluswamy a déclaré : "La solution pour un FSD évolutif consiste à obtenir une architecture, des données et un calcul parfaits, et nous avons constitué une équipe de classe mondiale. pour effectuer ce travail. Ils mettent ces trois efforts au premier plan. La société a fourni un correctif logiciel via une mise à jour en direct. Les clients Tesla peuvent acheter du FSD à partir de 99 $ par mois. Certains clients possédant des modèles Tesla plus anciens doivent également payer un supplément pour installer des ordinateurs FSD. Elluswamy affirme que les Teslas avec FSD sont toujours cinq à six fois plus sûres que la moyenne nationale américaine.

Elluswamy a déclaré : « À mesure que nous améliorons la sécurité, la fiabilité et le confort de nos systèmes, ils peuvent débloquer des opérations sans conducteur qui feront évoluer la façon dont les voitures sont utilisées et au-delà de la façon dont elles sont actuellement utilisées

Aujourd'hui, le La société exécute ses systèmes d'IA sur 14 000 GPU dans ses centres de données et peut exploiter 30 pétaoctets de cache vidéo, qui passe désormais à 200 pétaoctets. Environ 4 000 GPU sont utilisés pour l’étiquetage automatique, et les 10 000 GPU restants sont utilisés pour la formation des données d’intelligence artificielle.

Elluswamy a déclaré : "Une fois que nous aurons introduit Dojo (notre ordinateur d'entraînement) dans cette zone, tout cela augmentera considérablement."

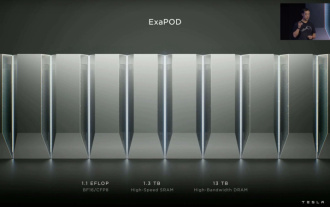

Le système Dojo est basé sur la puce D1 auto-développée par Tesla et peut fournir 22,6 téraflops. des performances du FP32. Il dispose de 50 milliards de transistors et de 10 To/s de bande passante sur puce, ainsi que de 4 To/s de bande passante hors puce.

Un ensemble de puces D1 sera installé dans une armoire ExaPOD haute densité, qui fournira 1,1 exaoctets de performances BFP16 et CFP8. L’ordinateur FSB embarqué de Tesla peut fournir 150 téraflops de performances et est principalement utilisé pour l’inférence.

Ganesh Venkataraman, directeur principal du matériel chez Tesla, a déclaré lors d'un discours lors de la conférence Hot Chips de l'année dernière que Tesla avait fabriqué la puce D1 en raison de défauts de mise à l'échelle du GPU et du CPU.

Venkataraman a déclaré : "Nous avons remarqué beaucoup de goulots d'étranglement. D'abord du côté de l'inférence, c'est pourquoi nous utilisons des ordinateurs FSD. Ensuite, nous avons commencé à remarquer des problèmes similaires d'échelle de formation, et après avoir compris la charge de travail... nous pouvons, en fonction de le résultat Il faut optimiser notre système. »

Au début, le système d’IA de Tesla reposait sur des caméras uniques et des images vidéo uniques, qui étaient ensuite assemblées en post-traitement dans le système de planification de voiture autonome.

"C'était très fragile et n'a pas conduit à un succès significatif", a déclaré Elluswamy.

Au cours des dernières années, Tesla s'est transformée en un « monde vidéo multi-caméras ». Chaque véhicule dispose de huit caméras qui transmettent des informations visuelles au système d'IA, qui génère ensuite un espace de sortie 3D. L'IA prend des décisions sur la présence d'obstacles, leur déplacement, les voies, les routes et les feux de circulation, etc.

La modélisation des tâches va au-delà de la vision par ordinateur et utilise des techniques utilisées dans les systèmes d'intelligence artificielle tels que ChatGPT, notamment la modélisation autorégressive des Transformers, des modules d'attention et des jetons.

Elluswamy a déclaré : « Avec une telle solution de bout en bout pour la perception, nous supprimons réellement l'étape fragile de post-traitement et fournissons un résultat de haute qualité au système de planification. Même le système de planification n'est pas gravé dans le marbre. De plus en plus de systèmes d'intelligence artificielle commencent désormais à être utilisés pour résoudre ce problème. "

Les véhicules autonomes doivent réagir rapidement pour prendre des décisions fluides et sûres en temps réel. Elluswamy a donné l'exemple d'un temps de réponse de 50 millisecondes, où une voiture autonome peut prendre des décisions de conduite après avoir interagi avec l'environnement (y compris les piétons et les feux de circulation).

Cela fait beaucoup de données, et dans l’informatique traditionnelle, « chaque élément de données nécessite 10 millisecondes de temps de calcul, qui peut facilement dépasser 1 000 millisecondes, a déclaré Elluswamy : « Mais avec l’IA, nous avons emballé. » tout cela en 50 millisecondes de calcul afin qu'il puisse fonctionner en temps réel. . Tesla utilise des algorithmes pour reconstruire les voies, les limites des routes, les bordures, les passages pour piétons et d'autres images, qui servent ensuite de base pour aider la voiture à naviguer.

Elluswamy a déclaré : "Ceci est réalisé en collectant divers fragments de différentes voitures de la flotte et en combinant tous les fragments dans une représentation unifiée du monde autour de la voiture." système, le modèle de formation est constamment reconstruit. Pour entraîner les réseaux, Tesla a construit un pipeline d'étiquetage automatisé complexe sur les données collectées, y a exécuté des algorithmes informatiques, puis a généré des étiquettes pour entraîner ces réseaux.

Elluswamy a déclaré : "Une fois la reconstruction des fondations terminée, nous pouvons construire diverses simulations au-dessus de la fondation pour générer des données infiniment diverses pour la formation." Tesla dispose d'un simulateur puissant qui peut synthétiser les conditions météorologiques, les conditions d'éclairage et même les conditions météorologiques adverses. le mouvement d'autres objets. "Chaque fois que nous ajoutons des données, les performances s'améliorent."

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Musk : débuts du supercalcul Tesla Dojo : la puissance de calcul de l'IA de formation d'ici la fin de l'année sera approximativement égale à 8 000 GPU NVIDIA H100

Jul 24, 2024 am 10:38 AM

Musk : débuts du supercalcul Tesla Dojo : la puissance de calcul de l'IA de formation d'ici la fin de l'année sera approximativement égale à 8 000 GPU NVIDIA H100

Jul 24, 2024 am 10:38 AM

Selon les informations de ce site du 24 juillet, le PDG de Tesla, Elon Musk, a déclaré aujourd'hui lors d'une conférence téléphonique sur les résultats que la société était sur le point d'achever le plus grand cluster de formation en intelligence artificielle à ce jour, qui sera équipé de 2 000 GPU NVIDIA H100. Musk a également déclaré aux investisseurs lors de la conférence téléphonique sur les résultats de la société que Tesla travaillerait au développement de son supercalculateur Dojo, car les GPU de Nvidia sont chers. Ce site traduit une partie du discours de Musk comme suit : Le chemin pour rivaliser avec NVIDIA via Dojo est difficile, mais je pense que nous n'avons pas le choix. Nous dépendons désormais trop de NVIDIA. Du point de vue de NVIDIA, ils augmenteront inévitablement le prix des GPU à un niveau que le marché peut supporter, mais

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

Selon les informations de ce site le 1er août, SK Hynix a publié un article de blog aujourd'hui (1er août), annonçant sa participation au Global Semiconductor Memory Summit FMS2024 qui se tiendra à Santa Clara, Californie, États-Unis, du 6 au 8 août, présentant de nombreuses nouvelles technologies de produit. Introduction au Future Memory and Storage Summit (FutureMemoryandStorage), anciennement Flash Memory Summit (FlashMemorySummit) principalement destiné aux fournisseurs de NAND, dans le contexte de l'attention croissante portée à la technologie de l'intelligence artificielle, cette année a été rebaptisée Future Memory and Storage Summit (FutureMemoryandStorage) pour invitez les fournisseurs de DRAM et de stockage et bien d’autres joueurs. Nouveau produit SK hynix lancé l'année dernière

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Selon les informations de ce site Web du 5 juillet, GlobalFoundries a publié un communiqué de presse le 1er juillet de cette année, annonçant l'acquisition de la technologie de nitrure de gallium (GaN) et du portefeuille de propriété intellectuelle de Tagore Technology, dans l'espoir d'élargir sa part de marché dans l'automobile et Internet. des objets et des domaines d'application des centres de données d'intelligence artificielle pour explorer une efficacité plus élevée et de meilleures performances. Alors que des technologies telles que l’intelligence artificielle générative (GenerativeAI) continuent de se développer dans le monde numérique, le nitrure de gallium (GaN) est devenu une solution clé pour une gestion durable et efficace de l’énergie, notamment dans les centres de données. Ce site Web citait l'annonce officielle selon laquelle, lors de cette acquisition, l'équipe d'ingénierie de Tagore Technology rejoindrait GF pour développer davantage la technologie du nitrure de gallium. g