Périphériques technologiques

Périphériques technologiques

IA

IA

Pourquoi ChatGPT est-il soudainement devenu si puissant ? Le long article de 10 000 mots d'un médecin chinois décortique en profondeur l'origine des capacités GPT-3.5

Pourquoi ChatGPT est-il soudainement devenu si puissant ? Le long article de 10 000 mots d'un médecin chinois décortique en profondeur l'origine des capacités GPT-3.5

Pourquoi ChatGPT est-il soudainement devenu si puissant ? Le long article de 10 000 mots d'un médecin chinois décortique en profondeur l'origine des capacités GPT-3.5

La récente sortie de ChatGPT par OpenAI a donné un coup de pouce au domaine de l'intelligence artificielle. Ses puissantes capacités dépassent de loin les attentes des chercheurs en traitement du langage.

Les utilisateurs qui ont expérimenté ChatGPT se poseront naturellement des questions : Comment le GPT 3 original a-t-il évolué vers ChatGPT ? D’où viennent les incroyables capacités linguistiques de GPT 3.5 ?

Récemment, des chercheurs de l'Allen Institute for Artificial Intelligence ont écrit un article, essayant d'analyser la capacité émergente de ChatGPT, de retracer la source de ces capacités et de proposer une technologie complète. La feuille de route illustre comment le modèle GPT-3.5 les séries et les modèles linguistiques à grande échelle associés ont évolué étape par étape vers leur forme puissante actuelle.

Lien original : https://yaofu.notion.site/GPT-3-5-360081d91ec245f29029d37b54573756

Auteur FU尧 Un doctorant à l'Université d'Édimbourg est-il admis en 2020 ? Il a obtenu une maîtrise de l'Université de Columbia et un baccalauréat de l'Université de Pékin. Il est actuellement stagiaire de recherche à l'Institut Allen pour l'intelligence artificielle. Ses principaux domaines de recherche portent sur les modèles génératifs probabilistes à grande échelle du langage humain.

L'auteur Peng Hao est diplômé de l'Université de Pékin avec un baccalauréat et un doctorat de l'Université de Washington. Il est actuellement jeune chercheur à l'Institut Allen pour l'intelligence artificielle et rejoindra le Département d'informatique. Sciences à l'Université de l'Illinois à Urbana-Champaign en août 2023 Département des sciences en tant que professeur adjoint. Ses principaux intérêts de recherche consistent à rendre l’IA linguistique plus efficace et plus compréhensible, ainsi qu’à créer des modèles linguistiques à grande échelle.

L'auteur Tushar KhotPh.D. est diplômé de l'Université du Wisconsin-Madison et est actuellement chercheur à l'Allen Institute for Artificial Intelligence. Son principal domaine de recherche est le raisonnement machine structuré.

1. Version 2020 du GPT-3 de première génération et pré-formation à grande échelle

Le GPT-3 de première génération a démontré trois capacités importantes :

- Génération de langage : Suivez le mot d'invite ( invite), puis générez les phrases complémentaires avec tous les mots d'invite. C’est également la manière la plus courante dont les humains interagissent avec les modèles de langage aujourd’hui.

- Apprentissage en contexte : Suivez quelques exemples d'une tâche donnée, puis générez des solutions pour de nouveaux cas de test. Un point très important est que bien que GPT-3 soit un modèle de langage, son article ne parle pratiquement pas de « modélisation du langage » - les auteurs ont consacré toute leur énergie d'écriture à la vision de l'apprentissage contextuel. C'est le véritable objectif de GPT-3.

- Connaissance du monde : Y compris les connaissances factuelles (connaissance factuelle) et le bon sens (sens commun).

Alors d'où viennent ces capacités ?

Fondamentalement, les trois capacités ci-dessus proviennent d'un pré-entraînement à grande échelle : pré-entraîner un modèle avec 175 milliards de paramètres sur un corpus de 300 milliards de mots (60% du corpus de formation provient de C4+22 de 2016- 2019 % de WebText2 + 16 % de Livres + 3 % de Wikipédia). Parmi eux :

- La capacité de génération de langage vient de l'objectif de formation de la modélisation du langage (modélisation du langage).

- La connaissance du monde provient d'un corpus de formation de 300 milliards de mots (où pourrait-elle être ailleurs).

- Les 175 milliards de paramètres du modèle servent à stocker des connaissances, ce qui est encore prouvé par l'article de Liang et al. Ils ont conclu que les performances dans les tâches à forte intensité de connaissances sont étroitement liées à la taille du modèle.

- La source des capacités d'apprentissage contextuel et la raison pour laquelle l'apprentissage contextuel peut être généralisé sont encore difficiles à retracer. Intuitivement, cette capacité peut provenir de points de données provenant de la même tâche disposés séquentiellement dans le même lot pendant la formation. Cependant, peu de recherches ont été menées sur les raisons pour lesquelles la pré-formation des modèles linguistiques déclenche un apprentissage contextuel et pourquoi l'apprentissage contextuel se comporte si différemment du réglage fin.

Ce qui est curieux, c'est la puissance du GPT-3 de première génération.

En fait, il est difficile de déterminer si le GPT-3 original (appelé davinci dans l'API OpenAI) est "fort" ou "faible".

D'une part, il a répondu raisonnablement à certaines requêtes spécifiques et a obtenu des performances décentes sur de nombreux ensembles de données.

D'autre part, il n'a pas fonctionné aussi bien que T5 sur de nombreuses tâches (voir Petit modèle). son papier original).

Selon les normes ChatGPT d'aujourd'hui (décembre 2022), il est difficile de dire que le GPT-3 d'origine est « intelligent ». Le modèle OPT open source de Meta tente de reproduire le GPT-3 original, mais ses capacités contrastent fortement avec les normes actuelles. De nombreuses personnes qui ont testé OPT pensent également que par rapport à l'actuel text-davinci-002, le modèle n'est en effet « pas si bon ».

Néanmoins, OPT peut être une assez bonne approximation open source du GPT-3 original (selon l'article OPT et l'évaluation HELM de l'Université de Stanford).

Bien que le GPT-3 de première génération puisse sembler faible en surface, des expériences ultérieures ont prouvé que le GPT-3 de première génération a un très fort potentiel. Ces potentiels ont ensuite été libérés par la formation au code, le réglage des instructions et l’apprentissage par renforcement avec rétroaction humaine (RLHF), et le corps final a démontré des capacités émergentes extrêmement puissantes.

2. De la version 2020 de GPT-3 à la version 2022 de ChatGPT

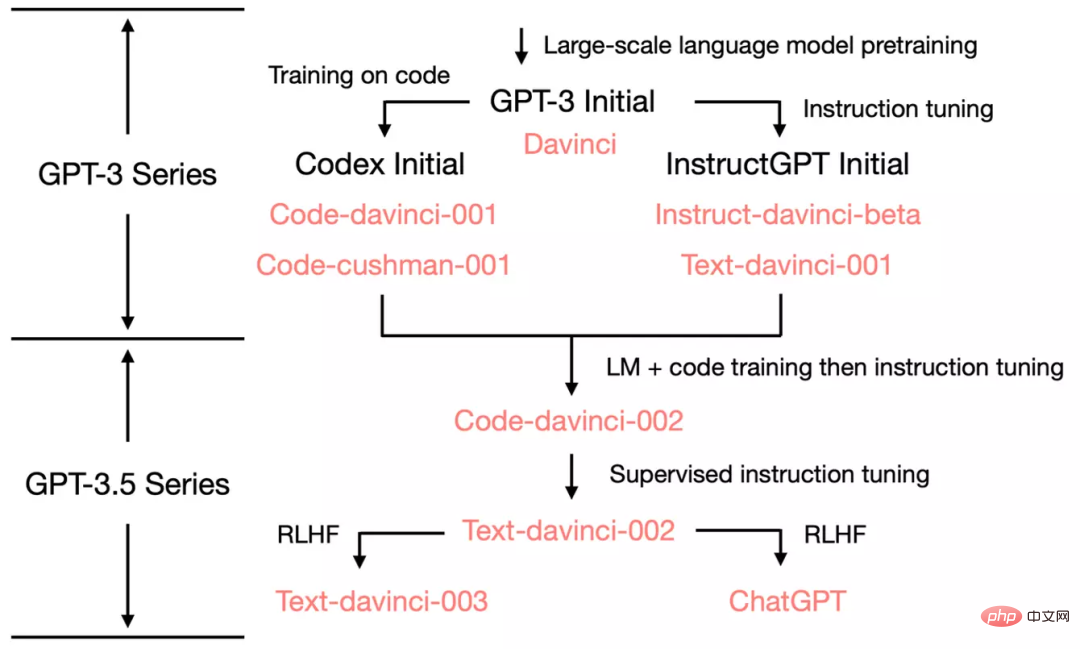

À partir du GPT-3 original, afin de montrer comment OpenAI évolue vers ChatGPT, jetons un coup d'œil à l'arbre évolutif de GPT. -3.5 :

En juillet 2020, OpenAI a publié l'article GPT-3 original de Davinci avec index de modèle, et il a continué d'évoluer depuis lors.

En juillet 2021, le document du Codex a été publié, dans lequel le Codex initial a été affiné sur la base d'une variante (éventuellement interne) de 12 milliards de paramètres GPT-3. Ce modèle de 12 milliards de paramètres a ensuite évolué vers le code-cushman-001 dans l'API OpenAI.

En mars 2022, OpenAI a publié un article sur le réglage des instructions, et sa partie de réglage des instructions supervisée correspond à davinci-instruct-beta et text-davinci-001.

D'avril à juillet 2022, OpenAI a commencé à tester en version bêta le modèle code-davinci-002, également appelé Codex. Ensuite, code-davinci-002, text-davinci-003 et ChatGPT sont tous obtenus grâce aux instructions de réglage fin du code-davinci-002. Consultez la documentation de l’index des modèles d’OpenAI pour plus de détails.

Bien que le Codex ressemble à un modèle de code uniquement, code-davinci-002 est probablement la variante GPT-3.5 la plus puissante pour le langage naturel (mieux que text-davinci-002 et -003). Il est probable que le code-davinci-002 ait été formé à la fois sur le texte et le code, puis adapté en fonction des instructions (expliquées ci-dessous).

Puis text-davinci-002 sorti en mai-juin 2022 est un modèle d'instruction supervisée basé sur le code-davinci-002. Affiner les instructions sur text-davinci-002 est susceptible de réduire la capacité d'apprentissage contextuel du modèle, mais d'améliorer la capacité de tir zéro du modèle (ce sera expliqué ci-dessous).

Ensuite, il y a text-davinci-003 et ChatGPT, tous deux sortis en novembre 2022, qui sont deux variantes différentes du modèle utilisant le réglage des instructions avec l'apprentissage par renforcement à partir du corps humain.

text-davinci-003 restaure (mais est toujours pire que code-davinci-002) certaines des capacités d'apprentissage contextuel perdues dans text-davinci-002 (probablement parce qu'elles ont été mélangées à la modélisation du langage lors du réglage fin) et plus loin capacité améliorée d’échantillonnage zéro (grâce au RLHF). ChatGPT, en revanche, semble sacrifier presque toutes les capacités d'apprentissage du contexte au profit de la possibilité de modéliser l'historique des conversations.

En général, en 2020-2021, avant le code-davinci-002, OpenAI a déployé beaucoup d'efforts pour améliorer GPT-3 grâce à la formation au code et à l'affinement des instructions. Au moment où ils ont complété le code-davinci-002, toutes les capacités étaient déjà là. Il est probable que les ajustements ultérieurs de l'instruction, que ce soit via une version supervisée ou une version d'apprentissage par renforcement, auront les effets suivants (nous y reviendrons plus tard) :

- L'ajustement précis de l'instruction n'injectera pas de nouvelles capacités dans le modèle - toutes les capacités existent déjà. Le rôle des nudges de commande est de débloquer/activer ces capacités. Cela est principalement dû au fait que la quantité de données nécessaires au réglage fin de l'instruction est inférieure de plusieurs ordres de grandeur à la quantité de données de pré-formation (les capacités de base sont injectées via la pré-formation).

- Le réglage fin des commandes différencie GPT-3.5 en différents arbres de compétences. Certains sont meilleurs en apprentissage contextuel, comme text-davinci-003, et d'autres sont meilleurs en conversations, comme ChatGPT.

-

Le réglage fin de l'instruction sacrifie la performance au profit de l'alignement avec les humains. Les auteurs d'OpenAI appellent cela une « taxe d'alignement » dans leur document de mise au point des instructions.

De nombreux articles rapportent que le code-davinci-002 obtient les meilleures performances dans les benchmarks (mais le modèle ne correspond pas nécessairement aux attentes humaines). Après avoir affiné les instructions sur le code-davinci-002, le modèle peut générer des commentaires plus conformes aux attentes humaines (ou le modèle est aligné sur les humains), tels que : des questions et réponses à échantillon nul, générant un dialogue sûr et équitable. réponses et le rejet au-delà de la portée du problème de connaissance du modèle.

Trois, Code-Davinci-002 et Text-Davinci-002, formés sur le code et affiné sur les instructions

Avant code-davinci-002 et text-davinci-002, il y avait deux modèles intermédiaires , Il s'agit respectivement de davinci-instruct-beta et text-davinci-001. Les deux sont pires que les modèles deux-002 mentionnés ci-dessus à bien des égards (par exemple, la capacité de raisonnement en chaîne de text-davinci-001 n'est pas forte).

Nous nous concentrons donc sur le modèle -002 dans cette section.

3.1 La source de capacités de raisonnement complexes et la capacité de généralisation à de nouvelles tâches

Nous nous concentrons sur code-davinci-002 et text-davinci-002, ces deux frères sont la première version du modèle GPT3.5, un pour le code et un autre pour le texte. Ils présentent trois capacités importantes qui sont différentes du GPT-3 d'origine :

- Réponse aux instructions humaines : Auparavant, la sortie de GPT-3 se concentrait principalement sur les phrases courantes dans l'ensemble d'entraînement. Le modèle génère désormais des réponses plus raisonnables (au lieu de phrases pertinentes mais inutiles) aux instructions/mots indicateurs.

- Généralisation à des tâches invisibles : Lorsque le nombre d'instructions utilisées pour ajuster le modèle dépasse une certaine échelle, le modèle peut générer automatiquement des réponses efficaces même sur de nouvelles instructions qu'il n'a jamais vues auparavant. Cette capacité est cruciale pour le déploiement en ligne, car les utilisateurs se poseront toujours de nouvelles questions et le modèle doit être capable d'y répondre.

- Génération de code et compréhension du code : Cette capacité est évidente car le modèle est entraîné avec du code.

- Utilisez la chaîne de pensée pour un raisonnement complexe : La capacité de raisonnement par chaîne de pensée du modèle GPT3 d'origine était faible, voire inexistante. code-davinci-002 et text-davinci-002 sont deux modèles dotés de capacités de raisonnement en chaîne de pensée suffisamment fortes.

- Le raisonnement en chaîne de pensée est important car les chaînes de pensée peuvent être la clé pour débloquer les capacités émergentes et transcender les lois d'échelle.

D'où viennent ces capacités ?

Par rapport au modèle précédent, les deux principales différences sont la mise au point des instructions et l'entraînement au code. Plus précisément :

- La capacité à répondre aux commandes humaines est un produit direct du réglage fin des commandes.

- La capacité de généralisation à répondre à des instructions invisibles apparaît automatiquement une fois que le nombre d'instructions dépasse un certain niveau, et les articles T0, Flan et FlanPaLM le prouvent davantage.

- La capacité à utiliser des chaînes de pensée pour un raisonnement complexe pourrait bien être un sous-produit magique de la formation au codage. Pour cela, nous avons les faits suivants à l'appui :

- Le GPT-3 d'origine n'était pas formé au code, il ne pouvait pas faire d'enchaînement de pensées.

- modèle text-davinci-001, bien qu'il ait été affiné par des instructions, la première version du document sur la chaîne de pensée rapporte que sa capacité à raisonner sur d'autres chaînes de pensée est très faible - donc le réglage fin des instructions peut ne pas être la raison de l'existence des chaînes de pensée, la formation au code est la raison la plus probable pour laquelle le modèle peut effectuer un raisonnement en chaîne de pensée.

- PaLM dispose de 5 % de données de formation de code et peut effectuer un enchaînement de pensées.

- Le volume de données de code dans le document Codex est de 159 Go, soit environ 28 % des 570 milliards de données d'entraînement du GPT-3 d'origine. code-davinci-002 et ses variantes ultérieures peuvent effectuer un raisonnement en chaîne de pensée.

- Dans le test HELM, Liang et al. (2022) ont mené une évaluation à grande échelle de différents modèles. Ils ont constaté que les modèles formés sur le code possèdent de fortes capacités d’inférence linguistique, notamment les 12 milliards de paramètres code-cushman-001.

- Nos travaux sur AI2 montrent également que lorsqu'il est équipé de chaînes de pensée complexes, le code-davinci-002 est actuellement le modèle le plus performant sur des benchmarks mathématiques importants tels que GSM8K.

- Intuitivement, la programmation orientée procédure est très similaire au processus par lequel les humains résolvent des tâches étape par étape, et la programmation orientée objet est similaire au processus par lequel les humains décomposent des tâches complexes en plusieurs tâches simples.

- Toutes les observations ci-dessus sont des corrélations entre le code et la capacité de raisonnement/la chaîne de pensée, mais pas nécessairement la causalité. Cette corrélation est intéressante, mais reste actuellement une question ouverte à étudier. À l’heure actuelle, nous ne disposons pas de preuves très concluantes selon lesquelles le code est à l’origine d’enchaînements de pensées et de raisonnements complexes.

- De plus, un autre sous-produit possible de l'entraînement au code est les dépendances à longue distance, comme l'a souligné Peter Liu : « La prédiction du mot suivant dans une langue est généralement très locale, et le code nécessite généralement des dépendances plus longues pour faire certaines choses comme faire correspondre les supports avant et arrière ou faire référence aux définitions des fonctions à distance. Ce que je voudrais ajouter ici est : en raison de l'héritage de classe dans la programmation orientée objet, le code peut également contribuer à la capacité du modèle à établir des hiérarchies de codage. Nous laissons le test de cette hypothèse à des travaux ultérieurs.

De plus, veuillez faire attention à certaines différences de détails :

- text-davinci-002 et code-davinci-002

- Code-davinci-002 est le modèle de base, text-davinci-002 est le produit des instructions de réglage fin du code-davinci-002 (voir le document d'OpenAI). Il est affiné sur les données suivantes : (1) les instructions annotées par l'homme et les résultats attendus (2) les résultats du modèle sélectionnés par les annotateurs humains ;

- Lorsqu'il y a des exemples en contexte, Code-davinci-002 est meilleur pour l'apprentissage du contexte ; lorsqu'il n'y a pas d'exemples contextuels/zéro échantillon, text-davinci-002 fonctionne mieux lors de l'achèvement d'une tâche sans échantillon. En ce sens, text-davinci-002 est plus conforme aux attentes humaines (puisque rédiger des exemples contextuels pour une tâche peut être fastidieux).

- Il est peu probable qu'OpenAI ait délibérément sacrifié la capacité d'apprentissage contextuel en échange de capacités sans échantillon - la réduction des capacités d'apprentissage contextuel est davantage un effet secondaire de l'apprentissage des instructions. OpenAI appelle cela une taxe d'alignement.

- Modèle 001 (code-cushman-001 et text-davinci-001) vs modèle 002 (code-davinci-002 et text-davinci-002)

- Le modèle 001 est principalement destiné Effectuez des tâches de code pur/texte pur ; le modèle 002 intègre profondément la formation au code et le réglage fin des instructions, le code et le texte peuvent être utilisés.

- Code-davinci-002 est peut-être le premier modèle qui intègre profondément la formation au code et la mise au point des instructions. La preuve est la suivante : code-cushman-001 peut effectuer une inférence mais ne fonctionne pas bien sur du texte brut, text-davinci-001 fonctionne bien sur du texte brut mais n'est pas bon en inférence. code-davinci-002 peut faire les deux en même temps.

3.2 Ces capacités existent-elles déjà après la pré-formation ou sont-elles injectées plus tard grâce à un réglage fin ?

A ce stade, nous avons identifié le rôle clé de la mise au point pédagogique et de l'entraînement au code. Une question importante est de savoir comment analyser plus en détail l’impact de la formation au code et du perfectionnement des instructions ?

Plus précisément : Les trois capacités ci-dessus existent-elles déjà dans le GPT-3 d'origine et ne sont-elles déclenchées/déverrouillées que via des instructions et une formation au code ? Ou ces capacités n'existent-elles pas dans le GPT-3 d'origine, mais ont été injectées via des instructions et une formation au code ?

Si les réponses sont déjà dans le GPT-3 d'origine, alors ces fonctionnalités devraient également être dans l'OPT. Par conséquent, pour reproduire ces capacités, il peut être possible d'ajuster l'OPT directement via des instructions et du code.

Cependant, le code-davinci-002 n'est peut-être pas basé sur le davinci GPT-3 d'origine, mais sur un modèle plus grand que le GPT-3 d'origine. Si tel est le cas, il n'y aura peut-être aucun moyen de le reproduire en ajustant l'OPT.

La communauté des chercheurs doit clarifier davantage quel type de modèle OpenAI a formé comme modèle de base pour le code-davinci-002.

Nous avons les hypothèses et preuves suivantes :

- Le modèle de base du code-davinci-002 n'est peut-être pas le modèle davinci GPT-3 de première génération.

- La première génération de GPT-3 a été formée sur l'ensemble de données C4 2016 - 2019, tandis que l'ensemble de formation code-davinci-002 a été étendu jusqu'en 2021. Il est donc possible que le code-davinci-002 soit entraîné sur la version 2019-2021 de C4.

- Le GPT-3 original avait une fenêtre contextuelle de 2048 mots. La fenêtre contextuelle pour le code-davinci-002 est 8192. La série GPT utilise l'intégration positionnelle absolue. L'extrapolation directe de l'intégration positionnelle absolue sans formation est difficile et nuira sérieusement aux performances du modèle (voir Press et al., 2022). Si le code-davinci-002 est basé sur le GPT-3 d'origine, comment OpenAI étend-il la fenêtre contextuelle ?

- D'un autre côté, que le modèle de base soit le GPT-3 original ou un modèle formé plus tard, la capacité de suivre les instructions et la généralisation du tir zéro peuvent déjà exister dans le modèle de base et être affinées plus tard via les instructions. Déverrouiller (pas injecter).

- Cela est principalement dû au fait que la taille des données d'instruction rapportées dans le document OpenAI n'est que de 77 Ko, soit plusieurs ordres de grandeur de moins que les données de pré-entraînement.

- D'autres articles sur le réglage fin des instructions démontrent en outre le contraste entre la taille de l'ensemble de données et les performances du modèle. Par exemple, dans les travaux de Chung et al (2022), le réglage fin des instructions de Flan-PaLM ne représente que 0,4 % de celui-ci. le calcul de pré-entraînement. De manière générale, les données d'instruction seront nettement inférieures aux données de pré-entraînement.

- Cependant, les capacités de raisonnement complexes du modèle peuvent provenir de l'injection de données de code pendant la phase de pré-formation.

- L'échelle de l'ensemble de données de code est différente du cas de réglage fin des instructions ci-dessus. La quantité de données de code ici est suffisamment importante pour occuper une partie importante des données de formation (par exemple, PaLM possède 8 % des données de formation de code)

- Comme mentionné ci-dessus, le modèle text-davinci-001 avant code- davinci-002 concerne Il n'a pas été affiné sur les données du code, donc sa capacité de raisonnement/chaîne de pensée est très faible. Comme indiqué dans la première version du document sur la chaîne de réflexion, c'est parfois encore pire que code-cushman-. 001 avec un plus petit nombre de paramètres.

- La meilleure façon de différencier les effets de la formation au code et du réglage fin des instructions est probablement de comparer les codes-cushman-001, T5 et FlanT5.

- Parce qu'ils ont des tailles de modèle similaires (11 milliards et 12 milliards) et des ensembles de données de formation similaires (C4), la plus grande différence entre eux est de savoir s'ils ont été formés sur le code / s'ils ont bien suivi les instructions. -réglage.

- Il n'existe pas encore de comparaison de ce type. Nous laissons cela à des recherches futures.

4. text-davinci-003 et ChatGPT, la puissance de l'apprentissage par renforcement à partir de la rétroaction humaine (RLHF)

Au stade actuel (décembre 2022), text-davinci-002, il existe peu de comparaisons statistiques strictes entre text-davinci-003 et ChatGPT, principalement parce que :

- text-davinci-003 et ChatGPT sont sortis depuis moins d'un mois au moment de la rédaction.

- ChatGPT ne peut pas être appelé via l'API OpenAI, il est donc fastidieux de le tester sur des benchmarks standard.

La comparaison entre ces modèles repose donc davantage sur l'expérience collective de la communauté des chercheurs (statistiquement peu rigoureuse). Nous pensons cependant que des comparaisons descriptives préliminaires peuvent encore éclairer les mécanismes du modèle.

Nous remarquons d'abord la comparaison suivante entre text-davinci-002, text-davinci-003 et ChatGPT :

- Les trois modèles sont peaufinés avec des instructions.

- text-davinci-002 est un modèle qui a été affiné avec un réglage d'instructions supervisé.

- text-davinci-003 et ChatGPT sont des réglages d'instructions avec l'apprentissage par renforcement à partir de la rétroaction humaine RLHF. C'est la différence la plus significative entre eux.

Cela signifie que le comportement de la plupart des nouveaux modèles est un artefact de RLHF.

Regardons donc les capacités du déclencheur RLHF :

- Réponse informative : text-davinci-003 prend généralement plus de temps à générer que text-davinci-002. La réponse de ChatGPT est plus longue, de sorte que les utilisateurs doivent explicitement demander « Répondez-moi en une phrase » pour obtenir une réponse plus concise. Il s’agit d’une conséquence directe du RLHF.

- Réponse équitable : ChatGPT donne généralement des réponses très équilibrées aux événements impliquant les intérêts de plusieurs entités, tels que les événements politiques. C'est également un produit de RLHF.

- Rejet des problèmes inappropriés : Il s'agit d'une combinaison de filtres de contenu et des propres capacités du modèle déclenchées par RLHF, où le filtre filtre une partie, puis le modèle rejette une partie.

- Rejeter les questions qui échappent à sa connaissance : Par exemple, rejeter les nouveaux événements survenus après juin 2021 (car il n'a pas été formé sur les données après cela). Il s’agit de la partie la plus étonnante du RLHF, car elle permet au modèle de distinguer implicitement quels problèmes relèvent de sa connaissance et lesquels ne le sont pas.

Il y a deux choses à noter :

- Toutes les capacités sont inhérentes au modèle, non injectées via RLHF. Ce que fait RLHF, c'est déclencher/déverrouiller des capacités émergentes. Cet argument vient principalement de la comparaison de la taille des données : par rapport à la quantité de données pré-entraînées, RLHF consomme beaucoup moins de puissance de calcul/données.

- Le modèle sait ce qu'il ne sait pas non pas en écrivant des règles, mais en le déverrouillant via RLHF. Il s'agit d'une découverte très surprenante car l'objectif initial du RLHF était de faire en sorte que le modèle génère des réponses qui aggravent les attentes humaines, ce qui consistait davantage à ce que le modèle génère des phrases sûres plutôt qu'à lui faire savoir ce qu'il ne savait pas.

Ce qui se passe dans les coulisses pourrait être :

- ChatGPT : sacrifiez la capacité d'apprendre le contexte en échange de la capacité de modéliser l'historique des conversations. Il s'agit d'une observation empirique, car ChatGPT ne semble pas être aussi fortement affecté par la présentation contextuelle que text-davinci-003.

- text-davinci-003 : restaure la capacité d'apprentissage du contexte sacrifiée par text-davinci-002 et améliore la capacité de zéro échantillon. Selon l'article instructGPT, cela vient de l'étape de réglage de l'apprentissage par renforcement mélangée à l'objectif de modélisation du langage (plutôt que du RLHF lui-même).

5. Résumé du processus évolutif de GPT-3.5 au stade actuel

Jusqu'à présent, nous avons soigneusement examiné toutes les capacités apparues le long de l'arbre évolutif. Le tableau suivant résume le chemin évolutif :

.

Nous pouvons conclure :

- La capacité de génération de langage + les connaissances de base du monde + l'apprentissage du contexte proviennent tous de la pré-formation (davinci).

- La capacité de stocker de grandes quantités de connaissances provient de 175 milliards de paramètres.

- La capacité de suivre des instructions et de généraliser à de nouvelles tâches provient de l'augmentation du nombre d'instructions dans l'apprentissage des instructions (Davinci-instruct-beta).

- La capacité à effectuer un raisonnement complexe vient probablement de la formation au code (code-davinci-002).

- La capacité à générer des réponses neutres, objectives, sûres et informatives vient de l'alignement avec les humains. Plus précisément :

- S'il s'agit de la version en apprentissage supervisé, le modèle résultant est text-davinci-002.

- S'il s'agit de la version apprentissage par renforcement (RLHF), le modèle obtenu est text-davinci-003.

- Qu'il soit supervisé ou RLHF, les performances du modèle ne peuvent dépasser le code-davinci-002 dans de nombreuses tâches. Ce phénomène de dégradation des performances dû à l'alignement est appelé taxe d'alignement.

- La capacité de dialogue vient également de RLHF (ChatGPT). Plus précisément, elle sacrifie la capacité d'apprentissage du contexte en échange de :

- Modélisation de l'historique du dialogue.

- Augmentez la quantité d'informations sur la conversation.

- Rejetez les questions qui sortent du cadre de la connaissance du modèle.

6. Ce que GPT-3.5 ne peut pas faire actuellement

Bien que GPT-3.5 soit une étape importante dans la recherche sur le traitement du langage naturel, il n'inclut pas pleinement toutes les propriétés idéales envisagées par de nombreux chercheurs (y compris AI2). Voici quelques propriétés importantes que GPT-3.5 n'a pas :

- Réécrivez les croyances du modèle en temps réel : Quand un modèle exprime une croyance sur quelque chose, si cette croyance est fausse, nous pouvons avoir du mal à la corriger :

- Un exemple que j'ai rencontré récemment était : ChatGPT insiste sur le fait que 3599 est un nombre premier, bien qu'il admet que 3599 = 59 * 61. Voir également cet exemple Reddit du mammifère marin nageant le plus rapidement.

- Cependant, il semble y avoir différents niveaux de force de croyance dans le modèle. Un exemple est que même si je lui dis que Dark Vador (le personnage des films Star Wars) a remporté les élections de 2020, le modèle pensera toujours que l’actuel président des États-Unis est Biden. Mais si je change l’année électorale en 2024, il pense que le président est Dark Vador et qu’il sera le président en 2026.

- Raisonnement formel : La série GPT-3.5 ne peut pas raisonner dans des systèmes formellement rigoureux tels que les mathématiques ou la logique du premier ordre :

- Dans la littérature sur le traitement du langage naturel, le mot "inférence" La définition de est souvent floue. Mais si nous l’examinons du point de vue de l’ambiguïté, par exemple, certaines questions sont (a) très ambiguës et sans raisonnement ; (b) il y a un peu de logique là-dedans, mais cela peut aussi être vague à certains endroits ; c) très rigoureux et ne peut avoir aucune ambiguïté.

- Ensuite, le modèle peut très bien effectuer un raisonnement de type (b) avec ambiguïté. Les exemples sont :

- Générer comment faire du tofu nao. Lorsque vous préparez des choux au tofu, il est acceptable d'être un peu vague sur de nombreuses étapes, par exemple s'il faut les rendre salés ou sucrés. Tant que les étapes globales sont à peu près correctes, le tofu caillé sera comestible.

- Idées pour prouver des théorèmes mathématiques. L'idée de preuve est une solution informelle étape par étape exprimée dans le langage, et la dérivation rigoureuse de chaque étape n'a pas besoin d'être trop spécifique. Les idées de démonstration sont souvent utilisées dans l’enseignement des mathématiques : tant que l’enseignant donne une étape globale à peu près correcte, les élèves peuvent la comprendre à peu près. Ensuite, l'enseignant donne les détails spécifiques de la preuve aux élèves comme devoirs, et les réponses sont omises.

- GPT-3.5 ne peut pas faire d'inférence de type (c) (l'inférence ne peut pas tolérer l'ambiguïté).

- Un exemple est une preuve mathématique stricte, qui exige que les étapes intermédiaires ne puissent pas être sautées, floues ou erronées.

- Mais la question de savoir si ce type de raisonnement strict doit être effectué par des modèles linguistiques ou des systèmes symboliques reste à discuter. Un exemple est qu'au lieu d'essayer de demander à GPT d'effectuer une addition à trois chiffres, appelez simplement Python.

- Récupération depuis Internet : La série GPT-3.5 (temporairement) ne peut pas rechercher directement sur Internet.

- Mais il existe un article WebGPT publié en décembre 2021, qui permet à GPT d'appeler le moteur de recherche. Les capacités de récupération ont donc été testées au sein d'OpenAI.

- Le point qui doit être distingué ici est que les deux capacités importantes mais différentes de GPT-3.5 sont la connaissance et le raisonnement. D'une manière générale, ce serait bien si nous pouvions décharger la partie connaissance vers un système de récupération externe et laisser le modèle de langage se concentrer uniquement sur le raisonnement. Parce que :

- La connaissance interne du modèle est toujours coupée à un moment donné. Les modèles nécessitent toujours les dernières connaissances pour répondre aux dernières questions.

- Rappelons que nous avons évoqué le fait que 175 milliards de paramètres sont fortement utilisés pour stocker les connaissances. Si nous pouvions décharger les connaissances en dehors du modèle, les paramètres du modèle pourraient être tellement réduits qu'à terme, il pourrait même fonctionner sur les téléphones mobiles (idée folle, mais ChatGPT est assez de science-fiction, qui sait ce que l'avenir nous réserve).

7. Conclusion

Dans cet article de blog, nous avons soigneusement examiné l'éventail des capacités de la série GPT-3.5 et retracé les sources de toutes leurs capacités émergentes.

Le modèle GPT-3 de première génération obtient des capacités génératives, des connaissances du monde et un apprentissage en contexte grâce à une pré-formation. Ensuite, grâce à la branche modèle de réglage des instructions, nous avons acquis la capacité de suivre des instructions et de généraliser à des tâches invisibles. Le modèle de branche formé par le code acquiert la capacité de comprendre le code. En tant que sous-produit de la formation du code, le modèle acquiert également potentiellement la capacité d'effectuer un raisonnement complexe.

En combinant ces deux branches, code-davinci-002 semble être le modèle GPT-3.5 le plus puissant avec toutes les grandes capacités. Ensuite, grâce au réglage supervisé des instructions et au RLHF, la capacité du modèle est sacrifiée en échange de l’alignement humain, c’est-à-dire de la taxe d’alignement. RLHF permet au modèle de générer des réponses plus informatives et impartiales tout en rejetant les questions en dehors de sa plage de connaissances.

Nous espérons que cet article pourra aider à fournir une image claire de l'évaluation GPT et déclencher des discussions sur les modèles de langage, le réglage des instructions et le réglage du code. Plus important encore, nous espérons que cet article pourra servir de feuille de route pour reproduire GPT-3.5 au sein de la communauté open source.

FAQ

- Les affirmations contenues dans cet article ressemblent-elles davantage à une hypothèse ou à une conclusion ?

- La capacité à faire un raisonnement complexe vient de la formation au code est une hypothèse que nous avons tendance à croire.

- La capacité de généraliser à des tâches invisibles vient de l'apprentissage d'instructions à grande échelle est la conclusion d'au moins 4 articles.

- On suppose que GPT-3.5 provient d'autres grands modèles de base, et non du paramètre GPT-3 de 175 milliards.

- Débloquer ces capacités grâce au réglage des instructions, qu'il s'agisse d'un apprentissage supervisé ou d'un apprentissage par renforcement, plutôt que de les injecter, est une hypothèse forte, si forte qu'on n'ose pas y croire. Principalement parce que la quantité de données de réglage des instructions est inférieure de plusieurs ordres de grandeur à la quantité de données de pré-entraînement.

- Conclusion = Beaucoup de preuves pour étayer la validité de ces affirmations ; Hypothèse = Preuves positives mais pas assez solides ; Supposition éclairée = Aucune preuve tangible, mais certains facteurs pointeraient dans cette direction

- Pourquoi sinon Modèles (comme OPT et BLOOM) pas si puissant ?

- OPT est probablement dû au fait que le processus de formation est trop instable. La situation de

- BLOOM est inconnue.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : Création d'un chatbot de service client intelligent Introduction : À l'ère de l'information d'aujourd'hui, les systèmes de service client intelligents sont devenus un outil de communication important entre les entreprises et les clients. Afin d'offrir une meilleure expérience de service client, de nombreuses entreprises ont commencé à se tourner vers les chatbots pour effectuer des tâches telles que la consultation des clients et la réponse aux questions. Dans cet article, nous présenterons comment utiliser le puissant modèle ChatGPT et le langage Python d'OpenAI pour créer un chatbot de service client intelligent afin d'améliorer

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Dans cet article, nous présenterons comment développer des chatbots intelligents à l'aide de ChatGPT et Java, et fournirons quelques exemples de code spécifiques. ChatGPT est la dernière version du Generative Pre-training Transformer développé par OpenAI, une technologie d'intelligence artificielle basée sur un réseau neuronal qui peut comprendre le langage naturel et générer du texte de type humain. En utilisant ChatGPT, nous pouvons facilement créer des discussions adaptatives

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions des utilisateurs Introduction : À l'ère numérique d'aujourd'hui, la technologie de l'intelligence artificielle est progressivement devenue un élément indispensable dans divers domaines. Parmi eux, le développement de la technologie de traitement du langage naturel (Natural Language Processing, NLP) permet aux machines de comprendre et de traiter le langage humain. ChatGPT (Chat-GeneratingPretrainedTransformer) est une sorte de

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

L’Open AI fait enfin son incursion dans la recherche. La société de San Francisco a récemment annoncé un nouvel outil d'IA doté de capacités de recherche. Rapporté pour la première fois par The Information en février de cette année, le nouvel outil s'appelle à juste titre SearchGPT et propose un c