Récemment, le Stanford HAI Institute dirigé par Li Feifei a publié un rapport prospectif sur « l'IA générative ».

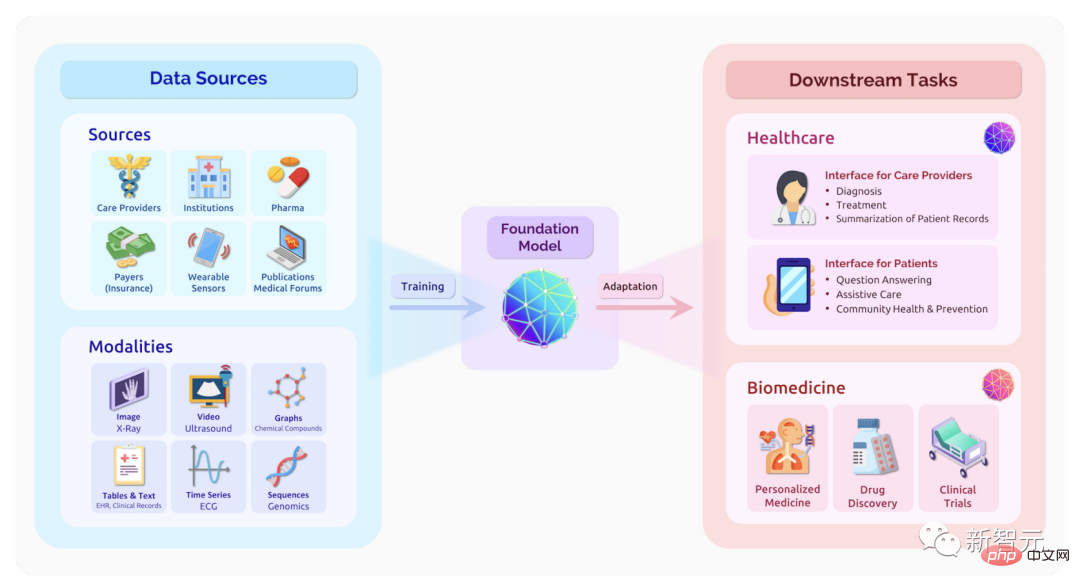

Le rapport souligne que la plupart des intelligences artificielles génératives actuelles sont pilotées par des modèles de base.

Les opportunités que ces modèles apportent à nos vies, à nos communautés et à notre société sont énormes, tout comme les risques.

D'une part, l'IA générative peut rendre les humains plus productifs et créatifs. D’un autre côté, ils peuvent amplifier les préjugés sociaux et même miner notre confiance dans l’information.

Nous pensons que la collaboration entre les disciplines est essentielle pour garantir que ces technologies profitent à tous. Voici ce que les dirigeants des domaines de la médecine, des sciences, de l’ingénierie, des sciences humaines et sociales ont à dire sur l’impact de « l’intelligence artificielle générative » sur leurs domaines et sur notre monde.

Dans cet article, nous avons sélectionné les idées de Li Feifei et Percy Liang sur l'IA générative actuelle.

Pour le rapport d'opinion complet, veuillez consulter :

https://hai.stanford.edu/generative-ai-perspectives-stanford-hai

Li Feifei, co-directeur de Stanford HAI, a écrit : "Le grand tournant de l'intelligence artificielle."

Le cerveau humain peut reconnaître tous les modèles du monde et construire des modèles ou générer des concepts basés sur eux. Le rêve de générations de scientifiques en intelligence artificielle est de donner aux machines cette capacité générative, et ils travaillent dur depuis longtemps dans le domaine du développement d’algorithmes de modèles génératifs.

En 1966, des chercheurs du MIT ont lancé le « Summer Vision Project » (Summer Vision Project), visant à utiliser la technologie pour construire efficacement une partie importante du système visuel. Ce fut le début de la recherche dans le domaine de la vision par ordinateur et de la génération d'images.

Récemment, grâce à la relation étroite entre le deep learning et le big data, les gens semblent avoir atteint un point d'inflexion important, qui est sur le point de donner aux machines la capacité de générer du langage, des images, du son, etc.

Bien que l'inspiration de la vision par ordinateur soit de construire une IA capable de voir ce que les humains peuvent voir, l'objectif de cette discipline va bien au-delà de cela. L'IA qui sera construite dans le futur devrait voir ce que les humains ne peuvent pas voir. voir. à quelque chose.

Comment utiliser l'intelligence artificielle générative pour améliorer la vision humaine ?

Par exemple, les décès causés par des erreurs médicales sont un problème préoccupant aux États-Unis. L’IA générative peut aider les prestataires de soins de santé à détecter les problèmes potentiels.

Si des erreurs se produisent dans des situations rares, l'IA générative peut créer des versions simulées de données similaires pour former davantage les modèles d'IA ou dispenser une formation au personnel médical.

Avant de commencer à développer un nouvel outil génératif, vous devez vous concentrer sur ce que les gens souhaitent tirer de cet outil.

Dans un récent projet visant à comparer les tâches robotiques, l'équipe de recherche a mené une étude à grande échelle sur les utilisateurs avant de commencer les travaux, demandant aux gens dans quelle mesure ils bénéficieraient si certaines tâches étaient exécutées par des robots. les gens deviennent le centre du projet.

Afin de saisir les opportunités significatives créées par l'intelligence artificielle générative, les risques associés doivent également être raisonnablement évalués.

Joy Buolamwini a mené une étude intitulée "Gender Shading" et a découvert que l'IA a souvent du mal à identifier les femmes et les personnes de couleur. Des préjugés similaires à l’égard des groupes sous-représentés continueront d’apparaître dans l’IA générative.

C'est également une capacité très importante de juger si une image est générée à l'aide de l'IA. La société humaine est bâtie sur la confiance dans la citoyenneté, et sans cette capacité, notre sentiment de confiance sera réduit.

Les progrès dans les capacités générées par les machines sont extrêmement passionnants, tout comme le potentiel de l'IA à voir des choses que les humains ne peuvent pas voir.

Cependant, nous devons être attentifs au fait que ces capacités peuvent perturber notre vie quotidienne, notre environnement et miner notre rôle de citoyens du monde.

Percy Liang, directeur de l'Institut pour l'intelligence artificielle centrée sur l'humain à l'Université de Stanford et professeur agrégé d'informatique, a publié un article "La nouvelle ère cambrienne : l'enthousiasme et l'anxiété de la science" Anxiété "

Dans l'histoire de l'humanité, il a toujours été difficile de créer de nouvelles choses, et cette capacité est presque uniquement possédée par des experts.

Mais avec les progrès récents des modèles de base, « l’explosion cambrienne » de l’intelligence artificielle est en train de se produire, et l’intelligence artificielle sera capable de créer n’importe quoi, des vidéos aux protéines en passant par les codes.

Cette capacité abaisse le seuil de création, mais elle nous prive également de la capacité de reconnaître la réalité.

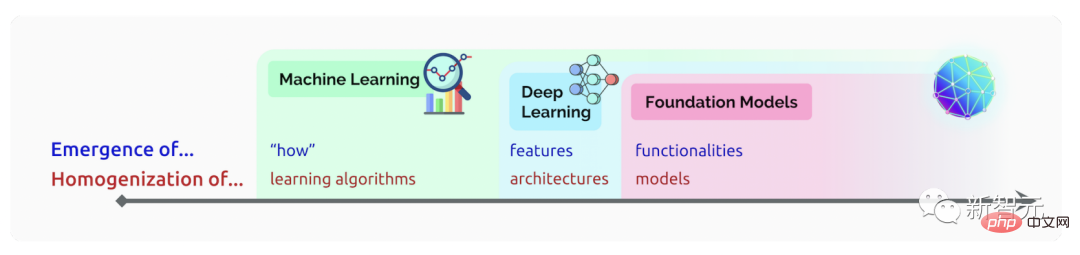

Les modèles de base basés sur des réseaux de neurones profonds et l'apprentissage auto-supervisé existent depuis des décennies. Cependant, récemment, le volume considérable de données sur lesquelles ces modèles peuvent être formés a conduit à des progrès rapides dans les capacités des modèles.

Un article publié en 2021 détaille les opportunités et les risques du modèle sous-jacent. Ces capacités émergentes deviendront une « source d'enthousiasme pour la communauté scientifique » et peuvent également entraîner des « conséquences inattendues ».

La question de l'homogénéité est également abordée dans le document. Les mêmes quelques modèles sont réutilisés comme base pour de nombreuses applications, permettant aux chercheurs de se concentrer sur un petit ensemble de modèles. Mais la centralisation fait également de ces modèles un point de défaillance unique, avec des dommages potentiels affectant de nombreuses applications en aval.

Il est également très important de comparer le modèle de base afin que les chercheurs puissent mieux comprendre ses capacités et ses lacunes et formuler des stratégies de développement plus raisonnables.

HELM (Holistic Évaluation of Language Models) a été développé à cet effet. HELM évalue les performances de plus de 30 modèles de langage bien connus dans une série de scénarios en utilisant divers indicateurs tels que l'exactitude, la robustesse et l'équité.

De nouveaux modèles, de nouveaux scénarios d'application et de nouveaux indicateurs d'évaluation continueront d'apparaître. Nous invitons chacun à contribuer au développement de HELM.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment démarrer le service MySQL

Comment démarrer le service MySQL

Comment ignorer la connexion réseau lors de l'installation de Win11

Comment ignorer la connexion réseau lors de l'installation de Win11

Comment résoudre le problème d'occupation du port phpstudy

Comment résoudre le problème d'occupation du port phpstudy

Comment réparer le système Win7 s'il est endommagé et ne peut pas être démarré

Comment réparer le système Win7 s'il est endommagé et ne peut pas être démarré

serveur xen

serveur xen

Code Red est-il un virus informatique ?

Code Red est-il un virus informatique ?

stackoverflowatline1

stackoverflowatline1

Comment annuler le compte Douyin sur Douyin

Comment annuler le compte Douyin sur Douyin

Quelles sont les différences entre les numéros de version d'Eclipse ?

Quelles sont les différences entre les numéros de version d'Eclipse ?