Périphériques technologiques

Périphériques technologiques

IA

IA

La « version améliorée » du grand modèle OPT-IML de Meta de 100 milliards de paramètres est ici, et le modèle complet et le code sont publiés !

La « version améliorée » du grand modèle OPT-IML de Meta de 100 milliards de paramètres est ici, et le modèle complet et le code sont publiés !

La « version améliorée » du grand modèle OPT-IML de Meta de 100 milliards de paramètres est ici, et le modèle complet et le code sont publiés !

En mai de cette année, MetaAI a officiellement annoncé la sortie du modèle ultra-large OPT-175B basé sur 175 milliards de paramètres, qui est également ouvert gratuitement à toutes les communautés.

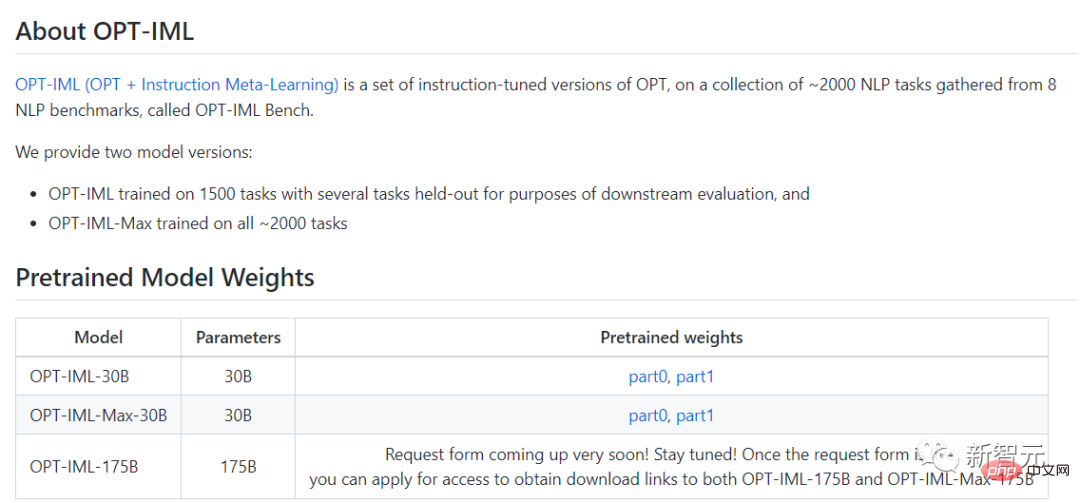

Le 22 décembre, une version mise à jour du modèle, OPT-IML (Open Pre-trained Transformer), a été officiellement lancée. Meta a déclaré qu'il était "affiné pour 2 000 tâches de langage et contenait 175 milliards de paramètres". sera également utilisé gratuitement à des fins de recherche non commerciale.

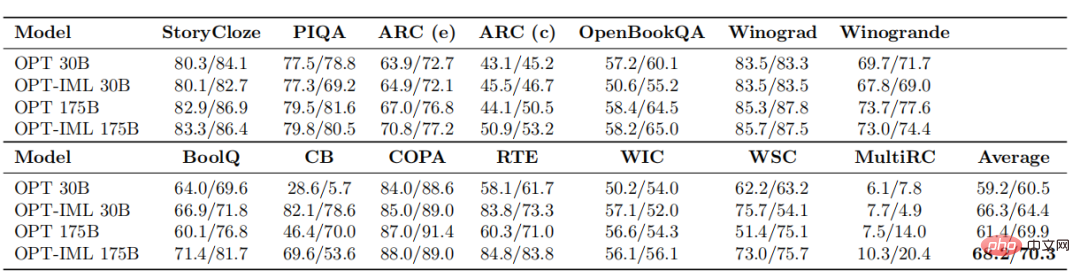

Quelles sont les performances de cet OPT-IML mis à jour ? Jetons un coup d'œil aux deux photos.

Cette fois, OPT-IML a créé deux tailles de modèle, 30B et 175B.

Par rapport à l'ancien modèle OPT, OPT-IML surpasse l'OPT en moyenne dans 14 tâches d'évaluation PNL standard.

Les deux tailles de modèle sont respectivement 7 %~ meilleures pour la tâche d'apprentissage sans tir et 4 %~ et 0,4 %~ meilleures pour la tâche d'apprentissage à 32 tirs.

Dans cette étude, les chercheurs décrivent comment l'augmentation de la taille du modèle et du benchmark affecte l'impact des décisions de réglage des instructions sur la performance des tâches en aval.

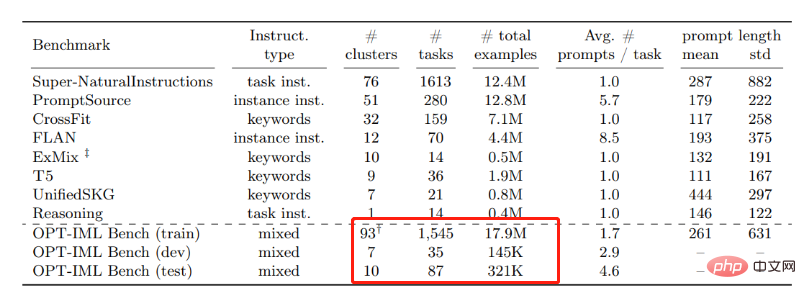

Pour cela, ils ont développé OPT-IML Bench, un benchmark de méta-apprentissage pédagogique (IML) assez volumineux contenant 2000 tâches PNL réparties en catégories de tâches basées sur huit benchmarks existants.

Pour former les OPT-IML 30B et 175B, les chercheurs ont d'abord fourni un aperçu des décisions de réglage des instructions appliquées à l'OPT-30B du point de vue de ce cadre.

Sur quatre benchmarks d'évaluation (PromptSource, FLAN, Super-NaturalInstructions et UnifiedSKG) avec différentes cibles et formats d'entrée, OPT-IML démontre les trois compétences de généralisation à deux échelles.

Non seulement il surpasse considérablement OPT dans tous les benchmarks, mais il surpasse également les modèles existants optimisés pour ce benchmark spécifique d'une manière très compétitive.

De plus, OPT-IML est open source et le lien Github est également publié ci-dessous~

Lien Github : https://github.com/facebookresearch/metaseq/tree/main /projects/ OPT-IML

Ensuite, découvrons OPT-IML à travers le document.

Lien papier : https://github.com/facebookresearch/metaseq/blob/main/projects/OPT-IML/optimal_paper_v1.pdf

Méthodes de recherche

Instructions pour les grands modèles de langage Le réglage fin est devenu une méthode efficace pour améliorer ses capacités de généralisation à tir nul et à quelques tirs. Dans cette étude, les chercheurs de Meta ont apporté trois ajouts importants à l’affinement de l’enseignement.

Tout d'abord, ils ont compilé un benchmark de réglage fin des instructions à grande échelle contenant 2 000 tâches PNL provenant de huit collections d'ensembles de données, classées par type de tâche.

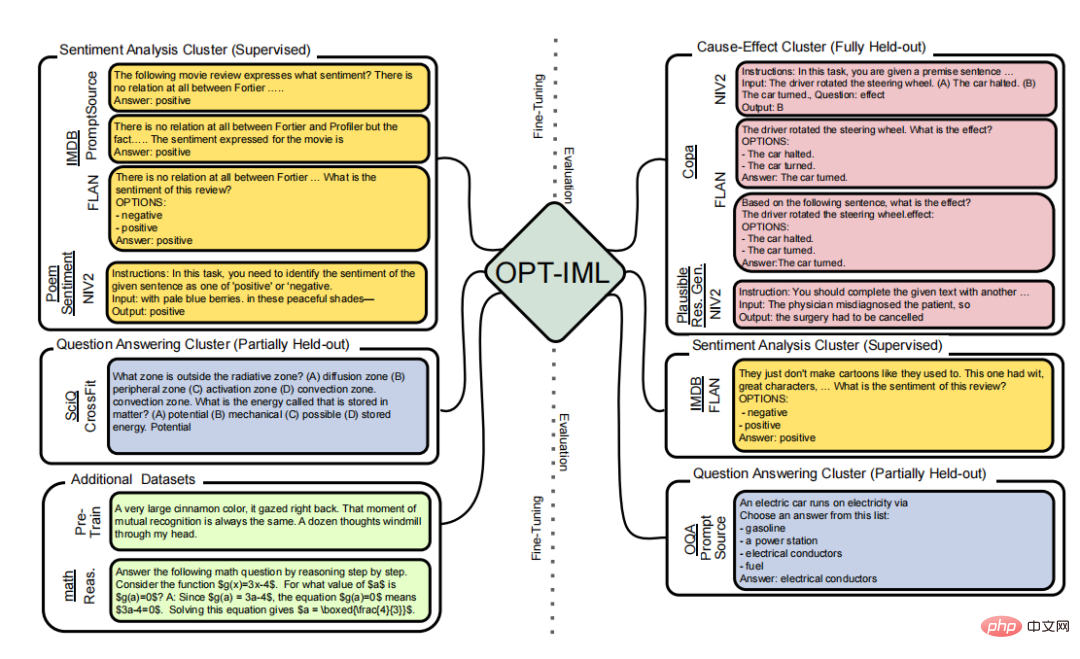

Les chercheurs construisent de manière sélective des divisions d'évaluation sur ce benchmark pour tester trois types différents de capacités de généralisation de modèles :

Comprend les tâches des catégories entièrement suspendues, les tâches suspendues des types vus et les instances suspendues des tâches vues).

Le réglage fin des instructions

Le réglage fin des modèles pour les rendre cohérents avec les instructions de conformité est l'une des directions de recherche actuelles en apprentissage automatique.

Il existe deux méthodes pour affiner les commandes. L’un se concentre sur le réglage fin des modèles pour une variété de tâches à l’aide d’instructions et de commentaires annotés par l’homme ; l’autre se concentre sur l’ajout d’instructions via des annotations ou automatiquement à des références et des ensembles de données accessibles au public.

Dans cette étude, les membres de Meta AI se sont concentrés sur la deuxième technique et ont compilé un certain nombre d'ensembles de données accessibles au public contenant des méthodes pour améliorer l'OPT.

Au cours de la recherche, les membres de Meta ont proposé une méthode de mise à l'échelle similaire utilisant 1836 tâches issues de quatre benchmarks. Enfin, tout en ajustant l'ensemble du test pour repousser les limites de performances de références externes difficiles telles que MMLU et Big-Bench Hard (BBH), les chercheurs décrivent les poids de diverses stratégies de réglage des instructions qui peuvent avoir un impact sur les performances en aval.

Apprentissage multitâche

L'apprentissage multitâche est une expression du réglage fin basé sur l'instruction (MTL).

MTL est un paradigme populaire qui peut améliorer les performances de généralisation d'une tâche lorsqu'il est combiné avec des fonctions similaires partageant des paramètres ou des représentations comparables.

Ces dernières années, MTL a été appliqué à de nombreux scénarios de PNL, se concentrant principalement sur l'amélioration des performances des tâches de formation ou de nouveaux domaines en exploitant les signaux des activités pertinentes.

En revanche, le réglage fin basé sur les instructions nous aide à améliorer les performances de généralisation sur des problèmes jamais vus auparavant. Pour ce faire, il demande de combiner toutes les tâches en un concept et de les entraîner ensemble en attribuant les poids du modèle à toutes les tâches.

Qu'est-ce que l'OPT ?

Les modèles linguistiques à grande échelle, les systèmes de traitement du langage naturel avec plus de 100 milliards de paramètres, ont transformé la recherche en PNL et en IA au cours des dernières années.

Formés sur un large éventail de textes divers, ces modèles ont démontré de nouvelles capacités surprenantes pour générer du texte créatif, résoudre des problèmes mathématiques de base, répondre à des questions de compréhension écrite, et bien plus encore.

Bien que dans certains cas, le public puisse interagir avec ces modèles via des API payantes, l'accès complet à la recherche est encore limité à une poignée de laboratoires disposant de ressources suffisantes.

Cet accès restreint limite la capacité des chercheurs à comprendre comment et pourquoi ces grands modèles de langage fonctionnent, ce qui entrave les progrès vers l'amélioration de leur robustesse et l'atténuation des problèmes connus tels que les biais.

Dans le cadre de son engagement en faveur de la science ouverte, Meta AI a publié Open Pretrained Transformer (OPT-175B) en mai de cette année, un modèle avec 175 milliards de paramètres formés sur des ensembles de données publics. En partageant ce modèle, Meta AI espère impliquer le monde. communauté plus large dans la compréhension des techniques fondamentales autour des grands modèles.

En termes simples, Meta ouvre au public l'accès aux modèles de langage à grande échelle utilisés dans la recherche sur l'intelligence artificielle, réalisant ainsi la démocratisation de l'intelligence artificielle dans la recherche sur des modèles à grande échelle.

Comparaison avec l'ancienne version

Selon la version IML désormais publiée par Meta, elle a été affinée et fonctionne mieux sur les tâches en langage naturel que l'ancienne version d'OPT.

Les tâches linguistiques typiques comprennent la réponse aux questions, la synthèse de texte et la traduction.

Pour la mise au point, les chercheurs ont utilisé environ 2 000 tâches en langage naturel. Les tâches sont réparties en huit benchmarks NLP (OPT-IML Bench), également fournis par les chercheurs.

En moyenne, en prenant les modèles 30B et 175B comme exemples, OPT-IML améliore la précision d'apprentissage zéro-shot d'environ 6 à 7 % par rapport à OPT. En 32 époques, le modèle avec 30 milliards de paramètres a montré une amélioration significative de la précision, et le modèle avec 175 milliards de paramètres a montré une légère amélioration.

Après comparaison, l'équipe Meta a constaté que les performances de l'OPT-IML sont meilleures que celles de l'OPT sur tous les benchmarks et sont plus compétitives que les autres modèles basés sur le réglage fin des instructions en termes de tir zéro et de quelques tirs. précision d’apprentissage.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Tutoriel sur la façon de résoudre le problème de l'impossibilité d'accéder à Internet après la mise à niveau du système Win10

Mar 27, 2024 pm 02:26 PM

Tutoriel sur la façon de résoudre le problème de l'impossibilité d'accéder à Internet après la mise à niveau du système Win10

Mar 27, 2024 pm 02:26 PM

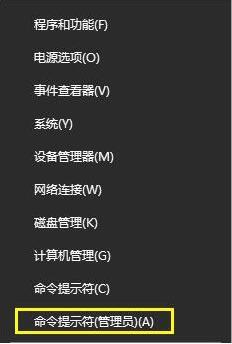

1. Utilisez la touche de raccourci win+x pour ouvrir le menu et sélectionnez [Invite de commandes (administrateur) (A)], comme indiqué ci-dessous : 2. Après être entré dans l'interface d'invite de commande, entrez la commande [ipconfig/flushdns] et appuyez sur Entrée. , comme le montre la figure ci-dessous : 3. Entrez ensuite la commande [netshwinsockresetcatalog] et appuyez sur Entrée, comme le montre la figure ci-dessous : 4. Entrez enfin la commande [netshintipreset] et appuyez sur Entrée, redémarrez l'ordinateur et vous pourrez accéder à Internet. , comme le montre la figure ci-dessous :

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

Xiaoyi est devenu un agent intelligent ! L'intelligence native HarmonyOS NEXT Hongmeng ouvre une nouvelle ère de l'IA

Jun 22, 2024 am 01:56 AM

Xiaoyi est devenu un agent intelligent ! L'intelligence native HarmonyOS NEXT Hongmeng ouvre une nouvelle ère de l'IA

Jun 22, 2024 am 01:56 AM

Le 21 juin, la Huawei Developer Conference 2024 (HDC2024) s'est à nouveau réunie au lac Songshan, à Dongguan. Lors de cette conférence, la chose la plus frappante est que HarmonyOSNEXT lance officiellement la version bêta pour les développeurs et les utilisateurs pionniers, et démontre de manière exhaustive les trois fonctionnalités innovantes « bouleversantes » d'HarmonyOSNEXT dans tous les scénarios, l'intelligence native et la sécurité native. Intelligence native HarmonyOSNEXT : ouvrir une nouvelle ère de l'IA Après avoir abandonné le framework Android, HarmonyOSNEXT est devenu un système d'exploitation véritablement indépendant d'Android et d'iOS, ce que l'on peut qualifier de renaissance sans précédent. Parmi ses nombreuses nouvelles fonctionnalités, l’intelligence native est sans aucun doute la nouvelle fonctionnalité qui peut le mieux apporter aux utilisateurs des sensations intuitives et des améliorations d’expérience.