Périphériques technologiques

Périphériques technologiques

IA

IA

ConvNeXt V2 est là, utilisant uniquement l'architecture de convolution la plus simple, les performances ne sont pas inférieures à celles de Transformer

ConvNeXt V2 est là, utilisant uniquement l'architecture de convolution la plus simple, les performances ne sont pas inférieures à celles de Transformer

ConvNeXt V2 est là, utilisant uniquement l'architecture de convolution la plus simple, les performances ne sont pas inférieures à celles de Transformer

Après des décennies de recherche fondamentale, le domaine de la reconnaissance visuelle a inauguré une nouvelle ère d'apprentissage des représentations visuelles à grande échelle. Les modèles de vision pré-entraînés à grande échelle sont devenus un outil essentiel pour l’apprentissage des fonctionnalités et les applications de vision. Les performances d'un système d'apprentissage de représentation visuelle sont grandement affectées par trois facteurs principaux : l'architecture du réseau neuronal du modèle, la méthode utilisée pour entraîner le réseau et les données d'entraînement. Les améliorations de chaque facteur contribuent à l’amélioration des performances globales du modèle.

L'innovation dans la conception d'architecture de réseaux neuronaux a toujours joué un rôle important dans le domaine de l'apprentissage des représentations. L'architecture de réseau neuronal convolutif (ConvNet) a eu un impact significatif sur la recherche en vision par ordinateur, permettant l'utilisation de méthodes universelles d'apprentissage de fonctionnalités dans diverses tâches de reconnaissance visuelle sans recourir à l'ingénierie de fonctionnalités mise en œuvre manuellement. Ces dernières années, l’architecture Transformer, initialement développée pour le traitement du langage naturel, est également devenue largement utilisée dans d’autres domaines de l’apprentissage profond en raison de son adéquation avec des modèles et des ensembles de données de différentes tailles.

L'émergence de l'architecture ConvNeXt modernise le ConvNet traditionnel, prouvant que les modèles convolutionnels purs peuvent également s'adapter aux changements de taille du modèle et de l'ensemble de données. Cependant, la manière la plus courante d’explorer l’espace de conception des architectures de réseaux neuronaux reste de comparer les performances de l’apprentissage supervisé sur ImageNet.

Une autre idée est de déplacer l'accent de l'apprentissage par représentation visuelle de l'apprentissage supervisé étiqueté vers la pré-formation auto-supervisée. Les algorithmes auto-supervisés ont introduit la modélisation du langage masqué dans le champ de vision et sont rapidement devenus une méthode populaire pour l’apprentissage des représentations visuelles. Cependant, l’apprentissage auto-supervisé utilise généralement une architecture conçue pour l’apprentissage supervisé et suppose que l’architecture est fixe. Par exemple, Masked Autoencoder (MAE) utilise une architecture de transformateur visuel.

Une solution consiste à combiner ces architectures avec des cadres d'apprentissage auto-supervisés, mais cela se heurtera à des problèmes spécifiques. Par exemple, le problème suivant se pose lors de la combinaison de ConvNeXt avec MAE : MAE a une conception d'encodeur-décodeur spécifique optimisée pour les capacités de traitement de séquence du transformateur, ce qui permet à l'encodeur à forte intensité de calcul de se concentrer sur les patchs visibles, réduisant ainsi la pré-formation. frais. Mais cette conception peut être incompatible avec le ConvNet standard, qui utilise des fenêtres coulissantes denses. De plus, sans considérer la relation entre l’architecture et les objectifs de formation, il n’est pas clair si des performances optimales peuvent être atteintes. En fait, les recherches existantes montrent qu'il est difficile de former ConvNet avec un apprentissage auto-supervisé basé sur des masques, et des preuves expérimentales montrent que Transformer et ConvNet peuvent diverger dans l'apprentissage des fonctionnalités, ce qui affectera la qualité de la représentation finale.

À cette fin, des chercheurs de KAIST, Meta et de l'Université de New York (dont Liu Zhuang, premier auteur de ConvNeXt, et Xie Saining, premier auteur de ResNeXt) ont proposé de concevoir conjointement l'architecture du réseau et l'auto-encodeur masqué sous le même Le but de ceci est de permettre à l'apprentissage auto-supervisé basé sur Mask d'être appliqué aux modèles ConvNeXt et d'obtenir des résultats comparables à ceux des transformateurs.

Adresse papier : https://arxiv.org/pdf/2301.00808v1.pdf

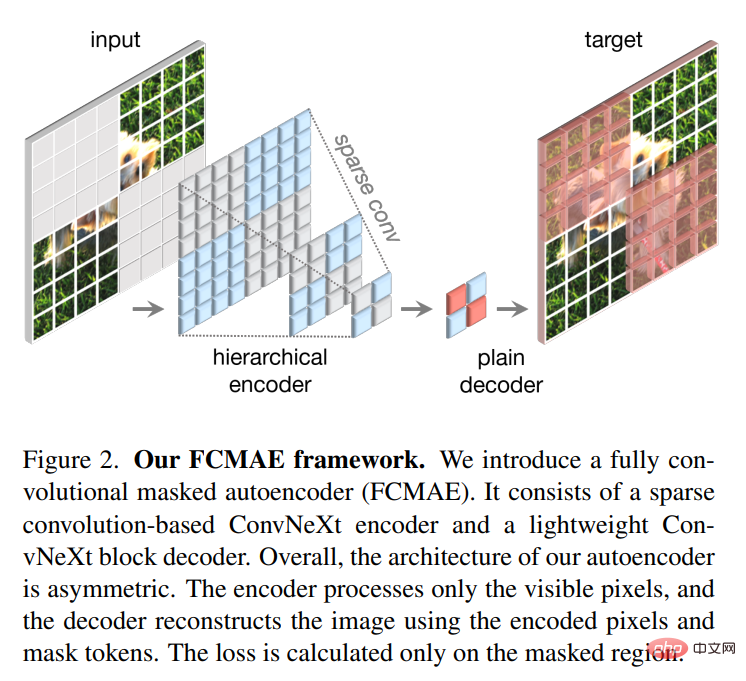

Lors de la conception d'un auto-encodeur masqué, cette étude traite l'entrée avec un masque comme un ensemble de patchs clairsemés , et une convolution clairsemée est utilisée pour traiter les parties visibles. L'idée a été inspirée par l'utilisation de convolutions clairsemées lors du traitement de nuages de points 3D à grande échelle. Plus précisément, cette étude propose d'implémenter ConvNeXt avec des convolutions clairsemées, puis, lors du réglage fin, les poids peuvent être reconvertis en couches de réseau denses standard sans traitement spécial. Pour améliorer encore l'efficacité de la pré-formation, cette étude remplace le décodeur de transformateur par un seul ConvNeXt, rendant l'ensemble de la conception entièrement convolutionnelle. Les chercheurs ont observé qu'après l'ajout de ces changements : les fonctionnalités apprises étaient utiles et amélioraient les résultats de base, mais les performances affinées étaient toujours inférieures à celles du modèle basé sur un transformateur.

Ensuite, l'étude a analysé l'espace de fonctionnalités de ConvNeXt avec différentes configurations de formation. Lors de la formation de ConvNeXt directement sur des entrées masquées, les chercheurs ont découvert des problèmes potentiels d'effondrement des fonctionnalités dans la couche MLP. Afin de résoudre ce problème, cette étude propose d'ajouter une couche de normalisation de réponse globale (couche de normalisation de réponse globale) pour améliorer la compétition de fonctionnalités entre les canaux. Cette amélioration est plus efficace lorsque le modèle est pré-entraîné à l'aide d'un encodeur automatique masqué, ce qui suggère que la réutilisation de conceptions d'architecture fixe issues de l'apprentissage supervisé n'est peut-être pas la meilleure approche.

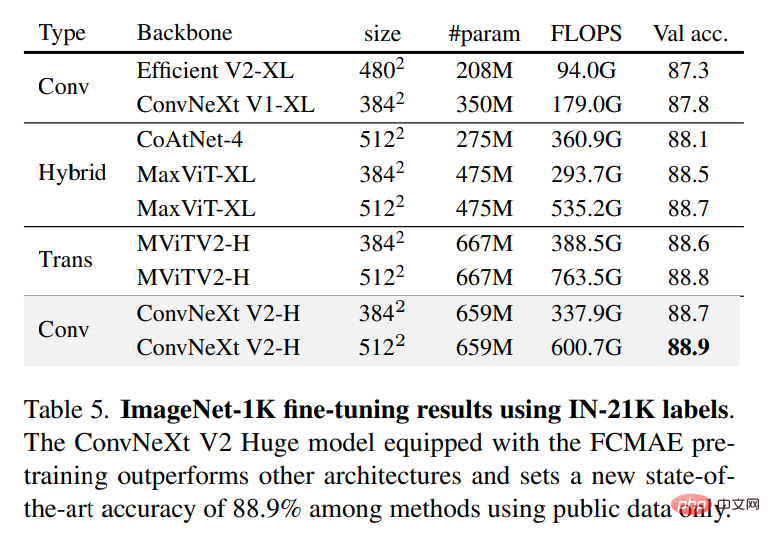

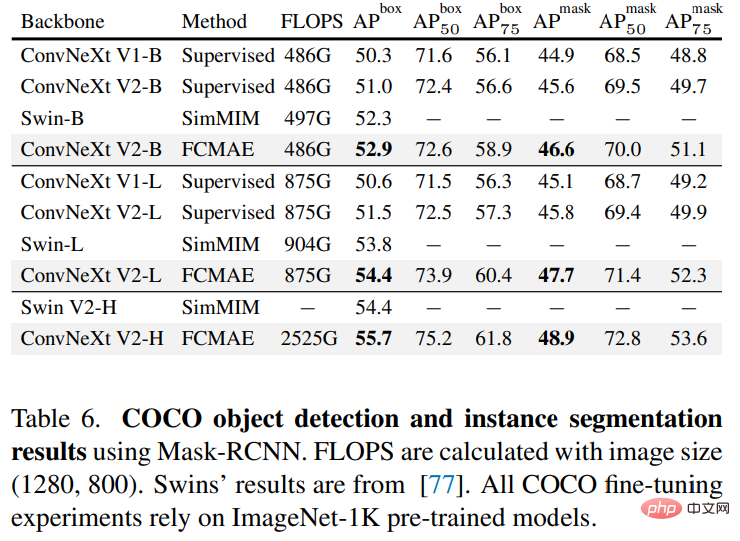

Sur la base des améliorations ci-dessus, cette étude propose ConvNeXt V2, qui montre de meilleures performances lorsqu'il est combiné avec des auto-encodeurs masqués. Dans le même temps, les chercheurs ont découvert que ConvNeXt V2 présentait des améliorations significatives en termes de performances par rapport à ConvNet pur sur diverses tâches en aval, notamment les tâches de classification sur ImageNet, la détection de cibles sur COCO et la segmentation sémantique sur ADE20K. La méthode proposée dans cette étude est conceptuellement simple et est basé sur un mode de fonctionnement à convolution complète. Le signal d'apprentissage est généré en masquant aléatoirement l'entrée visuelle d'origine avec un rapport de masque élevé, puis en laissant le modèle prédire les parties manquantes en fonction du contexte restant. Le cadre global est présenté dans la figure ci-dessous. Le framework

se compose d'un encodeur ConvNeXt basé sur une convolution clairsemée et d'un décodeur ConvNeXt léger, où la structure de l'auto-encodeur est asymétrique. L'encodeur traite uniquement les pixels visibles, tandis que le décodeur utilise des pixels codés et des jetons de masque pour reconstruire l'image. Dans le même temps, la perte est calculée uniquement dans la zone masquée.

se compose d'un encodeur ConvNeXt basé sur une convolution clairsemée et d'un décodeur ConvNeXt léger, où la structure de l'auto-encodeur est asymétrique. L'encodeur traite uniquement les pixels visibles, tandis que le décodeur utilise des pixels codés et des jetons de masque pour reconstruire l'image. Dans le même temps, la perte est calculée uniquement dans la zone masquée.

Normalisation de la réponse globale

Il existe de nombreux mécanismes dans le cerveau qui favorisent la diversité neuronale. Par exemple, l’inhibition latérale peut contribuer à améliorer la réponse des neurones activés, en augmentant le contraste et la sélectivité des neurones individuels aux stimuli tout en augmentant la diversité des réponses de populations neuronales entières. En apprentissage profond, cette forme d’inhibition latérale peut être obtenue grâce à la normalisation de la réponse. Cette étude introduit une nouvelle couche de normalisation de réponse appelée normalisation de réponse globale (GRN), qui vise à augmenter le contraste et la sélectivité entre les canaux. L'unité GRN comprend trois étapes : 1) l'agrégation globale des fonctionnalités, 2) la normalisation des fonctionnalités et 3) l'étalonnage des fonctionnalités. Comme le montre la figure ci-dessous, les couches GRN peuvent être fusionnées dans le bloc ConvNeXt d'origine.

Les chercheurs ont découvert, sur la base d'expériences, que lors de l'application de GRN, LayerScale n'est pas nécessaire et peut être supprimé. En tirant parti de cette nouvelle conception de bloc, l'étude a créé une variété de modèles avec des efficacités et des capacités variables, appelés famille de modèles ConvNeXt V2, allant du léger (Atto) au plus gourmand en calcul (Huge).

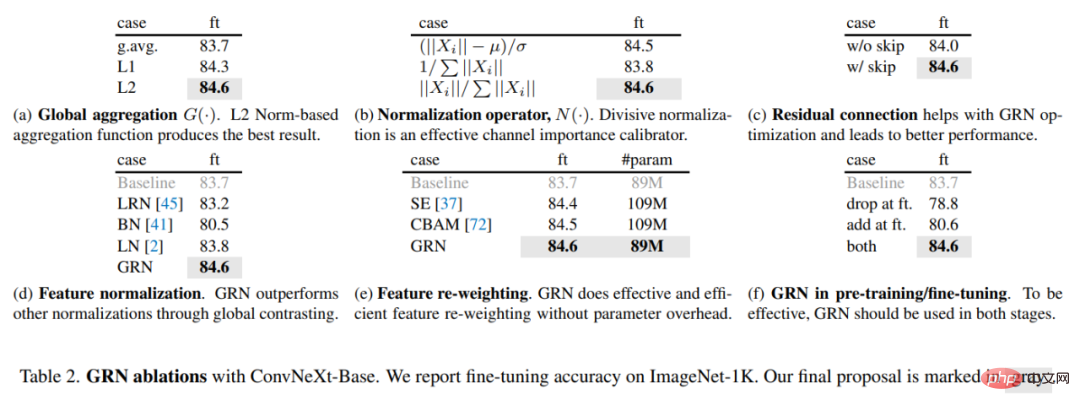

Pour évaluer le rôle de GRN, cette étude a utilisé le framework FCMAE pour pré-entraîner ConvNeXt V2. À partir de l'affichage visuel de la figure 3 ci-dessous et de l'analyse de la distance cosinus de la figure 4, on peut observer que ConvNeXt V2 atténue efficacement le problème d'effondrement des fonctionnalités. Les valeurs de distance cosinusoïdale sont constamment élevées, ce qui indique que la diversité des caractéristiques peut être maintenue pendant le transfert des couches réseau. Ceci est similaire au modèle ViT pré-entraîné à l'aide de MAE. Cela montre que le comportement d'apprentissage de ConvNeXt V2 est similaire à celui de ViT dans un cadre de pré-formation d'image de masque similaire.

Pour évaluer le rôle de GRN, cette étude a utilisé le framework FCMAE pour pré-entraîner ConvNeXt V2. À partir de l'affichage visuel de la figure 3 ci-dessous et de l'analyse de la distance cosinus de la figure 4, on peut observer que ConvNeXt V2 atténue efficacement le problème d'effondrement des fonctionnalités. Les valeurs de distance cosinusoïdale sont constamment élevées, ce qui indique que la diversité des caractéristiques peut être maintenue pendant le transfert des couches réseau. Ceci est similaire au modèle ViT pré-entraîné à l'aide de MAE. Cela montre que le comportement d'apprentissage de ConvNeXt V2 est similaire à celui de ViT dans un cadre de pré-formation d'image de masque similaire.

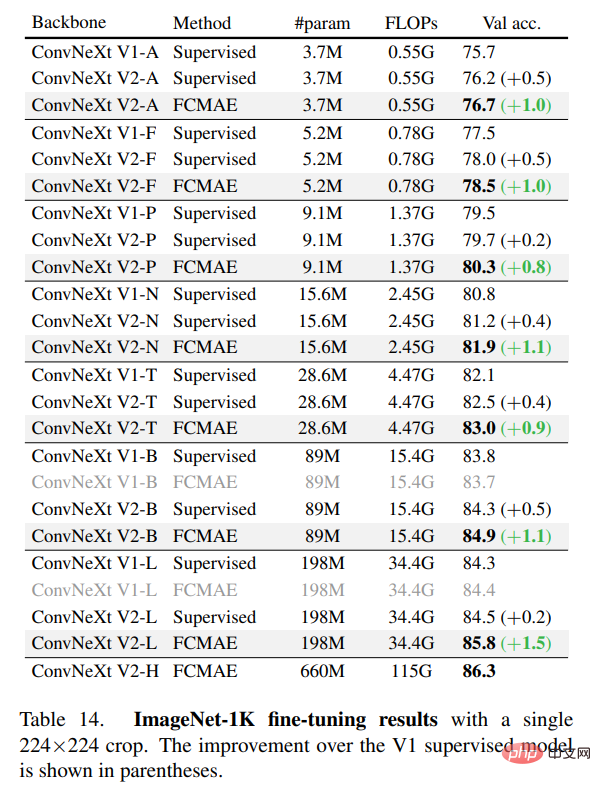

L'étude a en outre évalué les performances de réglage fin et les résultats sont présentés dans le tableau ci-dessous.

Lorsqu'il est équipé de GRN, le modèle pré-entraîné FCMAE peut largement surpasser le modèle supervisé formé sur 300 époques. GRN améliore la qualité de la représentation en améliorant la diversité des fonctionnalités, ce qui est crucial pour la pré-formation basée sur le masque et est absent dans le modèle ConvNeXt V1. Il convient de noter que cette amélioration est obtenue sans ajouter de paramètres supplémentaires et sans augmenter les FLOPS.

Enfin, l'étude a également examiné l'importance du GRN dans la pré-formation et la mise au point. Comme le montre le tableau 2 (f) ci-dessous, les performances diminuent considérablement si le GRN est supprimé du réglage fin ou si le GRN nouvellement initialisé est ajouté pendant le réglage fin, ce qui indique que le GRN est important à la fois dans la pré-formation et dans le réglage fin.

Les lecteurs intéressés peuvent lire le texte original de l'article pour en savoir plus sur les détails de la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Nouveaux travaux sur la prédiction de séries chronologiques + grand modèle NLP : générer automatiquement des invites implicites pour la prédiction de séries chronologiques

Mar 18, 2024 am 09:20 AM

Nouveaux travaux sur la prédiction de séries chronologiques + grand modèle NLP : générer automatiquement des invites implicites pour la prédiction de séries chronologiques

Mar 18, 2024 am 09:20 AM

Aujourd'hui, j'aimerais partager un travail de recherche récent de l'Université du Connecticut qui propose une méthode pour aligner les données de séries chronologiques avec de grands modèles de traitement du langage naturel (NLP) sur l'espace latent afin d'améliorer les performances de prévision des séries chronologiques. La clé de cette méthode consiste à utiliser des indices spatiaux latents (invites) pour améliorer la précision des prévisions de séries chronologiques. Titre de l'article : S2IP-LLM : SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting Adresse de téléchargement : https://arxiv.org/pdf/2403.05798v1.pdf 1. Modèle de fond de problème important

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles