Périphériques technologiques

Périphériques technologiques

IA

IA

Interprétation de la puissance de recherche derrière ChatGPT : la génération post-90 est devenue la force principale et les grands fabricants ne sont plus le premier choix pour les meilleurs talents en IA

Interprétation de la puissance de recherche derrière ChatGPT : la génération post-90 est devenue la force principale et les grands fabricants ne sont plus le premier choix pour les meilleurs talents en IA

Interprétation de la puissance de recherche derrière ChatGPT : la génération post-90 est devenue la force principale et les grands fabricants ne sont plus le premier choix pour les meilleurs talents en IA

La popularité de ChatGPT n'a pas seulement attiré l'attention et la faveur des utilisateurs sur OpenAI Dans la discussion sur "Pourquoi OpenAI peut créer ChatGPT", ses avantages en termes de personnel sont également devenus le centre d'attention du monde extérieur.

Récemment, Wisdom Research et AMiner ont publié un rapport statistique de l'équipe de recherche derrière OpenAI. Selon le rapport, 87 personnes ont contribué cette fois au projet ChatGPT, y compris celles qui sont « très jeunes », « ont un parcours luxueux », « se concentrent sur la technologie », « ont une profonde accumulation », « prônent l'entrepreneuriat ». et « chinois » accrocheur » et d'autres caractéristiques distinctives.

Lien du rapport : https://mp.weixin.qq.com/s/Y_LjjsuoEEmhIg5WO_iQhA

Dans une telle équipe de moins d'une centaine de personnes, le phénoménal langage à grande échelle Le modèle ChatGPT est né, cela met beaucoup de pression sur les grands fabricants tels que Google, Microsoft, Baidu et Alibaba, et ils ont suivi de près et publié ou pré-publié des produits de type ChatGPT.

En tant qu'institution de recherche à but non lucratif sur l'intelligence artificielle, OpenAI a toujours été considérée comme un paradis technologique par de nombreux jeunes talents intéressés à développer une carrière en IA. Ici, ils peuvent participer directement aux projets d'IA les plus avant-gardistes et les plus créatifs, utiliser les ressources de base de la recherche scientifique et se consacrer à l'innovation technologique sans distraction.

Ces dernières années, la marginalisation et l'indécision ont amené les instituts de recherche en IA et les talents en recherche scientifique des grands fabricants nationaux à faire face à des difficultés de survie. Cependant, je crois que sous l'impact de ChatGPT cette fois, les talents en IA reviendront aux yeux du public. et inaugurer une nouvelle ère. Un nouveau cycle de compétition et de brassage.

1

Le personnel technique représente près de 90%

La génération post-90 est la force principale

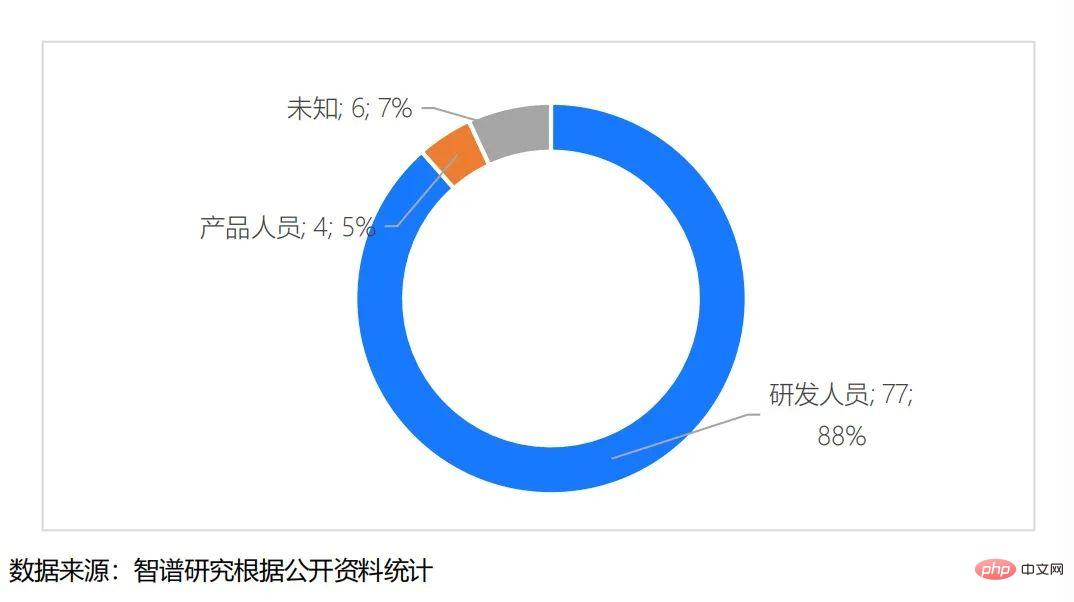

De la division poste de l'équipe ChatGPT (Figure 1), parmi les 87 personnes participant à ce projet , le nombre de personnel de R&D Le nombre a atteint 77, soit 88 %, dont le co-fondateur de l'entreprise Wojciech Zaremba, qui avait été précédemment sélectionné comme l'universitaire le plus influent dans le domaine de l'IA 2000 en 2023.

Il y a 4 membres du personnel produit, représentant 5%. De plus, les informations sur le poste de 6 participants ne peuvent pas être obtenues.

Figure 1 : Division des positions de l'équipe ChatGPT

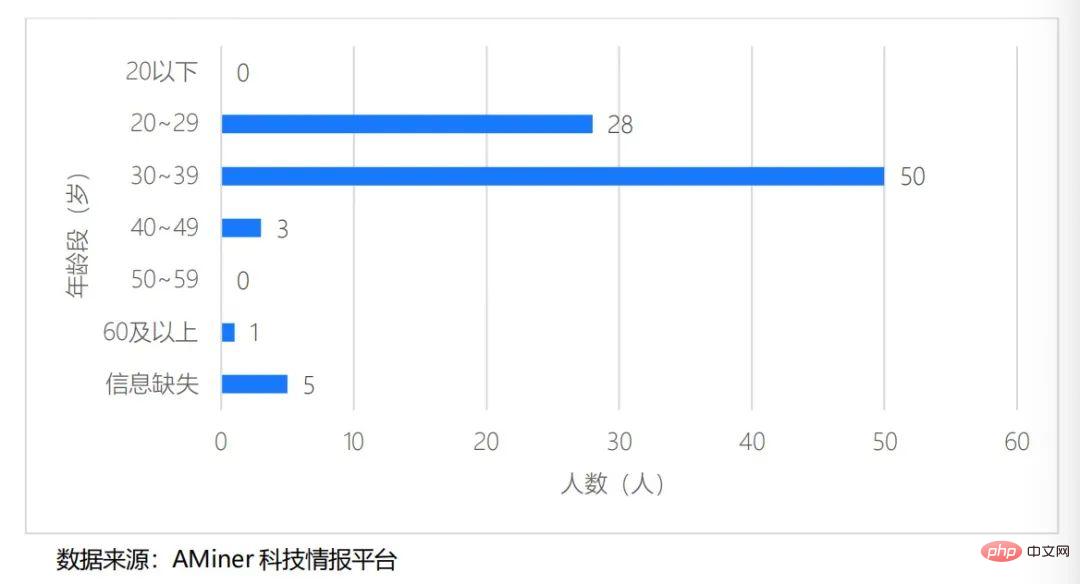

En termes de répartition par âge des membres (Figure 2), la génération post-90 est la principale force de l'équipe, parmi laquelle les personnes âgées entre 20 et 29 ans Il y a 28 membres au total, soit 34 % ; le plus grand nombre de membres est âgé de 30 à 39 ans, avec 50 personnes au total, soit 61 % ; Tranche d’âge de 40 à 49 ans, et un seul a plus de 60 ans.

Selon les statistiques, l'âge moyen de cette équipe de recherche est de 32 ans.

Figure 2 : Répartition par âge de l'équipe ChatGPT

« Âge fort » et « Focus sur la technologie » sont deux caractéristiques importantes des membres de l'équipe ChatGPT.

Bien que l'âge moyen ne soit que de 32 ans, les membres de l'équipe sont fortement concentrés sur la recherche et le développement technologique. Sur la base de leur grand intérêt et de leur dévouement total à l'innovation et à la recherche et au développement de l'IA, ils ont créé ce modèle phénoménal qui a fait exploser. nouveau cycle de technologie mondiale. On voit qu’il est tout à fait possible pour des jeunes considérés comme ayant une expérience insuffisante en recherche et développement de réaliser des percées majeures dans le domaine de la science et de la technologie de pointe.

Actuellement, les jeunes talents comme OpenAI ne manquent pas en Chine.

Après l'avènement de ChatGPT, Zhang Jiaxing, chercheur scientifique à l'Institut de recherche IDEA, a rapidement transféré le développement de grands modèles de l'équipe vers la ligne de tâches conversationnelles de ChatGPT à la fin de l'année dernière.

Selon lui, les principaux chercheurs de son équipe sont tous de jeunes talents exceptionnels nés dans les années 1990. Actuellement, le modèle de type ChatGPT qu'ils ont développé est aussi efficace que ChatGPT, ne comporte que 5 milliards de paramètres et la vitesse de génération de texte est également très rapide. Il est actuellement en test interne et sera rendu public dans un avenir proche.

2

9 personnes sont chinoises et ont fait des études dans des écoles prestigieuses

Les grandes usines ne sont plus le premier choix pour les meilleurs talents

Les membres de l'équipe ChatGPT ont un nombre relativement équilibré de diplômes de licence, de maîtrise et de doctorat, parmi dont 27 personnes Parmi eux, 25 ont un baccalauréat, 25 ont une maîtrise et 28 ont un doctorat, représentant respectivement 33 %, 30 % et 37 %.

Parmi elles, l'Université de Stanford compte le plus grand nombre d'anciens élèves avec 14, suivie par l'UC Berkeley avec 10 et le MIT en troisième position avec 7.

Figure 3 : Top 10 des membres de l'équipe ChatGPT diplômés des universités

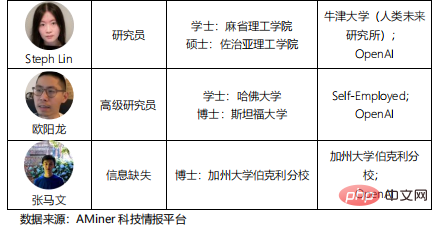

Les universitaires chinois sont une force importante dans l'innovation technologique dans l'équipe, avec un total de 9 personnes, représentant près de 10 %.

Parmi eux, 5 personnes sont diplômées d'universités chinoises et 3 personnes ont des diplômes de premier cycle de l'Université Tsinghua, à savoir Weng Jiayi, Zhao Shengjia et Yuan Qiming. Ils sont actuellement ingénieurs R&D dans l'équipe ; un baccalauréat Diplômé de l'Université des sciences et technologies de Huazhong et de l'Université de Pékin/Université de Hong Kong, respectivement Jiang Xu et Weng Lilian.

Ils sont tous allés aux États-Unis pour poursuivre leurs études après avoir obtenu leur diplôme des meilleures universités nationales et obtenu une maîtrise ou un doctorat.

Figure 4 : Membres chinois de l'équipe ChatGPT

Le turnover du personnel montre que les grands fabricants ne sont plus le premier choix pour les meilleurs talents , comme OpenAI, une institution de recherche plus pure, est plus favorisée par eux.

Au total, 5 membres de l'équipe ont été nommés 2023 AI 2000 Global Artificial Intelligence Scholars. Il s'agit de :

1. Wojciech Zaremba, co-fondateur d'OpenAI (domaine sélectionné et classement : robotique, 10ème place)

2. Lukasz Kaiser, chercheur de ChatGPT (domaine sélectionné et classement : apprentissage automatique, 10ème place) ).

3. John Schulman, co-fondateur d'OpenAI et chercheur chez ChatGPT (domaine sélectionné et classement : apprentissage automatique, 41e)

4. Tomer Kaftan, ingénieur R&D chez ChatGPT (domaine sélectionné et classement : base de données, No. 41) 52)

5.ChatGPT Barret Zoph, chercheur scientifique (domaine sélectionné et classement : apprentissage automatique, 95e)

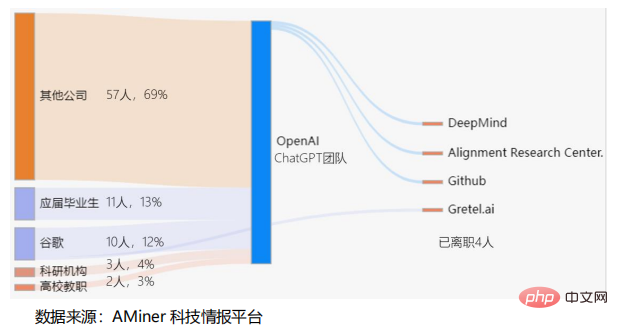

Proportion de personnel provenant d'entreprises externes, de nouveaux diplômés d'universités, d'instituts de recherche scientifique et de professeurs universitaires Ils représentaient respectivement 81 %, 13 %, 4 % et 3 %. La plupart d'entre eux provenaient d'entreprises technologiques de premier plan ou bien connues telles que Google, Microsoft, Meta, Intel, NVIDIA, Apple, etc. Au total, 10 personnes ont rejoint le groupe. Google et 1 personne avaient travaillé chez Baidu.

Figure 5 : Flux des membres de l'équipe ChatGPT

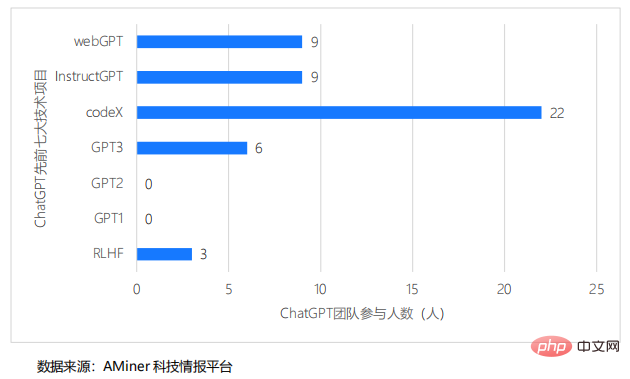

Les statistiques ont également révélé que dans la recherche et le développement des sept premiers projets techniques liés à ChatGPT, davantage de personnes de l'équipe ChatGPT ont participé eux En cours de développement.

Le projet CodeX compte le plus grand nombre de participants, avec un total de 22 personnes participant, représentant 25 % de l'équipe ; suivi de webGPT et instructGPT, avec un total de 9 personnes participantes ; GPT3 compte un total de 6 personnes participantes ; , le troisième rang ; le quatrième rang est RLHF, 3 personnes ont participé.

Figure 6 : Le nombre de personnes impliquées dans les sept précédentes recherches et développements techniques de l'équipe ChatGPT

On peut dire que ChatGPT est le résultat des années d'accumulation technologique d'OpenAI dans le domaine des grands modèles de langage, des leaders de haut niveau et un excellent personnel technique en IA. Les résultats rassemblés ont jeté une base solide pour le développement réussi de ChatGPT.

3

La bataille pour les talents en IA

En fait, au cours des dernières années, les instituts de recherche en IA et les talents en IA ont longtemps été confrontés au dilemme de la marginalisation et des changements stratégiques au sein des grandes usines, comme mentionné ci-dessus Chez Google , de nombreux talents ont afflué vers des lieux saints de la recherche scientifique pure comme OpenAI.

Dans le cadre du modèle de structure organisationnelle de l'entreprise, le personnel IA au sein des grandes usines a souvent du mal à développer ses capacités et ses réalisations.

Mais contrairement aux géants de la technologie traditionnelle, si des entreprises comme OpenAI ont pour mission de « développer l'intelligence artificielle », la R&D et l'innovation en IA sont leur mission, c'est-à-dire de participer étroitement aux projets d'IA les plus avant-gardistes, le la plupart des ressources de base sont utilisées pour la recherche et le développement, et en coulisses, nous devons être capables d'assumer la responsabilité de ne pas produire de résultats pendant une longue période. Parmi eux, le modèle GPT ne prend que trois ans entre le premier lancement et la fin de la formation, ce qui nécessite un ensemble complet de garanties systématiques de fonds, de technologie et de talents de la part de l'équipe.

L'émergence de ChatGPT a ramené les talents de l'IA sur le devant de la scène, a réitéré l'importance de la recherche scientifique pure et ne manquera pas de déclencher un nouveau cycle de compétition de talents. Dans le même temps, cela permettra également aux grands fabricants de mettre davantage l'accent sur les infrastructures telles que les grands modèles et les ressources informatiques, et d'accélérer le rattrapage et la complémentation des capacités techniques sous-jacentes.

Comme l'a déclaré l'ancien PDG de Sogou, Wang Xiaochuan, sur Weibo, "Le succès d'OpenAI est avant tout la victoire de l'idéalisme technique." Le succès de ChatGPT est inévitablement indissociable des efforts conjoints de l'industrie, du monde universitaire et de la recherche, et derrière eux. c’est l’intérêt des membres de l’équipe pour la technologie de l’intelligence artificielle et leur conviction d’y adhérer. Les forces de recherche scientifiques de pointe ne manquent pas dans le pays. Se concentrer sur l'innovation technologique de pointe et progresser régulièrement est d'une grande importance pour promouvoir le développement de l'innovation en matière d'IA en Chine.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Les modèles linguistiques à grande échelle (LLM) ont démontré des capacités convaincantes dans de nombreuses tâches importantes, notamment la compréhension du langage naturel, la génération de langages et le raisonnement complexe, et ont eu un impact profond sur la société. Cependant, ces capacités exceptionnelles nécessitent des ressources de formation importantes (illustrées dans l’image de gauche) et de longs temps d’inférence (illustrés dans l’image de droite). Les chercheurs doivent donc développer des moyens techniques efficaces pour résoudre leurs problèmes d’efficacité. De plus, comme on peut le voir sur le côté droit de la figure, certains LLM (LanguageModels) efficaces tels que Mistral-7B ont été utilisés avec succès dans la conception et le déploiement de LLM. Ces LLM efficaces peuvent réduire considérablement la mémoire d'inférence tout en conservant une précision similaire à celle du LLaMA1-33B

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Quelques réflexions personnelles de l'auteur Dans le domaine de la conduite autonome, avec le développement de sous-tâches/solutions de bout en bout basées sur BEV, les données d'entraînement multi-vues de haute qualité et la construction de scènes de simulation correspondantes sont devenues de plus en plus importantes. En réponse aux problèmes des tâches actuelles, la « haute qualité » peut être divisée en trois aspects : des scénarios à longue traîne dans différentes dimensions : comme les véhicules à courte portée dans les données sur les obstacles et les angles de cap précis lors du découpage des voitures, et les données sur les lignes de voie. . Scènes telles que des courbes avec des courbures différentes ou des rampes/fusions/fusions difficiles à capturer. Celles-ci reposent souvent sur de grandes quantités de données collectées et sur des stratégies complexes d’exploration de données, qui sont coûteuses. Valeur réelle 3D - image hautement cohérente : l'acquisition actuelle des données BEV est souvent affectée par des erreurs d'installation/calibrage du capteur, des cartes de haute précision et l'algorithme de reconstruction lui-même. cela m'a amené à

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

Veuillez noter que cet homme carré fronça les sourcils, pensant à l'identité des « invités non invités » devant lui. Il s’est avéré qu’elle se trouvait dans une situation dangereuse, et une fois qu’elle s’en est rendu compte, elle a rapidement commencé une recherche mentale pour trouver une stratégie pour résoudre le problème. Finalement, elle a décidé de fuir les lieux, de demander de l'aide le plus rapidement possible et d'agir immédiatement. En même temps, la personne de l'autre côté pensait la même chose qu'elle... Il y avait une telle scène dans "Minecraft" où tous les personnages étaient contrôlés par l'intelligence artificielle. Chacun d’eux a un cadre identitaire unique. Par exemple, la jeune fille mentionnée précédemment est une coursière de 17 ans mais intelligente et courageuse. Ils ont la capacité de se souvenir, de penser et de vivre comme des humains dans cette petite ville de Minecraft. Ce qui les anime est une toute nouvelle,

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

La tâche de génération d'image en vidéo (I2V) est un défi dans le domaine de la vision par ordinateur qui vise à convertir des images statiques en vidéos dynamiques. La difficulté de cette tâche est d'extraire et de générer des informations dynamiques dans la dimension temporelle à partir d'une seule image tout en conservant l'authenticité et la cohérence visuelle du contenu de l'image. Les méthodes I2V existantes nécessitent souvent des architectures de modèles complexes et de grandes quantités de données de formation pour atteindre cet objectif. Récemment, un nouveau résultat de recherche « I2V-Adapter : AGeneralImage-to-VideoAdapter for VideoDiffusionModels » dirigé par Kuaishou a été publié. Cette recherche introduit une méthode innovante de conversion image-vidéo et propose un module adaptateur léger, c'est-à-dire

Revoir! Fusion profonde de modèles (LLM/modèle de base/apprentissage fédéré/mise au point, etc.)

Apr 18, 2024 pm 09:43 PM

Revoir! Fusion profonde de modèles (LLM/modèle de base/apprentissage fédéré/mise au point, etc.)

Apr 18, 2024 pm 09:43 PM

Le 23 septembre, l'article « DeepModelFusion:ASurvey » a été publié par l'Université nationale de technologie de la défense, JD.com et l'Institut de technologie de Pékin. La fusion/fusion de modèles profonds est une technologie émergente qui combine les paramètres ou les prédictions de plusieurs modèles d'apprentissage profond en un seul modèle. Il combine les capacités de différents modèles pour compenser les biais et les erreurs des modèles individuels pour de meilleures performances. La fusion profonde de modèles sur des modèles d'apprentissage profond à grande échelle (tels que le LLM et les modèles de base) est confrontée à certains défis, notamment un coût de calcul élevé, un espace de paramètres de grande dimension, l'interférence entre différents modèles hétérogènes, etc. Cet article divise les méthodes de fusion de modèles profonds existantes en quatre catégories : (1) « Connexion de modèles », qui relie les solutions dans l'espace de poids via un chemin de réduction des pertes pour obtenir une meilleure fusion de modèles initiale.