Périphériques technologiques

Périphériques technologiques

IA

IA

Où ira ChatGPT à partir de là ? Nouveau travail de LeCun : examen complet du « modèle de langage amélioré » de nouvelle génération

Où ira ChatGPT à partir de là ? Nouveau travail de LeCun : examen complet du « modèle de langage amélioré » de nouvelle génération

Où ira ChatGPT à partir de là ? Nouveau travail de LeCun : examen complet du « modèle de langage amélioré » de nouvelle génération

ChatGPT a allumé le feu des modèles linguistiques, et les praticiens de la PNL réfléchissent et résument les futures orientations de recherche.

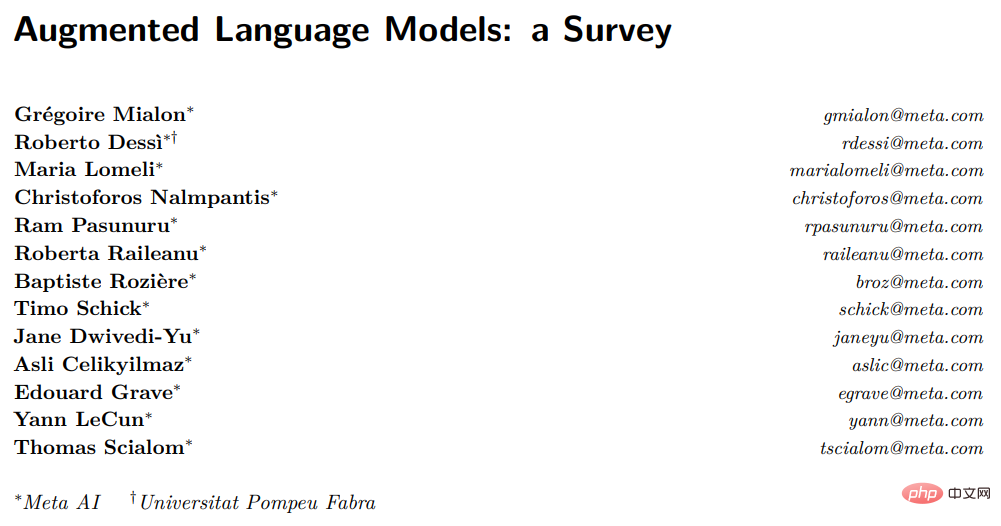

Yann LeCun, récent lauréat du prix Turing, a participé à la rédaction d'une revue sur les "Modèles de langage améliorés", a passé en revue le travail de combinaison de modèles de langage avec des compétences de raisonnement et la capacité d'utiliser des outils, et a conclu Conclusion,Ce nouveau L'orientation de la recherche a le potentiel de résoudre les limites des modèles linguistiques traditionnels, telles que les problèmes d'interprétabilité, de cohérence et d'évolutivité. Dans les modèles de langage améliorés, le raisonnement signifie décomposer des tâches complexes en sous-tâches plus simples, des outils incluant l'appel de modules externes (tels que comme interprètes de code, calculatrices, etc.), LM peut exploiter ces améliorations seules ou en combinaison via des heuristiques ou via un apprentissage par démonstration.

Tout en suivant l'objectif standard de prédiction des jetons manquants, le LM amélioré peut utiliser divers modules externes qui peuvent être non paramétriques pour étendre les capacités de traitement du contexte. Il ne se limite pas au paradigme de modélisation de langage pur et peut être qualifié de langage amélioré. . Modèles (ALM, modèles de langage augmenté).

Les cibles de prédiction de jetons manquantes permettent à ALM d'apprendre à raisonner, à utiliser des outils et même à agir (agir), tout en étant capable d'effectuer des tâches standard en langage naturel, surpassant même la plupart des LM conventionnels sur plusieurs ensembles de données de référence. Modèles linguistiques améliorés

Les modèles linguistiques à grande échelle (LLM) ont entraîné d'énormes progrès dans le traitement du langage naturel et sont progressivement devenus le noyau technique de produits utilisés par des millions d'utilisateurs, notamment l'assistant de codage Copilot, le moteur de recherche Google et le ChatGPT récemment publié.

La mémorisation combinée aux capacités de compositionnalité permet à LLM d'effectuer diverses tâches telles que la compréhension du langage ou la génération de texte conditionnel et inconditionnel à des niveaux de performances sans précédent, ouvrant ainsi une voie pratique à un plus large éventail d'interactions homme-machine.

Cependant, le développement actuel du LLM est encore soumis à de nombreuses restrictions, entravant son déploiement dans un plus large éventail de scénarios d'application.

Par exemple, les LLM fournissent souvent des prédictions non factuelles mais apparemment raisonnables, également connues sous le nom d'hallucinations. De nombreuses erreurs sont en réalité totalement évitables, notamment des problèmes arithmétiques et de petites erreurs dans la chaîne de raisonnement.

De plus, bon nombre des capacités révolutionnaires des LLM semblent émerger à grande échelle, mesurée par le nombre de paramètres pouvant être entraînés, et des chercheurs précédents ont démontré qu'une fois qu'un modèle atteint une certaine échelle, les LLM sont capables de réaliser de GRANDS- tâches de banc grâce à des invites en quelques coups.

Bien que des efforts aient été récemment déployés pour former certains LM plus petits tout en conservant certaines des capacités des grands modèles, l'échelle et les exigences en matière de données des LLM actuels ne sont pas pratiques pour la formation et la maintenance : les grands modèles L'apprentissage continu reste une question de recherche ouverte.

Les méta-chercheurs pensent que ces problèmes proviennent d'un défaut fondamental des LLM : leur processus de formation consiste à donner un modèle de paramètres et un contexte limité (généralement n mots avant et après), puis à effectuer une modélisation statistique du langage.

Bien que la taille du contexte n ait augmenté ces dernières années en raison du développement des logiciels et du matériel, la plupart des modèles utilisent encore des tailles de contexte relativement petites, donc la taille énorme du modèle est une nécessité pour stocker des connaissances qui n'apparaissent pas. dans le contexte, les conditions sont également essentielles à l'exécution des tâches en aval.

Par conséquent, une tendance croissante de la recherche consiste à résoudre ces problèmes d’une manière qui s’écarte légèrement du paradigme de modélisation purement statistique du langage mentionné ci-dessus. Par exemple, il existe un travail pour contourner le problème de la taille limitée du contexte du LLM en ajoutant le calcul de pertinence à partir des "informations extraites de fichiers externes pertinents". En équipant les LM d'un module de récupération pour récupérer de tels documents dans un contexte donné à partir de la base de données, nous pouvons égaler certaines des capacités des LM à plus grande échelle tout en ayant moins de paramètres. Il est important de noter que le modèle résultant est désormais non paramétrique car il peut interroger des sources de données externes. Plus généralement, LM peut également améliorer son contexte grâce à des stratégies d'inférence pour générer un contexte plus pertinent avant de générer des réponses, améliorant ainsi les performances grâce à davantage de calculs. Une autre stratégie consiste à permettre au LM d’exploiter des outils externes pour améliorer le contexte actuel avec des informations manquantes importantes non incluses dans les pondérations du LM. Bien que la plupart de ces travaux visent à atténuer les défauts mentionnés ci-dessus du LM, il est simple d’imaginer qu’une amélioration plus systématique du LM avec un raisonnement et des outils puisse conduire à des agents significativement plus puissants. Les chercheurs appellent collectivement ces modèles Modèles de langage augmentés (ALM). À mesure que cette tendance s'accélère, il devient difficile de suivre et de comprendre les nombreux modèles, nécessitant une classification du travail des ALM et la définition de termes techniques parfois utilisés à des fins différentes. Raisonnement Dans le contexte de l'ALM, le raisonnement est la décomposition d'une tâche potentiellement complexe en sous-tâches plus simples que le LM peut résoudre plus facilement par lui-même ou à l'aide d'outils. Il existe actuellement différentes manières de décomposer les sous-tâches, par exemple de manière récursive ou itérative. Dans un sens, le raisonnement est similaire au plan défini dans l'article de LeCun de 2022 « Routes to Autonomous Machine Intelligence ».

Lien papier : https://openreview.net/pdf?id=BZ5a1r-kVsf

Dans cette enquête, le raisonnement fait référence à diverses méthodes pour améliorer la capacité de raisonnement dans les stratégies LM , par exemple en utilisant un petit nombre d'exemples pour un raisonnement étape par étape. Bien qu'il ne soit pas encore entièrement compris si le LM raisonne réellement ou s'il génère simplement un contexte plus large qui augmente la probabilité de prédire correctement les jetons manquants.

Compte tenu de l'état actuel de la technologie, le raisonnement est peut-être un terme galvaudé, mais le terme est déjà largement utilisé au sein de la communauté. Dans le contexte de l'ALM, une définition plus pragmatique de l'inférence consiste à donner au modèle davantage d'étapes de calcul avant d'arriver à la réponse à l'invite.

Tool Tool

Pour ALM, un outil est un module externe, généralement appelé à l'aide d'une règle ou d'un jeton spécial, et sa sortie est incluse dans le contexte d'ALM.

Des outils peuvent être utilisés pour collecter des informations externes, ou avoir un impact sur le monde virtuel ou physique (généralement détecté par ALM) : Par exemple, un récupérateur de fichiers peut être utilisé comme un outil pour obtenir des informations externes, ou un robot Le bras peut être utilisé pour détecter les influences extérieures.

Les outils peuvent être appelés au moment de la formation ou au moment de l'inférence. Plus généralement, le modèle doit apprendre à interagir avec l'outil, notamment en apprenant à appeler son API

Act

Pour. ALM Dites, invoquez un outil qui a un impact sur le monde virtuel ou physique et observez ses résultats, en l'intégrant généralement dans le contexte actuel d'ALM.

Certains des travaux présentés dans cette enquête traitent de la recherche sur le Web ou de la manipulation de bras robotisés via des LM. Dans un léger abus de terminologie, l'invocation d'un outil par ALM est parfois représentée comme une action, même si elle n'a aucun impact sur le monde extérieur.

Pourquoi discuter de raisonnement et d'outils en même temps ?

La combinaison du raisonnement et des outils dans LM devrait permettre de résoudre un large éventail de tâches complexes sans heuristique, c'est-à-dire avec de meilleures capacités de généralisation.

Généralement, le raisonnement permet au LM de décomposer un problème donné en sous-tâches potentiellement plus simples, tandis que les outils aident à terminer chaque étape correctement, comme l'obtention de résultats à partir d'opérations mathématiques.

En d'autres termes, le raisonnement est un moyen pour LM de combiner différents outils pour résoudre des tâches complexes, et les outils sont un moyen d'éviter les échecs de raisonnement et de se décomposer efficacement.

Les deux devraient bénéficier de l'autre, et l'inférence et les outils peuvent être placés dans le même module, car les deux fonctionnent en améliorant le contexte de LM pour mieux prédire les jetons manquants, bien que de différentes manières.

Pourquoi discuter des outils et des actions en même temps ? Les outils qui collectent des informations supplémentaires et ont un impact sur le monde virtuel ou physique peuvent être appelés par LM de la même manière. Par exemple, il semble y avoir peu de différence entre un LM qui génère du code python pour résoudre des opérations mathématiques et un LM qui génère du code python pour manipuler un bras robotique. Certains des travaux discutés dans cette revue utilisent déjà des LM qui ont des effets sur le monde virtuel ou physique. Dans cette perspective, nous pouvons dire que les LM ont le potentiel d'agir et d'espérer des progrès importants dans la direction des LM en tant qu'agents autonomes.

Méthode de classificationLes chercheurs ont décomposé les travaux introduits dans la revue dans les trois dimensions ci-dessus et les ont présentés respectivement. Enfin, des travaux connexes dans d'autres dimensions ont également été discutés. Pour le lecteur, il convient de rappeler que bon nombre de ces techniques ont été initialement introduites dans des contextes autres que le LM, et si nécessaire, de consulter si possible les introductions des articles mentionnés et les travaux connexes. Enfin, bien que la revue se concentre sur le LLM, tous les travaux connexes n'adoptent pas de grands modèles, mais visent l'exactitude du LM.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Que signifie la transaction transversale? Quelles sont les transactions transversales?

Apr 21, 2025 pm 11:39 PM

Que signifie la transaction transversale? Quelles sont les transactions transversales?

Apr 21, 2025 pm 11:39 PM

Échanges qui prennent en charge les transactions transversales: 1. Binance, 2. UniSwap, 3. Sushiswap, 4. Curve Finance, 5. Thorchain, 6. 1inch Exchange, 7. DLN Trade, ces plateformes prennent en charge les transactions d'actifs multi-chaînes via diverses technologies.

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

Binance est le suzerain de l'écosystème mondial de trading d'actifs numériques, et ses caractéristiques comprennent: 1. Le volume de négociation quotidien moyen dépasse 150 milliards de dollars, prend en charge 500 paires de négociation, couvrant 98% des monnaies grand public; 2. La matrice d'innovation couvre le marché des dérivés, la mise en page Web3 et le système éducatif; 3. Les avantages techniques sont des moteurs de correspondance d'une milliseconde, avec des volumes de traitement de pointe de 1,4 million de transactions par seconde; 4. Conformité Progress détient des licences de 15 pays et établit des entités conformes en Europe et aux États-Unis.

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

Prévisions des prix WorldCoin (WLD) 2025-2031: WLD atteindra-t-il 4 $ d'ici 2031?

Apr 21, 2025 pm 02:42 PM

WorldCoin (WLD) se démarque sur le marché des crypto-monnaies avec ses mécanismes uniques de vérification biométrique et de protection de la vie privée, attirant l'attention de nombreux investisseurs. WLD a permis de se produire avec remarquablement parmi les Altcoins avec ses technologies innovantes, en particulier en combinaison avec la technologie d'Intelligence artificielle OpenAI. Mais comment les actifs numériques se comporteront-ils au cours des prochaines années? Prédons ensemble le prix futur de WLD. Les prévisions de prix de 2025 WLD devraient atteindre une croissance significative de la WLD en 2025. L'analyse du marché montre que le prix moyen du WLD peut atteindre 1,31 $, avec un maximum de 1,36 $. Cependant, sur un marché baissier, le prix peut tomber à environ 0,55 $. Cette attente de croissance est principalement due à WorldCoin2.

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

'Black Monday Sell' est une journée difficile pour l'industrie de la crypto-monnaie

Apr 21, 2025 pm 02:48 PM

Le plongeon sur le marché des crypto-monnaies a provoqué la panique parmi les investisseurs, et Dogecoin (Doge) est devenu l'une des zones les plus difficiles. Son prix a fortement chuté et le verrouillage de la valeur totale de la finance décentralisée (DEFI) (TVL) a également connu une baisse significative. La vague de vente de "Black Monday" a balayé le marché des crypto-monnaies, et Dogecoin a été le premier à être touché. Son Defitvl a chuté aux niveaux de 2023 et le prix de la devise a chuté de 23,78% au cours du dernier mois. Le Defitvl de Dogecoin est tombé à un minimum de 2,72 millions de dollars, principalement en raison d'une baisse de 26,37% de l'indice de valeur SOSO. D'autres plates-formes de Defi majeures, telles que le Dao et Thorchain ennuyeux, TVL ont également chuté de 24,04% et 20, respectivement.

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Classement des échanges à effet de levier dans le cercle des devises Les dernières recommandations des dix premiers échanges à effet de levier dans le cercle des devises

Apr 21, 2025 pm 11:24 PM

Les plates-formes qui ont des performances exceptionnelles dans le commerce, la sécurité et l'expérience utilisateur en effet de levier en 2025 sont: 1. OKX, adaptés aux traders à haute fréquence, fournissant jusqu'à 100 fois l'effet de levier; 2. Binance, adaptée aux commerçants multi-monnaies du monde entier, offrant un effet de levier 125 fois élevé; 3. Gate.io, adapté aux joueurs de dérivés professionnels, fournissant 100 fois l'effet de levier; 4. Bitget, adapté aux novices et aux commerçants sociaux, fournissant jusqu'à 100 fois l'effet de levier; 5. Kraken, adapté aux investisseurs stables, fournissant 5 fois l'effet de levier; 6. BUTBIT, adapté aux explorateurs Altcoin, fournissant 20 fois l'effet de levier; 7. Kucoin, adapté aux commerçants à faible coût, fournissant 10 fois l'effet de levier; 8. Bitfinex, adapté au jeu senior

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Les facteurs de la hausse des prix des devises virtuels comprennent: 1. Une augmentation de la demande du marché, 2. Daisser l'offre, 3. Stimulé de nouvelles positives, 4. Sentiment du marché optimiste, 5. Environnement macroéconomique; Les facteurs de déclin comprennent: 1. Daissement de la demande du marché, 2. AUGMENT DE L'OFFICATION, 3. Strike of Negative News, 4. Pespimiste Market Sentiment, 5. Environnement macroéconomique.

Comment gagner des récompenses de plateaux aériens du noyau sur la stratégie de processus complète de la binance

Apr 21, 2025 pm 01:03 PM

Comment gagner des récompenses de plateaux aériens du noyau sur la stratégie de processus complète de la binance

Apr 21, 2025 pm 01:03 PM

Dans le monde animé des crypto-monnaies, de nouvelles opportunités émergent toujours. À l'heure actuelle, l'activité aérienne de Kerneldao (noyau) attire beaucoup l'attention et attire l'attention de nombreux investisseurs. Alors, quelle est l'origine de ce projet? Quels avantages le support BNB peut-il en tirer? Ne vous inquiétez pas, ce qui suit le révélera un par un pour vous.

Aavenomics est une recommandation pour modifier le jeton Aave Protocol et introduire le rachat de jetons, qui a atteint le nombre de personnes quorum.

Apr 21, 2025 pm 06:24 PM

Aavenomics est une recommandation pour modifier le jeton Aave Protocol et introduire le rachat de jetons, qui a atteint le nombre de personnes quorum.

Apr 21, 2025 pm 06:24 PM

Aavenomics est une proposition de modification du jeton de protocole Aave et d'introduire des dépens de jetons, qui a mis en œuvre un quorum pour Aavedao. Marc Zeller, fondateur de l'Aave Project Chain (ACI), l'a annoncé sur X, notant qu'il marque une nouvelle ère pour l'accord. Marc Zeller, fondateur de l'Aave Chain Initiative (ACI), a annoncé sur X que la proposition d'Aavenomics comprend la modification du jeton Aave Protocol et l'introduction de dépens de jetons, a obtenu un quorum pour Aavedao. Selon Zeller, cela marque une nouvelle ère pour l'accord. Les membres d'Aavedao ont voté massivement pour soutenir la proposition, qui était de 100 par semaine mercredi