développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Dix astuces Python couvrent 90% des besoins en analyse de données !

Dix astuces Python couvrent 90% des besoins en analyse de données !

Dix astuces Python couvrent 90% des besoins en analyse de données !

Le travail quotidien des analystes de données implique diverses tâches, telles que le prétraitement des données, l'analyse des données, la création de modèles d'apprentissage automatique et le déploiement de modèles.

Dans cet article, je partagerai 10 opérations Python qui peuvent couvrir 90% des problèmes d'analyse de données. Gagnez des likes, des favoris et de l'attention.

1. Lecture d'ensembles de données

La lecture des données fait partie intégrante de l'analyse des données. Comprendre comment lire les données de différents formats de fichiers est la première étape pour un analyste de données. Voici un exemple d'utilisation de pandas pour lire un fichier csv contenant des données Covid-19.

import pandas as pd

# reading the countries_data file along with the location within read_csv function.

countries_df = pd.read_csv('C:/Users/anmol/Desktop/Courses/Python for Data Science/Code/countries_data.csv')

# showing the first 5 rows of the dataframe

countries_df.head()

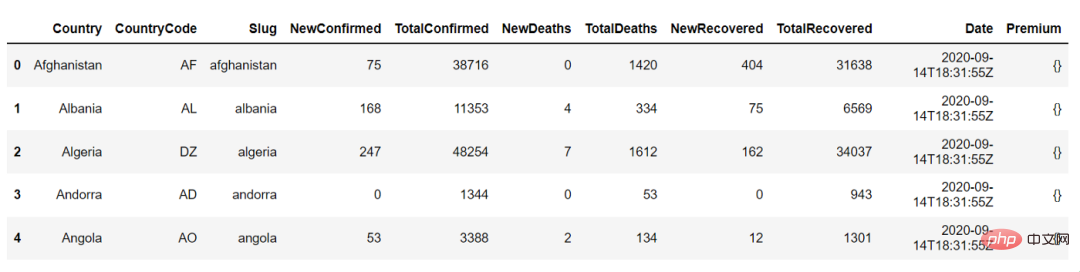

Ce qui suit est le résultat de country_df.head(), nous pouvons l'utiliser pour afficher les 5 premières lignes du bloc de données :

2. Statistiques récapitulatives

L'étape suivante consiste à comprendre les données en en affichant le résumé des données, telles que NewConfirmed, le nombre, la moyenne, l'écart type, le quantile des colonnes numériques telles que TotalConfirmed, ainsi que la fréquence et la valeur d'occurrence la plus élevée des colonnes catégorielles telles que le code du pays

<span style="color: rgb(89, 89, 89); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">countries_df</span>.<span style="color: rgb(0, 92, 197); margin: 0px; padding: 0px; background: none 0% 0% / auto repeat scroll padding-box border-box rgba(0, 0, 0, 0);">describe</span>()

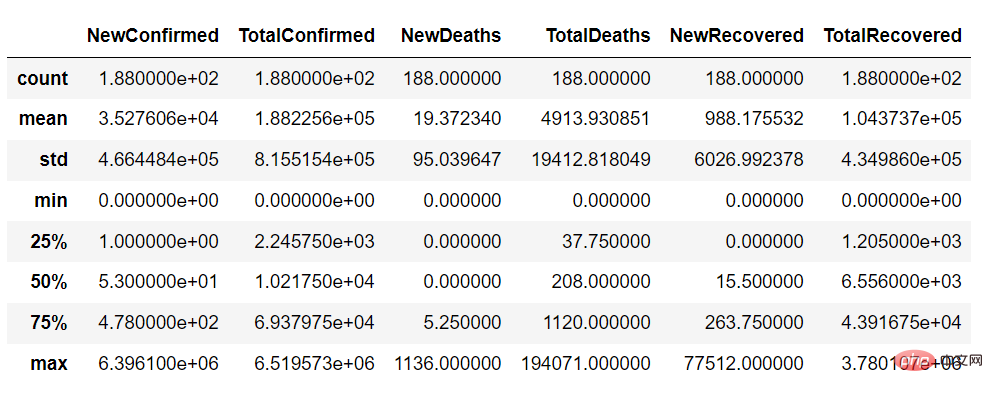

En utilisant la fonction de description, nous pouvons obtenir un résumé des variables continues de l'ensemble de données comme suit :

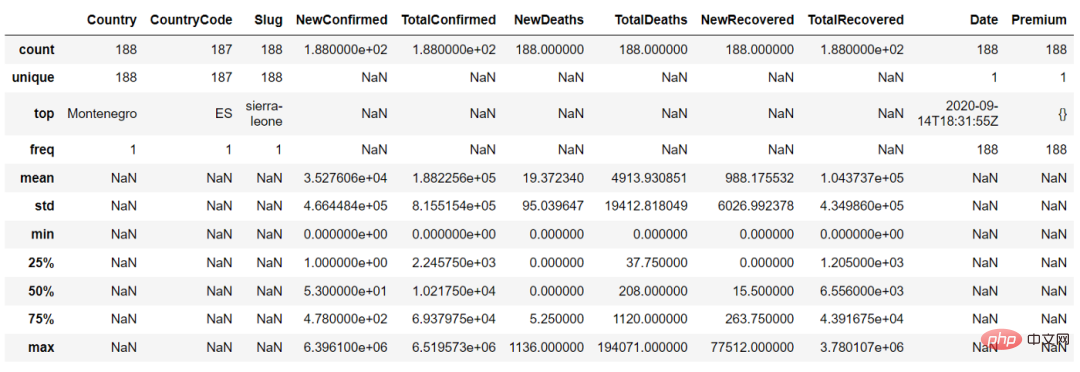

Dans la fonction décrire(), nous pouvons définir le paramètre "include = 'all'" pour obtenir le résumé des variables continues et des variables catégorielles

countries_df.describe(include = 'all')

3. Sélection et filtrage des données

L'analyse ne nécessite pas réellement un ensemble de données de toutes les lignes et colonnes, il suffit de sélectionner les colonnes qui vous intéressent et de filtrer certaines lignes en fonction de la question.

Par exemple, nous pouvons utiliser le code suivant pour sélectionner les colonnes Country et NewConfirmed :

countries_df[['Country','NewConfirmed']]

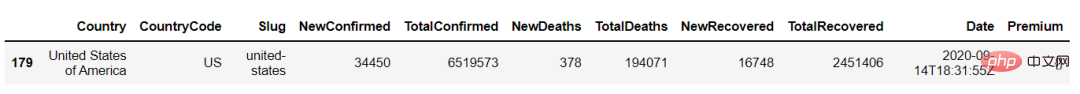

Nous pouvons également filtrer les données par Pays En utilisant loc, nous pouvons filtrer les colonnes en fonction de certaines valeurs comme suit :

countries_df.loc[countries_df['Country'] == 'United States of America']

4. Agrégation

L'agrégation de données telles que les décomptes, les sommes et les moyennes est l'une des tâches les plus couramment effectuées dans l'analyse des données.

Nous pouvons trouver le nombre total de cas NewConfimed par pays en utilisant l'agrégation. Utilisez les fonctions groupby et agg pour effectuer l'agrégation.

countries_df.groupby(['Country']).agg({'NewConfirmed':'sum'})5. Join

Utilisez l'opération Join pour combiner 2 ensembles de données en un seul ensemble de données.

Par exemple : un ensemble de données peut contenir le nombre de cas de Covid-19 dans différents pays, un autre ensemble de données peut contenir des informations de latitude et de longitude pour différents pays.

Maintenant, nous devons combiner ces deux informations, puis nous pouvons effectuer l'opération de connexion comme indiqué ci-dessous

countries_lat_lon = pd.read_excel('C:/Users/anmol/Desktop/Courses/Python for Data Science/Code/countries_lat_lon.xlsx')

# joining the 2 dataframe : countries_df and countries_lat_lon

# syntax : pd.merge(left_df, right_df, on = 'on_column', how = 'type_of_join')

joined_df = pd.merge(countries_df, countries_lat_lon, on = 'CountryCode', how = 'inner')

joined_df6 Fonctions intégrées

Comprendre les fonctions mathématiques intégrées, telles que min(), max(), Mean(), sum() etc., sont très utiles pour effectuer différentes analyses.

Nous pouvons appliquer ces fonctions directement sur le dataframe en les appelant, ces fonctions peuvent être utilisées indépendamment sur des colonnes ou dans des fonctions d'agrégation, comme indiqué ci-dessous :

# finding sum of NewConfirmed cases of all the countries

countries_df['NewConfirmed'].sum()

# Output : 6,631,899

# finding the sum of NewConfirmed cases across different countries

countries_df.groupby(['Country']).agg({'NewConfirmed':'sum'})

# Output

#NewConfirmed

#Country

#Afghanistan75

#Albania 168

#Algeria 247

#Andorra0

#Angola537. Fonctions définies par l'utilisateur

Fonction que nous avons écrite nous-mêmes. fonction définie par l'utilisateur. Nous pouvons exécuter le code de ces fonctions en cas de besoin en appelant la fonction. Par exemple, nous pouvons créer une fonction qui ajoute 2 nombres comme ceci :

# User defined function is created using 'def' keyword, followed by function definition - 'addition()' # and 2 arguments num1 and num2 def addition(num1, num2): return num1+num2 # calling the function using function name and providing the arguments print(addition(1,2)) #output : 3

8, Pivot

Pivot est une excellente technique de traitement de données qui convertit les valeurs uniques dans une ligne de colonne en plusieurs nouvelles colonnes.

En utilisant la fonction pivot_table() sur l'ensemble de données Covid-19, nous pouvons convertir les noms de pays en nouvelles colonnes distinctes :

# using pivot_table to convert values within the Country column into individual columns and # filling the values corresponding to these columns with numeric variable - NewConfimed pivot_df = pd.pivot_table(countries_df,columns = 'Country', values = 'NewConfirmed') pivot_df

9. Parcours du bloc de données

Souvent, nous devons parcourir les index et les lignes des données. frame, nous pouvons utiliser la fonction iterrows pour parcourir le bloc de données :

# iterating over the index and row of a dataframe using iterrows() function

for index, row in countries_df.iterrows():

print('Index is ' + str(index))

print('Country is '+ str(row['Country']))

# Output :

# Index is 0

# Country is Afghanistan

# Index is 1

# Country is Albania

# .......10. Opérations sur les chaînes

Souvent, nous traitons de colonnes de chaîne dans l'ensemble de données, dans ce cas, il est important de comprendre certaines opérations de base sur les chaînes.

Par exemple, comment convertir une chaîne en majuscules, minuscules et comment trouver la longueur d'une chaîne.

# country column to upper case countries_df['Country_upper'] = countries_df['Country'].str.upper() # country column to lower case countries_df['CountryCode_lower']=countries_df['CountryCode'].str.lower() # finding length of characters in the country column countries_df['len'] = countries_df['Country'].str.len() countries_df.head()

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

PHP et Python: exemples de code et comparaison

Apr 15, 2025 am 12:07 AM

PHP et Python: exemples de code et comparaison

Apr 15, 2025 am 12:07 AM

PHP et Python ont leurs propres avantages et inconvénients, et le choix dépend des besoins du projet et des préférences personnelles. 1.Php convient au développement rapide et à la maintenance des applications Web à grande échelle. 2. Python domine le domaine de la science des données et de l'apprentissage automatique.

Python vs JavaScript: communauté, bibliothèques et ressources

Apr 15, 2025 am 12:16 AM

Python vs JavaScript: communauté, bibliothèques et ressources

Apr 15, 2025 am 12:16 AM

Python et JavaScript ont leurs propres avantages et inconvénients en termes de communauté, de bibliothèques et de ressources. 1) La communauté Python est amicale et adaptée aux débutants, mais les ressources de développement frontal ne sont pas aussi riches que JavaScript. 2) Python est puissant dans les bibliothèques de science des données et d'apprentissage automatique, tandis que JavaScript est meilleur dans les bibliothèques et les cadres de développement frontaux. 3) Les deux ont des ressources d'apprentissage riches, mais Python convient pour commencer par des documents officiels, tandis que JavaScript est meilleur avec MDNWEBDOCS. Le choix doit être basé sur les besoins du projet et les intérêts personnels.

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

Miniopen Centos Compatibilité

Apr 14, 2025 pm 05:45 PM

Miniopen Centos Compatibilité

Apr 14, 2025 pm 05:45 PM

Minio Object Storage: Déploiement haute performance dans le système Centos System Minio est un système de stockage d'objets distribué haute performance développé sur la base du langage Go, compatible avec Amazons3. Il prend en charge une variété de langages clients, notamment Java, Python, JavaScript et GO. Cet article introduira brièvement l'installation et la compatibilité de Minio sur les systèmes CentOS. Compatibilité de la version CentOS Minio a été vérifiée sur plusieurs versions CentOS, y compris, mais sans s'y limiter: CentOS7.9: fournit un guide d'installation complet couvrant la configuration du cluster, la préparation de l'environnement, les paramètres de fichiers de configuration, le partitionnement du disque et la mini

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu

Comment choisir la version Pytorch sur Centos

Apr 14, 2025 pm 06:51 PM

Comment choisir la version Pytorch sur Centos

Apr 14, 2025 pm 06:51 PM

Lors de l'installation de Pytorch sur le système CentOS, vous devez sélectionner soigneusement la version appropriée et considérer les facteurs clés suivants: 1. Compatibilité de l'environnement du système: Système d'exploitation: Il est recommandé d'utiliser CentOS7 ou plus. CUDA et CUDNN: La version Pytorch et la version CUDA sont étroitement liées. Par exemple, Pytorch1.9.0 nécessite CUDA11.1, tandis que Pytorch2.0.1 nécessite CUDA11.3. La version CUDNN doit également correspondre à la version CUDA. Avant de sélectionner la version Pytorch, assurez-vous de confirmer que des versions compatibles CUDA et CUDNN ont été installées. Version Python: branche officielle de Pytorch

Python: automatisation, script et gestion des tâches

Apr 16, 2025 am 12:14 AM

Python: automatisation, script et gestion des tâches

Apr 16, 2025 am 12:14 AM

Python excelle dans l'automatisation, les scripts et la gestion des tâches. 1) Automatisation: La sauvegarde du fichier est réalisée via des bibliothèques standard telles que le système d'exploitation et la fermeture. 2) Écriture de script: utilisez la bibliothèque PSUTIL pour surveiller les ressources système. 3) Gestion des tâches: utilisez la bibliothèque de planification pour planifier les tâches. La facilité d'utilisation de Python et la prise en charge de la bibliothèque riche en font l'outil préféré dans ces domaines.