Périphériques technologiques

Périphériques technologiques

IA

IA

L'IA est-elle aussi amnésique ? Entretien exclusif avec un professeur britannique de 41 ans : Résoudre l'oubli catastrophique

L'IA est-elle aussi amnésique ? Entretien exclusif avec un professeur britannique de 41 ans : Résoudre l'oubli catastrophique

L'IA est-elle aussi amnésique ? Entretien exclusif avec un professeur britannique de 41 ans : Résoudre l'oubli catastrophique

Comment parvenir à un apprentissage continu et faire en sorte que l’IA s’améliore continuellement ?

Récemment, Christopher Kanan, un informaticien de 41 ans de l'Université de Rochester, a déclaré dans une interview exclusive qu'il construisait des algorithmes qui permettent à l'IA d'apprendre continuellement au fil du temps - tout comme nous, les humains.

Oubli catastrophique

Comme nous le savons tous, l'IA peut très bien accomplir des tâches « dans le cadre de l'examen » après la formation, mais ces algorithmes ne peuvent pas continuellement mettre à jour la base de connaissances avec de nouvelles informations comme les humains.

Pour apprendre ne serait-ce qu'une nouvelle chose, l'algorithme doit être entraîné à partir de zéro, au prix d'oublier presque tout ce qu'il a appris auparavant. Le problème que cela pose est « l’oubli catastrophique ». Tout comme lorsque vous rencontrez une nouvelle amie, la seule façon d’apprendre son nom est de redémarrer votre cerveau.

La raison pour laquelle cela se produit est due à la façon dont les réseaux de neurones apprennent de nouvelles choses. L’apprentissage de ces algorithmes nécessite de modifier la force des connexions entre les neurones. Cependant, cela représente également un savoir passé, donc trop modifier les connexions conduira à l’oubli.

Les réseaux de neurones biologiques ont développé des stratégies sur des centaines de millions d'années pour garantir la stabilité des informations importantes. Mais les réseaux de neurones artificiels d’aujourd’hui ont du mal à trouver un bon équilibre entre les anciennes et les nouvelles connaissances. À mesure que les réseaux voient de nouvelles données, leurs connexions peuvent facilement être écrasées, ce qui peut conduire à une incapacité soudaine et grave à reconnaître les informations passées.

1. Quel impact vos études en philosophie ont-elles eu sur votre façon de penser la recherche ?

Ce que la philosophie vous enseigne, c'est « Comment présenter des arguments raisonnables » et « Comment analyser les arguments des autres ? »

Mon laboratoire s'inspire de cette question : Si nous ne pouvons pas faire X, comment pouvons-nous faire Y ? ?

Nous apprendrons au fil du temps, mais pas le réseau de neurones, sa quantité de connaissances est fixe. Donc, si les humains veulent créer une intelligence artificielle générale à l’avenir, c’est un problème fondamental qui doit être résolu.

Notes de recherche de Kanan

2. Quels sont les progrès actuels dans la résolution de l’oubli catastrophique dans le monde universitaire ?

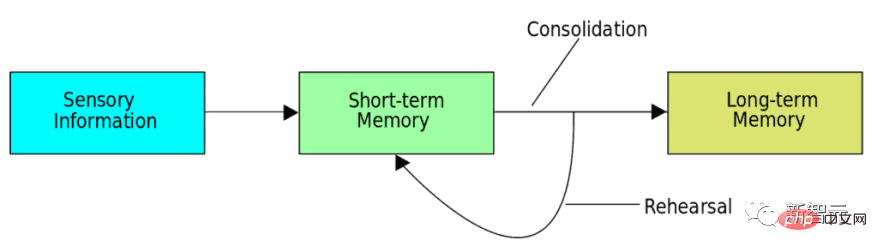

La méthode la plus efficace à l'heure actuelle est appelée replay, qui permet de stocker les connaissances passées, puis de les rejouer avec un nouvel ensemble de données pendant le processus de formation, afin que les informations d'origine ne soient pas perdues.

Cette méthode s’inspire du processus de consolidation de la mémoire (Memory Consolidation) dans notre cerveau. Pendant le sommeil, le contenu d’un apprentissage d’une journée est réencodé et rejoué au fur et à mesure de l’activation des neurones.

En d’autres termes, un nouvel apprentissage ne peut pas éradiquer complètement les connaissances passées de l’algorithme.

Il existe trois façons d’y parvenir.

- L'approche la plus courante est la « relecture réelle », dans laquelle les chercheurs stockent un sous-ensemble de l'entrée originale (par exemple, des images brutes pour une tâche de reconnaissance d'objets), puis mélangent ces images passées stockées avec de nouvelles images apprises.

- La deuxième méthode consiste à rejouer une représentation compressée de l'image.

- La troisième méthode la moins courante est "générer un replay".

Ici, le réseau de neurones artificiels génère en fait une version synthétique de l'expérience passée, puis mélange cet exemple synthétique avec de nouveaux exemples. Mon laboratoire se concentre sur les deux dernières approches.

3. Si nous pouvons résoudre complètement l’oubli catastrophique, cela signifie-t-il que l’IA peut apprendre de nouvelles choses au fil du temps ?

Pas exactement. Je pense que le problème ouvert dans le domaine de la formation continue n’est pas celui de l’oubli catastrophique.

Ce qui m'intéresse vraiment, c'est :

Comment les apprentissages passés peuvent-ils rendre les apprentissages futurs plus efficaces ? Comment les apprentissages futurs corrigent-ils les apprentissages passés ? Ce sont des choses que très peu de gens mesurent, et je pense que cela est un élément clé pour faire avancer le domaine, car en réalité, il ne s'agit pas seulement d'oublier quelque chose, il s'agit de devenir un meilleur apprenant.

Christopher Kanan a dit :

Il se passe certainement bien plus de choses dans nos têtes que les réseaux de neurones modernes. Nous devons mettre en place les bonnes configurations expérimentales et algorithmiques pour mesurer si l’apprentissage passé contribue à l’apprentissage futur. Et le plus gros problème à l'heure actuelle est que nous ne disposons pas de bons ensembles de données pour étudier l'apprentissage continu. Nous prenons essentiellement les ensembles de données existants utilisés dans l'apprentissage automatique traditionnel et les développons à partir de zéro.

De manière générale, le fonctionnement normal de l'apprentissage automatique est que nous avons un ensemble de formation et un ensemble de test - nous nous entraînons sur l'ensemble de formation et testons sur l'ensemble de test.

Mais l'apprentissage continu brise ces règles. Il permet à l'ensemble de formation de se développer au fur et à mesure que le formateur apprend, nous avons donc besoin d'un très bon environnement d'apprentissage continu.

4. À quoi devrait ressembler un environnement d’apprentissage continu idéal ?

Il est plus facile de vous dire ce que ce n’est pas que ce que c’est.

Je peux vous indiquer les propriétés qu'il peut avoir. Donc pour l'instant, supposons que l'algorithme d'IA n'est pas une intelligence incarnée dans la simulation. Et puis au moins, idéalement, nous apprenons de la vidéo, ou quelque chose comme ça, comme un flux vidéo multimodal, et voulons faire plus que simplement classer des images statiques.

Il y a beaucoup de questions ouvertes à ce sujet. J'étais à un atelier d'apprentissage continu il y a quelques années, et certaines personnes comme moi ont dit : « Nous devons arrêter d'utiliser un ensemble de données appelé MNIST, c'est trop simple. Et puis quelqu'un a dit : « Eh bien, alors nous allons passer à l'incrémental ». apprendre dans StarCraft

Je fais cela maintenant pour diverses raisons, mais je ne pense pas que ce soit suffisant pour vraiment résoudre le problème. Après tout, il y a bien plus dans la vie que d’apprendre à jouer à StarCraft.

5. Comment votre laboratoire essaie-t-il de concevoir des algorithmes qui apprennent au fil du temps ?

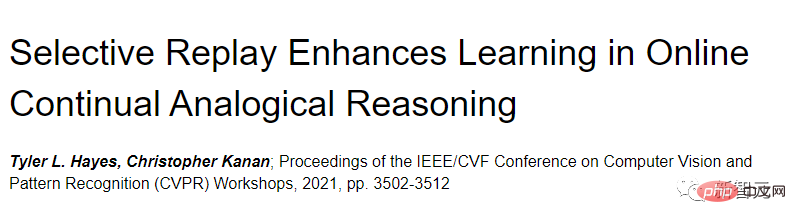

Mon ancien élève Tyler Hayes et moi avons lancé une étude d'apprentissage continu sur le raisonnement analogique. Cet article a également été publié dans CVPR 2021.

Lien papier : https://openaccess.thecvf.com/content/CVPR2021W/CLVision/html/Hayes_Selective_Replay_Enhances_Learning_in_Online_Continual_Analogical_Reasoning_CVPRW_2021_paper.html

Nous pensons que ce sera un bon moyen d'étudier le concept de transfert Domaine d'apprentissage parce que nous Plus des compétences sophistiquées sont désormais nécessaires pour résoudre des problèmes plus complexes.

Plus précisément, nous avons mesuré les données sur le transfert vers l'arrière, c'est-à-dire la quantité d'apprentissage passé qui vous aidera à l'avenir, et vice versa.

Nous avons trouvé de bonnes preuves de transfert, bien plus importantes que de simples tâches comme la reconnaissance d'objets.

6. Pensez-vous que l’intelligence artificielle apprendra vraiment comme les humains ?

Je pense qu’ils le feront. De nombreuses personnes extrêmement talentueuses travaillent à cet objectif dans ce domaine.

Mais ce dont nous avons besoin, c'est de créativité. De nombreuses études dans la communauté de l’apprentissage automatique sont basées sur des recherches antérieures et apportent quelques petites améliorations, et il n’existe pas beaucoup d’études véritablement transformatrices.

Mais ce jour viendra certainement, ce n’est qu’une question de temps.

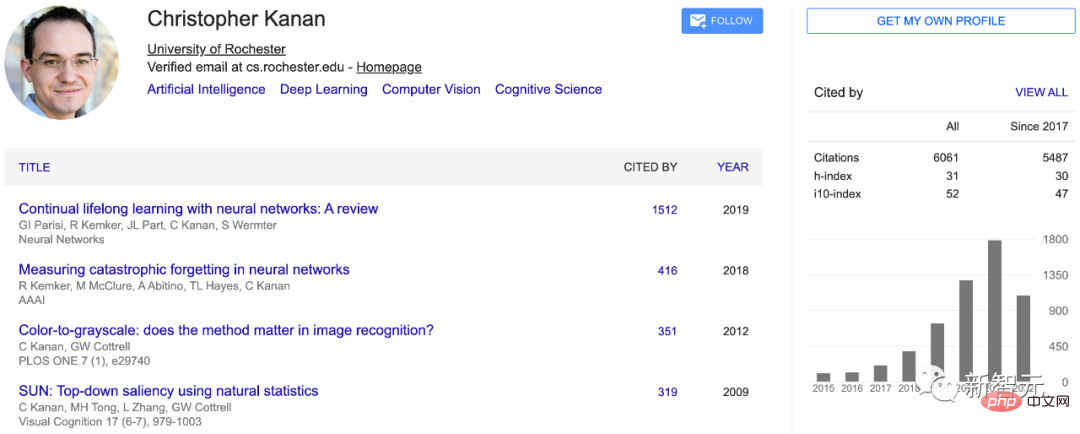

Christopher Kanan

Christopher Kanan est professeur agrégé titulaire d'informatique à l'Université de Rochester. L'orientation principale du travail est la recherche fondamentale sur l'apprentissage profond, y compris l'apprentissage continu, les biais en matière d'intelligence artificielle, la vision médicale par ordinateur et la compréhension de scènes guidée par le langage.

Kanan a travaillé dans l'apprentissage continu en ligne, la réponse visuelle aux questions, la pathologie informatique, la segmentation sémantique, la reconnaissance d'objets, la détection d'objets, la vision active, le suivi d'objets, etc. En plus de l'apprentissage automatique, il possède une solide expérience en suivi oculaire, en vision des primates et en neurosciences théoriques.

Avant cela, il était professeur agrégé titulaire au Carlson Center for Imaging Sciences du Rochester Institute of Technology (RIT). Au cours de son mandat, il a cofondé le Center for Human Conscious Artificial Intelligence (CHAI) avec ses collègues et en a été directeur adjoint pendant quatre ans. En outre, Kanan était professeur associé invité à l'Université de technologie de Cornell, enseignant des cours d'apprentissage profond à environ 100 étudiants diplômés chaque année pendant 4 ans.

Christopher Kanan a grandi dans une petite ville de la campagne de l'Oklahoma.

En 1996, il a commencé à explorer l'intelligence artificielle alors qu'il était encore au lycée, Kanan a créé de nombreux « robots » pour jouer à des jeux informatiques multijoueurs en ligne.

En 2002, Kanan a été admis à l'Oklahoma State University (OSU), avec une spécialisation en philosophie et en informatique, et a obtenu son baccalauréat en 2004.

En 2006, j'ai obtenu une maîtrise en informatique de l'Université de Californie du Sud (USC), axée sur l'intelligence artificielle et les neurosciences, et en collaboration avec Michael Arbib, un pionnier des neurosciences computationnelles et des réseaux de neurones. En 2013, il a obtenu son doctorat en informatique de l'Université de Californie à San Diego (UCSD). Après avoir obtenu son diplôme, Kanan est allé au California Institute of Technology pour entreprendre des recherches postdoctorales.

Référence : https://www.quantamagazine.org/the-computer-scientist-trying-to-teach-ai-to-learn-like-we-do-20220802/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

MySQL ne peut pas être installé après le téléchargement

Apr 08, 2025 am 11:24 AM

Les principales raisons de la défaillance de l'installation de MySQL sont les suivantes: 1. Problèmes d'autorisation, vous devez s'exécuter en tant qu'administrateur ou utiliser la commande sudo; 2. Des dépendances sont manquantes et vous devez installer des packages de développement pertinents; 3. Conflits du port, vous devez fermer le programme qui occupe le port 3306 ou modifier le fichier de configuration; 4. Le package d'installation est corrompu, vous devez télécharger et vérifier l'intégrité; 5. La variable d'environnement est mal configurée et les variables d'environnement doivent être correctement configurées en fonction du système d'exploitation. Résolvez ces problèmes et vérifiez soigneusement chaque étape pour installer avec succès MySQL.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Laravel Eloquent Orm dans Bangla Partial Model Search)

Apr 08, 2025 pm 02:06 PM

Laravel Eloquent Orm dans Bangla Partial Model Search)

Apr 08, 2025 pm 02:06 PM

Laravelelognent Model Retrieval: Faconttement l'obtention de données de base de données Eloquentorm fournit un moyen concis et facile à comprendre pour faire fonctionner la base de données. Cet article présentera en détail diverses techniques de recherche de modèles éloquentes pour vous aider à obtenir efficacement les données de la base de données. 1. Obtenez tous les enregistrements. Utilisez la méthode All () pour obtenir tous les enregistrements dans la table de base de données: usApp \ Modèles \ Post; $ poters = post :: all (); Cela rendra une collection. Vous pouvez accéder aux données à l'aide de Foreach Loop ou d'autres méthodes de collecte: ForEach ($ PostsAs $ POST) {echo $ post->