Périphériques technologiques

Périphériques technologiques

IA

IA

Dernières avancées dans les modèles clairsemés ! Ma Yi + LeCun unissent leurs forces : apprentissage non supervisé « boîte blanche »

Dernières avancées dans les modèles clairsemés ! Ma Yi + LeCun unissent leurs forces : apprentissage non supervisé « boîte blanche »

Dernières avancées dans les modèles clairsemés ! Ma Yi + LeCun unissent leurs forces : apprentissage non supervisé « boîte blanche »

Récemment, le professeur Ma Yi et Yann LeCun, lauréat du prix Turing, ont publié conjointement un article à l'ICLR 2023, décrivant une méthode d'apprentissage non supervisé minimaliste et interprétable qui ne nécessite pas de recourir à l'amélioration des données, à l'ajustement d'hyperparamètres ou à d'autres conceptions techniques, vous pouvez atteindre des performances proches de la méthode SOTA SSL.

Lien papier : https://arxiv.org/abs/2209.15261

Cette méthode utilise la transformation multiple clairsemée pour combiner le codage clairsemé, l'apprentissage multiple et l'analyse de fonctionnalités lentes (lent analyse des caractéristiques) combinées.

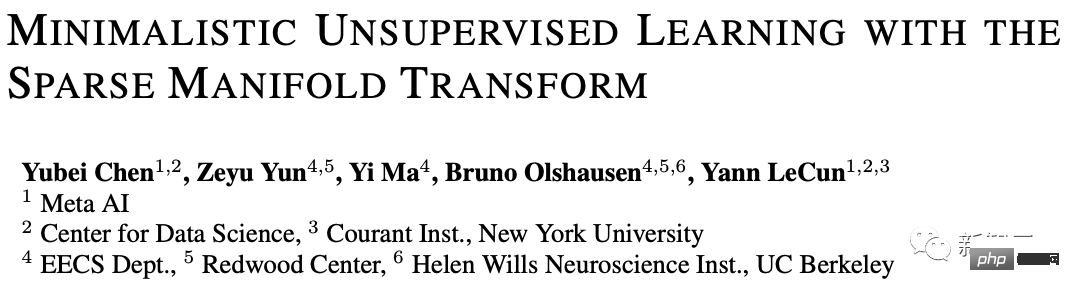

En utilisant la transformation de variété déterministe clairsemée monocouche, il peut atteindre une précision KNN top-1 de 99,3 % sur MNIST, 81,1 % de précision KNN top-1 sur CIFAR-10 et 81,1 % de précision KNN top-1 sur CIFAR-100. . A atteint une précision top-1 de 53,2 %.

Grâce à une simple amélioration des niveaux de gris, la précision du modèle sur CIFAR-10 et CIFAR-100 a atteint respectivement 83,2 % et 57 %. Ces résultats ont considérablement réduit l'écart entre la méthode simple « boîte blanche » et la méthode SOTA. .

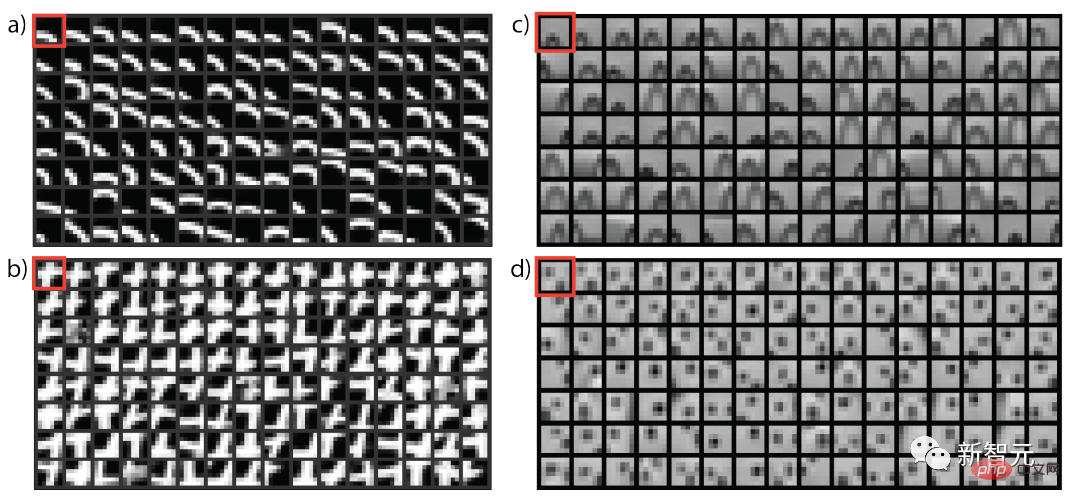

De plus, l'article fournit également une explication visuelle de la façon de former une transformation de représentation non supervisée. Cette méthode est étroitement liée à la méthode auto-supervisée d'intégration latente et peut être considérée comme la méthode VICReg la plus simple.

Bien qu'il existe encore un petit écart de performance entre notre modèle constructif simple et l'approche SOTA, il est prouvé qu'il s'agit d'une direction prometteuse pour parvenir à un apprentissage non supervisé en boîte blanche fondé sur des principes.

Le premier auteur de l'article, Yubei Chen, est assistant postdoctoral au Center for Data Science (CDS) et Meta Basic Artificial Intelligence Research (FAIR) de l'Université de New York. Son superviseur est le professeur Yann LeCun. avec un doctorat en neurologie théorique du Redwood Center de l'Université de Californie à Berkeley et du Berkeley Artificial Intelligence Institute (BAIR), avec un baccalauréat de l'Université Tsinghua.

La principale direction de recherche est l'intersection de l'apprentissage des neurosciences computationnelles et de l'apprentissage profond non supervisé (auto-supervisé). Les résultats de la recherche améliorent la compréhension des principes informatiques de l'apprentissage des représentations non supervisé dans le cerveau et la machine, et le remodeler Une compréhension des statistiques des signaux naturels.

Le professeur Ma Yi a obtenu une double licence en automatisation et mathématiques appliquées de l'Université Tsinghua en 1995, une maîtrise en EECS de l'Université de Californie à Berkeley en 1997, ainsi qu'une maîtrise en mathématiques et un doctorat en EECS en 2000. Il est actuellement professeur au Département de génie électrique et d'informatique de l'Université de Californie à Berkeley, et est également membre de l'IEEE, de l'ACM et du SIAM.

L'œuvre la plus célèbre de Yann LeCun est l'utilisation des réseaux de neurones convolutifs (CNN) dans la reconnaissance optique de caractères et la vision par ordinateur. Il est également connu comme le père des réseaux convolutifs en 2019, lui, Bengio et Hinton ont remporté conjointement le prix le plus élevé. honneur en informatique Prix Turing Award.

Commencez par l'apprentissage non supervisé le plus simple

L'apprentissage des représentations non supervisé a fait d'énormes progrès au cours des dernières années et devrait offrir une forte évolutivité dans l'apprentissage automatique basé sur les données.

Cependant, ce qu'est une représentation apprise et comment exactement elle est formée de manière non supervisée ne sont toujours pas clairs. De plus, il n'est toujours pas clair s'il existe un ensemble commun de principes qui sous-tendent toutes ces représentations non supervisées ;

De nombreux chercheurs ont réalisé l'importance d'améliorer la compréhension des modèles et ont pris des mesures pionnières pour tenter de simplifier la méthode SOTA, d'établir des liens avec les méthodes classiques, d'unifier différentes méthodes et de visualiser les représentations, et d'analyser ces méthodes d'un point de vue théorique. , dans l'espoir de développer une théorie informatique différente : une théorie qui nous permette de construire des modèles de « boîte blanche » simples et entièrement interprétables à partir de données basées sur les premiers principes, qui peuvent également fournir un aperçu des principes de l'apprentissage non supervisé dans le cerveau humain. .

Dans ce travail, les chercheurs ont fait un petit pas de plus vers cet objectif, en essayant de construire le modèle d'apprentissage non supervisé de « boîte blanche » le plus simple qui ne nécessite pas de réseaux profonds, de têtes de projection, d'augmentation de données ou d'autres conceptions techniques diverses.

En utilisant deux principes classiques d'apprentissage non supervisé, à savoir la parcimonie et l'intégration spectrale, un modèle à deux couches est établi et obtient des résultats sur plusieurs ensembles de données standard obtenus des résultats de base non significatifs.

Les résultats expérimentaux montrent que le modèle à deux couches basé sur la transformation de variété clairsemée a le même objectif que la méthode auto-supervisée à intégration latente et atteint les meilleures performances sur MNIST sans aucune augmentation de données. La précision de niveau 1 la plus élevée de KNN est de 99,3 %, et la précision de niveau 1 la plus élevée de KNN est de 81,1 % sur CIFAR-10, et la précision est de 53,2 % sur CIFAR-100.

Grâce à une simple amélioration des niveaux de gris, nous avons en outre atteint une précision KNN top-1 de 83,2 % sur CIFAR-10 et une précision KNN top-1 de 57 % sur CIFAR-100.

Ces résultats franchissent une étape importante vers la réduction de l'écart entre les modèles de « boîte blanche » et les modèles SOTA auto-supervisés (SSL). Bien que l'écart soit encore important, les chercheurs pensent qu'en le réduisant davantage, il est possible de l'améliorer. la représentation non supervisée. Apprendre à mieux comprendre est également une voie de recherche prometteuse menant à l’application pratique de cette théorie.

Trois questions fondamentales

Qu'est-ce qu'une re-présentation non supervisée (auto-supervisée)

Essentiellement, toute transformation non identitaire du signal original est On pourrait l'appeler une re-présentation, mais les universitaires sont plus intéressés par les transformations utiles.

Un objectif macro de l'apprentissage par re-présentation non supervisé est de trouver une fonction qui transforme les données originales en un nouvel espace afin que les éléments « similaires » soient rapprochés en même temps, le nouvel espace ne doit pas être réduit et ; trivial, c'est-à-dire que la structure géométrique ou aléatoire des données doit être préservée.

Si cet objectif est atteint, alors les contenus « différents » seront naturellement placés loin dans l'espace de représentation.

D'où vient la similitude ?

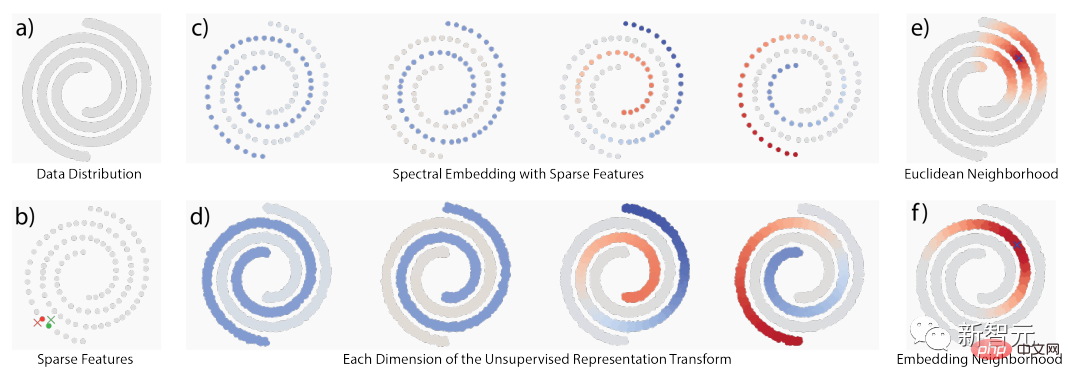

La similitude vient principalement de trois idées classiques : 1) la cooccurrence temporelle, 2) la cooccurrence spatiale et 3) les voisinages locaux dans l'espace du signal d'origine ;

Lorsque la structure sous-jacente est une structure géométrique, ces idées se chevauchent dans une mesure considérable ; mais lorsque la structure est une structure aléatoire, elles sont également conceptuellement différentes. La figure ci-dessous montre la structure multiple et la cooccurrence stochastique. structure.

En utilisant la localité, des travaux connexes proposent deux méthodes d'apprentissage non supervisé : l'apprentissage multiple et la modélisation statistique de cooccurrence Beaucoup de ces idées ont atteint la formulation d'une décomposition de lignée ou de matrices étroitement liées Décomposer l'expression.

Le concept d'apprentissage multiple est que seuls les quartiers locaux dans l'espace de signal d'origine sont crédibles. En considérant globalement tous les quartiers locaux, une géométrie globale émergera, c'est-à-dire une « pensée globale, adaptation locale » (penser globalement, s'adapter localement). ).

En revanche, la modélisation statistique de cooccurrence suit un concept probabiliste, car certaines structures ne peuvent pas être modélisées avec des variétés continues, elle est donc également complémentaire au concept de variété.

L'un des exemples les plus évidents vient du langage naturel, où les données originales ne proviennent fondamentalement pas d'une géométrie lisse. Par exemple, dans les intégrations de mots, les intégrations de "Seattle" et "Dallas" peuvent même être très similaires. bien qu’ils ne le soient pas, la raison fondamentale de leur cooccurrence fréquente est qu’ils ont des modèles de contexte similaires.

Les perspectives de probabilité et de variété sont complémentaires dans la compréhension de la « similarité ». Une fois qu'il existe une définition de la similarité, une transformation peut être construite pour rapprocher les concepts similaires.

Comment établir la transformation des représentations dans cet article ? Principes de base : parcimonie et rang bas

De manière générale, la parcimonie peut être utilisée pour gérer la localité et la décomposition dans l'espace de données afin d'établir un support, puis les fonctions basse fréquence sont utilisées pour construire des transformations de représentation pour transformer des valeurs similaires. affecté au point de similarité sur support.

L'ensemble du processus peut également être appelé transformation de variété clairsemée.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un