Périphériques technologiques

Périphériques technologiques

IA

IA

La recherche ML hors du cercle en 2022 : le populaire Stable Diffusion, l'agent généraliste Gato, LeCun retweets

La recherche ML hors du cercle en 2022 : le populaire Stable Diffusion, l'agent généraliste Gato, LeCun retweets

La recherche ML hors du cercle en 2022 : le populaire Stable Diffusion, l'agent généraliste Gato, LeCun retweets

2022 touche à sa fin. Au cours de cette année, un grand nombre d'articles précieux ont été publiés dans le domaine de l'apprentissage automatique, qui ont eu un impact profond sur la communauté de l'apprentissage automatique.

Aujourd'hui, Elvis S., chercheur en ML & NLP, responsable marketing produit de la technologie Meta AI et fondateur de DAIR.AI, a résumé 12 articles chauds sur l'apprentissage automatique en 2022. Le message est devenu viral et a été retweeté par Yann LeCun, lauréat du prix Turing.

Ensuite, jetons un coup d'œil un par un.

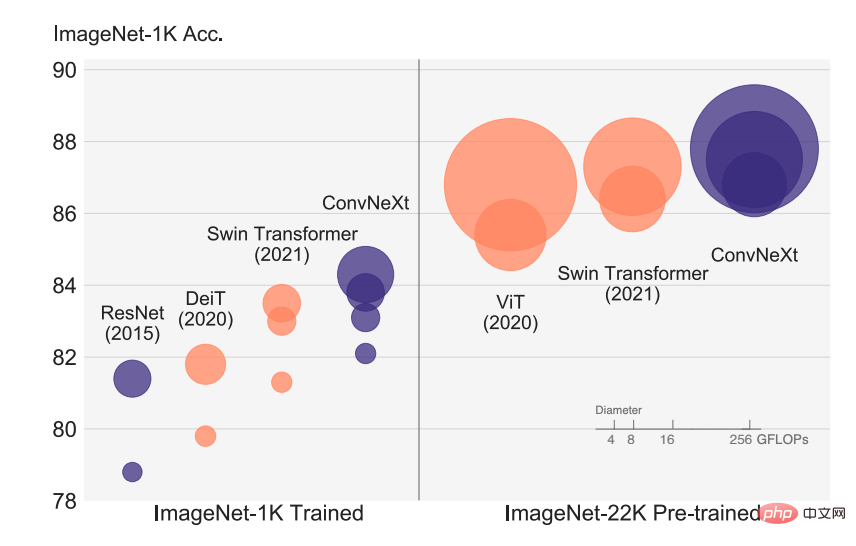

Article 1 : Un ConvNet pour les années 2020

Le développement rapide de la reconnaissance visuelle a commencé avec l'introduction de ViT, qui a rapidement remplacé le ConvNet traditionnel et est devenu le modèle de classification d'images SOTA. Le modèle ViT présente de nombreux défis dans une série de tâches de vision par ordinateur, notamment la détection de cibles, la segmentation sémantique, etc. Par conséquent, certains chercheurs ont proposé un Swin Transformer hiérarchique et ont réintroduit ConvNet auparavant, rendant Transformer réellement réalisable en tant que colonne vertébrale visuelle générale et montrant d'excellentes performances sur diverses tâches visuelles.

Cependant, l'efficacité de cette approche hybride est encore largement due aux avantages inhérents de Transformer plutôt qu'au biais inductif inhérent à la convolution. Dans cet article, des chercheurs de FAIR et de l'UC Berkeley ont réexaminé l'espace de conception et testé les limites de ce que le ConvNet pur peut réaliser. Les chercheurs ont progressivement « mis à niveau » le ResNet standard vers une conception de transformateur visuel et, ce faisant, ont découvert plusieurs composants clés à l'origine de la différence de performances.

Adresse du papier : https://arxiv.org/abs/2201.03545v2

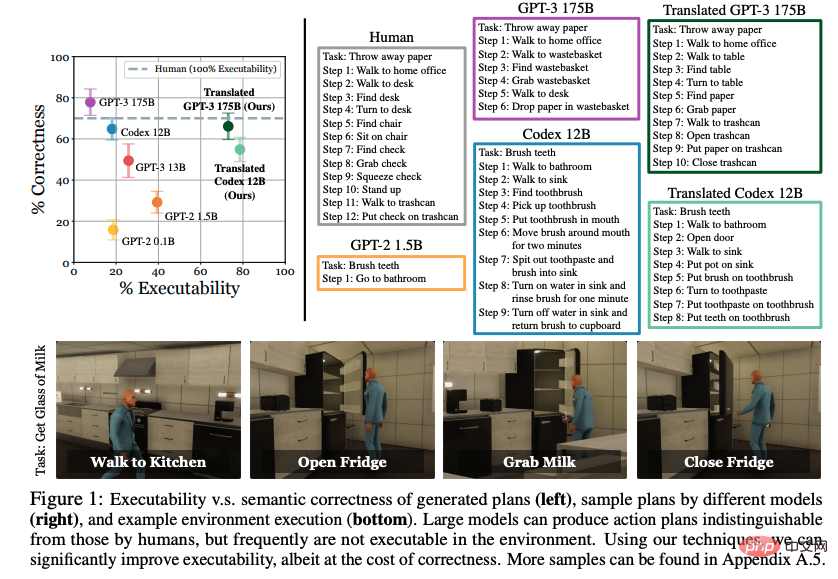

Papier 2 : Modèles linguistiques en tant que planificateurs Zero-Shot : Extraction de connaissances exploitables pour les agents incarnés

Les connaissances du monde acquises grâce aux grands modèles linguistiques (LLM) peuvent-elles être utilisées pour des actions dans des environnements interactifs ? Dans cet article, des chercheurs de l'UC Berkeley, de la CMU et de Google explorent la possibilité d'exprimer le langage naturel sous la forme d'un ensemble d'étapes concrètes sélectionnées. Des travaux antérieurs se sont concentrés sur l'apprentissage de la manière d'agir à partir d'exemples explicitement distribués, mais ils ont découvert de manière surprenante que si le modèle de langage pré-entraîné est suffisamment grand et reçoit des conseils appropriés, les tâches de haut niveau peuvent être efficacement décomposées en planification de niveau intermédiaire sans formation supplémentaire. Cependant, les plans élaborés par LLM ne correspondent souvent pas avec précision aux actions acceptables.

Les étapes proposées par les chercheurs conditionnent les démonstrations existantes et transforment sémantiquement les plans en actions acceptables. Les évaluations dans un environnement VirtualHome montrent que l'approche proposée améliore considérablement l'exécutabilité des références LLM. L'évaluation humaine révèle un compromis entre l'applicabilité et l'exactitude, mais montre des signes de la possibilité d'extraire des connaissances exploitables à partir de modèles de langage.

Adresse du papier : https://arxiv.org/abs/2201.07207v2

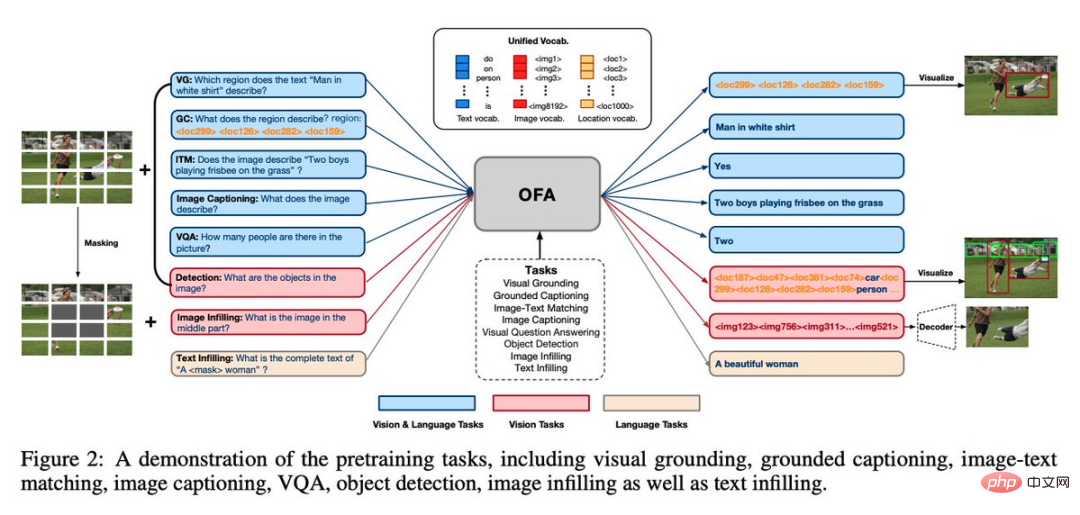

Papier 3 : OFA : Unifier les architectures, les tâches et les modalités grâce à un apprentissage simple séquence à séquence Framework

Il s'agit du cadre de modèle multimodal multitâche unifié OFA lancé par Alibaba Damo Academy. Il résume les trois caractéristiques qui correspondent le mieux au modèle général à ce stade, à savoir l'indépendance des modalités, l'indépendance des tâches et. diversité des tâches. Cet article a été accepté par l'ICML 2022.

Dans le domaine des graphiques et du texte, OFA représente des tâches classiques telles que la mise à la terre visuelle, le VQA, la légende d'image, la classification d'image, la génération text2image et la modélisation du langage via un cadre seq2seq unifié, partageant l'entrée et la sortie de différentes modalités entre les tâches. et gardez Finetune cohérent avec la pré-formation sans ajouter de structures de paramètres supplémentaires.

Adresse du papier : https://arxiv.org/abs/2202.03052v2

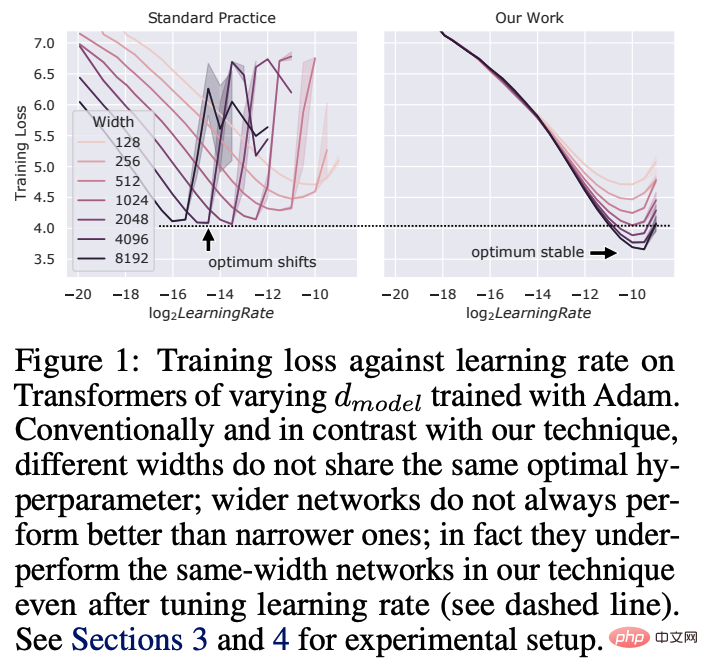

Papier 4 : Programmes Tensor V : Réglage de grands réseaux neuronaux via un transfert d'hyperparamètres Zero-Shot

Dans l'hyperparamètre d'apprentissage profond Le réglage (HP) est un processus coûteux, en particulier pour les réseaux de neurones comportant des milliards de paramètres. Dans cet article, des chercheurs de Microsoft et OpenAI montrent que dans le paramétrage de mise à jour maximale (muP) récemment découvert, de nombreux HP optimaux restent stables même si la taille du modèle change.

Cela a conduit à un nouveau paradigme de réglage HP qu'ils ont appelé muTransfer, qui consiste à paramétrer le modèle cible dans muP, à ne pas effectuer de réglage HP directement sur des modèles plus petits, et à les migrer sans tir vers le modèle pleine grandeur, cela signifie également que ce dernier modèle n'a pas du tout besoin d'être réglé directement. Les chercheurs ont vérifié muTransfer sur Transformer et ResNet. Par exemple, en migrant à partir d'un modèle de 40 M de paramètres, les performances sont meilleures que celles du modèle GPT-3 de 6,7 B publié, avec un coût de réglage de seulement 7 % du coût total de pré-formation.

Adresse papier : https://arxiv.org/abs/2203.03466v2

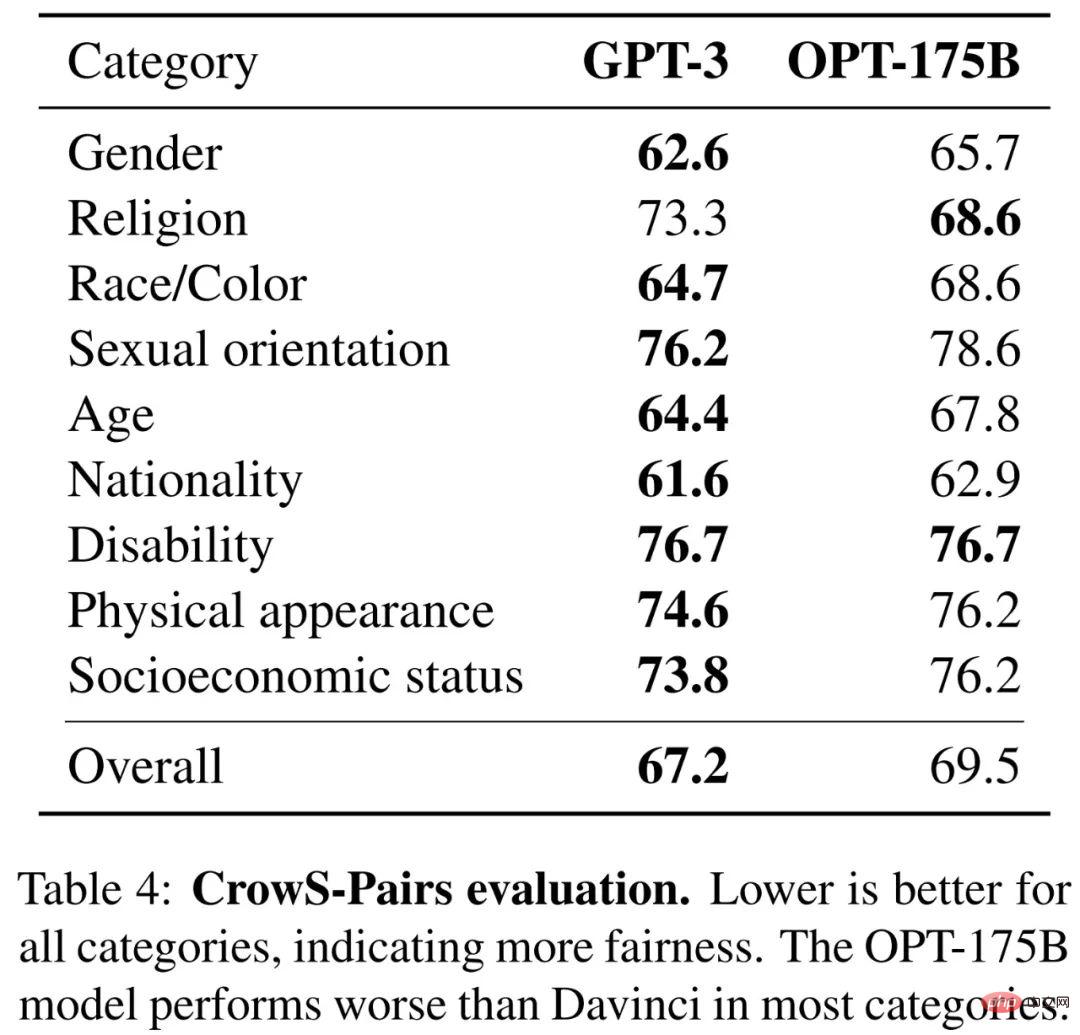

Papier 5 : OPT : Modèles ouverts de langage de transformateur pré-entraînés

Grands modèles y aller souvent Grâce à des milliers de jours de formation informatique, ils démontrent des capacités extraordinaires en matière d'apprentissage à zéro et à quelques coups. Mais compte tenu de leur coût de calcul, ces grands modèles sont difficiles à reproduire sans un financement adéquat. Pour les quelques modèles disponibles via l'API, il n'y a pas d'accès à leurs poids complets, ce qui rend leur étude difficile.

Dans cet article, les chercheurs de Meta AI proposent des Open Pre-trained Transformers (OPT), qui est un ensemble de modèles de transformateurs pré-entraînés uniquement pour les décodeurs, avec des paramètres allant de 125M à 175B. Ils ont montré que l’OPT-175B avait des performances comparables à celles du GPT-3, mais qu’il ne nécessitait que 1/7 de l’empreinte carbone pour se développer.

Adresse du papier : https://arxiv.org/abs/2205.01068v4

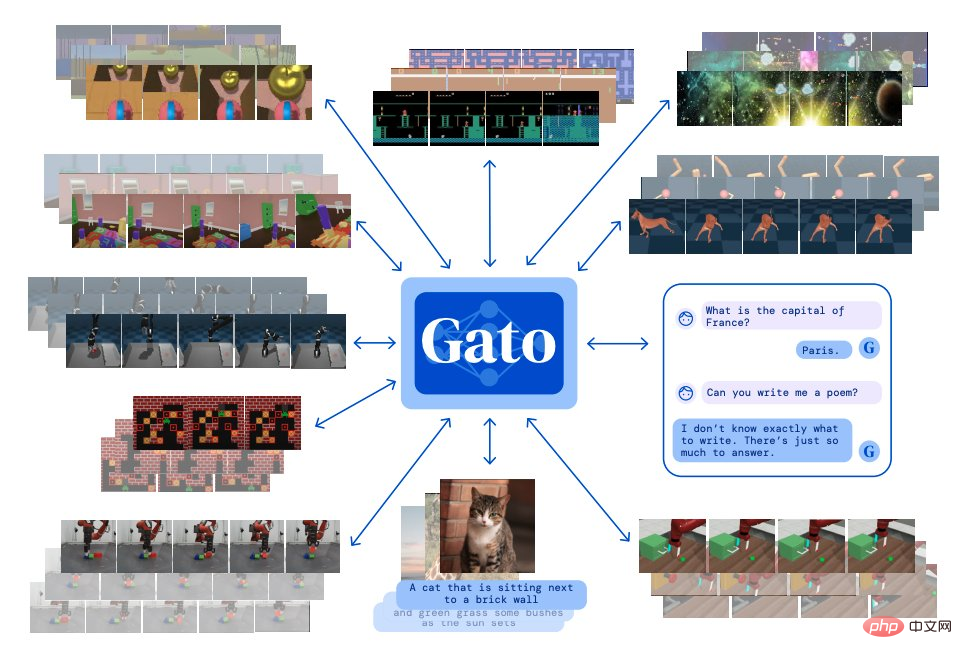

Papier 6 : Un agent généraliste

Inspiré par la modélisation du langage à grande échelle , Esprit profond A Un seul agent « généraliste » Gato est construit, qui présente les caractéristiques de multimodalité, de multitâche et de multi-incarnation.

Gato peut jouer à des jeux Atari, produire des sous-titres pour les images, discuter avec d'autres, empiler des blocs avec un bras robotique, et bien plus encore. De plus, Gato peut décider d'afficher du texte, des couples d'articulation, des pressions sur des boutons ou d'autres jetons en fonction du contexte.

Contrairement à la plupart des agents jouant à des jeux, Gato peut jouer à de nombreux jeux en utilisant le même modèle de formation sans avoir à s'entraîner séparément pour chaque jeu.

Adresse de l'article : https://arxiv.org/abs/2205.06175v3

Article 7 : Résoudre des problèmes de raisonnement quantitatif avec des modèles linguistiques

De Les chercheurs de Gu Song ont proposé de développer un modèle de langage d'apprentissage profond appelé Minerva qui peut résoudre des problèmes mathématiques quantitatifs grâce à un raisonnement étape par étape. Ses solutions incluent des calculs numériques et des manipulations symboliques sans recourir à des outils externes tels que des calculatrices.

De plus, Minerva combine plusieurs techniques, notamment de petits exemples d'invites, un enchaînement de pensées, des invites de bloc-notes et des principes de vote majoritaire pour obtenir des performances SOTA sur les tâches de raisonnement STEM.

Minerva est construit sur la base de PaLM (Pathways Language Model) et est en outre formé sur un ensemble de données de 118 Go. L'ensemble de données provient d'articles arXiv sur la technologie et de pages Web qui utilisent LaTeX, MathJax ou d'autres données d'expressions mathématiques. pour une formation complémentaire.

L'image ci-dessous montre un exemple de la façon dont Minerva résout le problème :

Adresse papier : https://arxiv.org/abs/2206.14858

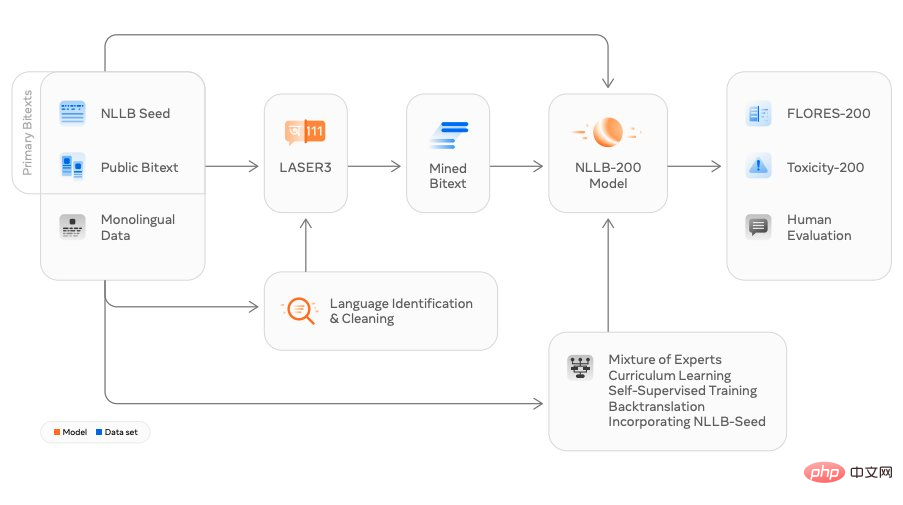

Papier 8 : Pas de langue Left Behind: Scaling Human-Centered Machine Translation

Des chercheurs de Meta AI ont publié le modèle de traduction NLLB (No Language Left Behind), qui se traduit littéralement par « Aucune langue ne peut être laissée pour compte », qui peut prendre en charge toute traduction entre Plus de 200 langues, en plus de la traduction de langues couramment utilisées telles que le chinois, l'anglais, le français et le japonais, NLLB peut également traduire de nombreuses langues de niche, notamment le luganda, l'ourdou, etc.

Meta affirme qu'il s'agit de la première conception au monde qui utilise un modèle unique pour traduire en plusieurs langues. Ils espèrent que cela aidera davantage de personnes à interagir dans plusieurs langues sur les plateformes sociales tout en améliorant l'expérience des utilisateurs dans le futur métaverse interactif. expérience.

Adresse de l'article : https://arxiv.org/abs/2207.04672v3

Article 9 : Synthèse d'images haute résolution avec modèles de diffusion latente

période récente La diffusion stable est devenue populaire ces dernières années et il existe d’innombrables études autour de cette technologie.

Cette recherche est basée sur l'article CVPR 2022 "Synthèse d'images haute résolution avec modèles de diffusion latente" par des chercheurs de l'Université de Munich et Runway, et a été réalisée en collaboration avec des équipes telles qu'Eleuther AI et LAION. Stable Diffusion peut fonctionner sur un GPU grand public avec 10 Go de VRAM et génère une image de 512 x 512 pixels en quelques secondes sans pré- et post-traitement.

En seulement quatre mois, ce projet open source a reçu 38K étoiles.

Adresse du projet : https://github.com/CompVis/stable-diffusion

Affichage d'un exemple d'image générée par diffusion stable :

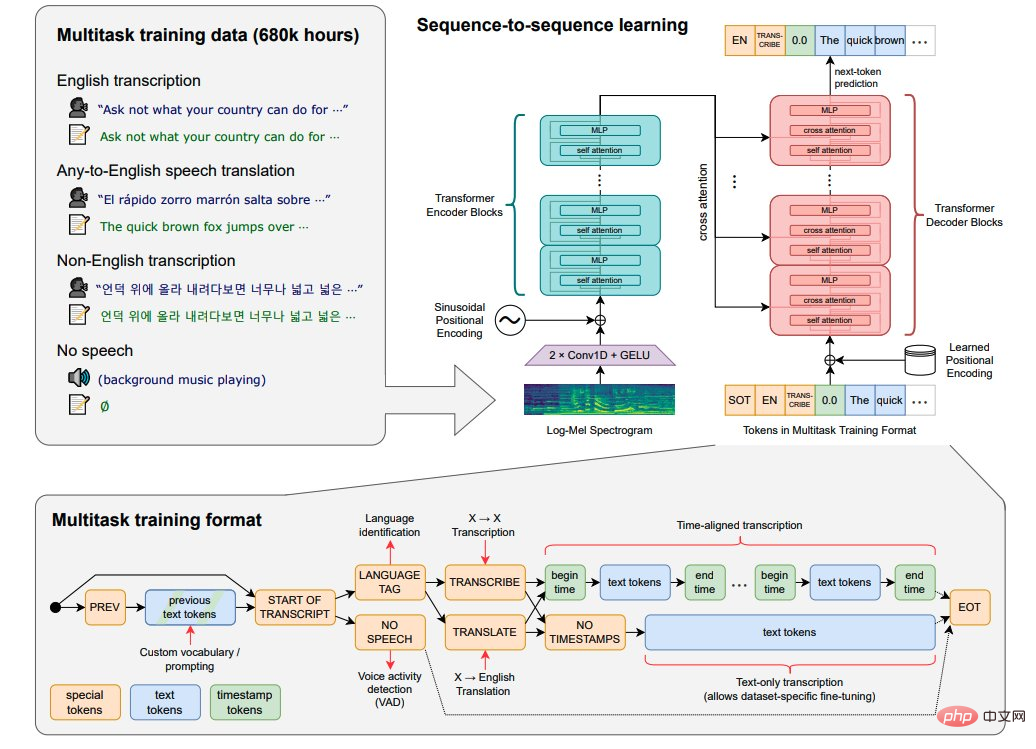

Papier 10 : Reconnaissance vocale robuste via Large-Scale Weak Supervision

OpenAI publie le modèle open source Whisper, qui est proche du niveau humain en matière de reconnaissance vocale en anglais et a une grande précision.

Whisper est un système de reconnaissance vocale automatique (ASR, Automatic Speech Recognition). Whisper a été formé par OpenAI en collectant 680 000 heures de 98 langues et des données supervisées multitâches à partir d'Internet. En plus de la reconnaissance vocale, Whisper peut également transcrire plusieurs langues et traduire ces langues en anglais.

Adresse du papier : https://arxiv.org/abs/2212.04356

Papier 11 : Créer une vidéo : génération de texte en vidéo sans données texte-vidéo

De Meta Les chercheurs en IA ont proposé un modèle de pointe de conversion texte-vidéo : Make-A-Video, qui peut générer une vidéo à partir d'une invite de texte donnée.

Make-A-Video présente trois avantages : (1) il accélère la formation des modèles T2V (Text-to-Video) sans avoir besoin d'apprendre des représentations visuelles et multimodales à partir de zéro, (2) il ne nécessitent un couplage de données texte-vidéo, (3) la vidéo générée hérite de nombreux avantages des modèles de génération d’images actuels.

Cette technologie est conçue pour générer du texte en vidéo, produisant des vidéos uniques en utilisant seulement quelques mots ou lignes de texte. L'image ci-dessous montre un chien portant des vêtements de super-héros et une cape rouge, volant dans le ciel :

Adresse papier : https://arxiv.org/abs/2209.14792

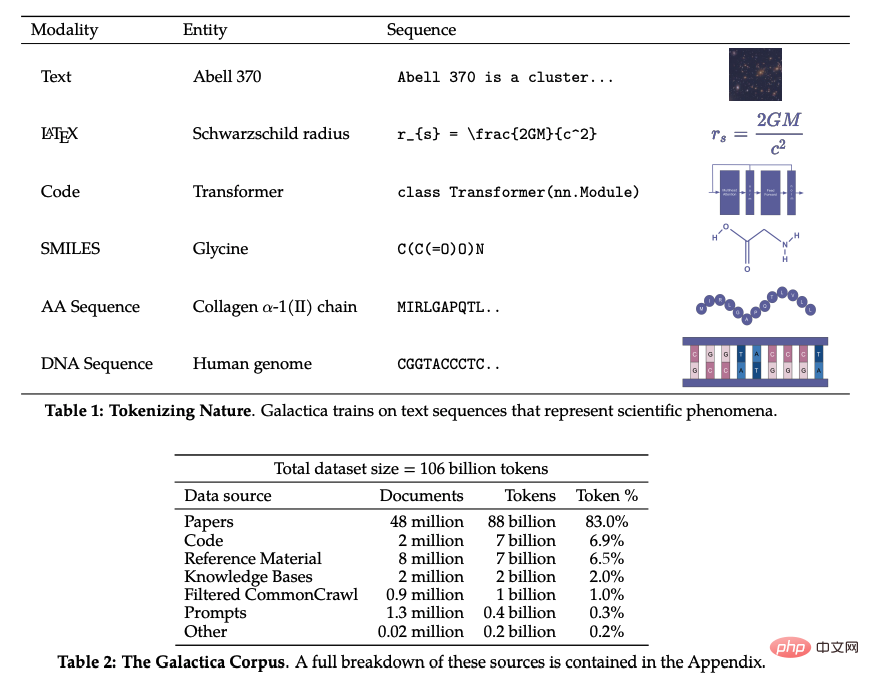

Papier 12 : Galactica : Un grand modèle linguistique pour la science

Ces dernières années, avec l'avancement de la recherche dans divers domaines, la littérature et les données scientifiques ont explosé, permettant aux chercheurs universitaires de découvrir des informations utiles à partir de grandes quantités d'informations. difficile. Habituellement, les gens utilisent les moteurs de recherche pour obtenir des connaissances scientifiques, mais les moteurs de recherche ne peuvent pas organiser les connaissances scientifiques de manière autonome.

Récemment, l'équipe de recherche de Meta AI a proposé un nouveau modèle de langage à grande échelle Galactica qui peut stocker, combiner et raisonner sur des connaissances scientifiques. Galactica peut résumer un article de synthèse, générer des requêtes encyclopédiques d'entrées et fournir des réponses éclairées aux questions.

Adresse papier : https://arxiv.org/abs/2211.09085

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1660

1660

14

14

1417

1417

52

52

1311

1311

25

25

1261

1261

29

29

1234

1234

24

24

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

L'annotation d'images est le processus consistant à associer des étiquettes ou des informations descriptives à des images pour donner une signification et une explication plus profondes au contenu de l'image. Ce processus est essentiel à l’apprentissage automatique, qui permet d’entraîner les modèles de vision à identifier plus précisément les éléments individuels des images. En ajoutant des annotations aux images, l'ordinateur peut comprendre la sémantique et le contexte derrière les images, améliorant ainsi la capacité de comprendre et d'analyser le contenu de l'image. L'annotation d'images a un large éventail d'applications, couvrant de nombreux domaines, tels que la vision par ordinateur, le traitement du langage naturel et les modèles de vision graphique. Elle a un large éventail d'applications, telles que l'assistance aux véhicules pour identifier les obstacles sur la route, en aidant à la détection. et le diagnostic des maladies grâce à la reconnaissance d'images médicales. Cet article recommande principalement de meilleurs outils d'annotation d'images open source et gratuits. 1.Makesens

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Cet article présentera comment identifier efficacement le surajustement et le sous-apprentissage dans les modèles d'apprentissage automatique grâce à des courbes d'apprentissage. Sous-ajustement et surajustement 1. Surajustement Si un modèle est surentraîné sur les données de sorte qu'il en tire du bruit, alors on dit que le modèle est en surajustement. Un modèle surajusté apprend chaque exemple si parfaitement qu'il classera mal un exemple inédit/inédit. Pour un modèle surajusté, nous obtiendrons un score d'ensemble d'entraînement parfait/presque parfait et un score d'ensemble/test de validation épouvantable. Légèrement modifié : "Cause du surajustement : utilisez un modèle complexe pour résoudre un problème simple et extraire le bruit des données. Parce qu'un petit ensemble de données en tant qu'ensemble d'entraînement peut ne pas représenter la représentation correcte de toutes les données."

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

Dans les années 1950, l’intelligence artificielle (IA) est née. C’est à ce moment-là que les chercheurs ont découvert que les machines pouvaient effectuer des tâches similaires à celles des humains, comme penser. Plus tard, dans les années 1960, le Département américain de la Défense a financé l’intelligence artificielle et créé des laboratoires pour poursuivre son développement. Les chercheurs trouvent des applications à l’intelligence artificielle dans de nombreux domaines, comme l’exploration spatiale et la survie dans des environnements extrêmes. L'exploration spatiale est l'étude de l'univers, qui couvre l'ensemble de l'univers au-delà de la terre. L’espace est classé comme environnement extrême car ses conditions sont différentes de celles de la Terre. Pour survivre dans l’espace, de nombreux facteurs doivent être pris en compte et des précautions doivent être prises. Les scientifiques et les chercheurs pensent qu'explorer l'espace et comprendre l'état actuel de tout peut aider à comprendre le fonctionnement de l'univers et à se préparer à d'éventuelles crises environnementales.

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

En termes simples, un modèle d’apprentissage automatique est une fonction mathématique qui mappe les données d’entrée à une sortie prédite. Plus précisément, un modèle d'apprentissage automatique est une fonction mathématique qui ajuste les paramètres du modèle en apprenant à partir des données d'entraînement afin de minimiser l'erreur entre la sortie prédite et la véritable étiquette. Il existe de nombreux modèles dans l'apprentissage automatique, tels que les modèles de régression logistique, les modèles d'arbre de décision, les modèles de machines à vecteurs de support, etc. Chaque modèle a ses types de données et ses types de problèmes applicables. Dans le même temps, il existe de nombreux points communs entre les différents modèles, ou il existe une voie cachée pour l’évolution du modèle. En prenant comme exemple le perceptron connexionniste, en augmentant le nombre de couches cachées du perceptron, nous pouvons le transformer en un réseau neuronal profond. Si une fonction noyau est ajoutée au perceptron, elle peut être convertie en SVM. celui-ci

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

MetaFAIR s'est associé à Harvard pour fournir un nouveau cadre de recherche permettant d'optimiser le biais de données généré lors de l'apprentissage automatique à grande échelle. On sait que la formation de grands modèles de langage prend souvent des mois et utilise des centaines, voire des milliers de GPU. En prenant comme exemple le modèle LLaMA270B, sa formation nécessite un total de 1 720 320 heures GPU. La formation de grands modèles présente des défis systémiques uniques en raison de l’ampleur et de la complexité de ces charges de travail. Récemment, de nombreuses institutions ont signalé une instabilité dans le processus de formation lors de la formation des modèles d'IA générative SOTA. Elles apparaissent généralement sous la forme de pics de pertes. Par exemple, le modèle PaLM de Google a connu jusqu'à 20 pics de pertes au cours du processus de formation. Le biais numérique est à l'origine de cette imprécision de la formation,