Périphériques technologiques

Périphériques technologiques

IA

IA

Vitesse d'échantillonnage par diffusion stable doublée ! Algorithme d'échantillonnage du modèle de diffusion en seulement 10 à 25 étapes

Vitesse d'échantillonnage par diffusion stable doublée ! Algorithme d'échantillonnage du modèle de diffusion en seulement 10 à 25 étapes

Vitesse d'échantillonnage par diffusion stable doublée ! Algorithme d'échantillonnage du modèle de diffusion en seulement 10 à 25 étapes

Pour parler des développements les plus influents dans le domaine de l'IA cette année, la cartographie explosive de l'IA en fait certainement partie. Les concepteurs n'ont qu'à saisir une description textuelle de l'image et l'IA générera une image haute résolution d'une qualité extrêmement élevée. Actuellement, le modèle le plus largement utilisé est le modèle open source Stable Diffusion de StabilityAI. Une fois que le modèle a été open source, il a suscité de larges discussions dans la communauté.

Cependant, le plus gros problème lors de l'utilisation du modèle de diffusion est sa vitesse d'échantillonnage extrêmement lente. L'échantillonnage du modèle doit commencer à partir d'images de bruit pur et débruiter continuellement étape par étape pour finalement obtenir des images claires. Dans ce processus, le modèle doit calculer au moins 50 à 100 étapes en série pour obtenir une image de meilleure qualité. Cela se traduit par un temps nécessaire pour générer une image 50 à 100 fois supérieur à celui des autres modèles de génération profonde, ce qui limite considérablement le déploiement du modèle. et la mise en œuvre.

Afin d'accélérer l'échantillonnage des modèles de diffusion, de nombreux chercheurs partent du point de vue de l'optimisation matérielle. Par exemple, Google utilise le langage JAX pour compiler et exécuter le modèle sur TPU, et l'équipe OneFlow [1] utilise un self. -compilateur développé pour obtenir une image de diffusion stable en une seconde. Ces méthodes sont basées sur l'algorithme d'échantillonnage en 50 étapes PNDM [2], dont l'effet d'échantillonnage diminue fortement lorsque le nombre d'étapes est réduit.

Il y a quelques jours à peine, ce record était à nouveau battu ! La mise à jour officielle Demo[3] de Stable Diffusion montre que le temps d'échantillonnage de 8 images a été directement réduit de 8 secondes d'origine à 4 secondes ! C'est deux fois plus rapide !

L'équipe OneFlow, basée sur une technologie de compilateur d'apprentissage profond auto-développée, a réussi à raccourcir l'ancienne « sortie d'image en une seconde » en « sortie d'image en une demi-seconde » sans réduire l'effet d'échantillonnage ! Obtenez une image haute définition en moins de 0,5 seconde sur le GPU ! Des travaux connexes ont été publiés dans [1].

En fait, le cœur de ces travaux vient du DPM-Solver proposé par l'équipe TSAIL dirigée par le professeur Zhu Jun de l'Université Tsinghua, un solveur efficace spécialement conçu pour les modèles de diffusion : cet algorithme ne nécessite aucun outil supplémentaire. la formation, adaptée aux modèles de diffusion en temps discret et en temps continu, peut presque converger en 20 à 25 étapes, et un échantillonnage de très haute qualité peut être obtenu en seulement 10 à 15 étapes. En diffusion stable, un solveur DPM à 25 étapes peut obtenir une meilleure qualité d'échantillonnage qu'un PNDM à 50 étapes, de sorte que la vitesse d'échantillonnage est directement doublée !

Lien du projet :

- DPM-Solver : Un solveur ODE rapide pour l'échantillonnage de modèles probabilistes de diffusion en 10 étapes environ : https://arxiv.org/abs/2206.00927 (NeurIPS 2022 Oral)

- DPM-Solver++ : Solveur rapide pour l'échantillonnage guidé de modèles probabilistes de diffusion : https://arxiv.org/abs/2211.01095

- Code open source du projet : https://github.com/LuChengTHU/dpm-solver

- Démo en ligne du projet : https://huggingface.co/spaces/LuChengTHU/dpmsolver_sdm

La définition et la méthode d'échantillonnage du modèle de diffusion

Le modèle de diffusion transforme progressivement l'image en gaussienne en définissant un processus avancé qui ajoute continuellement du bruit, puis définit un processus inverse pour débruiter progressivement le bruit gaussien en une image claire pour obtenir l'échantillon :

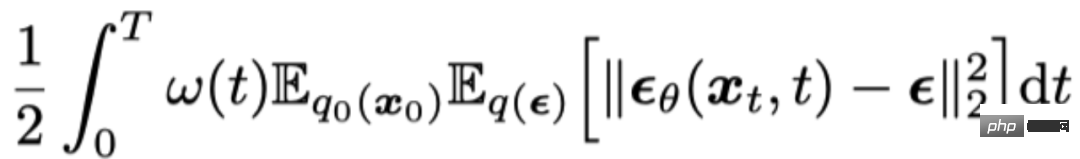

Pendant le processus d'échantillonnage, le modèle de diffusion peut être divisé en deux catégories selon que du bruit supplémentaire est ajouté : un type est le modèle d'équation différentielle stochastique de diffusion (Diffusion SDE) et l'autre est l'équation différentielle ordinaire de diffusion (Diffusion ODE). Les fonctions objectives d'entraînement des deux modèles sont les mêmes. Un « réseau de prédiction du bruit » est formé en minimisant l'erreur quadratique moyenne avec le bruit :

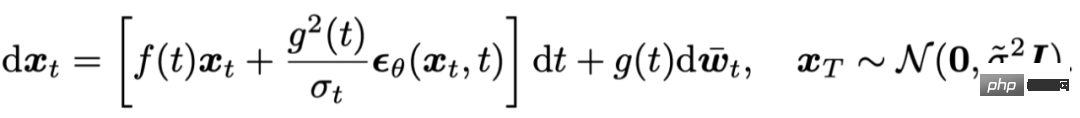

Le processus d'échantillonnage basé sur Diffusion SDE peut être considéré comme discrétisant le stochastique suivant. équation différentielle :

et il est prouvé dans [4] que DDPM[5] est une discrétisation du premier ordre du SDE ci-dessus.

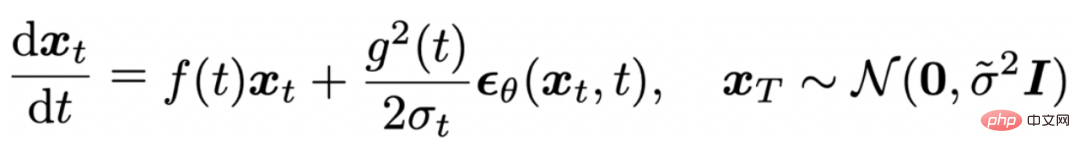

Le processus d'échantillonnage basé sur l'ODE de diffusion peut être considéré comme discrétisant l'équation différentielle ordinaire suivante :

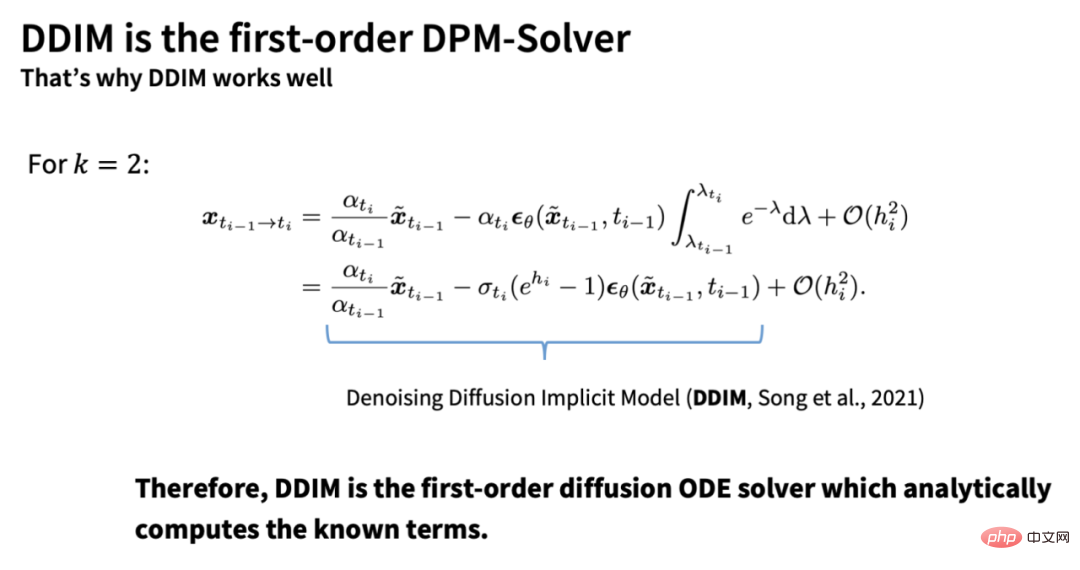

Et il est prouvé dans [6] que DDIM[7] est une discrétisation du premier ordre de l'ODE ci-dessus.

Cependant, ces méthodes de discrétisation du premier ordre convergent extrêmement lentement, et l'échantillonnage du modèle de diffusion nécessite généralement 100 à 1000 calculs en série pour obtenir une image de haute qualité. Habituellement, afin d'accélérer l'échantillonnage des modèles de diffusion, les chercheurs utilisent souvent des solveurs d'ordre élevé pour l'ODE de diffusion afin d'accélérer le processus, comme la méthode classique de Runge-Kutta (RK45). En effet, l'ODE n'apporte pas de caractère aléatoire supplémentaire. , la taille du pas de discrétisation peut être relativement plus grande. Après avoir donné la solution au temps s, la méthode Runge-Kutta est basée sur la discrétisation de l'intégrale comme suit :

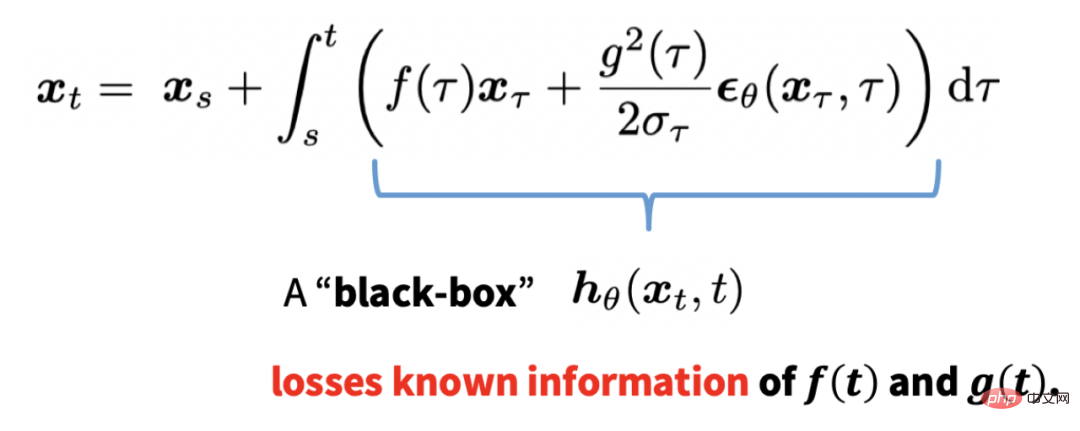

Une telle discrétisation traite l'ODE de diffusion comme une boîte noire dans son ensemble, perdant les informations connues de l'ODE, et en moins de Il est difficile de converger à 50 pas.

DPM-Solver : Un solveur spécialement conçu pour les modèles de diffusion

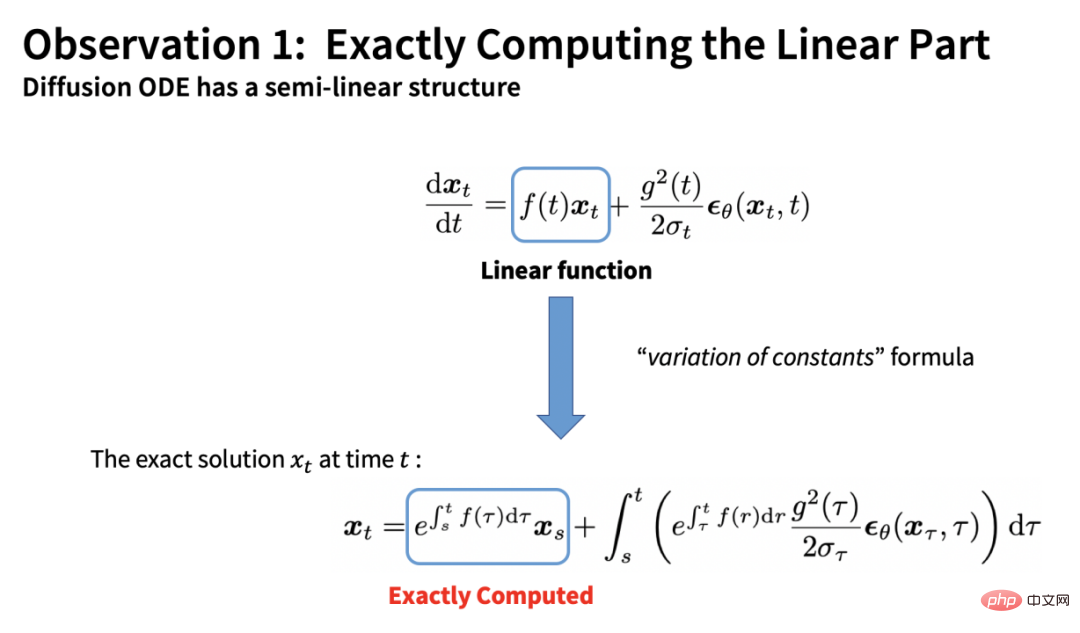

DPM-Solver est basé sur la structure semi-linéaire de Diffusion ODE En calculant avec précision et analyse les termes linéaires dans l'ODE, nous pouvons obtenir :

.

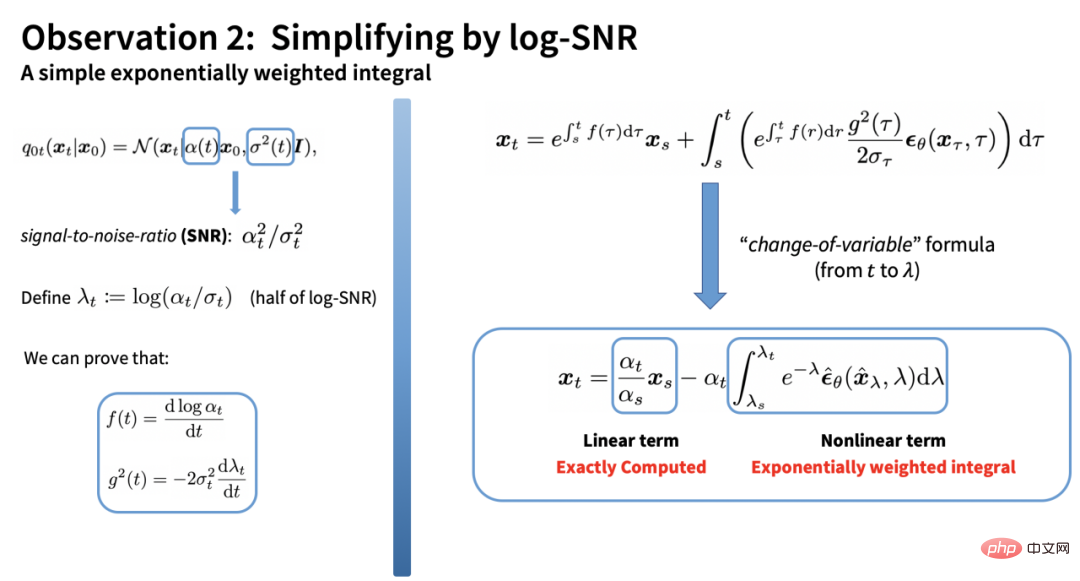

Le terme intégral restant est une intégrale complexe par rapport au temps. Cependant, le proposant de DPM-Solver a découvert que cette intégrale peut être obtenue en changeant le log-SNR (log rapport signal/bruit) pour obtenir une forme très simple :

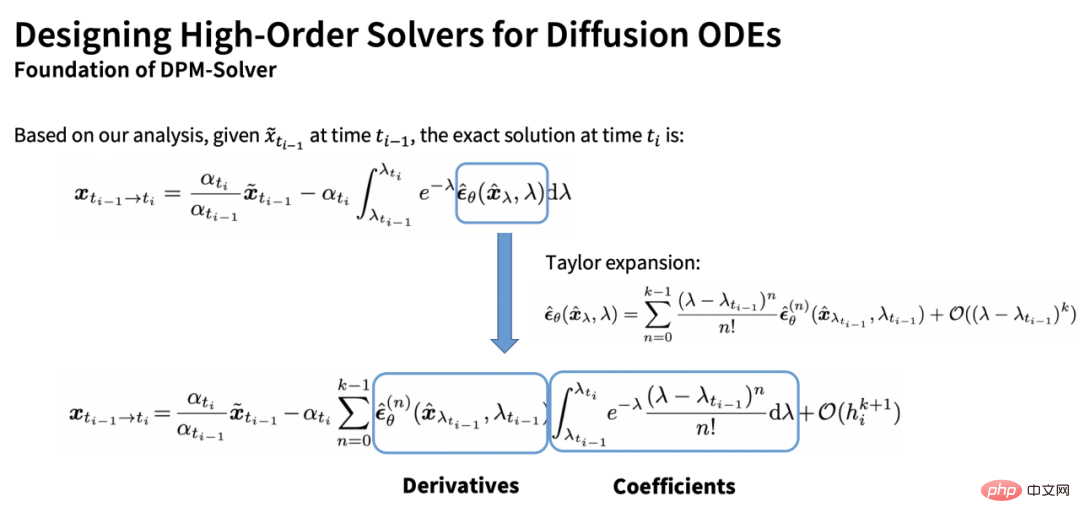

L'intégrale restante est fonction de bruit Intégrale pondérée exponentiellement du modèle prédictif. En effectuant un développement de Taylor sur le modèle de prédiction du bruit, nous pouvons obtenir une estimation de l'intégrale :

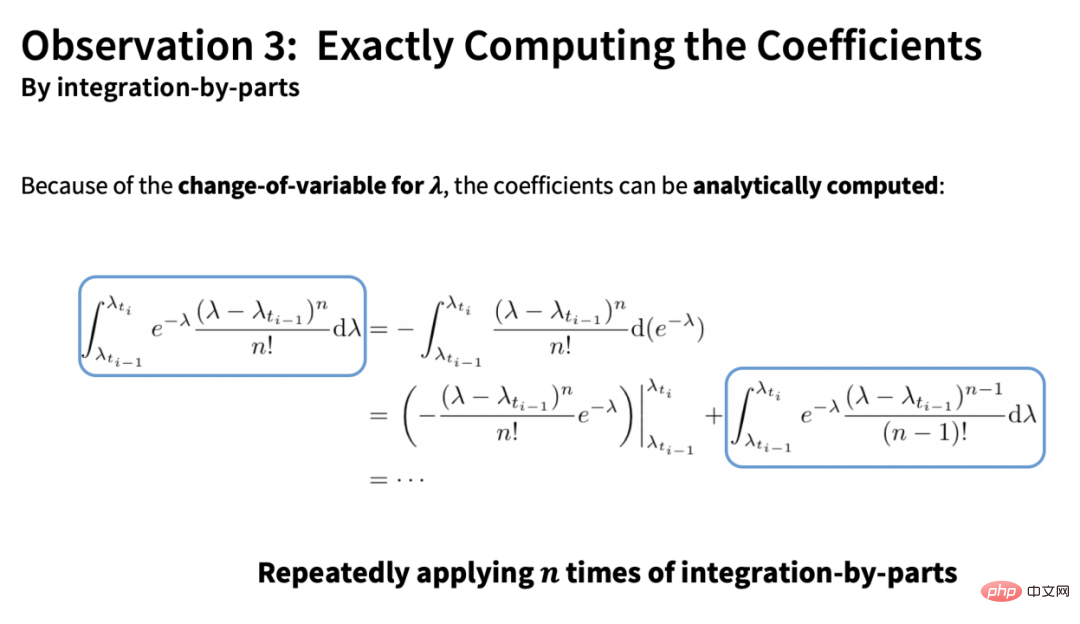

Il y a deux éléments dans cette estimation : l'un est la partie dérivée totale (vecteur) et l'autre est la partie coefficient (scalaire). Une autre contribution essentielle de DPM-Solver est que le coefficient peut être calculé analytiquement par intégration par parties :

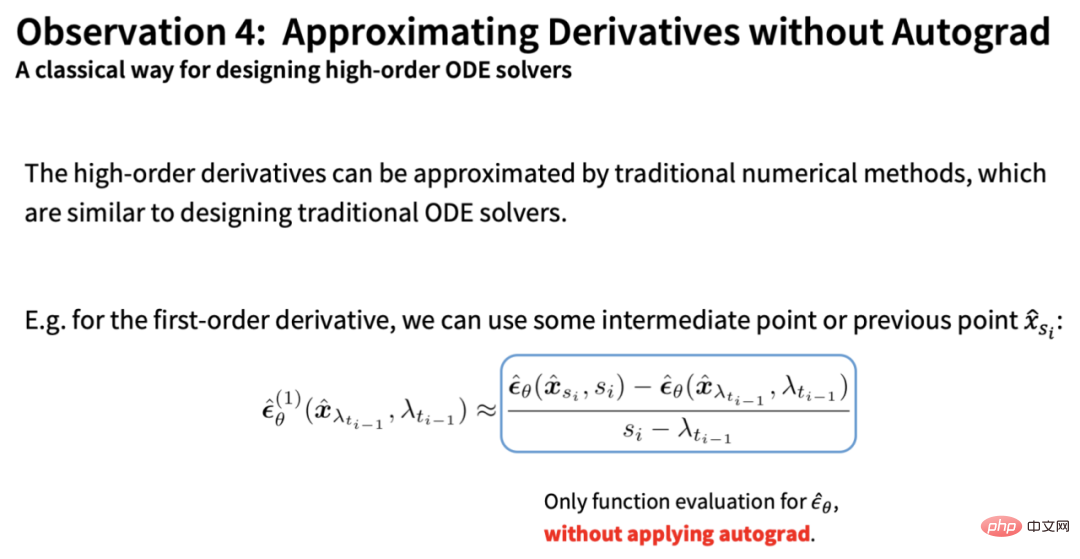

tandis que la partie dérivée totale restante peut être estimée approximativement par les méthodes numériques des solveurs ODE traditionnels (sans aucune opération dérivée) :

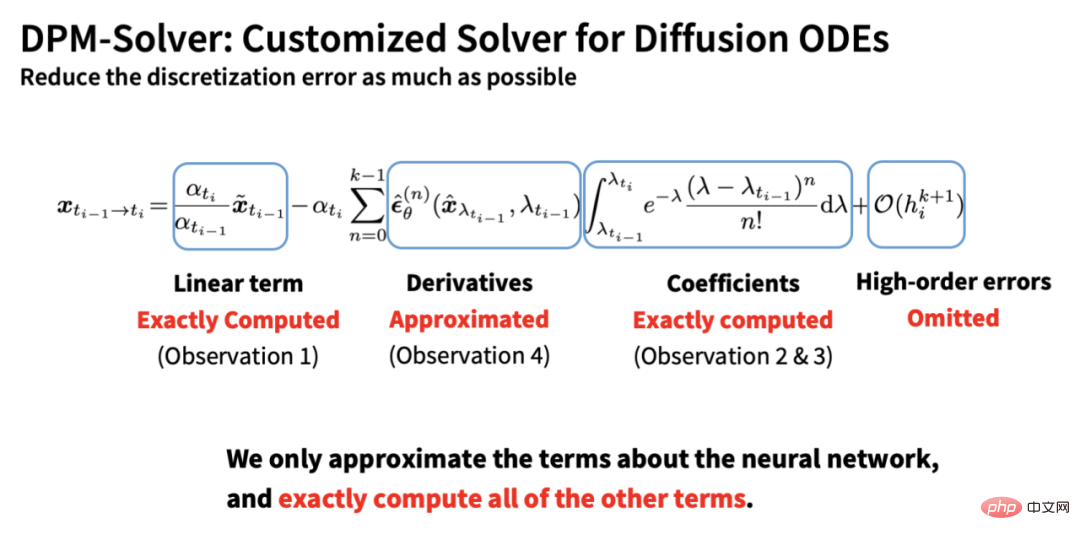

Sur la base des 4 points ci-dessus, DPM-Solver calcule tous les éléments connus aussi précisément que possible et se rapproche uniquement de la partie réseau neuronal, minimisant ainsi l'erreur de discrétisation :

De plus, sur la base de cette dérivation, nous pouvons déduire que DDIM est essentiellement la forme de premier ordre de DPM-Solver, ce qui peut également expliquer pourquoi DDIM peut encore obtenir de bons effets d'accélération lorsque le nombre d'étapes est petit :

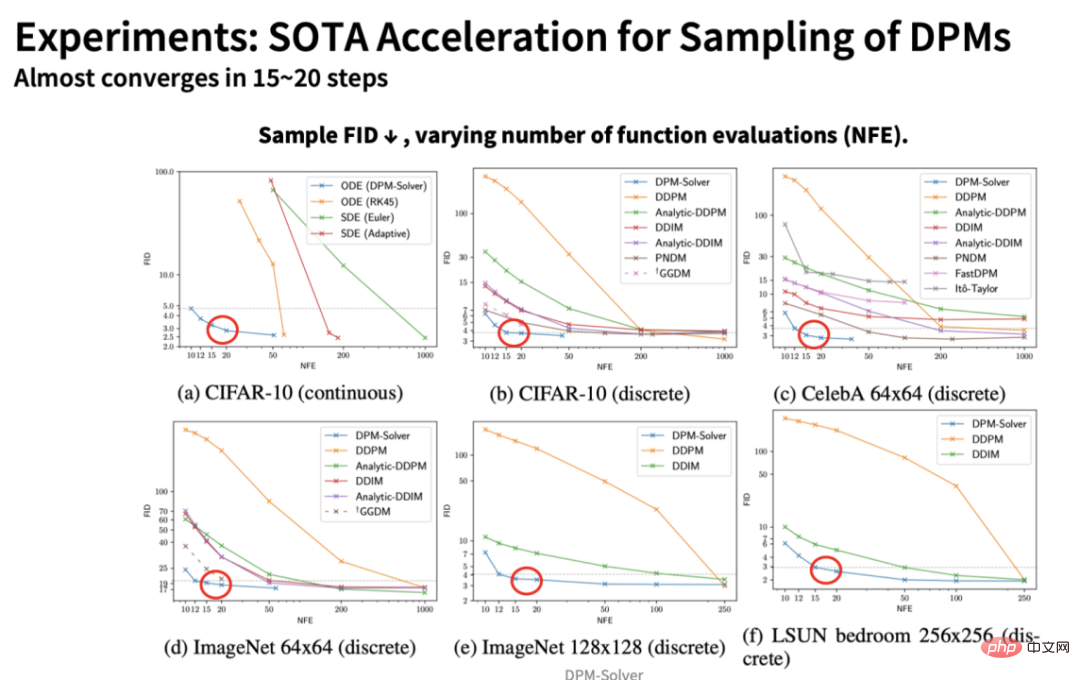

Dans Au cours de l'expérience, DPM-Solver a obtenu un effet d'accélération bien au-delà des autres algorithmes d'échantillonnage, et il a presque convergé en seulement 15 à 20 étapes :

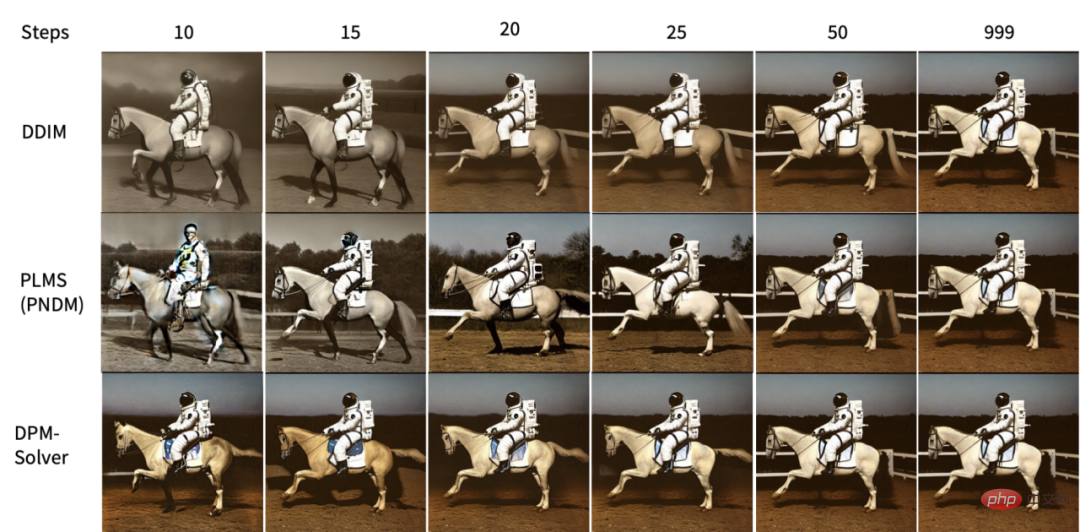

Et les résultats quantitatifs présentés dans l'article montrent que la quantité de calcul supplémentaire introduite par DPM-Solver est totalement négligeable, c'est-à-dire que l'effet d'accélération sur le nombre d'étapes est directement proportionnel à l'effet d'accélération sur le temps - donc, sur la base du Solveur DPM en 25 étapes, la vitesse d'échantillonnage du modèle Stable-Diffusion est directement doublée ! Par exemple, la figure ci-dessous montre l'effet de différents algorithmes d'échantillonnage sur la diffusion stable à mesure que le nombre d'étapes change. On peut voir que DPM-Solver peut obtenir un échantillonnage de très haute qualité en 10 à 15 étapes :

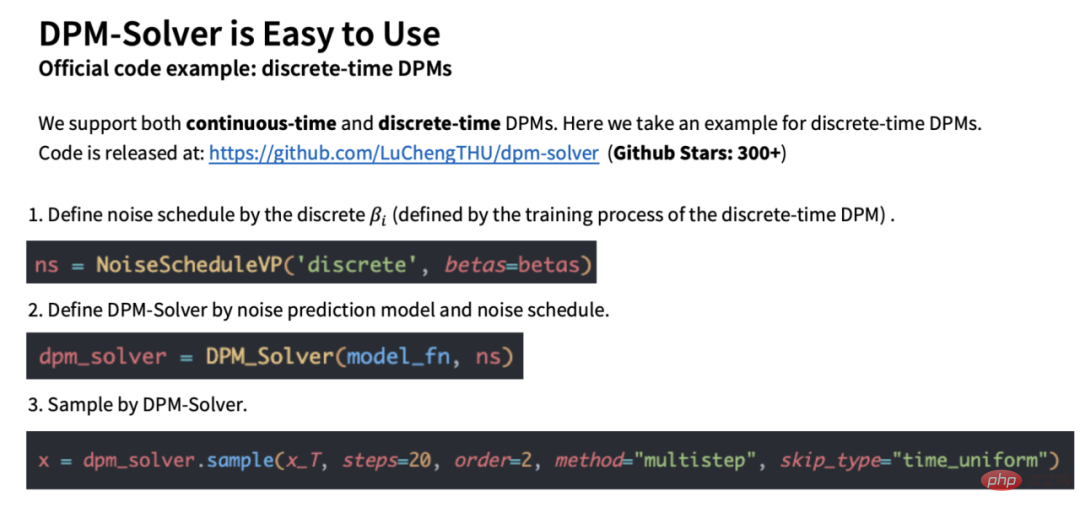

Utiliser DPM-Solver

DPM-Solver est très simple à utiliser. Il peut être basé sur le code officiel fourni par l'auteur, ou vous pouvez utiliser la bibliothèque grand public Diffusers. Par exemple, d'après le code officiel fourni par l'auteur (https://github.com/LuChengTHU/dpm-solver), seules 3 lignes sont nécessaires :

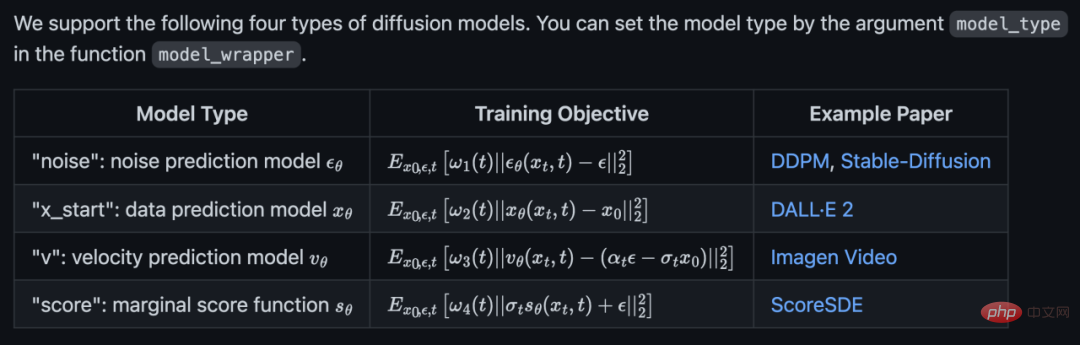

Le code officiel prend en charge les 4 modèles de diffusion :

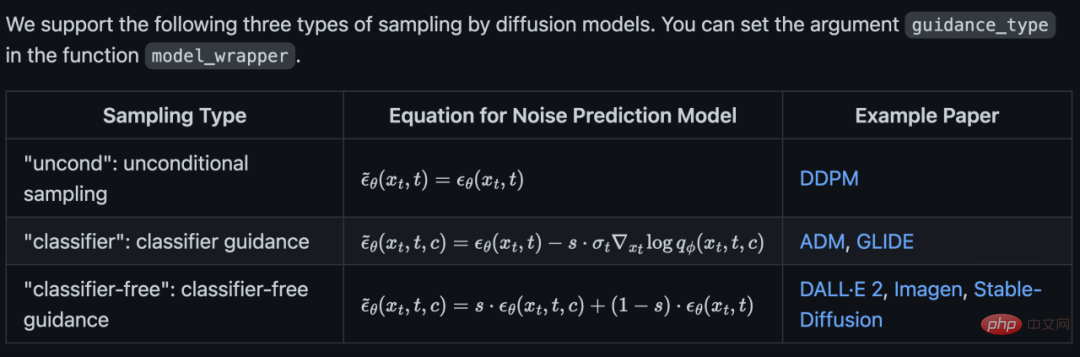

et prend en charge l'échantillonnage inconditionnel, le guidage du classificateur et le guidage sans classificateur en même temps :

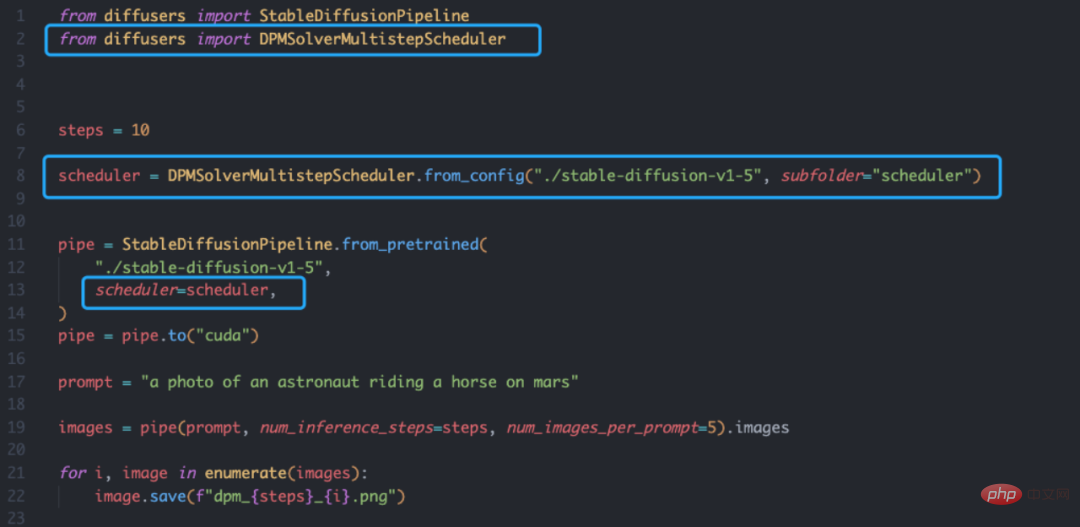

Le Solver DPM basé sur la bibliothèque Diffusers est également très simple, il vous suffit de définir le planificateur :

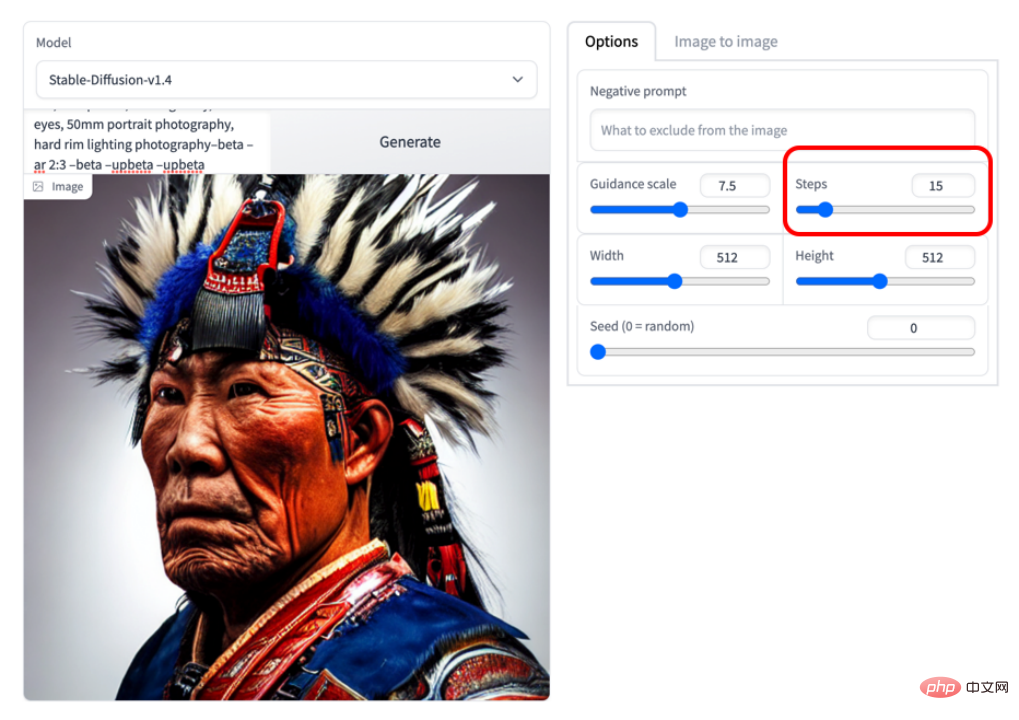

De plus, l'équipe d'auteurs propose également une démo en ligne : https://huggingface.co/spaces/LuChengTHU/dpmsolver_sdm

L'image ci-dessous est un exemple de 15 étapes que vous effectuez. On voit que la qualité de l'image est déjà très élevée :

Je pense que sur la base de DPM-Solver, la vitesse d'échantillonnage du modèle de diffusion ne sera plus un goulot d'étranglement.

À propos de l'auteur

DPM-Solver Le premier auteur de l'article est le Dr Lu Cheng de l'équipe TSAIL de l'Université Tsinghua. Il a également écrit une introduction au principe du modèle de diffusion dans la discussion sur la diffusion. modèle sur Zhihu. Il a été publié maintenant. Il y a plus de 2000 likes : https://www.zhihu.com/question/536012286/answer/2533146567

L'équipe TSAIL de l'Université Tsinghua est engagée depuis longtemps dans la théorie. et recherche algorithmique sur l'apprentissage automatique bayésien, et constitue la première recherche approfondie au monde. L'une des équipes travaillant sur des modèles génératifs probabilistes et a obtenu des résultats de recherche systématiques et approfondis sur les modèles bayésiens, les algorithmes efficaces et les bibliothèques de programmation probabiliste. Un autre doctorant de l'équipe, Bao Fan, a proposé Analytic-DPM [8][9], qui fournit une forme analytique simple et surprenante pour la moyenne et la variance optimales du modèle de diffusion, et a remporté le prix ICLR 2022 Outstanding Paper. En termes de programmation probabiliste, Machine Heart a rendu compte de la bibliothèque de programmation probabiliste approfondie « ZhuSuan » publiée par l'équipe dès 2017 (https://zhusuan.readthedocs.io/en/latest/) [10], qui est la plus ancienne dans le monde. L'une des bibliothèques de programmation pour les modèles probabilistes profonds. En outre, il convient de mentionner que les deux principaux auteurs du modèle de probabilité de diffusion, Song Yang et Song Jiaming, ont tous deux reçu une formation en recherche scientifique sous la direction du professeur Zhu Jun en tant qu'étudiants de premier cycle, puis sont allés à l'Université de Stanford pour étudier en vue d'obtenir un doctorat. . Les co-auteurs de l'article, Zhou Yuhao, Chen Jianfei et Li Chongxuan, sont également des doctorants exceptionnels formés par le groupe TSAIL. Zhou Yuhao est étudiant au département d'informatique de l'université Tsinghua et à l'université de Tsinghua. respectivement à la Hillhouse School of Artificial Intelligence de l'Université Renmin.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Publication du classement national CSRankings 2024 en informatique ! La CMU domine la liste, le MIT sort du top 5

Mar 25, 2024 pm 06:01 PM

Publication du classement national CSRankings 2024 en informatique ! La CMU domine la liste, le MIT sort du top 5

Mar 25, 2024 pm 06:01 PM

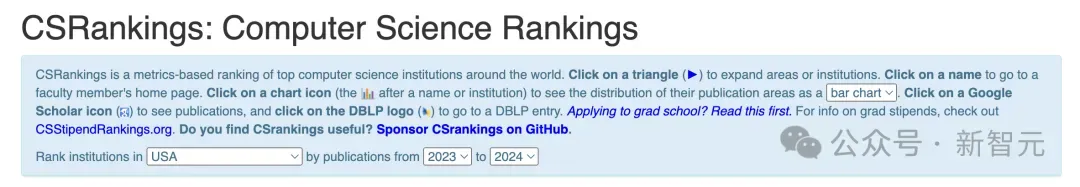

Les classements majeurs nationaux en informatique 2024CSRankings viennent d’être publiés ! Cette année, dans le classement des meilleures universités CS aux États-Unis, l'Université Carnegie Mellon (CMU) se classe parmi les meilleures du pays et dans le domaine de CS, tandis que l'Université de l'Illinois à Urbana-Champaign (UIUC) a été classé deuxième pendant six années consécutives. Georgia Tech s'est classée troisième. Ensuite, l’Université de Stanford, l’Université de Californie à San Diego, l’Université du Michigan et l’Université de Washington sont à égalité au quatrième rang mondial. Il convient de noter que le classement du MIT a chuté et est sorti du top cinq. CSRankings est un projet mondial de classement des universités dans le domaine de l'informatique initié par le professeur Emery Berger de la School of Computer and Information Sciences de l'Université du Massachusetts Amherst. Le classement est basé sur des objectifs

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.