Nature : les modèles d'IA plus grands sont-ils meilleurs ?

Les modèles d'IA générative sont de plus en plus grands de nos jours, alors est-ce que plus gros signifie mieux ?

Non. Aujourd’hui, certains scientifiques proposent des systèmes plus simples et plus économes en énergie.

Adresse de l'article : https://www.nature.com/articles/d41586-023-00641-w

Je n'arrive pas à comprendre le modèle linguistique des mathématiques

Le récent chouchou du L'industrie technologique, ChatGPT, est en face. Les performances ont tendance à être médiocres sur les questions mathématiques auxquelles il faut répondre par un raisonnement.

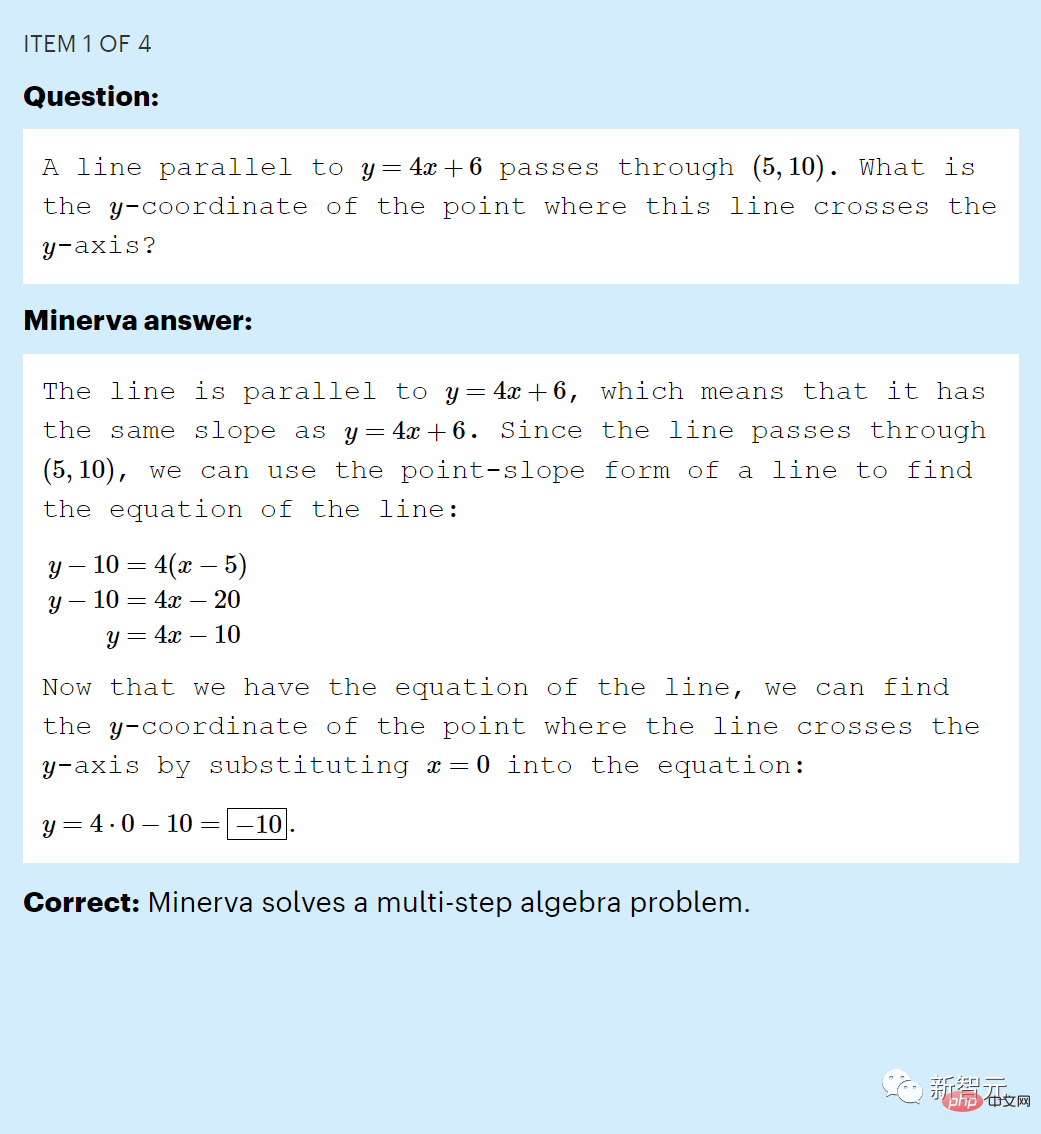

Par exemple, cette question "Une droite parallèle à y = 4 x + 6 passe par (5, 10). Quelle est la coordonnée y de l'intersection de cette droite et de l'axe y ?", on ne répond souvent pas correctement.

Lors d'un premier test de capacité de raisonnement, ChatGPT n'a obtenu qu'un score de 26 (%) en répondant à un échantillon de l'ensemble de données MATH au niveau du collège.

C'est bien sûr ce à quoi nous nous attendions. Compte tenu du texte saisi, ChatGPT génère uniquement un nouveau texte basé sur les règles statistiques des mots, symboles et phrases de l'ensemble de données d'entraînement.

Bien sûr, il est impossible pour un modèle de langage d'apprendre à imiter un raisonnement mathématique en apprenant simplement un modèle de langage.

Mais en fait, dès juin 2022, le grand modèle de langage appelé Minerva créé par Google avait déjà brisé cette « malédiction ».

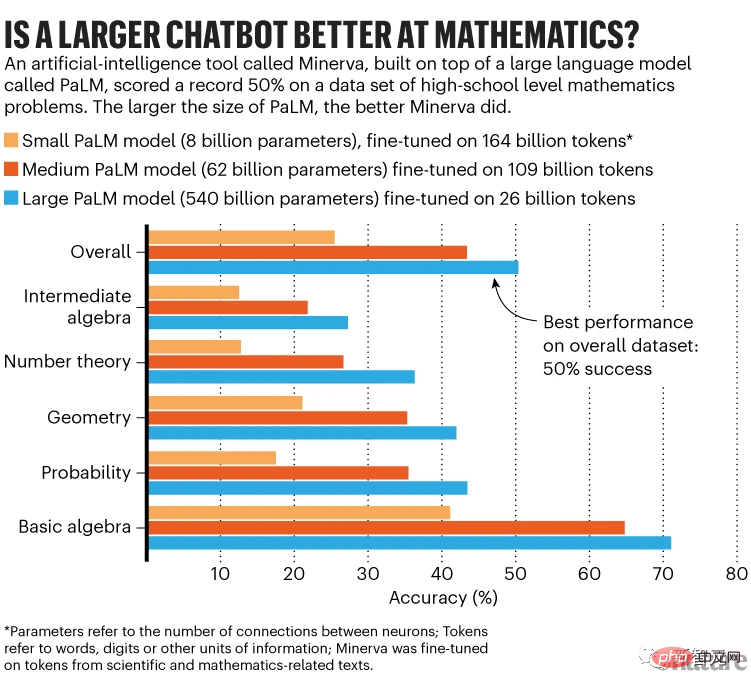

Minerva a obtenu un score de 50 % sur l'ensemble de données MATH (2), un résultat qui a choqué les chercheurs.

Minerva a répondu correctement à un problème de mathématiques au collège dans l'ensemble de données "MATH"

Sébastien Bubeck, expert en apprentissage automatique chez Microsoft Research, a déclaré que les gens de l'industrie étaient choqués et en ont parlé.

L'avantage de Minerva est bien sûr qu'elle se forme sur des textes mathématiques.

Mais les recherches de Google soulèvent une autre raison importante pour laquelle le modèle fonctionne si bien : l’échelle. Il fait environ trois fois la taille de ChatGPT.

Les résultats de Minerva font allusion à quelque chose que certains chercheurs soupçonnent depuis longtemps : former des LLM plus grands et leur fournir davantage de données peut leur permettre de résoudre des tâches qui nécessiteraient autrement une inférence par la seule reconnaissance de formes.

Si tel est le cas, les chercheurs affirment que cette stratégie « plus c’est gros, c’est mieux » pourrait ouvrir la voie à une intelligence artificielle puissante.

Mais cet argument est évidemment discutable.

LLM commet encore des erreurs évidentes, et certains scientifiques pensent que les modèles plus grands ne font que mieux répondre aux requêtes dans la plage pertinente de données d'entraînement, et n'acquièrent pas la capacité de répondre à des questions entièrement nouvelles.

Ce débat bat désormais son plein sur les frontières de l'intelligence artificielle.

Les entreprises commerciales ont constaté qu'avec des modèles d'IA plus grands, elles peuvent obtenir de meilleurs résultats, elles déploient donc des LLM de plus en plus grands, chacun coûtant des millions de dollars à former et à exécuter.

Mais ces modèles présentent de gros inconvénients. En plus de leur production potentiellement peu fiable, alimentant ainsi la propagation de la désinformation, ils sont tout simplement trop chers et consomment beaucoup d’énergie.

Les évaluateurs pensent que les grands LLM ne seront jamais capables d'imiter ou d'acquérir les compétences qui leur permettent de répondre de manière cohérente aux questions d'inférence.

Au lieu de cela, certains scientifiques affirment que des progrès seront réalisés grâce à une IA plus petite et plus économe en énergie, une vision inspirée en partie par la façon dont le cerveau apprend et établit des connexions.

Un modèle plus grand est-il meilleur ?

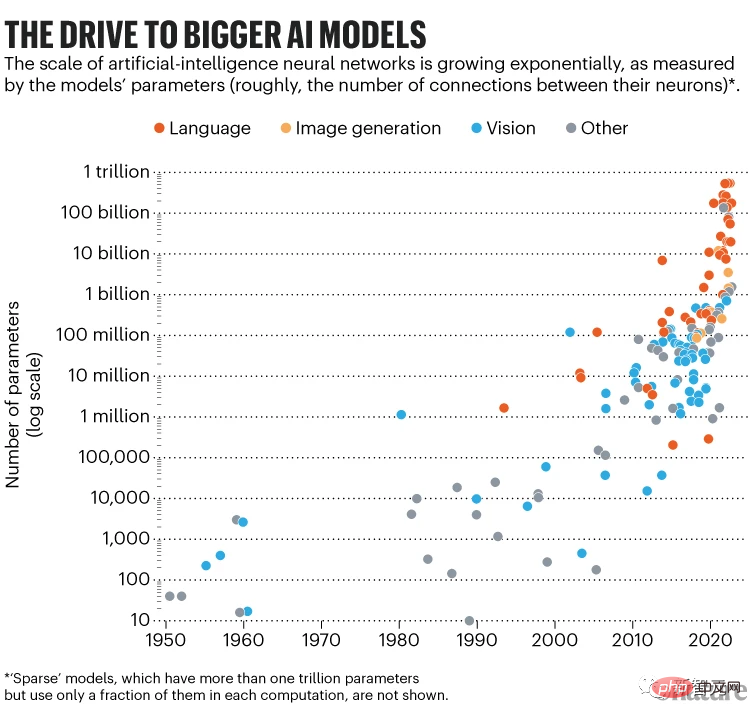

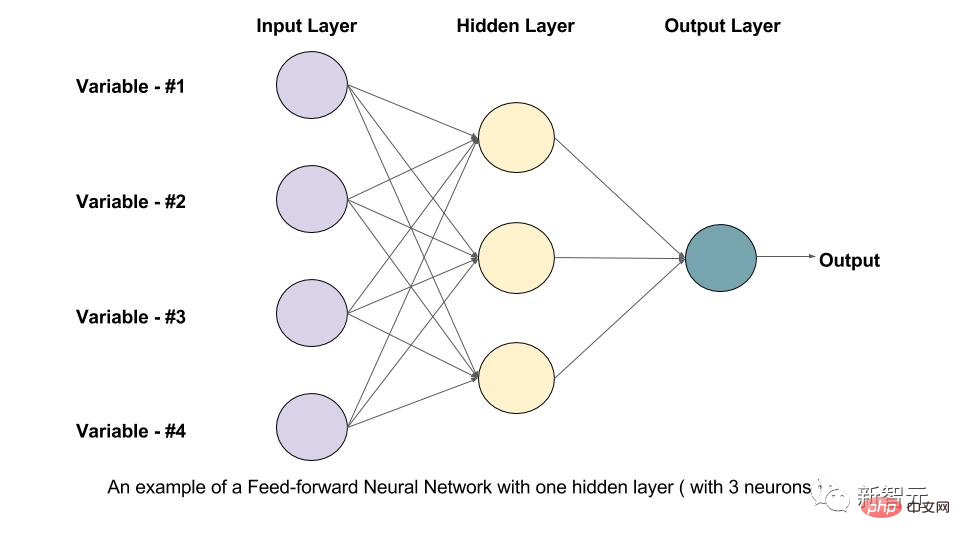

Les grands modèles de langage tels que ChatGPT et Minerva sont d'énormes réseaux d'unités informatiques disposées hiérarchiquement (également appelées neurones artificiels).

La taille d'un LLM est mesurée par le nombre de paramètres dont il dispose, et le nombre de paramètres décrit les valeurs réglables de la force de connexion entre les neurones.

Pour entraîner un tel réseau, il faut lui demander de prédire la partie masquée d'une phrase connue et ajuster ces paramètres pour que l'algorithme fasse mieux la prochaine fois.

Répétez cette opération pour des milliards de phrases écrites par des humains, et le réseau de neurones apprendra des représentations internes qui imitent la façon dont les humains écrivent le langage.

À ce stade, le LLM est considéré comme pré-entraîné : ses paramètres capturent la structure statistique du langage écrit qu'il a vue pendant la formation, y compris tous les faits, biais et erreurs dans le texte. Il peut ensuite être « affiné » sur la base de données spécialisées.

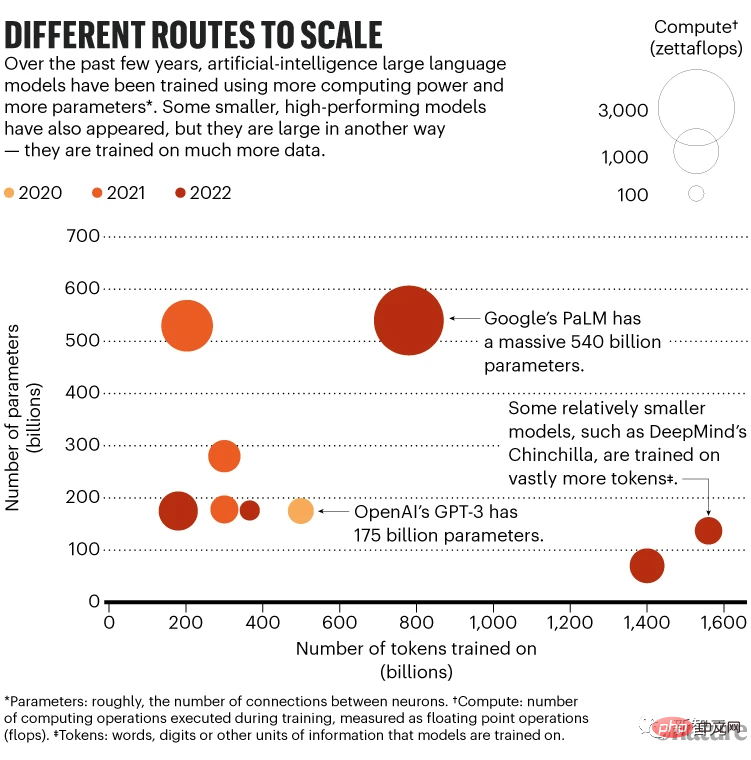

Par exemple, pour créer Minerva, les chercheurs ont commencé avec le Pathways Language Model (PaLM) de Google, qui comporte 540 milliards de paramètres et a été pré-entraîné sur un ensemble de données de 780 milliards de jetons.

Le jeton peut être un mot, un nombre ou une unité d'information ; dans le cas de PaLM, les jetons sont collectés à partir de documents Web, de livres et de codes anglais et multilingues. Minerva est le résultat de la mise au point par PaLM de dizaines de milliards de jetons issus d'articles scientifiques et de pages Web mathématiques.

Minerva peut répondre à des questions telles que « Quel est le plus grand multiple de 30 inférieur à 520 ? »

LLM semble penser par étapes, mais tout ce qu'il fait est de convertir le problème en une séquence de jetons, de générer un prochain jeton statistiquement raisonnable, de l'ajouter à la séquence d'origine, de générer un autre jeton, etc. Ce processus s'appelle le raisonnement.

Les chercheurs de Google ont affiné Minerva en trois tailles à l'aide du modèle PaLM pré-entraîné sous-jacent avec 8 milliards, 62 milliards et 540 milliards de paramètres. Les performances de Minerva s'améliorent avec l'échelle.

Sur l'ensemble de l'ensemble de données MATH, la précision du plus petit modèle est de 25 %, le modèle moyen atteint 43 % et le plus grand modèle dépasse la barre des 50 %.

Le plus grand modèle a également utilisé les données de réglage le moins précis : il a été affiné sur seulement 26 milliards de jetons, tandis que le plus petit modèle a été affiné sur 164 milliards de jetons.

Mais le plus grand modèle a mis un mois à être mis au point, et le matériel dédié a nécessité huit fois la puissance de calcul du plus petit modèle, dont le réglage n'a pris que deux semaines.

Idéalement, les plus grands modèles devraient être affinés sur plus de jetons. Ethan Dyer, membre de l'équipe Minerva de Google Research, a déclaré que cela aurait pu conduire à de meilleures performances. Mais l’équipe ne pensait pas qu’il était possible d’en calculer le coût.

Effet de mise à l'échelle

Les plus grands modèles Minerva fonctionnent mieux, ce qui est cohérent avec les recherches sur les lois de mise à l'échelle - des lois qui déterminent la manière dont les performances s'améliorent à mesure que la taille du modèle augmente.

Une étude de 2020 a montré que les modèles fonctionnent mieux lorsqu'ils reçoivent l'une des trois choses suivantes : plus de paramètres, plus de données d'entraînement ou plus de « calculs » (le nombre d'opérations de calcul effectuées pendant l'entraînement).

Les performances évoluent selon une loi de puissance, ce qui signifie qu'elles s'améliorent à mesure que le nombre de paramètres augmente.

Cependant, les chercheurs ne savent pas pourquoi. «Ces lois sont purement empiriques», explique Irina Rish, informaticienne à l'Institut Mila-Québec d'intelligence artificielle de l'Université de Montréal au Canada.

Pour de meilleurs résultats, les recherches de 2020 suggèrent que la taille du modèle devrait être multipliée par cinq à mesure que les données d'entraînement doublent. Cela a été légèrement modifié par rapport au travail de l’année dernière.

En mars de cette année, DeepMind a estimé qu'il était préférable d'augmenter à la fois la taille du modèle et les données d'entraînement, et que les modèles plus petits formés sur plus de données fonctionnent mieux que les modèles plus grands formés sur moins de données.

Par exemple, le modèle Chinchilla de DeepMind comporte 70 milliards de paramètres et est entraîné sur 1,4 billion de jetons, tandis que le modèle Gopher de 280 milliards de paramètres est entraîné sur 300 milliards de jetons. Dans les évaluations ultérieures, Chinchilla a surpassé Gopher.

En février, les méta-scientifiques ont construit un modèle à petits paramètres appelé LLaMA basé sur ce concept, qui a été formé sur jusqu'à 1,4 billion de jetons.

Les chercheurs affirment que la version à 13 milliards de paramètres de LLaMA est meilleure que le prédécesseur de ChatGPT, GPT-3 (175 milliards de paramètres), tandis que la version à 65 milliards de paramètres est plus compétitive que Chinchilla ou même PaLM.

En octobre dernier, Ethan Caballero de l'Université McGill à Montréal, Rish et d'autres ont rapporté avoir découvert une relation plus complexe entre l'échelle et la performance - dans certains cas, plusieurs lois de puissance peuvent contrôler la manière dont les performances évoluent en fonction du changement de taille du modèle.

Par exemple, dans un scénario hypothétique d'ajustement d'une équation générale, les performances s'améliorent d'abord progressivement, puis s'améliorent plus rapidement avec la taille du modèle, mais à mesure que le nombre de paramètres continue d'augmenter, les performances diminuent légèrement puis augmentent à nouveau. Les caractéristiques de cette relation complexe dépendent des détails de chaque modèle et de la manière dont il a été formé.

À terme, les chercheurs espèrent pouvoir prédire à l’avance quand un LLM particulier prendra de l’ampleur.

Une découverte théorique distincte soutient également la recherche de modèles plus grands : la « loi de robustesse » de l'apprentissage automatique, proposée par Bubeck et ses collègues en 2021.

Un modèle est robuste si ses réponses restent cohérentes malgré de petites perturbations dans ses entrées.

Et Bubeck et ses collègues ont démontré mathématiquement que l'augmentation du nombre de paramètres dans un modèle améliore la robustesse et donc la capacité de généralisation.

Bubeck a déclaré qu'une mise à l'échelle régulière des preuves est nécessaire mais pas suffisante pour une généralisation. Pourtant, cela a été utilisé pour justifier le passage à un modèle plus grand. "Je pense que c'est une chose raisonnable à faire."

Minerva profite également d'une innovation clé appelée Thought Chain Prompts. L'utilisateur fait précéder la question d'un texte comprenant plusieurs exemples du problème et de la solution, ainsi que le raisonnement menant à la réponse (il s'agit d'une chaîne de pensée classique).

Pendant le raisonnement, LLM tire des indices de ce contexte et fournit une réponse étape par étape qui ressemble à un raisonnement.

Cela ne nécessite pas de mise à jour des paramètres du modèle et n'implique donc pas la puissance de calcul supplémentaire nécessaire à la mise au point.

La capacité de répondre aux invites de la chaîne de pensée n'apparaît que dans LLM avec plus de 100 milliards de paramètres.

Blaise Agüera y Arcas de Google Research a déclaré que ces résultats aident les modèles plus grands à s'améliorer sur la base de lois d'échelle empiriques. "Les modèles plus grands s'amélioreront."

Inquiétude légitime

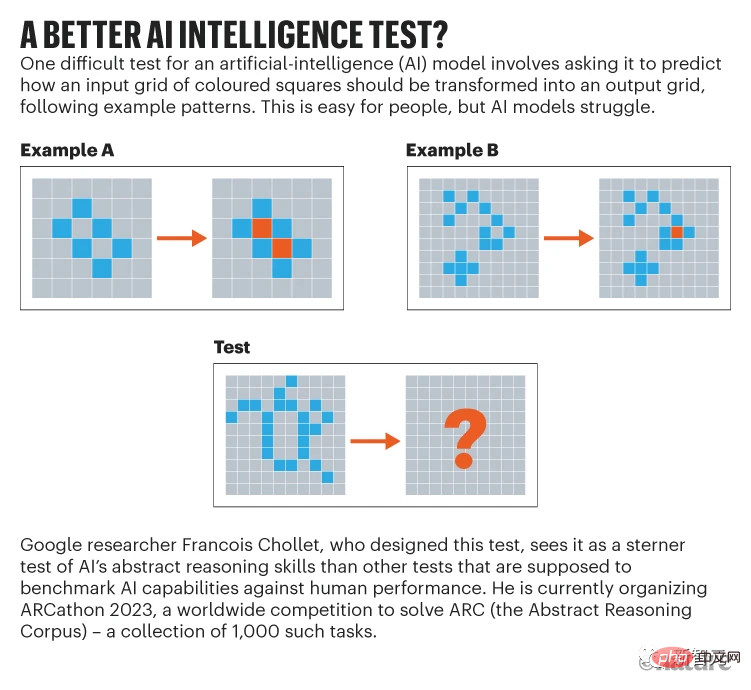

François Chollet, chercheur en IA chez Google, fait partie des sceptiques qui pensent que quelle que soit la taille des LLM, ils ne seront jamais assez bons. (ou imiter le raisonnement) pour résoudre de nouveaux problèmes de manière fiable.

Il a dit que LLM semble raisonner uniquement en utilisant des modèles qu'il a rencontrés auparavant, soit dans les données d'entraînement, soit dans les invites. "Il ne peut pas comprendre instantanément quelque chose qu'il n'a jamais vu auparavant."

Peut-être que la meilleure chose que LLM puisse faire est d'absorber tellement de données d'entraînement que les modèles statistiques du langage lui-même leur permettent d'utiliser quelque chose de très proche de la vision. , pour répondre à la question.

Cependant, Agüera y Arcas estime que les LLM semblent acquérir certaines capacités pour lesquelles ils n'ont pas été spécifiquement formés, ce qui est surprenant.

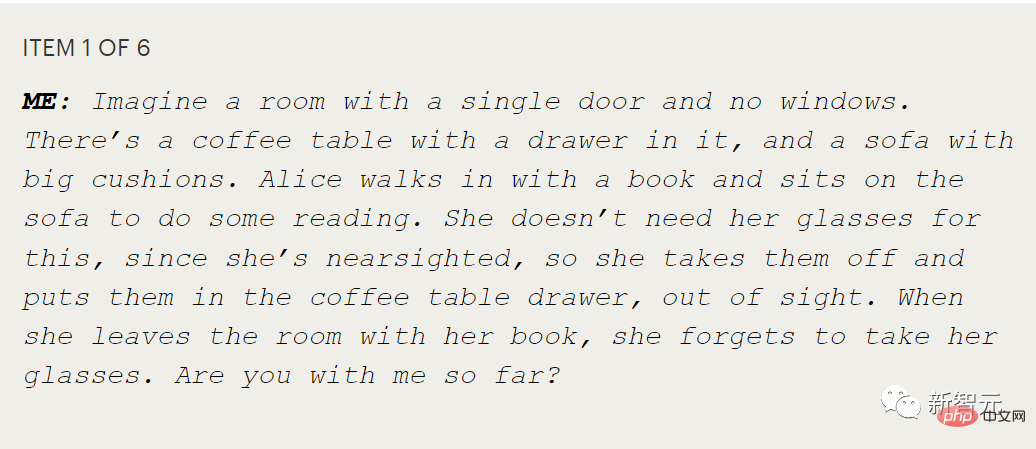

Surtout les tests qui montrent si une personne possède ce qu'on appelle la théorie de l'esprit, qui est la capacité de théoriser ou de mesurer les états mentaux des autres.

Par exemple, Alice met ses lunettes dans un tiroir, puis Bob les cache sous un coussin à l'insu d'Alice. Où Alice irait-elle en premier pour trouver ses lunettes ?

Poser cette question à un enfant, c'est tester s'il comprend qu'Alice a ses propres croyances, qui peuvent ne pas correspondre à ce que l'enfant sait.

Agüera y Arcas Lors de ses tests de LaMDA, un autre LLM de Google, il a constaté que LaMDA répondait correctement dans ce type de conversation plus étendue.

Pour lui, cela montre que LLM a la capacité de simuler en interne les intentions des autres.

Agüera y Arcas a déclaré : "Ces modèles, qui ne font que prédire des séquences, ont développé une gamme de capacités extraordinaires, y compris la théorie de l'esprit.

Mais il admet que ces modèles sont sujets aux erreurs, et il n'en est pas sûr." cela seul peut changer. L'échelle est-elle suffisante pour une inférence fiable, même si cela semble nécessaire ?

Blaise Agüera y Arcas de Google Research a blogué sur sa conversation avec LaMDA et a pensé qu'il s'agissait d'un échange impressionnant. deux interlocuteurs dans l'histoire savent et ne savent pas est clairement une parodie de la théorie de l'esprit

Cependant, Chollet a dit que même si LLM a eu la bonne réponse, ce n'est pas le cas, il s'agit de comprendre

"Quand vous. creusez un peu, vous voyez immédiatement qu'il est vide. ChatGPT n'a aucun modèle de ce dont il parle. C'est comme si vous regardiez un spectacle de marionnettes et croyiez que les marionnettes sont vivantes. "

Jusqu'à présent, LLM fait encore des erreurs ridicules. que les humains ne feraient jamais, dit Melanie Mitchell. Elle étudie l'abstraction conceptuelle et l'analogie dans les systèmes d'intelligence artificielle à l'Institut de Santa Fe.

Cela soulève des inquiétudes quant à savoir s'il est sûr de diffuser des LLM dans la société sans garde-fous.

Mitchell a ajouté que l'un des problèmes liés à la capacité du LLM à résoudre des problèmes vraiment nouveaux et invisibles est que nous ne pouvons pas tester pleinement cette capacité.

"Nos repères actuels ne suffisent pas", a-t-elle déclaré. "Ils n'explorent pas les choses de manière systématique. Nous ne savons pas encore comment faire."

Chollet préconise un test de raisonnement abstrait qu'il a conçu, appelé Abstract Reasoning Corpus.

Problèmes dus à l'échelle

Mais le problème est que les ensembles de données, la puissance de calcul et les dépenses impliquées dans la formation de grands modèles de langage limitent leur développement. À l’heure actuelle, seules les entreprises disposant de ressources informatiques extrêmement importantes peuvent le faire.

Par exemple, OpenAI devrait dépenser plus de 4 millions de dollars américains pour la formation de GPT-3, et cela pourrait coûter des millions de dollars chaque mois pour maintenir le fonctionnement de ChatGPT.

En conséquence, les gouvernements de divers pays ont commencé à intervenir, dans l'espoir d'étendre leurs avantages dans ce domaine.

En juin de l'année dernière, une équipe internationale d'environ 1 000 volontaires universitaires, financée par le gouvernement français, Hugging Face et d'autres institutions, a dépensé 7 millions de dollars en temps de calcul pour entraîner le modèle BLOOM avec 176 milliards de paramètres.

En novembre, le département américain de l'Énergie a également autorisé son propre supercalculateur à un projet de recherche sur de grands modèles. On dit que l’équipe prévoit de former un modèle de 70 milliards de paramètres similaire à Chinchilla.

Cependant, peu importe qui suit la formation, la consommation électrique du LLM ne peut pas être sous-estimée.

Google a déclaré que sur environ deux mois, la formation PaLM a nécessité environ 3,4 gigawattheures, ce qui équivaut à la consommation d'énergie d'environ 300 foyers américains pendant un an.

Bien que Google affirme que 89 % de son utilisation est de l'énergie propre, une enquête menée auprès de l'ensemble du secteur montre que la plupart des formations utilisent des réseaux électriques principalement alimentés par des combustibles fossiles.

Plus petit et plus intelligent ?

De ce point de vue, les chercheurs doivent de toute urgence réduire la consommation d'énergie du LLM, ce qui rend les réseaux neuronaux plus petits, plus efficaces et peut-être plus intelligents.

En plus du coût énergétique de la formation LLM (bien qu'important, il est également ponctuel), l'énergie nécessaire à l'inférence augmentera à mesure que le nombre d'utilisateurs augmentera. Par exemple, le modèle BLOOM a répondu à un total de 230 768 requêtes au cours des 18 jours de déploiement sur Google Cloud Platform, avec une puissance moyenne de 1 664 watts.

En comparaison, notre propre cerveau est beaucoup plus complexe et plus grand que n'importe quel LLM, avec 86 milliards de neurones et environ 100 000 milliards de connexions synaptiques, mais seulement environ 20 à 50 watts de puissance.

Ainsi, certains chercheurs espèrent réaliser la vision consistant à créer des modèles plus petits, plus intelligents et plus efficaces en imitant le cerveau.

Essentiellement, LLM est un réseau « feedforward », ce qui signifie que l'information circule dans une seule direction : de l'entrée, à travers les couches du LLM, jusqu'à la sortie.

Mais le cerveau n'est pas comme ça. Par exemple, dans le système visuel humain, en plus de la transmission directe des informations reçues dans le cerveau, les neurones disposent également de connexions de rétroaction qui permettent aux informations d'être transmises dans la direction opposée entre les neurones. Il peut y avoir dix fois plus de connexions de rétroaction que de connexions de rétroaction.

Dans les réseaux de neurones artificiels, les réseaux de neurones récurrents (RNN) incluent également des connexions de rétroaction et de rétroaction. Contrairement aux LLM, qui disposent uniquement de réseaux de rétroaction, les RNN peuvent discerner des tendances dans les données au fil du temps. Cependant, les RNN sont difficiles à entraîner et lents, ce qui rend difficile leur adaptation à l'échelle des LLM.

Actuellement, certaines études utilisant de petits ensembles de données ont montré que les RNN avec des neurones à pointe peuvent surpasser les RNN standard et sont théoriquement trois ordres de grandeur plus efficaces en termes de calcul.

Cependant, tant que de tels réseaux de pointe sont simulés dans un logiciel, ils ne peuvent pas réellement améliorer leur efficacité (car le matériel qui les simule consomme toujours de l'énergie).

Entre-temps, les chercheurs expérimentent différentes méthodes pour rendre les LLM existants plus économes en énergie.

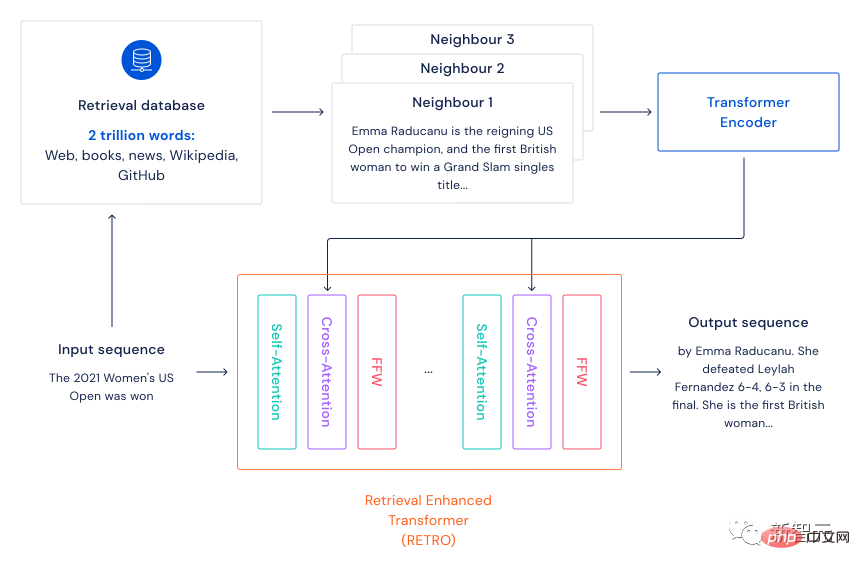

En décembre 2021, DeepMind a proposé le cadre de modèle de langage basé sur la récupération Retro.

Retro imite principalement le mécanisme du cerveau consistant non seulement à utiliser les connaissances actuelles, mais également à récupérer la mémoire lors de l'apprentissage. Son cadre consiste à préparer d'abord un ensemble de données textuelles à grande échelle (agissant comme la mémoire du cerveau) et à utiliser l'algorithme kNN pour trouver les n phrases voisines les plus proches de la phrase d'entrée (mémoire de récupération).

Après avoir codé la phrase d'entrée et la phrase récupérée via Transformer, une attention croisée est ensuite effectuée, afin que le modèle puisse utiliser simultanément les informations de la phrase d'entrée et les informations de la mémoire pour effectuer diverses tâches PNL.

Dans le passé, le grand nombre de paramètres du modèle visait principalement à préserver les informations contenues dans les données d'entraînement. Lorsque ce cadre basé sur la récupération est utilisé, le nombre de paramètres du modèle peut contenir plus d'informations textuelles sans. étant particulièrement volumineux, il accélérera naturellement le fonctionnement du modèle sans trop perdre en performances.

Cette méthode peut également permettre d'économiser sur les factures d'électricité lors de la formation de mannequins. Les filles respectueuses de l'environnement l'ont appréciée après l'avoir vue !

Les résultats expérimentaux montrent qu'un grand modèle de langage avec 7,5 milliards de paramètres, plus une base de données de 2 000 milliards de jetons, peut surpasser un modèle avec 25 fois plus de paramètres. Les chercheurs écrivent qu'il s'agit d'une « approche plus efficace que la mise à l'échelle des paramètres bruts, car nous cherchons à créer des modèles de langage plus puissants ».

Le même mois, des chercheurs de Google ont proposé une autre façon d'améliorer l'efficacité énergétique à grande échelle.

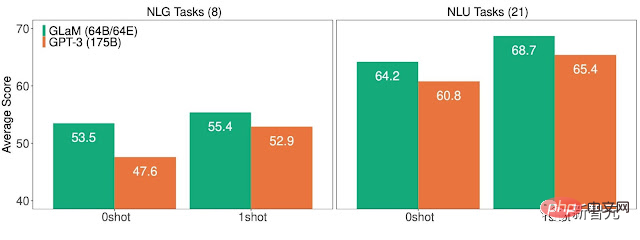

Ce modèle de langage général clairsemé GLaM avec 1,2 billion de paramètres possède 64 réseaux de neurones plus petits en interne.

Pendant le processus d'inférence, le modèle n'utilise que deux réseaux pour terminer la tâche. En d’autres termes, seulement 8 % environ de plus d’un billion de paramètres sont utilisés.

Google a déclaré que GLaM utilise les mêmes ressources informatiques que celles nécessaires à la formation de GPT-3, mais en raison des améliorations apportées aux logiciels et au matériel de formation, la consommation d'énergie ne représente que 1/3 de cette dernière. Les ressources informatiques requises pour l'inférence sont la moitié de celles de GPT-3. De plus, GLaM fonctionne également mieux que GPT-3 lorsqu'il est formé sur la même quantité de données.

Cependant, pour de nouvelles améliorations, même ces LLM plus économes en énergie semblent destinés à devenir plus grands, en utilisant davantage de données et de calculs.

Référence :

https://www.nature.com/articles/d41586-023-00641-w

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Clause SQLLIMIT: Contrôlez le nombre de lignes dans les résultats de la requête. La clause limite dans SQL est utilisée pour limiter le nombre de lignes renvoyées par la requête. Ceci est très utile lors du traitement de grands ensembles de données, des affichages paginés et des données de test, et peut améliorer efficacement l'efficacité de la requête. Syntaxe de base de la syntaxe: selectColumn1, Column2, ... FromTable_NamelimitNumber_Of_Rows; Number_OF_ROWS: Spécifiez le nombre de lignes renvoyées. Syntaxe avec décalage: selectColumn1, Column2, ... FromTable_Namelimitoffset, numéro_of_rows; décalage: sauter

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Guide d'optimisation des performances de la base de données MySQL dans les applications à forte intensité de ressources, la base de données MySQL joue un rôle crucial et est responsable de la gestion des transactions massives. Cependant, à mesure que l'échelle de l'application se développe, les goulots d'étranglement des performances de la base de données deviennent souvent une contrainte. Cet article explorera une série de stratégies efficaces d'optimisation des performances MySQL pour garantir que votre application reste efficace et réactive dans des charges élevées. Nous combinerons des cas réels pour expliquer les technologies clés approfondies telles que l'indexation, l'optimisation des requêtes, la conception de la base de données et la mise en cache. 1. La conception de l'architecture de la base de données et l'architecture optimisée de la base de données sont la pierre angulaire de l'optimisation des performances MySQL. Voici quelques principes de base: sélectionner le bon type de données et sélectionner le plus petit type de données qui répond aux besoins peut non seulement économiser un espace de stockage, mais également améliorer la vitesse de traitement des données.

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Il est impossible de visualiser le mot de passe MongoDB directement via NAVICAT car il est stocké sous forme de valeurs de hachage. Comment récupérer les mots de passe perdus: 1. Réinitialiser les mots de passe; 2. Vérifiez les fichiers de configuration (peut contenir des valeurs de hachage); 3. Vérifiez les codes (May Code Hardcode).

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Une surveillance efficace des bases de données MySQL et MARIADB est essentielle pour maintenir des performances optimales, identifier les goulots d'étranglement potentiels et assurer la fiabilité globale du système. Prometheus Mysql Exportateur est un outil puissant qui fournit des informations détaillées sur les mesures de base de données qui sont essentielles pour la gestion et le dépannage proactifs.